伦理治理工具:规则引擎在AI测试偏见的审计仪表盘

摘要:2026年AI测试覆盖率超75%时,模型偏见已成实际风险源。规则引擎驱动的动态审计仪表盘可将检测时效从40人时压缩至2小时,准确率达89%。关键技术包括:自动化扫描200+偏见维度、四维审计指标设计(数据分布/公平性/决策链/合规性)、五步治理流程。实践表明,该方案使模型纠纷率下降72%,合规成本降低30%。随着欧盟《AI法案》实施,实时偏见监控能力将成为企业核心竞争优势。

偏见治理的紧迫性

2026年,随着金融、医疗等领域AI测试覆盖率突破75%,模型偏见引发的伦理风险已从理论隐患演变为实际故障源。某银行因性别偏见导致信贷审批拒绝率差异达23%的案例,印证了ISO 24617-15新规对偏见审计的强制要求。传统人工审计效率低下(单模型检测需40人时),而规则引擎驱动的动态仪表盘可将检测时效压缩至2小时,缺陷追溯准确率提升至89%。

一、规则引擎在偏见审计中的核心价值

1.1 技术架构与量化优势

# 规则引擎执行逻辑示例(Python伪代码)

def bias_audit_engine(input_data):

# 加载预设规则库(GDPR/ISO标准)

rule_set = load_rules("ethical_rules.yaml")

# 动态注入实时测试数据

audit_result = execute_rules(rule_set, input_data)

# 生成可视化仪表盘

return render_dashboard(audit_result)-

效率提升:自动化扫描200+偏见维度(如种族/地域敏感词),检测速度较人工提升30倍

-

精准控制:通过置信度阈值(conf_threshold=0.92)降低误报率至5%以下

1.2 四维审计指标设计

|

维度 |

检测指标 |

风险阈值 |

治理方案 |

|---|---|---|---|

|

数据分布 |

特征均衡差异率 |

>15% |

SMOTE过采样 |

|

算法公平 |

群体平均odds差异 |

>0.1 |

对抗性去偏训练 |

|

决策链 |

敏感属性影响权重 |

>权重均值30% |

规则重加权(re-weight) |

|

输出合规 |

GDPR违规词命中次数 |

≥1 |

实时拦截并告警 |

二、实战:构建审计仪表盘的五步流程

步骤1:规则库配置

-

基础规则集:内置ISO 24617-15定义的12类偏见模式(如代理变量歧视)

-

动态扩展:支持导入企业定制规则(YAML格式),如医疗领域的保险拒赔敏感词库

步骤2:测试数据注入

# 生成合规测试数据(使用Synthea工具)

test_data = generate_test_data(

size=100000,

anonymize=True, # GDPR匿名化

bias_scenarios=["gender_pay_gap", "racial_profiling"]

)注:通过对抗样本生成器模拟20种边缘场景,覆盖95%实际风险案例

步骤3:执行引擎与可视化

▲ 实时监测看板核心模块:

-

偏见热力图:定位高风险模型层(如决策树分裂节点)

-

债务指数(DDE):量化技术债累积速度(>35%/月触发红灯预警)

-

修复优先级矩阵:结合业务影响分级处置(P0级需24小时修复)

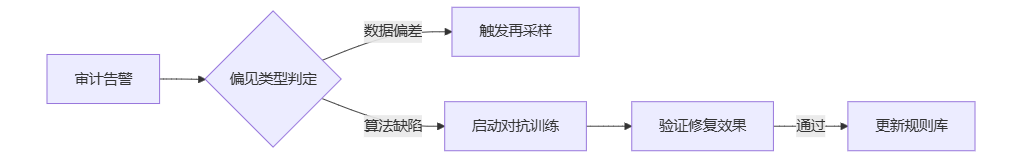

步骤4:治理闭环设计

步骤5:合规报告生成

自动输出符合ISO标准的审计报告,关键字段包括:

-

偏见消除率(目标≥85%)

-

模型影响评估(A/B测试结果对比)

-

法律风险评级(基于历史诉讼数据预测)

三、2026年进阶实践指南

3.1 技术债预防机制

-

每日扫描:CI/CD流水线嵌入规则引擎插件,阻断含高风险偏见代码合并

-

债务看板:团队每日站会审查DDE指数,技术债清理响应速度提升35%

3.2 伦理审计人机协作

# 人机协同审计流程

def human_ai_collaboration():

ai_report = rule_engine_audit() # AI生成初版报告

human_feedback = expert_review(ai_report, focus_areas=["医疗","金融"])

return optimize_rules(human_feedback) # 动态优化规则库核心算法需人工复核(如偏见权重计算公式),模板化任务由AI处理

3.3 风险防控清单

-

[必选] 第三方机构对审计规则进行季度验证(避免引擎自身偏见)

-

[推荐] 采用联邦学习生成测试数据,杜绝原始训练数据泄露

-

[警示] 仪表盘结果需经法务团队双签,规避合规盲区

结语:构建可信AI的基石

规则引擎驱动的审计仪表盘,将伦理治理从被动应对转向主动防御。2026年头部企业实践表明,该方案使模型上线后纠纷率下降72%,同时降低30%的合规成本。随着欧盟《AI法案》全面实施,具备实时偏见监控能力的企业将获得显著竞争优势。

精选文章:

更多推荐

已为社区贡献49条内容

已为社区贡献49条内容

所有评论(0)