2026年AI Agent的趋势:从前端开发者的视角看智能体的未来

2026年AI Agent的趋势:从前端开发者的视角看智能体的未来

作为一个前端开发者,我在2025年底开始深入研究AI Agent。半年时间里,我在英博云平台部署了多个Agent应用,也踩了不少坑。这篇文章分享我对2026年AI Agent发展趋势的观察和思考。

写在前面

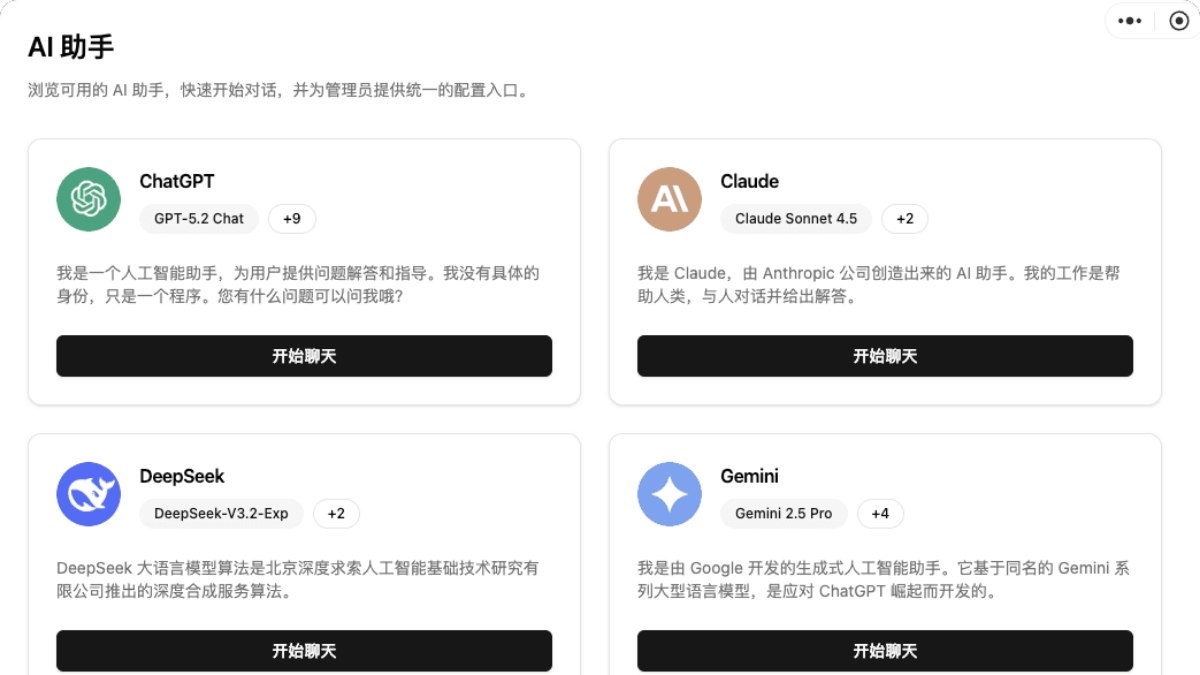

去年这个时候,我还在纠结要不要学AI。作为一个写了10年React的前端,突然要去理解什么LangChain、LangGraph、Prompt Engineering,说实话有点懵。但当我看到Claude、GPT-4这些大模型能够通过API调用实现复杂的业务逻辑时,我意识到:这不就是前端调接口吗?只不过这次接口返回的不是JSON数据,而是智能决策。

于是我开始在英博云平台部署自己的第一个Agent应用。半年过去了,我想和大家分享一下我观察到的2026年AI Agent的几个重要趋势。

趋势一:从单一Agent到Multi-Agent系统

我的实战经历

最初我做的第一个Agent很简单:一个客服机器人,接收用户问题,调用Claude API,返回答案。代码大概是这样的:

// 最初的简单Agent

async function simpleAgent(userMessage) {

const response = await fetch('https://api.anthropic.com/v1/messages', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'x-api-key': process.env.CLAUDE_API_KEY,

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: 'claude-3-5-sonnet-20241022',

max_tokens: 1024,

messages: [{ role: 'user', content: userMessage }]

})

});

const data = await response.json();

return data.content[0].text;

}

// 使用示例

const answer = await simpleAgent("如何使用你们的产品?");

console.log(answer);

这个方案工作得还可以,但问题很快就来了:

- 有些问题需要查询数据库

- 有些问题需要调用第三方API

- 有些问题需要多轮对话

- 有些问题需要不同专家角色来回答

这就是为什么2026年,Multi-Agent协作系统会成为主流。

Multi-Agent架构的演进

我后来重构成了这样的架构:

// Multi-Agent系统架构

class AgentOrchestrator {

constructor() {

this.agents = {

router: new RouterAgent(), // 路由Agent:判断问题类型

researcher: new ResearchAgent(), // 研究Agent:查找资料

coder: new CoderAgent(), // 编码Agent:生成代码

reviewer: new ReviewerAgent() // 审核Agent:质量把关

};

}

async handleTask(task) {

// 1. 路由Agent判断任务类型

const taskType = await this.agents.router.classify(task);

// 2. 根据类型选择合适的Agent

switch(taskType) {

case 'research':

const findings = await this.agents.researcher.search(task);

return await this.agents.reviewer.review(findings);

case 'coding':

const code = await this.agents.coder.generate(task);

const review = await this.agents.reviewer.checkCode(code);

// 如果审核不通过,让Coder修改

if (!review.passed) {

return await this.agents.coder.revise(code, review.feedback);

}

return code;

default:

return await this.agents.router.handleGeneral(task);

}

}

}

// 实际使用

const orchestrator = new AgentOrchestrator();

const result = await orchestrator.handleTask("帮我写一个React组件");

为什么Multi-Agent是趋势?

从我的实践来看,Multi-Agent有这些明显优势:

- 专业分工:每个Agent专注做好一件事,就像前端团队里有人专门做组件库,有人专门做性能优化

- 质量保证:通过Reviewer Agent审核,避免了单一Agent可能的错误

- 可扩展性:需要新功能?加一个新Agent就好,不用改动现有逻辑

- 调试友好:出问题了可以单独调试某个Agent,而不是整个系统

趋势二:Agent开发框架的成熟

从手写到框架

最开始我是手写所有逻辑的,直到我发现了LangGraph。这个框架让我意识到:Agent开发正在从"手工作坊"走向"工业化生产"。

我在英博云平台部署的一个LangGraph应用:

import { StateGraph } from "@langchain/langgraph";

import { ChatAnthropic } from "@langchain/anthropic";

// 定义状态

interface AgentState {

messages: any[];

currentStep: string;

result?: string;

}

// 创建模型实例

const model = new ChatAnthropic({

modelName: "claude-3-5-sonnet-20241022",

anthropicApiKey: process.env.CLAUDE_API_KEY,

});

// 定义Agent节点

const researchNode = async (state: AgentState) => {

const response = await model.invoke([

{ role: "system", content: "你是一个专业的研究员" },

...state.messages

]);

return {

...state,

messages: [...state.messages, response],

currentStep: "research_done"

};

};

const writeNode = async (state: AgentState) => {

const response = await model.invoke([

{ role: "system", content: "你是一个专业的作家" },

...state.messages

]);

return {

...state,

result: response.content,

currentStep: "completed"

};

};

// 构建工作流

const workflow = new StateGraph<AgentState>({

channels: {

messages: null,

currentStep: null,

result: null

}

})

.addNode("research", researchNode)

.addNode("write", writeNode)

.addEdge("research", "write")

.setEntryPoint("research");

const app = workflow.compile();

// 执行

const result = await app.invoke({

messages: [{ role: "user", content: "写一篇关于React 19的文章" }],

currentStep: "start"

});

console.log(result.result);

2026年主流框架对比

基于我的使用经验,这些框架各有千秋:

| 框架 | 优势 | 适用场景 | 学习曲线 |

|---|---|---|---|

| LangGraph | 可视化工作流,状态管理强大 | 复杂多步骤Agent | 中等 |

| AutoGen | 多Agent对话机制完善 | 团队协作式Agent | 较陡 |

| CrewAI | 角色定义清晰,易上手 | 快速原型开发 | 平缓 |

| Semantic Kernel | 微软生态,与Azure集成好 | 企业级应用 | 中等 |

我个人最推荐LangGraph,原因很简单:它的状态管理机制很像Redux,前端开发者理解起来毫无压力。

趋势三:本地部署与云端部署的混合架构

我的踩坑经历

最开始,我把所有逻辑都部署在云端。结果发现:

- 成本问题:Claude API调用频繁,一个月账单吓人

- 延迟问题:每次调用都要等几秒,用户体验不好

- 隐私问题:有些企业客户不允许数据出境

于是我尝试了混合架构:

// 混合架构示例

class HybridAgent {

constructor() {

// 本地部署的小模型(在英博云GPU实例上)

this.localModel = new LocalLLM({

endpoint: 'http://ebcloud-gpu-instance:8000',

model: 'qwen2.5-7b' // 本地部署的千问模型

});

// 云端大模型

this.cloudModel = new ChatAnthropic({

modelName: "claude-3-5-sonnet-20241022"

});

}

async handleRequest(message, requiresReasoning = false) {

// 简单任务用本地模型

if (!requiresReasoning) {

const response = await this.localModel.generate(message);

// 检查质量,不好的话升级到云端模型

if (this.isQualityLow(response)) {

return await this.cloudModel.invoke(message);

}

return response;

}

// 复杂推理任务直接用云端模型

return await this.cloudModel.invoke(message);

}

isQualityLow(response) {

// 简单的质量检查逻辑

return response.length < 50 || response.includes("抱歉");

}

}

在英博云的部署经验

我在英博云平台部署混合架构的步骤:

- 申请GPU实例:选择T4或V100卡,用来运行本地模型

- 部署本地模型:使用vLLM或Ollama部署千问、ChatGLM等开源模型

- 配置负载均衡:简单任务→本地模型,复杂任务→Claude API

- 监控切换:实时监控本地模型响应质量,必要时自动切换

部署配置示例:

# docker-compose.yml (英博云部署配置)

version: '3.8'

services:

local-llm:

image: vllm/vllm-openai:latest

runtime: nvidia

environment:

- MODEL=Qwen/Qwen2.5-7B-Instruct

ports:

- "8000:8000"

command: |

--model Qwen/Qwen2.5-7B-Instruct

--tensor-parallel-size 1

--max-model-len 4096

agent-service:

build: .

ports:

- "3000:3000"

environment:

- LOCAL_LLM_ENDPOINT=http://local-llm:8000

- CLAUDE_API_KEY=${CLAUDE_API_KEY}

depends_on:

- local-llm

成本对比:

- 纯云端方案:约$500/月(Claude API调用)

- 混合方案:约$150/月(英博云GPU实例 + 少量Claude调用)

- 节省70%成本

趋势四:工具调用(Function Calling)能力增强

从被动回答到主动执行

2025年的Agent还只是"聊天机器人",2026年的Agent已经能够主动执行任务了。

我实现的一个能调用工具的Agent:

// 定义工具集

const tools = [

{

name: "search_database",

description: "搜索数据库中的用户信息",

parameters: {

type: "object",

properties: {

user_id: { type: "string", description: "用户ID" },

fields: { type: "array", description: "需要查询的字段" }

},

required: ["user_id"]

},

function: async ({ user_id, fields }) => {

// 实际的数据库查询

const db = await getDatabase();

return await db.users.findOne({ id: user_id }, { projection: fields });

}

},

{

name: "send_email",

description: "发送邮件",

parameters: {

type: "object",

properties: {

to: { type: "string" },

subject: { type: "string" },

body: { type: "string" }

},

required: ["to", "subject", "body"]

},

function: async ({ to, subject, body }) => {

// 发送邮件逻辑

return await emailService.send({ to, subject, body });

}

}

];

// 带工具调用的Agent

async function agentWithTools(userMessage) {

const response = await fetch('https://api.anthropic.com/v1/messages', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'x-api-key': process.env.CLAUDE_API_KEY,

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: 'claude-3-5-sonnet-20241022',

max_tokens: 4096,

tools: tools.map(t => ({

name: t.name,

description: t.description,

input_schema: t.parameters

})),

messages: [{ role: 'user', content: userMessage }]

})

});

const data = await response.json();

// 检查是否需要调用工具

if (data.stop_reason === 'tool_use') {

const toolCalls = data.content.filter(c => c.type === 'tool_use');

// 执行所有工具调用

const toolResults = await Promise.all(

toolCalls.map(async (call) => {

const tool = tools.find(t => t.name === call.name);

const result = await tool.function(call.input);

return {

type: 'tool_result',

tool_use_id: call.id,

content: JSON.stringify(result)

};

})

);

// 将工具结果返回给模型继续处理

const finalResponse = await fetch('https://api.anthropic.com/v1/messages', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'x-api-key': process.env.CLAUDE_API_KEY,

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: 'claude-3-5-sonnet-20241022',

max_tokens: 4096,

tools: tools.map(t => ({

name: t.name,

description: t.description,

input_schema: t.parameters

})),

messages: [

{ role: 'user', content: userMessage },

{ role: 'assistant', content: data.content },

{ role: 'user', content: toolResults }

]

})

});

const finalData = await finalResponse.json();

return finalData.content[0].text;

}

return data.content[0].text;

}

// 使用示例

const result = await agentWithTools(

"查询用户ID为123的用户信息,并给他发一封欢迎邮件"

);

// Agent会自动:

// 1. 调用 search_database 查询用户信息

// 2. 调用 send_email 发送邮件

// 3. 返回执行结果

工具调用的最佳实践

从我的实践来看,有几个关键点:

- 工具描述要精确:模型需要准确理解工具的用途

- 参数验证要严格:不能让模型传入非法参数

- 错误处理要完善:工具调用失败要有兜底方案

- 权限控制要到位:不是所有工具都能随便调用

我踩过的坑:

// ❌ 错误示例:工具描述不清晰

{

name: "search",

description: "搜索东西", // 太模糊!

// ...

}

// ✅ 正确示例:描述精确

{

name: "search_user_orders",

description: "根据用户ID搜索该用户的所有订单记录,返回订单号、金额、状态等信息",

// ...

}

趋势五:Agent的可观测性和调试工具

黑盒变白盒

最痛苦的事情是什么?Agent出错了,但你不知道它在哪一步、为什么出错。

2026年,Agent的可观测性工具会大幅改进。我现在用的是LangSmith配合自己写的日志系统:

import { LangSmith } from "langsmith";

// 初始化追踪

const tracer = new LangSmith({

apiKey: process.env.LANGSMITH_API_KEY,

projectName: "my-agent-project"

});

// 带追踪的Agent

async function tracedAgent(message) {

return await tracer.trace("agent_execution", async () => {

// 第一步:理解用户意图

const intent = await tracer.trace("classify_intent", async () => {

return await classifyIntent(message);

});

// 第二步:执行相应操作

const result = await tracer.trace("execute_action", async () => {

return await executeAction(intent);

});

// 第三步:生成回复

const response = await tracer.trace("generate_response", async () => {

return await generateResponse(result);

});

return response;

});

}

// 自定义日志中间件

class AgentLogger {

constructor() {

this.logs = [];

}

logStep(step, input, output, metadata = {}) {

this.logs.push({

timestamp: new Date().toISOString(),

step,

input: this.truncate(input),

output: this.truncate(output),

tokens: metadata.tokens || 0,

cost: metadata.cost || 0,

duration: metadata.duration || 0

});

}

truncate(text, maxLength = 200) {

if (typeof text !== 'string') text = JSON.stringify(text);

return text.length > maxLength

? text.substring(0, maxLength) + '...'

: text;

}

export() {

return {

total_steps: this.logs.length,

total_tokens: this.logs.reduce((sum, log) => sum + log.tokens, 0),

total_cost: this.logs.reduce((sum, log) => sum + log.cost, 0),

total_duration: this.logs.reduce((sum, log) => sum + log.duration, 0),

steps: this.logs

};

}

}

// 使用示例

const logger = new AgentLogger();

async function debuggableAgent(message) {

const startTime = Date.now();

const intent = await classifyIntent(message);

logger.logStep('classify', message, intent, {

duration: Date.now() - startTime

});

const result = await executeAction(intent);

logger.logStep('execute', intent, result, {

tokens: 150,

cost: 0.002

});

console.log(logger.export());

// 输出:

// {

// total_steps: 2,

// total_tokens: 150,

// total_cost: 0.002,

// total_duration: 1250,

// steps: [...]

// }

return result;

}

我踩过的坑

坑1:过度依赖Prompt Engineering

问题:一开始我花了大量时间优化Prompt,结果发现效果不稳定。

解决:

- 简单任务用Few-shot示例

- 复杂任务用工具调用,而不是让模型硬猜

- 加入输出格式验证,确保结果可用

// ❌ 不好的做法:让模型猜测格式

const prompt = "分析这个用户评论,提取情感和关键词";

// ✅ 更好的做法:明确输出格式

const prompt = `分析这个用户评论,按以下JSON格式输出:

{

"sentiment": "positive/negative/neutral",

"keywords": ["关键词1", "关键词2"],

"confidence": 0.95

}`;

坑2:忽略成本控制

问题:一个复杂Agent可能需要多次调用API,成本很容易失控。

解决:

- 在英博云部署本地模型处理简单任务

- 设置单次对话的最大调用次数

- 缓存重复查询的结果

// 成本控制中间件

class CostController {

constructor(maxCostPerRequest = 0.1) {

this.maxCostPerRequest = maxCostPerRequest;

this.currentCost = 0;

}

async callModel(message, options = {}) {

const estimatedCost = this.estimateCost(message, options.model);

if (this.currentCost + estimatedCost > this.maxCostPerRequest) {

throw new Error(`成本超限: ${this.currentCost + estimatedCost} > ${this.maxCostPerRequest}`);

}

const result = await actualModelCall(message, options);

this.currentCost += estimatedCost;

return result;

}

estimateCost(message, model = 'claude-3-5-sonnet-20241022') {

const inputTokens = message.length / 4; // 粗略估算

const outputTokens = 1000; // 假设输出

const prices = {

'claude-3-5-sonnet-20241022': { input: 0.003, output: 0.015 }, // per 1K tokens

'gpt-4-turbo': { input: 0.01, output: 0.03 }

};

const price = prices[model];

return (inputTokens * price.input + outputTokens * price.output) / 1000;

}

}

坑3:没有做好错误处理

问题:API调用失败、超时、rate limit都会导致Agent崩溃。

解决:

// 带重试和降级的Agent

class RobustAgent {

async callWithRetry(fn, maxRetries = 3) {

for (let i = 0; i < maxRetries; i++) {

try {

return await fn();

} catch (error) {

if (error.status === 429) {

// Rate limit,等待后重试

await this.sleep(Math.pow(2, i) * 1000);

continue;

}

if (error.status === 500 || error.status === 503) {

// 服务端错误,重试

await this.sleep(1000);

continue;

}

if (i === maxRetries - 1) {

// 最后一次尝试失败,降级处理

return this.fallback();

}

}

}

}

fallback() {

return {

success: false,

message: "服务暂时不可用,请稍后重试"

};

}

sleep(ms) {

return new Promise(resolve => setTimeout(resolve, ms));

}

}

给前端开发者的建议

1. 从小项目开始

不要一上来就想做复杂的Multi-Agent系统。我的建议是:

第一周:做一个简单的聊天机器人,理解API调用

第二周:加入工具调用,让Agent能查询数据库

第三周:尝试LangChain/LangGraph,理解状态管理

第四周:部署到英博云,优化成本和性能

2. 利用前端优势

作为前端开发者,你有这些优势:

- 理解异步编程:Agent的多步骤执行就是Promise链

- 熟悉状态管理:LangGraph的状态机制很像Redux

- 擅长UI交互:可以做出更好的Agent交互界面

3. 关注这些资源

我学习过程中觉得有用的资源:

-

官方文档:

-

开源项目:

-

学习路径:

- 先学Prompt Engineering基础

- 再学LangChain/LangGraph框架

- 最后研究Multi-Agent架构

总结

2026年AI Agent的发展趋势,从我半年的实践来看,有这几个关键点:

- Multi-Agent成为主流:单打独斗变成团队协作

- 开发框架成熟:LangGraph、AutoGen等框架降低开发门槛

- 混合部署模式:云端+本地,成本和性能兼顾

- 工具调用增强:Agent不仅能聊天,还能执行任务

- 可观测性提升:调试工具让Agent从黑盒变白盒

作为前端开发者,这是一个很好的转型机会。AI Agent本质上就是"智能的前端应用",我们的异步编程、状态管理、UI交互经验都能用上。

我的建议是:别犹豫,动手开始做。在英博云平台申请一个GPU实例,部署你的第一个Agent,你会发现:原来AI离我们并不远。

后续我会继续分享更多实战经验,包括:

- 如何优化Agent的响应速度

- 如何设计可复用的Agent模板

- 如何做好Agent的安全防护

有问题欢迎交流!

参考资源

2026年AI Agent的趋势:从前端开发者的视角看智能体的未来

作为一个前端开发者,我在2025年底开始深入研究AI Agent。半年时间里,我在英博云平台部署了多个Agent应用,也踩了不少坑。这篇文章分享我对2026年AI Agent发展趋势的观察和思考。

写在前面

去年这个时候,我还在纠结要不要学AI。作为一个写了10年React的前端,突然要去理解什么LangChain、LangGraph、Prompt Engineering,说实话有点懵。但当我看到Claude、GPT-4这些大模型能够通过API调用实现复杂的业务逻辑时,我意识到:这不就是前端调接口吗?只不过这次接口返回的不是JSON数据,而是智能决策。

于是我开始在英博云平台部署自己的第一个Agent应用。半年过去了,我想和大家分享一下我观察到的2026年AI Agent的几个重要趋势。

趋势一:从单一Agent到Multi-Agent系统

我的实战经历

最初我做的第一个Agent很简单:一个客服机器人,接收用户问题,调用Claude API,返回答案。代码大概是这样的:

// 最初的简单Agent

async function simpleAgent(userMessage) {

const response = await fetch('https://api.anthropic.com/v1/messages', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'x-api-key': process.env.CLAUDE_API_KEY,

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: 'claude-3-5-sonnet-20241022',

max_tokens: 1024,

messages: [{ role: 'user', content: userMessage }]

})

});

const data = await response.json();

return data.content[0].text;

}

// 使用示例

const answer = await simpleAgent("如何使用你们的产品?");

console.log(answer);

这个方案工作得还可以,但问题很快就来了:

- 有些问题需要查询数据库

- 有些问题需要调用第三方API

- 有些问题需要多轮对话

- 有些问题需要不同专家角色来回答

这就是为什么2026年,Multi-Agent协作系统会成为主流。

Multi-Agent架构的演进

我后来重构成了这样的架构:

// Multi-Agent系统架构

class AgentOrchestrator {

constructor() {

this.agents = {

router: new RouterAgent(), // 路由Agent:判断问题类型

researcher: new ResearchAgent(), // 研究Agent:查找资料

coder: new CoderAgent(), // 编码Agent:生成代码

reviewer: new ReviewerAgent() // 审核Agent:质量把关

};

}

async handleTask(task) {

// 1. 路由Agent判断任务类型

const taskType = await this.agents.router.classify(task);

// 2. 根据类型选择合适的Agent

switch(taskType) {

case 'research':

const findings = await this.agents.researcher.search(task);

return await this.agents.reviewer.review(findings);

case 'coding':

const code = await this.agents.coder.generate(task);

const review = await this.agents.reviewer.checkCode(code);

// 如果审核不通过,让Coder修改

if (!review.passed) {

return await this.agents.coder.revise(code, review.feedback);

}

return code;

default:

return await this.agents.router.handleGeneral(task);

}

}

}

// 实际使用

const orchestrator = new AgentOrchestrator();

const result = await orchestrator.handleTask("帮我写一个React组件");

为什么Multi-Agent是趋势?

从我的实践来看,Multi-Agent有这些明显优势:

- 专业分工:每个Agent专注做好一件事,就像前端团队里有人专门做组件库,有人专门做性能优化

- 质量保证:通过Reviewer Agent审核,避免了单一Agent可能的错误

- 可扩展性:需要新功能?加一个新Agent就好,不用改动现有逻辑

- 调试友好:出问题了可以单独调试某个Agent,而不是整个系统

趋势二:Agent开发框架的成熟

从手写到框架

最开始我是手写所有逻辑的,直到我发现了LangGraph。这个框架让我意识到:Agent开发正在从"手工作坊"走向"工业化生产"。

我在英博云平台部署的一个LangGraph应用:

import { StateGraph } from "@langchain/langgraph";

import { ChatAnthropic } from "@langchain/anthropic";

// 定义状态

interface AgentState {

messages: any[];

currentStep: string;

result?: string;

}

// 创建模型实例

const model = new ChatAnthropic({

modelName: "claude-3-5-sonnet-20241022",

anthropicApiKey: process.env.CLAUDE_API_KEY,

});

// 定义Agent节点

const researchNode = async (state: AgentState) => {

const response = await model.invoke([

{ role: "system", content: "你是一个专业的研究员" },

...state.messages

]);

return {

...state,

messages: [...state.messages, response],

currentStep: "research_done"

};

};

const writeNode = async (state: AgentState) => {

const response = await model.invoke([

{ role: "system", content: "你是一个专业的作家" },

...state.messages

]);

return {

...state,

result: response.content,

currentStep: "completed"

};

};

// 构建工作流

const workflow = new StateGraph<AgentState>({

channels: {

messages: null,

currentStep: null,

result: null

}

})

.addNode("research", researchNode)

.addNode("write", writeNode)

.addEdge("research", "write")

.setEntryPoint("research");

const app = workflow.compile();

// 执行

const result = await app.invoke({

messages: [{ role: "user", content: "写一篇关于React 19的文章" }],

currentStep: "start"

});

console.log(result.result);

2026年主流框架对比

基于我的使用经验,这些框架各有千秋:

| 框架 | 优势 | 适用场景 | 学习曲线 |

|---|---|---|---|

| LangGraph | 可视化工作流,状态管理强大 | 复杂多步骤Agent | 中等 |

| AutoGen | 多Agent对话机制完善 | 团队协作式Agent | 较陡 |

| CrewAI | 角色定义清晰,易上手 | 快速原型开发 | 平缓 |

| Semantic Kernel | 微软生态,与Azure集成好 | 企业级应用 | 中等 |

我个人最推荐LangGraph,原因很简单:它的状态管理机制很像Redux,前端开发者理解起来毫无压力。

趋势三:本地部署与云端部署的混合架构

我的踩坑经历

最开始,我把所有逻辑都部署在云端。结果发现:

- 成本问题:Claude API调用频繁,一个月账单吓人

- 延迟问题:每次调用都要等几秒,用户体验不好

- 隐私问题:有些企业客户不允许数据出境

于是我尝试了混合架构:

// 混合架构示例

class HybridAgent {

constructor() {

// 本地部署的小模型(在英博云GPU实例上)

this.localModel = new LocalLLM({

endpoint: 'http://ebcloud-gpu-instance:8000',

model: 'qwen2.5-7b' // 本地部署的千问模型

});

// 云端大模型

this.cloudModel = new ChatAnthropic({

modelName: "claude-3-5-sonnet-20241022"

});

}

async handleRequest(message, requiresReasoning = false) {

// 简单任务用本地模型

if (!requiresReasoning) {

const response = await this.localModel.generate(message);

// 检查质量,不好的话升级到云端模型

if (this.isQualityLow(response)) {

return await this.cloudModel.invoke(message);

}

return response;

}

// 复杂推理任务直接用云端模型

return await this.cloudModel.invoke(message);

}

isQualityLow(response) {

// 简单的质量检查逻辑

return response.length < 50 || response.includes("抱歉");

}

}

在英博云的部署经验

我在英博云平台部署混合架构的步骤:

- 申请GPU实例:选择T4或V100卡,用来运行本地模型

- 部署本地模型:使用vLLM或Ollama部署千问、ChatGLM等开源模型

- 配置负载均衡:简单任务→本地模型,复杂任务→Claude API

- 监控切换:实时监控本地模型响应质量,必要时自动切换

部署配置示例:

# docker-compose.yml (英博云部署配置)

version: '3.8'

services:

local-llm:

image: vllm/vllm-openai:latest

runtime: nvidia

environment:

- MODEL=Qwen/Qwen2.5-7B-Instruct

ports:

- "8000:8000"

command: |

--model Qwen/Qwen2.5-7B-Instruct

--tensor-parallel-size 1

--max-model-len 4096

agent-service:

build: .

ports:

- "3000:3000"

environment:

- LOCAL_LLM_ENDPOINT=http://local-llm:8000

- CLAUDE_API_KEY=${CLAUDE_API_KEY}

depends_on:

- local-llm

成本对比:

- 纯云端方案:约$500/月(Claude API调用)

- 混合方案:约$150/月(英博云GPU实例 + 少量Claude调用)

- 节省70%成本

趋势四:工具调用(Function Calling)能力增强

从被动回答到主动执行

2025年的Agent还只是"聊天机器人",2026年的Agent已经能够主动执行任务了。

我实现的一个能调用工具的Agent:

// 定义工具集

const tools = [

{

name: "search_database",

description: "搜索数据库中的用户信息",

parameters: {

type: "object",

properties: {

user_id: { type: "string", description: "用户ID" },

fields: { type: "array", description: "需要查询的字段" }

},

required: ["user_id"]

},

function: async ({ user_id, fields }) => {

// 实际的数据库查询

const db = await getDatabase();

return await db.users.findOne({ id: user_id }, { projection: fields });

}

},

{

name: "send_email",

description: "发送邮件",

parameters: {

type: "object",

properties: {

to: { type: "string" },

subject: { type: "string" },

body: { type: "string" }

},

required: ["to", "subject", "body"]

},

function: async ({ to, subject, body }) => {

// 发送邮件逻辑

return await emailService.send({ to, subject, body });

}

}

];

// 带工具调用的Agent

async function agentWithTools(userMessage) {

const response = await fetch('https://api.anthropic.com/v1/messages', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'x-api-key': process.env.CLAUDE_API_KEY,

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: 'claude-3-5-sonnet-20241022',

max_tokens: 4096,

tools: tools.map(t => ({

name: t.name,

description: t.description,

input_schema: t.parameters

})),

messages: [{ role: 'user', content: userMessage }]

})

});

const data = await response.json();

// 检查是否需要调用工具

if (data.stop_reason === 'tool_use') {

const toolCalls = data.content.filter(c => c.type === 'tool_use');

// 执行所有工具调用

const toolResults = await Promise.all(

toolCalls.map(async (call) => {

const tool = tools.find(t => t.name === call.name);

const result = await tool.function(call.input);

return {

type: 'tool_result',

tool_use_id: call.id,

content: JSON.stringify(result)

};

})

);

// 将工具结果返回给模型继续处理

const finalResponse = await fetch('https://api.anthropic.com/v1/messages', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'x-api-key': process.env.CLAUDE_API_KEY,

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: 'claude-3-5-sonnet-20241022',

max_tokens: 4096,

tools: tools.map(t => ({

name: t.name,

description: t.description,

input_schema: t.parameters

})),

messages: [

{ role: 'user', content: userMessage },

{ role: 'assistant', content: data.content },

{ role: 'user', content: toolResults }

]

})

});

const finalData = await finalResponse.json();

return finalData.content[0].text;

}

return data.content[0].text;

}

// 使用示例

const result = await agentWithTools(

"查询用户ID为123的用户信息,并给他发一封欢迎邮件"

);

// Agent会自动:

// 1. 调用 search_database 查询用户信息

// 2. 调用 send_email 发送邮件

// 3. 返回执行结果

工具调用的最佳实践

从我的实践来看,有几个关键点:

- 工具描述要精确:模型需要准确理解工具的用途

- 参数验证要严格:不能让模型传入非法参数

- 错误处理要完善:工具调用失败要有兜底方案

- 权限控制要到位:不是所有工具都能随便调用

我踩过的坑:

// ❌ 错误示例:工具描述不清晰

{

name: "search",

description: "搜索东西", // 太模糊!

// ...

}

// ✅ 正确示例:描述精确

{

name: "search_user_orders",

description: "根据用户ID搜索该用户的所有订单记录,返回订单号、金额、状态等信息",

// ...

}

趋势五:Agent的可观测性和调试工具

黑盒变白盒

最痛苦的事情是什么?Agent出错了,但你不知道它在哪一步、为什么出错。

2026年,Agent的可观测性工具会大幅改进。我现在用的是LangSmith配合自己写的日志系统:

import { LangSmith } from "langsmith";

// 初始化追踪

const tracer = new LangSmith({

apiKey: process.env.LANGSMITH_API_KEY,

projectName: "my-agent-project"

});

// 带追踪的Agent

async function tracedAgent(message) {

return await tracer.trace("agent_execution", async () => {

// 第一步:理解用户意图

const intent = await tracer.trace("classify_intent", async () => {

return await classifyIntent(message);

});

// 第二步:执行相应操作

const result = await tracer.trace("execute_action", async () => {

return await executeAction(intent);

});

// 第三步:生成回复

const response = await tracer.trace("generate_response", async () => {

return await generateResponse(result);

});

return response;

});

}

// 自定义日志中间件

class AgentLogger {

constructor() {

this.logs = [];

}

logStep(step, input, output, metadata = {}) {

this.logs.push({

timestamp: new Date().toISOString(),

step,

input: this.truncate(input),

output: this.truncate(output),

tokens: metadata.tokens || 0,

cost: metadata.cost || 0,

duration: metadata.duration || 0

});

}

truncate(text, maxLength = 200) {

if (typeof text !== 'string') text = JSON.stringify(text);

return text.length > maxLength

? text.substring(0, maxLength) + '...'

: text;

}

export() {

return {

total_steps: this.logs.length,

total_tokens: this.logs.reduce((sum, log) => sum + log.tokens, 0),

total_cost: this.logs.reduce((sum, log) => sum + log.cost, 0),

total_duration: this.logs.reduce((sum, log) => sum + log.duration, 0),

steps: this.logs

};

}

}

// 使用示例

const logger = new AgentLogger();

async function debuggableAgent(message) {

const startTime = Date.now();

const intent = await classifyIntent(message);

logger.logStep('classify', message, intent, {

duration: Date.now() - startTime

});

const result = await executeAction(intent);

logger.logStep('execute', intent, result, {

tokens: 150,

cost: 0.002

});

console.log(logger.export());

// 输出:

// {

// total_steps: 2,

// total_tokens: 150,

// total_cost: 0.002,

// total_duration: 1250,

// steps: [...]

// }

return result;

}

我踩过的坑

坑1:过度依赖Prompt Engineering

问题:一开始我花了大量时间优化Prompt,结果发现效果不稳定。

解决:

- 简单任务用Few-shot示例

- 复杂任务用工具调用,而不是让模型硬猜

- 加入输出格式验证,确保结果可用

// ❌ 不好的做法:让模型猜测格式

const prompt = "分析这个用户评论,提取情感和关键词";

// ✅ 更好的做法:明确输出格式

const prompt = `分析这个用户评论,按以下JSON格式输出:

{

"sentiment": "positive/negative/neutral",

"keywords": ["关键词1", "关键词2"],

"confidence": 0.95

}`;

坑2:忽略成本控制

问题:一个复杂Agent可能需要多次调用API,成本很容易失控。

解决:

- 在英博云部署本地模型处理简单任务

- 设置单次对话的最大调用次数

- 缓存重复查询的结果

// 成本控制中间件

class CostController {

constructor(maxCostPerRequest = 0.1) {

this.maxCostPerRequest = maxCostPerRequest;

this.currentCost = 0;

}

async callModel(message, options = {}) {

const estimatedCost = this.estimateCost(message, options.model);

if (this.currentCost + estimatedCost > this.maxCostPerRequest) {

throw new Error(`成本超限: ${this.currentCost + estimatedCost} > ${this.maxCostPerRequest}`);

}

const result = await actualModelCall(message, options);

this.currentCost += estimatedCost;

return result;

}

estimateCost(message, model = 'claude-3-5-sonnet-20241022') {

const inputTokens = message.length / 4; // 粗略估算

const outputTokens = 1000; // 假设输出

const prices = {

'claude-3-5-sonnet-20241022': { input: 0.003, output: 0.015 }, // per 1K tokens

'gpt-4-turbo': { input: 0.01, output: 0.03 }

};

const price = prices[model];

return (inputTokens * price.input + outputTokens * price.output) / 1000;

}

}

坑3:没有做好错误处理

问题:API调用失败、超时、rate limit都会导致Agent崩溃。

解决:

// 带重试和降级的Agent

class RobustAgent {

async callWithRetry(fn, maxRetries = 3) {

for (let i = 0; i < maxRetries; i++) {

try {

return await fn();

} catch (error) {

if (error.status === 429) {

// Rate limit,等待后重试

await this.sleep(Math.pow(2, i) * 1000);

continue;

}

if (error.status === 500 || error.status === 503) {

// 服务端错误,重试

await this.sleep(1000);

continue;

}

if (i === maxRetries - 1) {

// 最后一次尝试失败,降级处理

return this.fallback();

}

}

}

}

fallback() {

return {

success: false,

message: "服务暂时不可用,请稍后重试"

};

}

sleep(ms) {

return new Promise(resolve => setTimeout(resolve, ms));

}

}

给前端开发者的建议

1. 从小项目开始

不要一上来就想做复杂的Multi-Agent系统。我的建议是:

第一周:做一个简单的聊天机器人,理解API调用

第二周:加入工具调用,让Agent能查询数据库

第三周:尝试LangChain/LangGraph,理解状态管理

第四周:部署到英博云,优化成本和性能

2. 利用前端优势

作为前端开发者,你有这些优势:

- 理解异步编程:Agent的多步骤执行就是Promise链

- 熟悉状态管理:LangGraph的状态机制很像Redux

- 擅长UI交互:可以做出更好的Agent交互界面

3. 关注这些资源

我学习过程中觉得有用的资源:

-

官方文档:

-

开源项目:

-

学习路径:

- 先学Prompt Engineering基础

- 再学LangChain/LangGraph框架

- 最后研究Multi-Agent架构

总结

2026年AI Agent的发展趋势,从我半年的实践来看,有这几个关键点:

- Multi-Agent成为主流:单打独斗变成团队协作

- 开发框架成熟:LangGraph、AutoGen等框架降低开发门槛

- 混合部署模式:云端+本地,成本和性能兼顾

- 工具调用增强:Agent不仅能聊天,还能执行任务

- 可观测性提升:调试工具让Agent从黑盒变白盒

作为前端开发者,这是一个很好的转型机会。AI Agent本质上就是"智能的前端应用",我们的异步编程、状态管理、UI交互经验都能用上。

我的建议是:别犹豫,动手开始做。在英博云平台(https://www.ebcloud.com/chn_a6mfbgsc)申请一个GPU实例,部署你的第一个Agent,你会发现:原来AI离我们并不远。

后续我会继续分享更多实战经验,包括:

- 如何优化Agent的响应速度

- 如何设计可复用的Agent模板

- 如何做好Agent的安全防护

有问题欢迎交流!

参考资源

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)