提示系统性能优化:负载均衡策略的智能演进

从传统轮询到智能负载均衡,演进的核心不是“技术更复杂”,而是“更贴近用户需求”——传统策略关注“如何分配流量”;智能策略关注“如何让流量分配更符合用户的体验(响应时间)和系统的效率(资源利用率)”。若场景简单(如静态文件服务):用传统策略+实时权重调整即可;若场景复杂(如混合AI推理和电商):用机器学习模型优化;若场景对延迟敏感(如直播、边缘计算):用边缘负载均衡。智能负载均衡不是“取代人”,而是

提示系统性能优化:负载均衡策略的智能演进

引言:从“救火式运维”到“主动式优化”的痛点

凌晨3点,电商平台的运维工程师突然被告警惊醒——某台服务器的CPU利用率飙升至95%,响应时间从50ms陡增至500ms,而相邻的两台服务器却空闲着(CPU利用率仅30%)。原因很简单:传统轮询负载均衡把流量平均分配给了所有服务器,但其中一台服务器刚部署了一个CPU密集型的促销活动计算逻辑,无法承受平均流量。

同样的困境也出现在AI推理场景:某计算机视觉公司的GPU集群中,处理1080p图像的请求让GPU A的显存占满,而处理720p图像的请求却让GPU B闲着——传统“最少连接”策略只看连接数,不看请求的计算复杂度,导致资源浪费高达40%。

这些场景暴露了传统负载均衡的核心缺陷:

- 依赖静态规则或周期性快照,无法实时感知服务器状态变化;

- 基于通用假设(如“所有请求的资源消耗相同”),无法适配动态业务场景;

- 被动响应问题,而非主动预测和预防。

当系统从“百万级并发”走向“亿级并发”,从“单一业务”走向“混合场景”(电商+直播+AI),传统负载均衡已成为性能瓶颈。此时,智能负载均衡应运而生——它像一个“系统调度大脑”,能实时感知状态、预测趋势、动态调整策略,让流量分配从“平均主义”走向“精准适配”。

基础篇:负载均衡的核心逻辑与传统策略

在讲智能演进前,我们需要先厘清负载均衡的本质:将流量合理分配到多个服务器/实例,以实现“高可用、高并发、资源最优”三大目标。

1. 负载均衡的核心目标

- 高可用:避免单点故障,当某台服务器宕机时,流量自动切换到其他服务器;

- 高并发:通过水平扩展,支撑更大的流量(如秒杀场景的10万QPS);

- 资源最优:让所有服务器的资源利用率尽可能均衡(避免“忙的忙死,闲的闲死”)。

2. 传统负载均衡策略:原理与局限

传统策略基于静态规则或简单动态指标,实现成本低但适应性差。我们逐一分析:

(1)轮询(Round Robin)

- 原理:按顺序将请求分配给每个服务器(如A→B→C→A→…)。

- 适用场景:所有服务器性能一致、请求资源消耗均匀(如静态文件服务)。

- 局限:完全不考虑服务器状态——若某台服务器过载,仍会分配流量,导致响应时间飙升。

(2)加权轮询(Weighted Round Robin)

- 原理:给性能好的服务器分配更高权重(如A权重3、B权重2,每5个请求中A处理3个,B处理2个)。

- 适用场景:服务器性能差异明确(如高配服务器vs低配服务器)。

- 局限:权重是静态配置的,无法实时调整——若某台服务器的性能因负载骤增下降,权重不会自动降低。

(3)最少连接(Least Connections)

- 原理:将请求分配给当前连接数最少的服务器。

- 适用场景:请求持续时间较长(如文件上传、数据库连接)。

- 局限:只看“连接数”,不看“连接的资源消耗”——比如一个AI推理请求的资源消耗可能是普通请求的10倍,连接数少但负载更高。

(4)IP哈希(IP Hash)

- 原理:根据客户端IP的哈希值分配服务器,保证同一客户端的请求始终落到同一台服务器(会话粘滞)。

- 适用场景:需要保持会话状态的应用(如购物车、用户登录)。

- 局限:若某台服务器宕机,该IP的所有请求会切换到其他服务器,可能导致负载不均;同时无法应对动态扩容(新服务器无法分担流量)。

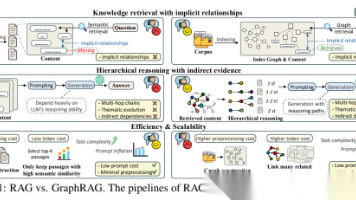

演进篇:智能负载均衡的四大方向

智能负载均衡的核心是**“感知-决策-执行”的闭环**:通过实时采集数据感知系统状态,用算法/模型决策最优策略,最后动态调整流量分配。其演进方向可总结为四点:

方向1:从“静态规则”到“实时状态感知”——让策略“看得见”

传统策略的致命缺陷是**“信息差”:负载均衡器不知道服务器当前的真实状态(如CPU瞬时负载、GPU显存利用率)。智能负载均衡的第一步,是用实时数据消除信息差**。

(1)实时指标采集:从“周期性快照”到“流式感知”

要实现实时感知,需要采集细粒度、低延迟的指标:

- 服务器指标:CPU瞬时负载(而非平均负载)、内存活跃使用率、GPU显存占用、磁盘IO队列长度、网络带宽利用率;

- 请求指标:请求类型(如AI推理/静态文件)、请求大小(如1080p图像/720p图像)、响应时间;

- 业务指标:促销活动时段、直播观看人数、新用户注册量。

工具选型:

- 传统采集:Prometheus(周期性拉取,间隔15秒)、Zabbix;

- 实时采集:eBPF(内核级采集,延迟<100ms)、Fluentd(流式日志采集)、OpenTelemetry(全链路遥测)。

比如,用eBPF采集CPU运行队列长度(反映CPU的繁忙程度):

// eBPF程序:采集CPU运行队列长度

#include <uapi/linux/ptrace.h>

#include <linux/sched.h>

BPF_HASH(runqueue_len, u32); // 存储每个CPU的运行队列长度

int trace_schedule(struct pt_regs *ctx) {

u32 cpu = bpf_get_smp_processor_id();

struct rq *rq = (struct rq *)ctx->di; // 从pt_regs获取rq结构体

u32 len = rq->nr_running + rq->nr_uninterruptible; // 运行队列长度=运行中+不可中断

runqueue_len.update(&cpu, &len);

return 0;

}

这段程序能实时获取每个CPU的运行队列长度(延迟<100ms),负载均衡器可根据该指标动态调整流量——若某台服务器的CPU运行队列长度超过阈值(如8),则暂时减少其流量分配。

(2)动态权重调整:从“手动配置”到“自动计算”

实时感知数据后,需要将其转化为动态权重。常见的动态策略有:

- Least Time(最少响应时间):Nginx的

ngx_http_upstream_module支持的策略,选择“当前连接数/响应时间”最小的服务器(兼顾连接数和响应速度); - Resource-Based Weighting(基于资源的权重):根据服务器的实时资源利用率计算权重(如CPU负载越低,权重越高);

- Request-Based Routing(基于请求的路由):根据请求的特征(如AI推理请求→GPU服务器,静态文件→CDN)分配流量。

案例:某视频平台用“基于请求的路由”优化负载均衡——将1080p视频请求分配给GPU编码服务器,720p视频请求分配给CPU编码服务器,让资源利用率提升了35%,编码延迟降低了20%。

方向2:从“被动响应”到“主动预测”——让策略“算得到”

实时感知能解决“当前的问题”,但无法应对“未来的问题”(如大促流量突增、直播热点爆发)。智能负载均衡的第二步,是用预测模型提前布局。

(1)时间序列预测:预测流量趋势

时间序列预测是最常用的预测方法,核心是用历史数据预测未来的流量模式。常见模型有:

- ARIMA:适用于线性趋势的流量(如日常用户访问);

- LSTM:适用于非线性、长周期的流量(如大促、直播);

- Prophet:Facebook开源的模型,适用于有季节效应的流量(如节日促销)。

案例:某电商平台用LSTM模型预测大促流量——

- 收集过去3年的大促数据(流量峰值、请求类型、服务器负载);

- 训练LSTM模型,输入“当前时间、促销活动阶段、历史流量”,输出“未来1小时的流量预测值”;

- 负载均衡器根据预测值提前调整权重:将流量向性能更好的服务器倾斜(如高配服务器权重从30%提升到50%),同时触发自动扩容(新增10台服务器)。

结果:大促期间服务器的CPU利用率从平均60%提升到80%,响应时间降低了25%,未出现过载情况。

(2)异常检测:预防故障扩散

预测不仅能应对流量增长,还能提前发现异常(如服务器性能下降、网络抖动)。常见的异常检测方法有:

- 统计方法:基于3σ原则(超过均值±3倍标准差视为异常);

- 机器学习方法:Isolation Forest(孤立森林)、One-Class SVM(一类支持向量机);

- 深度学习方法:AutoEncoder(自编码器)——用正常数据训练模型,若输入异常数据,重构误差会显著升高。

案例:某金融平台用AutoEncoder检测服务器异常——

- 用正常状态的服务器指标(CPU、内存、IO)训练自编码器;

- 实时输入服务器的指标数据,计算重构误差;

- 若重构误差超过阈值(如均值的2倍),则标记该服务器为“异常”,负载均衡器自动将流量从该服务器转移。

结果:故障响应时间从10分钟缩短到1分钟,客户投诉率降低了40%。

方向3:从“规则驱动”到“数据驱动”——让策略“学得到”

传统策略和预测策略都依赖人工设计的规则(如“CPU负载超过80%则减少权重”),但面对复杂场景(如混合了电商、直播、AI的系统),人工规则无法覆盖所有情况。智能负载均衡的第三步,是用机器学习让策略自动“学习”最优解。

(1)监督学习:预测“最优服务器”

监督学习的核心是用历史数据训练模型,预测每个服务器处理当前请求的性能。步骤如下:

- 数据收集:收集历史请求数据(请求类型、大小、到达时间)、服务器状态(CPU、内存、GPU利用率)、响应时间;

- 特征工程:将原始数据转化为模型可处理的特征(如“请求类型=AI推理”→1,“请求类型=静态文件”→0;“CPU负载”→归一化到0~1);

- 模型训练:用回归模型(如XGBoost、LightGBM)预测“某服务器处理当前请求的响应时间”;

- 策略执行:负载均衡器选择“预测响应时间最短”的服务器。

案例:某AI公司用XGBoost优化GPU负载均衡——

- 输入特征:请求类型(图像识别/NLP)、输入大小(图像像素/token数)、GPU显存利用率、GPU计算利用率;

- 输出:该GPU处理请求的预测响应时间;

- 策略:选择预测响应时间最短的GPU。

结果:GPU利用率从50%提升到75%,推理延迟降低了30%。

(2)强化学习:让策略“自主进化”

监督学习需要大量标注数据(如“某请求在某服务器的响应时间”),而强化学习(Reinforcement Learning, RL)不需要——它通过**“试错”学习最优策略**。核心概念:

- Agent:负载均衡器的决策模块;

- State:当前系统状态(所有服务器的负载、请求特征);

- Action:选择将请求分配给哪台服务器;

- Reward:奖励函数(如“响应时间越短,奖励越高;资源利用率越高,奖励越高”)。

案例:Google Borg系统的负载均衡策略——

Borg是Google内部的集群管理系统,支撑了搜索、YouTube等服务。其负载均衡策略用强化学习实现:

- State:集群中每个任务的资源需求(CPU、内存)、每个服务器的剩余资源;

- Action:将任务调度到某台服务器;

- Reward:任务的完成时间(Makespan)的倒数 + 服务器资源利用率的正数。

结果:Borg的任务调度效率比传统策略高20%,集群资源利用率提升了15%。

方向4:从“通用场景”到“定制场景”——让策略“贴得紧”

不同业务场景的负载特征差异极大,通用智能策略无法满足所有需求。智能负载均衡的第四步,是针对特定场景定制策略。

(1)AI推理场景:兼顾“计算复杂度”与“GPU状态”

AI推理请求的资源消耗差异极大(如1080p图像识别的GPU显存占用是720p的2倍),传统策略无法适配。定制策略需要:

- 请求特征提取:提取请求的计算复杂度(如图像像素、token长度、模型层数);

- GPU状态感知:实时采集GPU的显存利用率、计算利用率、温度;

- 调度逻辑:将高复杂度请求分配给高配置GPU(如A100),低复杂度请求分配给低配置GPU(如T4);同时避免GPU显存溢出。

工具:NVIDIA Triton Inference Server(支持基于模型和GPU状态的负载均衡)、TensorFlow Serving(支持动态批处理和负载均衡)。

(2)微服务场景:适配“服务类型”与“实例状态”

微服务架构中,不同服务的资源需求差异大(如“订单服务”是CPU密集型,“支付服务”是IO密集型)。定制策略需要:

- 服务类型标记:给每个服务实例打上标签(如

type: cpu-intensive、type: io-intensive); - 实例状态感知:实时采集实例的CPU利用率(针对CPU密集型)、磁盘IO队列长度(针对IO密集型);

- 调度逻辑:将CPU密集型请求分配给CPU利用率低的实例,IO密集型请求分配给IO利用率低的实例。

工具:Istio(支持基于服务标签和遥测数据的流量管理)、Linkerd(轻量级服务网格,支持动态负载均衡)。

(3)边缘计算场景:降低“延迟”与“带宽”

边缘计算场景中,流量需要分配到边缘节点(如5G基站、CDN节点),以降低延迟和带宽消耗。定制策略需要:

- 用户位置感知:通过GPS或IP地址获取用户的地理位置;

- 边缘节点状态:实时采集边缘节点的负载、带宽、延迟;

- 调度逻辑:将用户请求分配给“距离最近、负载最低”的边缘节点。

工具:Cloudflare Argo(边缘负载均衡)、AWS Global Accelerator(全球边缘加速)。

实践篇:如何落地智能负载均衡?

讲了这么多理论,我们来聊一聊如何从0到1落地智能负载均衡。落地流程可分为四步:数据采集→模型训练→策略集成→监控反馈。

1. 数据采集层:构建“感知网络”

数据是智能负载均衡的基础,需要采集全链路、多维度的数据:

- 服务器层:用eBPF采集CPU、内存、GPU的实时指标;用Prometheus采集周期性指标(如15秒一次的平均负载);

- 请求层:用Nginx的

access_log或Envoy的AccessLogService采集请求的类型、大小、响应时间; - 业务层:用 Kafka 采集业务事件(如促销活动开始、直播开播)。

注意:数据采集需要低侵入性——eBPF是内核级采集,不会影响应用性能;Prometheus用拉模式,不会给服务器造成压力。

2. 模型层:选择“合适的算法”

模型选择要根据场景和数据量:

- 若场景简单(如静态文件服务):用传统策略+实时权重调整即可;

- 若场景有明显趋势(如大促流量):用LSTM或Prophet做时间序列预测;

- 若场景复杂(如混合AI推理和电商):用XGBoost(监督学习)或强化学习。

小技巧:

- 用在线学习(如FTRL、SGD)实时更新模型参数,适应新的流量模式;

- 用模型压缩(如量化、剪枝)将大模型部署到负载均衡器(如Nginx、Envoy),避免延迟。

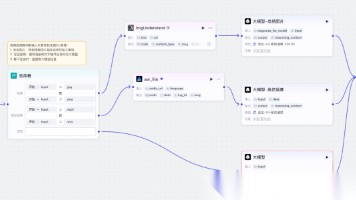

3. 策略执行层:集成到负载均衡器

智能策略需要集成到现有的负载均衡器中,常见的集成方式:

- Nginx:用Lua脚本(

lua-nginx-module)实现自定义策略(如基于实时CPU负载调整权重); - Envoy:用Filter(如

Lua Filter、Wasm Filter)实现动态路由; - Kubernetes:用

kube-scheduler的自定义调度器(如基于GPU状态调度Pod); - 服务网格:用Istio的

VirtualService和DestinationRule配置智能路由(如基于请求类型分配流量)。

代码示例:Nginx Lua实现基于实时CPU负载的动态权重调整(简化版):

-- 从Prometheus获取服务器的CPU负载

local function get_cpu_loads()

local res = ngx.location.capture("/prometheus/query", {

args = { query = "1 - avg by (instance) (node_cpu_seconds_total{mode='idle'})" }

})

local data = cjson.decode(res.body)

local loads = {}

for _, r in ipairs(data.data.result) do

loads[r.metric.instance] = tonumber(r.value[2])

end

return loads

end

-- 计算权重:CPU负载越低,权重越高

local function calc_weights(loads)

local total = 0

local weights = {}

for inst, load in pairs(loads) do

weights[inst] = 1 / (load + 0.1) -- 避免除以0

total = total + weights[inst]

end

-- 归一化权重(总和为100)

for inst, w in pairs(weights) do

weights[inst] = w / total * 100

end

return weights

end

-- 更新Nginx upstream的权重

local function update_upstream(weights)

local upstream = ngx.shared.upstream

for inst, w in pairs(weights) do

upstream:set(inst, w)

end

ngx.say("Upstream weights updated: ", cjson.encode(weights))

end

-- 主逻辑

local loads = get_cpu_loads()

local weights = calc_weights(loads)

update_upstream(weights)

4. 监控反馈层:形成“闭环优化”

智能策略不是“一劳永逸”的,需要实时监控效果并迭代优化:

- 效果指标:响应时间(RT)、错误率(Error Rate)、资源利用率(CPU/GPU/内存)、流量分配均匀度(如各服务器的流量差异<10%);

- 监控工具:Grafana(可视化指标)、Alertmanager(异常告警)、Jaeger(全链路追踪);

- 迭代优化:若某策略的响应时间升高,需分析原因(如模型预测不准确→更新训练数据;数据延迟→改用eBPF采集)。

避坑篇:智能负载均衡的常见问题与解决

1. 数据延迟:实时感知变成“滞后感知”

- 问题:Prometheus的采集间隔是15秒,导致负载均衡器拿到的是15秒前的状态;

- 解决:用eBPF采集实时指标(延迟<100ms),或用流式处理框架(如Flink)处理实时数据。

2. 模型过拟合:“历史经验”无法应对“新场景”

- 问题:模型用正常流量训练,遇到大促等突发流量时预测不准确;

- 解决:用在线学习实时更新模型参数,或用数据增强(如模拟大促流量)扩充训练数据。

3. 策略切换:“急刹车”导致系统波动

- 问题:若某台服务器突然过载,负载均衡器立即将所有流量转移,导致其他服务器瞬间压力骤增;

- 解决:用平滑切换策略——逐步降低过载服务器的权重(如每秒降低5%),同时逐步升高其他服务器的权重。

4. 复杂度高:“智能”变成“负担”

- 问题:机器学习模型需要大量计算资源,负载均衡器无法承受;

- 解决:用轻量级模型(如线性回归、决策树)替代复杂模型,或用边缘计算将模型部署到边缘节点(如CDN节点)。

未来篇:智能负载均衡的趋势

1. 大模型与智能调度:从“数据驱动”到“知识驱动”

大语言模型(LLM)如GPT-4、Claude 3具备理解复杂场景的能力,未来可用于智能负载均衡:

- 场景理解:LLM分析业务事件(如“双11促销开始”)和历史数据,生成“大促期间的负载均衡策略”;

- 策略优化:LLM根据实时监控数据,自动调整策略(如“某服务器的GPU利用率超过90%,请将AI推理请求转移到其他服务器”);

- 故障排查:LLM分析异常日志,定位负载均衡的问题(如“请求分配不均是因为某台服务器的网络带宽被限流”)。

2. 边缘-云协同:从“集中式”到“分布式”

边缘计算的普及,让负载均衡从“云中心”延伸到“边缘节点”:

- 边缘负载均衡:将流量分配到距离用户最近的边缘节点,降低延迟(如直播场景的延迟从500ms降到100ms);

- 云-边缘协同:边缘节点无法处理的流量(如大促峰值)自动回传到云中心,实现“边缘处理常规流量,云处理峰值流量”。

3. 自修复系统:从“主动预测”到“自动修复”

未来的智能负载均衡将与自修复系统结合:

- 故障预测:用机器学习模型预测服务器故障(如“某服务器的硬盘IO延迟持续升高,将在10分钟后宕机”);

- 自动修复:负载均衡器自动将流量从故障服务器转移,同时触发自动扩容(新增服务器);

- 根因分析:自动定位故障原因(如“硬盘IO延迟升高是因为磁盘坏道”),并通知运维工程师修复。

总结:智能负载均衡的本质是“以用户为中心”

从传统轮询到智能负载均衡,演进的核心不是“技术更复杂”,而是“更贴近用户需求”——

- 传统策略关注“如何分配流量”;

- 智能策略关注“如何让流量分配更符合用户的体验(响应时间)和系统的效率(资源利用率)”。

对于工程师来说,落地智能负载均衡的关键不是“追求最复杂的模型”,而是“理解业务场景,选择合适的策略”:

- 若场景简单(如静态文件服务):用传统策略+实时权重调整即可;

- 若场景复杂(如混合AI推理和电商):用机器学习模型优化;

- 若场景对延迟敏感(如直播、边缘计算):用边缘负载均衡。

最后,记住一句话:智能负载均衡不是“取代人”,而是“辅助人”——它让工程师从“救火式运维”中解放出来,专注于更有价值的业务创新。

延伸阅读:

- 《Google Borg:大规模集群管理实践》(Google论文);

- 《Envoy Proxy官方文档》(负载均衡部分);

- 《强化学习:原理与Python实现》(李航);

- 《eBPF实战》(David Calavera)。

欢迎在评论区分享你的负载均衡实践经验,让我们一起推动智能负载均衡的演进!

更多推荐

已为社区贡献148条内容

已为社区贡献148条内容

所有评论(0)