微调落地:春节祝福 AI 是怎样炼成的

这篇文章通过春节祝福AI的案例,深入探讨了微调技术的适用场景和实施方法。核心观点包括:1)微调最适合解决表达偏好问题而非知识不足问题;2)结构化输入设计比数据量更重要;3)30分钟微调成功的关键在于明确任务边界;4)人工评估在主观性任务中不可替代。文章指出,微调的价值在于让"正确的表达方式"成为模型的默认输出,而不需要反复提醒。该案例展示了微调在"表达偏好型"

微调落地:春节祝福 AI 是怎样炼成的

这是一个“看起来很轻”,但极其适合谈微调的场景

如果你只是把“春节祝福 AI”当成一个节日小工具,这个案例确实显得有点轻。

但如果你从微调落地的角度看,它反而非常典型,甚至可以说是“教科书级”的。

因为它几乎完美符合以下条件:

- 模型能力是足够的,但体验明显不对

- 问题不在“会不会”,而在“像不像人”

- 用户感知高度敏感,但很难用指标量化

- 用 Prompt 能凑合,用 RAG 几乎无解

而这类场景,正是大多数团队在真实业务中反复遇到、却迟迟不敢微调的原因:

“这点事,值得上微调吗?”

这篇文章要做的,不是证明“春节祝福 AI 有多厉害”,

而是通过这个足够具体、足够真实的案例,回答一个更普遍的问题:

微调,到底是怎么把一个通用大模型,拉进某个具体表达场景的?

一、通用模型的问题,不是“不会写”,而是“写得太安全”

很多人第一次用 Qwen3-32B 这类模型写祝福,都会得到一种“逻辑上没毛病,但情感上不对劲”的结果。

这些输出通常有几个共同特征:

- 句式完整、修辞正确

- 祝福要素齐全

- 几乎不可能冒犯任何人

但问题恰恰在这里。

通用模型默认追求的是“分布安全”:

它学到的是亿级语料中的“平均表达方式”,而不是你和某个人之间的关系。

春节祝福这种场景,真正难的不是“写祝福”,而是:

- 什么时候该轻一点

- 什么时候可以开玩笑

- 哪些细节提了是加分,不提反而更安全

这些判断,本质上都是表达偏好,而不是知识。

而表达偏好,正是微调比 Prompt 更有优势的地方。

二、为什么 Prompt 很难把“人情味”稳定下来

一个非常自然的工程反应是:

“那我把这些要求都写进 prompt 里不就好了?”

确实,在早期验证阶段,Prompt 是最低成本的方案。

但当你真正想把体验稳定下来,就会遇到几个绕不开的问题:

- Prompt 是一次性约束,不是概率重塑

- 模型很容易在长输出中“滑回默认语气”

- 用户输入稍微一变,风格就开始漂移

尤其是在这种“轻逻辑、重语气”的任务里,你会发现一个现象:

Prompt 能告诉模型“该怎么做”,

但很难让它默认就这么做。

而微调的核心价值,就在于这一点差异:

- Prompt:约束一次生成

- 微调:重排整个输出空间的优先级

当你希望“有分寸的表达”成为模型的第一反应,而不是“被提醒之后才想起来的规则”,Prompt 已经天然吃力了。

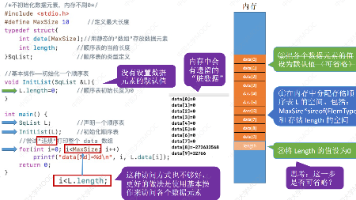

三、把“人情世故”拆成结构,是微调能成功的真正前提

这一点,是整个案例里最关键、也最容易被忽略的工程决策。

你们并没有试图让模型“理解人情世故”,而是做了一件非常理性的事:

把模糊的人情判断,拆成模型可以学习的输入结构。

称呼、关系、交往细节、场合、风格、篇幅——

这六个维度,本质上是在做一件事:

- 限定表达空间

- 明确哪些差异是“重要信号”

- 避免模型在“无限创意”里迷路

这一步非常重要,因为微调最怕的不是数据少,而是目标不清晰。

如果你只给模型“好祝福”和“坏祝福”,却不告诉它:

- 为什么这个好

- 在什么关系下好

- 在什么场合下才好

那模型学到的,往往只是“更油腻、更套路”的平均表达。

而结构化输入的作用,是让模型学会一种映射关系:

关系 × 场景 → 表达方式

这已经不是简单的文本生成,而是一种“表达决策模式”。

四、3107 条数据为什么“够用”,甚至是刻意控制的结果

从规模上看,3107 条训练数据非常小。

但在这个场景里,数据量并不是瓶颈,数据方向才是。

这套数据集有几个非常重要的隐含设计选择:

- 种子数据由人工撰写,确保“人味”基线

- 扩展不是无限生成,而是小规模繁殖

- 明确做了品质过滤,而不是“多多益善”

这意味着模型在训练时接收到的是一个方向非常一致的信号:

“在这种关系和风格下,

这种表达是被偏好的。”

对于表达类任务来说,这种一致性,远比数据规模重要。

很多微调失败的项目,并不是模型不行,而是数据在无意中告诉模型:

“什么风格都行,那就取平均吧。”

五、30 分钟微调的前提,并不是“微调很快”,而是“你没让它干多余的事”

“30 分钟完成微调”这句话,很容易被理解成某种营销口径。

但如果你仔细拆这个案例,会发现它成立的前提非常清晰:

- 使用 LoRA,只调整表达偏好

- 不启用 Thinking,避免无关推理

- 任务不需要新知识,也不需要复杂逻辑

- 目标是“生成更像人”,不是“想得更深”

换句话说,这次微调从一开始就没有试图改变模型的能力边界。

它做的只是:

在模型已经会的表达方式里,

重新排序什么更常被选出来。

在这种前提下,长时间训练反而是有风险的:

- 容易过拟合某种风格

- 容易把“人味”推成“刻意”

所以 30 分钟不是奇迹,而是一个非常克制的工程选择。

六、为什么这是一个“微调该出现的典型场景”

如果你抽象一下这个案例,会发现它具备几个非常清晰的特征:

- 输出高度主观,但用户感知极其敏感

- 评价标准难以量化,但“好不好”一看就知道

- 用 RAG 几乎帮不上忙

- Prompt 能解决 60%,但最后 40% 永远不稳

这正是微调最有价值的场景类型:

当问题不在“知识不足”,

而在“表达偏好不对”时,

微调往往是唯一能稳定解决问题的工具。

反过来说,如果你的任务是:

- 查资料

- 算步骤

- 严格对错判断

那这个案例反而不值得参考。

七、评估为什么只能靠“人”,而不是指标

春节祝福这种任务,天然无法用传统指标评估:

- BLEU、ROUGE 只会奖励“像训练文本”

- loss 下降并不等于“更走心”

- perplexity 只关心语言流畅度

在这种情况下,人工主观评估并不是“退而求其次”,而是唯一合理的选择。

但这里的关键不是“人工”,而是:

- 是否有明确的对照模型

- 是否覆盖多种关系和风格

- 是否在真实使用场景下评估

你们给出的多个评估样例,本质上是一种场景覆盖测试,而不是随意挑几条看看。

八、这个案例的边界:它解决了什么,也明确没解决什么

这个项目非常成功,但它的成功并不是“微调万能”。

它清楚地展示了微调的优势:

- 快速改变表达默认值

- 显著提升场景命中率

- 成本低、试错快

同时也非常明确地暴露了微调的边界:

- 不适合逻辑复杂任务

- 不适合知识快速变化的场景

- 对数据风格依赖极强

这恰恰是一个健康的微调案例:

它没有试图解决所有问题,只解决了一个它该解决的问题。

在这类“表达偏好型”场景中,真正耗时的往往不是训练本身,而是环境配置、数据对齐和反复试错。像LLaMA-Factory Online这样把微调流程标准化的平台,更适合用来快速验证:这个场景到底值不值得微调,而不是一开始就陷入重工程投入。

总结:微调的价值,是让“对的表达”成为默认值

用一句话收尾:

微调并不是让模型学会新东西,

而是让某一种你认可的表达方式,

不再需要被反复提醒。

春节祝福 AI 这个案例的价值,不在于它写了多少好句子,而在于它非常清楚地回答了一个工程问题:

什么时候,微调是合理的?

答案是:

- 当模型能力足够

- 当问题在表达偏好

- 当你知道“什么样的输出才是对的”

在这种情况下,微调不是重武器,而是一把非常锋利、非常节制的刀。

更多推荐

已为社区贡献35条内容

已为社区贡献35条内容

所有评论(0)