计算机毕业设计hadoop+spark+hive薪资预测 招聘推荐系统 招聘可视化大屏 大数据毕业设计(源码+文档+PPT+ 讲解)

本文综述了Hadoop+Spark+Hive技术在薪资预测与招聘推荐系统中的应用研究。重点分析了技术架构从批处理到实时分析的演进,以及算法从线性回归到深度学习融合的发展趋势。研究显示,混合推荐算法结合协同过滤与内容推荐,可使推荐准确率提升30%以上。行业实践案例表明,BOSS直聘等平台通过实时行为分析,将推荐点击率提升至18%。未来趋势将聚焦多模态大模型、隐私计算等技术融合,解决数据质量、算法可解

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Hadoop+Spark+Hive薪资预测与招聘推荐系统》的任务书模板,结合大数据处理与机器学习技术,适用于构建企业级招聘分析平台:

任务书:Hadoop+Spark+Hive薪资预测与招聘推荐系统

一、项目背景

在招聘市场中,企业与求职者常面临信息不对称问题:企业难以精准定位合适人才,求职者对岗位薪资预期模糊。本项目基于Hadoop(分布式存储)、Spark(数据处理与机器学习)和Hive(数据仓库)技术,构建一个薪资预测模型与智能招聘推荐系统,通过分析历史招聘数据、行业趋势及候选人特征,实现薪资透明化与岗位精准匹配。

二、项目目标

- 功能目标

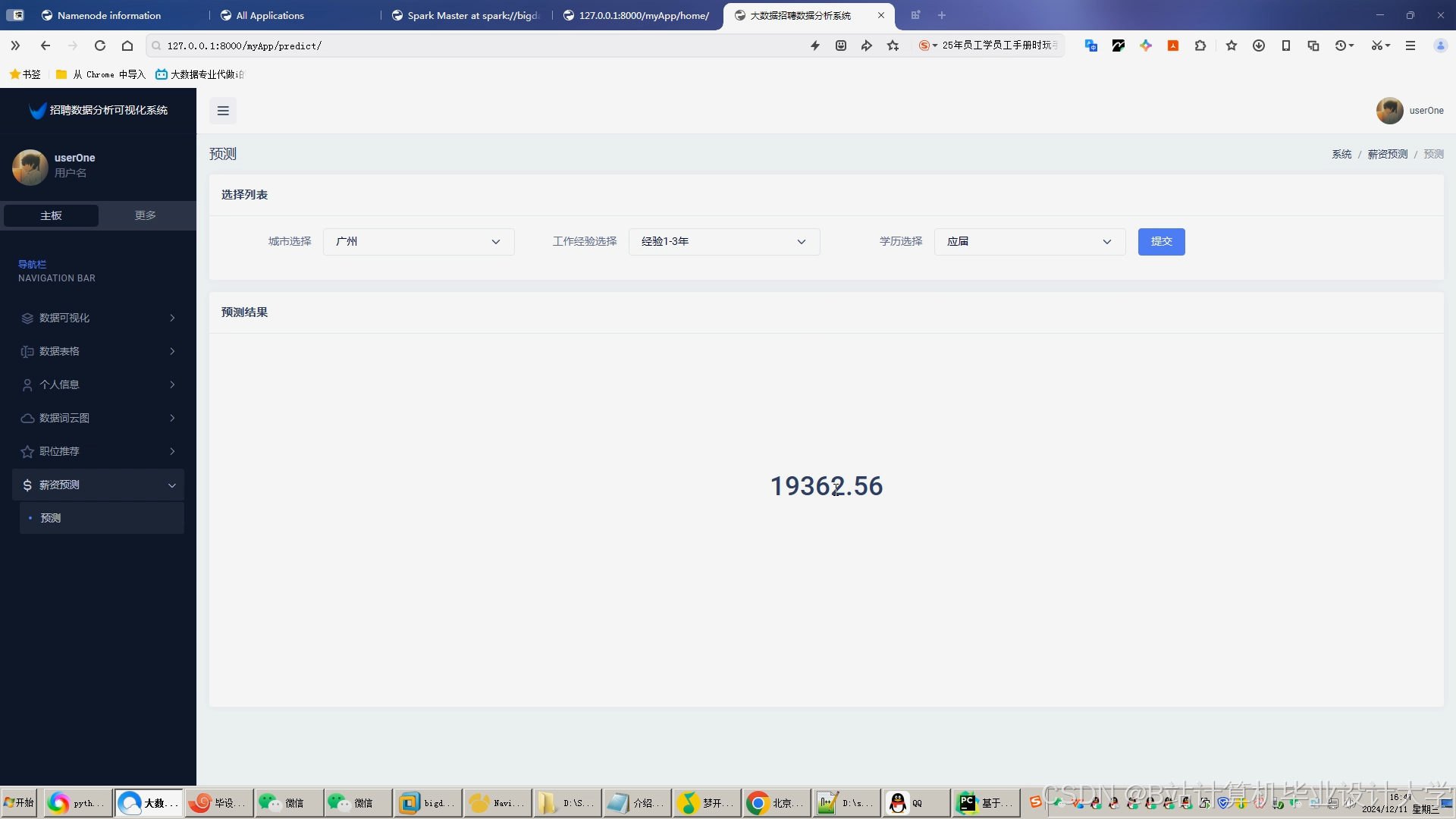

- 构建薪资预测模型,输入岗位、地区、经验等信息,输出预测薪资范围。

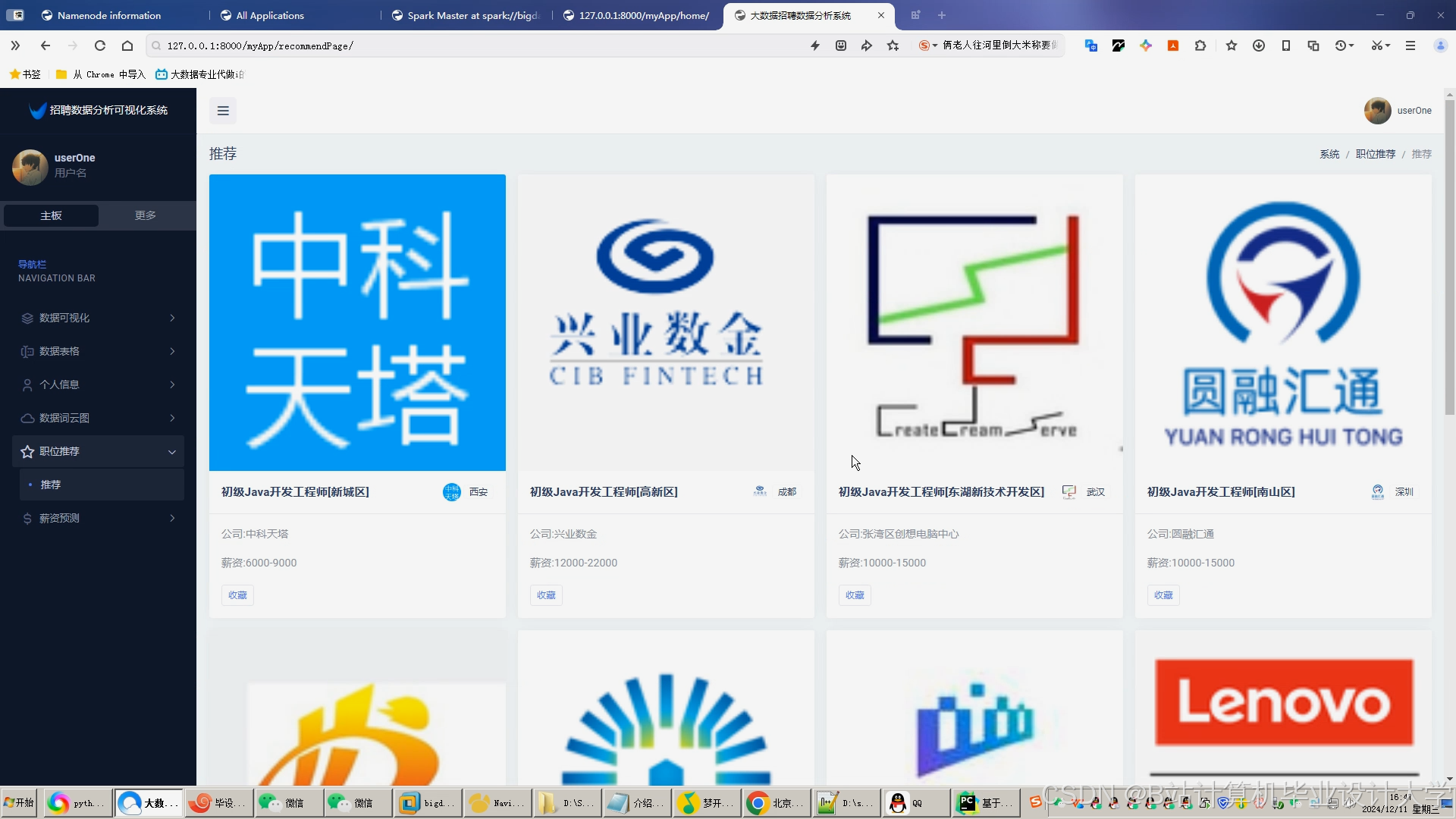

- 实现企业-求职者双向推荐:根据岗位需求推荐候选人,根据求职者简历推荐匹配岗位。

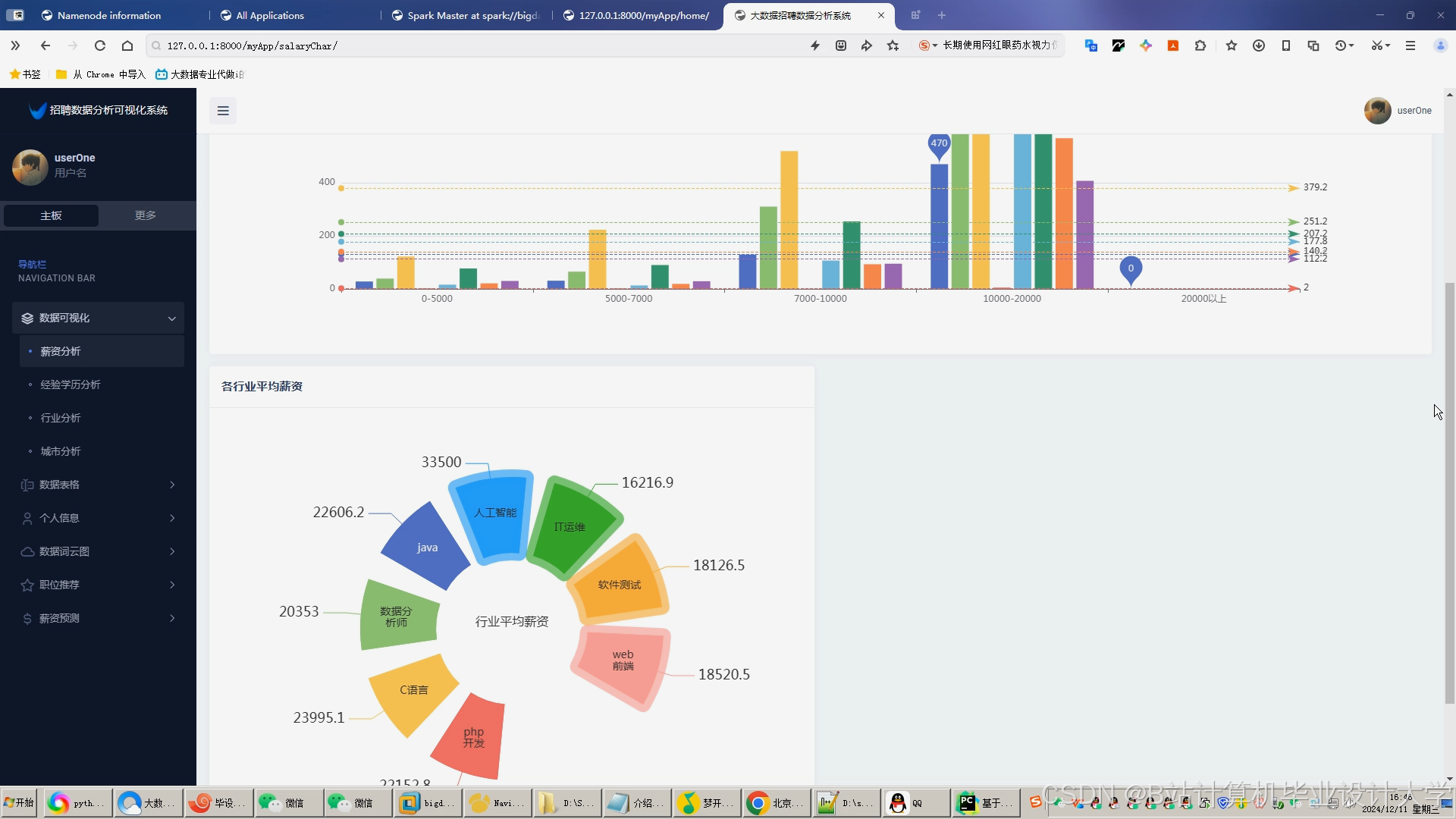

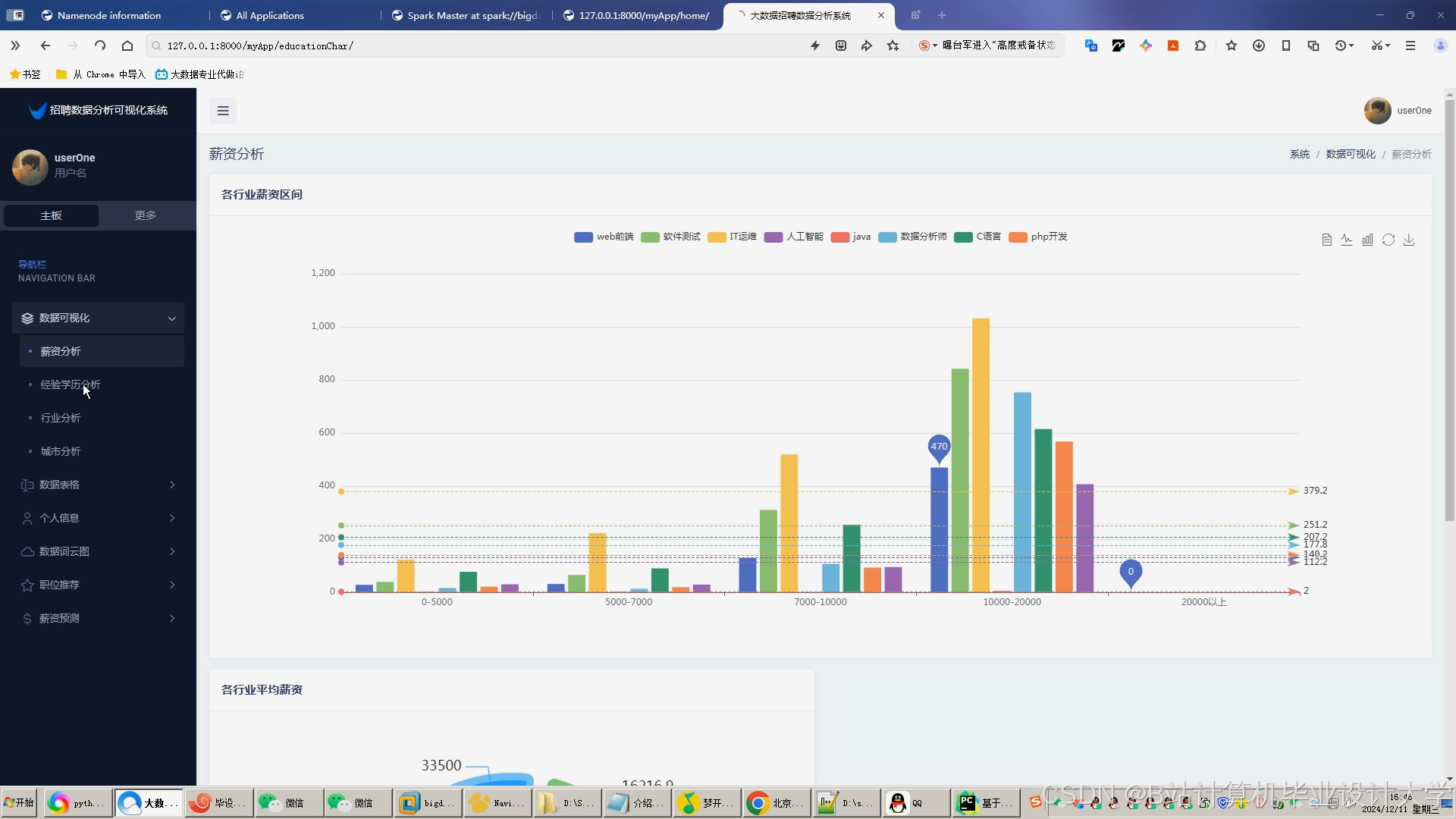

- 提供可视化分析看板,展示行业薪资分布、岗位热度、人才流动趋势等。

- 技术目标

- 使用Hadoop HDFS存储海量招聘数据(如爬取的招聘信息、企业HR系统数据)。

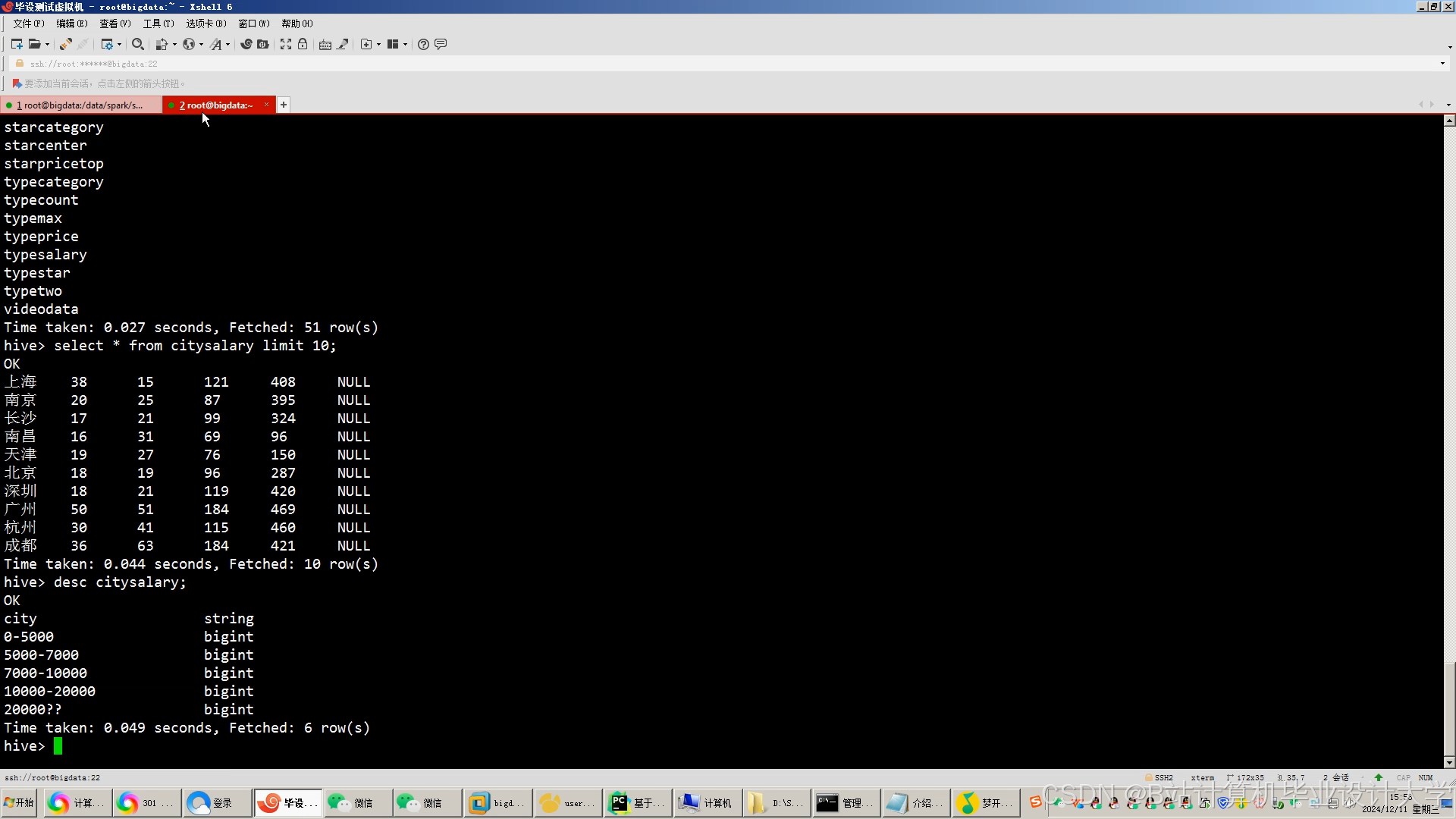

- 通过Hive构建数据仓库,支持SQL查询与复杂分析。

- 利用Spark MLlib实现薪资预测模型(如线性回归、随机森林)与推荐算法(如协同过滤、基于内容的推荐)。

- 性能目标

- 支持PB级数据存储与秒级查询响应。

- 模型预测误差率≤15%(MAE指标)。

- 推荐系统准确率≥80%(基于历史点击/录用数据)。

三、任务分解与分工

1. 数据层开发(Hadoop+Hive)

- 任务1:数据采集与清洗

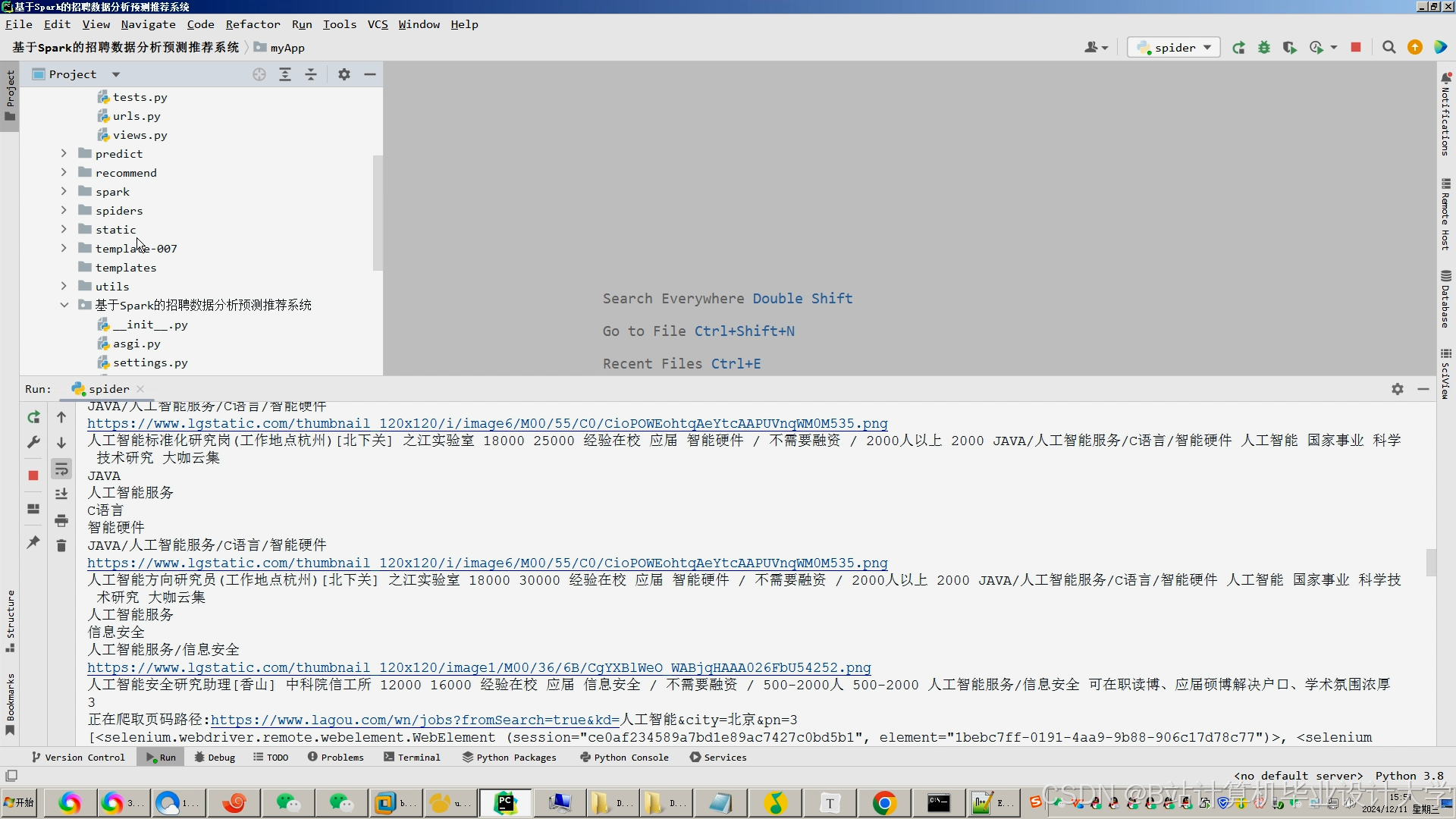

- 爬取招聘网站(如BOSS直聘、拉勾网)的公开数据,或对接企业HR系统API。

- 使用Spark清洗数据(去重、缺失值处理、异常值检测)。

- 任务2:数据存储与建模

- 在Hadoop HDFS中存储原始数据(如JSON、CSV格式)。

- 使用Hive创建外部表,定义薪资、岗位、地区、经验等维度表与事实表。

- 构建数据仓库分层模型(ODS→DWD→DWS→ADS)。

- 任务3:数据质量监控

- 编写Hive SQL脚本定期检查数据完整性(如字段覆盖率、分布合理性)。

2. 算法层开发(Spark MLlib)

- 任务1:薪资预测模型

- 特征工程:提取岗位类别、地区、公司规模、经验年限、学历等特征。

- 模型选择:基于Spark MLlib实现线性回归、随机森林或XGBoost模型。

- 模型评估:通过交叉验证与MAE/RMSE指标优化超参数。

- 任务2:招聘推荐算法

- 企业端推荐:基于求职者简历特征(技能、经验)与岗位需求的相似度匹配(余弦相似度)。

- 求职者端推荐:基于用户历史浏览/申请行为,使用ALS协同过滤推荐岗位。

- 任务3:模型部署

- 将训练好的模型保存为PMML或Spark MLlib原生格式。

- 通过Spark Streaming实现实时推荐(如求职者更新简历后触发重新匹配)。

3. 应用层开发(前端+API服务)

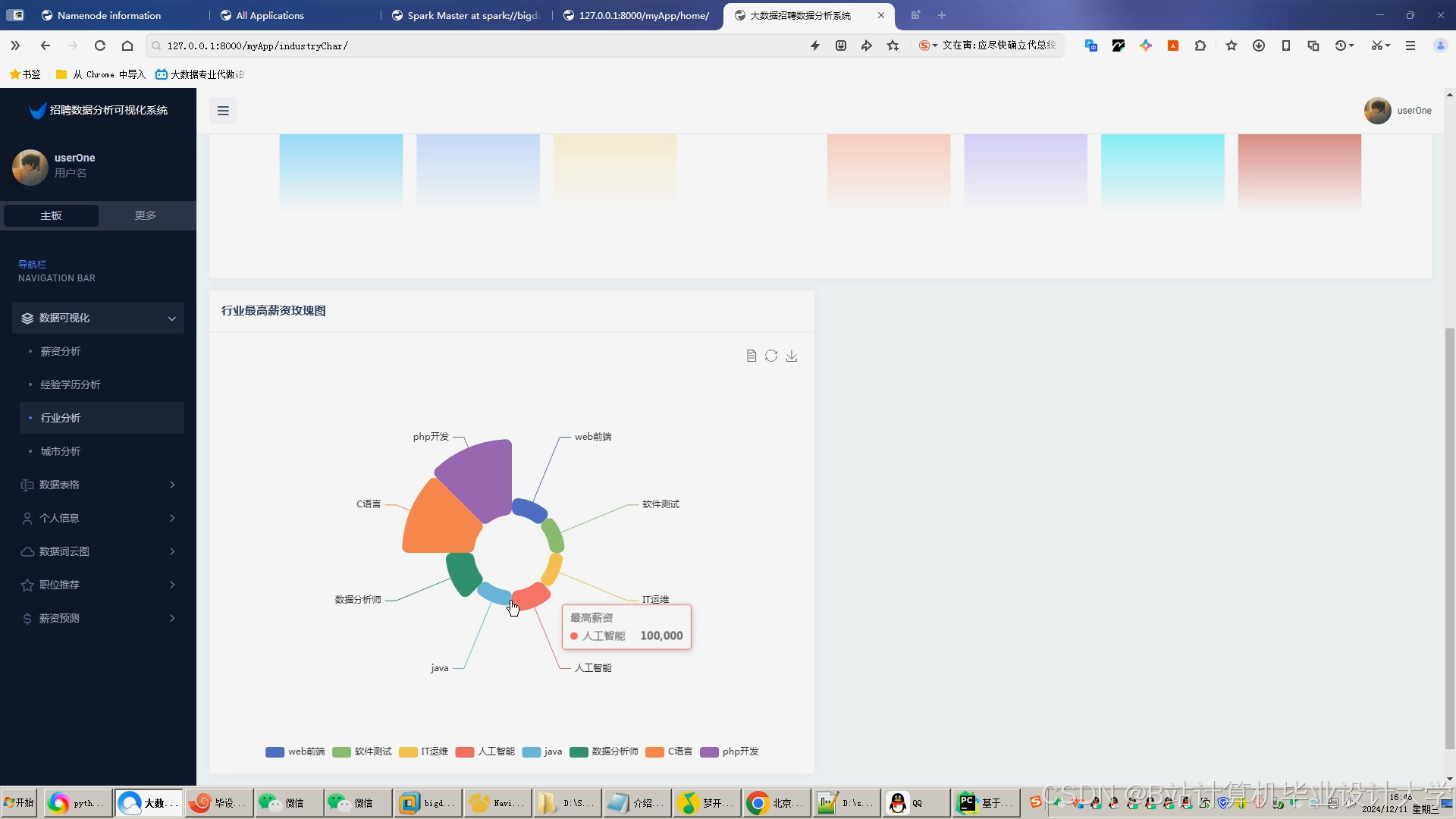

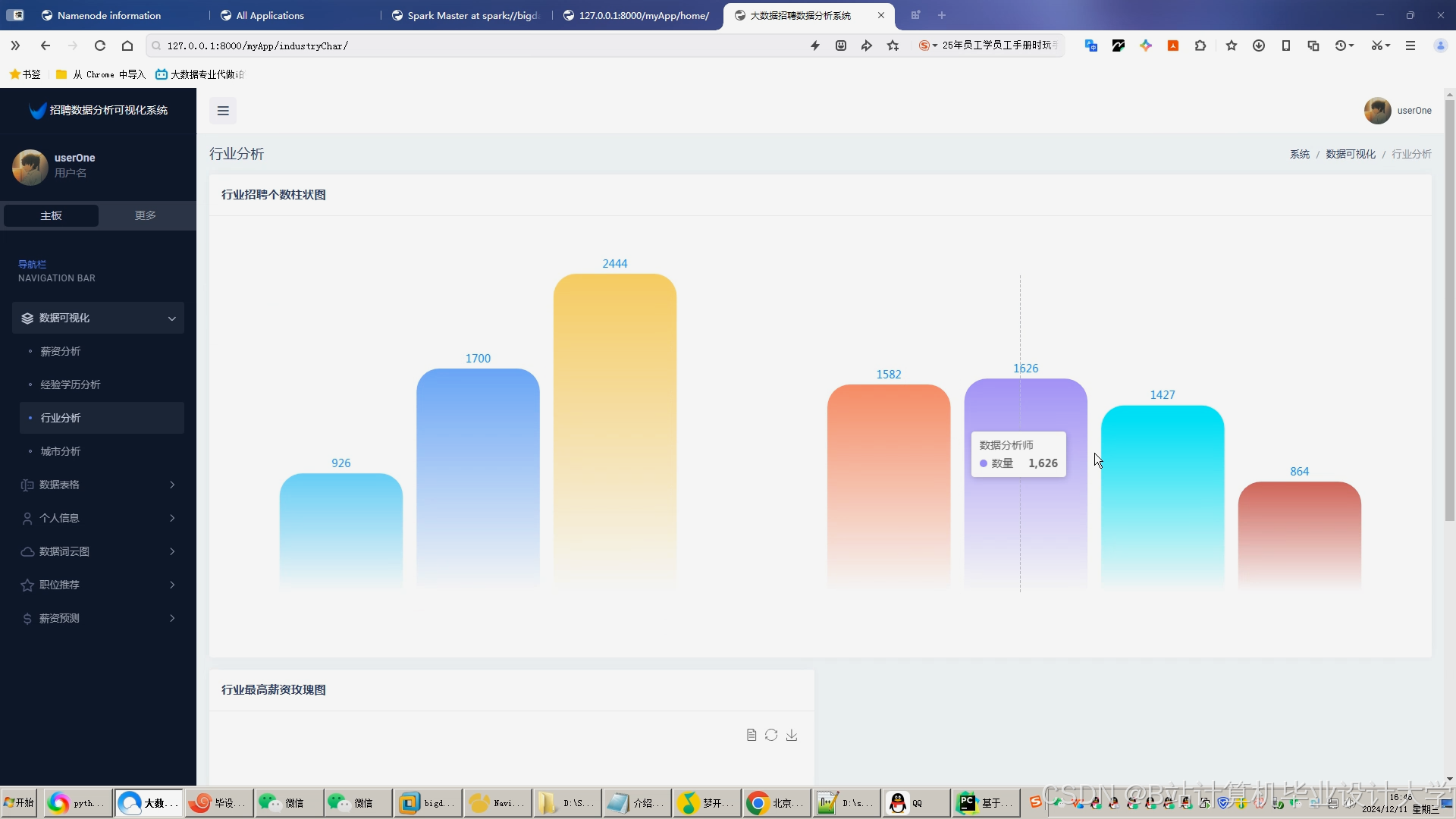

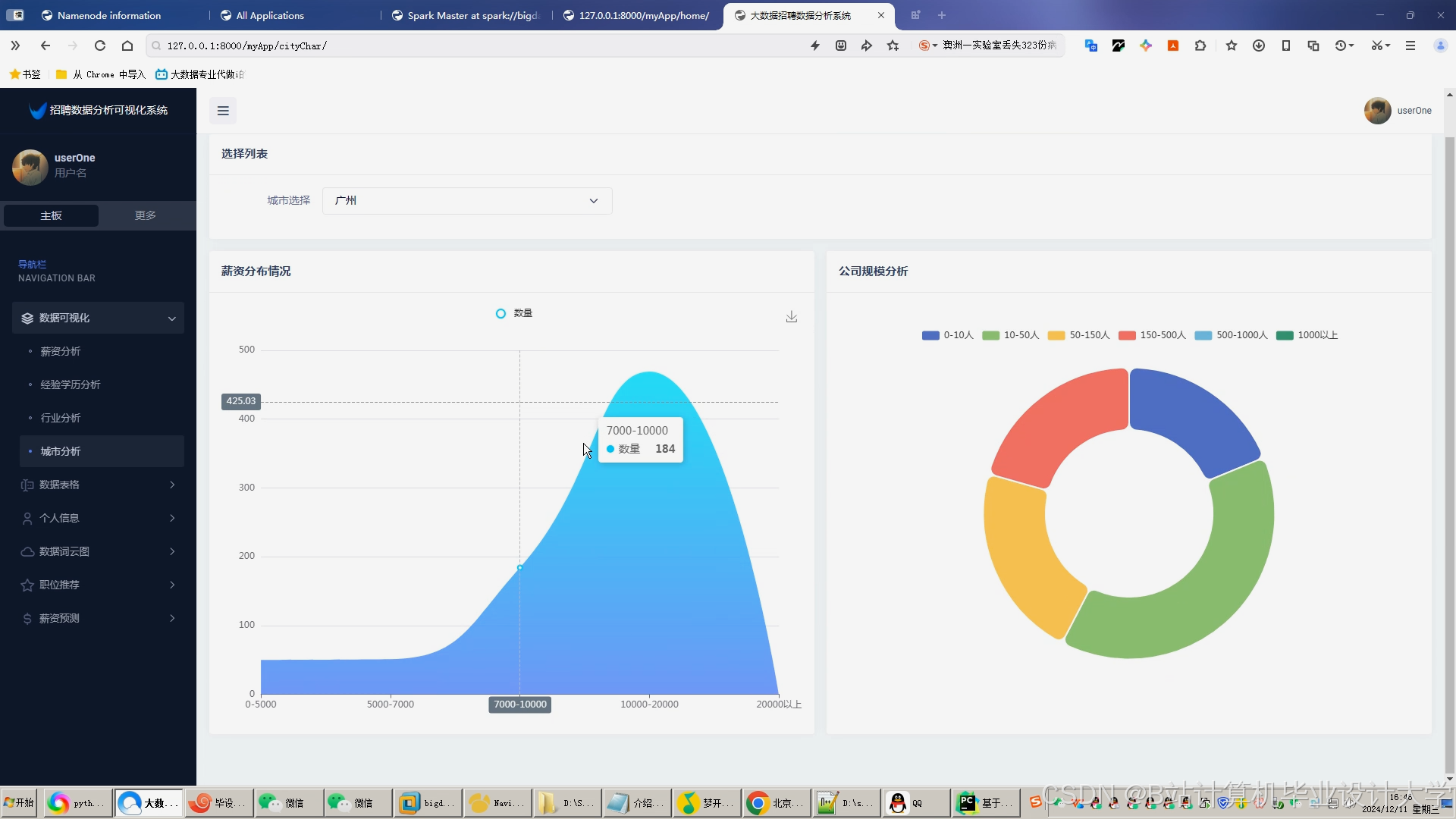

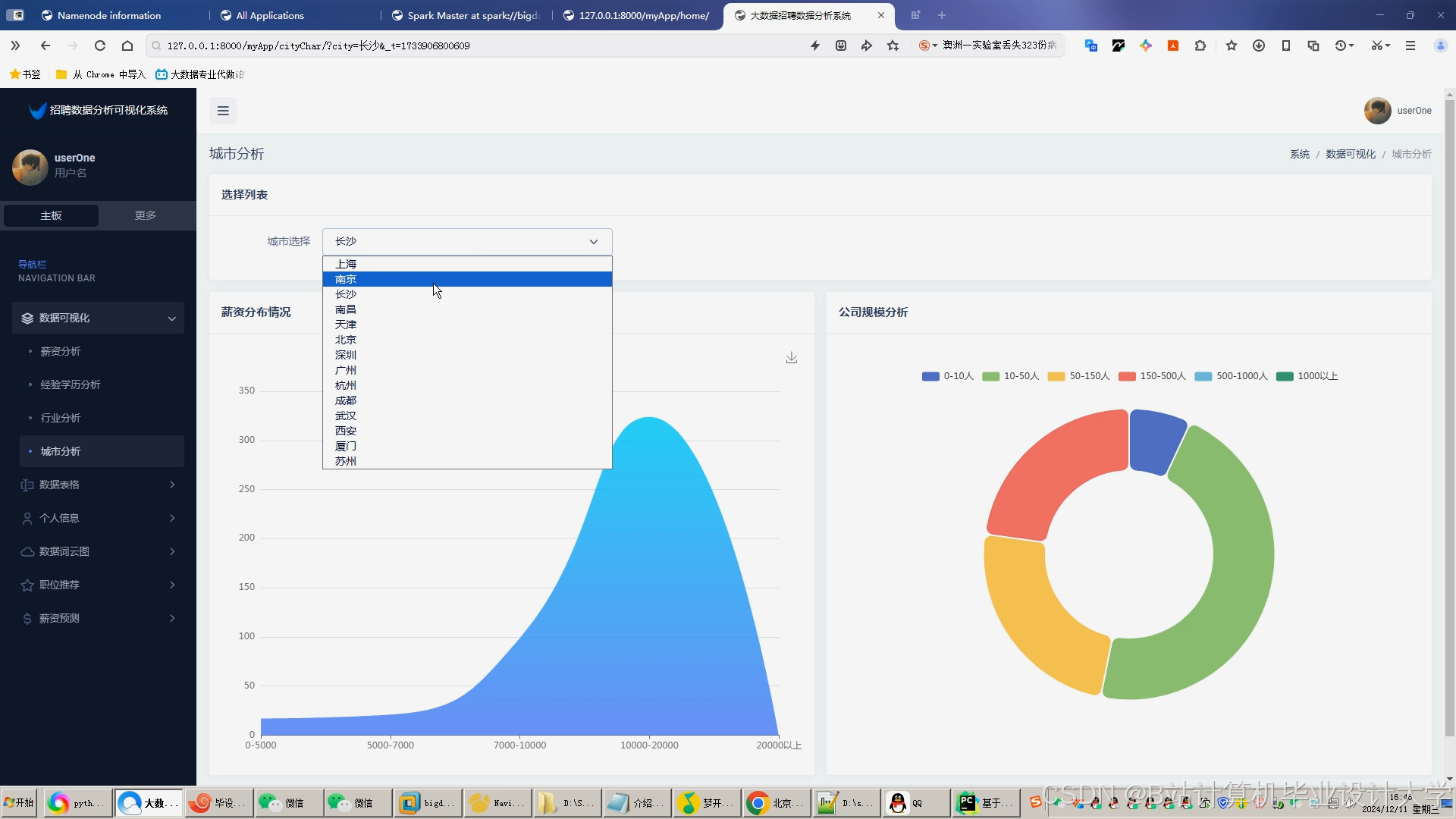

- 任务1:可视化看板

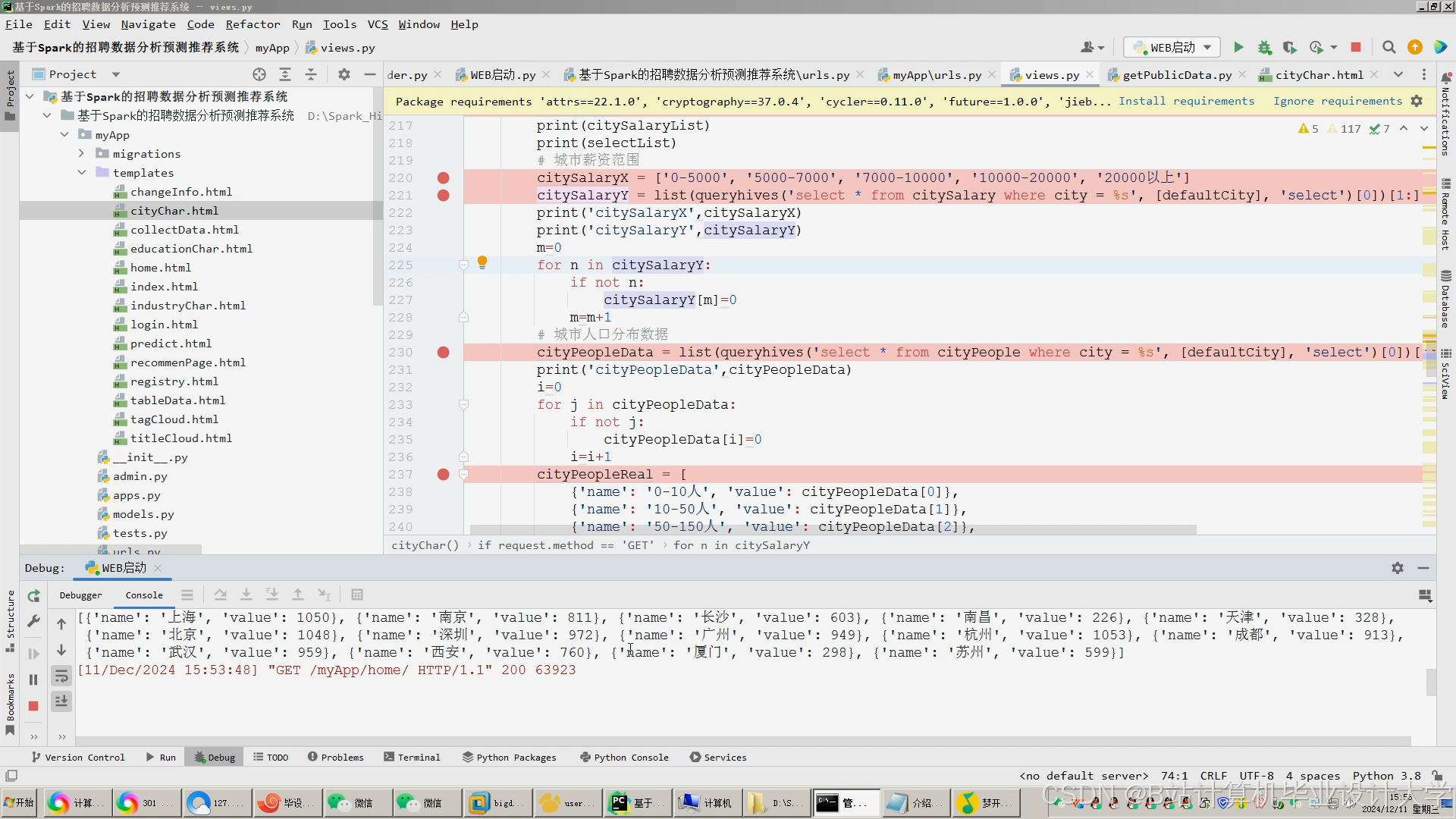

- 使用ECharts/Superset构建行业薪资热力图、岗位供需趋势图、人才流动地图。

- 展示关键指标:平均薪资、高薪岗位TOP10、热门技能排行榜。

- 任务2:推荐系统API

- 基于Flask/Django开发RESTful API,提供薪资预测与岗位推荐接口。

- 接口示例:

POST /api/predict_salary(输入:岗位、地区、经验;输出:薪资范围)GET /api/recommend_jobs?user_id=123(返回匹配岗位列表)

- 任务3:用户交互界面

- 企业端:发布岗位、查看推荐候选人、分析薪资竞争力。

- 求职者端:上传简历、查看预测薪资、接收岗位推荐。

4. 测试与优化

- 任务1:离线测试

- 使用历史数据验证模型准确性(如对比实际薪资与预测值)。

- 通过A/B测试比较不同推荐算法的点击率。

- 任务2:性能测试

- 使用JMeter模拟高并发请求,优化Hive查询与Spark任务调度。

- 调整Hadoop集群资源配置(如YARN内存分配)。

- 任务3:在线优化

- 收集用户反馈(如推荐岗位的申请率),迭代更新模型特征与参数。

四、时间计划

| 阶段 | 时间 | 任务内容 |

|---|---|---|

| 需求分析与设计 | 第1周 | 完成数据字典、模型选型、API设计文档 |

| 数据层开发 | 第2-3周 | 完成Hadoop集群搭建、Hive数据仓库构建、数据清洗 |

| 算法层开发 | 第4-5周 | 完成薪资预测模型训练、推荐算法实现、模型评估 |

| 应用层开发 | 第6周 | 完成可视化看板与API服务开发 |

| 测试与优化 | 第7周 | 完成离线/在线测试,修复性能瓶颈 |

| 部署上线 | 第8周 | 集群部署、监控告警配置、用户培训 |

五、交付成果

- 完整的招聘分析系统(含数据仓库、预测模型、推荐引擎、可视化看板)。

- 源代码(GitHub/GitLab托管)与部署文档。

- 模型评估报告与推荐系统准确率测试结果。

- 用户操作手册与系统维护指南。

六、资源需求

- 硬件资源:

- Hadoop集群:3台服务器(16核32G+,存储≥5TB)。

- 开发测试机:1台高配PC(32G内存,SSD存储)。

- 软件工具:

- Hadoop 3.x、Hive 3.x、Spark 3.x、Python 3.8+、Scala 2.12。

- ECharts/Superset(可视化)、Postman(API测试)、JMeter(性能测试)。

- 数据资源:

- 招聘网站公开数据集(如Kaggle的Job Salary Prediction数据集)。

- 企业合作提供的脱敏HR数据(需签署数据使用协议)。

七、风险评估

- 数据隐私风险:需对原始数据进行脱敏处理,避免泄露求职者个人信息。

- 模型冷启动问题:初期数据量不足时,可采用规则引擎(如关键词匹配)辅助推荐。

- 集群稳定性风险:需配置HDFS冗余存储与Spark任务容错机制(如checkpoint)。

项目负责人:XXX

日期:XXXX年XX月XX日

可根据实际业务场景调整技术栈(如替换Hive为ClickHouse提升查询性能)或增加NLP模块(如解析简历文本特征)。

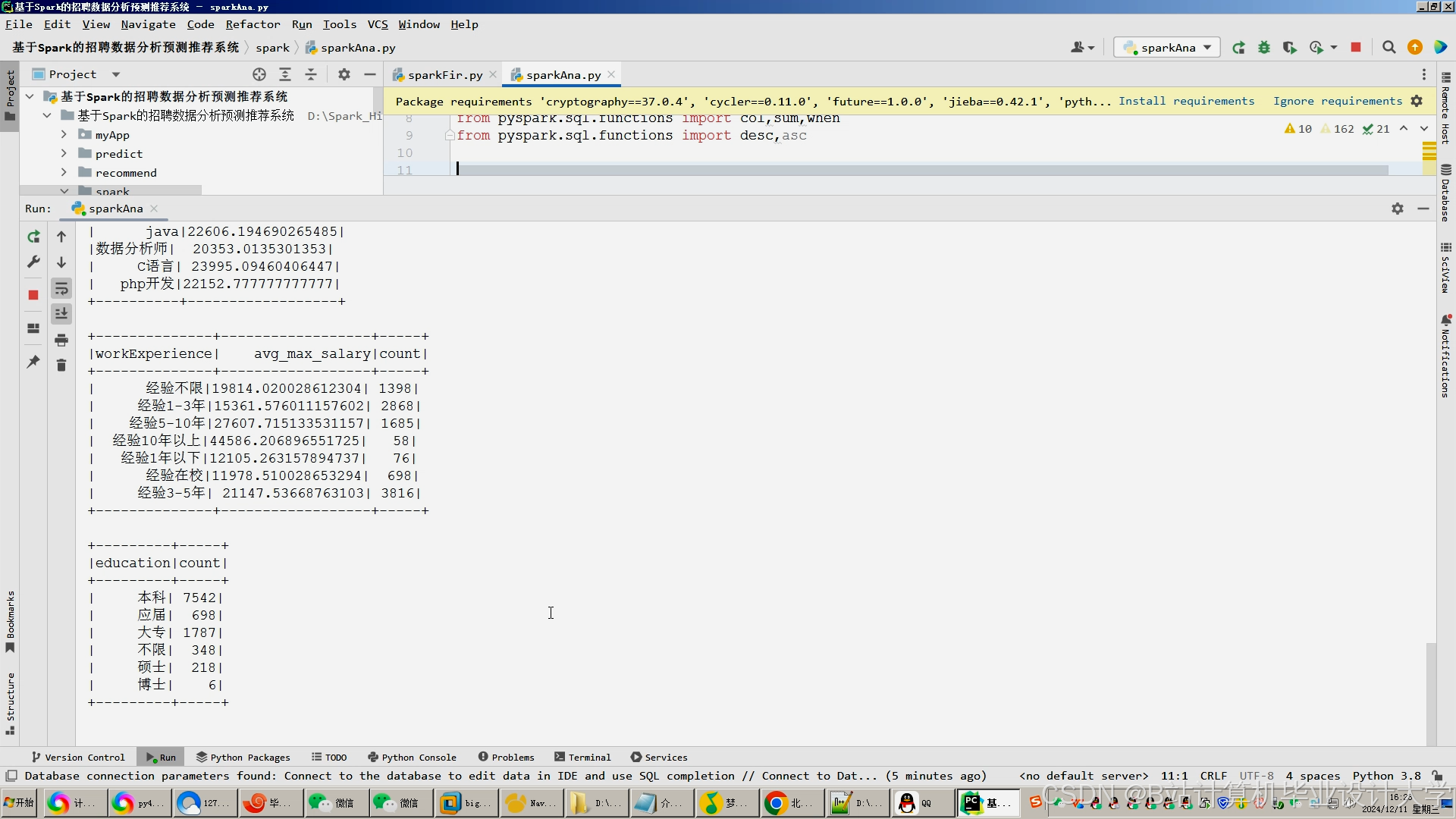

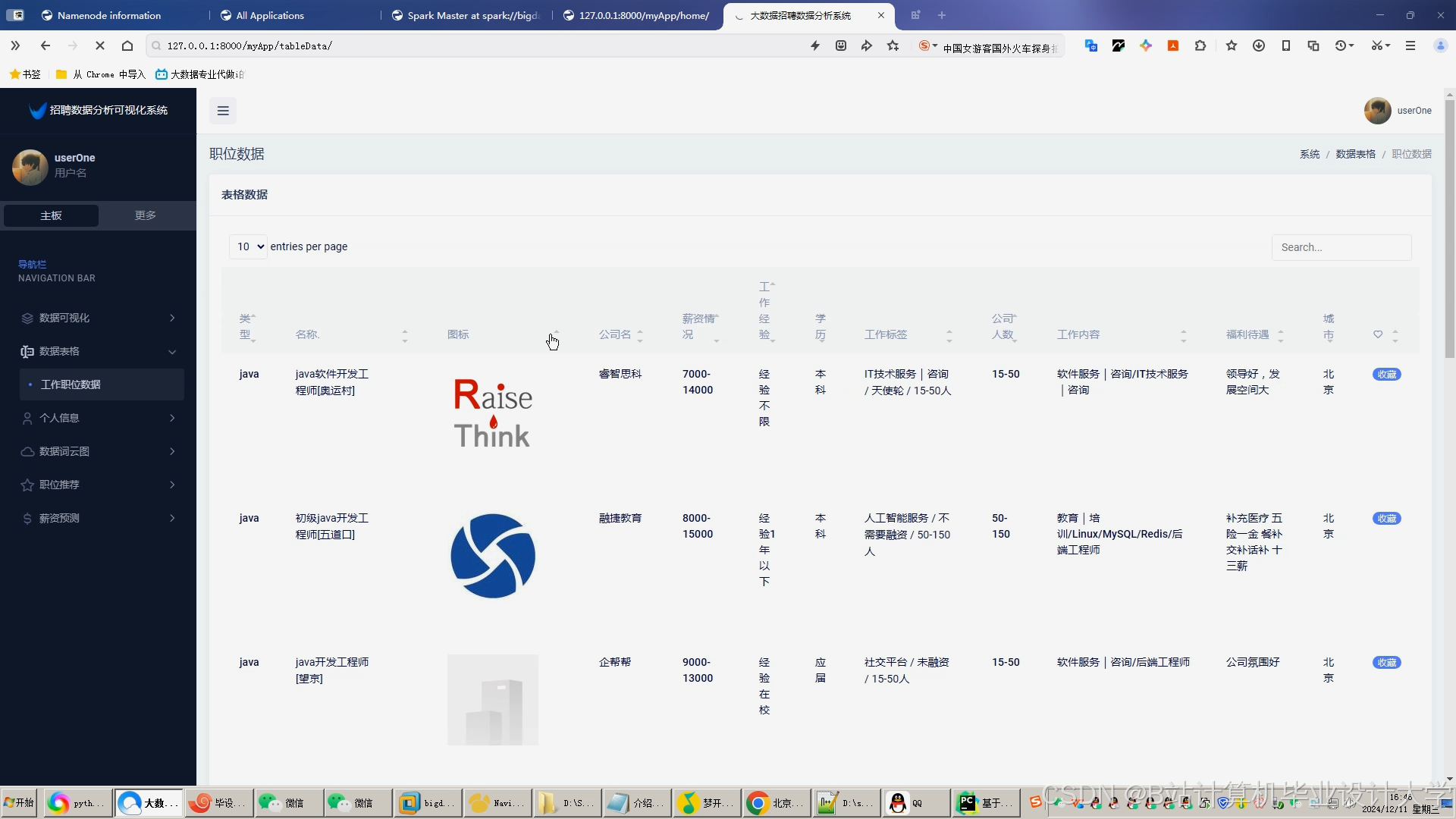

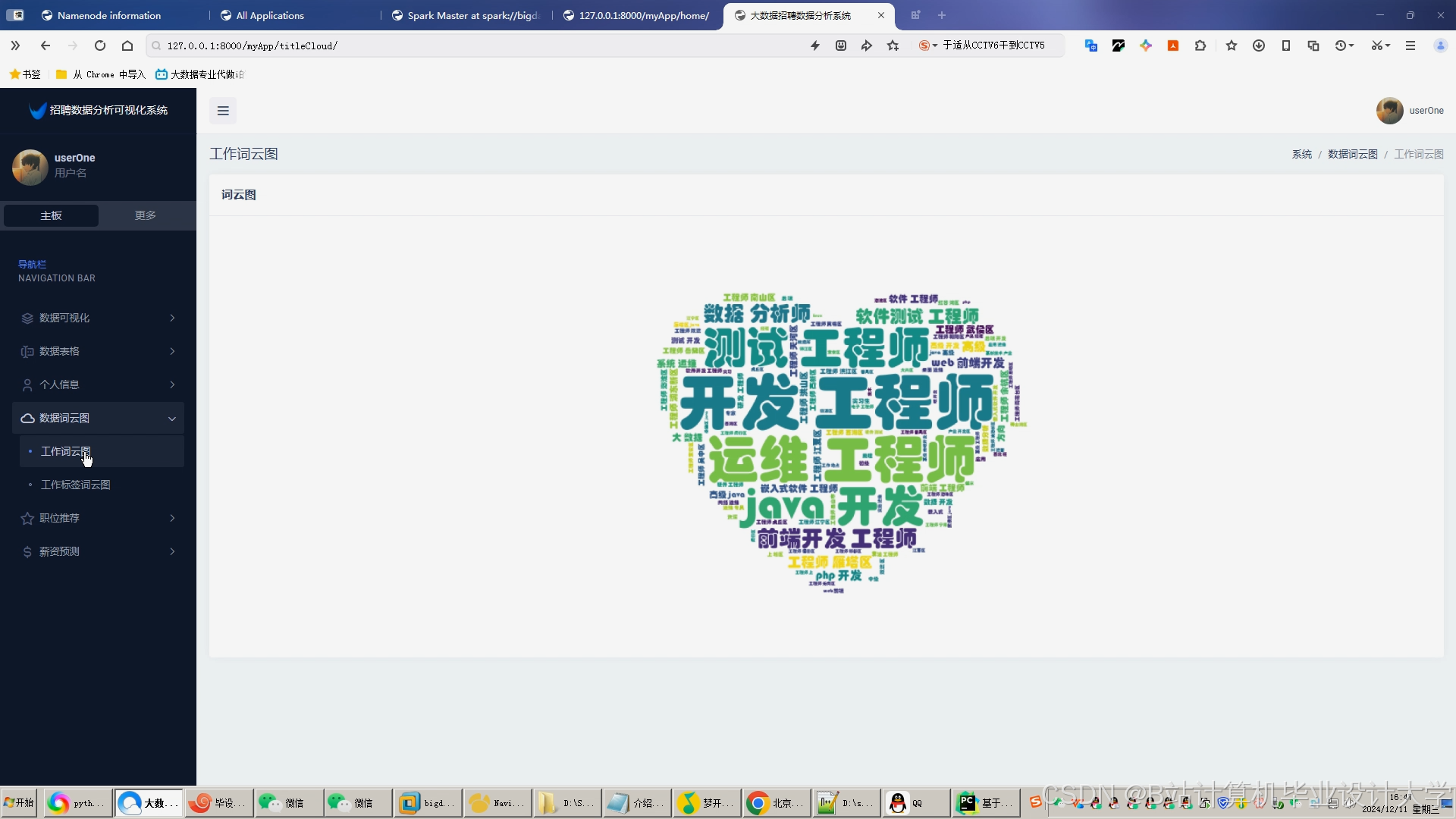

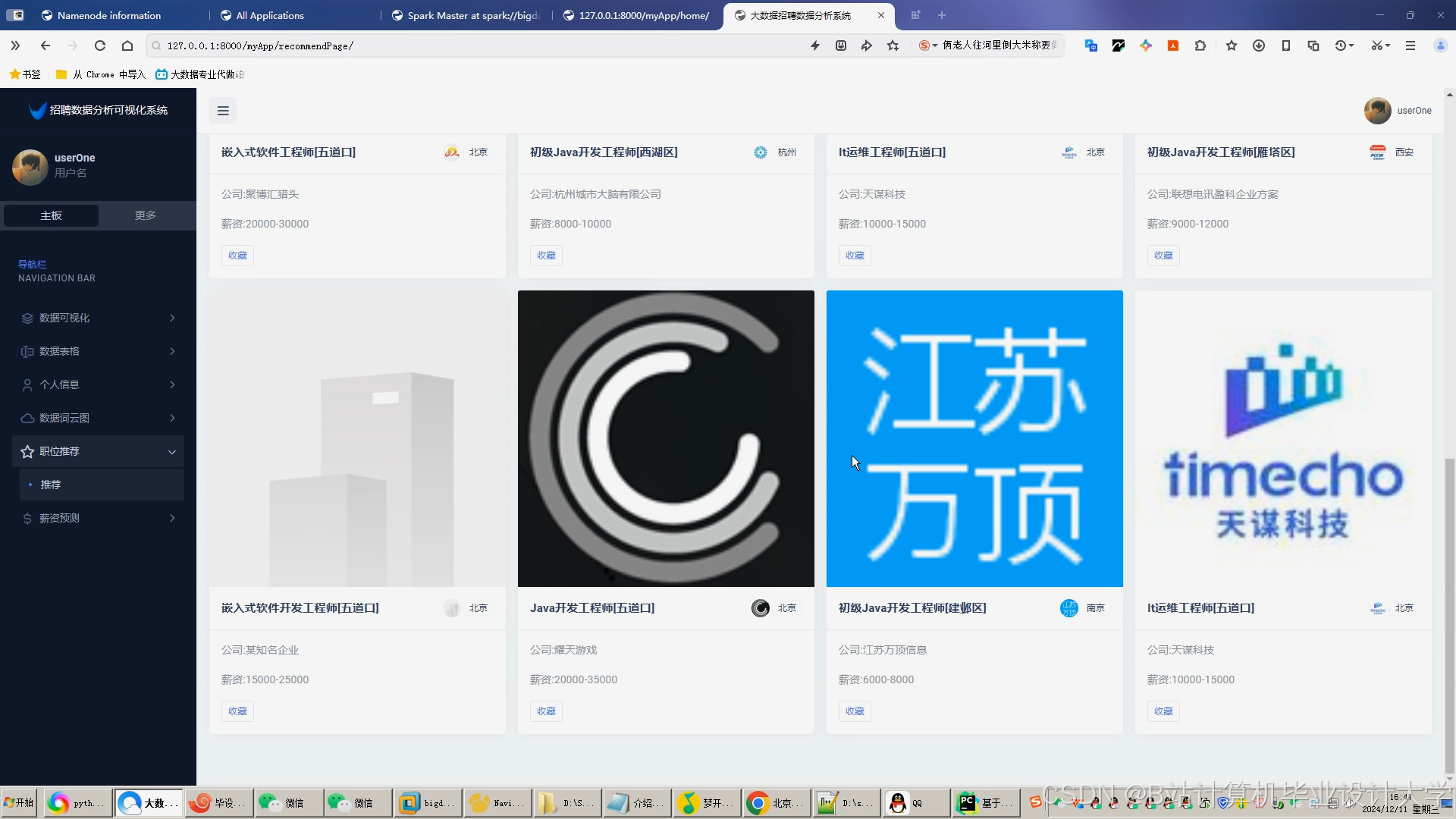

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是CSDN毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是CSDN特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

更多推荐

已为社区贡献930条内容

已为社区贡献930条内容

所有评论(0)