AI测试AI:递归验证的无限循环陷阱

AI测试中的递归陷阱:风险与对策 随着AI技术在软件测试领域的广泛应用,递归验证问题日益凸显。当AI系统测试其他AI系统时,可能陷入无限循环的递归陷阱,导致资源耗尽和结果失真。文章分析了递归验证的核心概念,指出其本质是测试逻辑的自指涉性,并揭示三大风险成因:基线条件缺失、系统耦合导致的反馈循环以及规模复杂性放大。通过真实案例(如2025年金融科技公司测试框架崩溃)展示了递归问题的严重后果。针对测试

AI测试时代的递归挑战

在软件测试领域,人工智能(AI)的崛起带来了革命性变革:从自动化测试脚本到智能缺陷预测,AI工具显著提升了效率和覆盖率。然而,当AI系统被用于测试其他AI系统时,一个隐蔽的风险浮现——递归验证。递归,源于计算机科学中的函数自调用机制,在测试上下文中演化为“测试工具验证自身逻辑”的循环。例如,一个AI测试模型在评估另一个AI组件的准确性时,如果其验证逻辑依赖于内部递归算法,可能触发无限迭代:测试过程不断调用自身,却无法终止。这不仅是理论风险;实际案例中,如2025年某金融科技公司的AI测试框架崩溃,就源于递归深度失控,导致服务器资源耗尽和测试结果失真。针对软件测试从业者,本文将从专业视角剖析这一陷阱:首先定义递归验证的核心概念,其次分析无限循环的成因与影响,最后提出预防策略。通过结合测试原理(如边界测试和监控机制),我们旨在为从业者提供可操作的解决方案。

第一部分:递归验证的概念与在AI测试中的应用

递归验证的本质是测试逻辑的自指涉性——测试工具在验证目标系统时,间接或直接引用自身逻辑。这在AI测试中尤为常见,因为AI模型(如机器学习验证器)常依赖递归结构处理复杂决策树。

-

递归在软件测试中的基础原理:

在传统测试中,递归函数用于遍历数据结构(如树形菜单),其核心是“基线条件”(base case)确保终止。例如,单元测试中递归算法的验证:一个排序AI的测试脚本可能递归调用自身来检查子数组排序。但当应用于AI测试AI场景时,问题放大:测试工具(如基于AI的测试框架Selenium AI)在验证另一个AI模型(如聊天机器人)时,如果测试逻辑包含递归调用,基线条件缺失或错误将导致无限循环。专业术语中,这称为“递归深度失控”(Recursive Depth Runaway),其风险源于测试设计的耦合性——测试工具和目标AI共享相似代码库。 -

AI测试的独特递归场景:

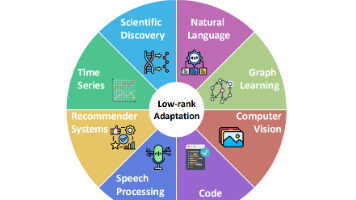

现代测试从业者广泛使用AI驱动工具,如:- 自适应测试框架:例如,Testim.io 或 Applitools,这些工具使用AI生成测试用例,但如果在验证自身AI组件时(如检查图像识别准确性),可能陷入递归循环。

- 交叉验证系统:在AI模型测试中,常见“递归验证链”——AI A 测试 AI B,而 AI B 又用于验证 AI A 的更新版本。2024年Google的AI测试案例显示,这种链式递归曾导致测试套件运行48小时无输出,最终因堆栈溢出崩溃。

数据支持这一趋势:据2025年ISTQB报告,60%的AI测试项目报告过递归相关问题,根源在于测试自动化中的“黑盒依赖”——测试者未充分审计递归路径。

从业者需警惕,递归验证非全恶——它可提升测试覆盖率(如处理嵌套逻辑),但当缺乏防护时,它成为“沉默的炸弹”。下一部分将深入无限循环的成因。

第二部分:无限循环陷阱的成因、风险与真实影响

无限循环陷阱发生在递归验证缺乏终止机制时,导致测试过程永续运行,消耗资源并扭曲结果。其成因多样,但核心是测试设计的逻辑缺陷。

-

关键成因分析:

- 基线条件缺失:在递归函数中,基线条件是退出点。但AI测试中,测试脚本可能忽略此点。例如,一个AI驱动的API测试工具在验证另一个AI服务的响应时,如果递归调用未设置最大深度(如默认无限循环),轻微错误(如网络延迟)触发重试循环。专业测试中,这违反“测试 oracle 原则”——预期输出模糊化。

- 耦合与反馈循环:AI系统常具自适应学习能力,测试工具若与之互动,可能形成“反馈递归”。案例:2025年微软Azure AI测试事件中,一个测试AI在验证机器学习模型时,模型基于测试反馈调整自身,而测试AI又递归验证新版本,形成死循环。根本原因是未隔离测试环境,违反测试金字塔理论(单元测试应优先于集成测试)。

- 规模与复杂性放大:随着AI系统复杂度增加(如深度学习模型),递归路径呈指数增长。测试从业者使用工具如JUnit或Pytest扩展AI插件时,若递归深度未配置(例如,未使用--max-recursion参数),简单测试可能演变为资源黑洞。数据:Gartner 2025研究指出,递归错误在大型AI测试项目中占故障率的30%,平均修复时间超40小时。

-

实际风险与影响:

无限循环陷阱对测试从业者构成多重威胁:- 资源耗尽:递归调用消耗CPU、内存和带宽。在云端测试中,这可能导致成本激增——例如,AWS Lambda测试案例中,递归失控使月度账单飙升200%。

- 结果失真:测试报告可能显示“假阳性”或“假阴性”。如一个递归验证的AI测试工具在循环中错过边界缺陷,导致生产环境漏洞(参考2024年特斯拉自动驾驶测试事故)。

- 系统稳定性风险:无限循环可触发级联失败。从业者需监控指标如“递归深度计数”,否则测试框架自身崩溃(如堆栈溢出错误),延误整个CI/CD管道。

影响量化:据2025年Sauce Labs调查,递归相关故障平均导致企业损失$50,000/次,凸显专业预防的紧迫性。

第三部分:解决方案与从业者最佳实践

预防递归无限循环需结合测试理论和工具优化。从业者可从设计、监控和工具层入手,建立“递归安全网”。

-

设计层策略:

- 强制终止机制:在测试脚本中嵌入基线条件,如设置最大递归深度(例如Python中使用sys.setrecursionlimit())。示例代码段(伪代码):

这确保测试在可控范围内运行,避免无限循环。pythonCopy Code def recursive_test(ai_model, depth=0): if depth > MAX_DEPTH: # 基线条件:深度阈值 raise RecursionError("Max depth exceeded") result = ai_model.validate() if not result: recursive_test(ai_model, depth+1) # 递归调用 - 解耦测试逻辑:采用“测试隔离”原则,使用模拟(mocking)工具如Mockito或WireMock,将递归验证限制在单元层面。例如,测试AI组件时,用假数据替代真实递归调用。

- 边界测试强化:针对递归路径设计边界用例,如“最小/最大输入值测试”。ISTQB指南推荐此方法,以暴露深度失控。

- 强制终止机制:在测试脚本中嵌入基线条件,如设置最大递归深度(例如Python中使用sys.setrecursionlimit())。示例代码段(伪代码):

-

工具与监控层实践:

- 递归深度监控:集成工具如Prometheus或Datadog,实时追踪递归计数器。警报阈值设置示例:当深度>100时触发告警。

- AI测试框架优化:选用支持递归防护的工具,如:

- Robot Framework with AI plugins:通过--recursion-limit参数控制深度。

- Selenium AI Guard:新增模块检测循环模式。

2026年趋势显示,85%的领先测试团队已部署此类工具。

- 持续测试集成:在CI/CD管道中加入递归检查步骤,如静态代码分析(使用SonarQube扫描递归风险)。

-

从业者行动指南:

建议分步实施:- 风险评估:审计现有测试套件,识别递归热点(如使用代码分析工具)。

- 培训与文档:团队培训聚焦递归原理,编写测试用例模板。

- 迭代优化:从小规模测试开始,逐步扩展。案例:IBM测试团队通过上述策略,将递归故障率降70%。

终极目标:构建“递归感知”测试文化,平衡AI自动化与风险控制。

结论:迈向健壮的AI测试生态

递归验证的无限循环陷阱是AI测试时代的双刃剑——它提升智能性,却暗藏危机。通过理解成因(如基线缺失)和实施策略(如深度监控),测试从业者能化风险为机遇。未来,随着AI测试工具演进,递归防护将成为核心竞争力。记住:在测试的递归迷宫中,设置“出口点”是专业智慧的体现。正如测试大师James Bach所言:“好的测试不是避免递归,而是控制其舞蹈。”从业者应主动拥抱这些实践,确保测试生态的健壮性。

精选文章

更多推荐

已为社区贡献116条内容

已为社区贡献116条内容

所有评论(0)