Zed IDE EP提供者:可插拔架构让 AI 编辑更懂你

在 Zed IDE 中,编辑预测是一项「隐形」却至关重要的功能:它默默观察你的编码行为,在恰当时机预判你接下来的操作——当你输入if (,它提前补全) {和闭合花括号当你选中一段冗余代码,它预判你将删除并高亮提示当你写注释,它准备生成对应的排序实现预测精准时,编码如行云流水;预测失准时,反而造成干扰。关键在于:不同开发者有不同的编码风格、项目类型和技术栈,单一模型难以满足所有场景。为此,Zed 推

一、什么是编辑预测(Edit Prediction)?

在 Zed IDE 中,编辑预测是一项「隐形」却至关重要的功能:它默默观察你的编码行为,在恰当时机预判你接下来的操作——

- 当你输入

if (,它提前补全) {和闭合花括号 - 当你选中一段冗余代码,它预判你将删除并高亮提示

- 当你写注释

// sort array,它准备生成对应的排序实现

预测精准时,编码如行云流水;预测失准时,反而造成干扰。关键在于:不同开发者有不同的编码风格、项目类型和技术栈,单一模型难以满足所有场景。

为此,Zed 推出 可插拔的编辑预测提供者架构(Pluggable Edit Prediction Providers),让你根据实际需求自由选择预测引擎。

二、支持的预测提供者

Zed 目前集成六大主流编辑预测服务,各具特色:

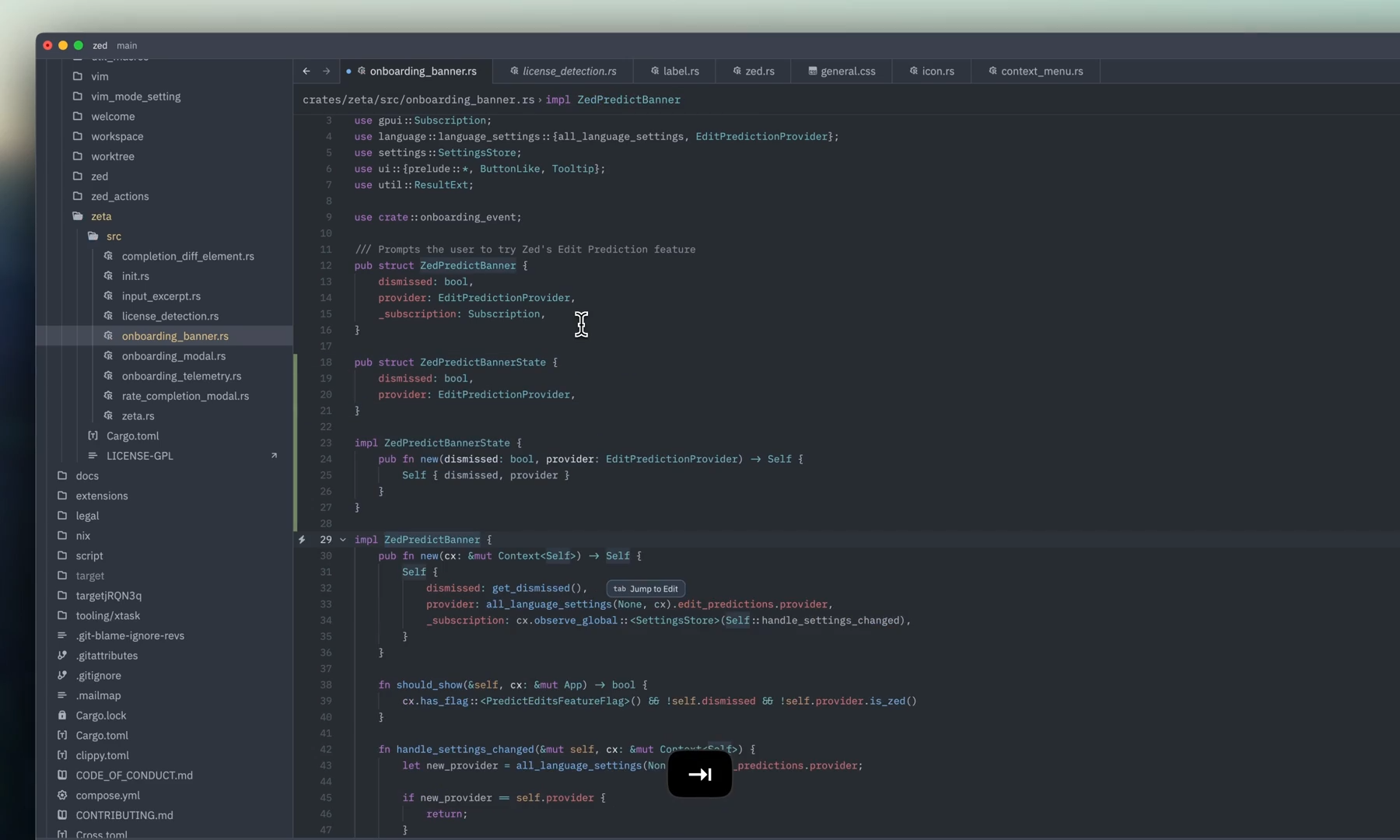

1. Zeta(默认提供者)

Zeta 是 Zed 团队自研的首款编辑预测模型,专为 Zed 的上下文格式优化训练。无需任何配置,开箱即用。

团队正在开发 Zeta2,预计数周内发布。新版本在速度、准确率和训练数据质量上均有显著提升。

如果你发现当前的预测是糟糕的或者瓦努七年不需要预测

zeta也提供了精细化模式来关闭预测功能

2. Mercury Coder

Mercury Coder 采用扩散模型架构(Diffusion Architecture),与传统自回归模型有本质区别:

| 传统自回归模型 | Mercury 扩散模型 |

|---|---|

| 逐 token 生成(如打字机) | 并行优化整个输出(如文档编辑) |

| 顺序依赖,延迟累积 | 全局调整,响应更流畅 |

特别适合需要整体重构或批量修改的场景,预测更自然连贯。

3. Sweep

Sweep 的核心优势是速度:

- 采用在线强化学习(Online RL)训练

- 自定义 diff 格式,精准捕捉最近的代码变更

- 专属推理栈优化,预测延迟低于 100ms

适合对响应速度要求极高的实时编码场景。

4. Ollama(本地运行)

Ollama 是社区呼声最高的功能之一。借助新的可插拔架构,Zed 现已原生支持 Ollama:

- 在本地机器运行开源模型(Qwen、CodeLlama、DeepSeek 等)

- 代码永不离开你的设备,满足安全与隐私要求

- 无需网络连接,离线环境也可使用

特别适合处理敏感代码、内网开发或网络不稳定场景。

5. 其他提供者

- GitHub Copilot:支持 Next Edit Suggestions 功能

- Codestral:Mistral AI 推出的专用代码模型

四、如何选择适合你的提供者?

没有「最好」的模型,只有「最适合」的模型。选择时需考虑:

| 场景 | 推荐提供者 | 理由 |

|---|---|---|

| 日常开发,追求平衡体验 | Zeta | 默认优化,无需配置 |

| 需要整体代码重构 | Mercury Coder | 扩散架构更适合批量编辑 |

| 极致响应速度 | Sweep | <100ms 延迟 |

| 敏感代码/离线环境 | Ollama | 本地运行,数据不出设备 |

| 已有 Copilot 订阅 | GitHub Copilot | 无缝衔接现有工作流 |

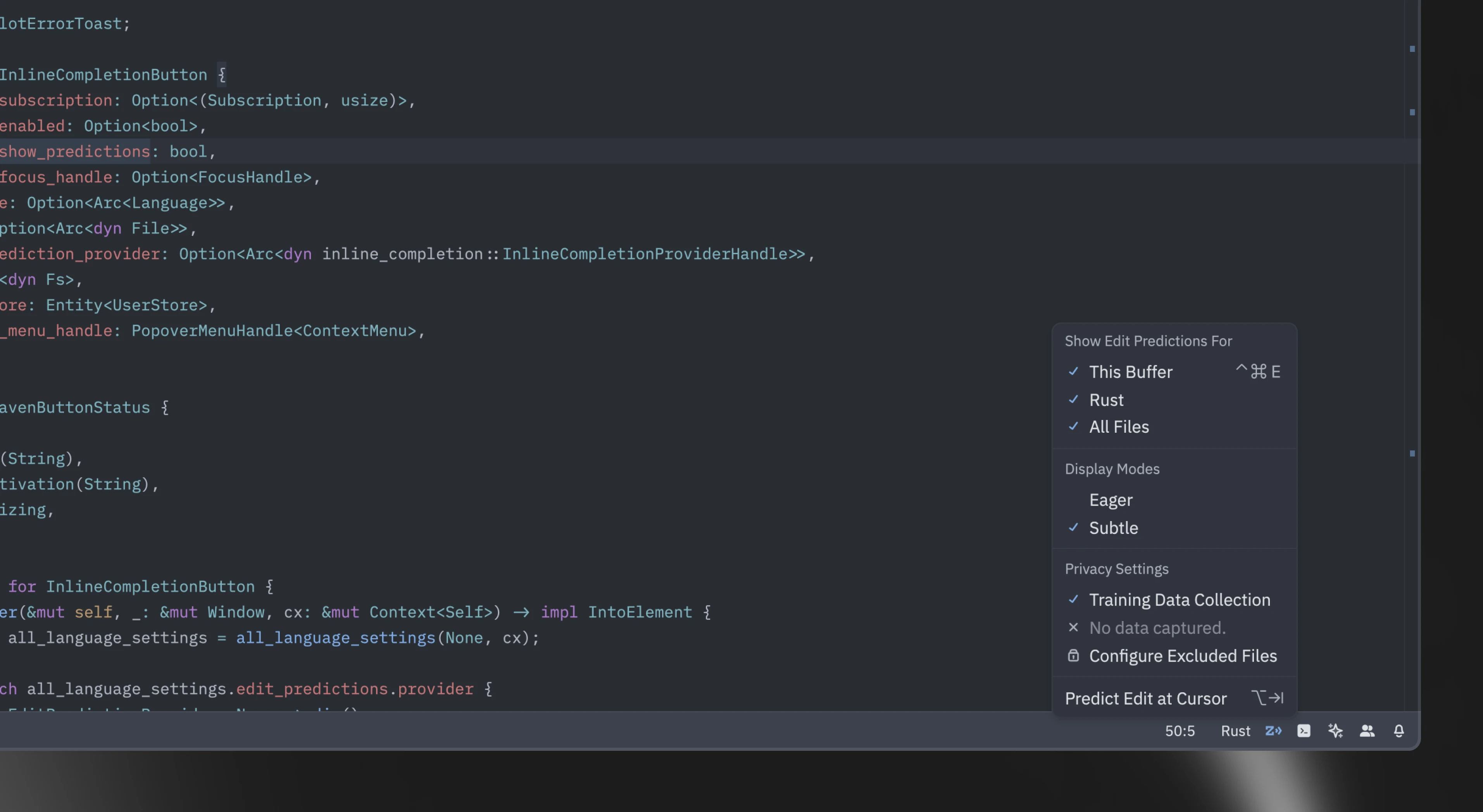

五、配置指南

- 打开 Zed Settings Editor(

Cmd+,或Ctrl+,) - 搜索

edit prediction provider - 从下拉菜单选择目标提供者

- 根据提示填写 API Key 或本地服务地址(如 Ollama 需指定

http://localhost:11434)

六、未来展望

Zed 团队明确表示将持续优化编辑预测体验:

- Zeta2 即将发布,性能全面提升

- 持续降低新提供者的集成门槛

- 探索多模型协同预测(如 Heuristic + LLM 混合)

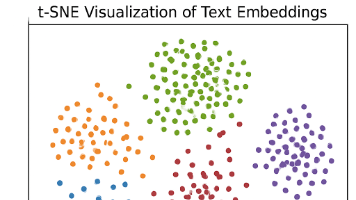

编辑预测的本质是理解开发者意图。随着可插拔架构的成熟,Zed 正从「提供单一预测方案」转向「构建预测生态」,让每位开发者都能找到最懂自己的 AI 助手。

更多推荐

已为社区贡献64条内容

已为社区贡献64条内容

所有评论(0)