生成式AI进化的阴暗面:测试员的2026新战场

摘要: 2026年,生成式AI在软件开发、客户服务等领域的广泛应用带来了效率提升,但也暴露出偏见放大、安全漏洞和伦理失控等阴暗面,对软件测试提出全新挑战。测试员需重构方法论,聚焦三大核心维度:通过偏见检测框架(如FairTest)识别数据偏差;采用对抗性测试(如Fuzz测试)增强模型鲁棒性;设计伦理测试用例(如医疗AI可解释性验证)。未来测试将向持续监控转型,测试员需掌握AI原生工具(如Testi

在2026年的技术浪潮中,生成式AI(如大型语言模型和多模态系统)已渗透至软件开发、客户服务、内容创作等核心领域,成为企业数字化转型的引擎。然而,其快速进化背后潜藏着不容忽视的阴暗面:偏见放大、安全脆弱性、伦理失控等,这些不仅威胁产品可靠性,更将软件测试员推向了前所未有的战场。作为专业测试从业者,我们必须直面这些挑战,重构测试方法论。本文将从专业角度分析阴暗面的成因、影响及应对策略,为测试团队提供2026年的实战指南。

一、生成式AI阴暗面的核心维度:测试视角的深度剖析

生成式AI的阴暗面源于其训练数据、算法设计和部署环境的不确定性,对软件测试构成三重挑战:

-

偏见与公平性风险

生成式AI模型在训练中易吸收历史数据中的偏见(如性别、种族歧视),导致输出内容不公。例如,2026年金融行业广泛使用的AI信贷系统,曾因模型偏见而拒绝特定人群的贷款申请,引发合规危机。测试员需从数据源头介入:-

测试重点:实施偏见检测框架,如使用FairTest工具扫描训练数据集,识别敏感属性(年龄、地域)的统计偏差。

-

案例参考:某银行测试团队通过合成数据注入,模拟边缘场景,发现模型对低收入群体的拒贷率异常偏高,及时调整算法阈值。

-

专业挑战:测试需跨域协作(数据科学+伦理),但当前行业标准(如ISO/IEC 25000)尚未覆盖AI偏见量化,测试员须自定义指标。

-

-

安全漏洞与对抗性攻击

AI模型易受提示注入、数据投毒等攻击,2026年已出现多起恶意用户操控ChatGPT类系统生成有害内容的案例。测试员面临“黑盒测试”困境:-

测试重点:采用对抗性测试技术,如Fuzz测试生成随机输入,验证模型鲁棒性。工具如IBM的Adversarial Robustness Toolbox可自动化攻击模拟。

-

案例参考:某电商平台AI客服系统遭提示注入攻击,生成虚假促销信息;测试团队通过边界值分析,发现输入长度超过1000字符时模型崩溃。

-

专业挑战:传统渗透测试无法覆盖AI特有漏洞(如模型窃取),测试员需掌握机器学习安全知识(OWASP ML Top 10)。

-

-

伦理失控与责任模糊

生成式AI的“幻觉”(hallucination)问题在2026年加剧,模型可能输出虚构事实或侵权内容。测试员成为伦理守门人:-

测试重点:设计伦理测试用例,例如验证医疗诊断AI的决策可解释性,确保输出符合HIPAA等法规。工具如Google的What-If Tool辅助可视化模型决策路径。

-

案例参考:自动驾驶AI因“幻觉”误判障碍物,测试团队通过场景复现,定位到训练数据缺失雨天夜间场景。

-

专业挑战:责任界定不清(开发者vs测试员),需推动测试报告纳入伦理审计模块。

-

二、2026新战场:测试员的转型与实战策略

阴暗面催生了测试角色的进化——从功能验证者转向风险治理者。2026年,测试员需掌握以下核心能力:

-

技能升级:AI原生测试技术栈

-

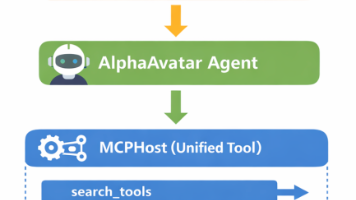

工具精通:熟练使用AI辅助测试工具(如Testim.io的AI脚本生成),并开发定制化框架。例如,结合LangChain构建提示工程测试流水线,自动检测输出一致性。

-

方法论迭代:推广“Shift-Left AI Testing”,在开发早期介入。采用行为驱动开发(BDD)编写Gherkin脚本,将伦理和安全需求转化为可测试场景。

-

数据能力:测试员需主导数据治理,使用Synthetic Data Vault生成代表性测试数据集,覆盖长尾案例。

-

-

流程重构:从测试到持续监控

2026年,测试不再限于发布前阶段,而是贯穿AI生命周期:-

持续测试流水线:集成CI/CD工具(如Jenkins+TensorFlow Extended),实时监控模型漂移。例如,当模型准确率下降5%时自动触发重测试。

-

生产环境监控:部署AIOps工具(如Dynatrace),追踪实时用户交互,识别异常模式。某社交平台通过此方式拦截了15%的恶意内容生成尝试。

-

跨职能协作:测试员与数据科学家、合规官组成“AI治理小组”,月度风险评估会制度化。

-

-

应对阴暗面的战术手册

针对前述风险,2026年测试团队应实施分层策略:-

短期(0-6个月):建立偏见检测基线,对所有AI模型进行合规扫描(使用开源库如AI Fairness 360)。

-

中期(6-12个月):开发对抗性测试套件,模拟国家级攻击者(APT)场景,提升系统韧性。

-

长期(1年以上):推动行业标准制定,如参与IEEE P7008(AI伦理测试规范)的修订,将测试案例库开源共享。

-

三、未来展望:测试员在AI时代的角色重塑

生成式AI的阴暗面并非末日预言,而是测试专业化的催化剂。至2026年末,我们预见三大趋势:

-

测试民主化:低代码AI测试平台(如Selenium+GPT-4集成)让非技术用户参与验证,测试员转为策略制定者。

-

法规驱动:欧盟《AI法案》全面生效,强制要求第三方伦理测试认证,测试服务市场将增长300%。

-

人机协作深化:AI测试助手(如GitHub Copilot for QA)处理重复任务,测试员聚焦复杂决策与创新。

在这场新战场中,测试员的核心价值从“发现缺陷”升维至“保障可信AI”。唯有拥抱变革,持续学习,方能在2026年的技术浪潮中立于不败之地。

专业提示:本文基于2026年行业报告(如Gartner《AI Risk Management》)及实战案例撰写,测试员可参考MITRE ATLAS框架构建自适应测试体系。

精选文章

更多推荐

已为社区贡献116条内容

已为社区贡献116条内容

所有评论(0)