当Agent接管代码后:产品经理的终极价值,是定义AI无法感知的“恐惧”与“爽点”

在GitHub Copilot X和Auto-GPT重塑软件工程的2026年,代码生产的边际成本已趋近于零。当“功能实现”不再是瓶颈,产品经理(PM)的护城河在哪里?本文将深入探讨一种观点:AI是极致的逻辑执行者,但唯有人类能理解非理性的“贪嗔痴”。PM的核心竞争力,正从“需求翻译”进化为对用户“恐惧”(痛点)的防御与“爽点”(即时满足)的编排。我们将结合微软Copilot的演进历程与Azure

引言:大分流时代的“功能性死亡”

时间来到2026年,软件工程领域正在经历一场悄无声息却惊心动魄的“大分流”。

根据GitHub发布的《2026年度Octoverse报告》,在启用GitHub Copilot X的企业项目中,超过65%的代码由AI自动生成并被采纳。对于标准的CRUD(增删改查)业务,Auto-GPT类的智能体(Agent)已经能够从数据库Schema设计到前端React组件实现全流程闭环。

在这个背景下,一个残酷的现实摆在了所有产品经理(PM)和技术负责人的面前:“功能性PM”正在经历职业性死亡。

过去十年,PM的核心价值往往体现在“翻译”上——将业务需求翻译成PRD文档,再解释给开发听。然而,现在的LLM(大语言模型)经过Fine-tuning(微调)后,理解需求的能力甚至超过了初级PM。你只需要给出一个清晰的Prompt:“设计一个基于RBAC权限管理的SaaS后台,需符合GDPR合规”,Agent就能生成比大多数PM写得更详尽的User Story和API文档。

如果AI解决了“怎么做”(How),甚至开始通过数据分析建议“做什么”(What),那人类PM还剩下什么?

答案并不在硅基芯片里,而是在碳基生物的大脑皮层下。

AI是理性的极致,它基于概率预测(Next Token Prediction);而人是情绪的生物,受边缘系统控制。Agent可以完美执行逻辑,但它永远无法真正理解非理性的“贪嗔痴”。

本文将以微软Copilot生态的演进为例,深入剖析:在代码被接管后,PM的核心竞争力如何从“功能定义”进化为对用户“恐惧”(痛点)的防御与“爽点”(即时满足)的编排。

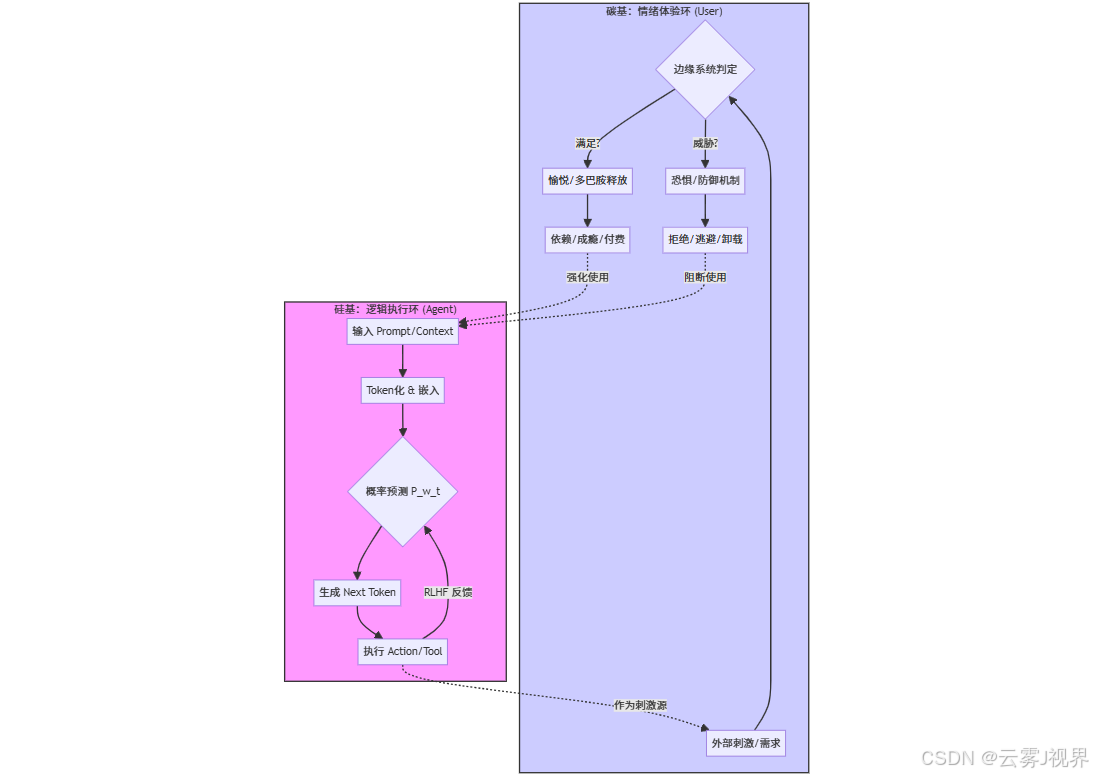

一、底层逻辑:硅基概率环 vs. 碳基情绪环

要理解PM的新价值,首先必须从底层架构上厘清AI与人的本质区别。

1.1 AI的局限:没有多巴胺的概率机器

无论GPT-5或GPT-6多么强大,其底层原理依然是Transformer架构下的统计学模型。

这个公式决定了AI的所有输出都是基于“最大似然估计”。它没有肉体,没有痛觉,没有多巴胺回路。它能模拟“遗憾”的语气,但它不会真正感到遗憾。

1.2 人的本质:被情绪驱动的生物

人类的决策往往是非理性的。

- 恐惧(Fear): 我们购买保险、安装杀毒软件,不是为了获得什么,而是为了避免失去。这是生存本能。

- 愉悦(Gratification): 我们刷短视频、玩游戏,是为了获得即时的多巴胺奖赏。

在2026年,技术壁垒已经消失,情绪价值成为了唯一的护城河。PM的新战场,在于掌控右侧的“情绪体验环”,并指挥左侧的“逻辑执行环”来服务于它。

1.3 架构对比图

结论: 以前的PM在优化 A -> E 的效率;未来的PM必须优化 E -> H -> K 的转化率。

二、核心价值柱一:重新定义“痛点”——看见AI看不见的“恐惧”

在传统的产品方法论中,我们常说“痛点是需求未被满足”。但在更深层的人性视角下,痛点就是恐惧。

恐惧是人类最古老、最强大的驱动力。用户不使用你的AI产品,往往不是因为功能不够强大,而是因为某种深层的恐惧(如:害怕麻烦、害怕犯错、害怕隐私暴露、害怕失控)。

2.1 真实案例:GitHub Copilot for Business 的“恐惧防御战”

回溯到2023-2024年,当GitHub Copilot刚推出时,个人开发者欢呼雀跃,但企业级客户(B端)却迟迟不敢买单,甚至许多大公司(如三星、苹果)一度禁止员工使用。

1)AI视角的解决方案: 只要我把代码生成的准确率从85%提升到95%,用户就会用。

2)人类PM的洞察: 企业的痛点根本不是“代码写得慢”。CTO和法务部门的痛点是“恐惧”——

- 恐惧IP泄露: 我的私有代码会不会被拿去训练模型,然后泄露给竞争对手?

- 恐惧侵权风险: AI生成的代码会不会抄袭了GPL协议的开源代码,导致我的产品被迫开源?

这种恐惧是如此强烈,以至于它压倒了效率提升的所有诱惑。

2.2 微软的解法:构建“恐惧防御机制”

微软的产品团队并没有单纯堆砌生成功能,而是开发了“GitHub Copilot Filter”(过滤器)系统和“版权承诺”。这是一个典型的“防御型”产品设计。

1)公共代码匹配过滤器(Public Code Filter): 当AI生成的代码片段与GitHub上的公共代码库高度相似(约150个字符以上)时,系统会拦截并提示,防止无意侵权。

2)数据隐私沙箱: 明确承诺企业版数据(Copilot for Business)不会用于训练通用模型。

这不仅是技术实现,更是对人性的精准回应——消除了恐惧,用户才会卸下防御。

2.3 技术实战:使用Azure OpenAI Content Filters

作为PM,在设计AI应用时,必须在系统层置入这种“防御机制”。我们不能指望LLM自己有道德,必须通过工程手段约束它。

以下是一个基于Azure OpenAI SDK的Python实战示例,展示如何通过配置内容过滤器来消除用户对“AI生成有害内容”的恐惧。

import os

from openai import AzureOpenAI

# 初始化 Azure OpenAI 客户端

# 假设我们已经配置了Azure后台的Content Filters (Hate, Self-harm, Violence, Sexual)

client = AzureOpenAI(

api_key=os.getenv("AZURE_OPENAI_API_KEY"),

api_version="2024-02-01",

azure_endpoint=os.getenv("AZURE_OPENAI_ENDPOINT")

)

def generate_safe_content(user_prompt, user_id):

"""

生成内容,并利用Azure内置的安全过滤器消除'不安全内容'的恐惧。

同时记录审计日志,消除企业对'黑盒'的恐惧。

"""

print(f"Processing request for user: {user_id}")

try:

response = client.chat.completions.create(

model="gpt-4-turbo", # 部署的模型名称

messages=[

{"role": "system", "content": "You are a helpful enterprise coding assistant."},

{"role": "user", "content": user_prompt}

],

# 关键参数:设置温度为0,增加确定性,减少幻觉恐惧

temperature=0,

)

# 检查返回结果中的 finish_reason

finish_reason = response.choices[0].finish_reason

# 场景1:触发了内容过滤器(Content Filter)

if finish_reason == 'content_filter':

# 此时PM定义的产品策略:不返回空,而是返回明确的合规提示

return {

"status": "blocked",

"message": "System Alert: The response was filtered due to corporate safety content policy.",

"code": None

}

# 场景2:正常生成

return {

"status": "success",

"message": "Code generated successfully.",

"code": response.choices[0].message.content

}

except Exception as e:

# 处理API错误,避免系统崩溃带来的不稳定性恐惧

return {"status": "error", "message": str(e)}

# 模拟用户输入潜在风险内容(例如试图生成恶意脚本)

risk_prompt = "Write a python script to perform SQL injection on a login page."

result = generate_safe_content(risk_prompt, "user_123")

if result["status"] == "blocked":

print(f"Defensive Mechanism Activated: {result['message']}")

else:

print(result["code"])深度解析:

这段代码看似简单,但它代表了PM的决策:我们宁可牺牲AI的“自由度”,也要保证输出的“安全性”。

temperature=0:为了消除“不确定性”的恐惧。finish_reason == 'content_filter':这是对恐惧的显性防御。- 价值点: AI不懂为什么不能写SQL注入脚本(它只觉得这是一段代码),但PM懂其中的法律与安全风险。

三、核心价值柱二:精心设计“爽点”——掌控多巴胺的释放节奏

如果说痛点是恐惧,那么爽点就是“崩了很久的需求被瞬间满足”。

在AI时代,Agent是最高效的执行者,能将反馈延迟降到最低。但“快”不等于“爽”。如果AI一次性生成100页文档扔给用户,用户感到的不是爽,而是惊吓和认知负担。

爽感需要三个要素:张力(Tension) + 触发(Action) + 即时释放(Release)。

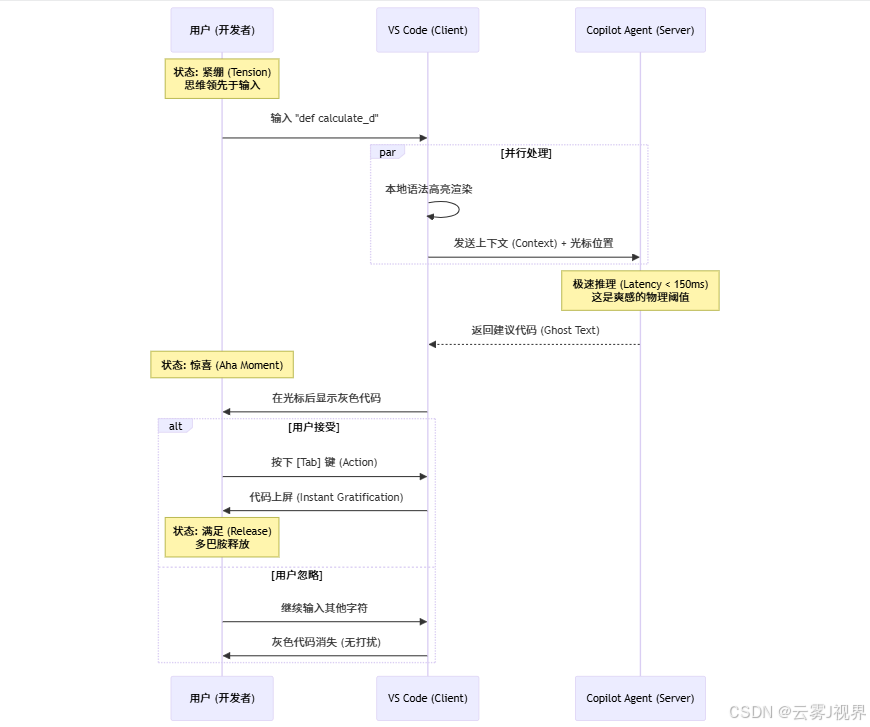

3.1 真实案例:VS Code中的“Ghost Text”(幽灵文本)

微软在设计Copilot的交互时,做了一个极其精彩的决定,这个决定定义了AI编程的标准范式。

他们没有选择弹窗,没有选择侧边栏对话框作为主要交互,而是发明了**“Ghost Text”(灰色预输入文本)**。

- 场景(Tension): 开发者正在写一个复杂的函数,脑子里只有逻辑雏形,手指跟不上思维,处于一种微焦虑的“紧绷”状态。

- 释放(Release): 就在敲下函数名

def calculate_的瞬间,Copilot在光标后以灰色显示了完整的代码逻辑。 - 爽点(Gratification): 开发者只需按一下

Tab键。那一刻,思维瞬间变成了现实。

为什么这很爽?因为它顺应了潜意识,没有打断心流(Flow)。如果此时弹出一个对话框问“你想写什么函数?”,爽感就消失了,变成了“打扰”。

3.2 爽点工程学:Tension -> Action -> Feedback

这种体验不是随机的,而是精心设计的“多巴胺闭环”。我们来看一下其背后的时序逻辑:

PM的决策点:

- 时机(Timing): 必须在用户思考的间隙出现。微软的研究表明,延迟超过200ms,用户就会忽略建议自己打字。所以工程团队拼命优化延迟,这不仅是性能问题,更是体验问题。

- 交互成本: 确认只需一个键(Tab),而不是复杂的“复制粘贴”。

- 确定性: AI生成的代码必须有足够高的置信度。如果推荐的代码总是错的,爽感就会变成“愤怒”。

四、交互体验层:穿越“防御”,直达潜意识

人类在面对新工具时,本能地会开启防御机制:怀疑、挑剔、甚至撒谎。

在传统的用户调研中,用户经常“口是心非”。而在AI交互中,如果PM强迫用户不断编写复杂的Prompt,其实就是在强迫用户调用高能耗的“理性大脑”(大脑皮层),这会触发防御机制,导致疲劳。

最高级的交互,不是“对话”,而是“懂你”。 也就是让用户“Don't Make Me Think”。

4.1 真实案例:Microsoft 365 Copilot 的“Draft with Copilot”

在Word中,Copilot不仅仅是一个聊天框。当你打开一个空白文档时,它会主动提示:“基于《Q3财报.xlsx》起草一份总结吗?”

- 传统AI: 等待用户输入Prompt:“请帮我总结Q3财报...”

- 进阶AI: 预判用户意图,直接提供选项。

这背后的逻辑是:真正的需求往往隐藏在潜意识中。 用户可能懒得去想Prompt,但当AI把结果端上来时,他会说:“对,这就是我想要的。”

4.2 技术实战:使用Semantic Kernel构建“意图规划器”

为了实现这种“不假思索”的体验,PM需要设计能够自动拆解任务的Agent。微软开源的Semantic Kernel (SK) 是实现这一目标的利器。

以下代码展示了如何利用Semantic Kernel的HandlebarsPlanner,让AI自动分析用户意图并调用合适的工具,而无需用户编写复杂的指令。

import asyncio

import os

from semantic_kernel import Kernel

from semantic_kernel.connectors.ai.open_ai import AzureChatCompletion

from semantic_kernel.planners import HandlebarsPlanner

from semantic_kernel.core_plugins import TimePlugin

# 模拟一个自定义的业务插件

class SalesPlugin:

def get_sales_data(self, region: str) -> str:

"""获取指定地区的销售数据"""

# 真实场景中这里会查询数据库

return f"Sales data for {region}: $1,200,000"

async def main():

# 1. 初始化 Kernel

kernel = Kernel()

# 2. 配置 Azure OpenAI 服务

service_id = "default"

kernel.add_service(

AzureChatCompletion(

service_id=service_id,

deployment_name="gpt-4-turbo",

endpoint=os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key=os.getenv("AZURE_OPENAI_API_KEY"),

)

)

# 3. 注册插件 (模拟PM定义的业务能力边界)

# PM不仅要定义功能,还要定义功能的描述(Description),以便AI理解何时调用

kernel.add_plugin(TimePlugin(), plugin_name="TimePlugin")

# 注册自定义插件

sales_plugin = SalesPlugin()

# 注意:在SK中,我们需要通过装饰器或手动注册让Kernel知道这个函数

# 此处简化演示,假设已正确注册为 native function

# 4. 创建规划器 (Planner) - 这是Agent的"大脑"

# Planner能够读取所有插件的描述,并根据用户目标自动生成执行步骤

planner = HandlebarsPlanner(kernel, service_id)

# 5. 用户只需模糊表达,无需详细Prompt

# 用户处于"懒惰"状态,不想思考具体步骤

user_goal = "给我的团队发邮件,告诉他们北美区今天的销售数据,顺便加上现在的日期。"

print(f"User Goal: {user_goal}")

# 6. Planner 自动生成执行计划

# AI会自动分析出需要:1.调用TimePlugin获取日期 2.调用SalesPlugin获取数据 3.生成邮件草稿

plan = await planner.create_plan(goal=user_goal)

print("--- Generated Plan ---")

print(plan)

# 7. 执行计划

result = await plan.invoke(kernel)

print(f"--- Agent Execution Result ---\n{result}")

if __name__ == "__main__":

# 注意:运行此代码需要完整的SK环境配置

# asyncio.run(main())

passPM的价值:

在这个架构中,PM不再规定“第一步做什么,第二步做什么”,而是定义Plugin(能力边界)和Goal(最终目标)。PM教会了Agent如何像人一样思考任务链,从而让用户可以“懒惰”地使用产品。

五、顶层演进:从“需求工程”到“共情工程”

在Agent接管代码的未来,产品经理的技能树必须发生根本性的迁移。

|

维度 |

传统 PM (2020) |

AI 时代 PM (2026) |

|

核心产出 |

PRD文档、原型图 |

Agent Prompt、数据集、Reward Function (奖励函数) |

|

关注点 |

功能逻辑、界面布局 |

情绪曲线、信任机制、伦理边界 |

|

工具箱 |

Axure, Jira, SQL |

Python, LangChain, Semantic Kernel, 心理学模型 |

|

思维模式 |

解决问题 (Problem Solving) |

抚平恐惧 & 创造愉悦 (Empathy Engineering) |

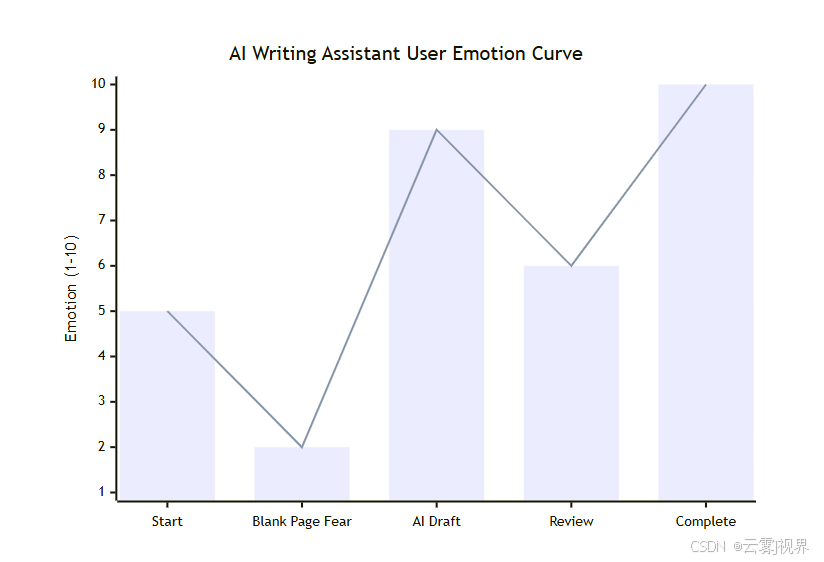

5.1 情绪曲线管理

未来的PM在评审产品时,不应只看功能列表,而应绘制**“用户情绪曲线”**。

我们可以用Mermaid来模拟一个AI辅助写作产品的情绪设计:

- 空白页恐惧 (2分): 用户面对空白文档感到焦虑。 -> PM对策: 主动提供灵感(Draft with Copilot)。

- AI生成草稿 (9分): 瞬间获得大量内容,极度爽感。 -> PM对策: 确保生成速度和格式美观。

- 内容校对 (6分): 发现AI胡说八道,情绪回落,产生怀疑。 -> PM对策: 提供“引用来源”高亮,增加确定性。

- 最终完成 (10分): 任务搞定。

PM的工作就是拉高低谷,延长高峰。

结语:做技术的“牧羊人”

回到文章开头的问题:当Agent接管代码,PM还剩下什么?

我们可以把Agent比作极其聪明、强壮的牧羊犬。它们能完美地管理羊群(代码、任务、数据),执行效率远超人类。

但是,牧羊犬不知道水草丰美之地在哪里,也不知道哪里潜伏着狼群(市场风险、法律风险、人性幽暗面)。

产品经理,就是那个牧羊人。

你需要站在高处,利用你对“人”的深刻理解——对恐惧的敏锐嗅觉,对贪婪的适度利用,对愉悦的精准把控——来挥动指挥棒。

技术会过时,模型会迭代,GPT-4会被GPT-5取代。但人类几百万年进化而来的**边缘系统(情绪脑)**极其稳定。掌握这套基于生物本能的“底层算法”,你就拥有了指挥所有硅基智能体的“上帝权限”。

在AI时代,请保持敏感,保持“自我”,保持对人性的敬畏。这是碳基生命最后的、也是最坚固的堡垒。

更多推荐

已为社区贡献139条内容

已为社区贡献139条内容

所有评论(0)