AIIA:行业数智化AI安全实践研究报告 2026

技术层面:覆盖基础设施(硬件可信根缺失、计算环境防护短板、供应链投毒等)、数据(计算态防护失效、数据投毒 / 泄露、训练数据版权合规风险等)、模型(对抗攻击、模型反推、算法偏见等)、应用服务(API 滥用、Agent 越权、AI 赋能攻击等)全链条,各环节风险相互叠加放大。制造领域:参考等保三级要求构建安全体系,结合 AI 分级分类、数据全链路审计、推理业务防火墙等措施,解决模型备案、云上推理安全

这份由华为、中国信通院等单位联合编写的《行业数智化 AI 安全实践研究报告》,立足 2026 年 “人工智能 +” 国家级推进背景,围绕行业 AI 深度融合下的安全问题展开全面分析,提出了端到端的安全治理体系,并结合金融、政务、医疗、制造四大重点行业实践给出落地方案,最后展望了行业 AI 安全治理的发展方向,核心内容可总结为以下五大方面:

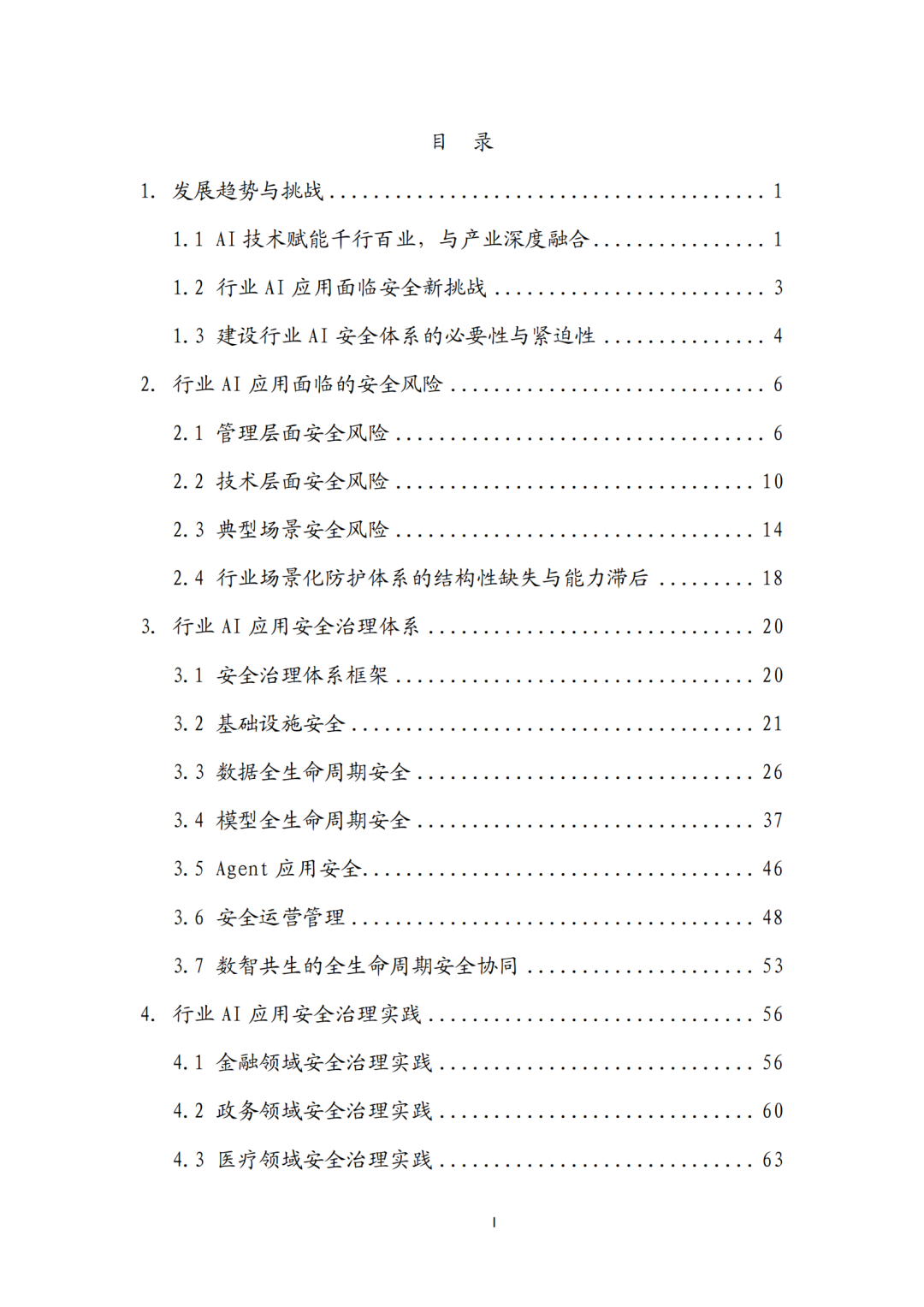

一、发展背景与核心挑战

融合趋势:AI 技术已从技术爆发迈向产业深耕,成为重塑产业结构的新型基础设施,与各行业从单点工具应用转向全业务流程深度融合,呈现业务流程重构、跨领域协同等特征,同时《国务院关于深入实施 “人工智能 +” 行动的意见》等政策明确了发展与安全并重的导向。

三重挑战:行业 AI 安全呈现 “管理 - 技术 - 场景” 多维交织的系统性问题,管理层面存在监管细则缺失、责任认定模糊、传统安全制度失效等问题;技术层面存在基础设施、数据、模型、应用服务全链条的内生性安全隐患;场景层面通用防护手段难以适配行业异构需求,防护能力与业务发展存在速度差。

建设必要性:AI 已成为行业核心基础设施,安全问题从 “附加题” 变为 “必答题”,构建系统化 AI 安全体系是落实国家总体安全观、应对全球严监管、破解行业落地痛点的迫切需求。

二、全维度安全风险剖析

报告从管理、技术、典型场景三大维度拆解行业 AI 应用的安全风险,同时指出行业场景化防护体系存在结构性缺失与能力滞后问题:

管理层面:垂直行业监管细则缺位,关键基础设施、金融 / 医疗等强监管领域存在监管盲区;AI 全生命周期合规指引有断点,数据治理、模型运维等环节缺乏操作标准;技术标准定性多定量少,行业专用合规工具链匮乏;人机协同下责任链条模糊,企业存在合规债务与创新保守倾向。

技术层面:覆盖基础设施(硬件可信根缺失、计算环境防护短板、供应链投毒等)、数据(计算态防护失效、数据投毒 / 泄露、训练数据版权合规风险等)、模型(对抗攻击、模型反推、算法偏见等)、应用服务(API 滥用、Agent 越权、AI 赋能攻击等)全链条,各环节风险相互叠加放大。

典型场景层面:既有 AIGC 深度伪造引发的身份互信危机、Prompt 注入导致的数据泄露等跨行业共性风险,也有各行业特有风险,如制造业的生产数据泄露与设备控制风险、医疗行业的隐私泄露与诊疗误诊风险、金融行业的算法歧视与模型投毒风险、政务领域的隐私泄露与决策公平性风险等。

三、端到端的安全治理体系构建

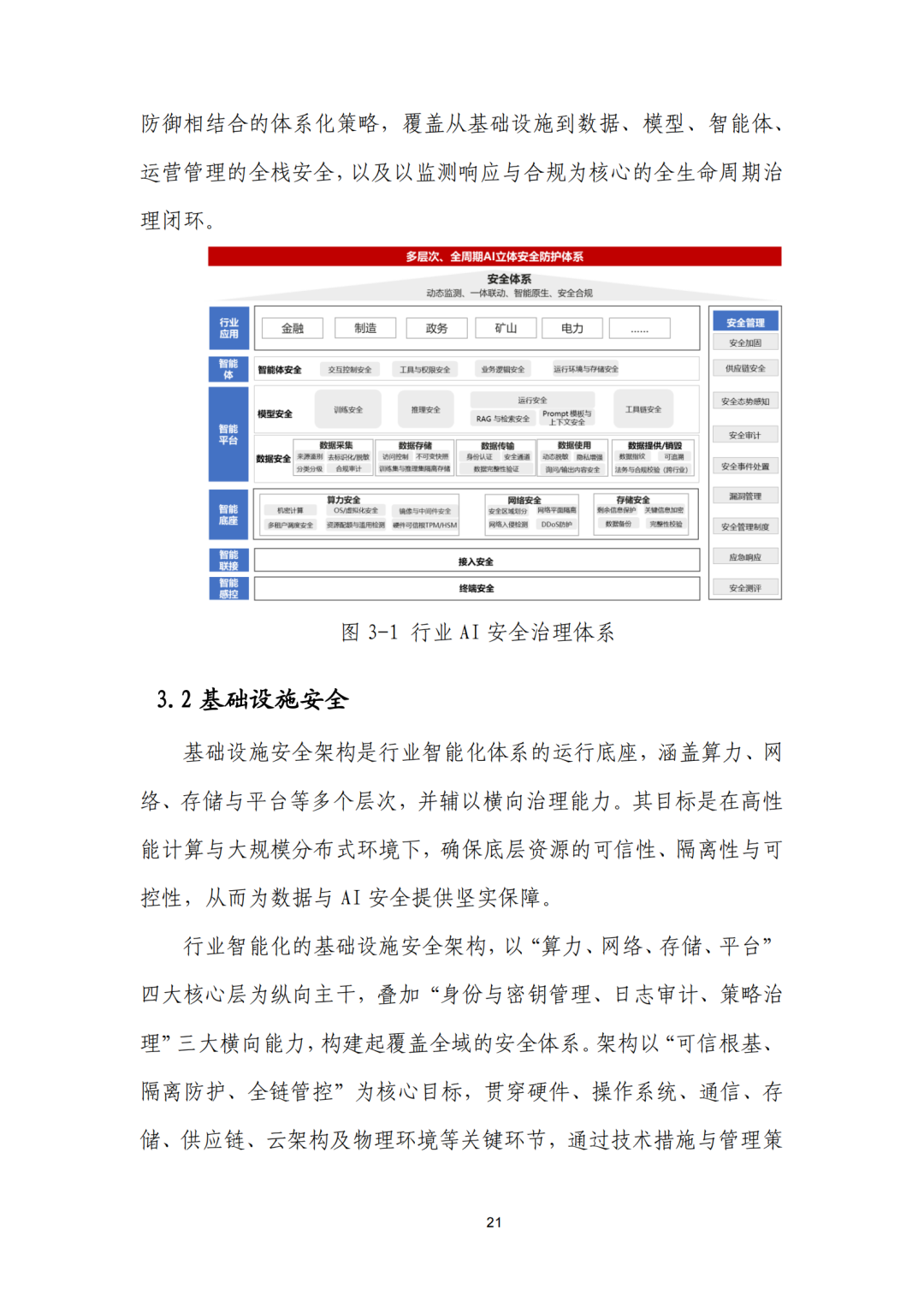

报告提出以 **“端到端、分层解耦”** 为核心思路,以 “安全即内建、安全即默认” 为设计原则的行业 AI 安全治理体系,构建 “1+3+1”(基础设施 + 数据 / 模型 / Agent + 运营管理)的全生命周期协同框架,核心模块包括:

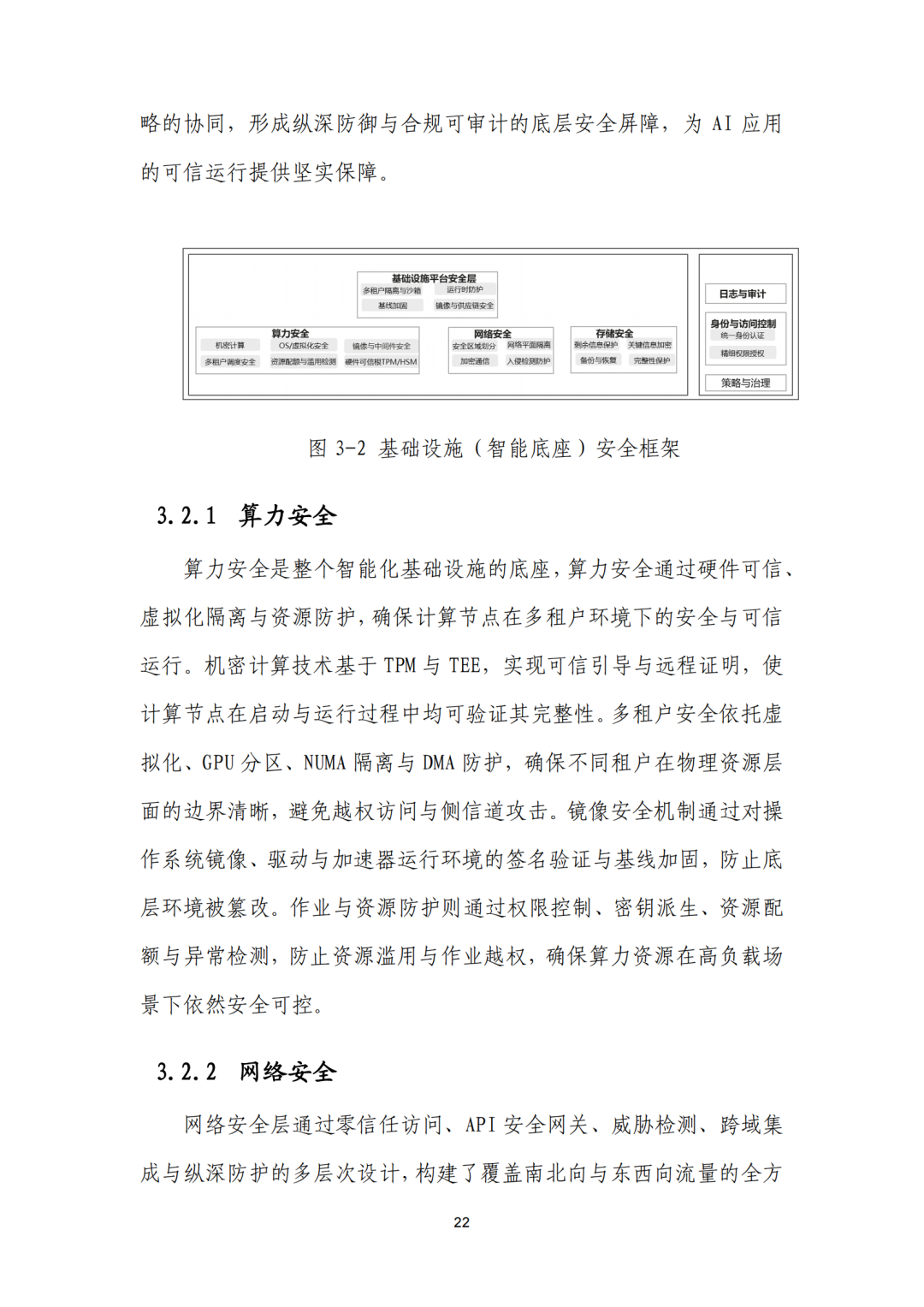

基础设施安全:以算力、网络、存储、平台为纵向主干,叠加身份与密钥管理、日志审计、策略治理三大横向能力,筑牢物理与技术底座,确保运行环境可信、隔离、可控。

数据全生命周期安全:遵循分类分级、全链防护、合规可控三大原则,覆盖数据采集、存储、使用、传输、销毁五大阶段,通过统一采集平台、隐私计算、动态标签索引等技术,保障数据的机密性、完整性与合规性。

模型全生命周期安全:覆盖算法工具链、训练、部署与运行全环节,通过供应链安全管理、对抗训练、后门防御、模型对齐、推理鲁棒性防护等措施,实现模型的可信根基、全链防护、合规可控。

Agent 应用安全:聚焦 Agent 运行、用户交互、内容、业务逻辑安全及可解释性与审计五大方面,通过行为约束、权限控制、内容过滤、流程校验等,确保 Agent 自主运行可控、合规、可追溯。

安全运营管理:建立 “检测 - 响应 - 优化 - 复盘” 的跨域协同动态防御闭环,构建全生命周期治理与合规架构,通过端到端闭环治理、分层解耦落地(控制面与数据面分离、模块化可替换等),实现安全策略的统一制定、下发与执行。

数智共生协同:确立基础设施为底座,数据、模型、智能体为核心要素,运营管理为中枢的协同逻辑,明确各生命周期阶段的安全锚点、核心责任与治理工具,实现全链路安全联动。

四、四大重点行业安全治理实践

报告结合金融、政务、医疗、制造四大行业的业务特性与安全痛点,给出针对性的安全治理方案与实践成效,核心共性为全流程闭环防控、技术与管理结合、贴合行业合规要求,各行业特色如下:

金融领域:围绕模型内在、应用、上线运营三大阶段,构建全链路一体化防控体系,重点解决数据泄露、算法歧视、模型攻击等问题,实现数据合规、内容安全、运营可控,对齐金融监管要求。

政务领域:从 Prompt 注入检测、内容审核、个人数据脱敏、AIGC 鉴伪四大维度构建内容安全防线,通过 AI 内容安全检测系统过滤恶意流量,实现内容合规、隐私无忧,满足等保、密评要求。

医疗领域:建设 “一个中心(安全运营中心)+ 三重防护” 体系,叠加图片训练安全、DDoS 防护等专项措施,解决云上业务暴露、医疗数据泄露、模型内容安全等问题,实现数据零泄漏、威胁防御自动化。

制造领域:参考等保三级要求构建安全体系,结合 AI 分级分类、数据全链路审计、推理业务防火墙等措施,解决模型备案、云上推理安全、数据合规、内容安全等问题,实现安全用云、数据合规能力提升,满足备案要求。

五、未来发展展望

报告提出行业 AI 安全治理将分阶段推进,短期聚焦基础补齐与共识建立,长期迈向自主可控与生态共建,核心方向为:

短期(2-3 年):筑牢可信底座,在关键行业规模化落地内生安全;深化数据治理,构建全生命周期技术化管控闭环;统一行业标准,将伦理规范转化为量化技术指标,建立人机协同的标准化运营体系,解决防护能力滞后、数据管理粗放、应急响应缺位等问题。

长期(3-5 年及更久):构建自主可控的 AI 安全技术底座,实现国产化软硬件全栈适配,发展可解释性 AI 打破算法黑箱;打造 “以模治模” 的智能进化防御体系,实现 AI-Native 的内生智能防御;打破行业与国界的安全孤岛,建立跨域威胁情报共享联盟,参与全球 AI 安全治理规则制定,输出中国方案,构建多方共治的全球 AI 安全生态。

整体而言,报告全面梳理了行业数智化转型中 AI 安全的核心问题、治理体系与落地实践,为各行业构建 AI 安全治理体系提供了系统化的理论框架与可复制的实践参考,明确了 “安全与发展并重、技术与管理协同、单点防护向体系化治理升级” 的行业 AI 安全发展核心逻辑。

更多推荐

已为社区贡献71条内容

已为社区贡献71条内容

所有评论(0)