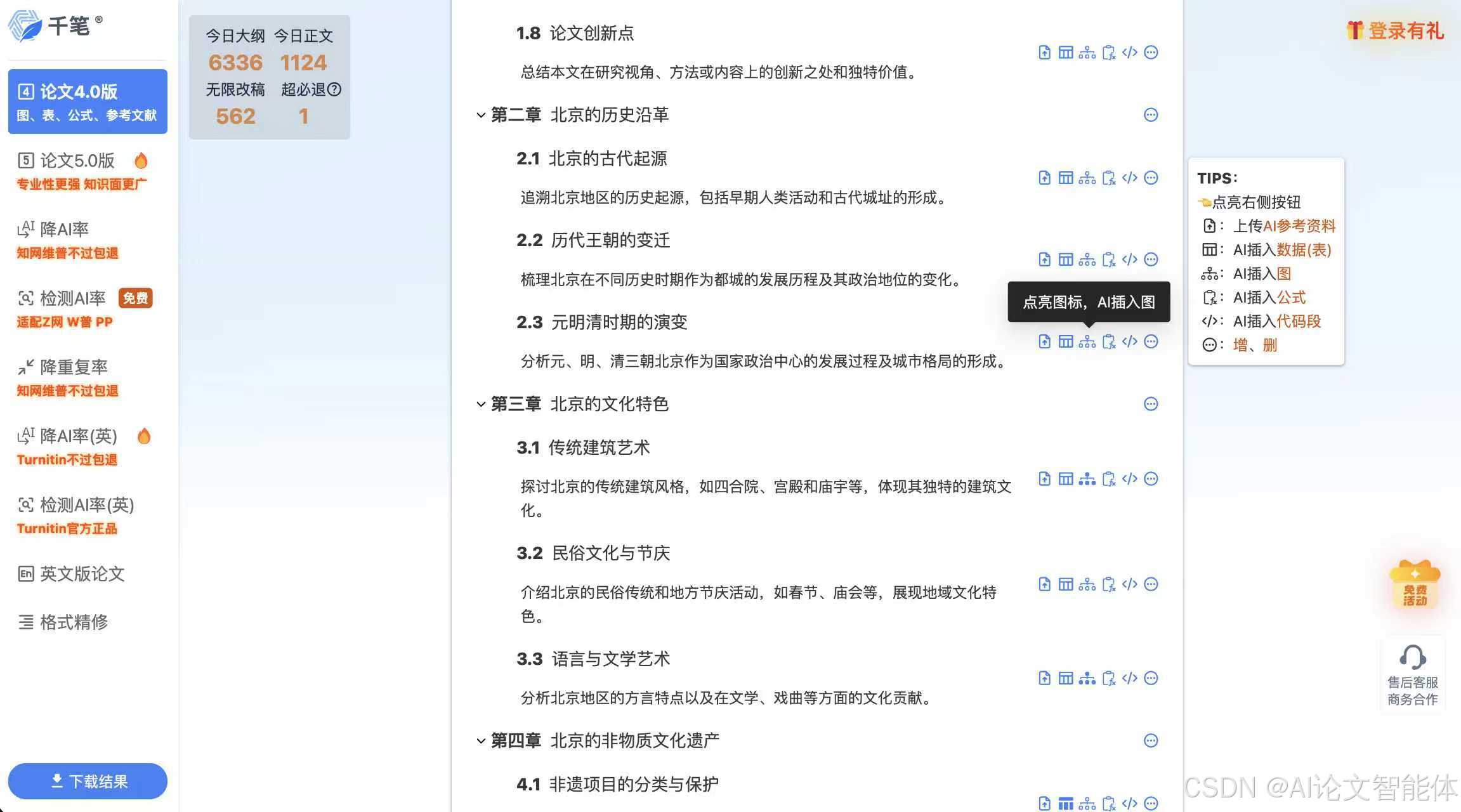

QDKT2-4-大模型评估维度和选型指南

参数规模是指模型中可调整的参数总数,单位为“B”(1B=10亿个参数),相当于模型的“先天智商”,直接关联模型的知识储备和规律学习能力。:如果任务涉及多场景需求(如“图文结合生成宣传视频”),优先选择多模态模型,避免多个单模态模型拼接(会出现信息不对齐,导致“幻觉”)。上下文长度指模型一次能处理的“输入+输出”总TOKEN数,相当于模型的“记事本容量”,决定了模型能记住的对话/文本长度。选型的核心

一、大模型评估核心维度

大模型的评估主要分为两大板块:固定属性(模型与生俱来、不可改变的核心特征)和任务适配指标(模型在具体任务中的表现能力)。这两大板块共同决定了模型是否能满足你的实际需求。

(一)固定属性:模型的“先天条件”

固定属性是模型的基础特质,选择时需优先匹配核心需求,一旦选定无法修改。主要包括3个关键指标:

1. 模态:模型能“处理”和“输出”哪些类型的信息

模态是指模型支持的输入和输出数据类型,直接决定了模型能完成的任务范围。不同模型的模态能力差异显著,需根据任务场景精准选择。

|

模态类型 |

核心能力 |

典型案例 |

关键说明 |

|

文本模态 |

仅处理文本(输入/输出均为文字) |

早期GPT-3、基础版千问 |

适用于文案生成、文本总结、问答等纯文字任务 |

|

文本+图像理解+生成 |

能理解图片信息,也能根据文字生成图片,支持参考图输入 |

豆包多模态模型、GPT-4O |

需同时具备图像理解和文本理解能力,可实现“参考图生图”“图文结合创作” |

|

仅文字生图 |

只能根据文字描述生成图片,不支持参考图 |

部分早期SD模型 |

输入仅为文字关键词,无法基于现有图片调整创作 |

|

语音相关模态 |

文字转语音(TTS)、语音克隆、语音情绪识别、音频转文字 |

B站index TTS(带情绪的TTS)、阶跃星辰音频情绪识别模型 |

语音克隆需提取音色特征,情绪识别/生成是高级能力 |

|

视频相关模态 |

文字生视频、文本+参考图生视频、视频内容理解 |

谷歌VEO13(生视频带声音)、部分多模态模型 |

视频理解需同时具备图像抽帧理解、音频理解、文本整合能力 |

核心原则:如果任务涉及多场景需求(如“图文结合生成宣传视频”),优先选择多模态模型,避免多个单模态模型拼接(会出现信息不对齐,导致“幻觉”)。

2. 参数规模:模型的“知识储备量级”

参数规模是指模型中可调整的参数总数,单位为“B”(1B=10亿个参数),相当于模型的“先天智商”,直接关联模型的知识储备和规律学习能力。

(1)参数规模的计算逻辑

模型参数由多层计算单元叠加而成:

- 每层计算需处理“TOKEN数量×维度数量”的坐标(如129000个TOKEN×7168个维度≈9亿个可调整坐标/层)

- 多层计算(如32层)+ 最终向量转TOKEN的计算,总和即为参数量级

(2)参数规模的核心认知

|

关键结论 |

具体说明 |

|

并非越大越好 |

千亿参数规模(如GPT系列)已能覆盖绝大多数人类知识;超过千亿后,边际效益递减 |

|

万亿参数的核心原因 |

部分模型千亿参数时训练的规律存在错误,需通过扩大参数弥补“度量维度不足”,但方向错误时扩大参数无效 |

|

激活参数的意义 |

部分模型标注“1.6万亿总参数”但“激活参数320亿”,因320亿已能满足特定任务需求,无需全量调用 |

|

与成本直接挂钩 |

参数规模越大,推理消耗的算力、存储成本越高(部署时需重点考虑) |

(3)部署显存计算(零基础必学)

模型部署时需占用显存(显卡内存),核心计算公式:

- 基础显存需求=参数量(B)× 每个参数占用字节数

- 常规精度:1个参数=4字节(如14B模型基础显存=140亿×4=560亿字节≈52.9GB)

- 量化压缩(INT4):1个参数=0.5字节(如14B模型量化后基础显存=140亿×0.5=70亿字节≈6.5GB)

- 实际显存需求=基础显存×1.2~1.3(预留推理计算、向量转换等额外消耗)

举例:14B模型(量化INT4)实际显存需求≈6.5GB×1.2≈7.8GB,需至少8GB显存的显卡支持。

3. 上下文长度:模型的“短期记忆力”

上下文长度指模型一次能处理的“输入+输出”总TOKEN数,相当于模型的“记事本容量”,决定了模型能记住的对话/文本长度。

(1)核心概念

- TOKEN单位:1K=1024个TOKEN,常见长度为4K、8K、32K、64K、128K、256K(均为2的倍数)

- TOKEN与字数的关系:1个TOKEN≈1.52个中文字符(如8K上下文长度≈1.2万1.6万字)

- 计算规则:上下文长度=输入TOKEN数+输出TOKEN数(如输入1000字+输出1000字≈占用2000个TOKEN)

(2)关键注意事项

- 收费逻辑:多数模型输入和输出分别计价,输出价格是输入的3~4倍(因输出需逐字计算迭代)

- 注意力机制限制:上下文过长时,模型注意力会分散,无法聚焦关键信息(如256K长度可能遗漏早期重要内容)

- 实用建议:避免“吃满”上下文长度,建议及时压缩对话、新开会话,让模型注意力集中在核心任务上

(二)任务适配指标:模型的“后天实战能力”

在固定属性匹配需求后,需评估模型在具体任务中的表现。不同类型模型(语言模型、图像模型)的核心指标不同,需针对性测试。

1. 语言模型:四大核心评估指标(产品选型重点)

语言模型是目前应用最广泛的类型,评估需聚焦“能否可靠完成任务”,而非依赖厂商榜单(榜单题目可能被提前纳入训练),需在自身实际任务中测试。

(1)通用知识能力

- 核心定义:模型掌握的基础知识点广度和准确性,与参数规模强相关

- 评估标准:

- 千亿参数以上模型:基本能覆盖日常问题(如常识问答、行业基础知识点)

- 需关注回答风格:根据场景选择(如客服场景选“简洁型”,科普场景选“详细型”)

- 关键测试点:幻觉问题(模型是否“撒谎成性”),需多轮提问验证答案一致性(如“请介绍3个小众历史事件,说明时间、人物、影响”,验证信息真实性)

(2)指令依从能力

- 核心定义:模型是否严格按照用户设定的规则、步骤完成任务,是产品稳定运行的关键

- 重要性:长链任务(需3~4步完成)或模型独立决策场景(如Agent自动处理客户需求)中,指令依从差会导致系统Bug

- 评估方法:

- 给出复杂任务(如“整理10条客户反馈,分类为‘功能需求’‘体验问题’‘投诉’,每条标注关键词,最后生成汇总表格”)

- 合格标准:能自主完成10步以内的任务流程,不敷衍、不偏离设定规则

(3)工具调用能力

- 核心定义:模型是否能判断“何时需要工具”“如何正确使用工具”,扩展模型能力边界

- 典型场景:

- 数据量过大时(如几万行Excel表格计算),模型是否会提示“需调用Excel工具”或“请分批次提供数据”

- 需实时信息时(如“查询2025年行业最新政策”),模型是否会主动调用搜索引擎

- 评估重点:工具使用的“判断力”(不盲目硬算)和“适配性”(能正确对接工具接口),编程类、数据处理类产品需重点测试

(4)代码与推理能力

- 核心定义:模型编写代码、逻辑推理的能力,反映强化学习训练质量

- 核心价值:

- 代码能力可验证(有明确正确答案),是模型强化学习的“基础考核”,无代码能力的模型长期价值有限

- 推理能力支撑复杂逻辑任务(如数学计算、流程规划)

- 注意事项:代码能力过强可能导致语言表达过于简洁(如SONNET4、K2模型),需根据场景平衡(如聊天机器人需兼顾代码能力和语言流畅度)

2. 图像模型:四大评估指标(当前商用价值有限)

目前国内图像模型成品率仅60%左右(俗称“抽卡”),未达到商用所需的90%以上稳定率,但需了解核心评估维度:

(1)模型类型(架构差异)

|

架构类型 |

核心原理 |

代表模型 |

优点 |

缺点 |

|

Stable Diffusion(扩散模型) |

关键词+图像碎片化训练,以画面元素为单位生成 |

SD、Midjourney、早期通义万相 |

支持单点元素控制(如单独调整画面中的“花朵颜色”) |

易生成混乱内容(如“胸口长手”),依赖精准关键词 |

|

Transformer(注意力机制) |

基于语义理解,一段话对应完整图片内容 |

豆包Seed、Gemini Flash 2.5 Image |

支持“故事性生图”(如“夕阳下的海边小镇,有一位老人在钓鱼”),可语音修图 |

不支持单点控制,修改局部可能影响整体画面 |

趋势:Transformer架构将成为主流,语义理解能力更强,适配更多商用场景。

(2)角色一致性

- 核心定义:多次使用相同关键词生成同一主体(如“生成同一个人的正面、侧面、背影照片”),主体特征(如脸型、发型)是否一致

- 重要性:商用场景(如品牌IP形象设计、宣传素材制作)中,角色不一致会导致无法统一管理,是当前图像模型的主要缺陷

(3)中文支持能力

- 双重维度:

- 中文提示词理解:Transformer架构对语言无感,基本都能支持

- 中文生成能力:部分国外模型(如Banana)无法在图片中生成中文文字,国内模型(如豆包Seed)支持中文生成,更适配国内商用场景

(4)生成质量(像素分辨率)

- 核心指标:生成图片的像素尺寸(决定清晰度)

- 主流需求:商用场景需2K(2560×1440)以上,最低1080P(1920×1080)

- 现状:多数模型训练素材为512×512(0.5K),画面模糊;少数模型(如豆包)支持4K生成(训练素材为4K),适配实际应用

二、开源与闭源模型选型指南

选型的核心是“匹配需求”,而非盲目追求“开源便宜”“闭源更强”,需明确3个正确决策依据和3个常见误区。

(一)正确的选型依据(3个核心条件)

1. 隐私与合规需求

- 适用场景:数据为保密信息(如企业财务数据、客户隐私数据),或财务审计要求数据不外流

- 选型结论:必须选择开源模型,进行私有化部署(数据存储在自身服务器,避免泄露)

2. 微调需求

- 适用场景:

- 模型需融入企业私有知识(如公司内部流程、行业专属数据)

- 需完成特殊定向任务(如生成公司专属格式的SQL语句、查询表格)

- 选型结论:只能选择开源模型(闭源模型不支持自定义微调)

- 注意:微调需满足“确实需要”(部分任务无需微调,通过提示词即可实现),后续课程会详细讲解微调条件

3. 场景约束需求

- 适用场景:

- 无法联网(如内网办公系统):闭源模型多依赖云端API,无法使用

- 极速响应(如实时客服、设备端应用):云端调用存在延迟,需本地私有化部署

- 选型结论:选择开源模型,本地部署满足实时性、离线需求

(二)常见选型误区(3个错误认知)

1. 误区1:开源模型更便宜

- 错误原因:开源模型部署需GPU算力服务器(常规服务器无法满足),硬件成本、维护成本极高(如部署671B参数的Deepseek模型,需多块高端显卡拼接,成本远超调用官方API)

- 正确认知:小参数开源模型(10B、20B)能力不足,大参数模型部署成本高昂,需计算“调用API成本”与“部署维护成本”的平衡点

2. 误区2:开源模型能力不如闭源模型

- 错误原因:国内主流强模型(如Deepseek、Kimi、千问)均为开源,其公开模型与厂商云端部署的模型能力一致(核心参数、训练数据公开)

- 正确认知:

- 国内开源模型 ≈ 国内闭源模型能力

- 海外顶级模型(GPT、Claude)未开源,需调用官方API

3. 误区3:技术不足无法部署开源模型

- 错误原因:大模型部署已完全标准化,如同安装电脑系统,阿里云、腾讯云、亚马逊云等服务商均提供现成部署包和技术支持

- 正确认知:部署成本足够时,服务商会提供专属技术团队协助,无需企业自身具备专业技术能力

三、总结与后续学习方向

(一)核心总结

- 评估模型先看“固定属性”(模态、参数规模、上下文长度),再看“任务适配指标”(语言模型看4大能力,图像模型看4大维度)

- 选型核心是“匹配需求”:隐私/微调/离线场景选开源,无特殊需求可优先考虑闭源模型(调用便捷、无需维护)

- 避免依赖厂商榜单,必须在自身实际任务中测试模型表现

课后练习

- 基础题:某产品需要“根据用户文字描述生成带中文Logo的宣传图,且多次生成的Logo样式一致”,请列出需要评估的图像模型指标。

- 应用题:某企业需要开发“内网使用的客户反馈分析系统”(需处理保密客户数据,自动分类反馈并生成报表),应选择开源还是闭源模型?说明理由。

- 计算题:估算14B参数模型(INT4量化)的实际显存需求(写出计算过程)。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)