QDKT2-2-大模型是如何推理生成答案的

经过多轮调整,最后一个Token(如“案”)的向量,已经编码了“下一个Token应该是什么”的信息——这是大模型预训练的核心目标:“看前面的文字,猜下一个字是什么”。Token 是大模型处理文字的“最小积木”—— 把完整的句子按统一规则“切碎”后,得到的一个个最小单位(可以是单个字、多个字组成的词,甚至是标点符号)。只有把文字变成数字(向量),大模型才能进行“比较”和“计算”——比如判断两个Tok

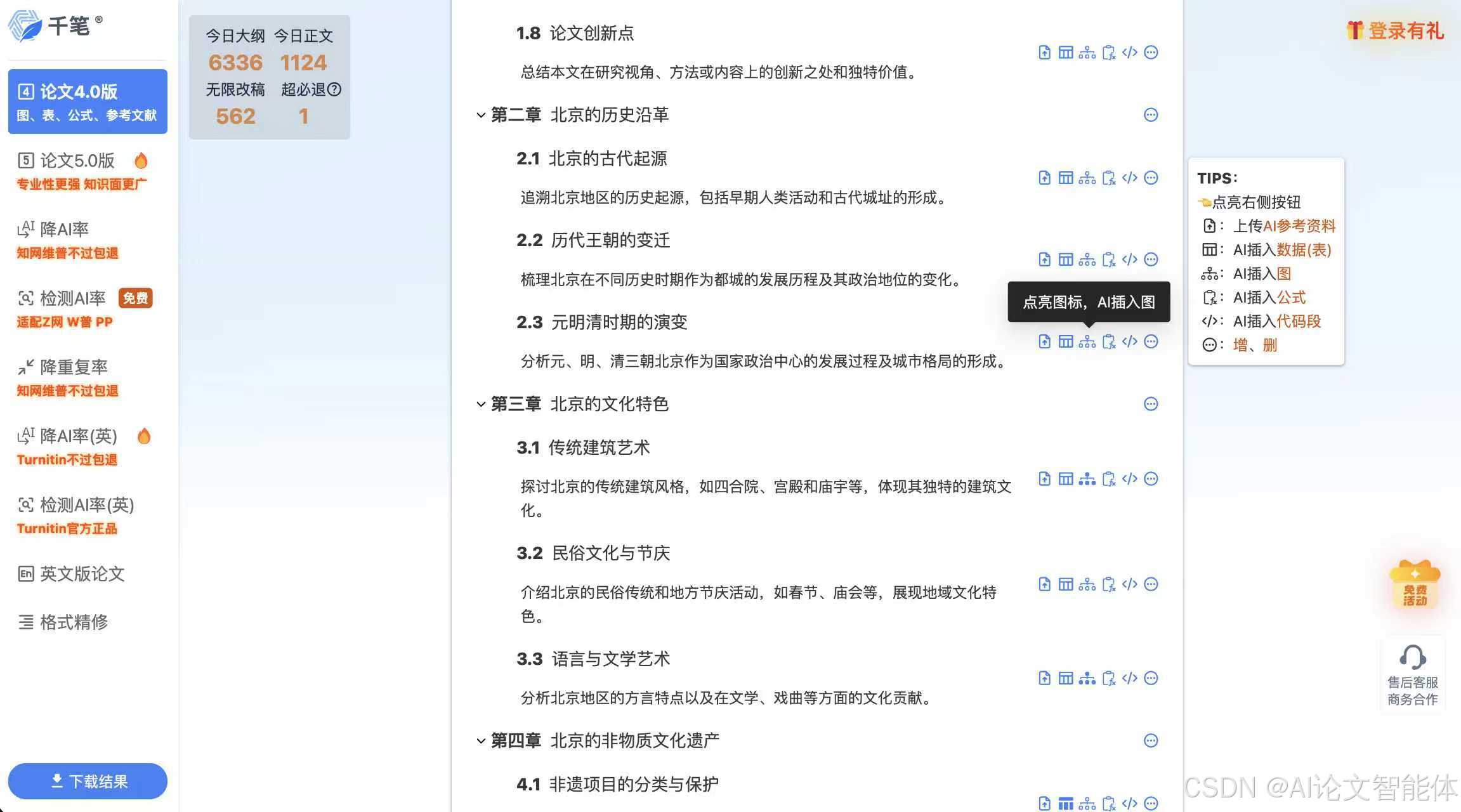

一、引言

1. 课程重要性

这是学习大模型最核心、最关键的一节课——只有看懂大模型“怎么干活”,才能真正用好它(比如写提示词、规避风险)。虽然是整套课程中最难的一节,但已做极致简化:剔除所有数学公式、编程代码,纯用通俗语言+类比+实例讲解。

二、基础认知:传统AI vs 生成式AI(大模型)

核心结论:两者的工作逻辑完全不同,学习大模型需彻底摒弃传统AI的思维定式。

|

对比维度 |

传统AI(判别式/规则式) |

生成式AI(大模型) |

|

核心逻辑 |

「匹配答案」—— 从知识库找相似问题的现成答案 |

「生成答案」—— 基于规律续写内容,无现成答案 |

|

依赖条件 |

必须有结构化、清洗干净的知识库 |

无知识库,只有预训练学到的“规律”(参数) |

|

输出特点 |

只能输出已有答案,死板无创新;未匹配到问题则无法回答 |

全新生成内容,可创新;无“答不出”的情况(除非触发限制) |

|

输出形式 |

直接返回完整答案 |

一个字一个字(Token)续写生成 |

实例对比

- 传统AI:问“团建活动方案怎么写?”,会在知识库中找“团建方案”相关的现成文档返回;若知识库没有,就回复“无法解答”。

- 大模型:问“团建活动方案怎么写?”,会先分析“团建活动方案”的规律,再顺着规律逐字续写,生成全新的方案内容。

三、核心基础:Token(大模型的“最小计算单元”)

1. 什么是Token?

Token 是大模型处理文字的“最小积木”—— 把完整的句子按统一规则“切碎”后,得到的一个个最小单位(可以是单个字、多个字组成的词,甚至是标点符号)。

2. Token的切分规则

- 切分依据:大模型内置的“词表”(相当于一本固定的字典),规定了哪些字/词要拆、哪些要合并;

- 核心要求:切分规则固定,不能随意更改(比如不能这次把“帮”单独切,下次把“帮我”切在一起);

- 实例:以“帮我策划一个团建活动方案”为例(按Deepseek/ChatGPT切分逻辑):

- 切分结果:帮(Token1)、我(Token2)、策(Token3)、划(Token4)、一(Token5)、个(Token6)、团(Token7)、建(Token8)、活(Token9)、动(Token10)、方(Token11)、案(Token12)

- 注意:不同大模型的词表不同,切分结果可能有差异(比如有的模型会把“团建”合并为1个Token)。

3. Token与汉字/单词的关系

- 不是“一对一”对应:1个Token可能是1个汉字(如“帮”),也可能是多个汉字(如部分模型的“团建”);

- 中文换算比例(关键!):1个中文字符≈0.6个Token;反过来,1个Token≈1.5-2个中文字符;

- 实用估算:100万Token≈150-200万个中文字符(按2倍估算更稳妥);

- 为什么要关注换算?:大模型的使用(如API调用)通常按Token计费,知道换算比例能估算成本和内容长度。

4. 不同大模型的词表差异

- 词表大小不同:比如Deepseek V3的词表有129280个Token(包含中英文、数字等);

- 切分逻辑不同:但对零基础学员来说,无需关注具体差异——核心是记住“Token是最小计算单元”即可。

四、文字的“数字化魔法”:向量嵌入(Embedding)

大模型是“数学大脑”,只能处理数字——向量嵌入就是把Token(文字)变成数字的过程。

1. 用类比理解:给“人”数字化

- 问题:小张、小王、小刘,谁更像小李?

- 解决思路:找2个衡量维度(智商、情商),给每个人打分(数据化);

- 具体数据:

- 小李:智商180,情商30

- 小张:智商30,情商180

- 小王:智商40,情商170

- 小刘:智商170,情商40

- 数字化结果:把4个人放到“智商(横轴)-情商(纵轴)”的坐标中,每个人都有唯一的“坐标位置”;

- 对比逻辑:坐标中两点距离越近(连线夹角越小),越相似——小刘和小李更像,小张和小王更像。

2. Token的数字化:向量嵌入

- 核心逻辑:给每个Token也找“衡量维度”,并打分,最终让每个Token都有唯一的“坐标位置”;

- 关键细节:

- 维度数量:不同大模型的维度不同(如Deepseek有7168个维度),这些维度是大模型“自己定义”的,人类无法理解(不是词性、使用频率等人类能感知的维度);

- 数字化结果:每个Token的7168个维度得分,会组成一个“向量”(相当于坐标),这个过程就是“嵌入”——把Token“镶”进数字空间;

- 参数的由来:所有Token的向量(7168个维度×12万+词表大小),构成了大模型的核心参数(几十亿、上千亿参数的本质就是这些数字)。

3. 为什么要做向量嵌入?

只有把文字变成数字(向量),大模型才能进行“比较”和“计算”——比如判断两个Token是否相关、距离有多远。

五、大模型的“思考”过程:注意力机制+并行计算

大模型生成内容的核心逻辑,和玩“狼人杀”完全一样!我们以“帮我策划一个团建活动方案”为例,拆解完整流程。

1. 准备阶段:Token化+向量嵌入

- 第一步:把输入句子“帮我策划一个团建活动方案”切分成12个Token(如前所述);

- 第二步:给每个Token做向量嵌入,让每个Token都有自己的“坐标位置”(7168个维度的数字)。

2. 核心环节:多轮“狼人杀游戏”(注意力机制)

每个Token相当于“狼人杀玩家”,整个过程分多轮进行(轮数=大模型的“层数”,如8层、16层),每一轮的规则如下:

(1)第一轮:天亮请睁眼

- 行动1:每个Token“看向前方”——只关注自己前面的所有Token(比如Token3“策”,能看到Token1“帮”和Token2“我”);

- 行动2:找“最相关的玩家”——通过计算向量距离,判断前面哪个Token和自己最相关(比如Token3“策”认为Token2“我”更相关);

- 行动3:调整自己的“状态”——根据最相关Token的向量,修改自己的部分维度得分(比如Token2“我”的某维度得分是7,调整为5),让自己和相关Token更“合拍”;

- 关键特点:并行计算——所有Token同时行动,不是排队进行(这就是大模型需要显卡的原因:CPU扛不住大量并行计算,显卡擅长此任务)。

(2)隐藏状态:中间缓存

- 每个Token调整后的得分,不会直接覆盖原始向量,而是存在“隐藏状态”(相当于缓存)——方便下一轮调整时参考。

(3)多轮迭代:重复“天亮-调整”

- 第二轮:所有Token基于上一轮的“隐藏状态”,再次看向前方、找相关Token、调整自己的得分;

- 后续轮次:重复上述操作,直到完成所有层数(如16层);

- 核心效果:每一轮调整后,后面的Token会逐渐“吸收”前面所有Token的信息——比如最后一个Token“案”,经过16轮调整后,其向量已经包含了“帮我策划一个团建活动方案”的所有诉求、逻辑和规律。

3. 关键结果:最后一个Token的“使命”

经过多轮调整,最后一个Token(如“案”)的向量,已经编码了“下一个Token应该是什么”的信息——这是大模型预训练的核心目标:“看前面的文字,猜下一个字是什么”。

六、Token的“续写游戏”:大模型如何生成下一个字?

当最后一个Token的向量确定后,大模型就开始生成下一个Token,流程如下:

1. 第一步:匹配词表

- 大模型拿着最后一个Token的向量,去内置词表中找“最相似的向量”(通过计算向量夹角大小判断);

- 理想情况:找到完全匹配的向量,直接输出对应的Token;

- 常见情况:没有完全匹配的向量,就从“Top3最相似”的Token中选一个。

2. 第二步:随机选择(大模型的“致命漏洞”)

- 大模型会从Top3相似Token中随机选一个输出(比如选了“书”“计划”“方案”中的“计划”);

- 蝴蝶效应:这个随机选择会直接影响后续所有生成——选“计划”和选“方案”,下一轮的调整逻辑完全不同,最终生成的内容可能天差地别。

3. 第三步:循环续写

- 新生成的Token(如“计划”)会加入到原始输入中,变成“帮我策划一个团建活动方案计划”;

- 大模型重新开始“Token化→向量嵌入→多轮调整→匹配词表→随机选择”的流程,生成下一个Token;

- 重复循环,直到大模型判断“没有下一个Token需要生成”(即所有词表中的Token都和最后一个向量不相似),生成过程结束。

实例:生成过程可视化

输入:帮我策划一个团建活动方案

- 第一轮生成:计划(随机从Top3中选择)

- 新输入:帮我策划一个团建活动方案计划

- 第二轮生成:主题(基于新输入的多轮调整后选择)

- 新输入:帮我策划一个团建活动方案计划主题

- 第三轮生成:户外拓展(继续循环)

- ... 直到生成完整方案

七、大模型的“小缺点”:固有漏洞与弊端

1. 漏洞1:输出全靠“运气”(随机选择)

- 核心问题:每一轮生成Token时的随机选择,导致同一问题可能生成完全不同的答案;

- 衍生问题:如果第一次选择的Token就“走偏”(比如输入“团建方案”,却选了“葬礼”相关Token),后续生成会一直偏,无法修正(起点决定全程)。

2. 漏洞2:极度消耗算力

- 原因1:并行计算需要高性能显卡(如英伟达GPU),CPU无法支撑;

- 原因2:生成越长的内容,需要循环的轮次越多(每轮都要处理所有Token),算力消耗呈线性增长;

- 表现:生成大段文字(如万言书)、复杂代码时,会出现卡顿、输出变慢。

3. 漏洞3:无法保证准确性

- 因为是“猜着生成”,不是“查知识库”,大模型可能生成看似合理但实际错误的内容(比如虚假数据、错误逻辑);

- 关键提醒:大模型的输出是“符合规律的续写”,不是“绝对正确的答案”。

八、总结

1. 核心知识点回顾

|

知识点 |

核心结论 |

|

传统AI vs 大模型 |

传统AI“找答案”,大模型“生答案” |

|

Token |

最小计算单元,1Token≈1.5-2个中文字符 |

|

向量嵌入 |

把文字变成数字(向量),方便计算 |

|

注意力机制 |

Token间“互相关注”,并行调整状态 |

|

生成逻辑 |

多轮调整→匹配词表→随机选择→循环续写 |

|

核心漏洞 |

随机选择、算力消耗、准确性无法保证 |

学习小贴士

- 遇到难懂的概念,多回想“狼人杀”“坐标打分”的类比;

- 不用死记硬背参数(如7168维度、12万词表),理解核心逻辑即可;

多尝试用大模型生成内容(如写短文、提问题),结合本节课知识观察它的“续写痕迹”(比如是否一个字一个字输出)。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)