AI Agent时代的产品管理:2026年必须掌握的六维知识模块与实战图谱

2026年,尽管AI技术成熟,企业级AIAgent项目失败率仍超60%,核心问题从技术瓶颈转向产品管理的系统性断层。传统PM的确定性思维与Agent的概率性黑盒特性冲突,需构建“动态耦合模型”,涵盖六维知识模块: 领域基础层:重构Agent认知框架(目标-约束-进化); 平台硬件层:算力成本与商业模型的平衡; AI核心技术层:理解记忆、规划与工具使用的工程边界; 应用场景层:从Copilot到自主

开篇:Agent时代的产品管理危机与机遇

站在2026年的时间节点回望,我们不得不承认一个残酷的现实:尽管大模型(LLM)的参数量早已突破万亿级,端侧算力(NPU)已成为PC标配,但企业级AI Agent项目的失败率依然高达60%以上。

为什么?在2023-2024年,我们以为瓶颈是“模型不够聪明”;到了2026年,我们发现真正的根因在于产品管理维度的系统性断层。

传统的软件产品经理(PM)习惯于确定性的逻辑:If A then B。但在Agent时代,PM面对的是概率性的黑盒。当一个产品经理试图用管理SaaS系统的思维去管理一个具备自主规划能力的Agent时,灾难不可避免。

本文将抛弃传统的“能力堆叠论”,提出**“动态耦合模型”。我们将解构决定Agent进化天花板的六维知识模块**,并提供一套可落地的实战图谱。这不仅是一份技能清单,更是你在这个智能涌现时代生存的底层操作系统。

一、六维知识模块体系架构:从碎片化到系统化

在Agent时代,产品经理的知识体系不再是平面的,而是立体的。我们将以微软(Microsoft)的Copilot Stack为贯穿案例,深度解析这六层架构。

1.1 领域基础层:Agent认知框架重构

在Web 2.0时代,PM的核心产出是PRD(需求文档),核心动作是定义功能。在Agent时代,PM的核心产出是System Prompt(系统提示词/元指令)与Reward Model(奖励模型)设计。

核心要素:目标-约束-进化三位一体

Agent不是被“设计”出来的,而是被“引导”出来的。你需要定义:

- 目标(Goal):Agent的终极意图是什么?(例如:帮助用户写代码 vs 帮助用户解决Bug,意图不同,路径迥异)。

- 约束(Constraint):Agent不能做什么?(例如:不能在未授权情况下修改生产环境数据库)。

- 进化(Evolution):Agent如何通过反馈自我优化?

真实案例:Microsoft 365 Copilot的意图理解

微软在设计Excel Copilot时,并没有穷举所有Excel公式的功能。相反,他们构建了一个“意图理解层”。当用户输入“分析这季度销售下滑的原因”时,PM定义的不是“调用筛选功能”,而是定义了一个认知框架:

- 识别意图:数据分析任务。

- 拆解步骤:检查异常值 -> 对比历史数据 -> 生成透视表。

- 约束条件:只能读取当前Sheet数据,不得联网搜索无关信息。

关键能力:PM必须具备从“功能清单(Feature List)”向“意图理解(Intent Understanding)”转化的需求翻译能力,以及对不确定性输出的量化评估方法。

1.2 平台硬件层:算力 Orchestration 决策

到了2026年,算力不再仅仅是运维关心的问题,而是直接决定产品商业模式(Unit Economics)的核心变量。

核心要素:端云协同的成本博弈

- 云端(Cloud):处理高复杂度推理(如GPT-5级别),成本高,延迟高。

- 端侧(Edge/NPU):处理隐私敏感、低延时任务(如SLM小模型),零边际成本。

真实案例:Windows Studio Effects

微软在Surface设备上推出的Studio Effects(背景虚化、眼神接触),并没有调用云端API,而是完全运行在本地NPU上。作为PM,如果不了解NPU的算力预算(TOPS),就无法设计出流畅的实时视频体验。如果强行上云,巨大的带宽成本和延迟将直接摧毁产品体验。

关键能力:硬件选型对商业模型的反向塑造能力。PM需要能计算“Token经济学”——每完成一个用户任务,消耗的算力成本(COGS)是否低于用户付费意愿。

1.3 AI核心技术层:工程化边界认知

这是PM与算法工程师对话的通用语言。你不需要会写CUDA代码,但必须懂原理。

核心要素:记忆、规划与工具使用

- LLM边界:理解上下文窗口(Context Window)的限制。2026年虽然窗口很大,但“大海捞针(Needle In A Haystack)”问题依然存在。

- 规划算法:理解ReAct(Reasoning + Acting)或CoT(Chain of Thought)是如何工作的。

- 记忆机制:区分短期记忆(Prompt内)和长期记忆(向量数据库/知识图谱)。

代码级理解:一个最小化的Agent实现

为了说明PM需要理解的逻辑深度,我们来看一段简化的Python代码,展示Agent是如何思考的:

# 这是一个简化的Agent思维链模拟,PM需要理解这个Loop

class SimpleAgent:

def __init__(self, tools, llm):

self.tools = tools

self.llm = llm

self.memory = []

def think(self, user_query):

# 1. 规划:基于历史记忆和当前问题,决定下一步做什么

prompt = f"History: {self.memory}\nQuestion: {user_query}\nAvailable Tools: {self.tools}"

plan = self.llm.generate(prompt)

return plan

def act(self, plan):

# 2. 执行:解析规划,调用工具

if "CALL_TOOL" in plan:

tool_name, args = parse_tool_call(plan)

result = self.tools[tool_name].run(args)

return result

return None

def run(self, user_query):

# 3. 循环:观察结果,修正规划

for i in range(5): # 防止死循环

plan = self.think(user_query)

print(f"Thought: {plan}")

if "FINAL_ANSWER" in plan:

return extract_answer(plan)

observation = self.act(plan)

self.memory.append((plan, observation)) # 写入记忆关键能力:PM需要具备技术可行性与场景期望的校准能力。比如,不要指望LLM能像计算器一样做精准的浮点数运算,而是应该设计机制让Agent去调用“计算器工具”。

1.4 应用场景层:价值分层与渗透路径

核心要素:从Copilot到Agent的价值跃迁

- L1 Copilot(辅助):人主导,AI建议。例如:GitHub Copilot的代码补全。

- L2 Autopilot(自动):人设定目标,AI执行流程,人审核结果。例如:GitHub Copilot Workspace自动修复Issue。

- L3 Agent(自主):AI自主感知环境、设定子目标并执行。

场景复杂度的熵值评估模型

PM需要评估场景的“熵”(混乱程度)。

- 低熵场景(如报销流程):适合传统RPA或规则引擎。

- 高熵场景(如创意写作、复杂Debug):适合AI Agent。

关键能力:识别“用户采纳曲线”的干预节点。在2026年,用户不再为“聊天”付费,只为“解决问题(Job to be Done)”付费。

1.5 行业知识层:深度语义理解护城河

通用大模型在2026年已经商品化(Commoditized),真正的护城河在于Vertical AI(垂直领域AI)。

核心要素:隐性知识(Tacit Knowledge)的显性化

行业里很多规则是“只可意会不可言传”的。PM的任务是把这些规则提取出来,变成Prompt或Fine-tuning数据。

真实案例:Nuance DAX Copilot (微软医疗云)

在医疗场景,医生写病历有极强的潜规则。比如“患者自述”和“临床观察”必须严格区分。通用的GPT-4写出的病历虽然通顺,但可能不合规。微软通过收购Nuance,将数十年的医疗语音数据和行业Know-how蒸馏进模型,使得DAX Copilot能自动生成符合ICD-10标准的医疗文档。

关键能力:业务专家与算法团队的语义对齐能力。PM是那个“翻译官”,将医生的“职业直觉”翻译成工程师能理解的“逻辑约束”。

1.6 伦理法律层:可解释性嵌入框架

在2026年,AI合规不是“锦上添花”,而是“准入执照”。

核心要素:AI治理的数字孪生

- 偏见检测:在产品发布前,必须进行Red Teaming(红队测试),检测是否存在性别、种族歧视。

- 数据隐私:企业级Agent必须确保“数据不出域”。

真实案例:Microsoft Responsible AI Standard

微软推行了严格的RAI标准。任何Agent产品上线前,必须通过“影响评估(Impact Assessment)”。例如,Bing Chat在早期会拒绝回答某些诱导性问题,这就是伦理层在起作用。PM需要设计“拒绝的话术”和“熔断机制”。

关键能力:将价值对齐(Alignment)产品化。PM需要能量化伦理风险的商业影响——一次严重的AI幻觉导致的公关危机,可能抵消一年的营收。

二、模块协同:四大断裂点与修复机制

拥有六维知识还不够,真正的挑战在于它们之间的连接。我们用四象限分析法来诊断常见的项目断裂点。

2.1 断裂点诊断矩阵

|

断裂类型 |

现象描述 |

典型案例 |

|

技术-场景断层 |

技术成熟度滞后于场景期望(高频陷阱) |

试图用2024年的LLM去全自动处理复杂的法律诉讼,导致大量事实性错误。 |

|

硬件-应用断层 |

算力成本吞噬商业价值(ROI失衡) |

开发了一个极其精准的Agent,但每次调用成本$5,而用户只愿付$1。 |

|

行业-技术断层 |

行业规则与算法泛化性冲突 |

金融风控Agent因为过度拟合通用逻辑,漏掉了特定行业的欺诈模式。 |

|

价值-约束断层 |

效率追求与伦理风险矛盾 |

客服Agent为了提高解决率,承诺了公司无法兑现的退款政策。 |

2.2 动态耦合机制:MECE原则应用

为了修复这些断裂,PM需要建立动态耦合机制。

机制一:需求定义的三角校验法

在PRD阶段,每一个功能点必须经过三方校验:

- 业务目标:用户想要什么?

- 技术约束:当前模型能做到什么程度?(准确率是80%还是99%?)

- 伦理边界:合规红线在哪里?

机制二:架构设计的双循环迭代

- 内循环(模型优化):Prompt工程 -> 评估 -> 微调。周期:天。

- 外循环(价值验证):用户反馈 -> 场景调整 -> 商业模式修正。周期:周。

三、实战图谱:三维优先级排序矩阵

不同阶段、不同行业的PM,对六维知识的权重分配是完全不同的。

3.1 矩阵构建逻辑

- X轴:职业阶段(初级PM -> 高级PM -> 产品负责人)

- Y轴:行业属性(容错率高 vs 容错率低)

- Z轴:Agent类型(Copilot辅助型 vs Agent自主型)

3.2 细分象限技能权重配比(实战示例)

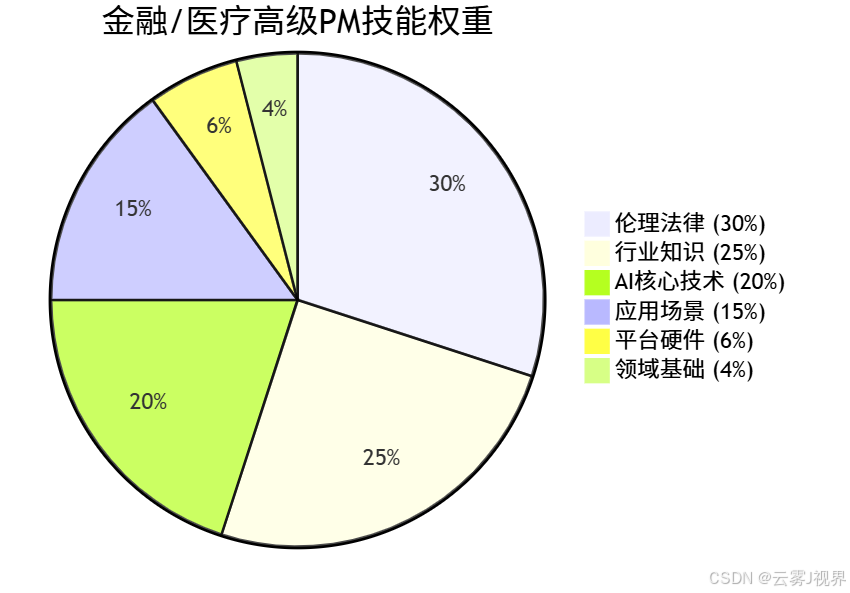

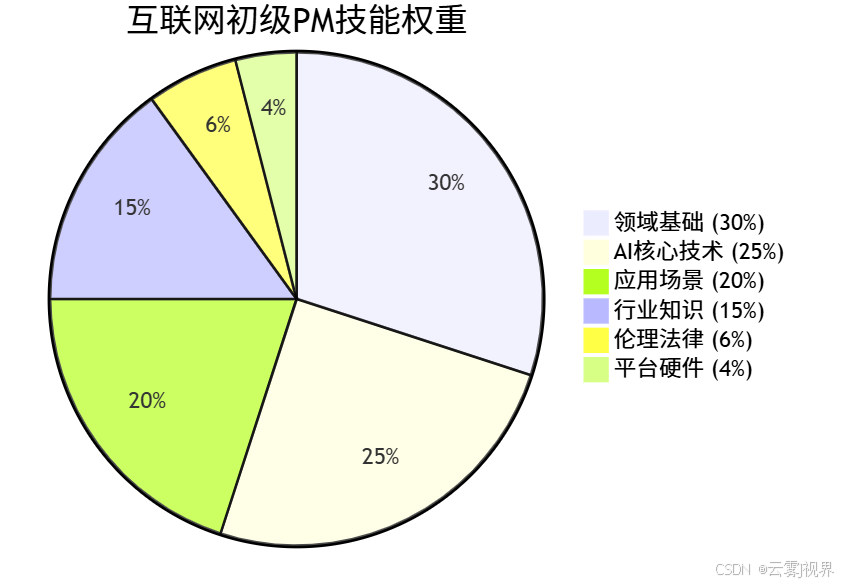

我们通过一个Mermaid饼图来直观展示两种极端场景下的技能权重差异。

场景A:金融/医疗领域 - 决策支持Agent - 高级PM

特点:高风险、高监管、高专业度。

场景B:互联网/文娱领域 - 个人助理Agent - 初级PM

特点:重体验、重增长、容错率相对较高。

深度解析:

- 在金融领域,你如果不懂《巴塞尔协议》或数据合规,技术再牛也是零。你的核心竞争力是“把合规数字化”。

- 在互联网领域,你的核心竞争力是“Prompt Engineering”和“用户体验设计”,你需要让Agent看起来更像人,更懂用户。

四、30天落地路径:从知识地图到工作交付

为了避免“知识焦虑”,我们制定了一个30天的行动计划,直接指向工作交付。

Week 1:诊断与定位(SMART目标)

- Day 1-2:对照上文的六维模型,给自己打分(0-5分)。

- Day 3-4:断裂点识别。复盘你手头正在做的或过去失败的一个项目,找出它是死在哪个断层上?(是算力太贵?还是不懂行业?)

- Day 5-7:搭建知识库。建议使用Notion或Obsidian,建立“Prompt库”、“Case库”和“论文库”。

Week 2:最小可行知识体系(MVP)

- Day 8-10:技术祛魅。不要只看文章,去跑通一个开源Demo。

- 行动:下载一个本地模型(如Ollama),尝试用Python写一个简单的ReAct Loop(参考上文代码)。这一步能让你对“延迟”和“幻觉”有切肤之痛。

- Day 11-14:跨模块演练。尝试用“伦理层”去攻击你的“技术层”。

- 行动:设计一组恶意的Prompt(红队测试),看看你的Agent是否会崩溃或输出有害信息。

Week 3:Agent产品微创新实验

- Day 15-17:设计一个Micro-Agent。不要做大平台,做一个小工具。

- 示例:一个自动读取Git提交记录并生成周报的Agent。

- Day 18-21:技术对齐会。拿着你的PRD去找开发,但不要只讲功能,要讲“意图”和“约束”。

- 话术模板:“我希望这个Agent在遇到不确定的Git Log时,不要瞎编,而是反问用户,或者直接跳过。我们可以通过设置Temperature参数或增加校验步骤来实现吗?”

Week 4:价值验证与进化

- Day 22-24:埋点设计。

- 传统指标:DAU、留存。

- Agent指标:任务完成率(Success Rate)、人工接管率(Human Intervention Rate)、对话轮数(Turns per Task)。

- Day 28-30:复盘与SOP。输出一份《Agent能力边界白皮书》给团队,确立你在团队中的专家地位。

五、结尾:构建反脆弱的知识体系

2026年的产品经理,正处于一个分水岭。

左边是旧世界的“功能经理”,他们还在纠结按钮的颜色、页面的跳转,最终将被能够自动生成UI的Agent所取代。

右边是新世界的“智能编排者”,他们掌握了六维知识图谱,懂得如何定义目标、约束算力、驾驭模型、深耕行业、坚守伦理。

核心洞察:

- 六维知识不是孤岛:它们是动态耦合的价值网络。技术决定下限,行业决定上限,伦理决定生死。

- 断裂点即机会点:60%的项目失败,意味着如果你能修复“技术-场景”断层,你就是那稀缺的40%。

- 微创新是唯一路径:不要试图一口气造出贾维斯(Jarvis)。从一个能完美写周报的Agent开始,建立你的信任链。

本周五之前,请做一件事:打开你负责的产品的对话框,问它一个带有陷阱的业务问题。如果它的回答让你失望,请不要责怪模型,那是你的“领域基础层”和“行业知识层”还没有完成对齐。

现在,就开始你的六维进化之旅吧。

更多推荐

已为社区贡献139条内容

已为社区贡献139条内容

所有评论(0)