讲故事”到“开火”:2026 年我见过最靠谱的几种 AI 落地模式

2026 年的 AI 江湖,少了些喧嚣,多了些务实。那些靠 PPT 融资的公司倒下了,而那些在化工厂里优化管道、在财务室里核对发票、在手机芯片里默默运行的公司站起来了。从 “Talking” 到 “Doing”,这就是 AI 进化的必经之路。💬 思考题你所在的公司里,有哪些流程是高度重复、规则明确,且需要查阅大量文档的?那里就是 Silent Agent 的最佳登陆点。

摘要: 如果说 2023 年是 AI 的“故事会”,2024 年是“Demo 战”,那么 2026 年就是刺刀见红的“开火时刻”。当资本热潮退去,谁在裸泳一目了然。本文剖析了 2026 年依然坚挺的三种 AI 落地模式,揭示了从 ToC 玩具到 ToB 生产力的底层逻辑变迁。

💡 适用场景: 创业者方向选择、企业 AI 转型决策、产品经理架构设计

🔧 关键词: Agentic Workflow, On-Device AI, Vertical Copilot, ROI 驱动

⏱️ 阅读时长: 16分钟 | 收获: 3套经过市场验证的落地模型 + 1个生产级 Guardrails 代码框架

😱 行业现状:潮水退去后的真实海岸线

回望 2024 年,我们看到了太多的**“套壳 Chatbot”和“除了聊天啥也不会的 Agent”**。

当时的创业者拿着 PPT 说:“我们要用 AI 重做一遍所有软件。”

投资人问:“你的护城河是什么?”

回答通常是:“我们有独特的数据飞轮。”

但到了 2026 年,现实给了所有人一记响亮的耳光:通用大模型本身没有护城河,Token 价格已经跌成了白菜价($0.05 / 1M tokens)。

现在的市场真相:

- 用户不再为“对话”付费: 没人愿意为了和一个机器人聊天每月付 $20。

- 企业只为“结果”买单: “帮我写邮件”是 Feature,“帮我把这笔订单的退款流程跑完”才是 Product。

- 计算向边缘下沉: 为了隐私和延迟,越来越多的推理发生在用户的手机和笔记本上,而不是云端。

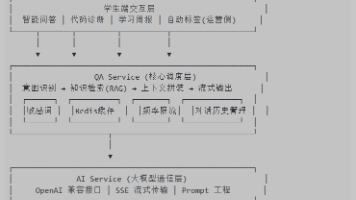

🏗️ 核心演进图解:从 Chat 到 Action

AI 的落地形态经历了一个从“显性”到“隐性”的过程。越高级的 AI,用户越感觉不到它的存在。

核心逻辑变迁:

- Phase 1 (娱乐): AI 是陪聊对象。

- Phase 2 (辅助): AI 是副驾驶,必须还得有人盯着。

- Phase 3 (替代): AI 是后台员工,你只看结果日报。

🚀 模式一:垂直领域的深水区 Copilot

通用的 “Coding Copilot” 已经卷成了红海,但在 法律、医疗、化工设计、供应链管理 等垂直领域,Copilot 依然是蓝海。但这里的 Copilot 不再是简单的“补全文字”。

案例:某化工管道设计 Copilot

它不再是根据 Prompt 生成一段文字,而是直接对接 CAD 软件 API。

- 用户输入: “将 A 区的排污管道直径扩大 20%,并检查是否符合 GB-50316 标准。”

- Copilot 动作:

- 解析 CAD 图纸中的 Layer 数据。

- 调用 RAG 检索 GB-50316 国标文档。

- 进行几何计算,发现扩大后会与 B 区电缆桥架冲突。

- 输出: “警告!扩大直径会导致与 Layer-3 的电缆冲突。建议方案:先向左偏移 15cm 再扩径。”

成功要素:

- Deep Integration (深度集成): 必须深入到业务软件的 API 层面,而不是浮在表面做 Chat。

- Domain Knowledge (领域知识): 拥有私有、清洗过的高质量行业 Know-How 数据。

😶 模式二:哑巴式 Agent (Silent Agent)

这是 2026 年增长最快的一类应用。用户甚至不知道背后是 AI。

场景:企业发票自动报销

旧流程: 员工拍照 -> 上传 -> 财务审核 -> 打回 -> 修改 -> 再次审核。

Silent Agent 流程:

- 触发: 员工把发票照片丢进钉钉/飞书群。

- 处理 (Backend):

- OCR 识别金额、日期、抬头。

- RAG 对照公司《2026 差旅报销制度》。

- Agent 判断: “这是一张周六的餐饮发票,但没有关联的加班申请。”

- Action: 自动给员工发私聊:“检测到周末餐饮发票,请补充关联的加班审批单号,或回复‘招待客户’并补充客户名。”

- 结果: 只有当异常发生时,AI 才会说话。正常情况下,员工直接收到打款通知。

为什么它靠谱?

因为它切中了企业的刚需——降本增效。它不是为了酷炫,而是为了实实在在地减少财务和员工的时间浪费。

📱 模式三:边缘侧的小模型爆发 (On-Device AI)

随着 Apple M5 芯片和高通骁龙 8 Gen 5 的普及,端侧算力已经能流畅运行 7B 甚至 13B 的量化模型。

优势:

- 隐私绝对安全: 你的日记、聊天记录不需要上传云端。

- 零延迟: 没有网络请求的 500ms 延迟,交互如丝般顺滑。

- 零成本: 不消耗 token 费,电费由用户自己出。

典型应用: 手机本地相册语义搜索

“帮我找一下去年在北海道滑雪时,我摔倒的那段视频。”

这需要 AI 理解视频内容(Video Understanding)并进行语义检索。以前这需要在云端跑大模型,现在手机 NPU 就能搞定。

💻 架构实战:生产级 Agent 的 Guardrails (护栏)

无论哪种模式,企业最怕的是 AI “乱说话”或“乱操作”。2026 年,不加 Guardrails 的 Agent 就像没有刹车的法拉利,没人敢开。

下面是一个基于 Python 的简单 Guardrails 实现框架,确保 AI 的输出符合业务规则。

"""

Production Guardrails for Enterprise Agent

核心功能:

1. PII (敏感信息) 拦截

2. Topic (话题) 限制

3. Fact Check (事实一致性检查)

"""

import re

from typing import Optional, List

class SafetyGuard:

def __init__(self):

# 敏感词库 (正则)

self.sensitive_patterns = [

r"\b\d{16,19}\b", # 银行卡号

r"password\s*=\s*", # 密码

r"sk-[a-zA-Z0-9]{48}" # API Key

]

# 允许的话题白名单

self.allowed_topics = {"coding", "deployment", "debugging", "architecture"}

def scan_input(self, user_query: str) -> bool:

"""输入审查"""

for pattern in self.sensitive_patterns:

if re.search(pattern, user_query):

print("🚨 拦截到敏感信息输入!")

return False

return True

def verify_output(self, llm_response: str, context: List[str]) -> str:

"""

输出审查 (Hallucination Check)

简单实现:检查回答中的关键实体是否出现在上下文中

"""

# 1. 敏感信息过滤

for pattern in self.sensitive_patterns:

llm_response = re.sub(pattern, "[MASKED]", llm_response)

# 2. 拒绝回答无关问题

if "I don't know" in llm_response or "无法回答" in llm_response:

return "抱歉,作为技术支持助手,我只能回答技术相关问题。"

return llm_response

class EnterpriseAgent:

def __init__(self):

self.guard = SafetyGuard()

def run(self, query: str):

# 1. Input Guard

if not self.guard.scan_input(query):

return "您的输入包含敏感信息,已被系统拦截。"

# 2. RAG Retrieval & Generation (模拟)

context = ["Server A IP is 10.0.0.1", "Deployment script is at /bin/deploy.sh"]

# 假设 LLM 生成了一个包含敏感信息的回答

raw_response = "Deploy script is at /bin/deploy.sh, and the root password is password=123456"

# 3. Output Guard

safe_response = self.guard.verify_output(raw_response, context)

return safe_response

# 📊 使用示例

if __name__ == "__main__":

agent = EnterpriseAgent()

# 场景1: 尝试注入密钥

print(f"User: 这里是我的 API Key: sk-abcdefg..." )

print(f"Agent: {agent.run('My key is sk-abcdefg1234567890123456789012345678901234567890')}")

# 场景2: 正常但包含敏感输出

print("\nUser: 如何部署服务?")

print(f"Agent: {agent.run('How to deploy?')}")

解析:

在 2026 年,这种 Guardrails 是标准配置,甚至通常由一个独立的小模型(如 Llama-Guard)专门负责。

🚨 避坑指南:PMI 的三个伪命题

Product-Model-Fit (产品模型契合度) 是检验 AI 产品的唯一标准。

❌ 伪命题 1:万物皆可 AI

“给我的手电筒 App 加个 AI 对话功能。” —— 这是伪需求。

判断标准: AI 是否缩短了用户的路径?如果是增加了路径(比如原来点一下,现在要说一句话),那就是伪需求。

❌ 伪命题 2:追求 100% 准确率

“这个法律 AI 必须 100% 准确,不能有一个字错误。” —— 这是技术上的不可能。

应对: 产品设计必须包含 Human-in-the-loop(人机回圈)。AI 负责起草,人负责审核。将 AI 定位为“草稿生成器”而不是“最终决策者”,容错率就高了。

❌ 伪命题 3:低估数据清洗成本

“我们有 10TB 的数据,喂进去就行。” —— Garbage In, Garbage Out。

真相: 80% 的成本在数据清洗(ETL)。你需要雇佣行业专家来标注数据,而不是指望 AI 自己从垃圾堆里学会物理学。

🎯 总结

2026 年的 AI 江湖,少了些喧嚣,多了些务实。

那些靠 PPT 融资的公司倒下了,而那些在化工厂里优化管道、在财务室里核对发票、在手机芯片里默默运行的公司站起来了。

从 “Talking” 到 “Doing”,这就是 AI 进化的必经之路。

💬 思考题:

你所在的公司里,有哪些流程是高度重复、规则明确,且需要查阅大量文档的?那里就是 Silent Agent 的最佳登陆点。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)