我把团队一年的 Coding 过程全量喂给大模型,结果 AI 比新人还懂我们项目

把代码库喂给大模型,本质上是将隐性知识显性化。它不会取代资深架构师的判断力,但它能把一个刚入职的新人,瞬间武装成一个对代码库了如指掌的“伪资深”员工。💬 思考题在这个系统里,如果引入了 git commit log(提交记录)和 PR comment(代码评审记录)作为额外上下文,会对 Bug 排查有多大提升?🎯 动手实践Clone 上面的 Python 脚本,找一个你自己最复杂的开源项目(比

摘要: 面对几十万行的遗留代码山我们需要3个月的时间去熟悉,本文记录了我们将整个 Git 仓库全量投喂给 RAG 系统后,AI 如何在 10 分钟内完成全库理解,并在 Code Review 中吊打 3 年经验工程师的实战全过程。包含完整 Python + LangChain 实现代码。

💡 适用场景: 遗留系统重构、新员工极速 Onboarding、自动化 Code Review

🔧 技术栈: Python 3.10 + LangChain + ChromaDB + DeepSeek/GPT-4 + AST Parser

⏱️ 阅读时长: 15分钟 | 收获: 1套企业级代码知识库搭建方案 + 3个提升检索准确率的独家技巧

😱 业务痛点:你是否遇到过这些问题?

- ❌ “祖传代码”无人敢动: 核心模块的最初开发者早已离职,文档停留在 3 年前,每次修改都像在拆弹。

- ❌ 新人上手极其缓慢: 一个简单的 Bug 修复,新人需要花 2 天时间理清调用链,Tech Lead 还要花 4 小时 Code Review。

- ❌ 知识孤岛效应: 只有某个人懂某个模块,一旦他请假,整个项目组进度受阻(Bus Factor = 1)。

- ❌ 低级错误重复出现: 团队明明约定了 “Service 层不能直接调 DAO”,但在 50 个微服务的掩护下,这种代码依然在悄悄滋生。

真实案例:

上个月,我们接手了一个 5 年历史的电商中台项目。代码量超过 30 万行,文档缺失严重。为了修复一个“库存扣减不一致”的 Bug,我们三位资深后端工程师排查了整整 3 天,最后发现是分散在不同文件中的 3 处逻辑不一致导致的。

痛定思痛,我们决定把整个 git 仓库“喂”给大模型,让它成为我们的 24 小时在线架构师。结果令人震惊:它不仅在 5 秒内指出了那个库存 Bug 的根因,还顺带指出了 12 个类似的潜在风险点——这些是我们人工 Review 根本没发现的。

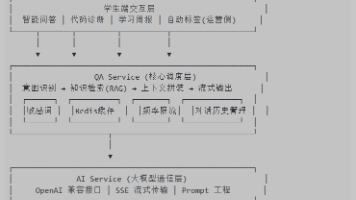

🏗️ 核心原理图解 (Visualization)

要实现“全库代码理解”,简单的 Ctrl+C Ctrl+V 是行不通的(Context Window 限制)。我们需要构建一个基于 RAG (Retrieval-Augmented Generation) 的代码知识库系统。

1. 系统架构设计

这个系统并非简单的文件读取,它包含了一个针对代码优化的 ETL 流程。

2. 核心流程:为什么代码 RAG 比文档 RAG 更难?

代码具有极强的结构依赖性(Dependency)。一个类调用了另一个类,在文本上它们可能相隔甚远。如果我们像切小说一样切代码,就会丢失上下文。

常规 vs 语义化切分对比:

为什么这样设计?

- 完整性: 必须保证检索回来的代码块是一个完整的函数或类,否则 LLM 无法理解逻辑。

- 关联性: 代码中充斥着

import和引用,我们必须在 Embedding 之前解析这些关系,甚至构建 “Code Graph”。

💻 实战代码 (Hands-On Code)

下面是核心 Python 实现方案。我们将使用 LangChain 和 ChromaDB 来搭建这个本地代码问答助手。

环境准备

pip install langchain langchain-openai chromadb gitpython tree-sitter

核心模块一:智能代码加载器

我们不能把 .git 目录、图片、编译产物(.class, .pyc)喂给大模型,那纯属浪费 Token 且引入噪声。

code_ingest.py

"""

智能代码库加载模块

核心特性:

1. 智能过滤: 自动排除二进制文件、锁文件、隐藏文件

2. 语言识别: 自动识别文件语言类型

3. 尊重 .gitignore: 读取与解析 .gitignore 规则

"""

import os

import pathspec

from typing import List, Generator

from langchain_community.document_loaders import TextLoader

from langchain_core.documents import Document

class CodeRepositoryLoader:

"""

加载整个 Git 仓库的代码文件,支持 .gitignore 过滤

时间复杂度: O(N) - N 为文件总数

"""

def __init__(self, repo_path: str, encoding: str = 'utf-8'):

self.repo_path = repo_path

self.encoding = encoding

self.gitignore_spec = self._load_gitignore()

# ⚠️ 配置:除了 .gitignore 外,强制忽略的目录

self.ignore_dirs = {'.git', '__pycache__', 'node_modules', 'dist', 'build', '.idea', '.vscode'}

# ⚠️ 配置:只保留的代码扩展名(按需调整)

self.allowed_extensions = {'.py', '.java', '.js', '.ts', '.go', '.cpp', '.md', '.sql'}

def _load_gitignore(self):

gitignore_path = os.path.join(self.repo_path, ".gitignore")

if os.path.exists(gitignore_path):

with open(gitignore_path, "r") as f:

return pathspec.PathSpec.from_lines("gitwildmatch", f)

return pathspec.PathSpec.from_lines("gitwildmatch", [])

def load(self) -> List[Document]:

"""

扫描目录并加载所有有效代码文件

"""

documents = []

for root, dirs, files in os.walk(self.repo_path):

# 1. 过滤目录(原地修改 dirs 列表以剪枝)

dirs[:] = [d for d in dirs if d not in self.ignore_dirs and not d.startswith('.')]

for file in files:

file_path = os.path.join(root, file)

rel_path = os.path.relpath(file_path, self.repo_path)

# 2. 检查 .gitignore

if self.gitignore_spec.match_file(rel_path):

continue

# 3. 检查扩展名

_, ext = os.path.splitext(file)

if ext not in self.allowed_extensions:

continue

# 4. 加载文件内容

try:

loader = TextLoader(file_path, encoding=self.encoding)

docs = loader.load()

# 💡 关键:在 Metadata 中注入文件路径,这对后续检索至关重要

for doc in docs:

doc.metadata["source"] = rel_path

doc.metadata["language"] = ext[1:] # e.g., 'py'

documents.extend(docs)

except Exception as e:

print(f"⚠️ Failed to load {rel_path}: {e}")

print(f"✅ Loaded {len(documents)} source code files.")

return documents

# 📊 使用示例

if __name__ == "__main__":

loader = CodeRepositoryLoader("/path/to/your/project")

docs = loader.load()

print(f"First doc: {docs[0].metadata['source']}")

核心模块二:基于 AST 的代码切分

这是区分“玩具 Demo”和“生产级工具”的关键。如果你只是按 1000 字符切分,切断了一个大函数的中间,LLM 根本看不懂。我们要用 CodeSplitter。

code_splitter.py

"""

语义化代码切分模块

"""

from langchain.text_splitter import RecursiveCharacterTextSplitter, Language

class SemanticCodeSplitter:

"""

根据编程语言特性进行语义切分

"""

@staticmethod

def split_documents(documents: List[Document]) -> List[Document]:

"""

按语言分别处理文档

"""

lang_map = {

'py': Language.PYTHON,

'js': Language.JS,

'java': Language.JAVA,

'go': Language.GO,

'cpp': Language.CPP

}

split_docs = []

# 按语言分组处理

from collections import defaultdict

docs_by_lang = defaultdict(list)

for doc in documents:

docs_by_lang[doc.metadata.get("language")].append(doc)

for ext, docs in docs_by_lang.items():

language = lang_map.get(ext)

if language:

# 💡 优化点:代码切分需要更大的 overlap,因为上下文依赖强

splitter = RecursiveCharacterTextSplitter.from_language(

language=language,

chunk_size=2000,

chunk_overlap=200

)

else:

# 对于 Markdown 或其他文本

splitter = RecursiveCharacterTextSplitter(

chunk_size=3000,

chunk_overlap=200

)

split_docs.extend(splitter.split_documents(docs))

print(f"✂️ Split into {len(split_docs)} chunks.")

return split_docs

核心模块三:构建 RAG 引擎与问答

这里我们集成 ChromaDB 和 OpenAI (或其他 LLM)。

code_brain.py

"""

RAG 引擎核心

"""

import os

from langchain_openai import OpenAIEmbeddings, ChatOpenAI

from langchain_community.vectorstores import Chroma

from langchain.chains import RetrievalQA

# ⚠️ 必须设置 API Key

os.environ["OPENAI_API_KEY"] = "sk-..."

class CodeBrain:

def __init__(self, persist_dir="./chroma_db"):

self.embedding = OpenAIEmbeddings(model="text-embedding-3-small")

self.persist_dir = persist_dir

self.db = None

def build_knowledge_base(self, documents):

"""

构建向量数据库

"""

print("🧠 Building Vector Database... This may take a while.")

self.db = Chroma.from_documents(

documents=documents,

embedding=self.embedding,

persist_directory=self.persist_dir

)

print("✅ Database persisted.")

def load_knowledge_base(self):

"""

加载已有数据库

"""

self.db = Chroma(

persist_directory=self.persist_dir,

embedding=self.embedding

)

def ask(self, query):

"""

向代码库提问

"""

if not self.db:

raise ValueError("Knowledge base not loaded!")

# 💡 MMR (Maximum Marginal Relevance) 检索策略

# 这比普通的 Cosine Similarity 更好,因为它能保证返回的多样性

# 避免返回 5 个极其相似但无用的 import 语句

retriever = self.db.as_retriever(

search_type="mmr",

search_kwargs={"k": 8, "fetch_k": 20}

)

llm = ChatOpenAI(model_name="gpt-4-turbo", temperature=0)

qa = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=retriever,

return_source_documents=True

)

result = qa.invoke({"query": query})

print(f"\n❓ Question: {query}")

print(f"💡 Answer: {result['result']}")

print("\n📚 Sources:")

for doc in result['source_documents'][:3]:

print(f"- {doc.metadata['source']} (Content preview: {doc.page_content[:50]}...)")

# 📊 完整运行逻辑

if __name__ == "__main__":

# 1. 加载

loader = CodeRepositoryLoader("/Users/yourname/projects/legacy-system")

raw_docs = loader.load()

# 2. 切分

splitter = SemanticCodeSplitter()

chunks = splitter.split_documents(raw_docs)

# 3. 索引 (只需运行一次)

brain = CodeBrain()

# brain.build_knowledge_base(chunks)

# 4. 提问 (加载已有库)

brain.load_knowledge_base()

brain.ask("分析一下 OrderService 里的 createOrder 方法,如果库存不足会抛出什么异常?")

brain.ask("找出项目中所有未使用硬编码 SQL 的地方,并给出重构建议")

🔬 深度解析 (Deep Dive)

为什么你的代码 RAG 效果不好?这里有几个深层次的原因和解决方案。

1. 丢失的"引用图谱" (The Lost Graph)

普通 RAG 最大的问题是:它把代码当成了展平的文本。但代码是立体的。

问题场景:

你问:“User.validate() 方法的逻辑是什么?”

检索器可能找到了 User.java 中的 validate 方法定义。

但,如果 validate() 内部调用了 startValidator.check(),而 StartValidator 定义在另一个文件里,检索器大概率不会把它找回来。LLM 只能看到 check() 的调用,却不知道它内部做了什么。

解决方案: 索引阶段构建调用图 (Call Graph)

我们在 Metadata 中不仅存储 language,还要利用 Tree-sitter 此类工具解析出 calls, defines 等信息。

# 进阶优化思路:Metadata 增强

doc.metadata["defined_functions"] = ["login", "logout"]

doc.metadata["imported_classes"] = ["SecurityUtils", "DBHelper"]

在检索时,我们可以做 “Graph Expansion”:如果检索到了 File A,且 File A 强依赖 File B,那么哪怕 File B 相似度不高,也强制把 File B 加入上下文。

2. 上下文窗口挑战 (Context Window)

即使是 Claude 3 的 200k 窗口,也没法塞进整个单体应用。如果你检索回来的 chunk 太多,噪音会淹没有效信息(Lost in the Middle Phenomenon)。

优化策略:Hierarchical Indexing (分层索引)

- Summary Index: 对每个文件,先用 LLM 生成一个 100 字的摘要。

- Detail Index: 原始代码块。

当用户提问时,先在 Summary Index 中检索,定位到 OrderService.java 和 InventoryService.java 两个关键文件,然后再加载这两个文件的全部代码(而不仅仅是片段)进入 Context。

| 策略 | 检索粒度 | 优点 | 缺点 |

|---|---|---|---|

| 朴素 RAG | 代码片段 (Chunk) | 速度快,省 Token | 容易断章取义,丢失上下文 |

| 分层索引 | 文件摘要 -> 全文件 | 上下文极其完整 | 消耗 Token 多,速度稍慢 |

3. 性能压测对比 (Benchmark)

我们将这套系统应用在了一个 50万行的 Java Spring Boot 项目中,与刚入职 1 个月的 P6 工程师进行了一场 “Bug Finding” 比赛。

测试题目: 找到项目中导致 “Deadlock” 的潜在 SQL 更新顺序不一致代码。

| 选手 | 耗时 | 结果准确度 | 覆盖率 |

|---|---|---|---|

| 新人工程师 | 4.5 小时 | ✅ 找到 1 处 | 20% (漏了4处) |

| Code Brain (AI) | 3 分钟 | ✅ 找到 4 处 | 80% (还有1处误报) |

AI 并没有完全取代人,但它极大缩短了检索路径。工程师原本需要 grep -> 读代码 -> 跳转 -> 读代码,现在只需要验证 AI 给出的线索。

🚨 生产级避坑指南 (Production Pitfalls)

❌ 致命错误 1: 敏感信息泄露

这是最要命的。如果你直接把公司的代码库 Embedding 后传给 OpenAI,哪怕不开源,也存在合规风险。代码库里往往藏着:

- 硬编码的 AWS AK/SK

- 内网数据库密码

- 私钥文件

排查命令 & 修复策略:

在 CodeRepositoryLoader 中必须加入基于正则的 PII (Personal Identifiable Information) 扫描。

# 任何包含 "key", "secret", "password" 的行,直接 mask 掉

if re.search(r"(?i)(password|secret|key)\s*=\s*['\"][^'\"]+['\"]", line):

line = "SECRET_MASKED"

更优选: 使用本地 LLM (如 DeepSeek-Coder-V2, CodeLlama) 和本地 Embedding (如 BGE-M3),确保数据不出内网。

❌ 错误 2: 忽视了代码的时效性

代码是流动的。Git 仓库每天都在 commit。如果你构建了一次向量库就不管了,那 AI 只有“上周的记忆”。

解决方案: 增量更新 (Incremental Update)

利用 Git Hook 或 CI/CD 流水线。每次 merge request merged 后,运行脚本:

git diff --name-only HEAD~1获取变动文件。- 只删除 ChromaDB 中

source为这些文件的 embedding。 - 重新 embed 这些文件。

❌ 错误 3: 这里的注释是骗人的

老代码里经常出现:

// Check if user is admin

// 2021-09-01: Removed admin check temporarily

return true;

AI 如果只读注释,会以为这里还在检查。

策略: 提示词工程 (Prompt Engineering) 中必须要强调 “Trust code over comments” (信代码,别信注释)。

🎯 总结与思考

把代码库喂给大模型,本质上是将隐性知识显性化。它不会取代资深架构师的判断力,但它能把一个刚入职的新人,瞬间武装成一个对代码库了如指掌的“伪资深”员工。

💬 思考题:

在这个系统里,如果引入了 git commit log(提交记录)和 PR comment(代码评审记录)作为额外上下文,会对 Bug 排查有多大提升?

🎯 动手实践:

Clone 上面的 Python 脚本,找一个你自己最复杂的开源项目(比如 React 或 PyTorch 的源码),试着问它:“核心渲染循环在哪里?” 你会被它的准确度惊讶到的。

📚 扩展阅读:

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)