从编码者到“AI 经纪人”:为什么未来的顶尖开发者必须学会管理?

这种变化标志着一个残酷的现实:未来的高杠杆(High-leverage)开发者将不再是单纯的“写代码的人”,而是运行着一支 AI 特工车队的“异步管理者”。要成为一名卓越的“AI 经纪人”,你需要建立一套可复用的“编排操作系统”: 计划(Plan) -> 产生(Spawn) -> 监控(Monitor) -> 验证(Verify) -> 集成(Integrate) -> 复盘(Retro)。这不再

目录

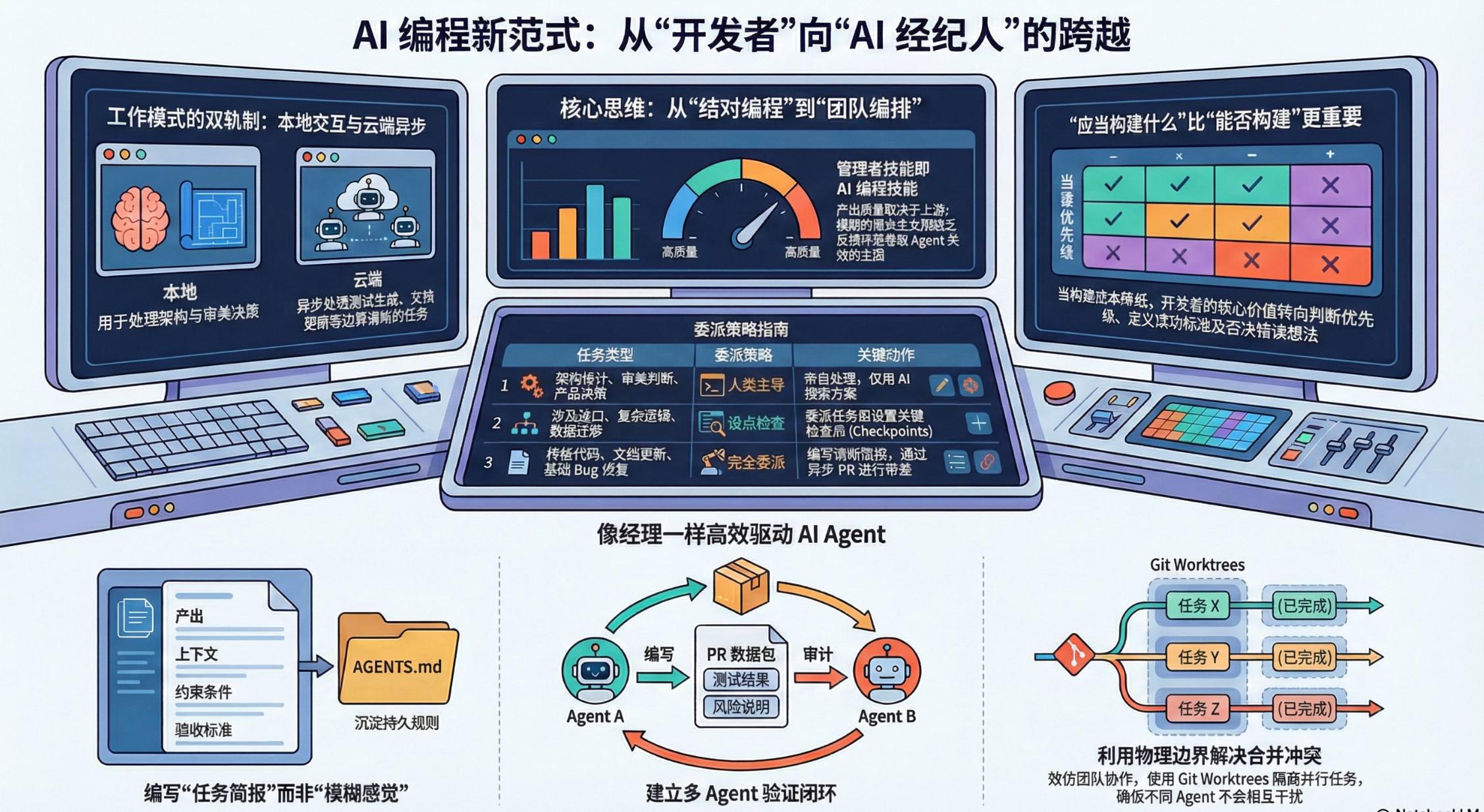

核心策略一:双模工作流(本地高频触达 vs. 云端异步执行)

核心策略四:构建验证闭环(Verification Loops)

引言:编程的瓶颈正在发生位移

当前的开发者正面临一个前所未有的范式转移:AI 生成代码的速度已经呈指数级超越了人类阅读和评审代码的速度。当 Claude Code 的创作者 Boris Cherny 在终端和浏览器中同时运行 15 个会话,甚至在手机上远程启动任务以便稍后检查进度时,传统的“结对编程”模式已经触及了效率天花板。

这种变化标志着一个残酷的现实:未来的高杠杆(High-leverage)开发者将不再是单纯的“写代码的人”,而是运行着一支 AI 特工车队的“异步管理者”。如果说过去的瓶颈是编码能力,那么未来的瓶颈将是你的管理带宽。当构建成本趋近于零,你的核心竞争力将取决于你如何编排这股洪流。

核心转变:从“提示词工程”到“指挥与控制”

当开发流程中引入多个并行运行的 Agent 时,工作的本质发生了变化。这不再是一个微观的“提示词(Prompting)”问题,而是一个宏观的“编排(Orchestration)”问题。

正如任何资深的工程经理所知,输出质量是在上游塑造的。模糊的指令必然导致下游的返工与混乱。我们正在进入一个“任务控制中心(Mission Control)”时代,正如 GitHub 预览的 Agent HQ 所示,它作为一个控制平面,允许开发者协调多个第三方 Agent 并行执行任务。现在的核心挑战不再是“AI 能写代码吗?”,而是“我们该构建什么?”以及“我能否像管理一支高效团队一样管理这些 Agent?”

核心策略一:双模工作流(本地高频触达 vs. 云端异步执行)

为了释放认知负荷,开发者必须像管理层分配人力资源一样,建立双模并行的思维模型:

- 模式 A:本地高频触达(Local, High-touch) 在这种模式下,人类保持“实时参与(Human-in-the-loop)”。这主要用于处理架构决策、复杂的重构、产品细微差别以及任何需要“品味”和判断力的模糊需求。你是总建筑师,在这里进行实时的指挥与纠偏。

- 模式 B:云端异步执行(Cloud/Background Async) 这是针对边界清晰、模式明确的任务。利用 GitHub Copilot Agent 或类似平台在沙盒环境中异步运行。无论是生成测试、更新文档、简单的依赖升级还是特定模式的 Bug 修复,你只需将其“发射”出去,即可切换上下文处理其他核心事务,稍后再回来通过 PR 审查结果。

这种划分将开发者从机械实现中解放出来,将注意力保留给那些无法被算法取代的高阶决策。

核心策略二:撰写“任务简报”而非“模糊感觉”

在管理 AI 时,模糊性是效率的杀手。专业的开发者必须学会将“意图”转化为一份严谨的“任务简报(Brief)”。

Anthropic 的最佳实践明确指出:预先明确规范可以显著提高成功率并减少纠偏成本。一份合格的简报必须包含:

- 预期结果: 完成后系统应处于什么状态(Definition of Done)。

- 上下文锚定: 明确指出 Agent 应该遵循或参考的现有代码文件,确保它锚定在真实的编码惯例上,而非凭空臆造。

- 约束条件: 性能、安全、API 形状及风格规范。

- 非目标(Non-goals): 明确哪些界限是不允许逾越的,防止“代码膨胀”。

- 验证计划: 具体的验收标准,如特定的测试通过或端点行为。

工程化技巧: 维护一个 AGENTS.md 文件。这就像是为 AI 成员准备的“员工手册”,存储关于 Lint 规则、测试要求和依赖政策的持久规则,确保每个新启动的 Agent 都能立即进入状态。

核心策略三:委派的艺术(Delegate vs. Own)

开发者必须不断练习如何分配任务,建立明确的职责边界。这不仅是技术选型,更是资源调度:

- 完全委派(Delegate): 具有清晰规格的机械化实现、样板代码重构、低风险的文档与维护任务。

- 带检查点的委派(Review): 涉及共享接口、可能导致合并冲突或存在复杂产品边缘情况的任务。在此模式下,必须在关键节点设置人工审核。

- 禁止委派(Own): 系统架构、核心抽象、跨领域的重大重构,以及最重要的——“是否该做这个功能”的决策。

当“构建”变得廉价,平庸的产品功能会像杂草一样蔓延。开发者必须利用**“终止准则(Kill Criteria)”**来行使管理职权:在投入过多资源之前,果断停止那些方向错误的实验。

核心策略四:构建验证闭环(Verification Loops)

AI 能够以极快的速度生成低质量的代码。为了防止被垃圾代码淹没,你必须建立自动化的质量门禁。

我们应采用 Anthropic 推荐的“双 Agent 模式”:

- Agent A(执行者): 负责代码实现。

- Agent B(审查者): 负责审查正确性、风格、边缘情况和遗漏的测试。

- 闭环: 执行者根据审查反馈进行迭代,直至通过所有验证。

要求 Agent 在提交 PR 之前必须运行测试套件并提供结构化的“PR 数据包”(包含更改摘要、测试结果和风险提示)。

“管理 AI 就像管理分布在不同时区的团队:你需要预置清晰度,依赖书面更新,并将实时注意力留给关键决策和解除阻塞。”

应对副作用:解决边界失败与认知过载

在大规模并行开发时,管理能力的缺失会导致系统性的崩溃:

- 边界失败(Boundary Failure): 当多个 Agent 同时修改相邻代码时,会产生严重的合并冲突。这本质上是管理上的“职责重叠”。解决方案是利用 Git Worktrees 为每个 Agent 创建隔离的独立工作目录,确保它们在物理上互不干扰。

- 15 分钟阻塞规则: 借鉴高效团队管理经验——如果 Agent 在 15 分钟内没有取得显著进展,必须停止运行并报告阻塞点(Blockers),防止无效的计算资源浪费。

- WIP(在办任务)限制: 正如 Simon Willison 所强调,评审才是真正的瓶颈。你必须诚实地评估自己的注意力带宽,限制同时运行的任务数量,避免自己成为团队中最慢的那块拼图。

结语:你的 AI 操作系统

要成为一名卓越的“AI 经纪人”,你需要建立一套可复用的“编排操作系统”: 计划(Plan) -> 产生(Spawn) -> 监控(Monitor) -> 验证(Verify) -> 集成(Integrate) -> 复盘(Retro)。

在“复盘”阶段,将每次失败的教训更新到 AGENTS.md 中,让系统实现自我进化。正如 Boris Cherny 在手机上启动任务所预示的,未来的创意循环将缩短为:灵感 -> 委派草案 -> 异步评审 -> 迭代发布。

当构建能力不再是限制,你是否已经准备好,让你的“判断力”和“品味”成为那道最后、也是最重要的质量闸门?当心,别让你的产品在 AI 的狂奔中变成一个毫无节制的“杂物间”。

作者:道一云低代码

作者想说:喜欢本文请点点关注~

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)