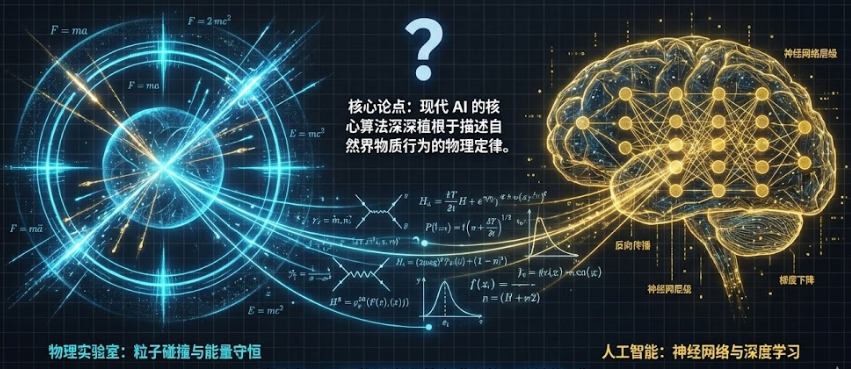

AI 的物理学:为什么神经网络不仅是代码,更是宇宙法则的回响?

诺贝尔委员会的答案揭示了一个深刻的真理:现代 AI 的核心算法并非凭空创造的数学游戏,而是深深植根于描述自然界物质行为的物理定律中。物理学研究的是“上帝”构建的神经网络(宇宙),而 AI 研究的是人类构建的宇宙(神经网络)。:当给 AI 一个残缺的图案(相当于把弹珠放在山坡上),根据物理学趋向最低能量的原理,弹珠会自动滚入最近的山谷。它面对的是一块包含所有可能性的“噪声大理石”,利用物理方程作为凿

2024 年 10 月 8 日,John Hopfield 和 Geoffrey Hinton 凭借在人工智能领域的奠基性工作获得了诺贝尔物理学奖。这一决定最初让许多人感到困惑:为什么计算机科学的成就被归入了物理学?

诺贝尔委员会的答案揭示了一个深刻的真理:现代 AI 的核心算法并非凭空创造的数学游戏,而是深深植根于描述自然界物质行为的物理定律中。从磁铁的微观结构到统计热力学,再到量子场的宏大理论,AI 正是物理学在数字世界的一种镜像。

以下是这一跨学科奇迹背后的四个核心物理支柱。

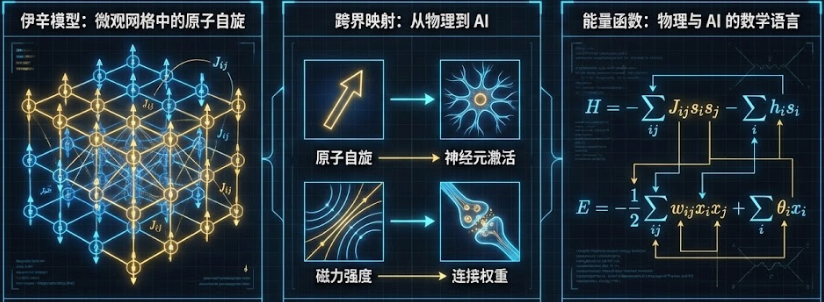

1. 从磁铁到记忆:伊辛模型与能量景观

要理解 AI 如何“记忆”,首先需要审视磁铁的物理本质。

在物理学中,伊辛模型 (Ising Model) 被用来解释铁磁性。想象一个微观网格,格子里充满了原子,每个原子都有一个“自旋”方向(向上或向下)。原子倾向于与邻居保持一致(如果邻居向上,我也向上),因为这样系统的总能量最低、状态最稳定。

1982年,John Hopfield 受到这个物理模型的启发,构建了 **霍普菲尔德网络 (Hopfield Network)**:

-

原子变成了神经元:原本的原子自旋变成了人造神经元的“激活” (1) 或“未激活” (-1) 状态。 -

磁力变成了权重:原子间的相互作用变成了神经元连接处的“权重” (Synaptic Weight)。

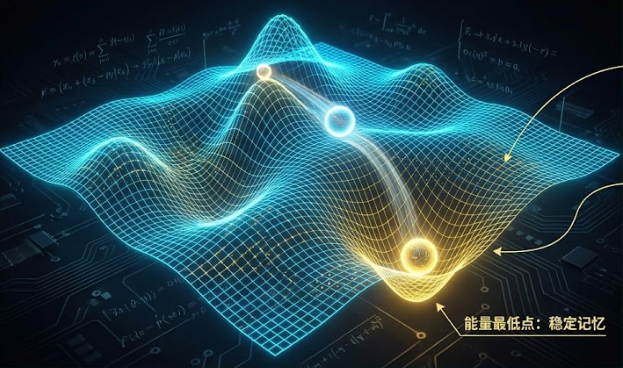

Hopfield 网络最精妙的地方在于它引入了 能量景观 (Energy Landscape) 的概念。可以将网络的所有可能状态想象成一片连绵起伏的山地:

-

学习即“挖坑”:当教 AI 记住一个图案时,实际上是在调整连接权重,在能量地形上“挖掘”出一个低能量的山谷(势阱)。 -

回忆即“滚动”:当给 AI 一个残缺的图案(相当于把弹珠放在山坡上),根据物理学趋向最低能量的原理,弹珠会自动滚入最近的山谷。这意味着网络能自动从噪点中“恢复”出最初记忆的完整图像。

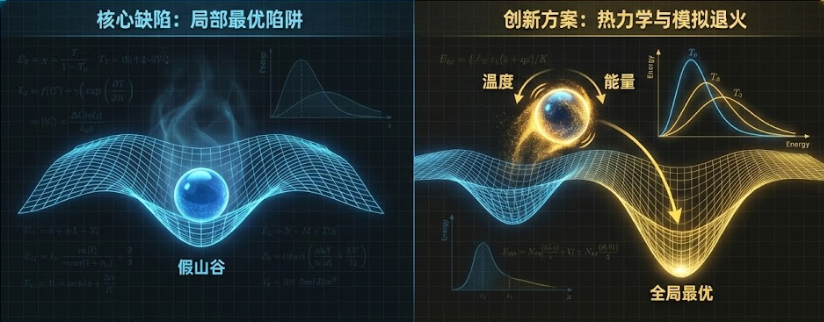

2. 从固执到灵活:Hinton 与热力学的魔法

Hopfield 网络虽然天才,但有一个致命缺陷:如果弹珠滚进了一个很浅的坑(局部最优解),它就会卡在里面出不来,无法找到真正的深谷(全局最优)。这就好比 AI 陷入了思维定势。

Geoffrey Hinton 引入了统计物理中的 “温度” (Temperature) 概念,将 Hopfield 网络升级为 **玻尔兹曼机 (Boltzmann Machine)**。

他借用了冶金学中的 “模拟退火” (Simulated Annealing) 原理:

-

加热:在训练初期,给系统极高的“温度”。这意味着弹珠会剧烈抖动(引入高随机噪声),即使遇到小坑也能轻易跳出来。 -

降温:随着时间推移,逐渐降低温度,让弹珠慢慢稳定下来,最终有极大概率落入整个地形中最深的山谷。

正是这种受热力学启发的“随机性”,让 AI 摆脱了死记硬背,拥有了举一反三的生成能力。

3. 数学的幽灵双胞胎:神经网络与量子场

如果说磁学解释了 AI 的记忆,热力学解释了 AI 的学习,那么 量子场论 则揭示了 AI 更深层的数学结构。这一联系之紧密,可以通过著名的 ** 模型 (The Phi-Fourth Model)** 和一个直观的类比来理解。

场景 A:无限宽网络 = 宇宙真空的涨落

为了理解这一点,我们可以想象一台拥无限多个像素点(神经元)的巨大电视屏幕。

-

现象:如果你随机初始化这些像素的亮度。虽然每个点是随机的,但如果你统计整个无限屏幕的亮度分布,它会呈现出一个完美的钟形曲线(高斯分布)。 -

物理对应:这就像量子力学中的 “真空”。真空不是空的,而是充满了随机的能量波动。如果没有粒子相互作用(自由场),这些波动的统计规律也正好是完美的钟形曲线。 -

结论:一个什么都没学的、无限大的 AI 大脑,它的“脑电波”底噪,和宇宙真空的量子涨落是一模一样的。

场景 B:有限宽网络 = 粒子碰撞与 模型

但现实中的 AI 网络是有限的,就像把那台巨大的电视变小了。

-

现象:因为像素(神经元)变少了,随机性的统计规律开始出现偏差,钟形曲线不再完美。 -

物理对应:这就像在真空中放入了真实的粒子。粒子不再是孤独的,而是开始相互作用(碰撞、吸引)。物理学家使用 ** 模型** 来描述这种粒子成对相互作用的情况。

惊人的同构

最令人震惊的发现在于:为了描述有限宽神经网络的偏差,科学家所使用的数学修正公式,竟然和物理学家用来计算 模型中粒子碰撞的公式是 同构(结构相同) 的。

这也让物理学家找到了解开 AI 黑盒的钥匙——**费曼图 (Feynman Diagrams)**。这一物理学家算了几十年的、用来描述粒子碰撞的图解工具,现在竟可以用来精确分析神经网络的内部运作。

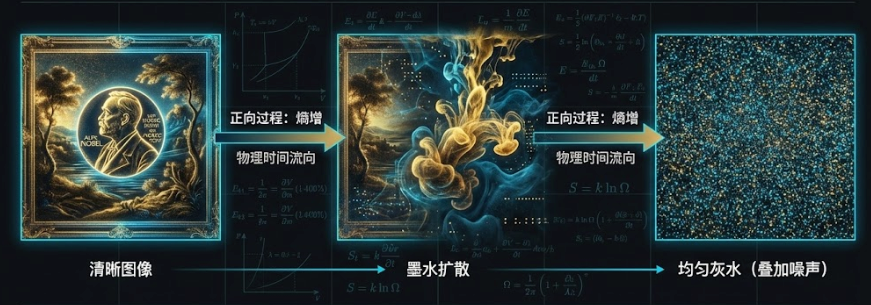

4. 创造的物理学:扩散模型与墨水实验

这一跨界融合的终极案例,是目前驱动 Midjourney、Sora 等生成式 AI 的核心——**扩散模型 (Diffusion Model)**。

它的灵感直接来源于 非平衡热力学。为了理解它,我们可以把生成一张图片的过程想象成“让时间倒流”。

正向过程:熵增与毁灭(Destruction)

想象你有一张清晰的照片,或者一滴滴入清水的浓墨。

-

物理现象:随着时间推移,墨水分子做布朗运动(无规则运动),图像逐渐模糊,最终变成一盆均匀的、毫无信息的灰水。 -

数学本质:这是一个不断叠加 高斯噪声的过程。在物理学中,这对应着 熵增(Entropy Increase),即系统从有序走向无序。这是宇宙最自然的法则,不需要学习。

逆向过程:逆熵与重塑(Creation)

AI 的任务是挑战热力学第二定律:它要学会如何把这盆灰水还原回那滴墨水。

-

学习机制:科学家训练 AI 观察无数张图片被“加噪”的过程。AI 并不需要一次性复原图片,它只需要学会预测“每一步加了什么噪声”。 -

生成的艺术:当你要 AI 画画时,你其实是给它一团完全随机的噪点(一块杂乱的大理石)。AI 开始运行“逆向扩散方程”,根据你的提示词,一步步 减去噪声。

雕刻家的比喻

这就像米开朗基罗雕刻大卫像。以前的 AI(如 GAN)试图一次性堆叠出完美的形状,容易倒塌;而扩散模型则是雕刻。 它面对的是一块包含所有可能性的“噪声大理石”,利用物理方程作为凿子,通过成百上千次微小的操作,剔除多余的杂质(噪声),最终让藏在石头里的图像“显形”。

没有流体力学和热力学的方程,就没有今天生成式 AI 的爆发。

结语

2024 年的诺贝尔物理学奖并非一次跨界的勉强,而是一次某种意义上的“归宗”。

物理学研究的是“上帝”构建的神经网络(宇宙),而 AI 研究的是人类构建的宇宙(神经网络)。这两个领域的殊途同归或许暗示着,智能并非碳基生物的特权,而是物质复杂到一定程度后,为了降低系统熵值而产生的一种必然物理现象。

AI 的物理学,才刚刚开始。

本文由 mdnice 多平台发布

更多推荐

已为社区贡献27条内容

已为社区贡献27条内容

所有评论(0)