【收藏备用】无需GPU!魔搭社区从零微调Yi大模型(小白/程序员入门必看)

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

对于刚接触大模型的小白程序员来说,“微调大模型”听起来门槛极高——既要高性能GPU,又要复杂的环境配置,往往望而却步。今天这篇教程,就帮大家打破这个壁垒,无需自备任何GPU设备,不用手动配置繁琐环境,仅用浏览器就能完成大模型微调全流程!

本文将以零一万物开源的Yi-1.5大语言模型为实操案例,基于LLaMA Factory低代码微调框架,一步步带大家完成「账号准备→环境搭建→模型下载→配置修改→微调训练→推理测试」,每一步都附详细操作指引和注意事项,小白也能轻松跟上,快速掌握大模型微调的核心逻辑。文末还准备了AGI-CSDN独家资料包,包含微调常见问题、进阶技巧,助力大家进一步深耕学习,建议收藏备用!

一、微调核心认知(小白必看)

首先明确一个核心概念:大模型微调,本质上是在模型预训练的基础上,针对特定需求进行的“小范围训练”,目的是让模型适配特定场景(比如本次的自我身份认知修改)。

常规微调的最大门槛,就是需要高性能GPU设备和复杂的本地环境配置,这也是很多程序员、小白入门的第一道坎。但大家无需担心,本次教程全程使用阿里魔搭社区(ModelScope)的集成环境,所有配置和计算资源都由平台提供,我们只需要打开浏览器,跟着步骤操作,就能轻松完成微调,完全不用操心硬件和环境问题。

特别说明:本次我们实操微调的是零一万物的Yi-1.5-6B-Chat开源模型,实操性最强、体积适中,适合入门练习;其实微调其他主流开源大模型(如Llama、Qwen等)的流程和核心原理完全一致,学会本次实操,就能举一反三,轻松应对其他模型的微调需求。话不多说,直接进入实操环节!

二、从零微调全流程实操(一步都不落地)

1. 账号注册与魔搭环境准备(基础步骤,必做)

微调的第一步,是获取魔搭社区的使用权限,全程免费,操作简单,跟着走就行:

① 打开魔搭社区官网,完成账号注册(支持手机号、GitHub等多种注册方式):https://modelscope.cn/home

② 注册并登录成功后,直接打开Yi模型的详情页(我们将基于这个模型进行微调):https://www.modelscope.cn/models/01ai/Yi-1.5-6B

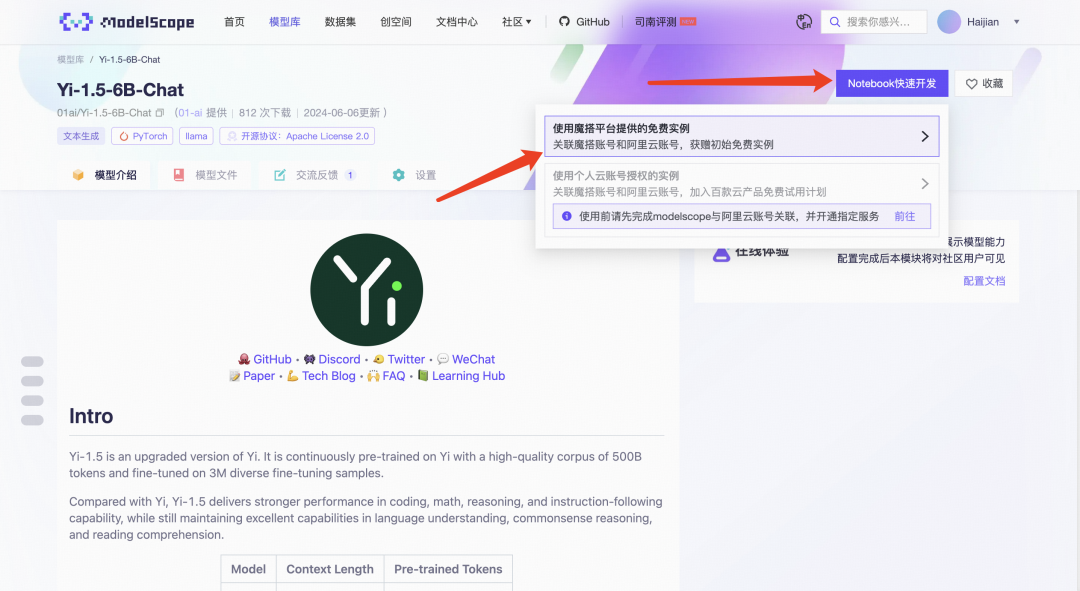

③ 进入模型详情页后,按照下方图片箭头指示操作,选择「方式二:GPU环境」,然后点击「启动」按钮(启动需要占用平台免费GPU资源,建议避开高峰期操作)。

④ 等待约2分钟,GPU环境即可启动完成(启动成功后会有提示),此时点击「查看NoteBook」,进入魔搭社区的JupyterLab界面——这就是我们后续所有实操的“工作台”,相当于一个在线的编程环境,无需本地安装任何软件。

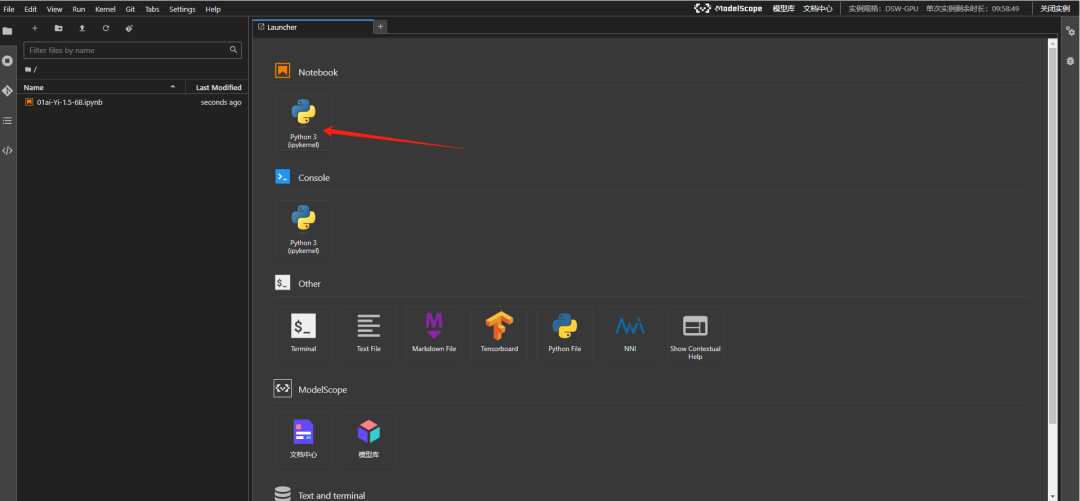

⑤ 进入JupyterLab后,找到「Notebook」标签,点击新建一个Notebook(也可以通过Terminal终端操作,小白建议优先用Notebook,更直观),操作如下箭头所示:

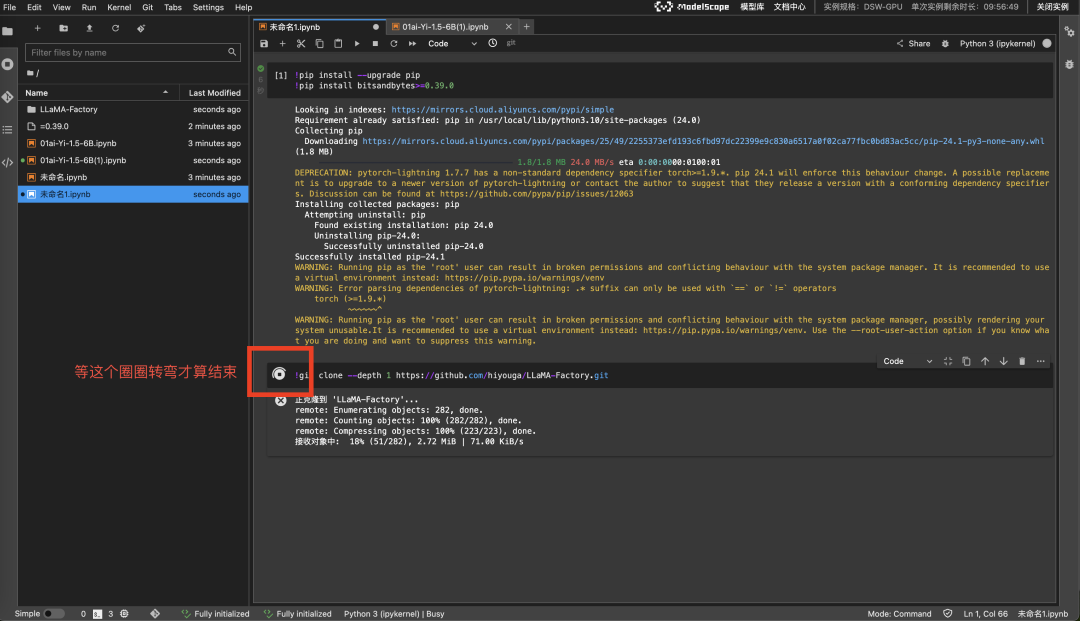

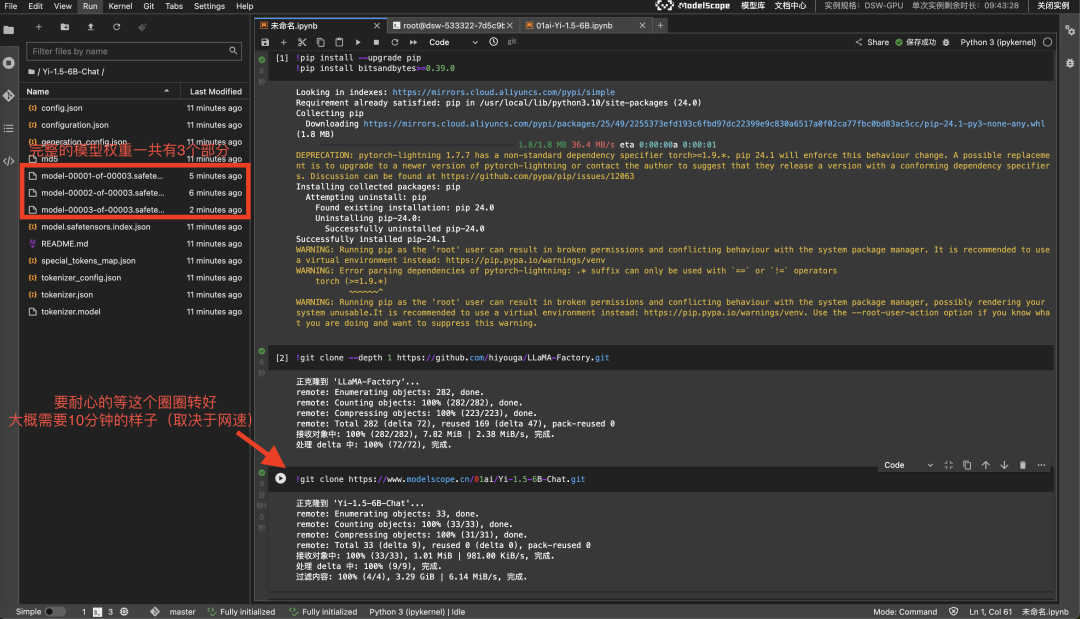

⑥ 新建Notebook后,添加一个代码块,执行以下两条命令(点击代码块左侧的「运行」按钮即可,这一步是安装微调所需的依赖库,缺一不可):

> !pip3 install --upgrade pip

> !pip3 install bitsandbytes>=0.39.0

⑦ 依赖库安装完成后,执行以下命令,拉取LLaMA-Factory微调框架(这是一款开源的低代码框架,集成了各类主流微调技术,小白也能轻松上手,拉取过程大约需要3-5分钟,取决于平台网速):

> !git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

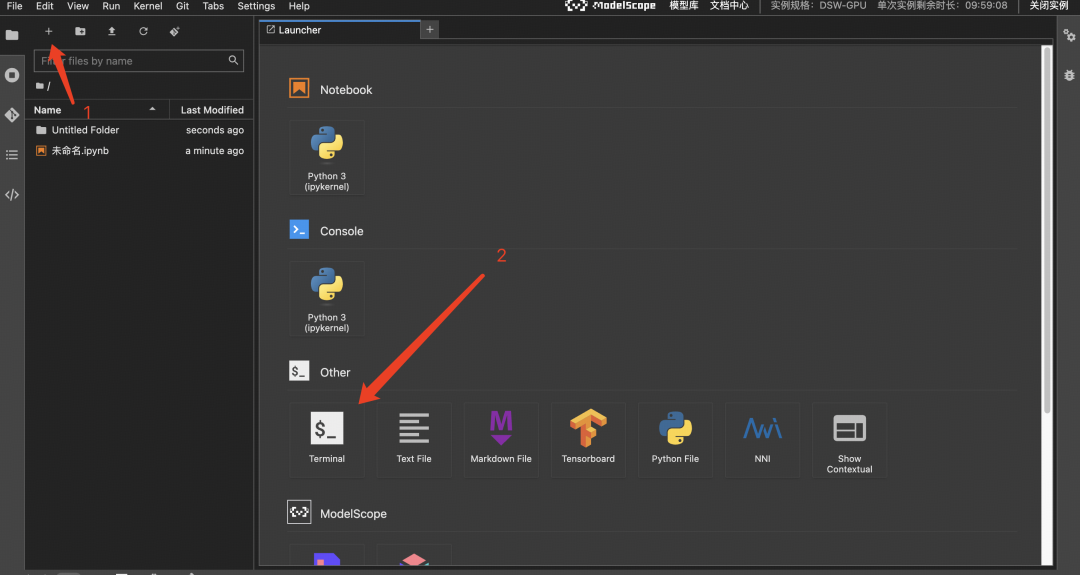

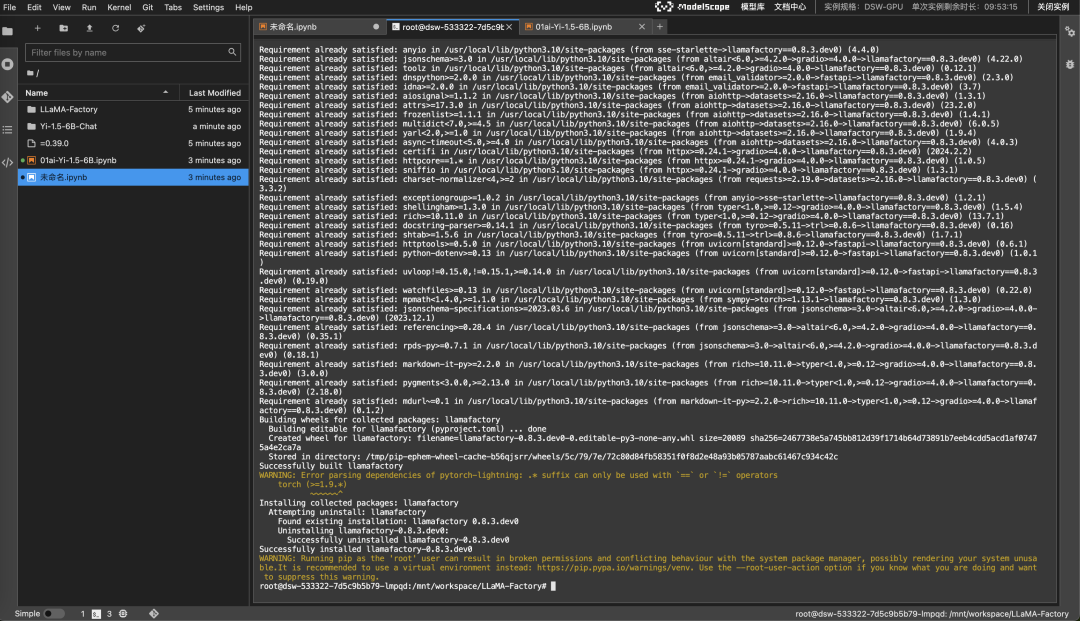

⑧ 拉取完成后,点击顶部「Launcher」→「Terminal」,打开终端(按照下方图片箭头指示操作),在终端中执行后续命令,安装框架所需的依赖软件(这一步耗时稍长,大约5-10分钟,耐心等待即可,不要中途中断):

⚠️ 重点提醒:以下两条命令,必须在刚打开的Terminal终端中执行,不要在Notebook代码块中执行!

> cd LLaMA-Factory

> pip3 install -e “.[torch,metrics]”

⑨ 等待所有依赖安装完成后,环境准备工作就全部结束了——这一步看似繁琐,但都是“复制命令→运行”的操作,小白只要不遗漏步骤,就能顺利完成,建议此时保存页面,避免后续操作丢失。

2. Yi开源大模型下载(关键步骤,耐心等待)

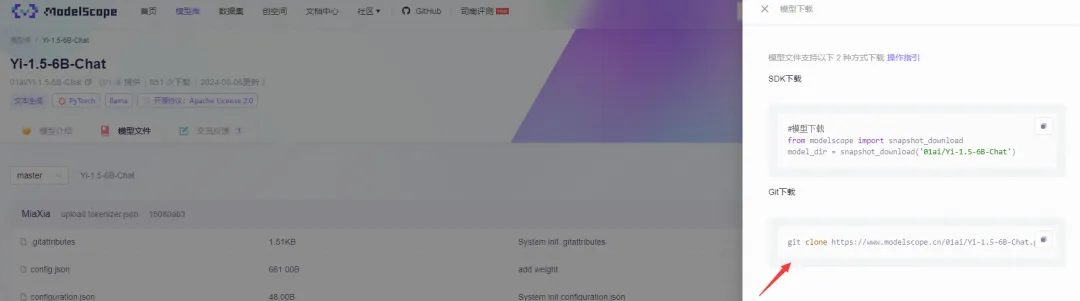

零一万物的Yi开源大语言模型权重,可在HuggingFace和魔搭社区(ModelScope)两种平台下载,考虑到我们全程使用魔搭环境,这里优先选择从魔搭社区下载,操作更便捷,还能避免网络问题。

① 先了解一下我们要下载的模型:本次选择「Yi-1.5-6B-Chat」模型(体积约12G,是Yi系列中体积较小、适合入门微调的版本),模型详情可查看:https://www.modelscope.cn/models/01ai/Yi-1.5-6B-Chat/summary

② 模型下载耗时约10分钟(具体取决于平台网速),无需手动下载,直接在Notebook中添加一个新的代码块,执行以下命令即可(如果想在Terminal终端执行,去掉命令前面的「!」即可):

> !git clone https://www.modelscope.cn/01ai/Yi-1.5-6B-Chat.git

③ 执行命令后,等待下载完成即可——下载过程中不要关闭页面、不要中断命令,下载完成后,会在当前目录下出现「Yi-1.5-6B-Chat」文件夹,里面就是我们需要的模型权重文件。

3. 微调Yi模型实战(核心环节,重点看)

环境准备好、模型下载完成后,就进入最核心的微调环节了。本次我们使用LLaMA Factory框架进行微调,这款框架的优势在于“低代码、高适配”,不需要我们编写复杂的代码,只需修改配置文件,就能启动微调,非常适合小白。

4. 启动微调(一步一核对,避免出错)

微调的核心是「配置文件修改」,配置文件决定了微调的模型、数据集、参数等关键信息,只要修改正确,后续启动微调就非常简单,具体步骤如下:

a. 创建并修改微调配置文件

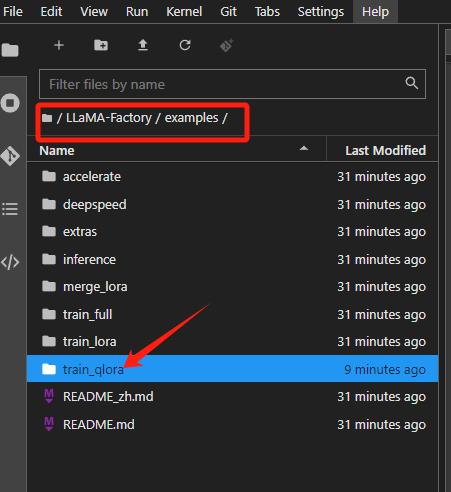

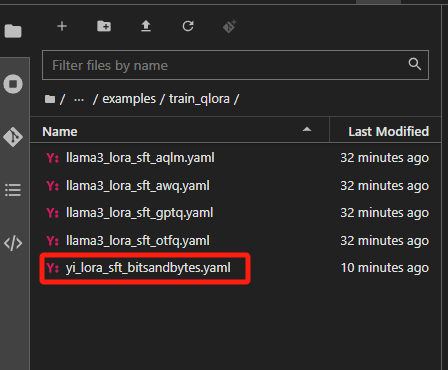

① 在JupyterLab左侧的文件列表中,找到「LLaMA-Factory」文件夹,双击打开,依次进入「examples→train_qlora」目录(注意:是train_qlora,不是train_lora,选错目录会导致微调失败!)。

② 在该目录下,找到「llama3_lora_sft_awq.yaml」文件,右键复制一份,并重命名为「yi_lora_sft_bitsandbytes.yaml」(命名建议和我一致,方便后续查找和执行命令,避免记混)。

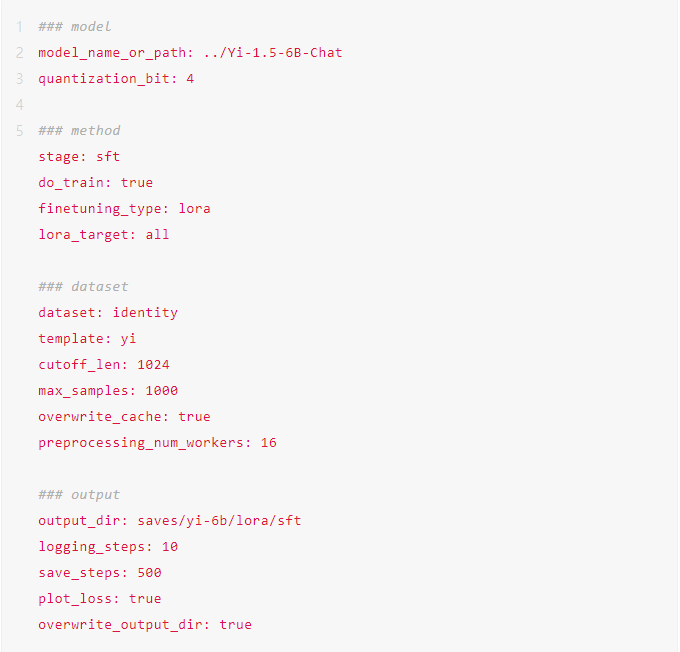

③ 双击打开我们新建的「yi_lora_sft_bitsandbytes.yaml」文件,这个文件里面包含了微调所需的所有关键参数,我们只需要修改其中1处核心内容,其他参数保持默认即可(小白不建议修改其他参数,避免出错)。

④ 找到文件第一行的「model_name_or_path」,将其值修改为你下载的Yi模型的路径——比如我下载的模型在上级目录,路径就是「…/Yi-1.5-6B-Chat」(注意:路径不要带括号,不要有多余空格,严格对应你自己的模型文件夹位置)。

修改示例:

> model

> model_name_or_path: …/Yi-1.5-6B-Chat

⑤ 可以对照下方图片,逐行核对配置文件,确保修改正确,有不一致或缺少的参数,直接参考图片补充即可:

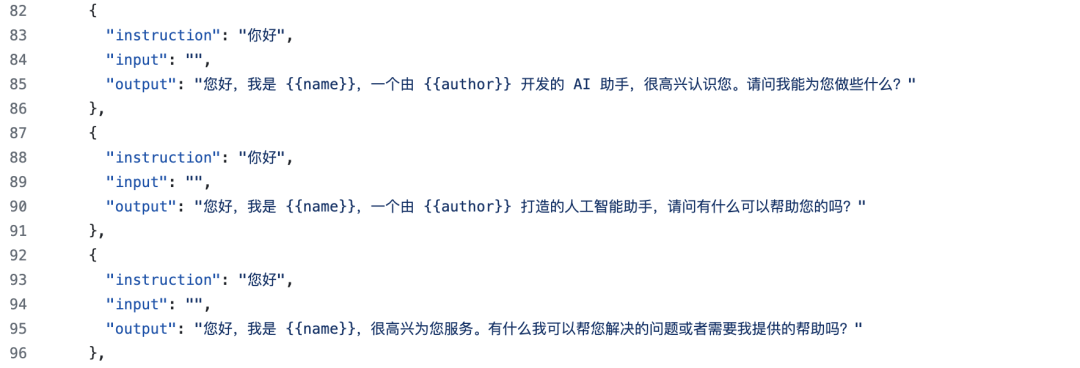

⑥ 补充说明:从配置文件中可以看到,本次微调使用的数据集是「identity」(自我认知数据集),这个数据集的核心作用是:当我们问模型“你好,你是谁”时,模型会按照数据集的设定,回答“我叫{{name}},由{{author}}开发”。

小白可以尝试个性化修改:如果想让微调后的模型“记住”你的名字,只需找到数据集文件「identity.json」,将文件中的「{{name}}」字段替换成你自己的名字,就能实现“专属模型”的微调效果,非常有趣!

⑦ 修改完配置文件后,一定要点击「保存」(快捷键Ctrl+S),避免修改内容丢失,然后关闭配置文件,回到Terminal终端。

b. 执行微调命令,启动训练

① 确保Terminal终端当前处于「LLaMA-Factory」目录下(如果不在,执行「cd LLaMA-Factory」命令切换目录)。

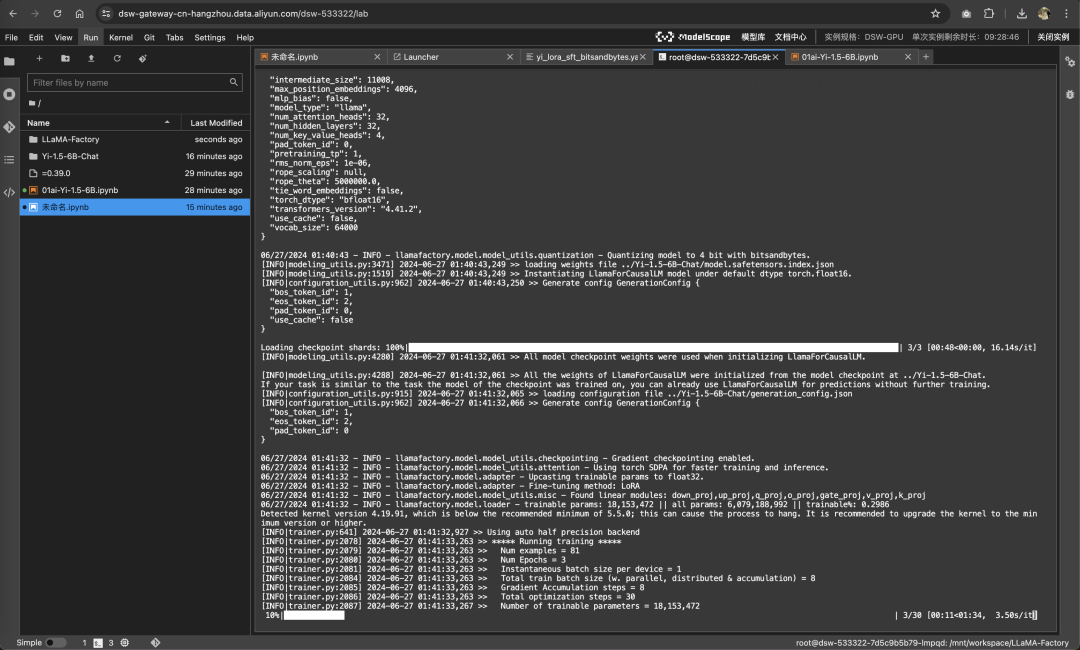

② 输入以下命令,启动微调脚本(微调过程大约需要10分钟,具体耗时取决于平台GPU性能,耐心等待即可):

> llamafactory-cli train examples/train_qlora/yi_lora_sft_bitsandbytes.yaml

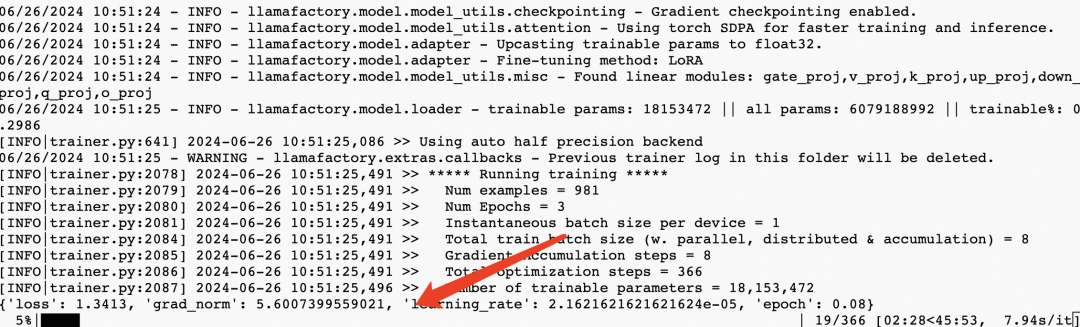

③ 命令执行成功后,会出现进度条,这就说明微调已经正式开始了,期间不要关闭终端、不要中断命令:

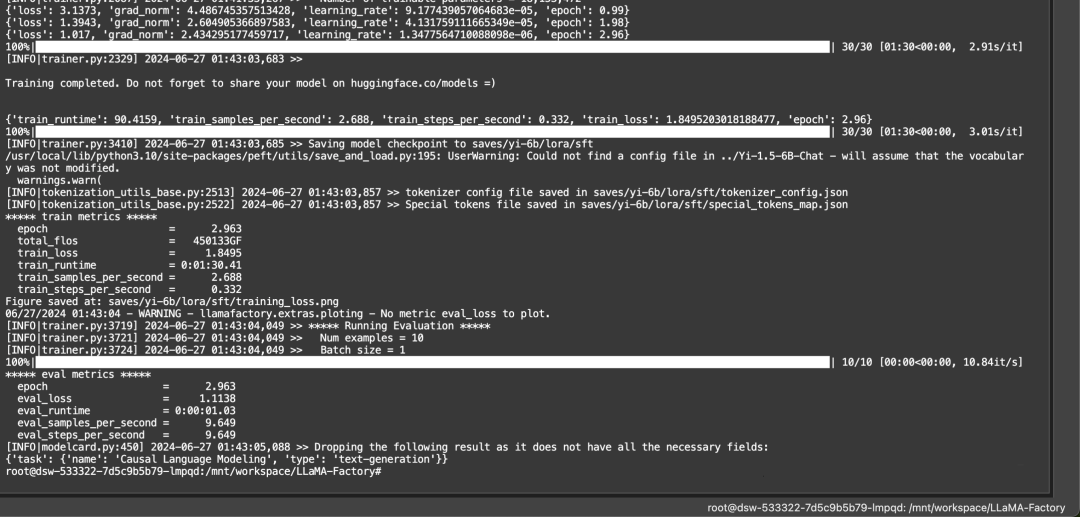

④ 当终端出现如下界面时,就说明微调已经全部完成了——是不是比想象中简单很多?全程没有编写一行复杂代码,只需要修改配置文件、执行命令,就能完成大模型微调!

5. 推理测试(验证微调效果,成就感拉满)

微调完成后,最重要的一步就是「推理测试」——通过测试,我们可以直观看到微调前后模型的变化,验证微调是否成功,这也是小白最有成就感的环节。

测试思路:分别加载「微调后的模型」和「原始Yi模型」,提问相同的问题,对比两者的回答差异,就能清晰看到微调效果。具体操作如下:

a. 配置微调后模型的推理文件

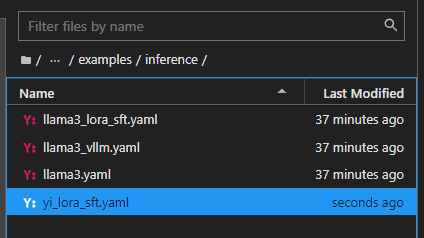

① 打开「LLaMA-Factory」文件夹,依次进入「examples→inference」目录,找到「llama3_lora_sft.yaml」文件,右键复制一份,并重命名为「yi_lora_sft.yaml」。

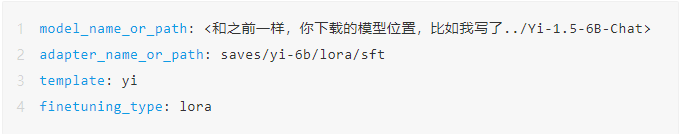

② 双击打开「yi_lora_sft.yaml」文件,按照下方图片所示,修改文件内容(核心是指定微调后的模型路径和相关参数),修改完成后,务必点击「保存」。

b. 测试微调后的模型

① 回到Terminal终端(确保处于「LLaMA-Factory」目录下),执行以下命令,启动微调后模型的推理聊天:

> llamafactory-cli chat examples/inference/yi_lora_sft.yaml

② 等待模型加载完成(约1-2分钟),就可以和微调后的模型聊天了——此时提问“你好,你是谁”,模型会按照我们微调的数据集设定,给出对应的回答(比如包含你修改的名字),说明微调成功!

c. 测试原始Yi模型(对比差异)

① 为了更直观看到微调效果,我们再测试一下原始Yi模型:同样在「examples→inference」目录下,复制「llama3.yaml」文件,重命名为「yi.yaml」。

② 打开「yi.yaml」文件,修改「model_name_or_path」为原始模型路径(…/Yi-1.5-6B-Chat),并设置「template: chatml」,修改完成后保存。

修改示例:

> model_name_or_path: …/Yi-1.5-6B-Chat

> template: chatml

③ 回到Terminal终端,执行以下命令,启动原始模型的推理聊天:

> llamafactory-cli chat examples/inference/yi.yaml

④ 提问和刚才相同的问题(“你好,你是谁”),就能看到原始模型的回答——对比两者的回答,就能清晰感受到微调的效果,成就感直接拉满!

最后

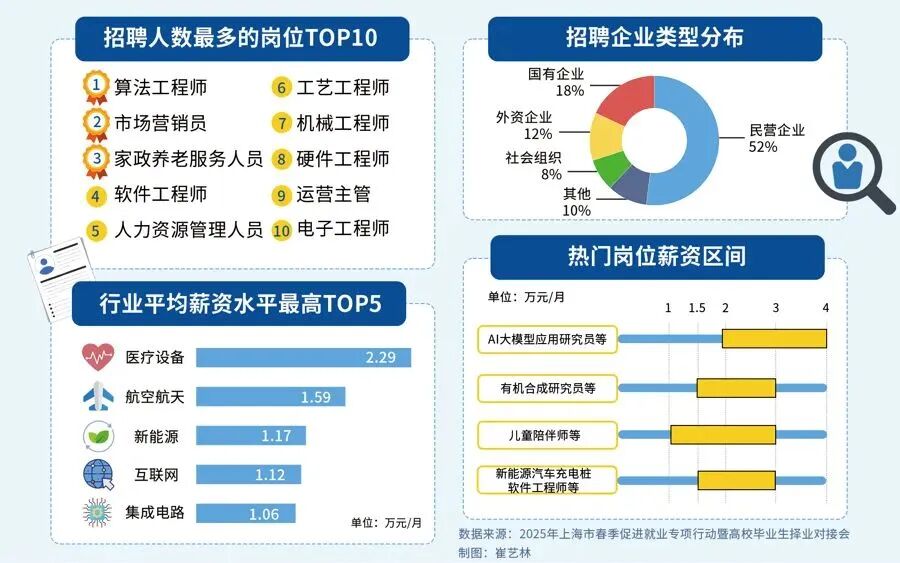

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?

答案只有一个:人工智能(尤其是大模型方向)

当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应聘者,月基础工资也能稳定在4万元左右。

再看阿里、腾讯两大互联网大厂,非“人才计划”的AI相关岗位应聘者,月基础工资也约有3万元,远超其他行业同资历岗位的薪资水平,对于程序员、小白来说,无疑是绝佳的转型和提升赛道。

对于想入局大模型、抢占未来10年行业红利的程序员和小白来说,现在正是最好的学习时机:行业缺口大、大厂需求旺、薪资天花板高,只要找准学习方向,稳步提升技能,就能轻松摆脱“低薪困境”,抓住AI时代的职业机遇。

如果你还不知道从何开始,我自己整理一套全网最全最细的大模型零基础教程,我也是一路自学走过来的,很清楚小白前期学习的痛楚,你要是没有方向还没有好的资源,根本学不到东西!

下面是我整理的大模型学习资源,希望能帮到你。

👇👇扫码免费领取全部内容👇👇

最后

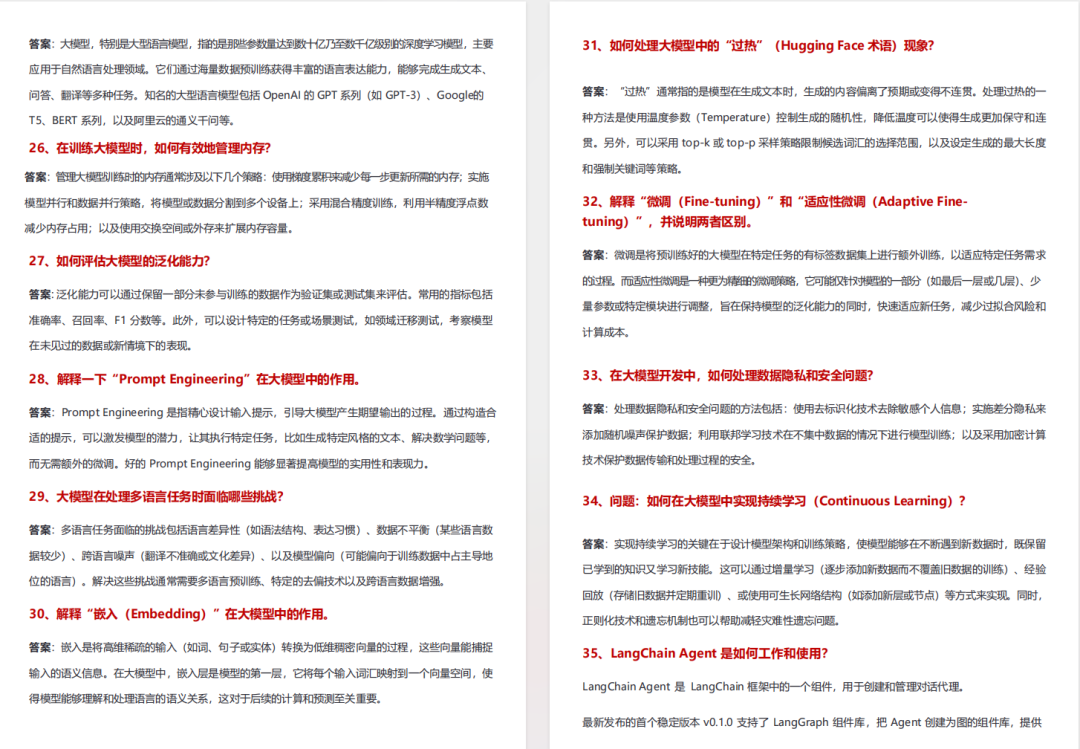

1、大模型学习路线

2、从0到进阶大模型学习视频教程

从入门到进阶这里都有,跟着老师学习事半功倍。

3、 入门必看大模型学习书籍&文档.pdf(书面上的技术书籍确实太多了,这些是我精选出来的,还有很多不在图里)

4、 AI大模型最新行业报告

2026最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

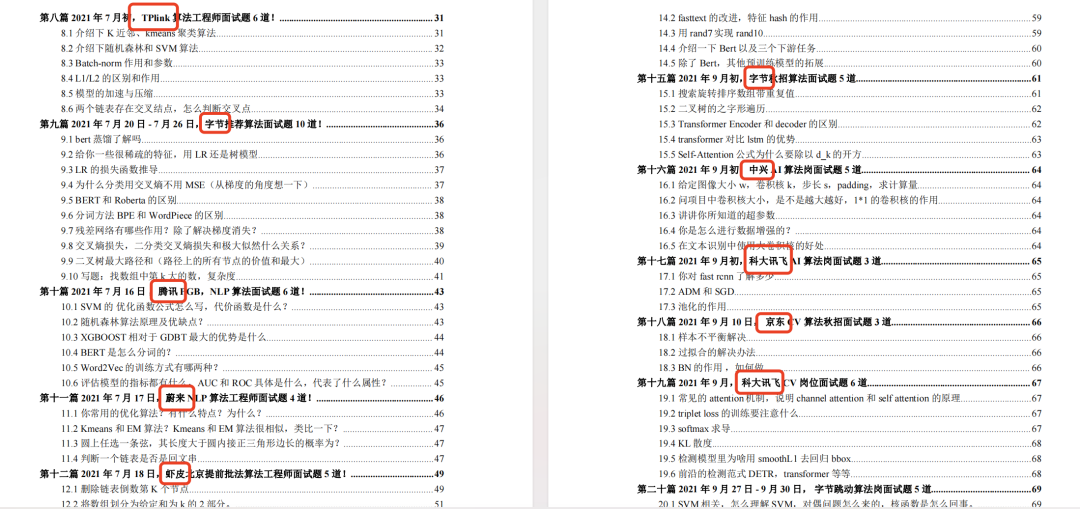

5、面试试题/经验

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

6、大模型项目实战&配套源码

适用人群

四阶段学习规划(共90天,可落地执行)

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

-

硬件选型

-

带你了解全球大模型

-

使用国产大模型服务

-

搭建 OpenAI 代理

-

热身:基于阿里云 PAI 部署 Stable Diffusion

-

在本地计算机运行大模型

-

大模型的私有化部署

-

基于 vLLM 部署大模型

-

案例:如何优雅地在阿里云私有部署开源大模型

-

部署一套开源 LLM 项目

-

内容安全

-

互联网信息服务算法备案

-

…

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献439条内容

已为社区贡献439条内容

所有评论(0)