开源社区AI测试:全球协作的自动化验证

开源社区正在推动AI测试向全球协作转型,通过共享代码和集体智慧打破传统闭源壁垒。开源工具已覆盖70%企业测试流程,其分层架构整合CV、NLP等技术,使自动化覆盖率达85%-90%。社区协作解决了数据孤岛问题,如OpenJudge等工具建立了标准化评测体系。尽管面临模型泛化、数据安全等挑战,未来趋势将向全自动化发展,实现"质量即代码"愿景。开源AI测试正从辅助工具升级为核心验证引

开源运动重塑AI测试生态

开源社区正驱动AI测试从封闭工具链向全球协作网络转型,其核心理念——代码共享、透明创新与集体智慧——彻底打破传统闭源模式的碎片化壁垒。例如,Linux和Apache等项目已证明,社区协作能加速技术迭代,使测试资源从企业专有转向大众共享。截至2026年,全球超70%的企业测试流程整合了开源工具,凸显其主流化趋势。这一变革的核心在于AI与开源的融合:通过自动化验证框架(如动态测试生成和智能缺陷检测),社区协同解决了测试覆盖率低、维护成本高等痛点。本文将从技术架构、协作模式、挑战及最佳实践展开,解析开源AI测试如何实现高效、可信的全球验证体系。

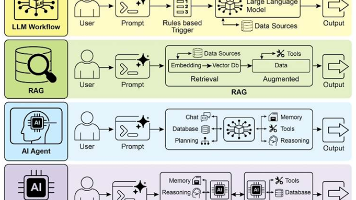

一、开源AI测试工具的核心架构与技术演进

开源AI测试框架通过分层设计整合计算机视觉(CV)、自然语言处理(NLP)和强化学习(RL),实现从用例生成到结果分析的全栈自动化。典型架构包括:

-

执行引擎层:基于Selenium或Playwright等开源底座,支持跨平台(Web/移动端)测试,但传统方法面临动态元素定位难题,例如React/Vue生成的DOM结构变化导致XPath选择器频繁失效。

-

AI驱动层:融入生成式模型(如YOLOv8)提升缺陷检测精度。对比显示,传统阈值法精度仅72%,而“生成式AI+YOLO”方案达95%,且训练数据需求极低。

-

验证与优化层:通过CI/CD管道实现实时反馈,例如PyTorch框架结合TensorBoard可视化模型性能,自动化覆盖率达85%-90%,核心回归周期缩短50%。

代表性工具如OpenJudge(阿里云开源)提供标准化评测体系,覆盖多模态输入与业务适配性验证;而qa-use平台则革新E2E测试,用户以自然语言描述步骤(如“点击搜索按钮”),AI代理自主执行并生成报告。

二、全球协作机制:社区驱动的自动化验证实践

开源社区的分布式贡献模式解决了AI测试中的数据孤岛和知识壁垒问题,其协作流程包括:

-

知识共享:开发者通过GitHub等平台提交用例库和模型优化代码,例如Hypothesis框架支持随机输入生成,用户仅需定义数据策略(

@given(st.floats())),社区贡献提升泛化能力。 -

工具共建:跨区域团队协作开发适配性工具。以鸿蒙系统为例,社区推出“HarmonyOS UI Automator + AI语义解析”方案,实现手机、平板、车机多设备脚本统一,复用率提升65%。

-

验证标准化:OpenJudge等框架建立可复现评测基准,推动测试从经验导向转向指标驱动,例如通过KPI(如异常捕获率)量化AI代理价值。

协作效益显著:全球开发者共同应对复杂场景(如电商促销规则变化),避免“用例大面积失效”问题,同时降低工具许可成本。

三、自动化验证的关键技术与创新应用

AI测试的自动化验证依赖三大技术支柱:

-

智能用例生成:

-

NLP模型解析需求文档,自动生成边界条件用例。例如,金融风控系统利用历史日志构建测试数据集,覆盖传统方法难以触及的异常场景。

-

结合强化学习优化用例组合,动态调整执行顺序以聚焦高风险模块。

-

-

实时执行与监控:

-

脚本自愈机制应对环境波动,如qa-use的AI代理在元素加载失败时自主重试或关闭弹窗。

-

多模型并行测试框架(如PyTorch)集成异常报警,生产环境错误率下降20%。

-

-

跨模态验证:

-

支持文本、图像、语音多模态输入,例如微信小程序测试中,AI识别页面结构并自动生成“授权→支付”路径。

-

创新应用如A/B测试优化:通过Mermaid流程图设计流量分配策略(graph LR A[业务目标] --> B[变量定义]),AI决策最优产品迭代方案。

四、挑战与解决方案:泛化、安全与人机协同

尽管开源AI测试高效,仍存核心挑战:

-

模型泛化不足:复杂业务(如医疗数据)中,通用方案适应性差。解法包括定制化模型和社区驱动的数据增强,例如OpenJudge支持垂直领域深度评测。

-

数据安全风险:测试数据含敏感信息(如用户日志),需动态脱敏。最佳实践结合差分隐私技术,确保可用性与合规性。

-

人机协作瓶颈:AI生成内容需人工验证,可能削弱策略创新。倡导“智能协作者”模式,如测试团队定义模型边界(如“图像识别时间≤100ms”),AI执行重复任务。

开源社区通过标准化协议(如OpenAPI)和培训资源缓解这些挑战,推动角色从“执行者”转向“质量策略制定者”。

五、未来趋势与最佳实践

开源AI测试正迈向全自动化与生态重构:

-

技术融合:量子计算探索复杂系统测试,生成式AI实现“需求理解→执行分析”闭环。

-

生态演进:从工具适配转向平台统一(如OpenQA),支持低代码准入和SaaS化服务。

-

最佳实践框架:

阶段

行动项

案例参考

评估

定义KPI(如成本降低率)

AI代理投资回报率量化

实施

分层执行核心模块

CI/CD触发自动化测试

优化

人机协同验证开放域场景

智能写作助手人工评分机制

最终,开源社区将推动AI测试成为“质量即代码”的智能体,实现零人工干预愿景。

结论

开源社区通过全球协作,将AI测试从辅助工具升级为自动化验证核心引擎。技术层面,工具如OpenJudge和qa-use解决覆盖度与效率问题;协作层面,分布式贡献打破数据孤岛;未来,人机协同与生态标准化将主导行业演进。测试从业者需深耕开源技能,拥抱这一不可逆的变革浪潮。

精选文章

更多推荐

已为社区贡献441条内容

已为社区贡献441条内容

所有评论(0)