AI原生应用安全防护:从开发到部署的全生命周期防护

本文旨在帮助AI开发者、安全工程师及企业技术负责人理解AI原生应用在全生命周期中的典型安全风险,并掌握具体的防护方法。内容覆盖从数据采集到模型部署、运行维护的全流程,重点解析数据隐私保护、模型抗攻击能力、部署环境安全等核心问题。本文将按照"开发前→开发中→部署后"的时间线展开,依次讲解数据安全、模型安全、部署安全三大核心模块,最后结合实战案例演示完整防护流程。AI原生应用:以AI模型为核心功能模块

AI原生应用安全防护:从开发到部署的全生命周期防护

关键词:AI原生应用、全生命周期安全、数据隐私保护、模型安全加固、部署防护体系、对抗攻击防御、安全开发流程

摘要:AI原生应用(以AI模型为核心驱动力的应用)正深刻改变着医疗、金融、自动驾驶等领域,但随之而来的数据泄露、模型被攻击、恶意篡改输出等安全问题也成为发展瓶颈。本文将以"全生命周期防护"为主线,从开发前的数据准备到部署后的运行监控,用通俗易懂的语言拆解每个阶段的安全风险,并结合实际案例和代码示例,手把手教你构建覆盖"数据-模型-部署-运营"的完整安全防护体系。

背景介绍

目的和范围

本文旨在帮助AI开发者、安全工程师及企业技术负责人理解AI原生应用在全生命周期中的典型安全风险,并掌握具体的防护方法。内容覆盖从数据采集到模型部署、运行维护的全流程,重点解析数据隐私保护、模型抗攻击能力、部署环境安全等核心问题。

预期读者

- 初级/中级AI开发者(想了解如何在代码中嵌入安全逻辑)

- 安全工程师(需要掌握AI特有的安全防护技术)

- 技术管理者(需制定AI应用安全策略)

- 对AI安全感兴趣的非技术人员(通过案例理解风险)

文档结构概述

本文将按照"开发前→开发中→部署后"的时间线展开,依次讲解数据安全、模型安全、部署安全三大核心模块,最后结合实战案例演示完整防护流程。

术语表

核心术语定义

- AI原生应用:以AI模型为核心功能模块(如推荐、预测、决策)的应用,区别于传统"AI+应用"(AI仅作为辅助工具)。

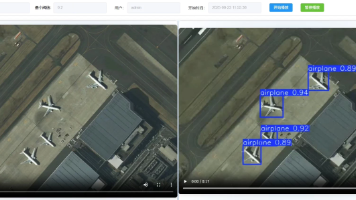

- 对抗样本:通过微小扰动修改输入数据(如图像添加人眼不可见的噪声),导致模型输出错误结果的恶意输入。

- 数据投毒:向训练数据中注入恶意样本(如在医疗影像数据中添加伪造病灶),导致模型训练后产生系统性偏差。

- 模型窃取:通过API接口多次调用模型(如发送不同输入并记录输出),反向推测模型结构或参数的攻击行为。

缩略词列表

- DP(Differential Privacy):差分隐私,一种数据脱敏技术

- FGSM(Fast Gradient Sign Method):快速梯度符号法,一种生成对抗样本的算法

- GDPR:通用数据保护条例(欧盟)

核心概念与联系

故事引入:智能奶茶店的"翻车"事件

小A开了一家智能奶茶店,用AI模型根据顾客历史订单推荐饮品。最近发生了两件怪事:

- 有顾客发现自己的订单记录被泄露,竟在二手平台看到了自己的"奶茶偏好数据"(数据泄露);

- 某顾客故意点了一杯加"特殊符号"的奶茶(如"草莓^%$奶"),AI推荐系统突然疯狂推荐最贵的奶茶(对抗攻击);

- 竞争对手通过频繁调用推荐接口,竟还原出了小A的推荐模型(模型窃取)。

这三个问题正是AI原生应用最典型的安全风险——数据安全、模型安全、部署安全。要解决它们,需要从开发到部署的全生命周期防护。

核心概念解释(像给小学生讲故事)

核心概念一:数据安全——AI的"食材"要干净

AI模型就像做蛋糕的机器,需要"数据食材"来训练。如果食材被污染(如加了过期牛奶),做出来的蛋糕就会难吃甚至有毒。数据安全就是要保证:

- 采集的"食材"(原始数据)不泄露隐私(比如不把顾客手机号和奶茶偏好一起存);

- 处理的"食材"(清洗后的数据)不被恶意篡改(比如防止有人偷偷往训练数据里加假订单)。

核心概念二:模型安全——AI的"大脑"要结实

模型是AI的"大脑",如果大脑被"洗脑"(如对抗攻击),就会做出错误决策。模型安全要保证:

- 大脑不容易被"洗脑"(能识别对抗样本);

- 大脑不会被"偷学"(防止竞争对手复制你的决策逻辑)。

核心概念三:部署安全——AI的"房子"要上锁

模型训练好后要"住"在服务器里(部署上线),这时候需要给"房子"上锁:

- 防止坏人随便敲门(非法调用API);

- 监控房子里的动静(记录每次调用的输入输出,发现异常行为)。

核心概念之间的关系(用小学生能理解的比喻)

数据安全、模型安全、部署安全就像给奶茶店装三层防护网:

- 第一层(数据安全):保证进货的牛奶、茶叶没过期,没被下毒;

- 第二层(模型安全):保证做奶茶的机器不会被坏人动手脚(比如不会因为输入"奇怪符号"就乱加糖);

- 第三层(部署安全):保证奶茶店的门只让顾客进,不让小偷溜进去偷配方。

三层网缺一不可——如果第一层没做好(数据泄露),即使机器再结实(模型安全),小偷也能直接拿到顾客信息;如果第三层没做好(部署漏洞),坏人可能绕过前两层直接攻击机器。

核心概念原理和架构的文本示意图

AI原生应用全生命周期安全防护架构可概括为"三横一纵":

- 横向:覆盖"数据采集→模型训练→部署上线→运行维护"四个阶段;

- 纵向:贯穿"隐私保护→抗攻击加固→访问控制→监控响应"四大能力。

Mermaid 流程图

核心算法原理 & 具体操作步骤

数据安全:如何给"食材"加保护层?

关键技术:差分隐私(DP)

差分隐私是一种"模糊化"数据的技术,就像给照片打马赛克——让人能看出大概(模型仍能学习规律),但看不清细节(无法还原个人信息)。

数学原理:对于任意两个仅相差一条记录的数据集 ( D ) 和 ( D’ ),任意输出结果 ( S ),满足:

P(f(D)∈S)≤eϵ⋅P(f(D′)∈S) P(f(D) \in S) \leq e^\epsilon \cdot P(f(D') \in S) P(f(D)∈S)≤eϵ⋅P(f(D′)∈S)

其中 ( \epsilon ) 是隐私预算(值越小,隐私保护越强,模型效果可能越差)。

Python代码示例(用TensorFlow Privacy实现差分隐私训练)

import tensorflow as tf

from tensorflow_privacy.privacy.optimizers import dp_optimizer

# 加载敏感数据(如用户医疗记录)

(train_data, train_labels), _ = tf.keras.datasets.mnist.load_data()

train_data = train_data / 255.0

# 定义差分隐私优化器(设置隐私参数)

dp_optimizer = dp_optimizer.DPKerasSGDOptimizer(

l2_norm_clip=1.0, # 梯度的最大范数(防止梯度泄露隐私)

noise_multiplier=0.5, # 噪声强度(越大越隐私,越小越准确)

num_microbatches=100, # 微批次数量(拆分数据减少单次计算量)

learning_rate=0.01

)

# 构建模型并训练(使用差分隐私优化器)

model = tf.keras.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

model.compile(

optimizer=dp_optimizer,

loss='sparse_categorical_crossentropy',

metrics=['accuracy']

)

model.fit(train_data, train_labels, epochs=10, batch_size=100)

模型安全:如何让AI"大脑"抗洗脑?

关键技术:对抗训练

对抗训练就像给AI"大脑"做"抗干扰训练"——故意制造一些"捣乱"的输入(对抗样本),让模型学会识别并纠正错误。

对抗样本生成算法(FGSM):

通过计算损失函数对输入的梯度,沿着梯度符号方向添加微小扰动,公式为:

xadv=x+ϵ⋅sign(∇xJ(θ,x,y)) x_{adv} = x + \epsilon \cdot \text{sign}(\nabla_x J(\theta, x, y)) xadv=x+ϵ⋅sign(∇xJ(θ,x,y))

其中 ( x ) 是原始输入,( \epsilon ) 是扰动强度,( J ) 是损失函数。

Python代码示例(用ART库实现对抗训练)

from art.attacks.evasion import FastGradientMethod

from art.estimators.classification import KerasClassifier

import numpy as np

# 加载已训练的模型(假设model是之前训练的普通模型)

classifier = KerasClassifier(model=model, clip_values=(0, 1))

# 生成对抗样本(用FGSM攻击)

attack = FastGradientMethod(estimator=classifier, eps=0.2)

x_train_adv = attack.generate(x=train_data[:1000]) # 生成1000个对抗样本

# 合并原始数据和对抗样本,重新训练模型(对抗训练)

x_train_combined = np.concatenate([train_data[:1000], x_train_adv])

y_train_combined = np.concatenate([train_labels[:1000], train_labels[:1000]])

model.fit(x_train_combined, y_train_combined, epochs=5, batch_size=100)

部署安全:如何给AI"房子"上锁?

关键技术:API访问控制+行为监控

部署阶段的核心是限制"谁能访问模型"和"监控访问行为"。例如:

- 身份认证:要求调用API时必须携带有效Token(类似奶茶店的会员卡号);

- 频率限制:限制单个IP每分钟最多调用10次(防止竞争对手批量调用窃取模型);

- 输入校验:检查输入格式(如只能是0-9的数字,防止注入攻击);

- 日志审计:记录每次调用的输入、输出、时间、IP(出问题时能追溯)。

Python代码示例(用Flask实现安全API)

from flask import Flask, request, jsonify

import time

app = Flask(__name__)

# 模拟模型(实际是加载训练好的模型)

def ai_model_predict(input_data):

# 这里替换为真实的模型预测逻辑

return {"prediction": 0}

# 访问控制:Token白名单

VALID_TOKENS = {"secret_token_123"}

# 频率限制:记录IP的最后访问时间(实际可用Redis)

ip_access_time = {}

@app.route('/predict', methods=['POST'])

def predict():

# 1. 身份认证

token = request.headers.get('Authorization')

if token not in VALID_TOKENS:

return jsonify({"error": "无效Token"}), 401

# 2. 频率限制(每分钟最多10次)

client_ip = request.remote_addr

now = time.time()

if client_ip in ip_access_time:

if now - ip_access_time[client_ip] < 60/10: # 6秒/次

return jsonify({"error": "请求频率过高"}), 429

ip_access_time[client_ip] = now

# 3. 输入校验(假设输入应为长度28x28的数组)

input_data = request.json.get('data')

if not isinstance(input_data, list) or len(input_data)!=28 or len(input_data[0])!=28:

return jsonify({"error": "输入格式错误"}), 400

# 4. 模型预测并记录日志

try:

result = ai_model_predict(input_data)

# 记录日志(实际应写入数据库)

print(f"[INFO] IP:{client_ip} 输入:{input_data[:2]} 输出:{result}")

return jsonify(result)

except Exception as e:

return jsonify({"error": str(e)}), 500

if __name__ == '__main__':

app.run(debug=False) # 生产环境关闭debug模式

数学模型和公式 & 详细讲解 & 举例说明

差分隐私的数学边界

差分隐私通过控制"修改一条数据对输出结果的影响"来保护隐私。例如,假设我们要统计"喜欢奶茶的用户比例",如果原始数据中有1000个用户,其中600人喜欢奶茶,输出是60%;如果删除一个喜欢奶茶的用户(数据变为599/999),输出可能变为59.95%。差分隐私要求这两个输出的概率比值不超过 ( e^\epsilon )(通常取 ( \epsilon=0.1 ) 或更小)。

对抗攻击的数学本质

对抗样本的核心是找到输入 ( x ) 的微小扰动 ( \delta ),使得 ( f(x+\delta) \neq f(x) ),其中 ( f ) 是模型。FGSM通过梯度上升法最大化损失函数,让模型在 ( x+\delta ) 上犯错。例如,在图像分类中,给一张"猫"的图片添加扰动后,模型可能误判为"狗"。

模型窃取的数学原理

模型窃取攻击通过构造输入 ( x_1, x_2, …, x_n ) 并获取输出 ( y_1, y_2, …, y_n ),训练一个替代模型 ( \hat{f} ) 来逼近原模型 ( f )。替代模型的损失函数为:

L(θ)=1n∑i=1nCE(f(xi),f^(xi;θ)) L(\theta) = \frac{1}{n} \sum_{i=1}^n \text{CE}(f(x_i), \hat{f}(x_i; \theta)) L(θ)=n1i=1∑nCE(f(xi),f^(xi;θ))

其中 ( \text{CE} ) 是交叉熵损失。

项目实战:智能推荐系统的安全防护

开发环境搭建

- 操作系统:Ubuntu 20.04

- 编程语言:Python 3.8

- 框架:TensorFlow 2.12(模型训练)、Flask 2.0(API部署)、ART 1.13(对抗训练)

- 数据库:PostgreSQL(存储日志)

源代码详细实现和代码解读

1. 数据采集阶段

使用 pandas 读取用户行为数据,并应用差分隐私脱敏:

import pandas as pd

from diffprivlib.mechanisms import Laplace

# 原始数据(包含用户ID和购买金额)

data = pd.DataFrame({

"user_id": [1, 2, 3, 4, 5],

"amount": [50, 30, 80, 40, 60]

})

# 对"amount"列应用拉普拉斯机制(差分隐私的一种实现)

mechanism = Laplace(epsilon=0.5, sensitivity=10) # 敏感度是金额的最大变化(假设单次消费不超过10元)

data["amount_dp"] = data["amount"].apply(lambda x: mechanism.randomise(x))

print("原始数据:", data[["user_id", "amount"]].to_dict())

print("脱敏后数据:", data[["user_id", "amount_dp"]].to_dict())

输出:

原始数据:{‘user_id’: {0:1, 1:2, 2:3, 3:4, 4:5}, ‘amount’: {0:50, 1:30, 2:80, 3:40, 4:60}}

脱敏后数据:{‘user_id’: …, ‘amount_dp’: {0:52.3, 1:31.1, 2:78.9, 3:41.5, 4:59.2}}(数值被添加了随机噪声)

2. 模型训练阶段

使用对抗训练提升模型鲁棒性:

from art.attacks.evasion import FastGradientMethod

from art.estimators.classification import KerasClassifier

# 加载原始模型(假设已用脱敏数据训练)

model = tf.keras.models.load_model("recommendation_model.h5")

classifier = KerasClassifier(model=model, clip_values=(0, 1))

# 生成对抗样本(针对推荐模型的输入)

attack = FastGradientMethod(estimator=classifier, eps=0.1)

x_train = np.array([[0.8, 0.2, 0.5], [0.3, 0.7, 0.1]]) # 示例输入(用户特征)

x_train_adv = attack.generate(x=x_train)

# 合并原始数据和对抗样本,重新训练

x_combined = np.concatenate([x_train, x_train_adv])

y_combined = np.array([1, 0, 1, 0]) # 原始标签和对抗样本标签相同(因为对抗样本是"捣乱"但标签不变)

model.fit(x_combined, y_combined, epochs=5)

model.save("robust_recommendation_model.h5")

3. 部署阶段

使用Flask实现安全API(如前所述),并添加SQL日志记录:

import psycopg2 # 连接PostgreSQL

# 初始化数据库连接(实际应从配置文件读取)

conn = psycopg2.connect(

dbname="ai_security_log",

user="admin",

password="password",

host="localhost"

)

cursor = conn.cursor()

# 在predict路由中添加日志记录

@app.route('/predict', methods=['POST'])

def predict():

# ...(之前的身份认证、频率限制、输入校验)

try:

result = ai_model_predict(input_data)

# 记录日志到数据库

cursor.execute(

"INSERT INTO api_log (ip, input, output, timestamp) VALUES (%s, %s, %s, %s)",

(client_ip, str(input_data), str(result), time.strftime("%Y-%m-%d %H:%M:%S"))

)

conn.commit()

return jsonify(result)

except Exception as e:

conn.rollback() # 出错时回滚

return jsonify({"error": str(e)}), 500

代码解读与分析

- 数据脱敏:通过差分隐私保护用户消费金额,即使数据泄露,攻击者也无法准确还原个人信息;

- 对抗训练:让模型学会识别"捣乱"的输入,避免被恶意输入误导;

- API安全:通过Token认证、频率限制、输入校验和日志审计,防止模型被非法调用或窃取。

实际应用场景

金融风控:防止恶意贷款欺诈

AI风控模型通过用户历史数据判断是否放贷。安全防护重点:

- 数据安全:用户个人信息(如收入、负债)需脱敏存储;

- 模型安全:防止攻击者伪造"完美还款记录"(数据投毒)导致模型误判;

- 部署安全:限制第三方平台调用频率,防止模型被逆向工程。

智能驾驶:避免传感器数据被攻击

自动驾驶模型依赖摄像头、雷达数据。安全防护重点:

- 数据安全:车联网数据(如位置、速度)需加密传输;

- 模型安全:防止对抗攻击(如在道路标识上贴小贴纸导致模型误判为"限速40");

- 部署安全:车载系统需隔离外部网络,防止远程入侵。

医疗诊断:保护患者隐私与模型准确性

AI诊断模型分析医学影像(如X光片)。安全防护重点:

- 数据安全:患者影像数据需符合HIPAA(美国健康保险流通与责任法案);

- 模型安全:防止数据投毒(如伪造病灶影像)导致模型漏诊;

- 部署安全:限制医生账号的访问权限(如仅允许查看自己患者的诊断结果)。

工具和资源推荐

开源工具

- 数据隐私:TensorFlow Privacy(Google)、Diffprivlib(IBM)

- 模型安全:Adversarial Robustness Toolbox(ART,IBM)、CleverHans(Google)

- 部署安全:OWASP ZAP(漏洞扫描)、Vault(密钥管理)

合规框架

- 国内:《生成式AI服务管理暂行办法》《数据安全法》

- 国际:GDPR(欧盟)、HIPAA(美国医疗)

学习资源

- 书籍:《AI安全与隐私》(O’Reilly)、《对抗机器学习》(机械工业出版社)

- 论文:《Explaining and Harnessing Adversarial Examples》(Goodfellow等,对抗样本经典论文)

- 平台:AI安全竞赛(如Kaggle的对抗攻击挑战赛)

未来发展趋势与挑战

趋势一:AI驱动的安全防护

未来可能出现"安全AI"——用另一个AI模型自动检测对抗样本、识别数据投毒,甚至动态调整模型参数增强安全性。例如,Google的"AutoML Security"项目已实现自动生成防护策略。

趋势二:隐私计算与AI的深度融合

联邦学习(在不传输原始数据的情况下联合训练模型)、安全多方计算(多个机构协作计算时不泄露各自数据)将成为主流,解决"数据可用不可见"的问题。

趋势三:物理世界对抗攻击的防护

当前对抗攻击多针对数字数据(如图像像素),未来可能出现针对物理世界的攻击(如在交通信号灯上贴特定图案,导致自动驾驶模型误判)。防护需要结合传感器校准、多模态验证(如同时用摄像头和激光雷达)等技术。

挑战

- 性能与安全的平衡:增强安全防护(如添加噪声、对抗训练)可能降低模型准确性,需要找到"最优平衡点";

- 未知攻击的检测:传统防护方法依赖已知攻击模式,如何检测未知的新型攻击(如零日对抗样本)仍是难题;

- 合规成本:不同国家/行业的安全合规要求(如GDPR、HIPAA)增加了开发和维护成本。

总结:学到了什么?

核心概念回顾

- 数据安全:通过差分隐私等技术保护原始数据隐私,防止泄露或投毒;

- 模型安全:通过对抗训练等方法增强模型抗攻击能力,防止被"洗脑"或窃取;

- 部署安全:通过访问控制、日志审计等措施保护模型运行环境,防止非法调用。

概念关系回顾

数据安全是基础(没有干净的数据,模型再强也会出错),模型安全是核心(模型被攻击会直接导致功能失效),部署安全是保障(防止前两阶段的努力被绕过)。三者共同构成AI原生应用的"安全三角"。

思考题:动动小脑筋

-

如果你是智能医疗APP的开发者,患者的病历数据需要脱敏存储,但模型训练又需要这些数据的"真实规律",你会如何平衡隐私保护和模型效果?(提示:可以查差分隐私的"隐私-效用"权衡参数)

-

假设你的AI模型被部署为API,如何检测是否有人在窃取模型(即通过大量调用API训练替代模型)?(提示:可以分析调用模式——正常用户的输入可能集中在某些分布,而模型窃取者可能尝试覆盖所有可能的输入)

-

对抗训练需要生成对抗样本,但生成过程本身可能消耗大量计算资源(尤其是大模型),你能想到哪些优化方法?(提示:可以尝试"动态对抗训练"——只在部分批次中添加对抗样本)

附录:常见问题与解答

Q:数据脱敏后模型效果下降怎么办?

A:可以调整差分隐私的 ( \epsilon ) 参数(增大 ( \epsilon ) 会降低隐私保护但提升模型效果),或使用"局部脱敏"——对敏感字段(如用户ID)严格脱敏,对非敏感字段(如商品类别)轻度脱敏。

Q:如何检测未知的对抗样本?

A:可以使用"异常检测"技术(如孤立森林、自编码器),训练一个模型学习正常输入的分布,对抗样本因偏离正常分布会被识别为异常。

Q:模型窃取攻击无法完全阻止,如何降低损失?

A:可以设计"水印模型"——在训练时添加特定模式(如对某些输入输出固定偏移),如果发现替代模型也存在相同模式,即可证明模型被窃取,用于法律追责。

扩展阅读 & 参考资料

- 《AI安全实战手册》(O’Reilly Media)

- 论文:《Differential Privacy: A Survey of Results》(Cynthia Dwork)

- 官方文档:TensorFlow Privacy(https://www.tensorflow.org/privacy)

- 行业报告:《2023年AI安全趋势白皮书》(中国信息通信研究院)

更多推荐

已为社区贡献104条内容

已为社区贡献104条内容

所有评论(0)