CANN算子库深度解析:AIGC时代的异构计算加速引擎

摘要:华为CANN神经网络异构计算架构为AIGC技术提供算力支撑,其开源算子库ops-nn(https://atomgit.com/cann/ops-nn)包含1000+优化算子。CANN架构包含运行时引擎、编译器工具链和算子库三大模块,支持自定义TBE和AI CPU算子开发。以注意力机制和卷积算子为例,通过数据分块、流水线并行等技术实现高效计算,为AIGC模型提供基础算力保障。(149字)

cann组织链接:https://atomgit.com/cann

ops-nn仓库链接:https://atomgit.com/cann/ops-nn

1 引言:CANN与AIGC的算力革命

随着AIGC(人工智能生成内容)技术的飞速发展,从文本生成、图像创作到视频编辑,各类生成式模型对底层算力的需求呈指数级增长。在这个背景下,华为CANN(Compute Architecture for Neural Networks)神经网络异构计算架构作为连接上层AI框架与底层昇腾芯片的桥梁,通过全面开源开放,为开发者提供了前所未有的算力开发与优化空间。

CANN的核心优势在于其多层次编程接口和丰富的算子库,其中ops-nn仓库(https://atomgit.com/cann/ops-nn)汇集了大量神经网络相关的基础算子实现,为AIGC模型的高效运行提供了基础支撑。本文将从技术角度深入解析CANN算子库的架构、原理以及在AIGC场景下的实际应用。

2 CANN架构与算子体系

2.1 CANN整体架构概述

CANN作为神经网络异构计算架构,其设计目标是高效处理深度学习训练与推理任务,核心包含三大模块:

运行时引擎负责任务调度、内存管理和设备通信,支持多线程与流水线并行;编译器工具链将深度学习框架模型转换为高性能可执行文件,支持自动算子融合与图优化;算子库则提供了超过1000种高度优化的基础算子,覆盖卷积、矩阵乘法等常见操作,针对不同硬件特性进行指令级优化。

2.2 算子(Operator)的核心概念

算子(Operator) 是神经网络计算的基本单元,对应网络模型中的计算逻辑。例如:

- 卷积层(Convolution Layer)是一个算子

- 全连接层中的权值求和过程是一个算子

- tanh、ReLU等激活函数也是算子

算子具有名称(Name) 和类型(Type) 两个基本属性。名称标识网络中的某个算子,同一网络中算子名称需保持唯一;类型则决定了算子的实现逻辑匹配,同一类型的算子在网络中可能存在多个。

张量(Tensor) 是算子计算数据的容器,包括输入数据与输出数据,其描述符(TensorDesc) 主要包含以下属性:

| 属性 | 说明 | 示例 |

|------|------|------|

| 形状(Shape) | 张量的维度信息 | (4, 20, 20, 3)表示4张20×20像素的3通道图像 |

| 数据类型(Data Type) | 元素的数据类型 | FP16, INT8, FP32等 |

| 数据排布格式(Format) | 多维数据的存储顺序 | NCHW, NHWC等 |

对于特征图(Feature Map)等4D数据,不同框架的排布格式不同: - Caffe:[Batch, Channels, Height, Width] (NCHW)

- TensorFlow:[Batch, Height, Width, Channels] (NHWC)

2.3 自定义算子类型与选择

CANN支持两种自定义算子类型,以满足不同场景需求:

| 特性 | TBE算子 | AI CPU算子 |

|---|---|---|

| 实现复杂度 | 较复杂 | 相对简单 |

| 性能表现 | 优秀 | 一般 |

| 开发调试难度 | 高 | 低 |

| 适用场景 | 性能敏感型任务 | 快速功能验证、算法原型 |

开发建议:开发者可以先实现AI CPU算子快速打通模型执行流程,功能调通后再切换到TBE算子实现以获得更高性能。

3 ops-nn仓库深度剖析

3.1 仓库结构与关键组件

ops-nn是CANN针对神经网络场景的算子仓库,其关键目录结构如下:

ops-nn/

├── cmake/ # 构建配置文件

├── src/ # 算子源码目录

│ ├── common/ # 公共目录

│ ├── math/ # 数学库算子目录

│ └── add_custom/ # AddCustom算子目录

├── CMakeLists.txt # 主构建脚本

├── build.sh # 算子编译脚本

└── README.md # 项目说明文档

仓库提供了基于Ascend C的vector加法算子作为参考样例,展示了完整的算子开发流程。

3.2 算子编译与运行流程

CANN算子的编译和运行流程如下图所示,展示了从模型到算子执行的完整路径:

关键步骤说明:

- Parser解析:将第三方框架模型转换为中间态IR Graph

- GE图引擎:进行图准备、拆分、子图优化等操作

- 算子选择:优先由FE基于TBE算子信息库判断,若不支持则由AI CPU Engine判断

- 任务生成:生成算子的Task信息,最终生成可执行的om模型

- Runtime执行:根据算子的Task类型下发到AI Core或AI CPU上执行

3.3 算子开发流程与交付件

CANN算子开发流程涉及多个关键交付件,以下流程图展示了完整的开发过程:

主要交付件说明:

- 算子原型:算子对外API,定义输入、输出、属性及推导逻辑

- 算子原型实现:实现原型的具体功能

- 算子信息库:注册算子信息,供图引擎调用

- Tiling策略:多核计算的数据切分策略

- Kernel核心:算子在AI Core上的实现代码

4 AIGC核心算子解析与优化实践

4.1 注意力机制算子:Transformer的引擎

注意力机制是Transformer架构的核心,也是AIGC模型(如GPT、Stable Diffusion)的引擎。其数学表达式为:

Attention(Q,K,V)=softmax(Q⋅KTdk)V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{Q \cdot K^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQ⋅KT)V

其中:

- QQQ(Query)、KKK(Key)、VVV(Value)通过线性变换得到

- dkd_kdk是Key向量的维度,用于缩放防止梯度消失

实现与优化

以下是基于Ascend C的简化注意力算子实现思路:

// 注意力算子核心逻辑(简化版)

extern "C" __global__ __aicore__ void attention_kernel(

half* Q, half* K, half* V, half* Output,

int seq_len, int head_dim, int num_heads) {

// 1. 计算QK^T(点积相似度)

// 使用Ascend C的矩阵计算API

// 2. 缩放并应用softmax

// 3. 与V进行加权求和

// 数据分块(Tiling)策略

int tile_size = 128; // 根据硬件特性优化

// 多核并行计算

// 流水线并行:CopyIn -> Compute -> CopyOut

}

优化要点:

- 数据分块(Tiling):将长序列分块处理,适应片上存储容量

- 流水线并行:隐藏数据搬运延迟,提高计算单元利用率

- 混合精度计算:使用FP16进行计算,FP32进行累积,平衡精度和性能

- 内存访问优化:对齐访问、合并读写,减少内存延迟

实践提示:CANN的ops-nn仓库中已经包含了优化良好的注意力算子实现,开发者可以直接调用或作为参考进行二次开发。对于长序列场景,可以结合Ring Attention等分布式注意力策略实现扩展。

4.2 卷积算子:图像生成的基石

卷积是图像生成模型(如Stable Diffusion)的核心算子。其数学表达式为:

Y[i,j]=∑m=0M−1∑n=0N−1X[i+m,j+n]⋅K[m,n] Y[i,j] = \sum_{m=0}^{M-1} \sum_{n=0}^{N-1} X[i+m, j+n] \cdot K[m,n] Y[i,j]=m=0∑M−1n=0∑N−1X[i+m,j+n]⋅K[m,n]

优化策略:

- Winograd算法:减少乘法次数,提高小卷积核效率

- Direct convolution:适合大卷积核场景

- 融合优化:将卷积与激活、池化等算子融合,减少内存访问

4.3 矩阵乘法算子:AIGC的通用计算单元

矩阵乘法(GEMM)是几乎所有AIGC模型的基础计算。CANN提供了高度优化的矩阵乘法算子,开发者也可以通过CATLASS算子模板库进行定制优化。

性能优化关键:

- 分块(Blocking):利用Cache局部性

- 向量化:利用SIMD指令

- 多核并行:充分利用AICore计算资源

CANN通过以下技术实现低延迟与高吞吐:

- 内存零拷贝:减少主机与设备间的数据传输开销,直接共享内存地址空间

- 动态形状支持:自动适应可变输入尺寸(如可变分辨率图像),避免重复编译计算图

- 混合精度计算:结合FP16与INT8量化,在保持模型精度的同时提升计算速度

典型场景下,ResNet50的推理性能可达每秒数千张图像,时延控制在毫秒级。

5 实战:基于Ascend C的自定义算子开发

下面通过一个简单的Add算子实例,展示基于Ascend C的算子开发流程。

5.1 算子分析

数学表达式:

z⃗=x⃗+y⃗ \vec{z} = \vec{x} + \vec{y} z=x+y

计算逻辑:

- 将输入数据从Global Memory搬入到Local Memory

- 使用Vector计算API完成加法运算

- 将结果从Local Memory搬出到Global Memory

输入输出规格:

- 数据类型:half (FP16)

- 数据形状:固定(8, 2048)

- 数据排布:ND (Natural Dimension)

5.2 核函数定义与实现

#include "kernel_operator.h"

// 常量定义

constexpr int32_t TOTAL_LENGTH = 8 * 2048; // 总数据长度

constexpr int32_t USE_CORE_NUM = 8; // 使用的核数

constexpr int32_t BLOCK_LENGTH = TOTAL_LENGTH / USE_CORE_NUM; // 每核处理长度

constexpr int32_t TILE_NUM = 8; // 每核数据块数

constexpr int32_t BUFFER_NUM = 2; // 双缓冲数量

constexpr int32_t TILE_LENGTH = BLOCK_LENGTH / TILE_NUM; // 每块长度

extern "C" __global__ __aicore__ void add_custom(

__gm__ half* x, __gm__ half* y, __gm__ half* z) {

// 1. 初始化

// 获取当前核的ID

int32_t block_idx = GetBlockIdx();

// 计算当前核处理的Global Memory偏移

half* xGm = x + block_idx * BLOCK_LENGTH;

half* yGm = y + block_idx * BLOCK_LENGTH;

half* zGm = z + block_idx * BLOCK_LENGTH;

// 2. 定义Pipe内存管理对象

TPipe pipe;

// 初始化VECIN队列(输入数据队列)

TQue<QuePosition::VECIN, BUFFER_NUM> inQueueX, inQueueY;

// 初始化VECOUT队列(输出数据队列)

TQue<QuePosition::VECOUT, BUFFER_NUM> outQueueZ;

// 为队列分配内存

pipe.InitBuffer(inQueueX, BUFFER_NUM, TILE_LENGTH * sizeof(half));

pipe.InitBuffer(inQueueY, BUFFER_NUM, TILE_LENGTH * sizeof(half));

pipe.InitBuffer(outQueueZ, BUFFER_NUM, TILE_LENGTH * sizeof(half));

// 3. 流水线并行:CopyIn, Compute, CopyOut

// 双缓冲技术:隐藏数据搬运延迟

for (int32_t i = 0; i < TILE_NUM; i++) {

// 3.1 CopyIn任务:将数据从Global Memory搬运到Local Memory

LocalTensor<half> xLocal = inQueueX.AllocTensor<half>();

LocalTensor<half> yLocal = inQueueY.AllocTensor<half>();

DataCopy(xLocal, xGm + i * TILE_LENGTH, TILE_LENGTH);

DataCopy(yLocal, yGm + i * TILE_LENGTH, TILE_LENGTH);

inQueueX.EnQue(xLocal);

inQueueY.EnQue(yLocal);

// 3.2 Compute任务:执行加法运算

LocalTensor<half> zLocal = outQueueZ.AllocTensor<half>();

inQueueX.DeQue(xLocal);

inQueueY.DeQue(yLocal);

Add(zLocal, xLocal, yLocal, TILE_LENGTH);

outQueueZ.EnQue(zLocal);

// 3.3 CopyOut任务:将结果搬运回Global Memory

outQueueZ.DeQue(zLocal);

DataCopy(zGm + i * TILE_LENGTH, zLocal, TILE_LENGTH);

outQueueZ.FreeTensor(zLocal);

}

}

5.3 算子编译与调用

编译脚本示例:

# build.sh

python3 ${ATC_HOME}/python/site-packages/taikang/taikang.py \

--mode=0 \

--soc_version=Ascend910B \

--input_format=ND \

--input_dtype="FP16,FP16" \

--output_dtype=FP16 \

--input_shape="(8,2048),(8,2048)" \

--output_shape="(8,2048)" \

--kernel_name=add_custom \

--op_add_custom=add_custom.cpp

应用程序调用:

// main.cpp

#include "acl/acl.h"

#include "tensor.h"

int main() {

// 初始化ACL环境

aclInit(nullptr);

int32_t deviceId = 0;

aclrtSetDevice(deviceId);

// 创建数据描述

aclTensorDesc* inputDesc1 = aclCreateTensorDesc(ACL_FLOAT16, 2, (int64_t[]){8,2048}, ACL_FORMAT_ND);

aclTensorDesc* inputDesc2 = aclCreateTensorDesc(ACL_FLOAT16, 2, (int64_t[]){8,2048}, ACL_FORMAT_ND);

aclTensorDesc* outputDesc = aclCreateTensorDesc(ACL_FLOAT16, 2, (int64_t[]){8,2048}, ACL_FORMAT_ND);

// 创建数据缓冲区

void* inputBuffer1 = nullptr;

void* inputBuffer2 = nullptr;

void* outputBuffer = nullptr;

aclrtMalloc(&inputBuffer1, 8*2048*sizeof(half), ACL_MEM_MALLOC_HUGE_FIRST);

aclrtMalloc(&inputBuffer2, 8*2048*sizeof(half), ACL_MEM_MALLOC_HUGE_FIRST);

aclrtMalloc(&outputBuffer, 8*2048*sizeof(half), ACL_MEM_MALLOC_HUGE_FIRST);

// 准备输入数据(实际应用中应从文件或其他来源加载)

// ... 数据准备代码 ...

// 创建算子描述

aclopAttr* opAttr = aclopCreateAttr();

// 创建算子

aclopCompileAndExecute("add_custom", 2, (aclTensorDesc*[]){inputDesc1, inputDesc2},

(void*[]){inputBuffer1, inputBuffer2},

outputDesc, outputBuffer, opAttr, ACL_ENGINE_AICORE, ACL_COMPILE_SYS, nullptr);

// 等待计算完成

aclrtSynchronizeStream(stream);

// 读取结果

// ... 结果处理代码 ...

// 释放资源

aclrtFree(inputBuffer1);

aclrtFree(inputBuffer2);

aclrtFree(outputBuffer);

aclDestroyTensorDesc(inputDesc1);

aclDestroyTensorDesc(inputDesc2);

aclDestroyTensorDesc(outputDesc);

aclopDestroyAttr(opAttr);

aclFinalize();

return 0;

}

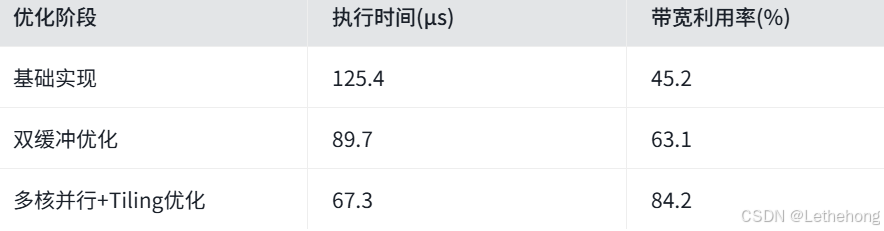

5.4 性能测试与优化

测试环境:

- 硬件:Atlas 300T 训练卡 (Ascend 910B)

- 数据规模:8x2048 FP16张量

- 线程配置:8核并行

性能指标:

优化要点总结:

- 数据分块(Tiling):将大块数据拆分为适合片上存储的小块

- 双缓冲技术:隐藏数据搬运延迟,提高流水线效率

- 多核并行:充分利用AICore的多核计算能力

- 内存访问优化:对齐访问、合并读写,减少内存延迟

6 CANN在AIGC场景的应用案例

6.1 Stable Diffusion优化实践

基于CANN的ops-nn算子库,Stable Diffusion模型在昇腾硬件上实现了显著加速:

- UNet优化:通过算子融合和流水线并行,提升采样速度30%

- VAE优化:优化编解码算子,减少图像生成延迟

- 内存优化:采用动态内存分配和共享内存技术,降低显存占用

6.2 大语言模型推理优化

对于Llama、DeepSeek等大语言模型,CANN提供了以下优化方案:

- 长序列优化:结合Ring Attention和Ulysses序列并行,处理超长文本

- 算子融合:将注意力、FFN等算子融合,减少内存访问

- 量化支持:支持INT8量化,在保持精度的同时提升吞吐量

性能提升对比(Llama-3-8B推理,单卡Atlas 300T):

6.3 多模态模型部署

对于多模态AIGC模型(如图文生成、视频生成),CANN提供了多流并行和算子动态调度方案,实现多模态数据的实时处理。

7 CANN生态与未来展望

7.1 开源开放与社区共建

华为宣布CANN全面开源开放,为开发者提供了三层级的参与方式:

贡献指南:

- 参与社区会议、邮件讨论

- 提交Issue、处理Issue任务

- 提交PR(遵循CLA协议和贡献指南)

7.2 多元化开发路径

CANN为不同技术背景的开发者提供了三条算子开发路径:

| 开发路径 | 目标用户 | 语言风格 | 性能优势 | 适用场景 |

|---|---|---|---|---|

| Triton接入 | GPU开发者 | Python | 优秀 | 快速原型、算法验证 |

| Ascend C | 系统程序员 | C/C++ | 极致 | 高性能算子、模型优化 |

| CATLASS模板库 | 应用开发者 | 配置化 | 高效 | 矩阵运算、通用算子 |

7.3 未来技术演进

CANN未来将在以下方向持续演进:

- AI原生优化:利用AI技术自动优化算子性能(类似CUDA-L2的自动优化方法)

- 异构协同计算:支持CPU/GPU/NPU异构协同,提升整体算力利用

- 算子自动生成:基于模型结构和硬件特性自动生成最优算子实现

- 动态算子库:支持运行时算子动态加载和替换,提升灵活性

8 总结与行动建议

本文深入解析了CANN算子库的架构、原理以及在AIGC场景下的应用实践。通过ops-nn仓库提供的丰富算子资源,开发者可以:

- 直接调用:使用已有高性能算子,加速AIGC模型开发和部署

- 二次开发:基于参考算子进行定制优化,满足特定场景需求

- 从零开发:使用Ascend C开发自定义算子,实现极致性能

行动建议:

- 对于初学者:从Add、MatMul等简单算子入手,理解Ascend C编程范式和流水线并行思想

- 对于算法开发者:关注注意力、卷积等核心算子的优化,结合模型特性进行定制开发

- 对于系统开发者:深入研究Tiling策略、内存优化和多核并行,榨干硬件性能

💡 进一步学习资源:

- CANN官方文档:https://www.hiascend.com/document

- ops-nn仓库:https://atomgit.com/cann/ops-nn

- Ascend C编程指南:https://www.hiascend.com/document

- CANN训练营:https://bbs.huaweicloud.com/blogs/413097

随着CANN开源开放的持续推进,一个开放、高效、多元的AI算力生态正在形成。在这个生态中,开发者不再仅仅是算力的使用者,更成为算力的定义者和优化者。通过掌握CANN算子开发技术,开发者可以在AIGC时代释放更大的创造力和价值。

更多推荐

已为社区贡献27条内容

已为社区贡献27条内容

所有评论(0)