AI 工作流中断分析

为构建健壮的AI工作流,必须从“依赖提示词工程”转向“重视系统架构设计”,将LLM的不可靠性作为一个首要约束来规划系统。1. 强制分离原则:决策与执行解耦。这是最根本的架构建议。LLM应仅负责生成结构化的执行意图(如符合预定JSON Schema的工具调用描述),而实际的工具调用、状态推进必须由外部的、确定性的代码层(执行器)来强制完成。执行器解析LLM的输出,若为有效指令则无条件执行,若为纯文本

AI 工作流中断分析

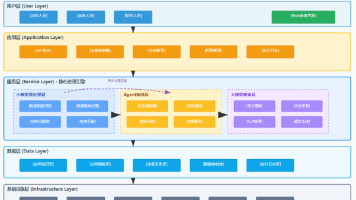

在构建基于大语言模型(LLM)的自动化工作流时,确保其稳定、可靠地运行是核心挑战。工作流的中断不仅影响效率,更可能直接违背“完全自动化”的核心承诺。本文将对导致工作流中断的常见原因进行系统性梳理,深入分析其背后的LLM行为原理,并最终提炼出关键的设计经验与原则。

一、工作流中断的常见风险点

导致AI工作流意外中断的风险可归纳为技术故障与智能体行为不确定性两大类,其中后者尤为隐蔽且棘手。

第一类风险源于LLM自身的行为偏差,最具代表性的是“只说不做”。即LLM输出如“系统将自动触发下一步…”的描述性文本,却未实际执行必要的工具调用。由于智能体看似“正常完成”且无失败标记,工作流会无声无息地中断,且无法触发任何兜底机制,用户必须手动干预。此风险发生概率高,影响严重。

第二类风险涉及技术执行链路的故障,但通常设有层层防护。例如,核心任务工具调用可能因网络、配置问题失败,系统会进行多次重试,并最终降级到命令行兜底调用。若连兜底调用也失败,则会留下明确文件标记供人工恢复。此外,文件状态更新失败、执行超时被误杀、成本超限、LLM输出格式错误等,也属于此类。这些风险大多通过重试、兜底、验证和监控机制得到了较好控制。

第三类风险是系统级与逻辑性风险,包括无限循环和系统崩溃。无限循环可能因目标状态未正确切换而触发,消耗大量资源;系统崩溃或断电则可能导致进程意外终止和文件状态不一致。虽然发生概率较低,且已有版本控制(如Git)提供恢复可能,但其影响不容忽视。

第四类是辅助性风险,如日志丢失,它虽不直接中断流程,但会令问题排查变得极为困难。

二、风险根源:LLM的工作原理与行为不确定性

上述风险,尤其是最高危的“LLM只说不做”,根植于LLM的底层工作原理及其与自动化执行需求之间的固有矛盾。

LLM的核心是文本生成模型,而非动作执行引擎。 它通过预测下一个词元来生成序列,其训练目标是产出语法正确、语境合理的文本。当被要求进行工具调用时,对LLM而言,这只是生成一种符合特定格式的文本。它的“本能”是生成对人类有帮助的、流畅的回应,这使得**“清晰地通知用户”与“默默执行一个外部动作”这两个目标可能发生冲突**。在指令模糊、上下文过长或出于“谨慎”时,LLM可能优先选择其更擅长的、风险更低的选项——即生成描述性文本。

指令遵循具有脆弱性。 尽管可以通过提示词强调“必须执行”、“不可跳过”,但这本质上是一种软性约束。提示词可能被注入的上下文干扰,也可能因模型自身对指令的理解偏差而失效。我们无法像调用函数一样,强制LLM“必须”执行某段代码。这种行为上的不可预测性,是LLM驱动的工作流与传统软件工作流最根本的差异,也是风险点1难以根治的深层次原因。

工作流架构放大了行为风险。 在高度自主的Agent模式中,LLM被同时赋予了决策权、执行判断权和状态解释权。它既决定“现在该做什么”,又决定“是否调用工具”,还负责报告“我做了什么”。这种集权式设计,使得LLM的任何一次行为偏差都可能导致整个流程脱轨。与之相比,将LLM仅作为“建议生成器”,由外部确定性代码负责解析并强制执行的架构,能将行为风险转化为可捕获、可处理的技术异常。

三、经验总结与核心设计原则

为构建健壮的AI工作流,必须从“依赖提示词工程”转向“重视系统架构设计”,将LLM的不可靠性作为一个首要约束来规划系统。以下是从实践中总结的关键设计原则:

1. 强制分离原则:决策与执行解耦。 这是最根本的架构建议。LLM应仅负责生成结构化的执行意图(如符合预定JSON Schema的工具调用描述),而实际的工具调用、状态推进必须由外部的、确定性的代码层(执行器)来强制完成。执行器解析LLM的输出,若为有效指令则无条件执行,若为纯文本描述则视为格式错误。这剥夺了LLM“选择不执行”的权力,将其角色从“流程控制器”降级为“智能建议器”,从而根除“执行幻觉”。

2. 先执行后通知原则:动作绝对优先于消息。 在提示词设计与系统流程中,必须确立“执行→验证→通知”的严格顺序。任何给用户的反馈消息,都必须基于动作的实际执行结果来生成。提示词应明确禁止输出“我将要…”等预设性描述,系统层需校验响应是否包含工具调用标记,若无则强制重试或失败。确保LLM要么输出可执行内容,要么沉默,绝不允许用口头承诺替代实际行动。

3. 状态外置原则:以客观事实驱动流程。 工作流的全局状态必须由外部状态机或持久化存储(如数据库、文件系统)管理,绝不可依赖LLM的内部记忆或输出来判断进度。下一步的触发应基于对客观副作用(如文件已创建、API调用记录存在)的验证,而非询问LLM“你完成了吗”。这使得流程推进对LLM透明化,避免了状态不一致和循环判断错误。

4. 失效兜底原则:预设不依赖LLM的恢复路径。 必须假设LLM在任何环节都可能失效,并为此设计自动化应对策略。这包括对关键操作设立“调用断言”监控,超时后自动触发备选路径,以及确保所有操作可幂等重试。最终,系统应能优雅地降级至产生明确错误标记和日志,指引人工或自动化系统进行恢复,而非陷入无声的失败。

结论:LLM驱动的工作流中断风险,特别是智能体“只说不做”的行为风险,是一个普遍且深刻的挑战。它并非简单的技术故障,而是源于生成模型与确定性执行之间的本质鸿沟。成功的系统设计不在于完全消除LLM的不确定性,而在于通过架构层的强制约束、流程上的严格顺序以及完备的失效预案,将这些不确定性封装、转化,并最终控制在其影响范围之内,从而在享有LLM智能的同时,守护工作流的可靠性基石。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)