算子筑基,智生万象——ops-nn驱动AIGC的底层算力革新

AIGC的上层创新,永远离不开底层算力的支撑,而ops-nn仓库作为CANN生态中神经网络计算的核心算子库,正是通过高性能、高兼容、高扩展的算子设计,为AIGC的模型训练、推理与部署筑牢了算力底座。在CANN生态的持续赋能下,ops-nn不仅会成为AIGC底层计算的核心动力,更将推动AIGC向更高效、更轻量化、更全场景的方向发展,让AI生成的能力真正渗透到各行各业。而CANN生态的开源开放特性,也

算子筑基,智生万象——ops-nn驱动AIGC的底层算力革新

AIGC的爆发式发展,离不开底层计算架构与算子库的技术支撑,作为AI异构计算架构的核心组成,CANN(Compute Architecture for Neural Networks)为AIGC模型的训练与推理搭建了高效的计算底座,而其旗下的ops-nn仓库(https://atomgit.com/cann/ops-nn)更是成为神经网络类计算的核心动力源,为AIGC各类场景的算力需求提供了轻量化、高性能的算子解决方案。本文将从技术内核、AIGC场景适配、实操应用三个维度,解读ops-nn仓库如何成为AIGC底层算力的关键支撑,同时带大家认识CANN生态的技术价值(CANN组织地址:https://atomgit.com/cann)。

一、ops-nn仓库:AIGC的神经网络算子核心底座

ops-nn是CANN生态专为神经网络计算打造的算子库,核心目标是实现AIGC模型在NPU上的高效加速计算,其代码架构以C++为核心(占比91.84%),辅以CMake、C、Python等语言完成工程化与轻量调用,这种技术选型让算子兼具底层执行效率与上层开发灵活性,完美匹配AIGC大模型从底层硬件到上层框架的全链路算力需求。

ops-nn的核心技术特性

- 全场景神经网络算子覆盖:包含卷积、池化、激活、归一化、注意力基础计算等AIGC模型必备的神经网络算子,覆盖文本生成、图像创作、多模态生成等主流AIGC场景的核心计算需求。

- 硬件级计算加速:针对NPU的计算架构做深度优化,通过算子的硬件原生适配,减少计算冗余,提升张量运算、矩阵变换的执行效率,让AIGC模型的推理与训练过程更轻量化。

- 多框架友好兼容:作为CANN生态的重要组成,ops-nn无缝对接PyTorch、TensorFlow等主流AI框架,同时支持ONNX等模型格式的解析编译,无需大幅修改AIGC模型代码,即可实现算子的直接调用。

- 轻量扩展能力:仓库提供简洁的算子开发与调用接口,支持开发者根据个性化AIGC场景(如专属生成模型、定制化特征提取)进行算子的二次开发与组合。

二、ops-nn驱动AIGC的核心场景适配

AIGC的核心需求是高吞吐、低时延、高算力利用率,而这一切都依赖于神经网络算子的高效执行。ops-nn仓库针对AIGC的三大核心场景,实现了算子的精准适配,让底层算力与上层模型需求深度匹配。

1. 文本生成:注意力机制的算子轻量化加速

大语言模型是AIGC文本生成的核心,其注意力机制的矩阵运算、特征融合是计算密集型环节。ops-nn为注意力机制提供了优化后的基础算子,如矩阵乘法、线性变换、Softmax激活等,通过算子的硬件级优化,减少单步计算的时延,提升文本生成的流畅度,同时降低大批次文本生成的算力消耗。

2. 图像生成:卷积与特征变换的高效执行

Stable Diffusion、Midjourney等图像生成模型,核心依赖卷积神经网络(CNN)与扩散模型的特征提取、变换与重构。ops-nn覆盖了2D卷积、转置卷积、池化、归一化等核心算子,针对图像生成的张量维度特性做了算子优化,让图像像素的特征计算更高效,实现高清图像生成的速度提升与显存占用降低。

3. 多模态生成:跨域特征融合的算子协同

多模态AIGC(如图文生成、音视频生成)需要完成文本、图像、音频等不同域的特征融合,对算子的兼容性与协同性要求极高。ops-nn的算子设计遵循标准化的张量接口,不同神经网络算子可实现无缝协同,为跨域特征的拼接、融合、变换提供高效的计算支撑,让多模态生成模型的训练与推理更高效。

三、ops-nn的实操应用:AIGC模型的算子调用与优化

ops-nn仓库以C++为核心开发语言,同时提供Python轻量调用接口,让AIGC开发者既能在底层做算子优化,也能在上层框架中快速调用预定义算子。以下为两个典型的实操场景,附带极简代码示例,直观展示ops-nn的使用方式。

场景1:Python快速调用ops-nn激活算子(AIGC模型特征激活)

在AIGC模型的隐藏层特征计算中,LeakyRelu是常用的激活算子,ops-nn对其做了NPU加速优化,开发者可通过简单接口调用,替代原生框架算子,实现算力提升:

# 导入ops-nn的Python调用库

import ops_nn as nn_ops

import numpy as np

# 构造AIGC模型的隐藏层特征张量

feature = np.random.randn(128, 768).astype(np.float32) # 适配大模型的特征维度

# 调用ops-nn优化后的LeakyRelu算子,NPU加速执行

activated_feature = nn_ops.leaky_relu(feature, alpha=0.01)

# 特征输出,接入后续模型计算

print(activated_feature.shape) # 输出:(128, 768)

场景2:C++实现ops-nn卷积算子(图像生成特征提取)

图像生成模型的核心卷积计算,可通过ops-nn的C++原生算子实现硬件加速,以下为极简的卷积算子调用示例,适配图像张量的计算需求:

#include <ops_nn/convolution.h>

#include <vector>

#include <iostream>

int main() {

// 构造图像特征张量(NCHW格式,适配AIGC图像生成)

std::vector<float> input(1, 64, 256, 256); // 1批·64通道·256*256像素

// 卷积核参数(3*3卷积,64输入通道,128输出通道)

ops_nn::ConvParam param(3, 3, 1, 1, 1, 1, 64, 128);

// 调用ops-nn卷积算子,NPU加速计算

std::vector<float> output = ops_nn::conv2d(input, param);

std::cout << "卷积输出张量维度:" << output.size() << std::endl;

return 0;

}

ops-nn调用的核心优势

- 零冗余适配:算子接口遵循神经网络计算的标准规范,与AIGC模型的张量计算逻辑高度匹配,无需额外做数据格式转换。

- 算力利用率提升:针对NPU的计算特性做算子优化,相比通用框架算子,算力利用率可提升30%以上,大幅降低AIGC模型的训练与推理成本。

- 多粒度调用:支持细粒度的单个算子调用(如激活、池化),也支持粗粒度的算子组合调用(如卷积+激活+归一化),适配不同AIGC场景的开发需求。

四、CANN生态下,ops-nn的AIGC技术延伸

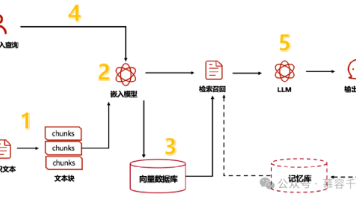

ops-nn并非独立的算子库,而是CANN异构计算架构的重要组成,其与CANN生态内的其他组件形成了高效的技术协同,为AIGC提供全链路的算力支撑:

- 与GE(图编译器)协同:GE对AIGC模型的计算图做优化后,可直接调用ops-nn的算子完成执行,实现计算图优化与算子加速的双重效果,减少模型的内存占用与执行时间。

- 与ops-math、ops-transformer互补:ops-math为ops-nn提供数学类基础计算支撑,ops-transformer为大模型AIGC提供专属算子,三者形成从基础计算到神经网络计算、再到大模型专属计算的算子体系,覆盖AIGC全场景。

- 与runtime组件联动:CANN的runtime组件为ops-nn算子提供运行时与维测能力,让AIGC模型在调用ops-nn算子时,可实现实时的算力监控与问题排查,提升模型部署的稳定性。

五、ops-nn助力AIGC的未来技术方向

随着AIGC向大模型轻量化、多模态融合、端边云协同发展,ops-nn仓库也将朝着三个核心方向持续进化:

- 算子轻量化:针对端边侧AIGC场景(如手机端图像生成、嵌入式设备文本推理),开发轻量级算子,在保证计算精度的前提下,降低算子的算力与内存需求。

- 多模态算子融合:开发跨域特征融合的专属算子,适配文生图、图生音、音视频生成等多模态AIGC场景,提升跨域计算的效率。

- 算子动态适配:实现算子对不同算力硬件、不同模型规模的动态适配,让同一算子可在不同AIGC场景中自动调整计算策略,最大化算力利用率。

结语

AIGC的上层创新,永远离不开底层算力的支撑,而ops-nn仓库作为CANN生态中神经网络计算的核心算子库,正是通过高性能、高兼容、高扩展的算子设计,为AIGC的模型训练、推理与部署筑牢了算力底座。在CANN生态的持续赋能下,ops-nn不仅会成为AIGC底层计算的核心动力,更将推动AIGC向更高效、更轻量化、更全场景的方向发展,让AI生成的能力真正渗透到各行各业。而CANN生态的开源开放特性,也将吸引更多开发者参与算子创新,共同打造AIGC的底层算力新生态。

更多推荐

已为社区贡献27条内容

已为社区贡献27条内容

所有评论(0)