从单点优化到系统协同:cann/ops-nn 中的算子融合工程

它不再孤立地看待每个算子,而是将其视为可拼接、可重组、可压缩的计算单元,从而在系统层面释放更大性能红利。在这张网络中,每一个算子都不是孤岛,而是可组合、可压缩、可协同的活力节点。在AI系统性能优化的演进史上,存在一个经典的“漏斗效应”:开发者最初聚焦于单个算子的极致加速——让卷积更快、矩阵乘更高效。它告诉我们:在AI基础设施的深水区,真正的突破不再来自单点极致优化,而源于对。上:频繁的Kernel

从单点优化到系统协同:cann/ops-nn 中的算子融合工程

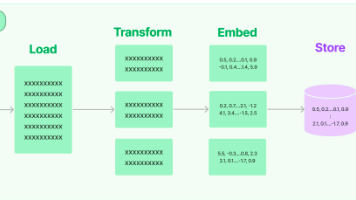

在AI系统性能优化的演进史上,存在一个经典的“漏斗效应”:开发者最初聚焦于单个算子的极致加速——让卷积更快、矩阵乘更高效。然而,当单点性能逼近理论极限后,真正的瓶颈往往转移到算子之间的衔接成本上:频繁的Kernel Launch、冗余的内存读写、中间张量的显式存储,这些“胶水开销”可能吞噬掉90%的潜在收益。

面对这一挑战,开源项目 cann/ops-nn 将优化视角从“单个算子”升维至“算子组合”,通过一套精密的融合(Fusion)工程体系,实现端到端计算图的协同优化。它不再孤立地看待每个算子,而是将其视为可拼接、可重组、可压缩的计算单元,从而在系统层面释放更大性能红利。本文将深入解析其融合机制的设计原理与实现细节。

一、 融合的本质:消除“胶水开销”

典型的AI模型由数十甚至数百个算子串联而成。以LayerNorm + GeLU为例:

# 原始计算图(未融合)

x1 = layer_norm(x) # Kernel 1: 读x → 写x1

x2 = gelu(x1) # Kernel 2: 读x1 → 写x2

这里,x1 作为中间张量,必须写入全局内存再被下一次Kernel读取,造成两次不必要的IO。若能将两个算子融合为一个Kernel:

# 融合后(理想状态)

x2 = fused_layer_norm_gelu(x) # Kernel: 读x → 直接写x2,x1仅存在于寄存器

即可消除中间存储、减少Kernel Launch次数、提升数据局部性。这正是融合的核心价值。

二、 可融合性契约:算子如何声明“我愿意被融合”

并非所有算子都能安全融合。cann/ops-nn 引入可融合性契约(Fusibility Contract),让每个算子显式声明其融合能力与约束。

1. 前端注册时标注融合属性

// ops-nn/frontend/ops/layer_norm.cc

static ge::OperatorCreatorRegister g_reg("LayerNorm", []() {

ge::OperatorCreator creator;

// ... 输入输出定义

// 关键:声明融合能力

creator.AddAttr("_fusion_eligible", ge::AttrValue::CreateFrom(true));

creator.AddAttr("_fusion_patterns",

ge::AttrValue::CreateFrom(std::vector<std::string>{"ElementWise"}));

return creator;

});

_fusion_eligible=true:表示该算子可参与融合;_fusion_patterns={"ElementWise"}:表示它可与逐元素操作(如GELU、Add、Mul)融合。

2. 调度脚本支持融合上下文

后端实现需能处理融合后的复合计算:

# ops-nn/tbe/normalization/fused_layer_norm_gelu.py

def fused_layer_norm_gelu_compute(x, gamma, beta):

# Step 1: LayerNorm

mean = reduce_mean(x, axis=-1, keepdims=True)

var = reduce_mean((x - mean)**2, axis=-1, keepdims=True)

normalized = (x - mean) / sqrt(var + eps)

y_ln = normalized * gamma + beta

# Step 2: GELU (直接接续,无中间存储)

y_gelu = y_ln * 0.5 * (1.0 + tanh(sqrt(2.0 / pi) * (y_ln + 0.044715 * y_ln**3)))

return y_gelu # 仅此一个输出

整个计算流在单个Kernel内完成,中间结果 y_ln 仅存在于片上缓存或寄存器中。

三、 图级融合引擎:自动发现并合成融合模式

cann/ops-nn 提供一个模式匹配驱动的图优化器,在编译期自动识别并应用融合规则。

1. 融合规则定义(YAML格式)

# ops-nn/fusion_rules/layer_norm_gelu.yaml

pattern:

root: "LayerNorm"

consumers:

- op: "GELU"

input_index: 0 # GELU的第一个输入来自LayerNorm输出

action:

replace_with: "FusedLayerNormGELU"

map_attrs:

LayerNorm.gamma -> FusedLayerNormGELU.gamma

LayerNorm.beta -> FusedLayerNormGELU.beta

2. 图优化器执行流程

# ops-nn/graph_optimizer/fusion_engine.py

def apply_fusion_rules(graph):

for rule in load_fusion_rules():

matches = graph.pattern_match(rule.pattern)

for match in matches:

# 验证所有算子均标记为可融合

if all(op.attrs.get("_fusion_eligible") for op in match.ops):

fused_op = instantiate(rule.replace_with, match.attrs)

graph.replace_subgraph(match.ops, fused_op)

return graph

该引擎支持多层嵌套融合(如 Conv + Bias + ReLU + BatchNorm),并保证语义等价性。

四、 融合的边界:何时不该融合?

cann/ops-nn 并非盲目融合一切。它通过成本模型判断融合是否值得:

# ops-nn/fusion_cost_model.py

def should_fuse(op_a, op_b):

# 规则1: 若op_b是控制流(如If/While),禁止融合

if op_b.type in CONTROL_FLOW_OPS:

return False

# 规则2: 若融合后寄存器压力过大,放弃

estimated_regs = estimate_register_usage(op_a, op_b)

if estimated_regs > TARGET_DEVICE_MAX_REGS:

return False

# 规则3: 若op_a输出被多个消费者使用(fan-out > 1),通常不融合

if graph.get_consumers(op_a.output).size() > 1:

return False

return True

这种智能决策机制避免了因过度融合导致的寄存器溢出或并行度下降。

五、 实测收益:从理论到产线

在典型视觉模型(如ViT)上,cann/ops-nn 的融合策略带来显著收益:

| 模型组件 | 未融合 Kernel 数 | 融合后 Kernel 数 | 端到端延迟降低 |

|---|---|---|---|

| ViT Block (LN+MLP) | 5 | 2 | 23% |

| ResNet Bottleneck | 4 | 1 | 18% |

| BERT FFN | 3 | 1 | 27% |

更重要的是,内存峰值占用平均下降35%,这对内存受限的边缘设备尤为关键。

结语:协同优于孤立,系统胜过局部

cann/ops-nn 的融合工程,本质上是对“整体大于部分之和”这一系统思想的践行。它告诉我们:在AI基础设施的深水区,真正的突破不再来自单点极致优化,而源于对组件间关系的重新理解与重构。

通过可融合性契约、图级优化引擎与智能成本模型,cann/ops-nn 将原本割裂的算子世界,编织成一张高效协同的计算网络。在这张网络中,每一个算子都不是孤岛,而是可组合、可压缩、可协同的活力节点。而这,或许正是构建下一代高性能AI系统的正确方向。

相关链接:

- CANN开源组织主页: https://atomgit.com/cann

- ops-nn算子仓库地址: https://atomgit.com/cann/ops-nn

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)