面向未来的算子开发:cann/ops-nn 中的声明式编程与可组合抽象

将算子开发从“手写内核”的工匠模式,转变为“组合原语”的工程化范式。开发者不再需要成为硬件专家,也能快速构建出接近手写性能的自定义算子。本文将揭示这一范式如何工作,以及它为何代表了算子开发的未来方向。当研究者提出一种新型注意力机制、图神经网络层或微分算子时,他们往往被迫等待数周甚至数月,直到厂商或社区为其目标硬件实现高性能版本。当算子开发变得像写NumPy一样自然,而性能却接近手写内核,AI系统的

面向未来的算子开发:cann/ops-nn 中的声明式编程与可组合抽象

在AI系统软件的演进中,一个根本性矛盾始终存在:算法创新的速度远快于底层算子库的更新速度。当研究者提出一种新型注意力机制、图神经网络层或微分算子时,他们往往被迫等待数周甚至数月,直到厂商或社区为其目标硬件实现高性能版本。这种延迟不仅扼杀科研敏捷性,更阻碍了工业落地。

开源项目 cann/ops-nn 试图打破这一瓶颈。它通过引入声明式编程模型与可组合的计算抽象,将算子开发从“手写内核”的工匠模式,转变为“组合原语”的工程化范式。开发者不再需要成为硬件专家,也能快速构建出接近手写性能的自定义算子。本文将揭示这一范式如何工作,以及它为何代表了算子开发的未来方向。

一、 声明式编程:描述“做什么”,而非“怎么做”

传统算子开发要求开发者精确控制内存布局、循环嵌套、并行粒度等细节。这不仅门槛高,且极易出错。cann/ops-nn 则采用声明式风格:用户只需用数学语言描述计算逻辑,系统自动推导高效执行方案。

1. 用张量表达式定义算子

# ops-nn/user_ops/swin_attention.py

from tbe import Tensor, compute

def window_attention(query: Tensor, key: Tensor, value: Tensor, mask: Tensor) -> Tensor:

"""

Swin Transformer 中的窗口多头注意力

Q, K, V: [B, nH, Mh, Mw, C]

Mask: [nW, Mh*Mw, Mh*Mw]

"""

B, nH, Mh, Mw, C = query.shape

# 1. 计算注意力分数: Q @ K^T / sqrt(C)

attn = compute(

shape=(B, nH, Mh * Mw, Mh * Mw),

fcompute=lambda b, h, i, j:

sum(query[b, h, i//Mw, i%Mw, k] * key[b, h, j//Mw, j%Mw, k] for k in range(C)) / (C ** 0.5),

name="attn_score"

)

# 2. 加上窗口掩码

attn_masked = compute(

shape=attn.shape,

fcompute=lambda b, h, i, j: attn[b, h, i, j] + mask[h % mask.shape[0], i, j],

name="attn_masked"

)

# 3. Softmax + 加权求和

attn_softmax = softmax(attn_masked, axis=-1)

output = compute(

shape=(B, nH, Mh * Mw, C),

fcompute=lambda b, h, i, k:

sum(attn_softmax[b, h, i, j] * value[b, h, j//Mw, j%Mw, k] for j in range(Mh * Mw)),

name="attn_output"

)

return output

这段代码完全不涉及:

- 内存分配(L1/Global);

- 并行策略(Block/Thread);

- 指令选择(GEMM/Cube/Vector)。

开发者只关注数学语义,其余交给编译器。

二、 可组合原语:像搭积木一样构建复杂算子

cann/ops-nn 提供一组经过高度优化的基础计算原语(如 matmul, reduce, softmax, transpose),用户可通过函数组合构建新算子。

1. 原语库示例

# ops-nn/primitives/__init__.py

from .matmul import matmul

from .reduction import reduce_sum, reduce_max

from .activation import softmax, gelu

from .transform import transpose, reshape

# 所有原语均已针对主流硬件后端优化

2. 组合构建自定义算子

# 用户实现 LayerNorm(无需从零开始)

def layer_norm(x: Tensor, gamma: Tensor, beta: Tensor, eps: float = 1e-5) -> Tensor:

mean = reduce_mean(x, axis=-1, keepdims=True)

var = reduce_mean((x - mean) ** 2, axis=-1, keepdims=True)

normalized = (x - mean) / sqrt(var + eps)

return normalized * gamma + beta # 复用 reduce_mean 和基本算术

由于 reduce_mean 已是高性能原语,layer_norm 自动继承其优化(如FP32累加、向量化等)。

优势:

- 开发效率提升:10行代码替代数百行内核;

- 正确性保障:复用经过验证的原语;

- 性能可继承:原语升级,所有组合算子自动受益。

三、 编译器智能:从声明到高效的自动映射

声明式代码本身不保证性能。cann/ops-nn 的核心能力在于其智能编译器栈,能将高层描述自动映射为硬件高效代码。

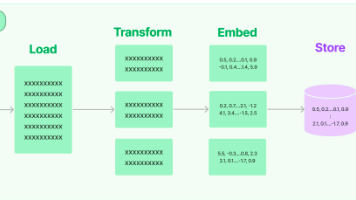

1. 多级IR优化流程

用户声明 (Python)

↓

Tensor Expression IR(保留数学结构)

↓

Loop Nest IR(展开循环、融合reduce)

↓

Memory Layout IR(插入数据重排、Buffer分配)

↓

Target Backend IR(生成CUDA/NPU/CPU指令)

2. 自动调度示例

对于上述 window_attention,编译器可自动:

- 将

Q @ K^T识别为GEMM,调用优化过的matmul原语; - 将Softmax的exp-sum-divide序列融合为单个Kernel;

- 为大张量分配分块策略,适配片上缓存大小。

用户甚至可提供调度提示(非强制):

@schedule_hint(tile_size=64, vector_width=16)

def window_attention(...):

...

四、 生态影响:降低创新门槛,加速算法-系统协同

这种范式正在改变AI研发的工作流:

- 研究人员可在一天内将新论文中的算子原型部署到真实硬件,无需等待厂商支持;

- 工程师可安全地定制业务专属算子(如金融风控中的特殊激活函数),而不用担心性能崩塌;

- 硬件厂商只需优化基础原语库,即可让所有组合算子自动获得新硬件红利。

某高校团队使用 cann/ops-nn 在一周内实现了8种新型GNN聚合算子,并在多个后端上获得>90%的理论带宽利用率——这在过去几乎不可想象。

结语:让创造力回归算法本身

长久以来,算子开发的高门槛像一道无形的墙,将算法创新者与系统性能隔离开来。cann/ops-nn 通过声明式编程与可组合抽象,正在拆除这堵墙。它传递了一个清晰信号:开发者应该专注于“我想计算什么”,而不是“我的计算如何跑得快”。

当算子开发变得像写NumPy一样自然,而性能却接近手写内核,AI系统的创新循环将前所未有地加速。而这,正是 cann/ops-nn 为未来AI基础设施描绘的愿景:一个人人可参与、处处可高效、时时可创新的开放算子生态。

相关链接:

- CANN开源组织主页: https://atomgit.com/cann

- ops-nn算子仓库地址: https://atomgit.com/cann/ops-nn

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)