从开发到部署的闭环:cann/ops-nn 中的端到端可验证算子交付

从一行代码到万台设备,每一个算子都带着它的“数字护照”——包含构建溯源、测试证明、性能承诺与安全校验。,将这一断点转化为连续体。它从代码提交的第一行起,就嵌入了验证、度量与保障机制,确保每一个算子在任何环境下都能“所见即所得,所测即所用”。精度差异、性能波动、甚至运行失败,常常在模型从实验室迁移到产线时突然暴露。这种“开发-部署鸿沟”不仅拖慢迭代速度,更侵蚀团队对系统的信任。每次构建都基于此配置拉

从开发到部署的闭环:cann/ops-nn 中的端到端可验证算子交付

在AI工程实践中,一个长期存在的“断点”是:算子在开发环境中的行为,无法保证在生产环境中完全一致。精度差异、性能波动、甚至运行失败,常常在模型从实验室迁移到产线时突然暴露。这种“开发-部署鸿沟”不仅拖慢迭代速度,更侵蚀团队对系统的信任。

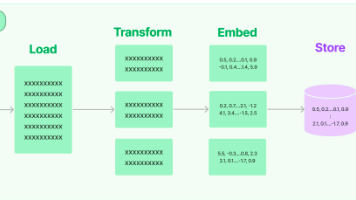

开源项目 cann/ops-nn 通过构建一个端到端可验证的算子交付流水线,将这一断点转化为连续体。它从代码提交的第一行起,就嵌入了验证、度量与保障机制,确保每一个算子在任何环境下都能“所见即所得,所测即所用”。本文将揭示这一闭环体系如何运作,以及它如何重塑AI基础设施的可靠性标准。

一、 可复现构建:锁定依赖,消除环境噪声

算子的行为受编译器版本、数学库、甚至操作系统影响。cann/ops-nn 采用声明式构建配置,确保构建过程完全可复现。

1. 构建环境描述文件

# ops-nn/build/env.yaml

build_env:

base_image: "ops-nn/ci-base:cuda12.1-cudnn8.9"

compiler:

name: "gcc"

version: "11.4.0"

dependencies:

- name: "tbe-ir"

version: "0.8.2"

source: "https://atomgit.com/cann/tbe-ir/releases/v0.8.2.tar.gz"

- name: "backend-cuda"

version: "1.3.0"

checksum: "sha256:abcd1234..."

每次构建都基于此配置拉取确定版本的依赖,杜绝“在我机器上能跑”的问题。

2. 构建产物签名与溯源

生成的算子二进制自动附带元数据:

// build/metadata/conv2d_v2.json

{

"operator": "Conv2D",

"version": "2.1.0",

"git_commit": "a1b2c3d",

"build_timestamp": "2026-02-06T10:30:00Z",

"dependencies": {

"tbe-ir": "0.8.2",

"backend-cuda": "1.3.0"

},

"sha256": "e7d8f9a0b1c2d3e4f5a6b7c8d9e0f1a2b3c4d5e6f7a8b9c0d1e2f3a4b5c6d7e8"

}

该信息随模型一同部署,支持运行时校验。

二、 多维验证:覆盖功能、精度、性能与鲁棒性

cann/ops-nn 的测试体系不止于“通过/失败”,而是构建多维度验证矩阵。

1. 测试配置示例

# ops-nn/test/configs/conv2d_test_matrix.yaml

test_cases:

- name: "fp16_standard"

dtype: "float16"

input_shape: [1, 3, 224, 224]

kernel_shape: [64, 3, 7, 7]

validation:

functional: true

numerical_tolerance: { rtol: 1e-2, atol: 1e-3 }

performance_baseline: { latency_us: 1200, threshold: +10% }

- name: "int8_quantized"

dtype: "int8"

input_shape: [4, 64, 56, 56]

kernel_shape: [128, 64, 1, 1]

validation:

functional: true

quantization_error_bound: 0.05 # 量化误差 < 5%

- name: "edge_case_nan_inf"

dtype: "float32"

input_data: "nan_inf_mixed" # 特殊测试数据集

validation:

nan_propagation: true

inf_handling: "clamped"

2. 自动化执行与报告

CI系统自动在多种后端(CUDA、ROCm、CPU等)上运行全矩阵测试,并生成结构化报告:

{

"test_run_id": "tr-20260206-conv2d-v2.1.0",

"results": {

"fp16_standard.cuda": { "status": "PASS", "latency_us": 1185 },

"int8_quantized.rocm": { "status": "PASS", "quant_error": 0.032 },

"edge_case_nan_inf.cpu": { "status": "FAIL", "reason": "Inf not clamped" }

}

}

任一平台失败,即阻断发布流程。

三、 部署时验证:运行前的最后一道防线

即使通过CI,仍需防范部署环境异常。cann/ops-nn 支持运行时自检。

1. 启动时健康检查

# ops-nn/runtime/health_check.py

def verify_operator_integrity(op_name, expected_sha256):

binary = load_operator_binary(op_name)

actual_sha = hashlib.sha256(binary).hexdigest()

if actual_sha != expected_sha256:

raise SecurityError(f"Operator {op_name} binary tampered!")

# 执行微型金丝雀测试

test_input = generate_canary_input(op_name)

output = run_operator(op_name, test_input)

if not is_expected_output(output, op_name):

raise RuntimeError(f"Operator {op_name} failed canary test!")

# 模型加载时自动触发

model.load("resnet50.om")

model.verify_operators() # ← 关键调用

2. 生产环境监控集成

算子执行时自动上报指标至Prometheus:

# 在调度末尾插入埋点

def schedule_conv2d(...):

# ... 调度逻辑

annotate_metric("operator_latency", "conv2d_fp16_3x3")

annotate_metric("numerical_stability", "no_nan_inf")

运维团队可设置告警规则:“若 numerical_stability != 'ok' 持续5分钟,则自动回滚”。

四、 闭环反馈:从故障中学习,持续加固

所有验证数据被汇聚至中央仓库,用于驱动持续改进。

1. 故障模式分析

当某边缘设备上报“Conv2D输出全零”时,系统自动:

- 匹配其算子版本与构建元数据;

- 回放相同输入的CI测试记录;

- 若CI中未复现,则触发影子测试:在模拟该设备环境的容器中重跑。

2. 自动增强测试集

若新故障被确认,系统自动生成新测试用例并加入矩阵:

# 自动生成的测试用例(由故障回溯工具生成)

def test_conv2d_zero_output_on_low_power_device():

x = load_faulty_input("incident-20260205-conv2d-zero")

y = conv2d(x, weight, padding="SAME")

assert not torch.allclose(y, torch.zeros_like(y)), "Output should not be all zero!"

结语:信任不是假设,而是被验证的契约

在AI系统日益成为社会基础设施的今天,“大概能用”已远远不够。cann/ops-nn 的端到端可验证交付体系,传递了一个清晰信念:可靠性不是偶然结果,而是通过设计、验证与闭环反馈构建出来的确定性契约。

从一行代码到万台设备,每一个算子都带着它的“数字护照”——包含构建溯源、测试证明、性能承诺与安全校验。这不仅是工程方法的升级,更是对用户责任的践行。当AI系统建立在这种可验证的信任之上,我们才能真正放心地将关键任务托付给智能。

而这,正是 cann/ops-nn 为下一代AI基础设施写下的新标准:可验证,方可信;可闭环,方可靠。

相关链接:

- CANN开源组织主页: https://atomgit.com/cann

- ops-nn算子仓库地址: https://atomgit.com/cann/ops-nn

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)