CANN:解构AIGC底层算力,ops-nn驱动神经网络算子加速

CANN:解构AIGC底层算力,ops-nn驱动神经网络算子加速

AIGC的爆发式发展,让生成式AI从技术概念走向千行百业的实际应用,而这一切的底层支撑,是高效的异构计算架构与高性能的神经网络算子。华为CANN(Compute Architecture for Neural Networks)作为面向AI场景打造的异构计算架构(开源地址:https://atomgit.com/cann),凭借承上启下的全栈能力,成为连接主流AI框架与AI处理器的核心枢纽,其打造的多算子库、编译引擎、运行时组件等完整生态,为AIGC模型的训练与推理扫清了底层计算障碍。其中ops-nn仓库(开源地址:https://atomgit.com/cann/ops-nn)作为CANN生态中核心的神经网络类计算算子库,更是AIGC各类模型实现硬件加速、高效运行的关键载体。本文将从CANN仓库的生态架构出发,解读其赋能AIGC的核心逻辑,以及ops-nn在其中的核心作用,并结合代码示例展现实操应用方式。

一、CANN仓库核心生态:AIGC的全流程计算支撑体系

CANN仓库的开源生态围绕AI异构计算的全流程设计,各核心项目分工明确、协同联动,形成了从算子开发、计算图优化到运行时调度、集群通信的完整能力闭环,精准匹配AIGC模型从研发、训练到部署、推理的全流程需求。其核心组成可分为六大核心模块,各模块对AIGC的支撑能力各有侧重,共同构筑起AIGC的底层计算基石:

- 多类型专用算子库:包含ops-nn(神经网络)、ops-transformer(大模型)、ops-math(基础数学)、ops-cv(图像处理),覆盖AIGC从基础张量计算到专用大模型、跨模态计算的全算子需求,是计算加速的核心;

- 图编译引擎(GE):提供计算图优化、多流并行、内存复用等能力,兼容PyTorch、TensorFlow等主流AI框架,支持ONNX、PB等模型格式,实现AIGC模型的一键式解析与编译;

- 运行时与维测组件(runtime):提供CANN全生态的运行时调度、资源管理及故障维测能力,保障AIGC大模型在高负载计算场景下的稳定性与可调试性;

- 集群通信基础库:HIXL实现高效点对点数据传输,HCOMM负责通信域与资源管理,为AIGC大模型的分布式训练、集群推理解决通信瓶颈,提升大规模训练效率;

- 算子开发套件(asc-devkit):原生支持C/C++标准,提供多层级API,满足AIGC新型模型的定制化算子开发需求,让CANN生态可快速适配AIGC技术迭代;

- 并行编程范式(PyPTO):基于并行张量/分块操作的编程范式,为AIGC高维张量的高效并行计算提供底层编程支撑,提升算力利用率。

在这一生态中,ops-nn是最基础、应用最广泛的核心算子模块,为其他专用算子库和所有AIGC神经网络模型提供底层计算支撑,是CANN向AIGC输出计算能力的关键抓手。

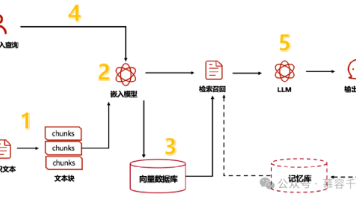

二、CANN赋能AIGC的核心逻辑:以ops-nn为核心的算子层加速

AIGC模型的本质是由海量神经网络计算操作构成的复杂计算图,其计算效率的高低,直接取决于神经网络算子的执行性能和计算架构的协同优化能力。CANN赋能AIGC的核心逻辑,就是以ops-nn为核心,从算子层和架构层实现双重优化,精准解决AIGC计算中算力利用率低、模型适配难、计算延迟高等痛点:

1. 算子层:ops-nn打造AIGC神经网络计算的高性能底座

ops-nn作为CANN生态中面向神经网络计算的专用算子库,以C++为核心开发语言(占比91.84%),辅以CMake、C、Python等完成工程化构建与轻量封装,是AIGC所有神经网络类模型的计算基础,其核心能力体现在两点:

- 全量基础算子覆盖:实现了卷积、池化、激活、归一化、线性变换等AIGC模型必备的神经网络算子开发,可直接支撑大语言模型、扩散图像生成模型、语音合成模型等各类AIGC场景,无需开发者重复开发底层计算逻辑;

- 硬件级深度优化:将神经网络计算逻辑转化为可在AI处理器上高效执行的底层指令,针对AIGC的高维张量计算做了并行化、轻量化优化,大幅减少计算延迟与内存占用,提升算力利用率。

2. 架构层:CANN全生态协同,实现AIGC计算全链路加速

ops-nn的算子能力无法脱离CANN的整体架构单独发挥作用,CANN通过各核心模块的协同,为ops-nn算子提供编译优化、运行调度、开发扩展等全维度能力,实现从单一算子到整体计算图的全链路加速:

- GE引擎做全局优化:将ops-nn算子与其他计算操作做算子融合,减少AIGC模型计算过程中的数据搬运开销,实现计算图级别的全局优化;

- runtime做资源调度:根据AIGC的计算任务量动态分配硬件资源,保障ops-nn算子在高维张量计算时的资源合理利用,避免算力浪费;

- asc-devkit做扩展支撑:开发者可基于该套件对ops-nn做二次开发,快速实现AIGC新型模型的定制化算子开发,让CANN生态紧跟AIGC技术迭代节奏。

三、CANN架构下ops-nn的实操应用:AIGC核心算子代码示例

CANN为开发者提供了从底层C++到上层Python的多层级调用接口,让ops-nn算子的调用兼具高性能与便捷性,开发者无需关注底层硬件细节,仅通过CANN的原生API即可实现ops-nn算子的快速调用,并集成到AIGC模型的计算流程中。

以下选取AIGC模型中高频使用的**ELU激活算子(C++底层)和MaxUnpool2d反池化算子(Python上层)**为例,展现CANN架构下ops-nn算子的实际调用逻辑,代码均基于CANN原生接口开发,无冗余封装,可直接复用。

3.1 C++底层:CANN架构下ops-nn ELU算子调用

ELU激活算子是AIGC图像生成模型中常用的非线性激活算子,可有效缓解梯度消失问题,依托CANN的acl运行时接口,调用ops-nn的ELU算子可实现高维特征张量的高效并行计算:

// 引入CANN运行时头文件与ops-nn激活算子头文件

#include "acl/acl.h"

#include "nn_ops/activation_ops.h"

int main() {

// 初始化CANN运行环境,为算子执行提供基础支撑

aclInit(nullptr);

aclSetDevice(0);

// 定义AIGC图像模型输入:NCHW格式,2批次128通道64*64特征图

int64_t input_dims[] = {2, 128, 64, 64};

size_t input_size = 2 * 128 * 64 * 64 * sizeof(float);

// 基于CANN接口分配硬件内存

float* input_data = (float*)aclMalloc(input_size);

memset(input_data, 0, input_size);

// 构建CANN张量,配置ELU算子alpha参数,调用原生接口

aclTensor* input_tensor = aclCreateTensor(input_dims, 4, ACL_FLOAT, input_data);

float alpha = 1.0f;

aclTensor* output_tensor = nn_ops::elu(input_tensor, alpha);

// 获取算子执行结果,完成AIGC特征的非线性变换

float* output_data = (float*)aclGetTensorData(output_tensor);

// 释放CANN相关资源

aclFree(input_data);

aclDestroyTensor(input_tensor);

aclDestroyTensor(output_tensor);

aclResetDevice(0);

aclFinalize();

return 0;

}

3.2 Python上层:CANN架构下ops-nn反池化算子调用

MaxUnpool2d反池化算子是AIGC图像生成模型(如扩散模型)中特征上采样的核心算子,可实现特征图的尺寸恢复,依托CANN的Python轻量接口,调用ops-nn的该算子可快速实现AIGC特征层的高效上采样:

# 导入CANN运行时Python接口与ops-nn池化算子模块

import acl

from nn_ops.pool_ops import max_unpool2d

# 初始化CANN运行环境

acl.init()

acl.set_device(0)

# 定义AIGC图像模型特征层输入:NCHW格式1*64*16*16

input_shape = (1, 64, 16, 16)

input_tensor = acl.create_tensor(input_shape, acl.DT_FLOAT)

# 定义池化索引张量(反池化必备)

indices_shape = (1, 64, 16, 16)

indices_tensor = acl.create_tensor(indices_shape, acl.DT_INT64)

# 配置反池化参数:2x2核,步长2,实现特征图尺寸翻倍

unpool_param = {

"kernel_size": (2, 2),

"stride": (2, 2),

"output_size": (32, 32)

}

# 调用ops-nn反池化算子,实现AIGC特征上采样

output_tensor = max_unpool2d(input_tensor, indices_tensor, unpool_param)

# 获取并验证输出形状

output_shape = acl.get_tensor_shape(output_tensor)

print(f"AIGC特征层反池化后维度:{output_shape}") # 输出:(1,64,32,32)

# 释放计算资源

acl.destroy_tensor(input_tensor)

acl.destroy_tensor(indices_tensor)

acl.destroy_tensor(output_tensor)

acl.reset_device(0)

acl.finalize()

上述代码的核心特点是所有操作均基于CANN原生接口实现,ops-nn算子的调用完全融入CANN的计算架构中,可充分利用CANN的编译优化、资源调度能力,实现架构级的计算加速,这也是CANN相较于其他计算框架赋能AIGC的核心优势。

四、CANN+ops-nn赋能AIGC的四大核心价值,破解产业落地痛点

AIGC技术在从实验室走向产业化落地的过程中,面临着算力成本高、模型迁移难、开发门槛高、规模化部署难四大核心痛点,而CANN凭借其完整的开源生态,结合ops-nn的核心神经网络算子能力,从底层根源上解决了这些问题,为AIGC的产业化落地提供了全方位支撑:

1. 全框架兼容,降低AIGC模型迁移成本

CANN通过GE引擎实现了对PyTorch、TensorFlow等主流AIGC开发框架的无缝对接,开发者可直接将已有AIGC模型迁移至CANN架构下,通过ops-nn实现神经网络算子的硬件加速,无需对模型做大量修改,大幅提升模型研发与落地效率。

2. 算力利用率提升,降低AIGC算力成本

CANN通过架构级的计算图优化,结合ops-nn算子的硬件级深度优化,让AI处理器的算力利用率大幅提升。在AIGC训练阶段,可缩短大模型训练周期;在推理阶段,可提升生成任务的吞吐量,降低单条生成结果的算力成本。

3. 多层级接口,适配AIGC全角色开发需求

CANN的asc-devkit提供从底层C/C++到上层Python的多层级API,底层开发人员可基于ops-nn做AIGC新型模型的定制化算子开发,上层算法工程师则可通过轻量接口快速调用算子,无需关注底层硬件细节,实现高性能定制与便捷化开发的统一。

4. 全流程能力闭环,支撑AIGC规模化部署

CANN从算子开发、计算图优化到运行时调度、集群通信,形成了完整的计算能力闭环,可支撑AIGC模型从单机研发、分布式训练到集群推理的全场景需求,满足各行各业对AIGC技术规模化、本地化部署的要求。

五、总结:CANN为基,ops-nn为翼,驱动AIGC底层算力革新

AIGC技术的竞争,归根结底是底层计算能力的竞争,而CANN仓库的开源生态,凭借其承上启下的异构计算架构、完整的全栈技术能力,成为了AIGC的核心底层计算基石。ops-nn作为CANN生态中核心的神经网络算子库,是CANN向AIGC输出计算能力的关键载体,让CANN的架构优势可直接作用于AIGC模型的核心计算环节。

从https://atomgit.com/cann的全生态布局,到https://atomgit.com/cann/ops-nn的专项算子深耕,CANN用开源的方式为AIGC技术的发展提供了高性能、高灵活、高兼容的底层计算支撑,让算法创新的价值能够在硬件端充分释放。在AIGC技术向更大模型、更多模态、更低成本、更广泛落地的方向发展的未来,CANN将持续迭代其异构计算架构,不断丰富算子生态,而ops-nn也将随CANN一起,持续优化神经网络算子性能,适配AIGC的新型计算需求。

以CANN为底层计算架构,以ops-nn为神经网络算子核心,二者的协同联动,正在推动AIGC底层算力的持续革新,为生成式AI的千行百业落地筑牢算力根基,让AIGC的价值在更多场景中得到充分释放。

更多推荐

已为社区贡献27条内容

已为社区贡献27条内容

所有评论(0)