大模型图解基础教程(非常详细),大模型实战应用入门到精通,收藏这一篇就够了!

当今这个由 AI 驱动的时代,我们早已不再惊讶于 ChatGPT 编写诗歌、Copilot 生成代码,甚至 Midjourney 一键出图。大模型(LLM)正悄然渗透进各行各业,深刻改变着我们与机器的互动方式。而如果你想真正理解这些改变背后的技术逻辑,亲手构建属于自己的 LLM 应用,那么这本 **《图解大模型》** 将是一本不可错过的实战之书。

前言

当今这个由 AI 驱动的时代,我们早已不再惊讶于 ChatGPT 编写诗歌、Copilot 生成代码,甚至 Midjourney 一键出图。大模型(LLM)正悄然渗透进各行各业,深刻改变着我们与机器的互动方式。而如果你想真正理解这些改变背后的技术逻辑,亲手构建属于自己的 LLM 应用,那么这本 《图解大模型》 将是一本不可错过的实战之书。

作者 Jay Alammar 和 Maarten Grootendorst,一个是以图解 Transformer 闻名的可视化大牛,另一个是 BERTopic 作者、embedding 实战派。这对组合联手打造的这本书,既有清晰的技术讲解,也有动手实操的示例代码,堪称想看懂又能上手的理想教程。

图解内容概要

为什么要读书? 我们处于AI时代,也是一个信息过载的时代,每天面临着海量的信息输入,只有对它们进行系统化地梳理学习之后,才能更好地提升知识获取的效率。而读书,就是系统性地梳理和学习知识的重要途径之一。

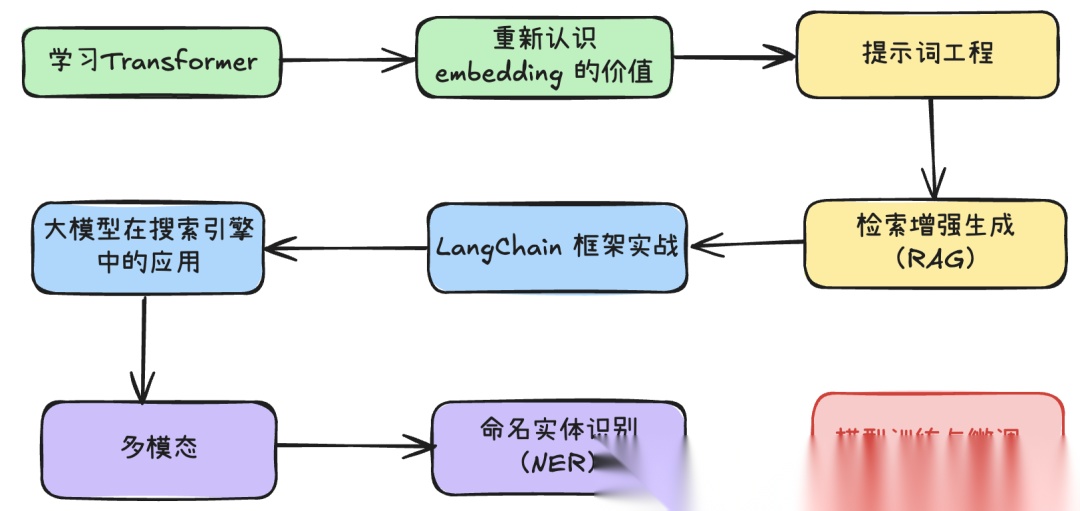

书中系统地讲解了大模型学习过程中的各种概念和实战框架与场景,包括Transformer、embedding、PE工程、LangChain、大模型结合搜索引擎、多模态、知识图谱命名实体识别、模型的训练与微调等。全书以图解的方式来讲解这些不易被理解的概念。

通过让机器更好地理解并生成类人语言,大模型为人工智能领域打开了全新的可能性,并深刻影响了整个行业。

这是《图解大模型》一书中由作者 Jay Alammar 和 Maarten Grootendorst 撰写的开篇语。随着人工智能的不断演进,大模型正站在最前沿,彻底改变我们与机器的互动方式、信息处理流程,甚至语言本身的理解方式。

为什么这本书值得读?

1. 不再被 Transformer 吓退

第 1 章提供了语言模型内部工作机制的高级概述,第 2 和第 3 章则对这些概念进行了更深入的拆解。

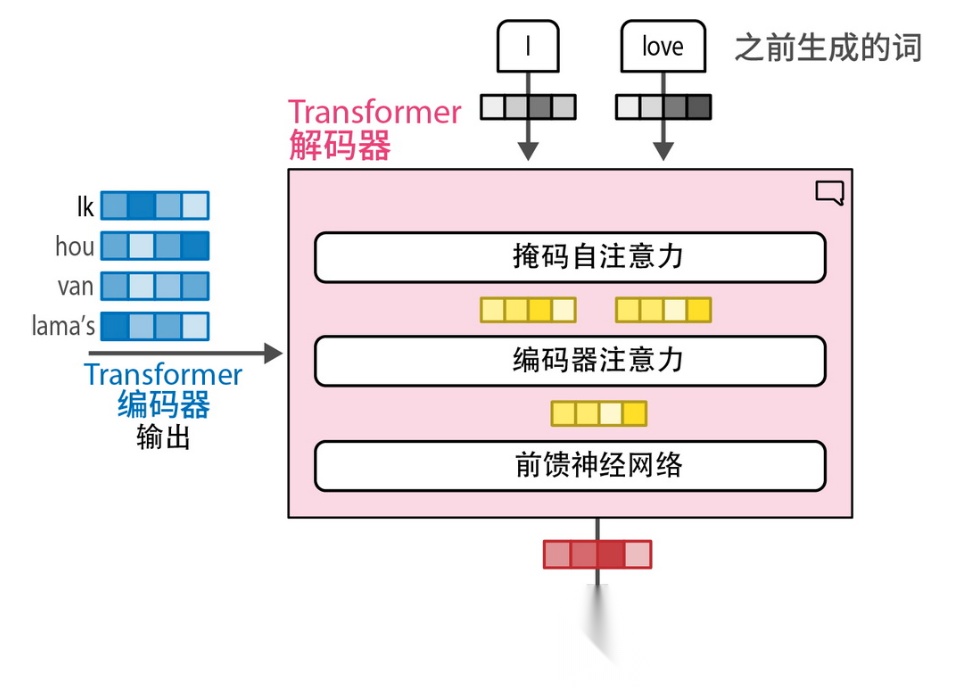

作者巧妙地使用图示、插图和代码示例来解释复杂主题,如分词、嵌入、Transformer 模型以及注意力机制。

2. 解码器具有一个附加的注意力层,用于关注编码器的输出

阅读建议:第 1 章内容可能更适合具备机器学习背景的读者,对其他人而言可能略显艰涩。如果你觉得吃力,可以先快速浏览;后面的第 2、3 章会对这些内容进行更细致的讲解。

3. 重新认识 embedding 的价值

嵌入模型在该领域的重要性不言而喻,因为它们是众多应用背后的核心驱动力。

第 4 章讲解了如何利用开源嵌入模型完成分类任务,无需高成本的微调,也不需要 GPU 训练,甚至可以处理无标签数据。

第 5 章讲解了如何用嵌入模型进行文本聚类,识别异常点、加速标注流程,或是在大量文本中抽取主题信息。

4. 提示工程

第 6 章对提示工程的讲解非常实用,哪怕你只是日常使用 ChatGPT,也能从中学到设计 prompt 的思路。

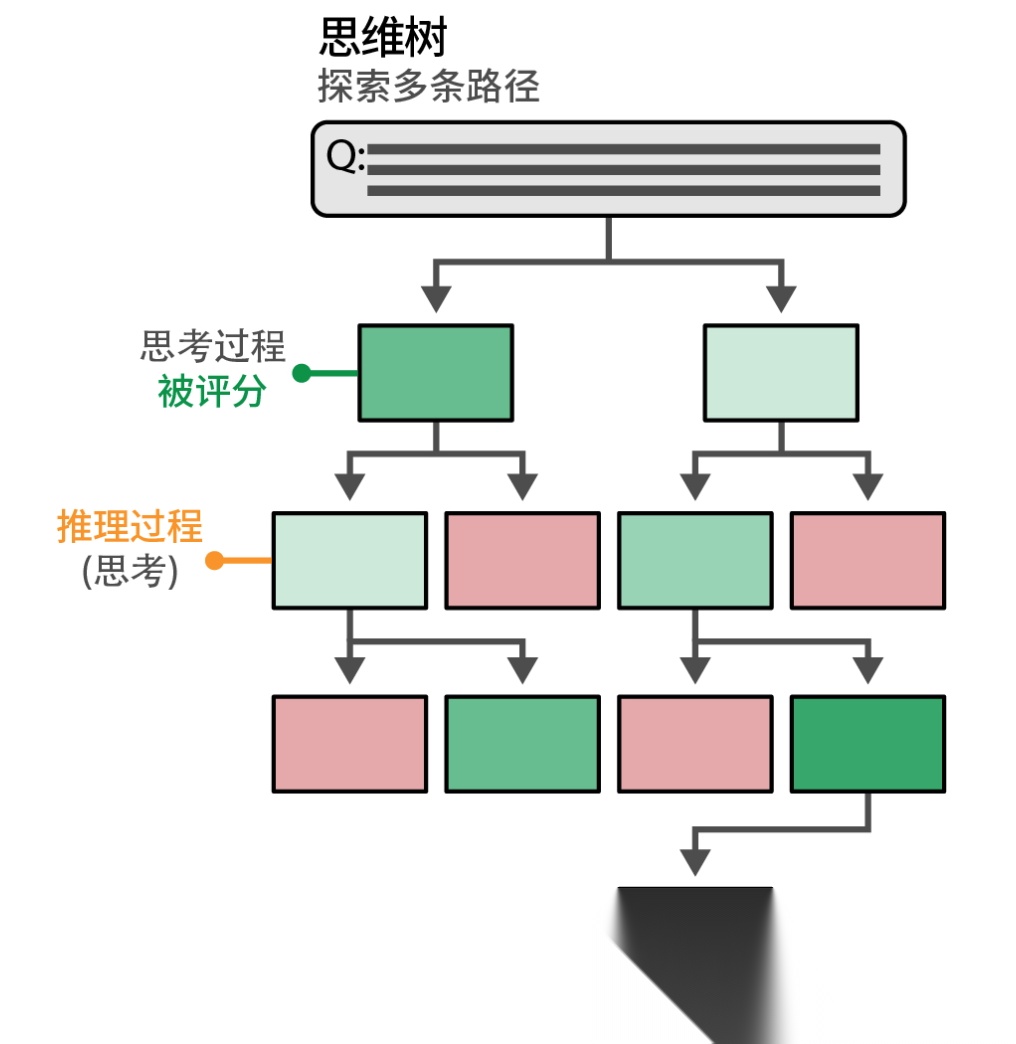

其中“Tree of Thought”的方法更是让我印象深刻,一个简单的模板就能引导模型展开多条思路,非常适合任务拆解。

利用树状结构,生成模型可以生成待评分的中间思考过程。最有希望的思考过程会被保留,而较差的会被剪枝

5. 检索增强生成(RAG)

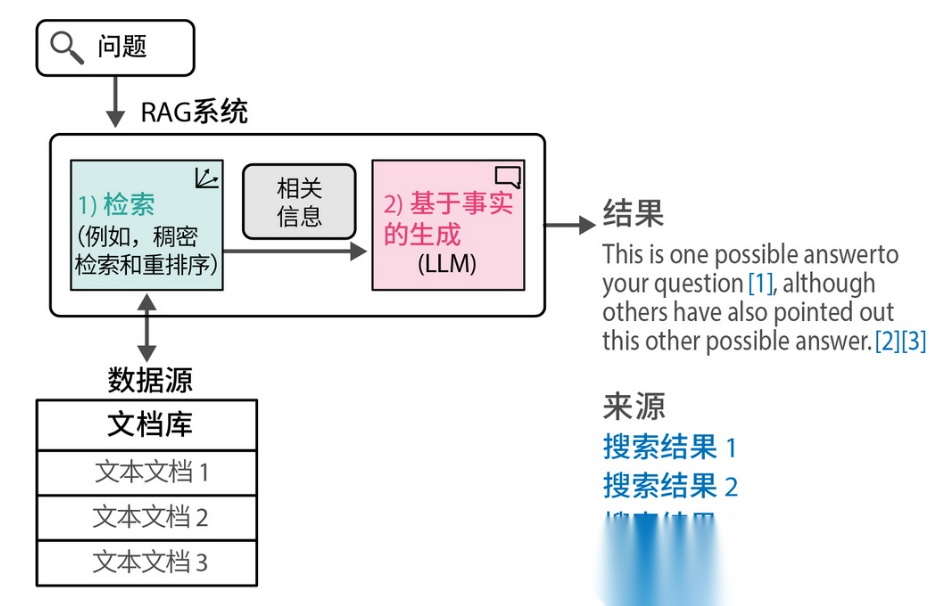

第 8 章专门介绍了热门的 RAG 技术 —— “让大模型看懂你的知识库”。不仅讲解了基础架构,还涵盖了高级技巧与评估方法,是构建私有 ChatGPT 的核心章节。

生成式搜索在搜索流程的末端生成答案和摘要,同时引用其来源(由搜索系统的前序步骤返回)

6. LangChain 框架实战

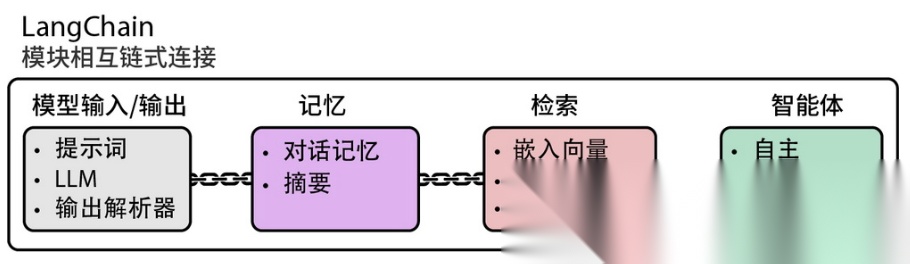

第 7 章系统介绍了 LangChain,这个目前很受欢迎的 LLM 应用开发框架。对于开发者来说,这一章可以大大缩短上手时间,尤其是 Agent 部分的讲解更是非常具有启发性。

LangChain 作为全功能 LLM 应用框架,其模块化组件可通过链式架构构建复杂的 LLM 系统

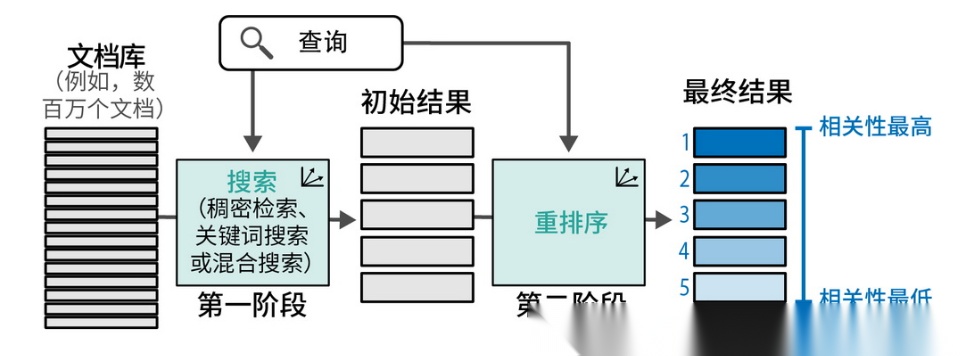

7. 大模型在搜索引擎中的应用

第 8 章还探讨了语义搜索在 Google、Bing 等搜索引擎中的应用,讲解了 reranking(重排序)优化搜索结果的工程机制,内容很硬核。

LLM 重排器作为搜索流程组件,其目标是根据相关性对候选搜索结果重新排序

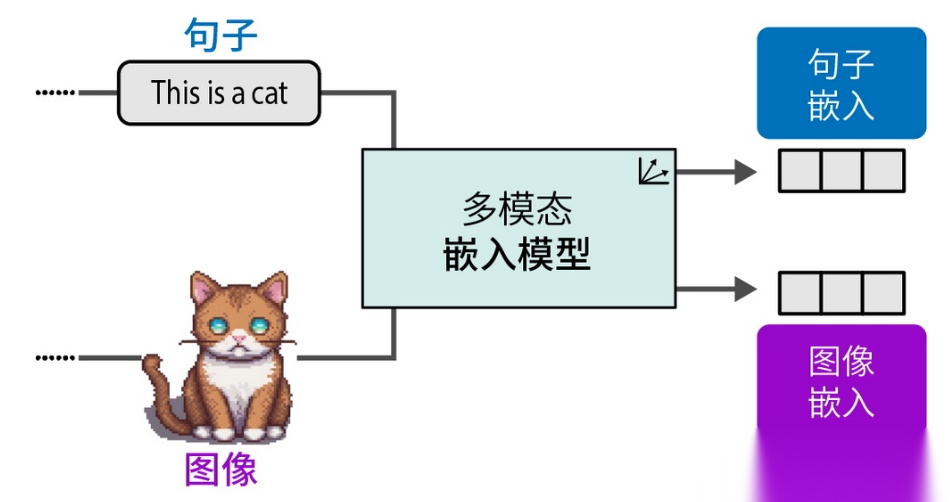

8. 多模态

第 9 章介绍了如何将图像信息引入大模型体系,实现图文联合理解,例如图像问答、语义搜索等前沿场景。

多模态嵌入模型可在同一向量空间中为不同模态生成嵌入向量

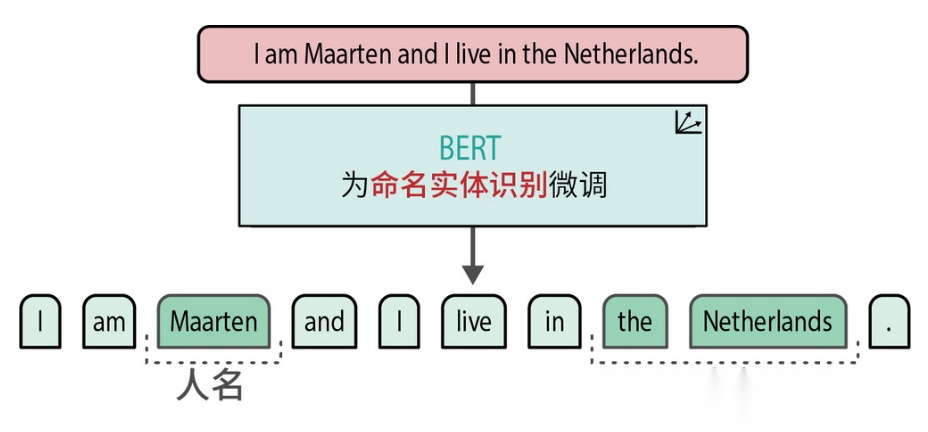

9. 命名实体识别(NER)

作者还在书中介绍了如何通过 NER 精准地识别文本中的人名、地名等实体,特别适用于涉及敏感信息的脱敏处理。

微调后的 BERT 模型能够识别人名和地点等命名实体

10. 模型训练与微调

这一部分是我最期待的内容之一——将大模型(LLM)适配到特定的应用场景,展现了它们的灵活性和广泛的适用性。第 10 到第 12 章就专门聚焦于这个主题,涵盖了嵌入式模型和生成式模型的应用。

我特别喜欢第 10 章,它讲解了如何在数据有限的情况下使用增强版 SBERT(Augmented SBERT)对模型进行微调,并介绍了用于无监督训练的 TSDAE 方法。这些技术在缺乏大规模标注数据时非常有价值。

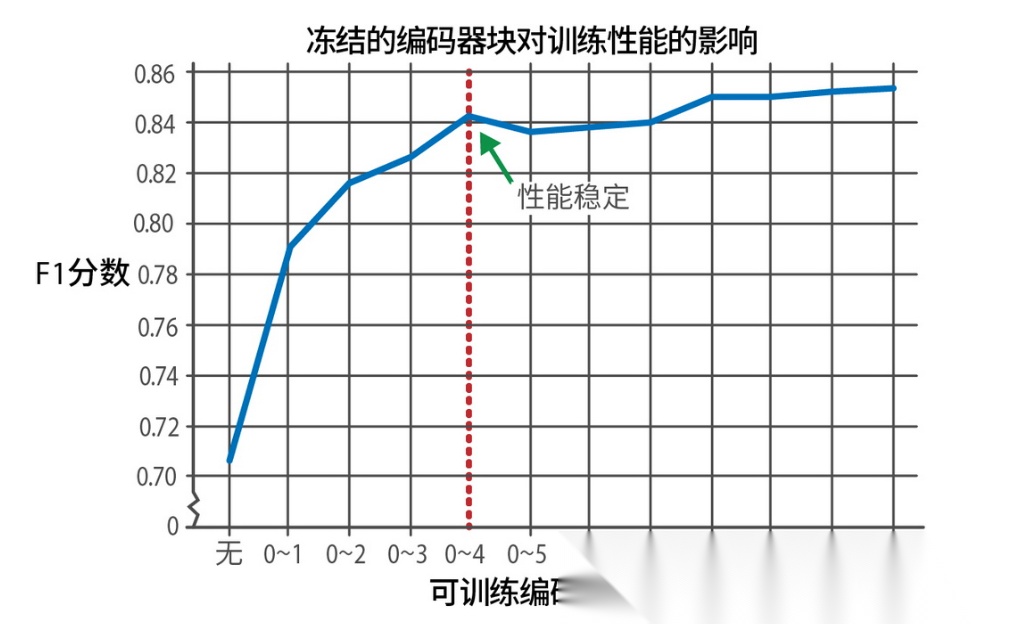

第 11 章则超越了传统的分类任务微调范畴,深入探讨了如何根据算力资源有选择性地微调模型的部分层级。作者对“微调部分层”和“微调全部层”的对比分析,也提供了在资源有限或训练时间受限的情况下,做出合理取舍的实用指南。

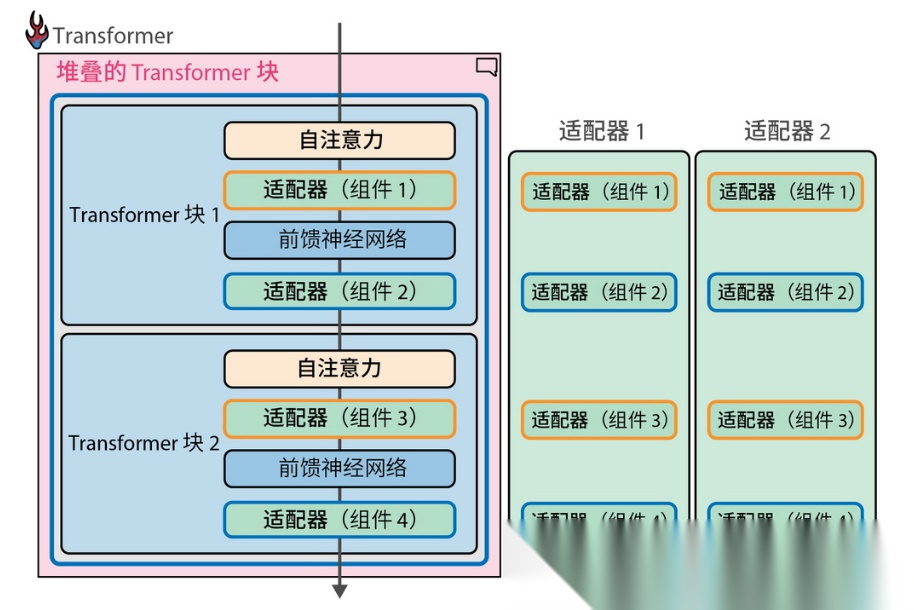

第 10 至 12 章聚焦 LLM 的定制化使用,包括少量数据下的微调方法(如 Augmented SBERT、TSDAE)、选择性微调策略,以及 Adapter 模型和量化技术。对于有意将 LLM 应用到具体场景的开发者来说,这几章干货满满。

冻结特定编码器块对模型性能的影响。训练更多模块带来的性能提升会快速趋于平缓

第 12 章介绍了“适配器(Adapters)”的概念,它为每个下游任务都进行完整微调提供了一种替代方案。这种方法与构建可组合的软件的理念高度契合,而这正是工程师们始终追求的目标。此外,本章还探讨了量化(Quantization)技术如何提升训练效率,将数学原理与计算机科学方法相结合,展现了模型优化中的一系列创新策略。

学AI大模型的正确顺序,千万不要搞错了

🤔2026年AI风口已来!各行各业的AI渗透肉眼可见,超多公司要么转型做AI相关产品,要么高薪挖AI技术人才,机遇直接摆在眼前!

有往AI方向发展,或者本身有后端编程基础的朋友,直接冲AI大模型应用开发转岗超合适!

就算暂时不打算转岗,了解大模型、RAG、Prompt、Agent这些热门概念,能上手做简单项目,也绝对是求职加分王🔋

📝给大家整理了超全最新的AI大模型应用开发学习清单和资料,手把手帮你快速入门!👇👇

学习路线:

✅大模型基础认知—大模型核心原理、发展历程、主流模型(GPT、文心一言等)特点解析

✅核心技术模块—RAG检索增强生成、Prompt工程实战、Agent智能体开发逻辑

✅开发基础能力—Python进阶、API接口调用、大模型开发框架(LangChain等)实操

✅应用场景开发—智能问答系统、企业知识库、AIGC内容生成工具、行业定制化大模型应用

✅项目落地流程—需求拆解、技术选型、模型调优、测试上线、运维迭代

✅面试求职冲刺—岗位JD解析、简历AI项目包装、高频面试题汇总、模拟面经

以上6大模块,看似清晰好上手,实则每个部分都有扎实的核心内容需要吃透!

我把大模型的学习全流程已经整理📚好了!抓住AI时代风口,轻松解锁职业新可能,希望大家都能把握机遇,实现薪资/职业跃迁~

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献674条内容

已为社区贡献674条内容

所有评论(0)