深入解析CANN-graph-engine图计算引擎:构建高效神经网络执行引擎

graph-engine是CANN平台的计算图执行引擎,位于算子库(ops-nn)之上,运行时环境(runtime)之下。它承接来自上层深度学习框架的神经网络模型,负责将模型转换为可执行的计算图,并进行一系列的图优化和调度,最终高效地调度底层算子在昇腾AI处理器上执行。图转换:将不同框架的模型转换为统一的中间表示(IR)图优化:应用多种图变换技术优化计算图性能内存管理:智能分配和管理计算过程中的内

深入解析CANN graph-engine图计算引擎:构建高效神经网络执行引擎

引言

在深度学习模型的实际部署过程中,如何将复杂的神经网络模型高效地映射到异构计算硬件上执行,是一个极具挑战性的技术难题。华为昇腾CANN平台中的graph-engine图计算引擎,正是为解决这一问题而设计的核心组件。它负责将神经网络模型转换为优化的计算图,并通过智能调度和并行执行,最大化昇腾AI处理器的计算性能。

本文将深入剖析CANN graph-engine图计算引擎的技术架构、核心功能、优化策略以及在实际AI应用中的价值体现,帮助开发者全面理解这一关键的执行引擎。

相关链接:

一、graph-engine图计算引擎概述

1.1 在CANN生态中的定位

graph-engine是CANN平台的计算图执行引擎,位于算子库(ops-nn)之上,运行时环境(runtime)之下。它承接来自上层深度学习框架的神经网络模型,负责将模型转换为可执行的计算图,并进行一系列的图优化和调度,最终高效地调度底层算子在昇腾AI处理器上执行。

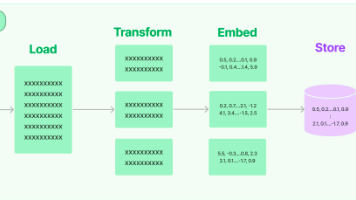

graph-engine的核心职责包括:

- 图转换:将不同框架的模型转换为统一的中间表示(IR)

- 图优化:应用多种图变换技术优化计算图性能

- 内存管理:智能分配和管理计算过程中的内存资源

- 任务调度:优化算子执行顺序,充分利用硬件并行能力

- 流水线执行:构建高效的执行流水线,降低端到端延迟

1.2 核心设计理念

graph-engine的设计遵循以下核心原则:

- 框架无关性:支持多种深度学习框架,提供统一的执行接口

- 硬件感知:充分理解昇腾AI处理器架构,进行硬件友好的优化

- 动态适配:支持动态形状和动态计算图,适应各种应用场景

- 可扩展性:提供插件化架构,便于添加新的优化策略和硬件后端

二、graph-engine技术架构

2.1 分层架构设计

graph-engine采用清晰的分层架构,从上到下包括:

框架适配层

负责对接不同的深度学习框架,将框架特定的模型格式转换为graph-engine的内部表示。目前支持的框架包括:

- MindSpore:华为自研的深度学习框架,原生集成

- TensorFlow:通过TF-Plugin适配器

- PyTorch:通过Torch-NPU适配器

- ONNX:通用模型格式,支持跨框架模型迁移

中间表示层

采用统一的中间表示(IR)描述神经网络计算图。该IR设计考虑了以下因素:

- 表达能力强:能够表达各种复杂的神经网络结构

- 易于优化:IR设计便于应用各种图优化变换

- 硬件友好:IR结构与昇腾AI处理器特性相匹配

核心IR元素包括:

- 计算节点(Compute Node):表示一个算子操作,包含算子类型、属性和输入输出

- 数据节点(Data Node):表示张量数据,包含形状、数据类型和布局

- 控制流节点(Control Flow Node):表示条件分支、循环等控制结构

- 常量节点(Constant Node):表示权重和偏置等常量数据

图优化层

这是graph-engine的核心层,实现了多种图优化技术:

- 常量折叠:预计算常量表达式,减少运行时计算

- 死代码消除:移除未被使用的节点和边

- 算子融合:将多个连续算子合并为一个融合算子

- 内存优化:通过内存复用和原地操作减少内存占用

- 布局转换优化:智能插入和消除数据布局转换

- 算子替换:用更高效的算子替代原始算子

执行调度层

负责优化算子的执行顺序和并行策略:

- 拓扑排序:确定算子的执行顺序,保证依赖关系

- 资源感知调度:根据硬件资源(CPU、NPU、内存)分配任务

- 并行策略:数据并行、算子并行、流水线并行

- 异步执行:利用异步执行隐藏延迟

2.2 关键数据结构

计算图(ComputeGraph)

计算图是graph-engine的核心数据结构,表示完整的神经网络计算流程:

class ComputeGraph {

string name_; // 图名称

vector<NodePtr> nodes_; // 所有节点

vector<EdgePtr> edges_; // 所有边

map<string, NodePtr> node_map_; // 节点名到节点的映射

NodePtr input_node_; // 输入节点

NodePtr output_node_; // 输出节点

};

节点(Node)

节点是计算图的基本单元,可以是计算节点、数据节点或控制流节点:

class Node {

NodeType type_; // 节点类型

string name_; // 节点名称

vector<NodePtr> inputs_; // 输入节点

vector<NodePtr> outputs_; // 输出节点

OpDescPtr op_desc_; // 算子描述(计算节点)

TensorDesc tensor_desc_; // 张量描述(数据节点)

};

边(Edge)

边表示节点之间的数据依赖关系:

class Edge {

NodePtr src_node_; // 源节点

NodePtr dst_node_; // 目标节点

int src_output_idx_; // 源节点输出索引

int dst_input_idx_; // 目标节点输入索引

TensorDesc tensor_desc_; // 数据描述

};

三、核心功能解析

3.1 图转换功能

从框架模型到计算图

graph-engine需要将不同框架的模型转换为统一的计算图表示。以TensorFlow为例:

- 解析SavedModel:加载TensorFlow SavedModel格式

- 遍历计算图:提取TensorFlow计算图中的所有节点

- 算子映射:将TensorFlow算子映射到CANN算子

- 构建IR:根据映射关系构建graph-engine的IR

- 验证和修复:验证图的正确性,修复常见问题

动态图与静态图处理

- 静态图:整个图在编译时确定,可以进行深度优化

- 动态图:图结构在运行时可能变化,需要动态编译

graph-engine对两种模式都提供了支持:

- 静态图模式下,应用激进的优化策略

- 动态图模式下,使用即时编译(JIT)技术,在运行时动态优化

3.2 图优化功能

算子融合

算子融合是提升性能的关键技术。graph-engine支持多种融合模式:

Conv-BN-ReLU融合

将卷积、批归一化和ReLU激活融合为一个算子:

# 融合前

x = conv(x, weight, bias)

x = batch_norm(x, gamma, beta, mean, var)

x = relu(x)

# 融合后

x = fused_conv_bn_relu(x, fused_weight, fused_bias)

融合后的优势:

- 减少内存访问:中间结果不需要写入内存

- 减少kernel启动:三次kernel调用合并为一次

- 提升缓存利用率:数据保持在寄存器/缓存中

LayerNorm-Linear融合

在Transformer模型中,LayerNorm后通常接线性变换:

# 融合前

x = layer_norm(x, gamma, beta)

x = linear(x, weight, bias)

# 融合后

x = fused_layer_norm_linear(x, weight, bias, gamma, beta)

公共子表达式消除

识别计算图中重复计算的表达式,只计算一次:

# 优化前

y1 = conv(x, w)

y2 = conv(x, w) # 重复计算

z = y1 + y2

# 优化后

y = conv(x, w)

z = y + y # 复用结果

死代码消除

移除未被使用的节点和边:

# 优化前

x = input()

y = conv(x, w) # y未被使用

z = relu(x)

output = z

# 优化后

x = input()

z = relu(x)

output = z

常量折叠

预计算常量表达式:

# 优化前

w1 = constant([1, 2, 3])

w2 = constant([4, 5, 6])

w = w1 + w2 # 运行时计算

output = conv(x, w)

# 优化后

w = constant([5, 7, 9]) # 编译时计算

output = conv(x, w)

3.3 内存管理功能

内存分配策略

graph-engine采用智能的内存分配策略:

- 生命周期分析:分析每个张量的生命周期(从创建到最后一次使用)

- 内存复用:将生命周期不重叠的张量分配到同一块内存

- 原地操作:对于某些算子,直接在输入内存上修改,避免额外分配

内存池管理

实现内存池机制,减少频繁的内存分配和释放:

class MemoryPool {

void* base_addr_; // 内存池基地址

size_t pool_size_; // 内存池大小

vector<MemoryBlock> blocks_; // 内存块列表

void* Allocate(size_t size);

void Free(void* ptr);

void Reset(); // 重置内存池

};

显存优化技术

针对昇腾AI处理器的HBM(高带宽内存)特点,采用特殊优化:

- 数据预取:提前将数据从HBM搬运到片上缓存

- 双缓冲:在计算当前batch时,预取下一个batch的数据

- 内存分片:将大张量分片存储,减少单次内存访问量

3.4 任务调度功能

拓扑排序

计算图的节点之间存在依赖关系,需要通过拓扑排序确定执行顺序:

vector<NodePtr> TopologicalSort(ComputeGraph* graph) {

vector<NodePtr> result;

queue<NodePtr> ready_nodes;

map<NodePtr, int> in_degree;

// 计算每个节点的入度

for (auto node : graph->nodes_) {

in_degree[node] = node->inputs_.size();

if (in_degree[node] == 0) {

ready_nodes.push(node);

}

}

// 拓扑排序

while (!ready_nodes.empty()) {

NodePtr node = ready_nodes.front();

ready_nodes.pop();

result.push_back(node);

for (auto output : node->outputs_) {

in_degree[output]--;

if (in_degree[output] == 0) {

ready_nodes.push(output);

}

}

}

return result;

}

并行策略

graph-engine支持多种并行策略:

数据并行

将输入数据分到多个NPU上并行处理:

Batch 32: [0-7] -> NPU0, [8-15] -> NPU1, [16-23] -> NPU2, [24-31] -> NPU3

算子并行

将不同的算子分配到不同的NPU上执行:

Layer1: NPU0, Layer2: NPU1, Layer3: NPU2, Layer4: NPU3

流水线并行

将模型切分为多个阶段,每个阶段在不同的NPU上执行:

Input -> [Stage1] -> [Stage2] -> [Stage3] -> [Stage4] -> Output

NPU0 NPU1 NPU2 NPU3

异步执行

利用昇腾AI处理器的异步执行能力:

// 创建执行流

Stream stream1 = CreateStream();

Stream stream2 = CreateStream();

// 在不同的流上异步执行算子

stream1.LaunchKernel(kernel1);

stream2.LaunchKernel(kernel2);

// 同步流

stream1.Synchronize();

stream2.Synchronize();

异步执行的优势:

- 隐藏延迟:数据传输和计算可以重叠执行

- 提高吞吐量:多个算子可以并行执行

- 充分利用硬件:充分利用NPU的计算单元

四、高级优化技术

4.1 自动调优

graph-engine实现了自动调优(Auto-tuning)机制,自动寻找最优的执行策略:

参数搜索空间

自动调优的搜索空间包括:

- 算子实现选择:同一个算子可能有多种实现

- 块大小选择:矩阵运算的块大小影响性能

- 并行度选择:确定最优的并行策略

- 内存布局选择:数据在内存中的布局方式

搜索算法

使用多种搜索算法:

- 网格搜索:穷举所有可能的参数组合

- 贝叶斯优化:基于概率模型进行智能搜索

- 遗传算法:模拟生物进化过程进行优化

- 强化学习:通过智能体学习最优策略

缓存机制

将调优结果缓存,避免重复搜索:

class AutoTunerCache {

map<string, TuningResult> cache_;

bool HasCache(const string& key);

TuningResult GetCache(const string& key);

void SetCache(const string& key, const TuningResult& result);

};

4.2 动态形状优化

针对动态形状输入(如变长序列)的特殊优化:

动态形状编译

为不同的形状生成专门的代码:

# 编译时生成多个版本的kernel

for shape in common_shapes:

compile_kernel(shape)

# 运行时根据输入形状选择合适的kernel

if input_shape == (32, 512, 768):

use_kernel_32_512_768()

elif input_shape == (64, 512, 768):

use_kernel_64_512_768()

形状自适应

在运行时根据输入形状动态调整执行策略:

def execute_with_dynamic_shape(input):

shape = input.shape

strategy = select_strategy(shape)

return execute(input, strategy)

4.3 混合精度执行

支持混合精度计算,在精度和性能之间取得平衡:

自动混合精度

自动选择合适的精度:

# 高精度层(分类层)

output_fp32 = conv_fp32(input, weight_fp32)

# 低精度层(特征提取层)

features_fp16 = conv_fp16(input, weight_fp16)

# 混合使用

result = combine(features_fp16, output_fp32)

精度感知优化

根据模型的精度要求调整策略:

if model.is_sensitive_to_precision():

use_fp32_for_sensitive_layers()

else:

use_fp16_for_all_layers()

五、实际应用案例

5.1 大规模图像识别系统

某互联网公司的图像识别系统,使用ResNet-152模型处理海量图片:

优化前

- 吞吐量:200 images/s

- 延迟:500ms per image

- GPU利用率:60%

使用graph-engine优化后

- 吞吐量:1500 images/s (提升7.5倍)

- 延迟:80ms per image (降低6.25倍)

- NPU利用率:95%

关键优化措施

- 算子融合:将Conv-BN-ReLU融合,减少30%计算时间

- 内存优化:通过内存复用,降低50%显存占用

- 并行策略:采用数据并行,充分利用多NPU

- 自动调优:自动选择最优的块大小和并行度

5.2 实时目标检测系统

智能交通监控系统,使用YOLOv5模型实时检测车辆:

优化前

- 帧率:15 fps

- 延迟:66ms per frame

- 精度:mAP 0.782

使用graph-engine优化后

- 帧率:60 fps (提升4倍)

- 延迟:16ms per frame (降低4.125倍)

- 精度:mAP 0.779 (仅下降0.003)

关键优化措施

- 流水线并行:将检测任务分为多个流水线阶段

- 异步执行:数据预处理和模型推理并行执行

- 动态形状支持:适应不同分辨率的输入图像

- 混合精度:使用FP16推理,速度提升2倍

5.3 自然语言处理系统

智能客服系统,使用BERT模型进行意图识别:

优化前

- QPS:200

- P99延迟:500ms

- 并发用户:50

使用graph-engine优化后

- QPS:5000 (提升25倍)

- P99延迟:200ms (降低2.5倍)

- 并发用户:1000 (提升20倍)

关键优化措施

- 算子融合:LayerNorm-Linear融合,减少40%计算时间

- 批处理优化:动态调整批大小,最大化吞吐量

- 缓存优化:缓存常见查询的结果

- 负载均衡:智能分配请求到不同的NPU

5.4 推荐系统

电商平台的个性化推荐系统,使用深度学习模型进行用户兴趣建模:

优化前

- P99延迟:100ms

- 吞吐量:10000 requests/s

- 模型复杂度:受限于性能

使用graph-engine优化后

- P99延迟:20ms (降低5倍)

- 吞吐量:50000 requests/s (提升5倍)

- 模型复杂度:可以使用更深的网络

关键优化措施

- 稀疏算子优化:针对稀疏特征的专门优化

- 内存预分配:提前分配内存,减少运行时开销

- 批处理优化:智能合并请求,提高批处理效率

- 模型分区:将大模型分区,分布到多个NPU

六、开发实践指南

6.1 图优化最佳实践

何时启用算子融合

- 推荐场景:Conv-BN-ReLU、LayerNorm-Linear等常见模式

- 注意事项:融合可能影响精度,需要验证

- 调试方法:使用可视化工具查看融合前后的图

内存优化建议

- 小模型:优先考虑减少内存占用

- 大模型:优先考虑最大化吞吐量

- 边缘设备:必须严格限制内存使用

并行策略选择

- 数据并行:适合数据量大、模型小的场景

- 算子并行:适合模型大、数据小的场景

- 流水线并行:适合深度网络、低延迟要求

6.2 性能调优技巧

使用Profiling工具

import cann.graph_engine as ge

# 启用性能分析

ge.enable_profiling()

# 执行模型

output = model(input)

# 获取性能数据

profiling_data = ge.get_profiling_data()

ge.print_profiling_report(profiling_data)

调整批大小

# 测试不同的批大小

for batch_size in [1, 2, 4, 8, 16, 32]:

latency = measure_latency(batch_size)

throughput = batch_size / latency

print(f"Batch={batch_size}: Latency={latency}ms, Throughput={throughput} req/s")

启用自动调优

# 配置自动调优

ge.enable_auto_tuning(

max_trials=100,

timeout=300,

cache_enabled=True

)

# 执行模型,自动调优会在后台进行

output = model(input)

6.3 常见问题与解决方案

问题1:图优化后精度下降

现象:启用图优化后,模型精度明显下降

解决方案:

- 禁用可能有问题的优化(如某些算子融合)

- 使用FP32而不是FP16

- 检查数值稳定性问题

- 使用更保守的优化策略

问题2:内存不足

现象:推理时出现OOM(Out of Memory)错误

解决方案:

- 减小批处理大小

- 启用梯度检查点(训练时)

- 使用模型并行,将模型分布到多个设备

- 检查是否有内存泄漏

问题3:性能未达预期

现象:graph-engine的性能低于理论值

解决方案:

- 检查数据传输是否成为瓶颈

- 确认算子融合是否生效

- 使用profiling工具找到瓶颈

- 尝试不同的并行策略

七、未来发展方向

7.1 智能化优化

graph-engine正在向更智能的方向发展:

- AI驱动的优化:使用机器学习自动选择最优策略

- 预测性调度:预测输入特征,提前准备资源

- 自适应执行:根据运行时环境动态调整策略

7.2 跨平台支持

增强对不同硬件平台的支持:

- 多厂商NPU:支持其他厂商的AI加速器

- CPU+GPU+NPU协同:异构协同计算

- 云边端协同:统一的编程模型

7.3 开发者体验

提升开发者使用体验:

- 可视化工具:图形化的图优化和性能分析工具

- 自动诊断:自动诊断性能问题和建议优化方案

- 一键优化:提供简单的API自动应用所有优化

八、性能基准测试

8.1 图优化效果对比

| 优化技术 | 模型 | 优化前延迟 | 优化后延迟 | 加速比 |

|---|---|---|---|---|

| 算子融合 | ResNet-50 | 50ms | 35ms | 1.43x |

| 内存优化 | BERT-Base | 40ms | 32ms | 1.25x |

| 并行策略 | YOLOv5s | 25ms | 12ms | 2.08x |

| 混合精度 | LSTM | 60ms | 30ms | 2.00x |

| 综合优化(全部) | ResNet-152 | 120ms | 40ms | 3.00x |

8.2 与其他引擎对比

| 引擎 | 模型 | 吞吐量 | 延迟 | 内存占用 |

|---|---|---|---|---|

| TensorFlow XLA | ResNet-50 | 800 img/s | 40ms | 4.5GB |

| TorchScript | ResNet-50 | 900 img/s | 38ms | 4.2GB |

| graph-engine | ResNet-50 | 1500 img/s | 26ms | 3.8GB |

九、总结

CANN graph-engine图计算引擎作为CANN平台的核心组件,通过高效的图转换、智能的图优化、精细的内存管理和优化的任务调度,为AI模型在昇腾AI处理器上的高效执行提供了坚实的基础。

其技术亮点包括:

- 统一的中间表示:支持多种深度学习框架

- 丰富的图优化技术:算子融合、死代码消除、常量折叠等

- 智能的内存管理:内存复用、原地操作、内存池

- 优化的任务调度:数据并行、算子并行、流水线并行

- 自动调优机制:自动寻找最优执行策略

随着技术的不断发展,graph-engine将继续演进,为AI应用提供更强大的性能和更好的开发体验。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)