使用OpenClaw+Ollama+1Panel本地化部署个人AI助理

通过上述步骤,我们依托“1Panel+Ollama+OpenClaw”开源三件套快速搭建了一个7X24小时不间断运行的本地AI助理。用户最终只需通过浏览器访问OpenClaw,即可畅享本地模型驱动的AI智能助理服务。全程操作以1Panel作为核心载体,无需复杂的命令行功底,所有配置流程均实现可视化和步骤化,即便是新手小白也能按照操作指南完成快速部署。经实测发现,当前本地模型在工具调用的灵活性上仍存

以1Panel开源面板为基础,搭配Ollama本地大模型(无需担心Token花销),手把手教您部署当下受到高度追捧的个人AI助理应用OpenClaw。通过这三款开源软件的组合,OpenClaw可以实现全天候的稳定运行,真正成为您的贴身专属智能助理!

一、资源准备

OpenClaw本地个人AI助理基于一台腾讯GPU云服务器构建,云服务器的获取过程不做赘述,详情参见腾讯云官网。其中云服务器的配置如下:

■ 操作系统:Ubuntu Server 24.04 LTS 64位

■ 计算资源:20核80G

■ 磁盘容量:100GB

■ GPU:计算型GN7(GN7.5XLARGE80)

■ 网络:绑定弹性公网IP

二、操作过程概览

基于1Panel开源面板搭建本地化OpenClaw主要涉及五个步骤,具体如下:

■ 第一步:1Panel的安装部署;

■ 第二步:GPU资源调度配置;

■ 第三步:Ollama的安装部署;

■ 第四步:gpt-oss:20b开源模型加载;

■ 第五步:OpenClaw安装部署及配置

三、详细操作步骤说明

1. 1Panel的安装部署

1Panel的安装部署比较简单,可参照官方文档进行在线安装:https://1panel.cn/docs/v2/installation/online_installation/ 。

步骤一:获取root权限,登录服务器后首先切换至root权限。

sudo su -步骤二:输入在线安装命令执行安装操作。

bash -c "$(curl -sSL https://resource.fit2cloud.com/1panel/package/v2/quick_start.sh)"步骤三:Docker的安装,指定安装目录并安装Docker。

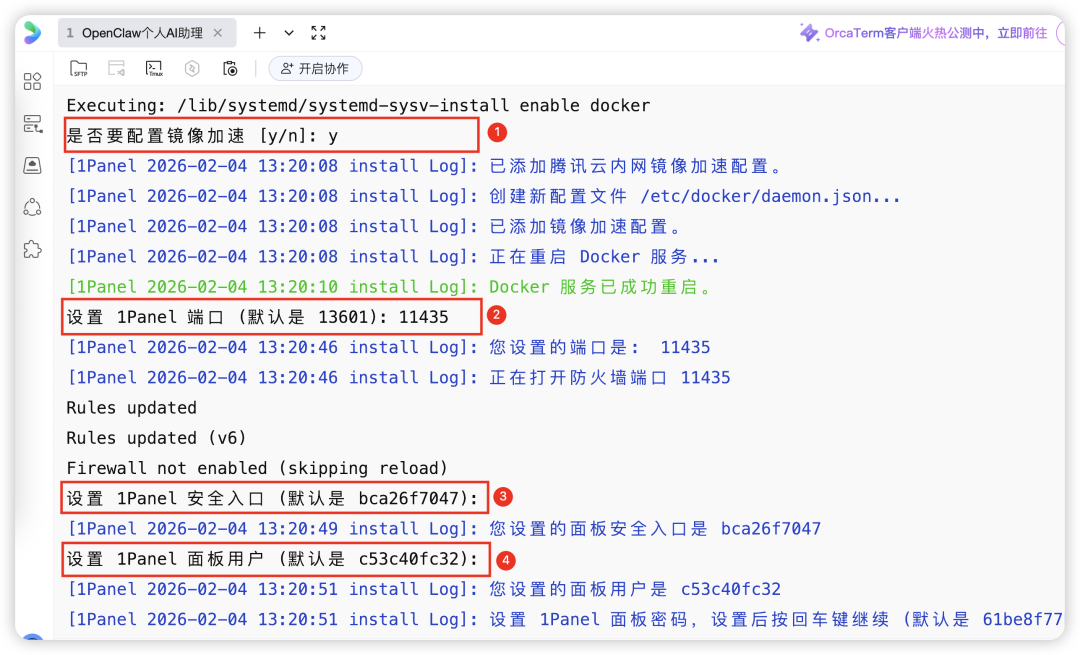

步骤四:镜像加速器配置。选择配置镜像加速器,并设置1Panel面板的访问参数。

步骤四:镜像加速器配置。选择配置镜像加速器,并设置1Panel面板的访问参数。

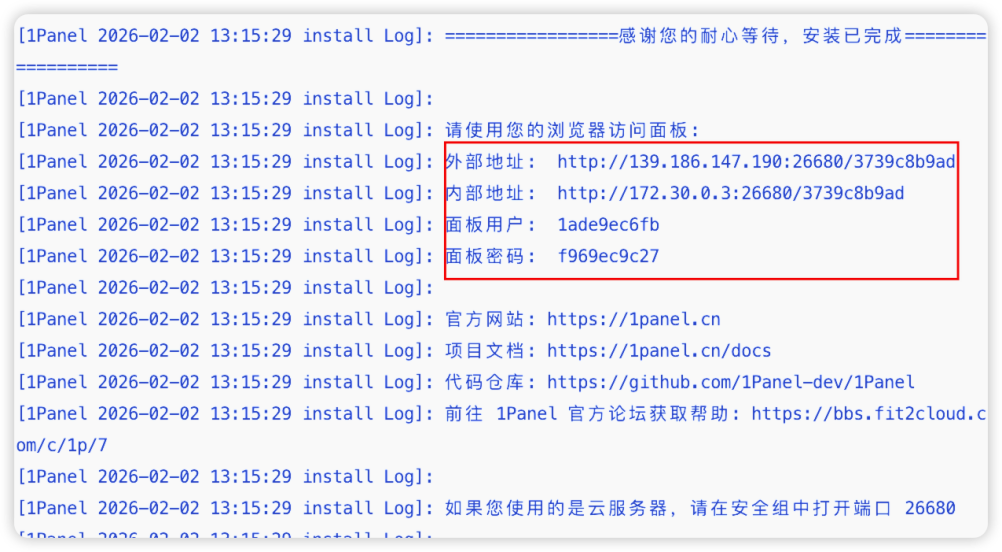

步骤五:获取1Panel面板的登录信息。

步骤六:验证1Panel部署成功。将外部地址输入浏览器进入1Panel登录页面,输入对应的面板用户和密码,确认安装完成。

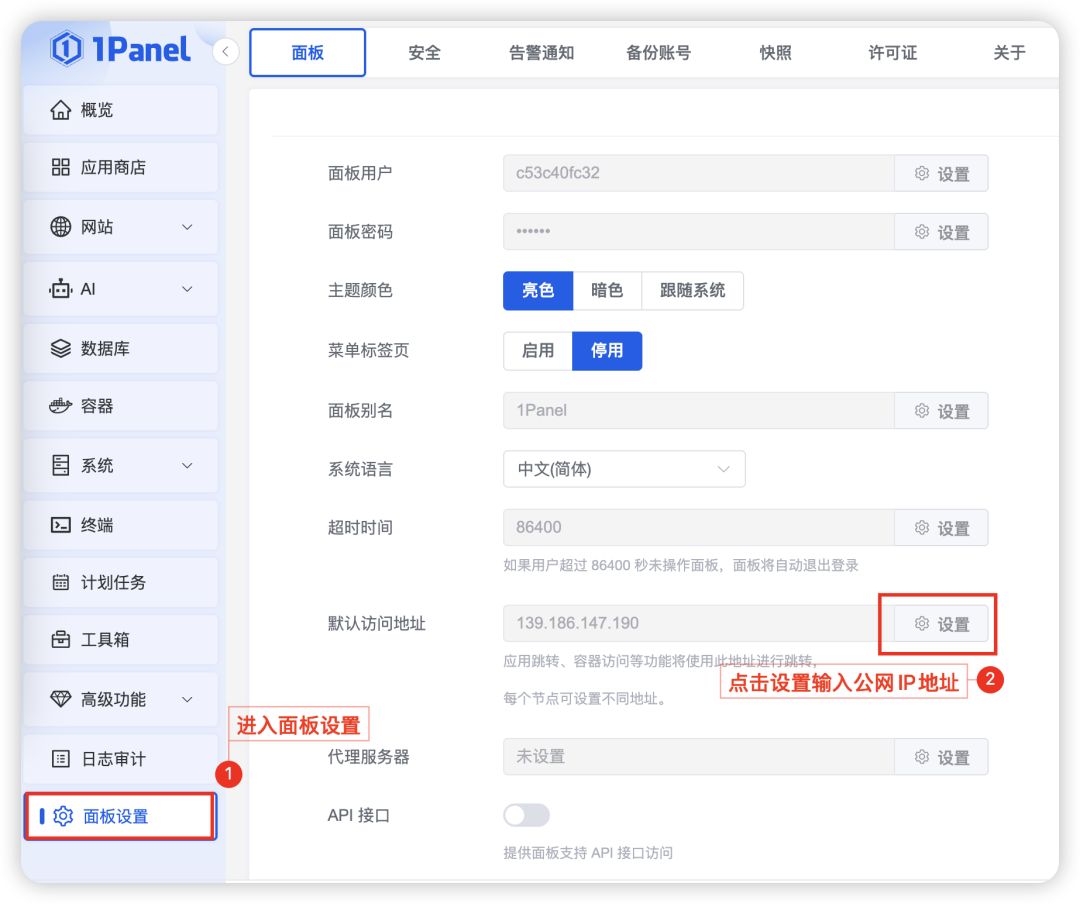

步骤七:1Panel访问地址设置。进入1Panel面板后,切换到“面板设置”页面,将默认访问地址设置为1Panel访问的公网IP,方便后续部署的应用可以通过点击“跳转”按钮进行访问。

2. GPU资源调度配置

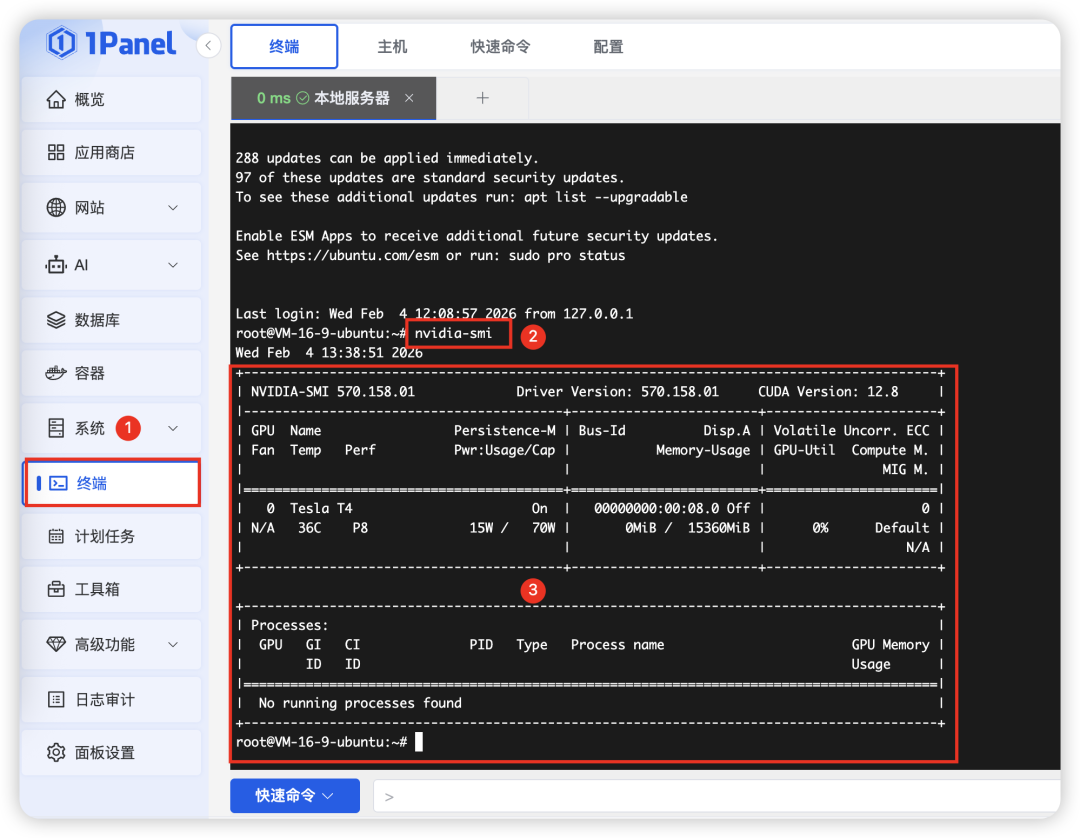

进入1Panel的“终端”页面,完成NVIDIA容器镜像的配置,最终让基于容器安装的模型能够调度GPU资源。

步骤一:NVIDIA显卡驱动确认。需要确保NVIDIA显卡驱动已正确安装,输入以下命令:

nvidia-smi如果结果如下图所示,则代表显卡驱动已经成功安装。如果没有安装则自行前往英伟达官网下载驱动文件并安装:

https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html#installing-with-apt。

步骤二:安装NVIDIA容器镜像。为了能够在Docker容器中使用GPU资源,我们需要安装NVIDIA的容器镜像,参照如下命令行逐个执行操作:

- 命令行1:添加NVIDIA容器工具仓库与签名(注意,请确保网络能够正常访问GitHub)

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \

&& curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list- 命令行2:启用仓库中的experimental组件(可选)

sed -i -e '/experimental/ s/^#//g' /etc/apt/sources.list.d/nvidia-container-toolkit.list- 命令行3:更新软件源

sudo apt-get update- 命令行4:安装nvidia-container-toolkit

sudo apt-get install -y nvidia-container-toolkit步骤三:配置Docker镜像使用NVIDIA。安装完容器镜像后,需要配置Docker以使用NVIDIA的GPU资源,并且重启Docker服务。

- 命令行1:配置Docker以使用NVIDIA

sudo nvidia-ctk runtime configure --runtime=docker- 命令行2:重启Docker

sudo systemctl restart docker3. Ollama的安装部署

安装好1Panel,并且配置好服务器的GPU资源后,我们就可以基于1Panel开源面板进行OpenClaw个人AI助理的本地化安装部署了。操作非常简单,小白也能轻松上手。

首先我们来安装Ollama。Ollama是一个开源的大型语言模型服务,提供了类似于OpenAI的API接口和聊天界面,可以非常方便地部署最新版本的gpt-oss模型。

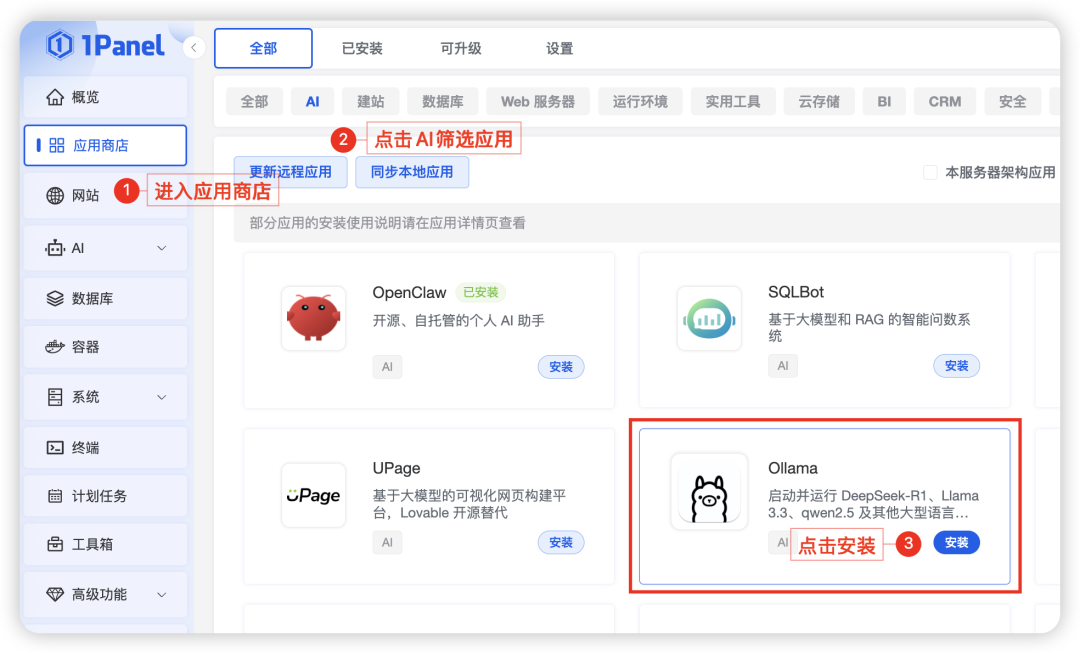

步骤一:安装Ollama应用。首先我们进入1Panel应用商店,在AI分类中找到“Ollama”并点击“安装”按钮。

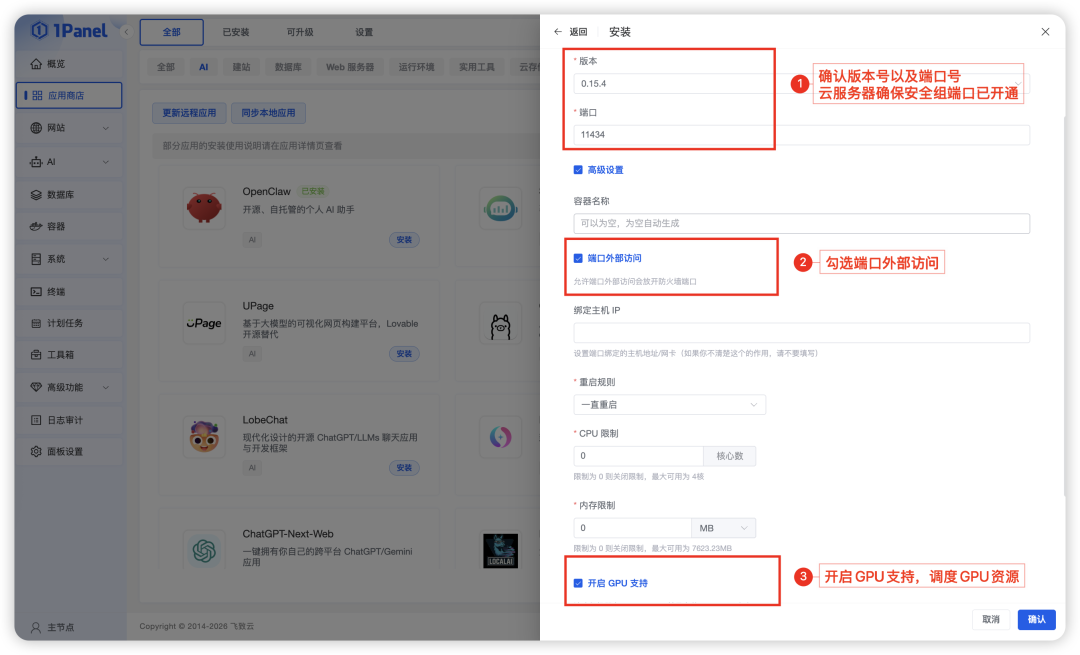

步骤二:设置Ollama安装参数。配置安装参数时需要确认版本号以及端口号,另外记得勾选“端口外部访问”选项,同时勾选“开启GPU支持”选项,以确保后续我们可以正常访问Ollama,同时模型可使用GPU资源,其他参数保持默认,点击“确认”按钮即可。

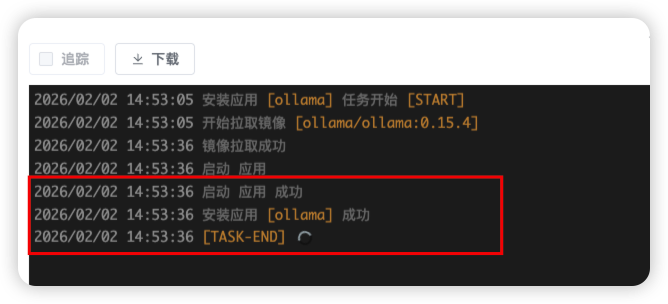

步骤三:下载镜像并安装Ollama。点击“确认”按钮后,系统开始自动拉取镜像并安装应用,直到系统提示“安装应用「ollama」成功”,则代表已经完成Ollama安装。

步骤四:验证Ollama安装是否成功。在1Panel应用商店的“已安装”页面,找到Ollama应用,点击“跳转”按钮,确认输出内容为“Ollama is running”,则代表Ollama已经部署成功。

4. 本地大模型部署

Ollama部署完成后,我们继续通过1Panel来完成基于Ollama本地gpt-oss:20b模型的加载部署,参照如下步骤即可实现。

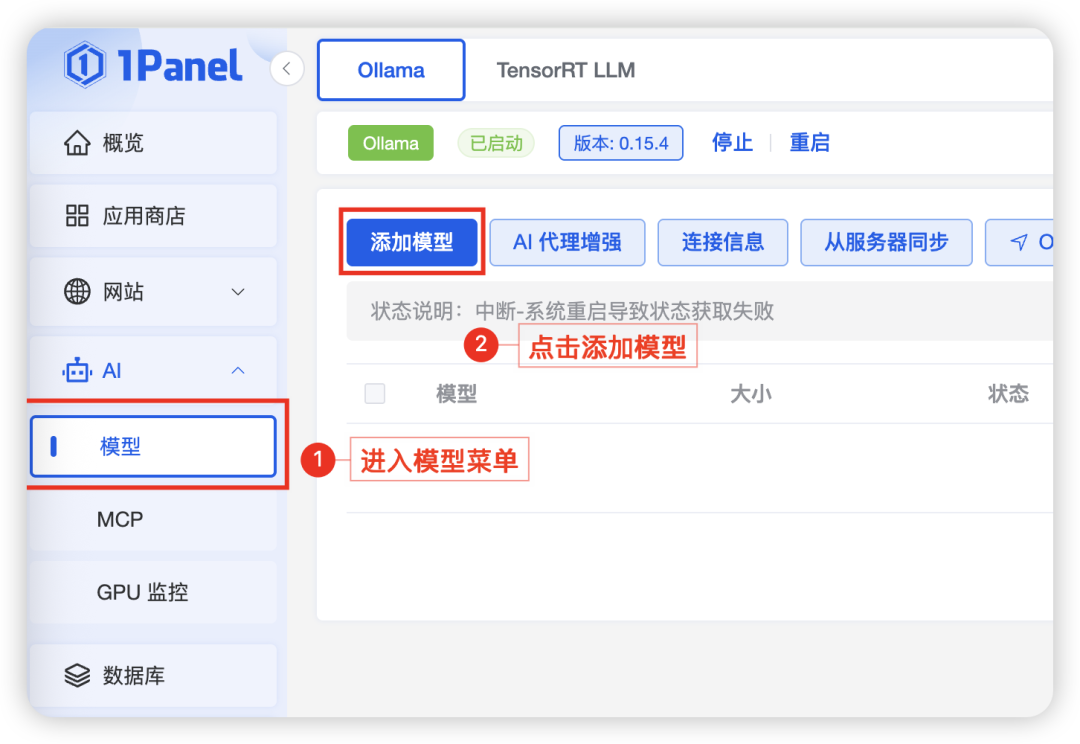

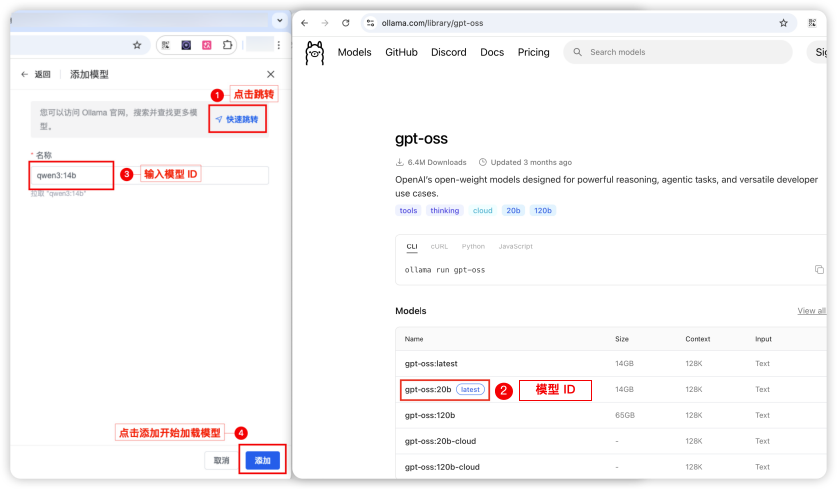

步骤一:创建gpt-oss模型。在1Panel中依次选择“AI”→“模型”,点击“添加模型”按钮。

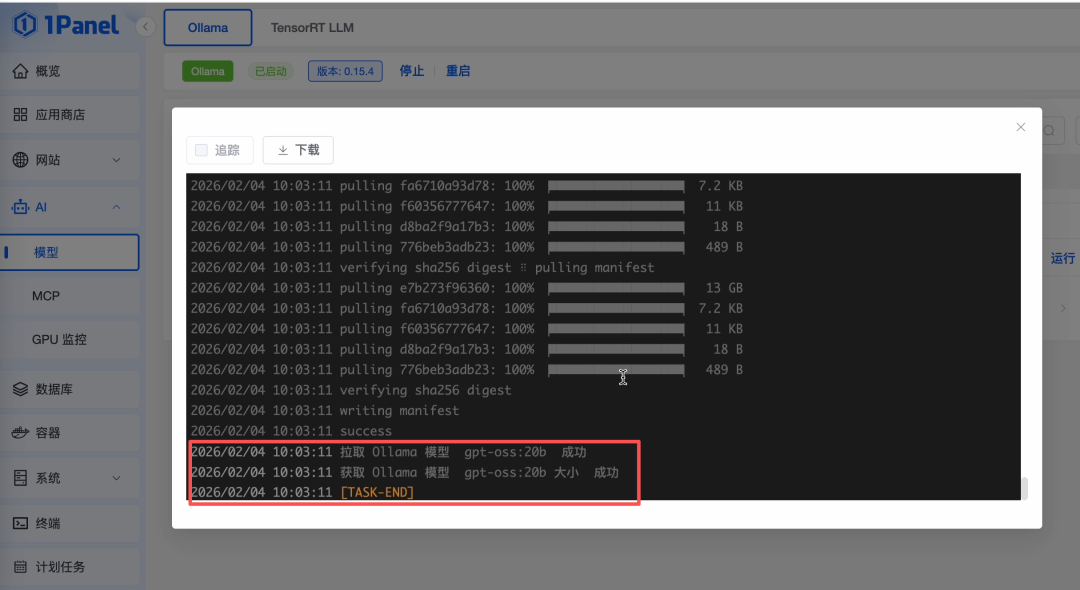

步骤二:加载模型。如下图所示点击“快速跳转”链接访问Ollama官网,输入模型名称“gpt-oss”快速搜索到gpt-oss模型,并复制模型ID“gpt-oss:20b”输入到1Panel“添加模型”页面的“名称”栏目中,点击“添加”按钮开始加载模型文件。注意,模型加载大概需要20至30分钟。

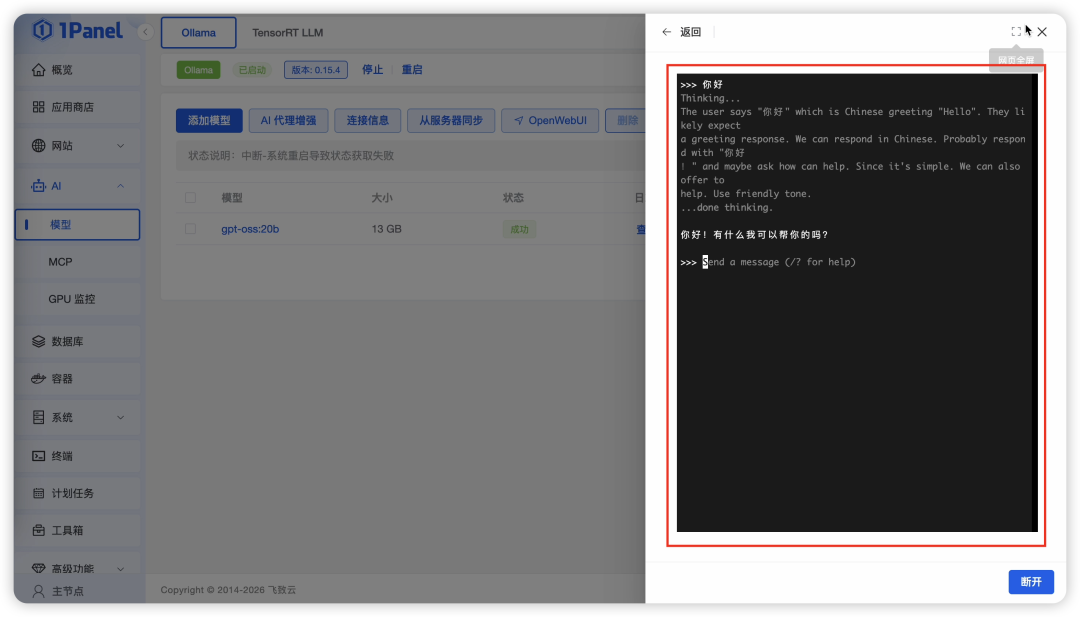

步骤三:模型运行确认。当模型列表中的“状态”项更新为“成功”后,可以点击“运行”按钮验证模型部署效果。如果能够正常对话则代表模型已经加载成功,如下图所示:

5. OpenClaw的安装部署

基于以上步骤,我们已经完成了本地模型的准备工作,接下来我们继续通过1Panel快速搭建OpenClaw个人AI助理。

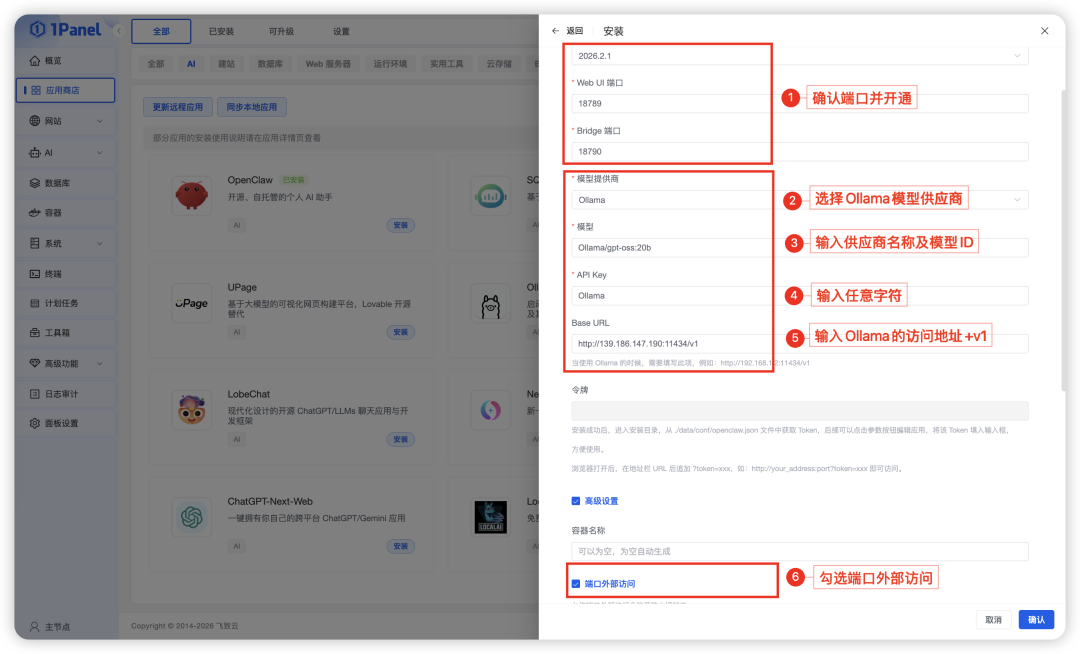

步骤一:安装OpenClaw应用。进入1Panel应用商店,找到OpenClaw应用并点击“安装”按钮,进入安装参数设置页面。

步骤二:设置应用安装参数,如下图设置OpenClaw的版本号及端口、Ollama本地模型以及是否进行外部访问等配置项,设置完成后点击“确认”按钮开始安装。其中安装参数的具体说明如下:

■ 版本:OpenClaw版本默认为最新版本;

■ 端口:OpenClaw应用访问端口默认为18789、18790,如有占用可自行调整变更,最终需要确保端口已开通,可进行外部访问;

■ 模型供应商:下拉选择“Ollama”;

■ 模型:按照“Ollama/模型”格式输入(即模型管理中添加的模型ID),例如Ollama/gpt-oss:20b;

■ 模型API Key:本地模型输入任意字符即可;

■ Base URL:输入按照上述步骤部署的Ollama应用的地址,即http://IP:11434/v1即可;

■ 端口外部访问:勾选“端口外部访问”选项,方便后续OpenClaw应用进行访问。

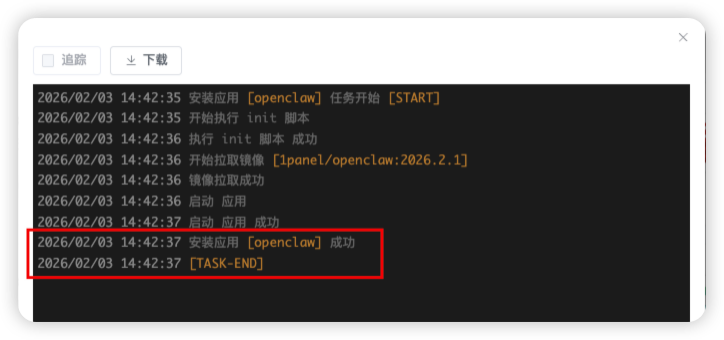

步骤三:OpenClaw应用安装。参数设置完成后点击“确认”按钮,系统自动开始拉取镜像并安装应用,看到下图所示信息则代表OpenClaw应用已安装成功。

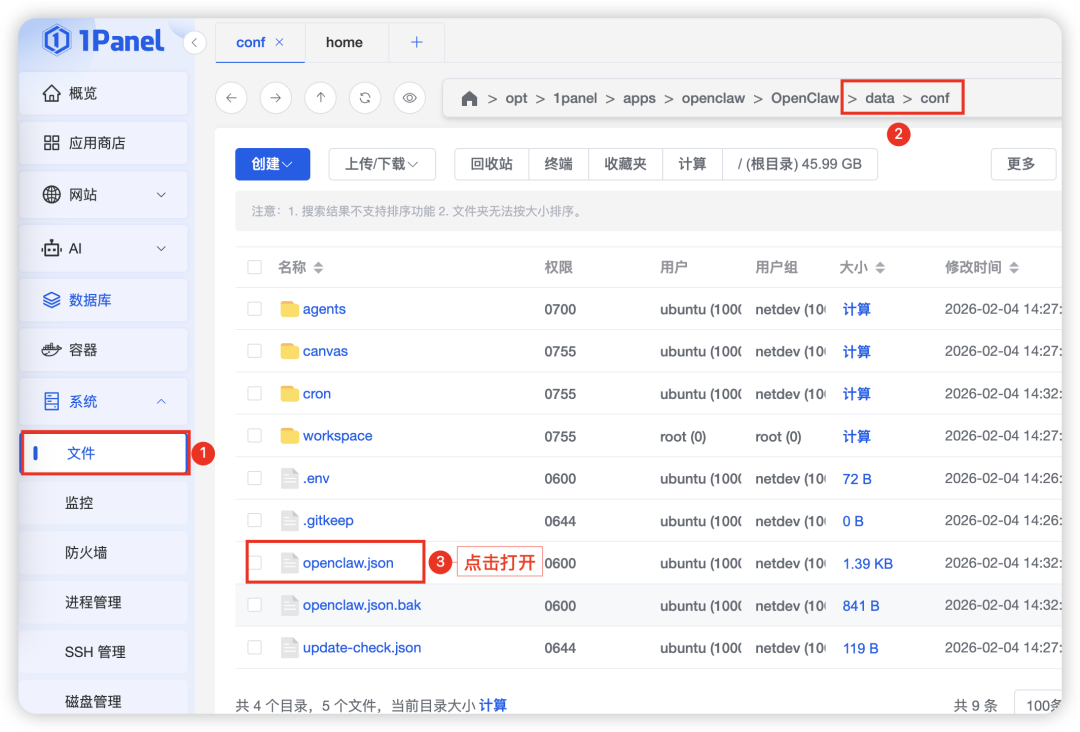

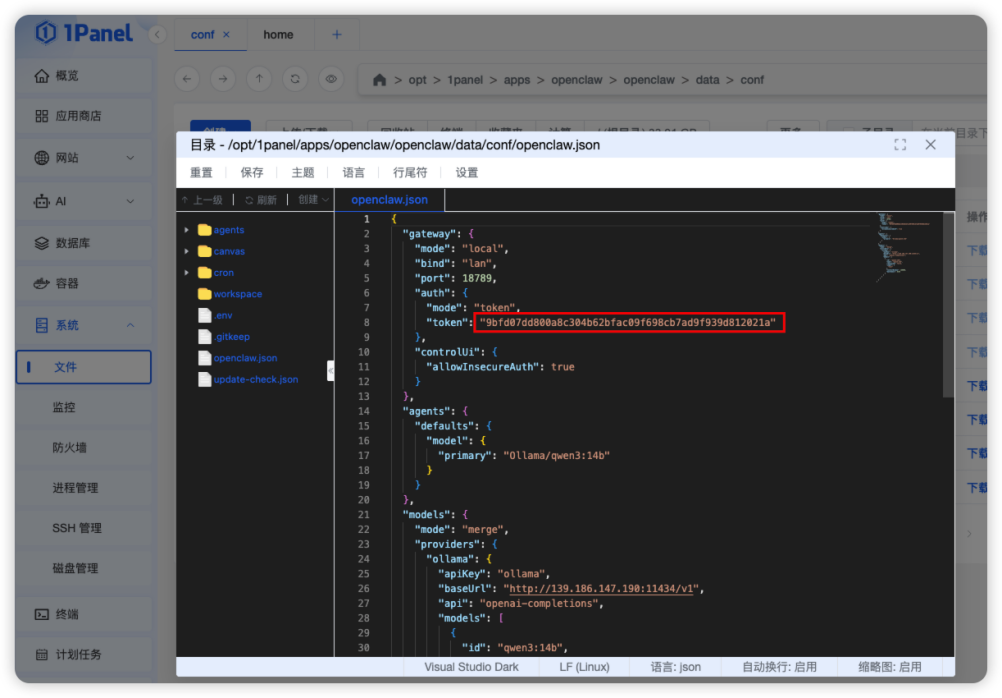

步骤四:应用Token获取。在1Panel应用商店的“已安装”页面找到已经安装好的OpenClaw,点击“进入目录”按钮,进入data/conf目录,找到openclaw.json文件并点击打开。在该文件中找到“gateway”中的“token”复制其中的Token值,例如9bfd07dd800a8c304b62bfac09f698cb7ad9f939d812021a。

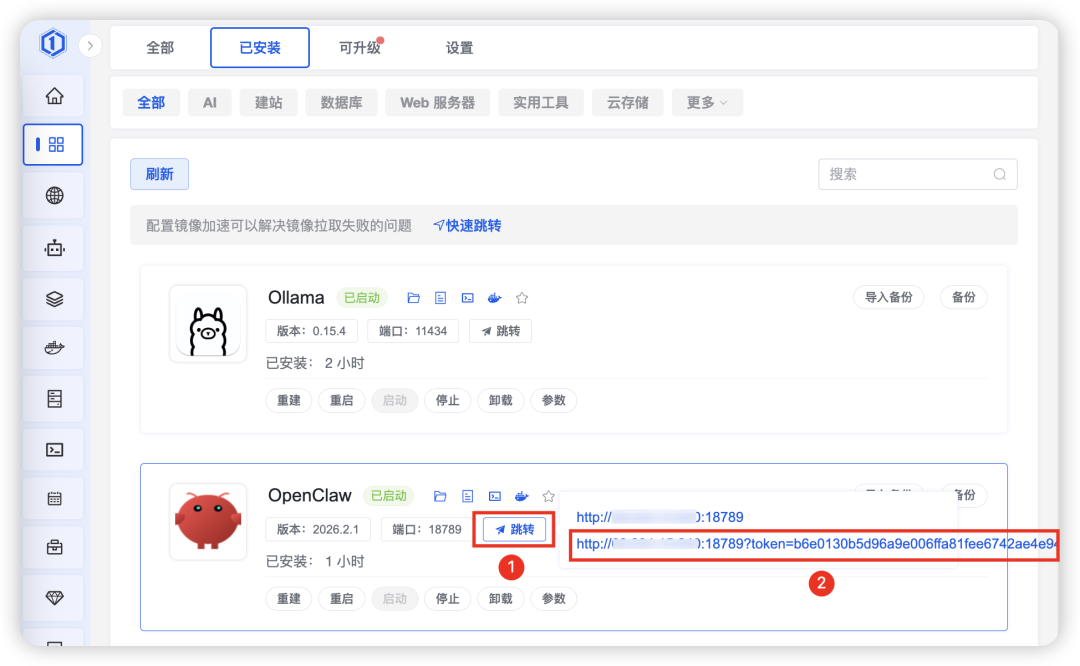

步骤五:Web应用访问设置。如下图所示,点击“参数”按钮,将获取到的Token与IP地址,以及端口号按照“IP:端口?token={token}具体值”的方式进行拼接,例如

139.186.147.190:18789?token=9bfd07dd800a8c304b62bfac09f698cb7ad9f939d812021a,拼接完成后填写在“Web访问地址”栏目中。

四、OpenClaw个人AI助理的使用效果

完成上述操作后,我们就基于1Panel完成了OpenClaw个人AI助理应用的搭建。直接进入1Panel应用商店的“已安装”页面,找到OpenClaw,点击“跳转”按钮,选择带有Token的链接地址点击即可体验OpenClaw的神奇魔力。

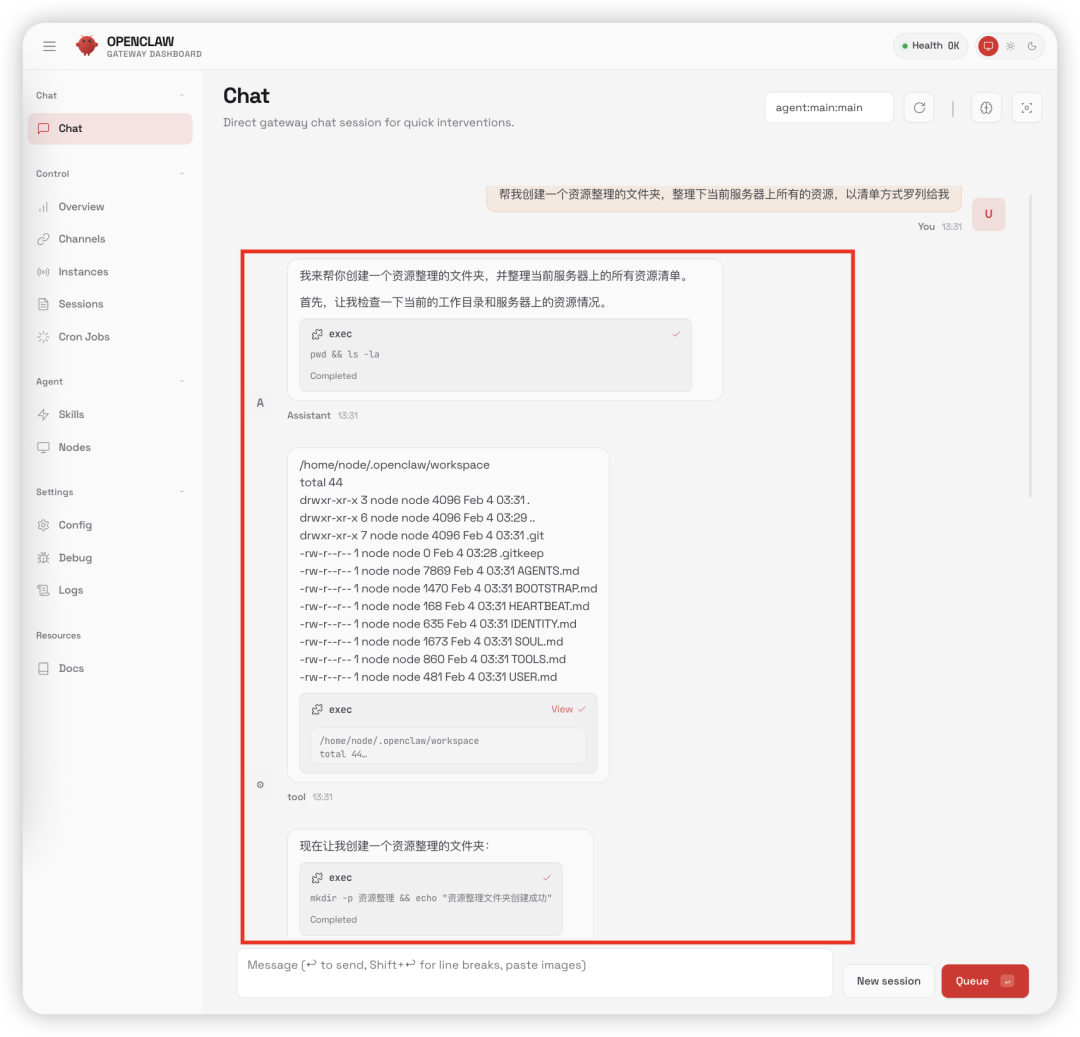

我们可以把一些简单的事情交给AI助理去完成,比如让AI帮助我们对服务器上的文件进行整理和分类:

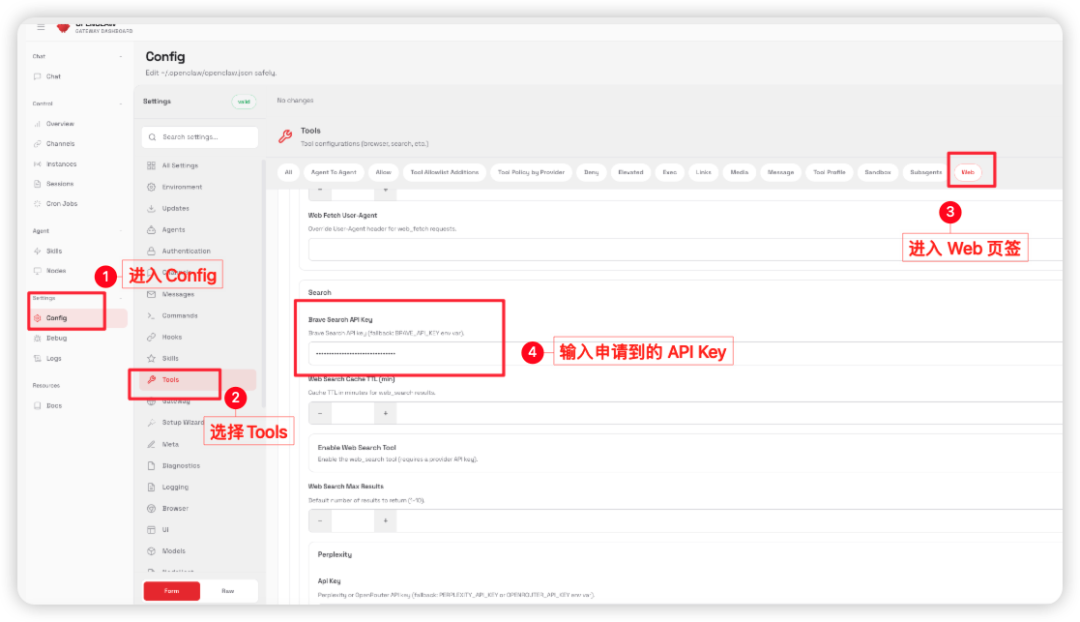

另外,如果我们需要让AI助理进行一些联网操作,需要到https://brave.com/网站申请一个API Key,然后进入OpenClaw的Config/Web/Search页面输入Brave Search API Key。

五、总结

通过上述步骤,我们依托“1Panel+Ollama+OpenClaw”开源三件套快速搭建了一个7X24小时不间断运行的本地AI助理。用户最终只需通过浏览器访问OpenClaw,即可畅享本地模型驱动的AI智能助理服务。全程操作以1Panel作为核心载体,无需复杂的命令行功底,所有配置流程均实现可视化和步骤化,即便是新手小白也能按照操作指南完成快速部署。

经实测发现,当前本地模型在工具调用的灵活性上仍存在一些局限性,当前主要推荐gpt-oss:20b模型。OpenClaw、Ollama等开源项目正在持续迭代和优化,相信其他主流模型也会很快得到优化和改善,未来基于OpenClaw的本地化AI助理的功能性会愈发强大,成为我们生活和工作的好帮手。

需要说明的是,这套本地化AI助理应用搭建方案无需依赖外部Token,数据隐私更有保障,诚邀大家动手实操体验,感受“开源三件套”工具带来的高效智能服务。

更多推荐

已为社区贡献25条内容

已为社区贡献25条内容

所有评论(0)