为什么你的AI Agent总是互相打架?看完OpenClaw的仲裁机制我沉默了

多Agent系统协作难题的核心在于缺乏仲裁机制。OpenClaw项目通过中央仲裁模式解决了传统多Agent系统中常见的资源争抢、输出冲突和死循环问题,其关键设计包括优先级队列、资源锁机制和冲突检测回滚功能。该项目在Sealos云平台上可实现快速部署,显著简化了多Agent系统的编排与管理。实践表明,清晰的协作规则比提升单个Agent智能更重要,这一思路对团队管理同样具有启示意义。OpenClaw为

为什么你的AI Agent总是互相打架?看完OpenClaw的仲裁机制我沉默了

上周我的多Agent系统又崩了。

三个Agent同时抢一个API配额,互相覆盖对方的输出,最后生成了一份四不像的报告。我盯着屏幕,感觉自己像个幼儿园老师在拉架。

直到我发现了OpenClaw这个项目,才意识到问题出在哪——不是Agent不够聪明,是裁判不存在。

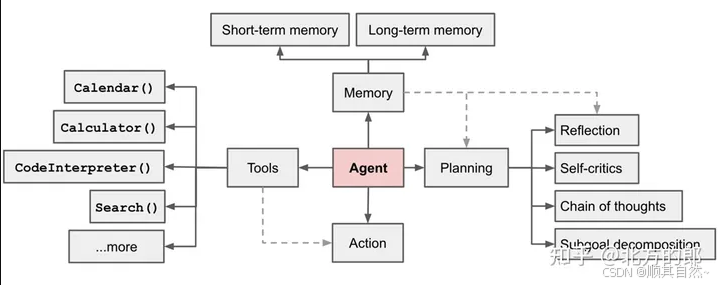

你的Agent为什么总在"内战"

先说个扎心的事实:大多数人搭建多Agent系统的方式,本质上就是把几个聪明人关进同一个房间,然后说"你们商量着来吧"。

结果可想而知:

-

资源争抢:两个Agent同时调用同一个工具,互相阻塞

-

输出冲突:A说往东,B说往西,系统不知道听谁的

-

死循环:Agent互相等待对方的结果,谁都不动

我之前用LangGraph搭了个内容生产流水线,研究Agent负责找资料,写作Agent负责成文,审核Agent负责把关。听起来很美好,实际运行时经常出现研究Agent还没输出完,写作Agent就开始写了,最后审核Agent收到的是残缺的内容。

这不是Agent的问题,是编排层的缺失。

OpenClaw的思路:先有裁判,再有比赛

翻了下GitHub上OpenClaw的代码,它的核心设计让我眼前一亮。

传统做法是让Agent自己协商(peer-to-peer),OpenClaw选择了中央仲裁模式。简单说就是:所有Agent不能直接对话,必须通过一个"仲裁层"来调度。

它的调度算法有几个关键点:

1. 优先级队列而非先来先得

不是谁先发请求谁先执行,而是根据任务的依赖关系动态排序。比如写作Agent依赖研究Agent的输出,那研究任务的优先级自动提升。

2. 资源锁机制

同一个外部工具(比如搜索API)同一时间只能被一个Agent占用,其他Agent自动进入等待队列。这解决了我之前遇到的配额争抢问题。

3. 冲突检测与回滚

当两个Agent的输出产生矛盾时,系统不是随机选一个,而是根据预设的置信度规则做决策,必要时回滚到上一个稳定状态。

说白了,OpenClaw把"多Agent协作"从自由市场变成了有规则的博弈。

我在Sealos上跑通的完整过程

说实话,最初我是想本地跑的,但OpenClaw依赖的组件有点多——Redis做消息队列、PostgreSQL存状态、还要配置向量数据库。光是环境搭建就折腾了两小时。

后来发现Sealos已经做了模板支持,整个部署流程压缩到了几分钟。

部署步骤

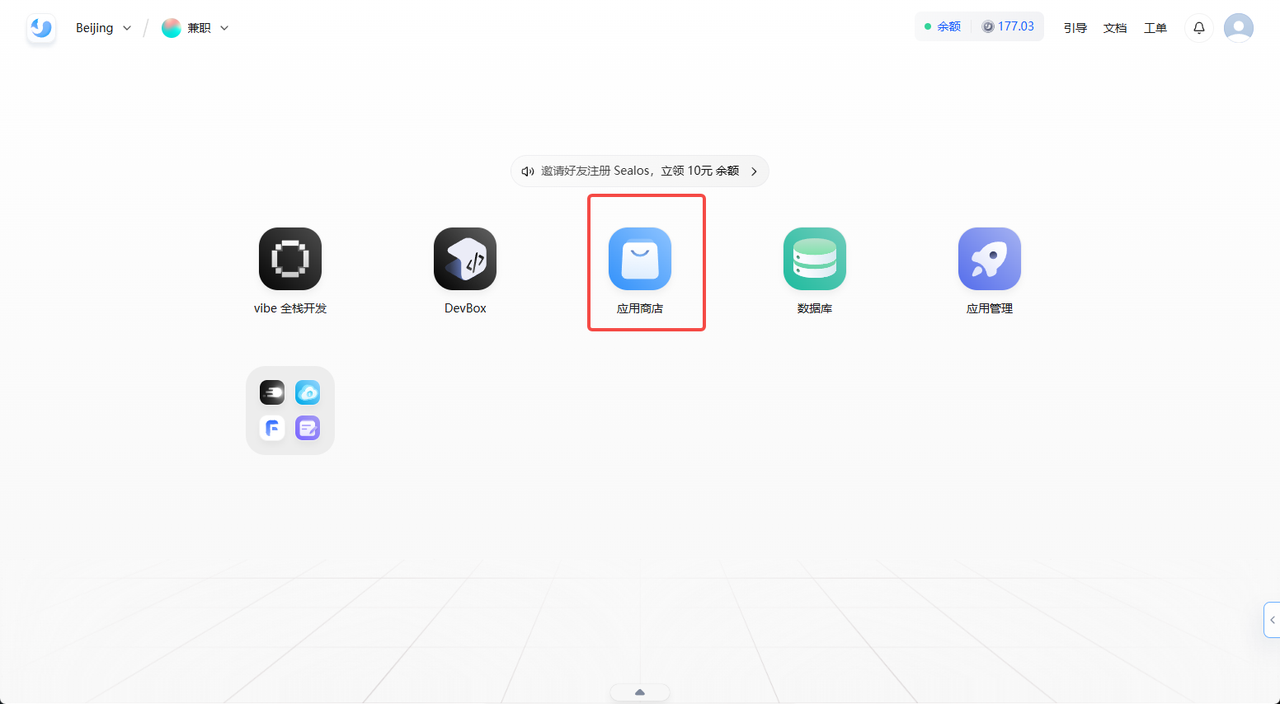

第一步:进入Sealos应用市场

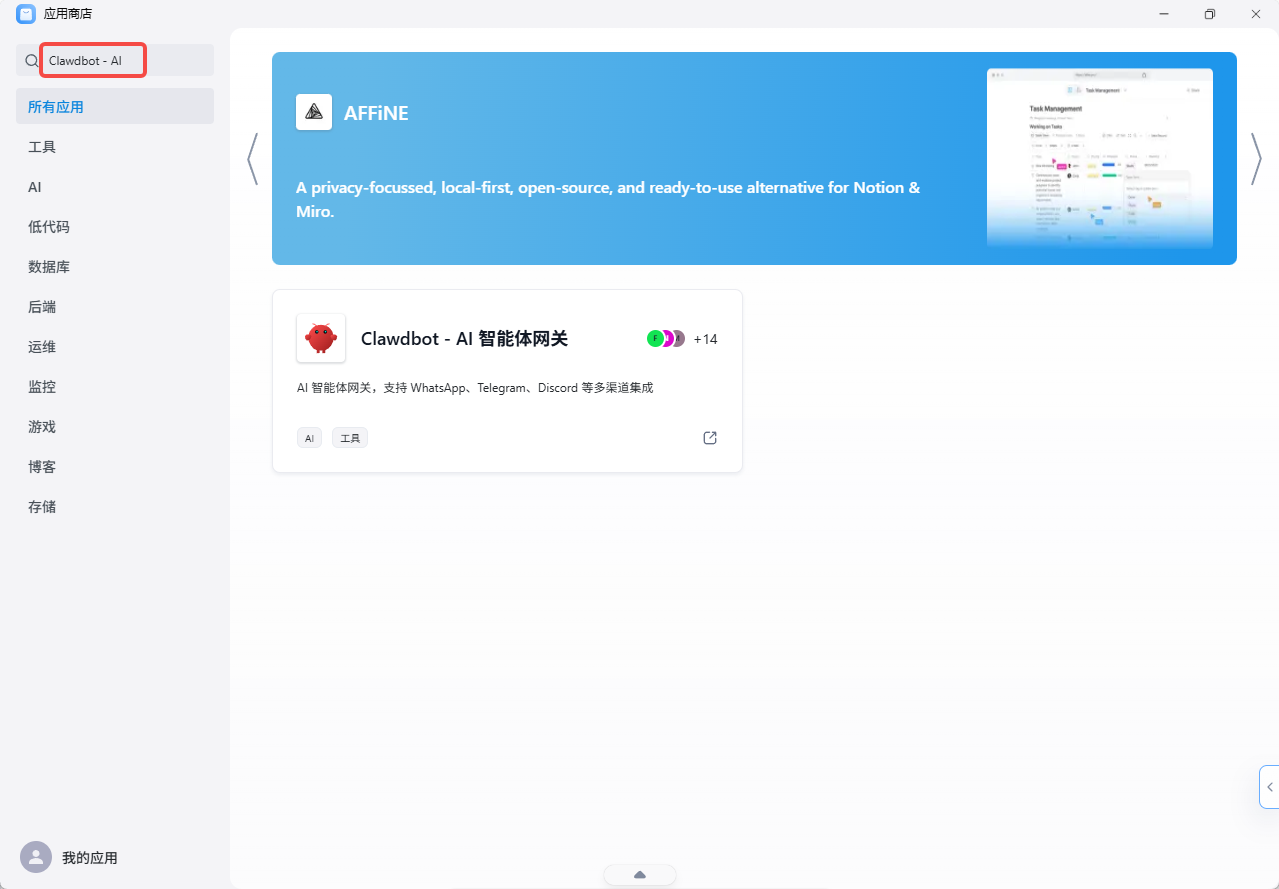

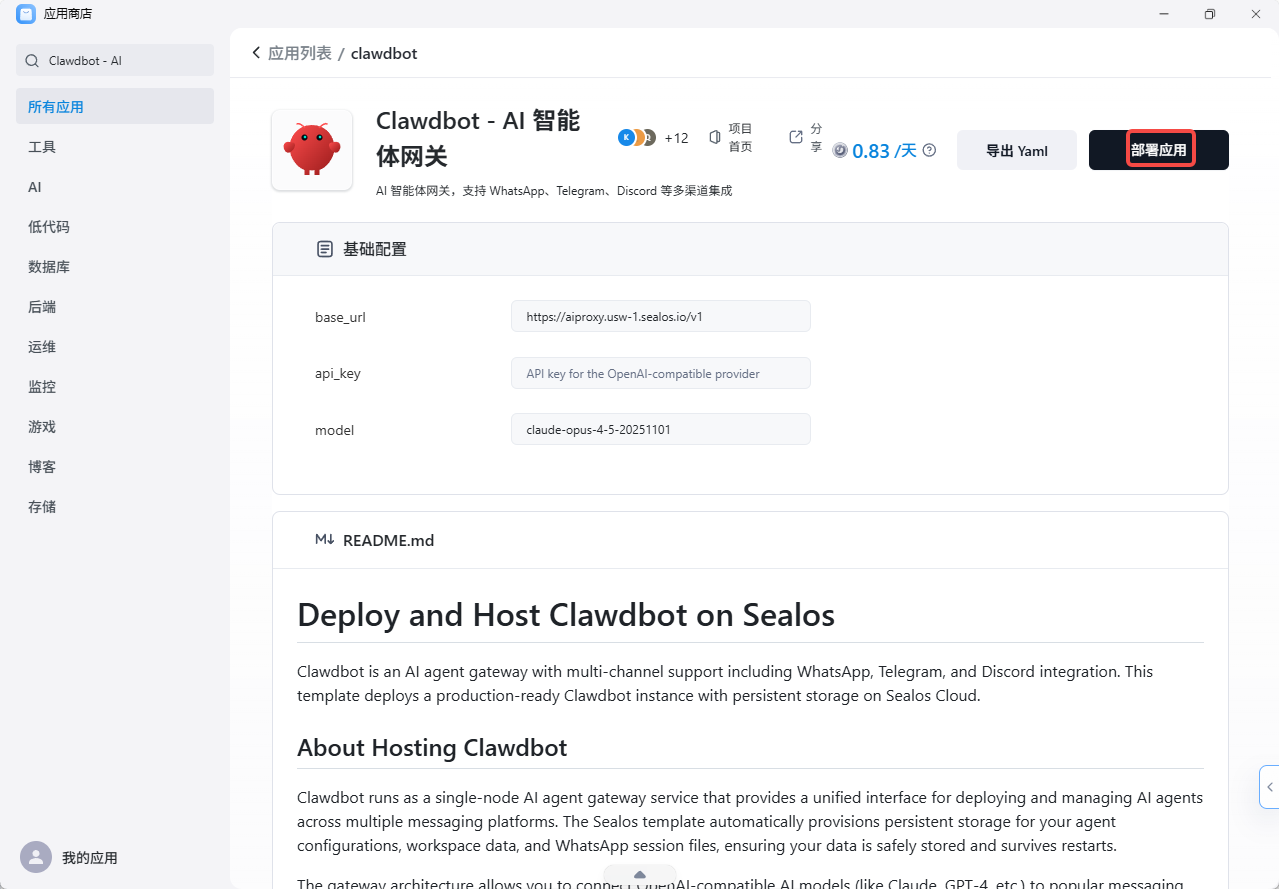

打开 Sealos Cloud,在应用市场搜索"Clawdbot - AI 智能体网关 ",能看到官方模板。

第二步:一键部署

第二步:一键部署

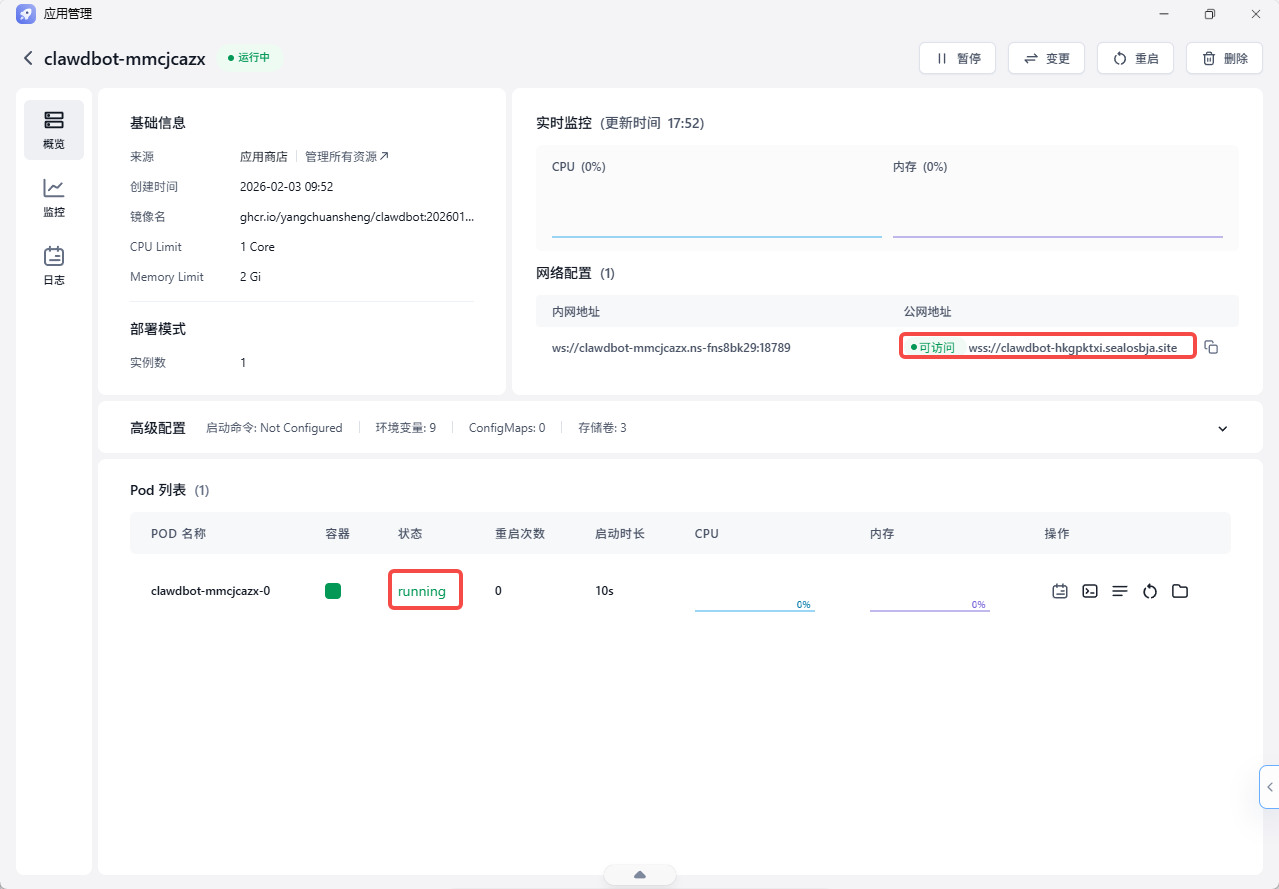

点击部署后,系统会自动拉起:

-

OpenClaw主服务

-

Redis实例(用于Agent间通信)

-

PostgreSQL实例(存储任务状态和历史)

不需要手动配置网络、存储这些,模板都预设好了。

第三步:配置你的Agent

部署完成后会给你一个访问地址,进去后在Dashboard里添加Agent。每个Agent需要配置:

-

名称和职责描述

-

调用的工具列表

-

优先级权重

第四步:定义编排规则

这是关键。你需要告诉系统Agent之间的依赖关系,比如"B必须等A完成后才能启动"。OpenClaw用的是一种简化的DAG(有向无环图)配置,比自己写代码直观很多。

整个过程大概10分钟,如果在本地从零搭建,保守估计要半天。

实测体验:爽点和坑

跑了一周,说说真实感受。

爽点:

-

再也没出现Agent"打架"的情况,任务队列清清楚楚

-

调试变简单了,每个Agent的输入输出都有日志,出问题能快速定位

-

Sealos的计费是按实际用量,我这种间歇性使用的场景比包月服务器省不少

坑点:

-

文档还不够完善,有些高级配置得翻源码才能搞懂

-

冷启动有点慢,第一次调用Agent大概要等5-8秒

-

目前只支持文本类任务,多模态场景还在开发中

最后说句实在的

多Agent系统的难点从来不是单个Agent的能力,而是协作的秩序。

OpenClaw给我最大的启发是:与其让Agent变得更聪明,不如让规则变得更清晰。这思路放到团队管理上也成立——一群聪明人如果没有好的协作机制,产出可能还不如一个普通团队。

如果你也在折腾多Agent项目,建议先花10分钟在Sealos上把OpenClaw跑起来,感受下"有仲裁"和"没仲裁"的区别。

这东西说再多不如自己试一把。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)