Giskard与DeepEval:AI质量测试的终极指南

摘要:本文深入剖析Giskard和DeepEval两款AI质量测试工具的核心价值,纠正常见认知偏差。Giskard不仅是报告生成器,更是具备静态扫描+动态验证的全链路质量管家,能穿透数据层、模型层和结果层风险;DeepEval则通过可配置指标和断言机制,将主观的LLM评测转化为可量化、工程化的标准流程。文章对比了两款工具的定位差异:Giskard适用于多模型全流程管控,DeepEval专注LLM评

别只当“报告工具”!Giskard与DeepEval底层逻辑拆解,纠正90%人的认知偏差

AI模型上线前,是不是也踩过这样的坑:靠人工核对结果效率极低,想证明模型质量却拿不出靠谱依据,好不容易找到两款评测工具,却只用到了皮毛功能?

Giskard和DeepEval是当下最火的两款AI质量测试工具,很多人对它们的认知停留在“生成报告”“集成测试”的表层——比如觉得Giskard只是用来出HTML报告给老板看,DeepEval仅能对接Pytest做单元测试。但这两款工具的核心价值远不止于此,今天我们拆解底层逻辑,矫正片面认知,帮真正用对工具、守住AI质量底线。

一、Giskard:不止是“报告生成器”,更是全链路AI质量管家

先矫正一个核心认知偏差

提到“把模型和数据喂给Giskard,它能自动生成HTML分析报告”,这句话没错,但报告只是结果呈现,不是核心功能。很多人忽略了:Giskard的核心是“主动检测+风险预警+测试闭环”,生成报告只是它将检测结果标准化、可视化的手段,而非最终目的。

如果只把它当“报告工具”用,相当于买了一台精密检测仪,却只用来打印检测单,完全浪费了它的核心能力。

底层逻辑:静态扫描+动态验证,全维度穿透模型风险

Giskard之所以能成为开源AI质量管理的“标杆”,核心是它构建了“数据层→模型层→结果层”的三层检测体系,底层依赖两大核心机制:

-

规则驱动+语义理解的双重扫描:它不仅会基于预定义的AI风险规则(比如幻觉、偏见、鲁棒性不足的典型特征)扫描数据和模型输出,还会通过语义分析挖掘隐性问题——比如LLM生成内容的事实一致性偏差、分类模型对小众群体的歧视性预测,这些是单纯统计分析无法发现的。

-

动态测试与静态评估结合:静态层面,它会分析数据集的分布偏差、缺失值影响、异常样本占比;动态层面,它会模拟模型在不同输入下的响应(比如修改输入文本的关键词、调整数值精度),验证模型的稳定性——这也是它能精准识别“鲁棒性差”的关键。

重新理解它的核心功能(纠正片面解读)

-

自动扫描(Scan):不止是生成HTML报告,核心是“自动化风险诊断”——报告里的每一项结论,都对应着模型或数据的具体问题,还会给出初步优化建议(比如“某类样本缺失导致偏见,建议补充数据”),帮定位问题而非单纯展示结果。

-

漏洞检测:范围远不止幻觉、偏见、鲁棒性差。它还能检测模型的“泛化能力不足”“输入输出不匹配”“数据漂移隐患”等问题,覆盖分类、回归、LLM等各类AI模型,适配结构化、非结构化等多种数据类型。

-

测试套件:“定义准确率>0.8”只是基础操作,它支持自定义多维度测试规则(比如召回率、精确率、事实一致性、语义相似度等),还能实现“回归测试”——当优化模型后,重新运行测试套件,就能快速判断优化是否有效,避免优化后引入新的漏洞。

正确适用场景(不止是“给老板看报告”)

除了生成正式报告同步给团队/老板,它更适合:

-

企业级AI模型上线前的“全流程质量把关”(比如金融、医疗等对模型可靠性要求高的行业);

-

模型迭代后的回归测试,快速验证优化效果;

-

定位模型性能瓶颈(比如为什么泛化能力差、哪些样本会导致幻觉),为优化提供方向。

二、DeepEval:不止是“LLM单元测试”,更是可落地的评测工程化工具

先矫正一个核心认知偏差

“LLM的单元测试”是DeepEval的定位,但这句话很容易让人误解为“它只能做简单的单元测试,功能单一”。实际上,DeepEval的核心价值是将LLM评测标准化、工程化,Pytest集成只是它适配Python技术栈的一个入口,而非全部能力。

很多人用它只做“是否通过测试”的判断,却忽略了它能解决LLM评测的核心痛点——主观性强、难以量化、无法批量执行。

底层逻辑:可配置指标+断言机制,让LLM评测从“主观判断”变“客观量化”

LLM的评测难点在于,不像分类模型能直接用准确率量化,它的生成结果(比如文案、回答)需要判断“事实是否准确”“语义是否贴合”“逻辑是否通顺”,这些往往依赖人工。而DeepEval的底层逻辑,就是把这些“主观指标”转化为“可量化、可自动化的客观指标”,核心依赖两大机制:

-

内置多维度评测指标库:它预定义了LLM核心评测指标,比如事实一致性(Faithfulness)、语义相似度(Semantic Similarity)、回答相关性(Relevance)、流畅度(Fluency)等,每个指标都有明确的计算逻辑(比如基于大模型交叉验证、语义向量比对),无需用户手动实现。

-

与Python测试生态深度融合:通过Pytest集成,将LLM评测嵌入到常规的Python开发测试流程中——开发者可以像写单元测试一样,为LLM的每一个输出场景写评测用例,批量执行、自动生成测试报告,实现“开发→测试→优化”的闭环。

重新理解它的核心功能(纠正片面解读)

Pytest集成是它的“亮点功能”,但不是唯一功能:

-

Pytest集成:核心价值是“工程化落地”——让LLM评测不再是独立的手动操作,而是融入到团队的CI/CD流程中,每次模型迭代后,自动运行评测用例,快速发现问题,适合研发团队高效协作。

-

自定义评测逻辑:支持用户自定义指标(比如针对特定业务场景的“回答合规性”指标),也能修改内置指标的阈值,适配不同业务对LLM的要求(比如客服LLM更看重相关性,知识库LLM更看重事实一致性)。

-

多场景适配:不止支持LLM,还能适配RAG系统、对话机器人等基于LLM的复杂应用,比如评测RAG的检索准确性+生成准确性,解决端到端的质量问题。

正确适用场景(不止是“Python测试流程”)

除了适配Python测试流程,它更适合:

-

LLM/RAG开发者的日常测试(批量验证生成结果的质量,减少人工核对成本);

-

需要将LLM评测标准化、工程化的团队(比如规模化落地LLM应用的企业);

-

LLM模型迭代的回归测试(快速对比不同版本的评测结果,判断优化效果)。

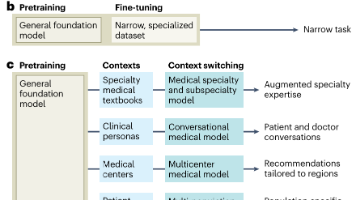

三、核心对比:两款工具该怎么选?(避开选型误区)

| 对比维度 | Giskard | DeepEval |

|---|---|---|

| 底层定位 | 全链路AI质量管理平台(适配各类AI模型) | LLM专属评测工具(侧重生成质量量化) |

| 核心优势 | 多模型适配、全维度风险检测、测试闭环 | LLM评测量化、工程化集成、轻量灵活 |

| 适用模型 | 分类、回归、LLM、RAG等各类AI模型 | 主要适配LLM及基于LLM的应用(RAG、对话机器人等) |

| 选型误区 | 只用来生成HTML报告 | 只用来做简单的单元测试,忽略自定义评测能力 |

四、总结:别让“片面认知”浪费工具价值

无论是Giskard还是DeepEval,它们的核心价值都不是“生成报告”或“集成测试”,而是帮实现AI质量的“自动化、标准化、可追溯”——Giskard帮守住“全链路质量关”,适合企业级多模型场景;DeepEval帮搞定“LLM评测落地”,适合研发团队快速迭代。

很多人觉得“工具不好用”,其实是没读懂它的底层逻辑,只用了表层功能。AI质量测试的核心不是“走个过场、出份报告”,而是通过工具发现隐性问题、规避上线风险——这也是这两款工具能脱颖而出的关键。

如果的团队正在落地AI模型,不妨根据自身场景选型:需要全流程质量管控,选Giskard;专注LLM评测、追求工程化效率,选DeepEval。用好工具,才能让AI模型真正靠谱、可用。

更多推荐

已为社区贡献43条内容

已为社区贡献43条内容

所有评论(0)