告别碎片化指令:从 Prompt 到 AI 资产化的范式革命

很多人听到 Skills 的第一反应是:“这不就是一个保存 Prompt 的地方吗?” 这种理解只触及了表象。“资产化思维”是 AI 时代最底层的竞争力。当你不再满足于写出一个“好 Prompt”,而是致力于封装一套“好 Skill”时,你就已经跨越了工具使用的初级阶段,开始构建属于自己的数字护城河。今天,就开始把你常用的那段 Prompt,改造成你的第一个 AI 资产吧!(本文首发于 [您的网站

告别碎片化指令:从 Prompt 到 AI 资产化的范式革命

** 🔗👉 立即获取高性能 claude API Key**

让 AI 的思考不再等待,让工程化落地更顺畅。

引言:为什么只会写 Prompt 的人正在失去竞争力?

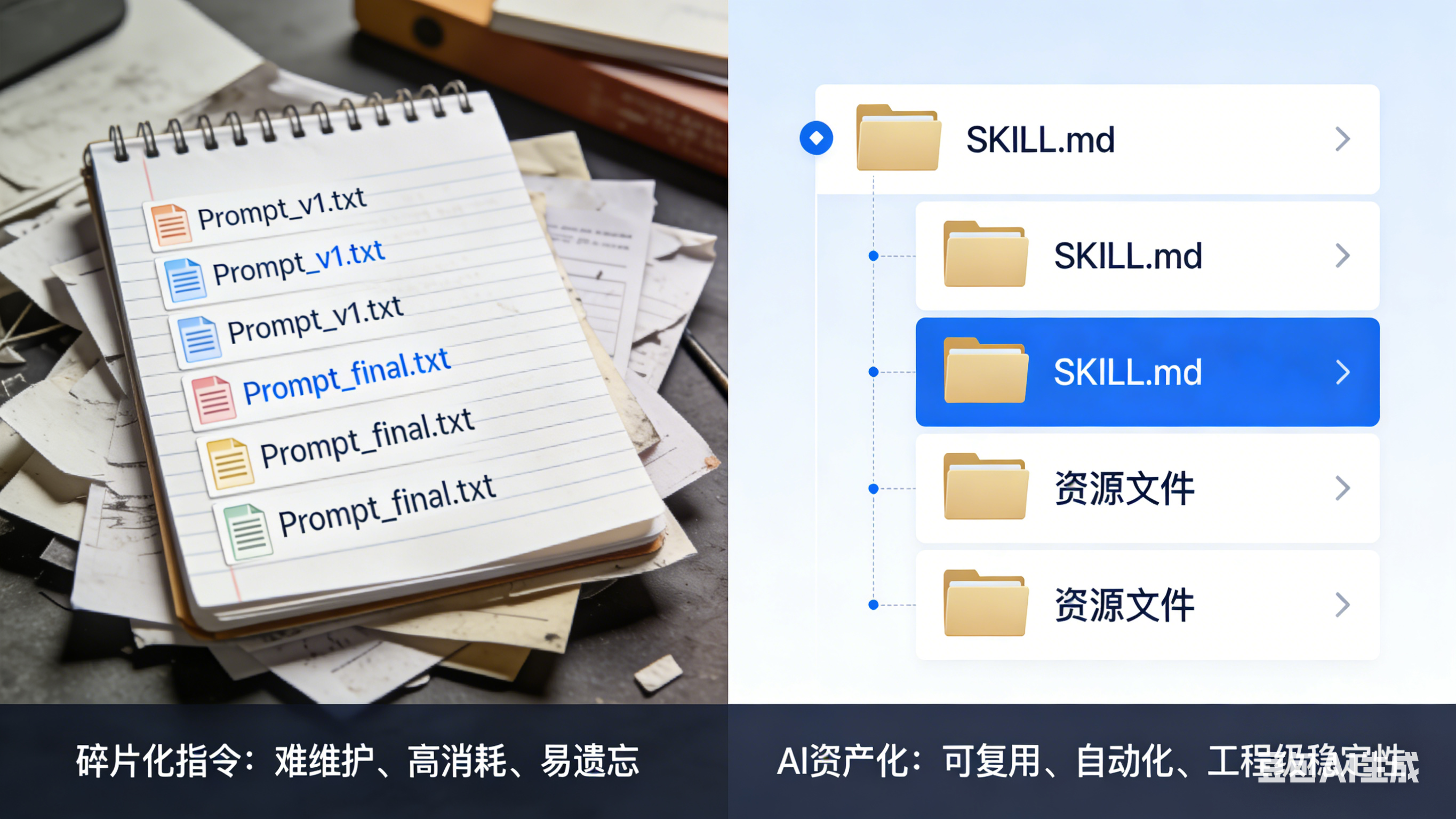

在 AI 浪潮的初期,我们曾为写出一段精妙的提示词(Prompt)而沾沾自喜。然而,随着任务复杂度的提升,弊端开始显现:你是否厌倦了在记事本里翻找那段 2000 字的长指令?是否发现即便复制了同样的 Prompt,AI 的表现依然不稳定?是否感叹每次开启新对话都要重新“调教”AI,浪费了大量的 Token 和精力?,

2024 年初,英伟达 CEO 黄仁勋曾预言“未来不需要人人学编程”。 确实,只会敲代码的人会被替代,但能够构建系统的人永远稀缺。, 2025 年 10 月,Anthropic 推出的 Claude Skills 标志着一个转折点的到来:我们与 AI 的协作,正在从“指令对话模式”进化为“系统构建模式”。

本文将带你深度拆解这一范式革命,教你如何将零散的经验封装为可复用的 “AI 数字资产”。

一、 重新定义 Claude Skills:它绝不只是“保存好的 Prompt”

很多人听到 Skills 的第一反应是:“这不就是一个保存 Prompt 的地方吗?” 这种理解只触及了表象。

1. 结构化:从一段话到一个文件夹

官方定义 Skills 是由指令、脚本和资源组成的文件夹。 它的核心是 SKILL.md,用 Markdown 格式定义了:

- 任务目标:这个 Skill 解决什么问题?

- 判断标准:AI 如何进行专业审计?

- 操作 SOP:分几步走?每步用什么工具?

2. 核心差异:形态与生命周期的飞跃

| 维度 | 传统 Prompt | Claude Skill |

|---|---|---|

| 形态 | 一次性对话内容 | 结构化文件夹资产 |

| 调用方式 | 人肉复制粘贴 | AI 根据意图自动识别并触发, |

| 上下文占用 | 全文塞入,极度消耗 Token | 渐进式披露,启动仅占约 100 Tokens, |

| 协作性 | 难以在团队间标准化共享 | 可版本化、可放 Git、团队开箱即用, |

结论:Prompt 告诉 AI 做什么,而 Skills 告诉 AI 如何判断,以及整个流程如何跑。

二、 核心黑科技:渐进式披露(Progressive Disclosure)

这是 Skills 能够规避上下文空间过载的杀手锏。它采用了一种“三层加载机制”,确保了 AI 的性能与成本的最佳平衡:

- 启动层(目录检索):Claude 启动时只加载所有 Skills 的名称和描述(Description)。这就像进入图书馆先看目录,每项仅消耗约 100 Tokens。

- 触发层(章节读取):当你的意图(Intent)与描述匹配时,Claude 才会加载完整的

SKILL.md指令。 - 按需层(查阅附录):只有在执行过程中真正需要参考资料、脚本或模板时,才会动态加载相关部分。

设计心法: 描述(Description)的质量决定了触发的准确率。一个好的描述应包含明确的输入类型、核心功能说明、关键触发词以及特殊能力强调。

—

三、 实战拆解:从“能力包”到“软编排”

基于 MAPS™ 框架,我们将 Skills 的应用分为两种深度模式:

模式 A:能力包型(Capability Pack)—— 封装专业判断

代表案例:discussion-organizer(笔记整理助手)

该模式的重点是把你的**隐性知识(Tacit Knowledge)**显性化。

例如整理 50 条杂乱的学习笔记,该 Skill 内置了四层判断逻辑:

- 价值评估:给信息打分(⭐⭐⭐⭐⭐ 核心洞察 vs. ❌ 噪音)。

- 可信度核查:区分“已验证官方文档”与“需验证推测”。

- 提取粒度:决定是直接引用还是改写提炼。

- 风格统一:去除口语化,统一技术术语。

成果: 原本需要 3-4 小时的人工整理,现在 5 分钟跑完,且结果具备工程级的一致性。

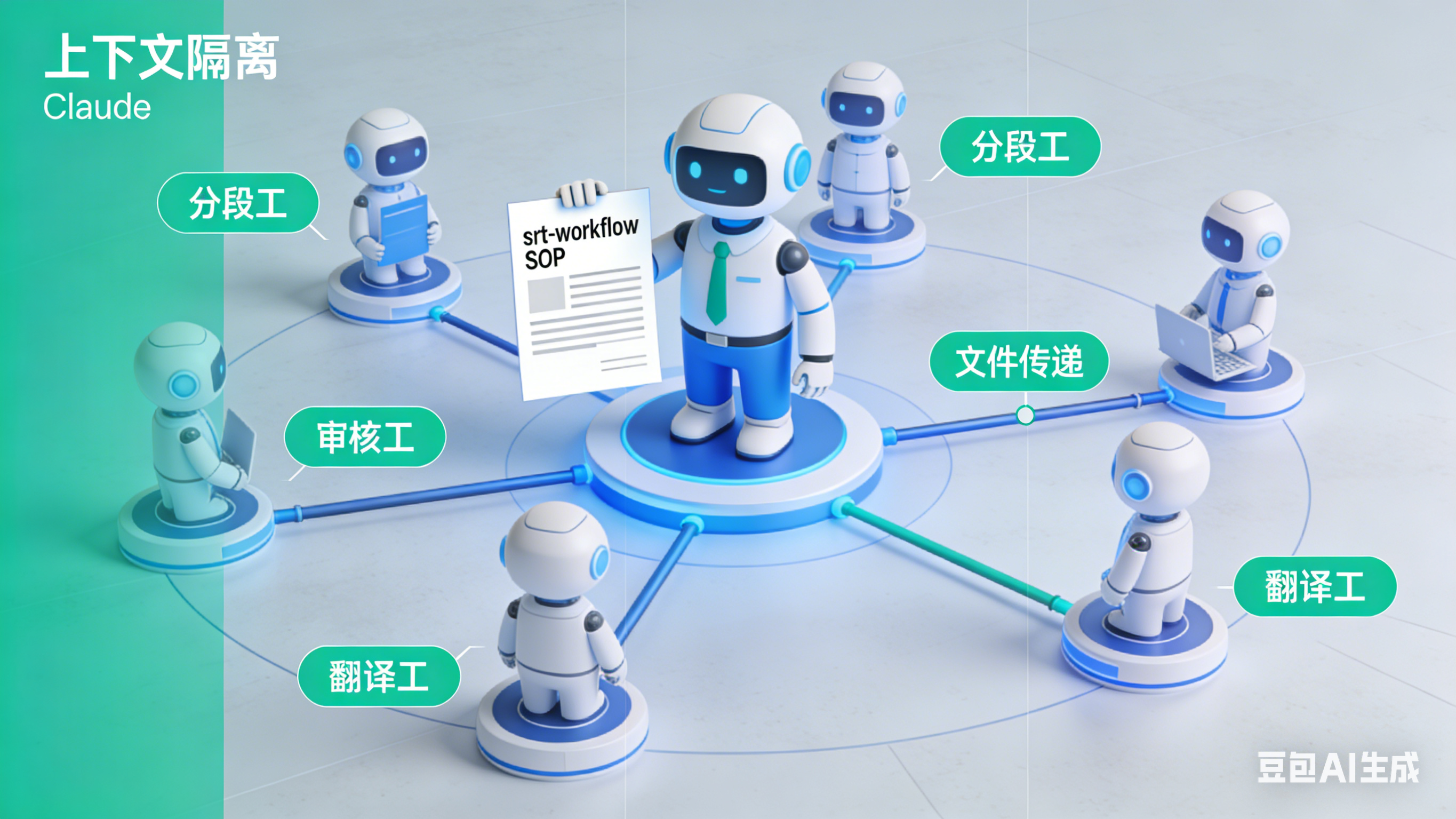

模式 B:软编排型(Soft Orchestration)—— 跨 Agent 协作

代表案例:srt-workflow(字幕转文章流水线)

这是针对复杂任务的进阶用法(目前仅限 Claude Code)。 它不再是一个 Agent 干全活,而是由主 Claude 担任“项目经理”,根据 SOP 调度多个独立的 Sub-agents(子智能体):

- 阶段 0:

subtitle-segmenter负责语义分段。 - 阶段 1:

reviewer专门修正 ASR 语音识别错误。 - 阶段 2:

finalizer负责润色定稿。 - 数据传递:不同 Agent 之间不通过对话粘贴,而是通过 文件(JSON/MD)传递上下文。

核心理念: 像工厂流水线一样工作。每道工序只看上一道的成品,有效隔离上下文污染,并大幅优化 Token 消耗。

四、 MAPS™ 5A+ 方法论:如何构建你的第一项 AI 资产?

如果你想立刻开始,请遵循这套从想法到落地的系统化闭环:

- AIM(明确目标):评估任务。如果它是高频重复、需要专业判断、有标准流程的,那就值得做成 Skill。

- ACQUIRE(获取资源):搜集你现有的 Prompt、SOP 文档和参考案例。

- ATTEMPT(快速验证):构建 MVS(最小可行 Skill)。先做一个能跑通的功能,不要贪大求全。

- ADJUST(评估迭代):根据触发准确率、执行成功率和 Token 消耗进行微调。

- APPLY(规模化):将 Skill 存入你的资源库(如 Notion 或 Obsidian),并尝试与团队共享。

小窍门: 初学者可以利用官方提供的 skill-creator,只需用自然语言描述需求,它就能自动帮你生成标准化的文件夹结构和 SKILL.md。

五、 进阶愿景:构建你的 Persistent Context Layer(持久化上下文层)

AI 不应只是一个网页窗口。AI 资产化的终极形态是将你的笔记软件(如 Obsidian)变为 “Persistent Context Layer”。

通过在根目录放置 CLAUDE.md 定义角色边界,并利用 Skills 将各种工作流(如研究自动化、LifeOS、批量笔记重构)封装起来,AI 才能真正从“通用模型”变成“你的专属员工”。

六、🔌 基础设施基石:稳定高并发的 API 支持

要实现上述的 90% 技能激活率,代价是 Token 消耗量的激增。

因为我们强制 Hooks 在每次对话前注入几百 tokens 的“评估指令”,并且一旦激活 Skills,会加载数千 tokens 的上下文文档。如果底层 API 响应慢或网络波动,AI 的反应会变得极其迟钝,甚至因为超时导致代码生成中断。

这套工程化架构,需要像赛车一样的高性能燃油支持。

推荐使用 🔗weelinking Claude直连:

- ⚡ 极速响应:专线优化,国内直连低延迟,确保 Hooks 瞬间加载,代码生成不卡顿。

- 🛡️ 稳定高并发:支持企业级并发请求,无论是 CI/CD 中的自动审查 (@code-reviewer) 还是多开发并行,都能稳如磐石。

- 💰 成本优化:相比直连,我们提供更灵活的计费策略,让您在享受“重上下文”开发模式时,无需为 Token 账单焦虑。

- 🔑 一键接入:完全兼容 Claude Code 及各类 IDE 插件,只需一行配置即可替换 Endpoint。

** 🔗👉 立即获取高性能 claude API Key**

让 AI 的思考不再等待,让工程化落地更顺畅。

结语:从提问者到系统架构师

“资产化思维”是 AI 时代最底层的竞争力。

当你不再满足于写出一个“好 Prompt”,而是致力于封装一套“好 Skill”时,你就已经跨越了工具使用的初级阶段,开始构建属于自己的数字护城河。

今天,就开始把你常用的那段 Prompt,改造成你的第一个 AI 资产吧!

(discussion-organizer 完整 Skill 包。

安装命令 npx skills add https://github.com/qodex-ai/ai-agent-skills --skill discussion-intelligence)

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)