从入门到大神:提示工程架构师应对Agentic AI技术挑战

理解本质:Agentic AI是“感知→规划→执行→反思”的闭环,提示要设计“思考逻辑”,而不是“输入输出”;解决核心挑战规划不足:用“任务分解提示”拆分子任务;执行偏差:用“执行约束提示”明确边界;缺乏反思:用“反思引导提示”自我修正;记忆缺失:用“记忆管理提示”存储检索;进阶能力:多智能体协作、安全伦理、性能优化。通过本文的方法,你已经能搭建一个可自主完成复杂任务的AI智能体——比如“自动生成

从入门到大神:提示工程架构师的Agentic AI挑战应对指南

备选标题

- 《Agentic AI时代:提示工程架构师的进阶之路与挑战破解》

- 《提示工程+Agentic AI:从新手到专家的全链路能力升级手册》

- 《应对Agentic AI挑战:提示工程架构师的入门、实践与进阶》

- 《从“写提示”到“设计大脑”:提示工程架构师的Agentic AI实战指南》

引言

你有没有过这样的经历?

- 用ChatGPT写个产品文案,分分钟出活;但让它**自主完成“调研竞品→提炼卖点→生成营销方案→优化预算”**的复杂任务时,要么漏掉关键步骤(比如没算ROI),要么跑歪方向(比如突然开始写产品说明书)。

- 试了LangChain的智能体框架,却发现AI要么“不敢”调用工具(比如明明需要查实时数据,却自己编),要么“乱”调用工具(比如查天气用了股票API)。

- 好不容易让AI完成了任务,却没法让它**“反思”**——比如方案超了预算,它完全意识不到要调整。

这不是你的问题,而是AI从“工具”进化到“智能体(Agentic AI)”带来的范式转移:传统LLM是“输入→输出”的单向黑盒,而Agentic AI是“感知→规划→执行→反思”的闭环系统——它需要“自己做决定”,而不是被动响应指令。

作为提示工程架构师,你的角色已经从“给AI写说明书的人”,变成了“给AI设计思考逻辑的工程师”。

本文要做什么?

我们会从Agentic AI的本质讲起,拆解它的四大核心挑战(规划、执行、反思、记忆),并给出可落地的提示工程解决方案——从基础的“任务分解提示”到进阶的“多智能体协作规则”,全程配套代码示例和真实场景。

你能学到什么?

- 搞懂Agentic AI和传统LLM的本质区别;

- 掌握Agentic AI的四大核心挑战及对应的提示技巧;

- 能独立设计可自主决策、自我修正的AI智能体(比如“自动生成电商营销方案”“帮你做项目管理”的智能体);

- 了解Agentic AI的进阶方向(多智能体、安全、性能优化)。

准备工作

在开始之前,你需要具备这些基础:

1. 技术栈/知识

- LLM基础:了解大语言模型的基本概念(Token、上下文窗口、温度参数),用过至少一个LLM工具(如ChatGPT、Claude、Gemini);

- 基础提示工程:会写“清晰指令”“思维链(CoT)”“少样本示例”,知道如何用提示约束AI输出;

- Python基础(可选但推荐):能看懂简单的Python代码,方便实践LangChain/Autogen等智能体框架。

2. 环境/工具

- LLM API:推荐OpenAI API(gpt-4o/gpt-3.5-turbo)或Anthropic Claude(更擅长长上下文);

- 智能体框架(可选):LangChain(适合快速搭建智能体)、Autogen(适合多智能体协作);

- 开发工具:Jupyter Notebook/Colab(方便调试代码)、VS Code(写提示和脚本)。

核心内容:手把手应对Agentic AI的四大挑战

在正式解决问题前,我们先明确Agentic AI的核心组件(这是设计提示的基础):

- 目标(Goal):智能体要完成的任务(比如“做智能水杯的营销方案”);

- 规划器(Planner):将大目标拆分成可执行的子任务(比如“用户调研→竞品分析→卖点提炼→渠道选择→预算分配”);

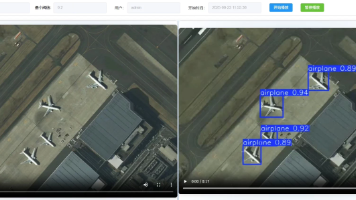

- 执行器(Executor):执行子任务,必要时调用工具(比如查竞品价格用PriceChecker API);

- 反思器(Reflector):检查执行结果是否符合目标,修正错误(比如“方案超预算了,要把抖音的预算从6万砍到5万”);

- 记忆(Memory):存储历史任务、用户反馈和关键结论(比如“上次用户调研显示,白领更看重‘续航’”)。

挑战1:规划能力不足——AI不会拆任务怎么办?

问题场景

让AI做“智能水杯的营销方案”,它直接输出一个大纲,但没有拆分步骤——比如跳过“用户调研”直接写“卖点提炼”,导致方案脱离用户需求。

本质原因

传统LLM擅长“解决具体问题”,但不擅长“拆解复杂问题”。Agentic AI的核心是“规划”,而规划的前提是**“任务分解能力”**。

解决方法:设计“任务分解提示”

做什么? 用提示引导AI将大目标拆分成可执行、有依赖关系的子任务。

为什么? 就像人做项目要写“甘特图”,AI也需要“任务清单”——明确“先做什么,再做什么,需要什么输入”。

提示模板&代码示例

我们用LangChain的PlanAndExecuteAgent(规划-执行智能体)来实践,核心是写好plan_prompt(规划提示):

from langchain.agents import initialize_agent, Tool

from langchain_openai import OpenAI

# 1. 定义工具(比如查询竞品价格的工具)

def check_price(product_ids):

"""模拟调用价格查询API,返回竞品价格"""

return {

"智能水杯A": 99,

"智能水杯B": 129,

"智能水杯C": 149

}

tools = [

Tool(

name="PriceChecker",

func=check_price,

description="查询竞品价格的工具,输入是竞品ID/名称列表,输出是价格字典"

)

]

# 2. 初始化LLM(用OpenAI gpt-3.5-turbo)

llm = OpenAI(temperature=0, model_name="gpt-3.5-turbo-instruct")

# 3. 设计任务分解提示(plan_prompt)

plan_prompt = """

你是一个专业的电商运营智能体,负责完成复杂的营销任务。当接到目标时,请严格按照以下步骤拆分任务:

### 任务拆分规则

1. **拆分子任务**:将大目标拆成3-5个**可执行、有依赖**的子任务(比如“做营销方案”→“用户调研→竞品分析→卖点提炼→渠道选择→预算分配”);

2. **明确输入输出**:每个子任务要写清楚“需要什么输入”“会产生什么输出”;

3. **标注工具需求**:如果子任务需要调用工具,注明工具名称和参数(比如“竞品分析”需要调用PriceChecker,参数是竞品名称列表)。

### 示例

目标:为新品“智能手表”做营销方案

拆分结果:

1. 用户调研:输入=产品功能(心率监测、续航7天)、目标人群(25-35岁白领);输出=用户需求报告(比如“白领最看重续航和颜值”);无需工具;

2. 竞品价格分析:输入=竞品名称列表(智能手表X、智能手表Y);输出=竞品价格对比表;需要调用PriceChecker,参数=["智能手表X", "智能手表Y"];

3. 卖点提炼:输入=用户需求报告、竞品价格对比表;输出=核心卖点(比如“同价位续航最长”);无需工具;

4. 渠道选择:输入=核心卖点、目标人群;输出=渠道列表(比如“小红书、抖音”);无需工具;

5. 预算分配:输入=渠道列表、总预算(10万);输出=预算分配表(比如“小红书4万、抖音5万、备用1万”);无需工具。

### 现在请拆分你的任务

目标:{input}

"""

# 4. 初始化智能体(用PlanAndExecute策略)

agent = initialize_agent(

tools=tools,

llm=llm,

agent="plan-and-execute", # 规划-执行策略

verbose=True, # 打印执行过程

agent_kwargs={

"plan_prompt": plan_prompt, # 传入任务分解提示

"executor_prompt": "严格执行子任务,需要工具时调用指定工具", # 简化的执行提示

}

)

# 5. 测试智能体

result = agent.run("为新品智能水杯做营销方案,总预算10万元,目标人群是25-35岁白领")

print("最终结果:", result)

关键说明

- 提示的“规则感”:用“### 任务拆分规则”明确要求,AI会更遵守;

- 示例的重要性:给AI一个“正确拆分”的例子(少样本学习),它能更快掌握方法;

- 依赖关系:子任务的输入要来自前一个任务的输出(比如“卖点提炼”需要“用户调研”的结果),这样AI会按顺序执行。

挑战2:执行偏差——AI做任务跑歪了怎么办?

问题场景

让AI“做竞品价格分析”,它却输出了“竞品的包装设计分析”;或者需要调用PriceChecker工具时,它直接“猜”了一个价格(比如“智能水杯A大概100元”)。

本质原因

Agentic AI的“执行器”需要**“约束”**——它得知道“能做什么,不能做什么,必须做什么”。传统提示的“模糊指令”(比如“帮我分析竞品价格”)不足以约束AI的执行行为。

解决方法:设计“执行约束提示”

做什么? 用提示明确AI的执行边界、工具使用规则、输出要求。

为什么? 就像给员工写“岗位职责说明书”,AI需要清晰的“执行指南”——比如“只能用PriceChecker查价格,不能猜;输出必须是表格,包含竞品名称、价格、对比结论”。

提示模板&代码示例

我们升级之前的executor_prompt(执行提示),加入更严格的约束:

# 升级执行提示(executor_prompt)

executor_prompt = """

你现在需要执行子任务,请严格遵守以下规则:

### 执行规则

1. **工具调用要求**:

- 只有子任务明确要求时才能调用工具(比如“竞品价格分析”需要调用PriceChecker);

- 调用工具时必须传入正确参数(比如PriceChecker的参数是竞品名称列表);

- 工具返回结果后,必须用结果回答,不能自己编造数据。

2. **输出要求**:

- 输出必须包含**关键结果**(比如具体的价格数值、用户需求点);

- 输出格式要符合子任务要求(比如“竞品价格分析”要输出表格);

3. **错误处理**:

- 如果工具调用失败(比如返回空结果),立即反馈“工具调用失败,请检查参数”;

- 如果遇到无法解决的问题(比如没有竞品名称列表),立即询问用户,不要猜测。

### 当前任务信息

子任务:{task}

之前的执行历史:{history}

需要的输入:{input}

请输出执行结果:

"""

# 重新初始化智能体(替换executor_prompt)

agent = initialize_agent(

tools=tools,

llm=llm,

agent="plan-and-execute",

verbose=True,

agent_kwargs={

"plan_prompt": plan_prompt,

"executor_prompt": executor_prompt, # 传入升级后的执行提示

}

)

# 测试:让AI执行“竞品价格分析”子任务

result = agent.run("分析智能水杯的竞品价格,竞品名称是智能水杯A、智能水杯B、智能水杯C")

print("执行结果:", result)

关键说明

- “禁止性规则”:明确“不能做什么”(比如“不能自己编造数据”),比“鼓励性规则”更有效;

- “输出格式要求”:用“必须包含关键结果”“必须是表格”约束AI的输出,避免跑题;

- “错误处理”:告诉AI“遇到问题怎么办”,避免它“乱猜”或“沉默”。

挑战3:缺乏反思——AI做完任务不会检查怎么办?

问题场景

AI做了一个营销方案,预算是12万元(超过了用户要求的10万),但它完全没意识到要调整;或者方案里的“卖点”和之前的“用户调研结果”矛盾(比如用户看重“续航”,但卖点写了“颜值高”)。

本质原因

传统LLM是“一次性输出”,没有“自我检查”的能力。Agentic AI的“反思器”需要**“主动对比目标和结果”**——就像人做完作业要检查“有没有漏题”“有没有算错”。

解决方法:设计“反思引导提示”

做什么? 用提示引导AI从目标匹配度、任务完整性、结果合理性三个维度反思,输出修正方案。

为什么? 反思是Agentic AI的“闭环关键”——只有会反思,AI才能“越做越好”,而不是“一遍过”。

提示模板&代码示例

我们用LangChain的SelfReflectiveAgent(自我反思智能体)来实践,核心是写好reflect_prompt(反思提示):

from langchain.agents import SelfReflectiveAgent, AgentExecutor

from langchain.prompts import PromptTemplate

# 1. 定义反思提示(reflect_prompt)

reflect_prompt = PromptTemplate.from_template("""

你刚刚完成了任务,请按照以下维度反思:

### 反思维度

1. **目标匹配度**:结果是否满足用户的所有要求?(比如预算是否≤10万?目标人群是否是25-35岁白领?)

2. **任务完整性**:有没有遗漏子任务?(比如有没有做用户调研?有没有分析竞品价格?)

3. **结果合理性**:结果有没有逻辑矛盾?(比如卖点是否符合用户需求?渠道选择是否匹配目标人群?)

4. **修正方案**:如果有问题,如何调整?(比如“预算超了,把抖音的预算从6万砍到5万”)

### 当前信息

任务目标:{goal}

执行结果:{output}

之前的反思历史:{反思历史}

请输出反思报告(分点说明)和修正方案:

""")

# 2. 初始化反思智能体

reflective_agent = SelfReflectiveAgent.from_llm_and_tools(

llm=llm,

tools=tools,

reflect_prompt=reflect_prompt, # 传入反思提示

verbose=True

)

# 3. 测试反思功能(用之前的营销方案结果)

goal = "为智能水杯做营销方案,预算10万,目标人群25-35岁白领"

output = """

营销方案:

1. 用户调研:白领看重续航和颜值;

2. 竞品价格:智能水杯A 99元,B 129元,C 149元;

3. 卖点:同价位续航最长(7天);

4. 渠道:抖音(6万)、小红书(3万)、公众号(2万);

5. 预算:总11万。

"""

# 让智能体反思

reflection = reflective_agent.reflect(goal=goal, output=output,反思历史="")

print("反思结果:", reflection)

输出示例(AI的反思)

1. 目标匹配度:预算11万,超过用户要求的10万,不满足;

2. 任务完整性:无遗漏;

3. 结果合理性:渠道预算分配不合理(抖音6万+小红书3万+公众号2万=11万);

4. 修正方案:将抖音的预算从6万调整为5万,总预算变为10万(5+3+2=10)。

关键说明

- “结构化反思”:用“反思维度”引导AI按顺序检查,避免遗漏;

- “修正方案要具体”:让AI输出“可执行的调整步骤”(比如“把抖音预算砍1万”),而不是“泛泛的建议”(比如“减少预算”);

- “迭代反思”:可以让AI根据反思结果重新执行任务(比如调整预算后,再检查一次),形成“执行→反思→修正”的闭环。

挑战4:记忆缺失——AI做长任务会“忘事”怎么办?

问题场景

让AI做“智能水杯的全流程运营”(从调研到上线再到复盘),它在“上线阶段”完全忘了“调研阶段”的结论(比如用户看重“续航”,但上线的文案却在强调“颜值”);或者做“项目管理”时,忘了上周的任务进展(比如“已经完成了用户调研”,却又重新做了一遍)。

本质原因

传统LLM的“上下文窗口”是有限的(比如gpt-3.5-turbo是16k Token),长任务的历史信息会被“挤掉”;更关键的是,AI没有**“主动记忆”**的能力——它不会“记笔记”,也不会“检索之前的结论”。

解决方法:设计“记忆管理提示”

做什么? 用提示引导AI**“存储关键信息”“检索历史记忆”“使用记忆优化当前任务”**。

为什么? 记忆是Agentic AI的“经验库”——就像人做事情会“查笔记”,AI也需要“回忆”之前的结论,避免重复劳动或矛盾。

提示模板&代码示例

我们用LangChain的Memory组件(比如ConversationBufferMemory)来实践,核心是写好“记忆调用提示”:

from langchain.memory import ConversationBufferMemory

from langchain.chains import LLMChain

# 1. 初始化记忆组件(存储历史对话和关键结论)

memory = ConversationBufferMemory(

memory_key="chat_history", # 记忆的键名,用于提示中引用

return_messages=True # 返回Message对象,更易处理

)

# 2. 设计包含记忆的提示(比如“营销方案优化提示”)

memory_prompt = PromptTemplate.from_template("""

你是一个电商运营智能体,需要根据历史记忆优化当前任务。请先检索记忆库中的相关信息,再执行当前任务。

### 记忆库信息

{chat_history}

### 当前任务

{input}

请输出优化后的结果:

""")

# 3. 初始化带记忆的LLM Chain

chain = LLMChain(

llm=llm,

prompt=memory_prompt,

memory=memory,

verbose=True

)

# 4. 测试记忆功能

# 第一步:存储用户调研结论(模拟之前的任务)

chain.run(input="用户调研结论:25-35岁白领最看重智能水杯的续航(希望≥7天)和价格(希望≤150元)")

# 第二步:让AI优化卖点(需要用到记忆中的结论)

result = chain.run(input="请优化智能水杯的核心卖点")

print("优化后的卖点:", result)

输出示例(AI的优化结果)

核心卖点:

1. 同价位续航最长(7天)——满足白领对续航的需求;

2. 高性价比(价格129元,≤150元)——符合白领的价格预期。

关键说明

- “记忆的结构化”:用

ConversationBufferMemory存储历史信息,AI可以通过{chat_history}引用; - “主动检索”:提示中要求“先检索记忆库中的相关信息”,让AI主动“回忆”之前的结论;

- “记忆的迭代”:可以将新的结论(比如“优化后的卖点”)再存储到记忆库中,让AI的“经验”越来越丰富。

进阶探讨:Agentic AI的高阶挑战与解决方案

当你掌握了基础的“规划、执行、反思、记忆”提示技巧后,还可以探索这些进阶方向:

1. 多智能体协作——让AI“组队”完成复杂任务

场景:让“调研智能体”“方案智能体”“优化智能体”协同工作,比如:

- 调研智能体:负责用户调研和竞品分析;

- 方案智能体:根据调研结果写营销方案;

- 优化智能体:根据反思结果调整方案。

提示技巧:设计“智能体沟通规则”,比如:

你是“方案智能体”,负责根据“调研智能体”的结果写营销方案。请遵守以下沟通规则:

1. 必须等待“调研智能体”输出“用户调研报告”和“竞品分析报告”后再开始写方案;

2. 方案中必须包含调研结果中的关键结论(比如“用户看重续航”);

3. 写完方案后,将结果发送给“优化智能体”。

工具推荐:用Autogen(微软开源的多智能体框架),可以快速搭建多智能体协作流程。

2. 安全与伦理——避免AI“做坏事”

场景:AI可能生成虚假宣传(比如“我们的智能水杯续航10天,但实际只有7天”),或者违反法律法规(比如“使用用户隐私数据做调研”)。

提示技巧:加入“安全护栏提示”,比如:

你生成的所有内容必须遵守以下规则:

1. 不能包含虚假信息(比如不能夸大产品功能);

2. 不能违反法律法规(比如不能使用用户隐私数据);

3. 不能有歧视性内容(比如不能针对某一人群贬低)。

如果内容违反规则,请立即修改,并说明修改原因。

工具推荐:用OpenAI的“Moderation API”或Anthropic的“Constitutional AI”,辅助检查内容安全性。

3. 性能优化——处理长任务时的“上下文爆炸”

场景:当任务很长(比如“做一个6个月的项目管理”),AI的上下文窗口会不够用(比如gpt-3.5-turbo的16k Token只能存约1.2万字的历史信息)。

提示技巧:用“提示压缩”和“摘要提示”,比如:

请将之前的执行历史总结为3点关键信息,要求:

1. 包含核心结论(比如“用户看重续航”);

2. 排除无关细节(比如“调研问卷的第5题答案”);

3. 用简洁的语言表达(每点不超过50字)。

工具推荐:用LangChain的ContextualCompressionRetriever(上下文压缩检索器),自动压缩长文本。

总结:从“写提示”到“设计AI大脑”的进化

到这里,你已经掌握了Agentic AI时代提示工程架构师的核心能力:

- 理解本质:Agentic AI是“感知→规划→执行→反思”的闭环,提示要设计“思考逻辑”,而不是“输入输出”;

- 解决核心挑战:

- 规划不足:用“任务分解提示”拆分子任务;

- 执行偏差:用“执行约束提示”明确边界;

- 缺乏反思:用“反思引导提示”自我修正;

- 记忆缺失:用“记忆管理提示”存储检索;

- 进阶能力:多智能体协作、安全伦理、性能优化。

通过本文的方法,你已经能搭建一个可自主完成复杂任务的AI智能体——比如“自动生成电商营销方案”“帮你做项目管理”“辅助写论文”的智能体。

行动号召:一起成为Agentic AI时代的“大脑设计师”

现在,轮到你动手实践了!

- 选一个场景:比如“帮你写公众号文章”“帮你做旅游规划”“帮你整理工作周报”;

- 设计提示:用本文的“任务分解→执行约束→反思引导→记忆管理”框架,写一套提示;

- 测试优化:用LangChain或Autogen搭建智能体,测试它的表现,根据结果调整提示。

如果你在实践中遇到问题(比如“AI拆任务拆不好”“不会反思”),或者做出了好玩的智能体,欢迎在评论区分享!我们一起讨论优化,成为Agentic AI时代的“大脑设计师”!

最后送你一句话:

传统提示工程是“教AI说话”,Agentic AI的提示工程是“教AI思考”——而思考,才是智能的本质。

祝大家在Agentic AI的世界里,玩得开心,做得精彩!

更多推荐

已为社区贡献104条内容

已为社区贡献104条内容

所有评论(0)