AI原生应用:图像相似度匹配的深度学习方案

在“万物皆可图”的数字时代,从电商“找同款”到安防“找可疑人脸”,从医学影像“找相似病灶”到相册“找风格照片”,图像相似度匹配(Image Similarity Matching)已成为AI原生应用的核心需求。传统方法(如直方图、SIFT特征)依赖人工设计特征,难以应对复杂场景(如光照变化、视角偏移)。本文将聚焦深度学习方案,系统讲解如何让计算机自动学习“图像相似性”的判别能力。本文从生活场景引出

AI原生应用:图像相似度匹配的深度学习方案

关键词:图像相似度匹配、深度学习、特征提取、度量学习、对比学习、嵌入向量、Siamese网络

摘要:本文从“找相似图片”的日常需求出发,系统讲解基于深度学习的图像相似度匹配技术。我们将用“图像翻译官”“指纹生成器”“相似裁判”等生活化比喻,拆解特征提取、嵌入向量、度量学习等核心概念;结合Siamese网络、对比学习等经典模型,通过Python代码实战演示如何让计算机学会“看”懂图片的相似性;最后探讨该技术在电商、安防、医疗等领域的实际应用,以及未来的发展方向。无论你是AI初学者还是工程师,都能通过本文掌握图像相似度匹配的深度学习方案精髓。

背景介绍

目的和范围

在“万物皆可图”的数字时代,从电商“找同款”到安防“找可疑人脸”,从医学影像“找相似病灶”到相册“找风格照片”,图像相似度匹配(Image Similarity Matching)已成为AI原生应用的核心需求。传统方法(如直方图、SIFT特征)依赖人工设计特征,难以应对复杂场景(如光照变化、视角偏移)。本文将聚焦深度学习方案,系统讲解如何让计算机自动学习“图像相似性”的判别能力。

预期读者

- AI/计算机视觉开发者(想掌握图像匹配核心技术)

- 业务产品经理(想了解技术如何落地)

- 技术爱好者(对“计算机如何看图片”感兴趣)

文档结构概述

本文从生活场景引出核心概念,通过“特征提取→嵌入向量→度量学习”的技术链路,结合代码实战和应用案例,最终展望未来趋势。你将依次学习:

- 用“翻译官”“指纹”等比喻理解核心概念;

- 用Siamese网络、对比学习等模型的技术原理;

- 从数据准备到模型训练的完整实战流程;

- 电商、安防等领域的真实应用场景。

术语表

核心术语定义

- 特征提取(Feature Extraction):将图像像素转换为计算机能理解的“特征向量”的过程(类似将图片“翻译”成数字语言)。

- 嵌入向量(Embedding Vector):图像的“数字指纹”,长度固定的向量(如256维),能唯一表示图像的核心特征。

- 度量学习(Metric Learning):训练模型学习“相似度计算规则”(类似训练一个“裁判”,判断两个指纹的相似程度)。

- 对比学习(Contrastive Learning):通过“相似样本拉近距离,不相似样本推远”的方式训练模型(类似“双胞胎训练法”,让模型学会区分像与不像)。

相关概念解释

- Siamese网络:共享权重的双分支神经网络,用于生成两个图像的嵌入向量(想象成“双胞胎工厂”,用同一套模具生产两个指纹)。

- Triplet三元组:包含“锚点(Anchor)、正样本(Positive)、负样本(Negative)”的样本组合(如“猫的照片”+“另一只猫”+“狗的照片”),用于训练模型区分相似与不相似。

核心概念与联系

故事引入:小明的“找图烦恼”

小明想在电商APP买一件“白色圆领、带小草莓图案”的T恤,但搜索结果里有“白色圆领没草莓”“红色圆领有草莓”“白色V领有草莓”的款式。他嘀咕:“计算机怎么就不懂我要的‘相似’呢?”

原来,传统方法只能对比颜色、领口形状等简单特征,而深度学习方案能让计算机“看懂”更抽象的相似性(如“小草莓图案”的风格、比例)。这背后的关键,就是接下来要讲的“特征提取→嵌入向量→度量学习”三部曲。

核心概念解释(像给小学生讲故事一样)

核心概念一:特征提取——图像翻译官

想象你有一张“小猫追蝴蝶”的照片。如果直接把像素(红/绿/蓝数值)丢给计算机,它看到的只是一堆数字,就像我们看“乱码”一样。

特征提取就像一个“翻译官”,能把这堆乱码翻译成计算机能理解的“故事”:比如“黄色毛发(颜色特征)”“尖尖的耳朵(形状特征)”“蝴蝶的翅膀在动(动态特征)”。深度学习中的卷积神经网络(CNN)就是最厉害的翻译官,它通过层层卷积层(类似“放大镜”),从像素中提取边缘、纹理、物体部件,最终得到图像的核心特征。

核心概念二:嵌入向量——图像的数字指纹

翻译官翻译完“故事”后,需要把它压缩成一个“数字指纹”,方便后续比较。这个指纹就是嵌入向量,比如一个256维的向量(类似256个格子,每个格子填一个数字)。

举个例子:蒙娜丽莎的嵌入向量可能在“微笑弧度”格子填0.8,“背景山水”格子填0.6;而梵高《星月夜》的嵌入向量可能在“漩涡笔触”格子填0.9,“蓝色调”格子填0.7。不同图片的指纹差异越大,说明它们越不相似。

核心概念三:度量学习——相似性裁判

有了指纹,还需要一个“裁判”来判断两个指纹的相似程度,这就是度量学习。常见的裁判规则有:

- 欧氏距离:计算两个指纹向量的“空间距离”(距离越小越相似,类似两个点在地图上离得越近越像);

- 余弦相似度:计算两个向量的“方向夹角”(夹角越小越相似,类似两个箭头指向越接近越像)。

但深度学习更厉害的是“动态裁判”——通过训练让模型自己学习最佳的相似性计算规则(比如发现“草莓图案的位置”比“颜色”更重要)。

核心概念四:对比学习——双胞胎训练法

为了让翻译官(特征提取器)生成更优质的指纹,我们需要“训练”它。对比学习就是一种高效的训练方法:

假设我们有一对“相似图片”(如同一朵花的不同角度照片)和一对“不相似图片”(如花和猫),训练时告诉模型:“相似图片的指纹要离得近,不相似的要离得远!”。就像训练双胞胎识别:“这两个是你(相似),要手拉手;那个是陌生人(不相似),要离远点!”

核心概念之间的关系(用小学生能理解的比喻)

这四个概念就像“做蛋糕”的流程:

- 特征提取(翻译官):把面粉、鸡蛋等原料(像素)揉成面团(初步特征);

- 嵌入向量(指纹):把面团捏成固定形状的蛋糕胚(256维向量);

- 度量学习(裁判):用尺子量两个蛋糕胚的形状差异(计算相似度);

- 对比学习(训练):通过反复练习(调整揉面手法),让蛋糕胚的形状更能反映“蛋糕是否相似”(比如草莓蛋糕胚的“草莓形状”格子数值更高)。

核心概念原理和架构的文本示意图

图像A → 特征提取器 → 嵌入向量A

图像B → 特征提取器 → 嵌入向量B

度量学习 → 计算向量A与向量B的相似度(0-1分,越接近1越相似)

Mermaid 流程图

核心算法原理 & 具体操作步骤

经典模型:Siamese网络(双胞胎网络)

Siamese网络是图像相似度匹配的“经典武器”,因两个分支共享权重(像双胞胎)而得名。它的核心思想是:用同一套特征提取器处理两张图,生成嵌入向量,再计算相似度。

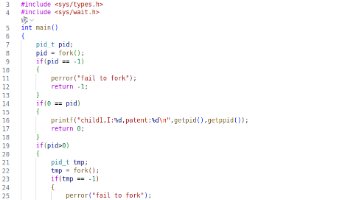

网络结构(用Python伪代码理解)

import torch

import torch.nn as nn

class SiameseNetwork(nn.Module):

def __init__(self):

super(SiameseNetwork, self).__init__()

# 共享特征提取器(卷积神经网络)

self.encoder = nn.Sequential(

nn.Conv2d(3, 64, 3), # 输入3通道(RGB),输出64通道

nn.ReLU(),

nn.MaxPool2d(2), # 下采样,减少计算量

nn.Conv2d(64, 128, 3),

nn.ReLU(),

nn.Flatten(), # 展平为一维向量

nn.Linear(128*10*10, 256) # 输出256维嵌入向量

)

def forward(self, img1, img2):

# 共享编码器生成两个嵌入向量

embed1 = self.encoder(img1)

embed2 = self.encoder(img2)

# 计算余弦相似度(范围-1到1,越接近1越相似)

similarity = nn.functional.cosine_similarity(embed1, embed2)

return similarity

训练关键:对比损失(Contrastive Loss)

为了让模型学会“相似样本拉近距离,不相似推远”,需要设计对比损失函数。公式如下:

L=(1−y)⋅12D2+y⋅12(max(0,m−D))2 L = (1 - y) \cdot \frac{1}{2} D^2 + y \cdot \frac{1}{2} (\max(0, m - D))^2 L=(1−y)⋅21D2+y⋅21(max(0,m−D))2

- ( y ):标签(1表示相似,0表示不相似);

- ( D ):两个嵌入向量的欧氏距离;

- ( m ):“边界值”(比如设为2,要求不相似样本的距离至少大于2)。

通俗解释:如果两张图相似(( y=1 )),损失是距离的平方(距离越大,惩罚越重);如果不相似(( y=0 )),损失是“边界值减去距离”的平方(但如果距离已经大于边界值,损失为0,不再惩罚)。

进阶模型:Triplet三元组网络

为了更严格地训练模型,Triplet网络使用“三元组样本”(锚点A、正样本P、负样本N),要求:

距离(A,P)+m<距离(A,N) \text{距离}(A,P) + m < \text{距离}(A,N) 距离(A,P)+m<距离(A,N)

即“锚点与正样本的距离”必须比“锚点与负样本的距离”小( m )(比如0.5),否则产生损失。

Triplet损失公式

L=max(0,距离(A,P)−距离(A,N)+m) L = \max(0, \text{距离}(A,P) - \text{距离}(A,N) + m) L=max(0,距离(A,P)−距离(A,N)+m)

生活化理解:就像训练小狗区分“自己的玩具”和“别人的玩具”——必须让“自己玩具的气味距离”比“别人玩具”近足够多,否则小狗会被“批评”(损失)。

数学模型和公式 & 详细讲解 & 举例说明

嵌入向量的数学本质

嵌入向量是一个高维空间中的点(如256维),两个点的位置关系直接反映图像相似性。例如:

- 两张“白色草莓T恤”的嵌入向量可能在“白色”维度(值0.9)、“草莓图案”维度(值0.8)接近;

- 一张“红色圆领T恤”的嵌入向量可能在“红色”维度(值0.9)、“圆领”维度(值0.7),与前者在“颜色”维度差异大,导致整体距离远。

相似度计算的数学选择

- 欧氏距离:( D = \sqrt{\sum_{i=1}^n (x_i - y_i)^2} )(适合需要绝对差异的场景,如人脸验证);

- 余弦相似度:( \cos\theta = \frac{x \cdot y}{||x|| \cdot ||y||} )(适合需要方向一致性的场景,如图像风格匹配)。

举例:假设嵌入向量A=[1,2,3],向量B=[2,4,6]:

- 欧氏距离:( \sqrt{(1-2)^2 + (2-4)^2 + (3-6)^2} = \sqrt{1+4+9} = \sqrt{14} \approx 3.74 );

- 余弦相似度:( (12 + 24 + 3*6)/(√(1²+2²+3²)√(2²+4²+6²)) = (2+8+18)/(√14√56) = 28/(√784) = 28/28 = 1 )。

可见,余弦相似度更关注“比例关系”(B是A的2倍),适合捕捉风格相似性。

项目实战:代码实际案例和详细解释说明

开发环境搭建

- 操作系统:Windows/Linux/macOS;

- 工具链:Python 3.8+、PyTorch 1.9+、OpenCV(图像读取)、Matplotlib(可视化);

- 依赖安装:

pip install torch torchvision opencv-python matplotlib

数据集准备(以“相似T恤”为例)

我们使用自定义数据集,结构如下:

dataset/

train/

001_white_straw/ # 类别1:白色草莓T恤

001_01.jpg

001_02.jpg

002_red_round/ # 类别2:红色圆领T恤

002_01.jpg

002_02.jpg

test/

...(类似训练集结构)

源代码详细实现和代码解读

步骤1:数据加载(生成三元组样本)

import os

import random

import numpy as np

import cv2

from torch.utils.data import Dataset

class TripletDataset(Dataset):

def __init__(self, root_dir, transform=None):

self.root_dir = root_dir

self.transform = transform

self.classes = os.listdir(root_dir) # 所有类别(如001_white_straw)

self.class_to_imgs = { # 类别到图像路径的映射

cls: [os.path.join(root_dir, cls, img)

for img in os.listdir(os.path.join(root_dir, cls))]

for cls in self.classes

}

def __getitem__(self, index):

# 随机选一个锚点类别

anchor_cls = random.choice(self.classes)

# 选两个不同的正样本(同一类别的不同图片)

anchor_img, positive_img = random.sample(self.class_to_imgs[anchor_cls], 2)

# 选一个负样本(不同类别的图片)

negative_cls = random.choice([c for c in self.classes if c != anchor_cls])

negative_img = random.choice(self.class_to_imgs[negative_cls])

# 读取并预处理图像(转Tensor、归一化)

def load_img(path):

img = cv2.imread(path)

img = cv2.cvtColor(img, cv2.COLOR_BGR2RGB) # BGR转RGB

if self.transform:

img = self.transform(img)

return img

return (load_img(anchor_img),

load_img(positive_img),

load_img(negative_img))

步骤2:定义Triplet网络模型

class TripletNetwork(nn.Module):

def __init__(self):

super(TripletNetwork, self).__init__()

self.encoder = nn.Sequential(

nn.Conv2d(3, 64, 3, padding=1), # 输入3通道,输出64通道

nn.ReLU(),

nn.MaxPool2d(2), # 尺寸减半(如224→112)

nn.Conv2d(64, 128, 3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2), # 112→56

nn.Conv2d(128, 256, 3, padding=1),

nn.ReLU(),

nn.AdaptiveAvgPool2d((1, 1)), # 全局平均池化(56→1)

nn.Flatten(),

nn.Linear(256, 256) # 输出256维嵌入向量

)

def forward(self, anchor, positive, negative):

embed_anchor = self.encoder(anchor)

embed_positive = self.encoder(positive)

embed_negative = self.encoder(negative)

return embed_anchor, embed_positive, embed_negative

步骤3:定义Triplet损失函数

class TripletLoss(nn.Module):

def __init__(self, margin=0.5):

super(TripletLoss, self).__init__()

self.margin = margin

def forward(self, anchor, positive, negative):

# 计算欧氏距离

dist_pos = nn.functional.pairwise_distance(anchor, positive)

dist_neg = nn.functional.pairwise_distance(anchor, negative)

# 损失公式:max(0, dist_pos - dist_neg + margin)

loss = torch.mean(torch.clamp(dist_pos - dist_neg + self.margin, min=0.0))

return loss

步骤4:训练循环

from torch.utils.data import DataLoader

from torchvision import transforms

# 图像预处理(缩放、归一化)

transform = transforms.Compose([

transforms.ToPILImage(),

transforms.Resize((224, 224)), # 统一尺寸

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) # ImageNet均值方差

])

# 加载数据

train_dataset = TripletDataset(root_dir="dataset/train", transform=transform)

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True)

# 初始化模型、损失函数、优化器

model = TripletNetwork()

criterion = TripletLoss(margin=0.5)

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练10个epoch

for epoch in range(10):

model.train()

total_loss = 0.0

for batch in train_loader:

anchor, positive, negative = batch

optimizer.zero_grad()

embed_a, embed_p, embed_n = model(anchor, positive, negative)

loss = criterion(embed_a, embed_p, embed_n)

loss.backward()

optimizer.step()

total_loss += loss.item()

print(f"Epoch {epoch+1}, Loss: {total_loss/len(train_loader):.4f}")

代码解读与分析

- 数据加载:通过

TripletDataset生成“锚点-正样本-负样本”三元组,确保模型学习“相似”与“不相似”的差异; - 特征提取器:使用卷积层提取局部特征(如草莓的纹理),全局平均池化(AdaptiveAvgPool2d)将不同尺寸的图像压缩为固定长度的向量;

- 损失函数:通过

TripletLoss强制正样本距离小于负样本距离(+margin),推动模型学习判别性特征; - 训练技巧:使用Adam优化器(比SGD更稳定),归一化(匹配预训练模型的输入分布)提升训练效果。

实际应用场景

1. 电商:商品相似推荐

用户搜索“白色草莓T恤”,模型能从百万商品库中快速检索出“白色草莓卫衣”“粉色草莓短袖”等相似款(基于图案、风格的嵌入向量相似性)。相比传统的“关键词匹配”,深度学习方案能捕捉“隐性相似性”(如“小草莓”的设计风格)。

2. 安防:人脸检索

在监控视频中提取人脸嵌入向量,与“黑名单库”中的向量对比。例如,某嫌疑人的嵌入向量与库中“张三”的向量余弦相似度达0.95(阈值设为0.8),系统自动报警。

3. 医学影像:辅助诊断

将患者的肺部CT图像转换为嵌入向量,与“肺结节数据库”中的相似病例对比。医生可快速查看历史相似病例的诊断结果和治疗方案,提升诊断效率。

4. 艺术:风格匹配

博物馆想举办“后印象派画展”,模型能从馆藏中检索出与梵高《星月夜》风格相似的画作(如高更的《我们从何处来?我们是谁?我们向何处去?》),基于笔触、色彩分布的嵌入向量相似性。

工具和资源推荐

框架与库

- PyTorch/TensorFlow:深度学习训练的核心框架(PyTorch更易调试,TensorFlow适合生产部署);

- FAISS(Facebook AI Similarity Search):高效向量检索库(支持亿级向量的快速相似查询);

- OpenCV:图像预处理工具(调整尺寸、颜色空间转换)。

数据集

- ImageNet:1400万张图像,1000个类别(预训练特征提取器的“宝库”);

- CUB-200-2011:鸟类细粒度图像数据集(适合训练“细微差异”的相似度模型);

- Stanford Online Products:电商商品数据集(包含120万张图像,适合商品相似匹配任务)。

学习资源

- 论文:《Dimensionality Reduction by Learning an Invariant Mapping》(Siamese网络开山作)、《SimCLR: A Simple Framework for Contrastive Learning of Visual Representations》(对比学习经典);

- 课程:Coursera《Convolutional Neural Networks》(吴恩达,详解CNN与图像任务);

- 博客:TensorFlow官方博客《图像相似度匹配实战》(附完整代码)。

未来发展趋势与挑战

趋势1:轻量级模型,端侧部署

随着手机、摄像头等设备的AI算力提升,未来会有更多“端侧图像相似度匹配”需求(如手机相册本地搜索相似照片)。轻量级模型(如MobileNet、EfficientNet-Lite)将成为主流,在保证精度的同时降低计算量。

趋势2:多模态融合

单纯的图像特征可能不足以描述“相似性”。例如,用户搜索“红色连衣裙”时,可能同时参考文本描述(“复古风”)和图像。未来的模型将融合图像、文本、视频等多模态特征,生成更全面的嵌入向量。

趋势3:小样本/零样本学习

现有方案依赖大量标注数据(如百万级三元组),但在医疗等领域(罕见病图像)数据稀缺。小样本学习(Few-shot Learning)通过“少量样本+元学习”让模型快速适应新任务,是未来的重要方向。

挑战1:对抗样本鲁棒性

恶意修改图像(如给人脸加个小贴纸)可能导致嵌入向量剧烈变化,模型误判相似性。如何提升模型对对抗样本的鲁棒性,是工业落地的关键问题。

挑战2:伦理与隐私

图像相似度匹配涉及大量用户隐私(如人脸、医疗影像),如何在“高效检索”和“数据脱敏”之间平衡?联邦学习(在本地设备训练模型,不传输原始数据)可能是解决方案之一。

总结:学到了什么?

核心概念回顾

- 特征提取:将图像像素翻译为计算机能理解的“数字故事”;

- 嵌入向量:图像的“数字指纹”,长度固定的高维向量;

- 度量学习:训练模型判断两个指纹的相似程度;

- 对比学习:通过“相似拉近距离,不相似推远”训练特征提取器。

概念关系回顾

特征提取生成嵌入向量,度量学习计算向量相似度,对比学习是训练特征提取器的“教练”。三者协作,让计算机从“看像素”进化到“看本质相似性”。

思考题:动动小脑筋

- 如果你要做一个“宠物狗相似匹配”APP,如何设计三元组样本?(提示:考虑品种、毛色、年龄等差异)

- 假设你只有100张猫的图片,如何用小样本学习训练一个猫的相似度模型?(提示:参考元学习或迁移学习)

- 对比学习中,如何避免模型“记住”特定样本(过拟合)?(提示:数据增强,如随机裁剪、颜色扰动)

附录:常见问题与解答

Q:为什么Siamese网络要共享权重?

A:共享权重保证两个分支用同一套“翻译规则”处理图像,否则可能出现“左分支关注颜色,右分支关注形状”的不一致,导致嵌入向量无法直接比较。

Q:对比学习需要标注数据吗?

A:不需要!对比学习是自监督学习的一种,通过“图像自身的变换(如裁剪、模糊)生成正样本,随机图像作为负样本”,无需人工标注“这两张图相似”。

Q:嵌入向量的维度越高越好吗?

A:不一定!高维度可能包含更多噪声(如无关的背景信息),低维度可能丢失关键特征。实际中需通过实验调参(常见256-512维)。

扩展阅读 & 参考资料

- 论文:

- Hadsell, R., Chopra, S., & LeCun, Y. (2006). Dimensionality Reduction by Learning an Invariant Mapping.

- Chen, T., Kornblith, S., Norouzi, M., & Hinton, G. (2020). A Simple Framework for Contrastive Learning of Visual Representations.

- 书籍:《Deep Learning for Computer Vision》(Adrian Rosebrock,含图像相似度匹配实战);

- 工具文档:

- FAISS官方文档:https://github.com/facebookresearch/faiss

- PyTorch度量学习库:https://github.com/KevinMusgrave/pytorch-metric-learning

更多推荐

已为社区贡献162条内容

已为社区贡献162条内容

所有评论(0)