AI Agent最新重磅综述:迈向高效智能体,记忆、工具学习和规划综述

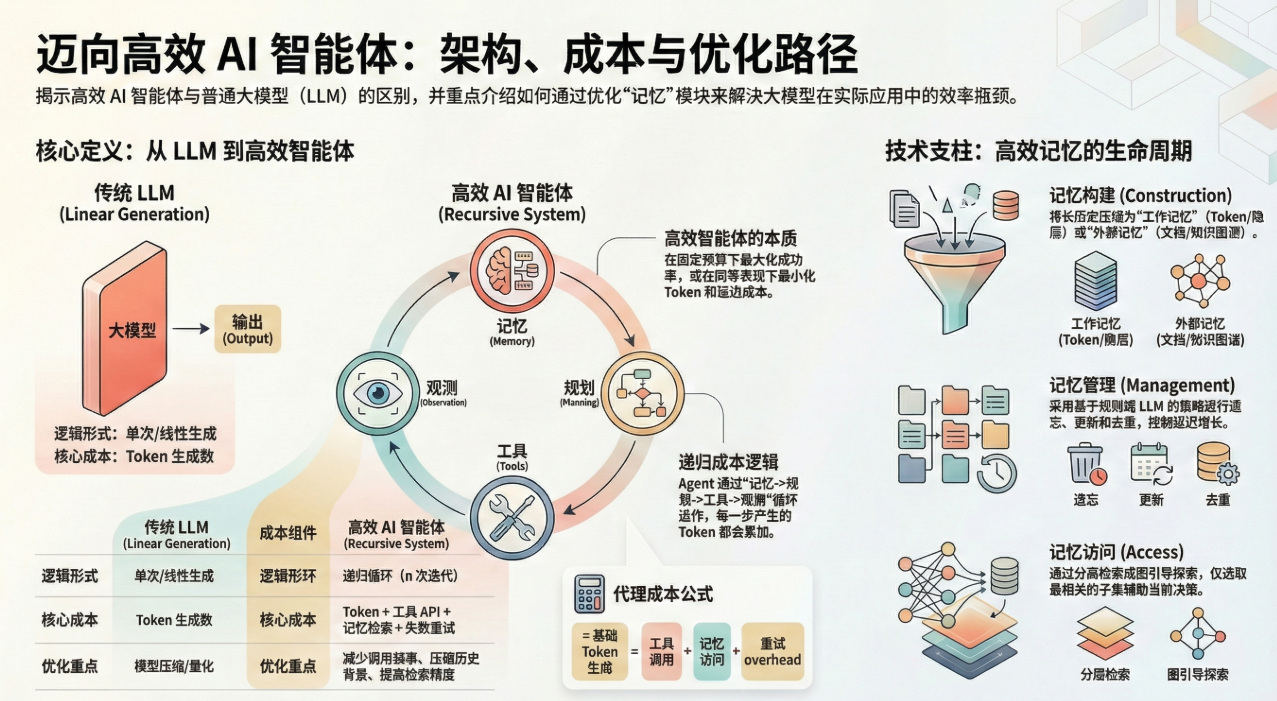

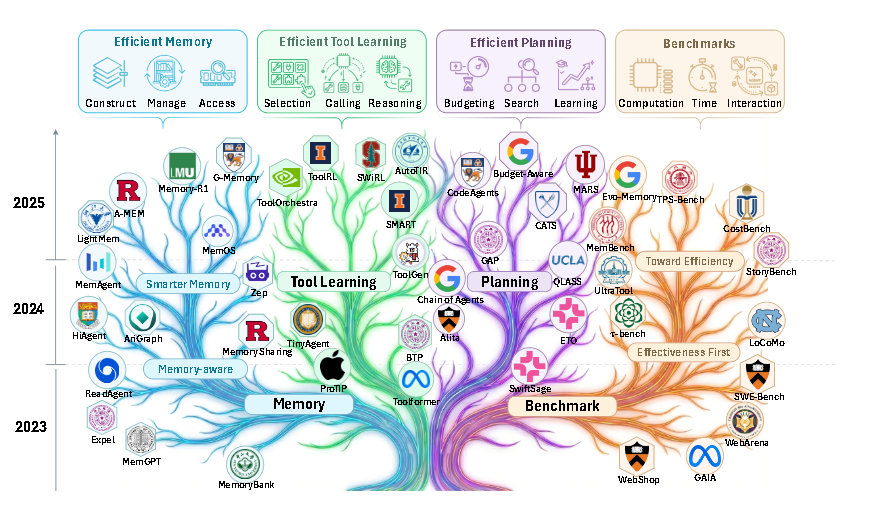

近年来,将大型语言模型扩展到智能体系统的研究兴趣日益浓厚。尽管智能体的有效性不断提高, 但对于实际部署至关重要的 效率却常常被忽视。因此,本文从智能体的三个核心组成部分——记忆、工具学习和规划——出发,研究了效率问题,并考虑了延迟、令牌、步骤等成本。

在这篇来自上海人工智能实验室等机构的最新综述论文中,研究者们为我们勾勒了一幅 AI Agent “从臃肿向干练”进化的完整蓝图。为了更直观地理解如何实现 Agent 的高效运行,结合论文中的具体对比数据和技术细节,深入剖析这套“减肥增效”方案。

项目主页:https://efficient-agents.github.io/

- 这篇论文指出,尽管大型语言模型(LLMs)代理系统(agents)在提高有效性方面取得了进展,但其在实际部署中至关重要的效率问题(如延迟、tokens、步骤和成本)常被忽视。

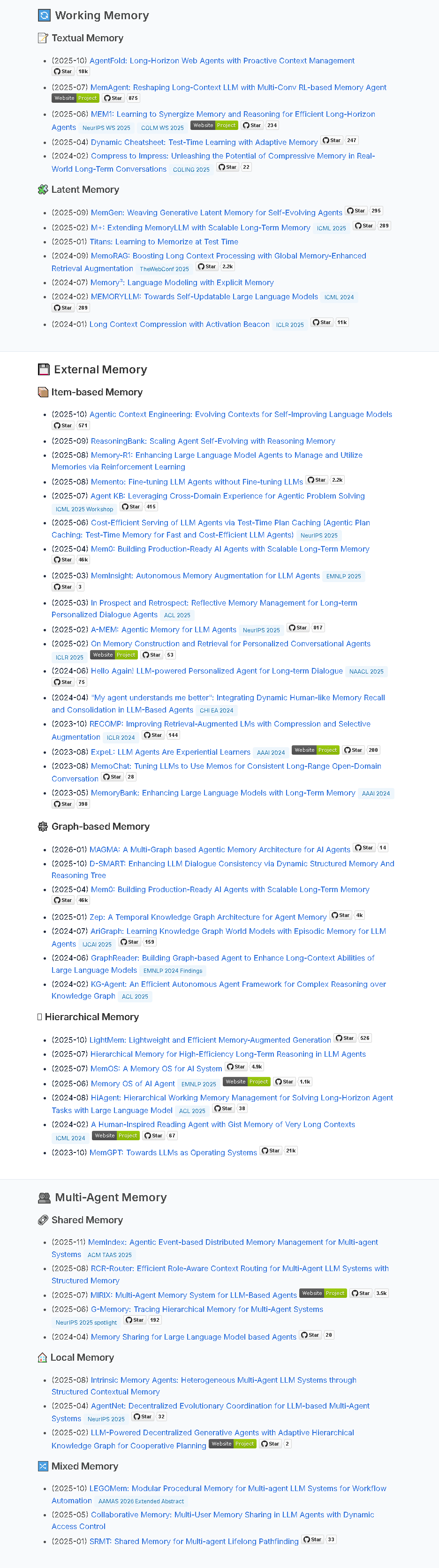

- 为解决此问题,该调查深入探讨了agent的三个核心组件——memory、tool learning和planning——的效率优化,涵盖了通过压缩管理上下文、设计RL奖励以减少工具调用以及采用受控搜索机制等方法。

- 论文通过比较固定成本预算下的有效性和相同有效性水平下的成本来量化效率,并总结了针对这些组件的评估协议和常用的效率指标,旨在提供有价值的见解和未来方向。

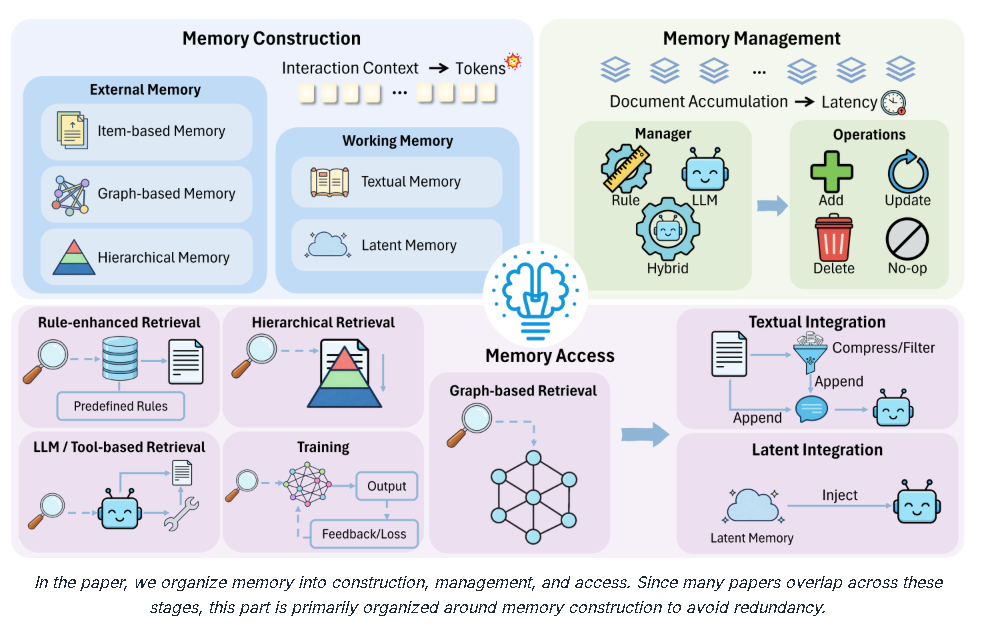

一、 存储优化:从“全文背诵”到“精准提炼”

Agent 的记忆管理是成本的大头。如果直接将所有历史记录(Raw History)塞进 Context Window,Token 消耗会呈指数级增长。

- 数据对比: 论文提到,传统的长上下文处理往往会导致“迷失在中间(Lost in the middle)”现象,而采用 AgentFold 等技术,通过主动折叠历史记录生成多尺度摘要,可以在显著降低 Token 使用量的同时,有效延缓关键信息的丢失。

- 潜层记忆(Latent Memory)的优势: 与其存储数千个 Token 的文本,不如将其压缩为 KV Cache 状态的隐藏信号。例如 Memory3 通过将知识外部化为稀疏的 KV 记忆,在解码时按需注入,直接避开了重复阅读长文档的开销。

- 管理效率: 简单的规则管理(如 FIFO 或遗忘曲线)虽然成本极低且能防止内存爆炸,但可能会导致 15% 以上的性能下滑;而 Hybrid Management(混合管理) 策略,即在缓冲区满时才调用 LLM 进行压缩,能在保持 90% 以上检索准确率的同时,大幅减少昂贵的 LLM 调用次数。

二、 工具学习:从“笨拙尝试”到“极速秒杀”

在处理复杂任务时,Agent 往往需要调用成百上千次 API,这带来了巨大的延迟。

- 数据对比——CoA vs. Toolformer: 传统的 Toolformer 模式在生成路径时直接填充参数,而 CoA(Chain-of-Abstraction) 引入了符号抽象来表示中间步骤,实验证明 CoA 在任务表现更佳的前提下,能减少 30% 以上的推理时间。

- Prompt 瘦身——TinyAgent: 如果把成千上万个工具描述都塞进 Prompt,模型会直接“宕机”。TinyAgent 采用多标签分类(MLC)技术,先用小模型筛选工具,这使得 Prompt 的大小缩减了近一半,非常适合在边缘设备上运行。

- 并发的力量: 通过 LLMCompiler 等框架,Agent 可以将原本需要串行等待的 10 次工具调用转化为并行执行,这在涉及大量搜索或数据查询的任务中,能将任务完成的绝对时长降低数倍。

三、 规划优化:从“胡思乱想”到“快慢结合”

规划的效率在于:如何用最少的思考步骤换取最高的成功率?

- 双系统思考(SwiftSage): 论文推崇类似人类的 System 1(直觉快思考) 与 System 2(逻辑慢思考) 的切换。只有当启发式模型处理不了时,才启动复杂的规划器,这能节省大量的计算预算。

- 搜索剪枝的威力: 传统的树搜索(如 MCTS)极其耗费 Token,而 ToolChain* 引入了 A* 搜索策略,利用学到的成本函数(Cost Function)提前剪掉那些没前途的路径,避免了穷举搜索带来的资源浪费。

- 多智能体通信:从 O ( N 2 ) O(N^2) O(N2) 到 O ( N ) O(N) O(N)。 在多 Agent 协作时,如果每个人都和所有人说话,通信成本是参与人数的平方。Chain-of-Agents 等技术通过构建线性的拓扑结构,将通信复杂度降到了线性级别,让多机协作不再是“ Token 吞金兽”。

核心衡量标准:性价比的“帕累托前沿”

论文提出,衡量一个 Agent 优不优秀,要看它在 Cost-of-pass(单次通关成本) 上的表现。

- 固定预算看成功率: 给你 1 万个 Token,看谁能解出更难的题。

- 固定成功率看成本: 大家都把题解出来了,看谁花的钱少、延迟低。

这种效用与成本的帕累托平衡(Pareto Frontier),才是未来 Agent 真正走向大规模商业化部署的关键。

总结

这篇综述不仅仅是一篇技术汇总,它更是一份 “Agent 降本增效说明书”。它告诉开发者:不要一味追求更大的模型,而应该通过层级化记忆、并行化工具调用 和自适应规划策略,构建出真正能在现实世界中大规模落地的智能系统。

*注:本解读基于综述论文《Toward Efficient Agents: A Survey of Memory, Tool learning, and Planning》

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)