MCP 协议火了,但 90% 的人还在用最笨的方式对接 AI

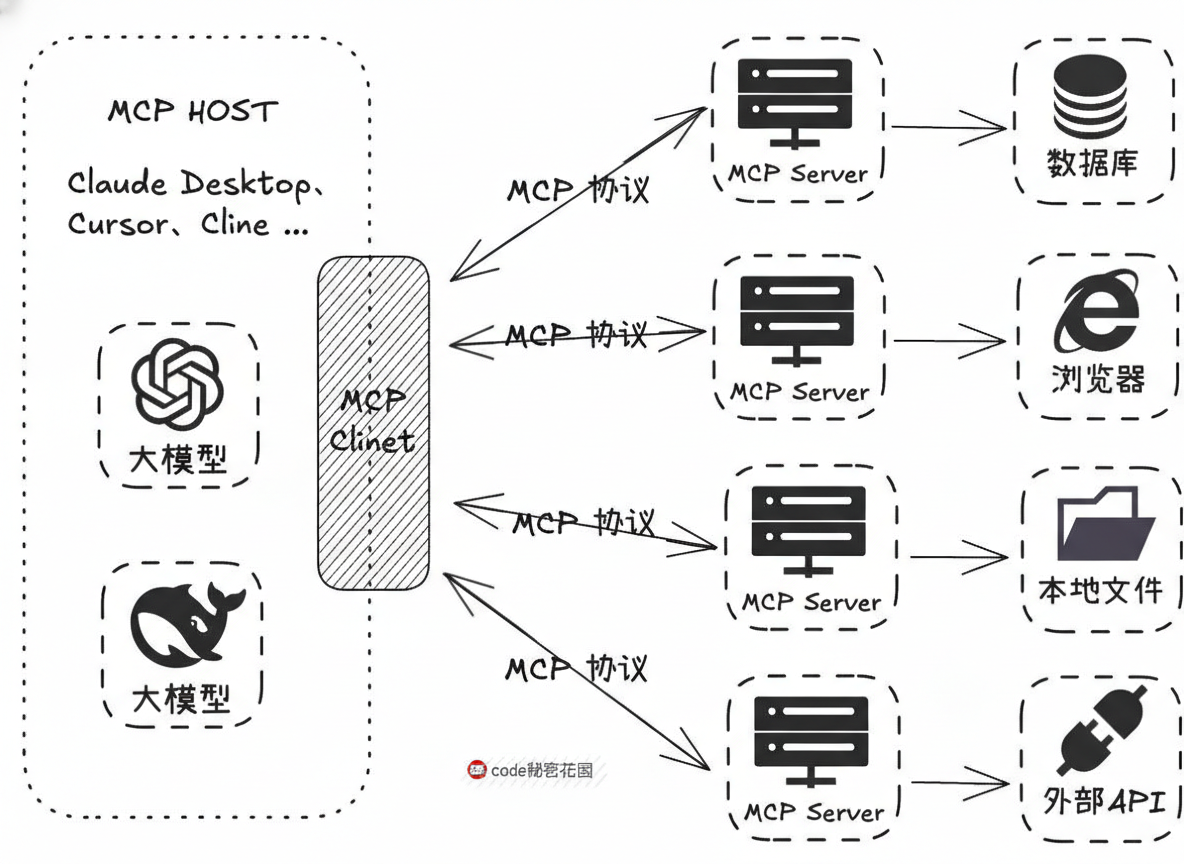

MCP协议:AI时代的"USB接口" 摘要:MCP(ModelContextProtocol)是Anthropic开源的AI连接标准协议,相当于AI时代的USB接口。它将AI模型与外部服务的连接标准化,通过定义Resources、Tools和Prompts三层结构,实现"即插即用"的能力接入。相比传统需要反复修改代码的FunctionCall方式,MCP能显

上周有个做 SaaS 的朋友问我:你们 Sealos 接入 AI 是怎么搞的?我说用 MCP 啊。他一脸懵:啥是 MCP?

我突然意识到一个问题——这玩意儿在技术圈已经火得不行了,但大部分人还在用"最原始"的方式让 AI 调用外部工具:手写 Function Call、硬编码 API、每接一个新服务就改一遍代码。

累不累?

先说清楚 MCP 到底是什么

Model Context Protocol,Anthropic 去年底开源的协议。一句话解释:它是 AI 时代的 USB 接口。

还记得没有 USB 之前吗?打印机一个口,鼠标一个口,扫描仪又一个口,驱动装到死。USB 出来之后,管你什么设备,插上就能用。

MCP 干的是同一件事,只不过连接的不是硬件,而是 AI 模型和外部数据源、工具、服务。

协议本身定义了三层东西:

-

Resources:数据源(文件、数据库、API 返回的内容)

-

Tools:可执行的操作(发邮件、查日历、调接口)

-

Prompts:预设的交互模板

有了这套标准,AI 模型不需要知道你的服务具体怎么实现的,它只需要按协议格式"问",你的服务按格式"答"就行。

为什么说 90% 的人还在用笨办法

我见过太多这种场景了:

一个团队想让 AI 助手能查公司内部文档,于是写了一堆 Function Call 定义,硬编码了文档系统的 API,调试了三天,终于跑通了。

过两周,产品说要加个日历功能,又是一轮改代码、调接口、测试。

再过一个月,要接第三方服务,继续重复。

每接一个新能力,就是一次"定制化开发"。这不叫笨办法叫什么?

MCP 的思路完全不同:把"连接"这件事标准化了。

一个服务只要实现了 MCP Server,任何支持 MCP 的 AI 客户端都能直接用。不用改 AI 那边的代码,不用重新调试,插上就能跑。

Sealos 为什么对这件事特别有感触

我们做云操作系统,本质上就是在解决"连接"的问题——让用户能一键把各种能力组合起来,而不是每次都从零搭建。

MCP 让我们看到了 AI 领域的同一套逻辑。

现在 Sealos 上的 DevBox 已经在考虑这个方向了:开发者在云端开发环境里,需要让 AI 助手访问代码仓库、读取配置、调用部署接口。用传统方式,每个能力都要单独打通;用 MCP,理论上可以做到"加个 Server 就加个能力"。

这不是我们自己的意淫,GitHub、Slack、Notion 这些大厂都已经在做官方的 MCP Server 了。生态正在快速成型。

这玩意儿有没有坑

当然有。

首先,标准还在演进。现在的 MCP 规范已经比较完整了,但细节上还有变动的可能。生产环境用的话,要做好版本兼容的准备。

其次,安全边界要自己守住。MCP 让 AI 能调用的东西变多了,这意味着权限控制必须更严格。不能让 AI 随便就把数据库给你删了。

最后,不是所有场景都需要。如果你就只接一个服务,而且逻辑简单,Function Call 也够用,没必要为了"先进"而上 MCP。

什么时候该认真考虑

几个信号:

-

你的 AI 应用需要接 3 个以上外部服务

-

你预期未来还会不断加新能力

-

你在做平台型产品,需要让第三方能扩展 AI 能力

符合这些条件,MCP 能帮你省掉大量重复劳动。

说到底,技术演进的方向一直没变:把重复的事情标准化,把精力留给真正有价值的事。

USB 是这样,HTTP 是这样,MCP 大概率也会是这样。

Sealos 是以 Kubernetes 为内核的云操作系统,让开发者能像用个人电脑一样使用云。DevBox 是其中的云端开发环境,支持一键启动、协作开发和 AI 辅助编程。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)