GPT-5.2 与 Sora 2 强强联手:开发者的“末日”还是“新生”?万字硬核实测与 API 接入指南

如果你觉得这篇文章对你有启发。欢迎在评论区留下你的看法。或者分享你正在用 AI 做什么有趣的项目。我会随机挑选几位朋友。交流一下最新的 Prompt 技巧。不迷路。

作为一名在这个行业摸爬滚打十年的老码农。

最近我的 GitHub Copilot 就像喝了假酒。

代码补全经常出现幻觉。

直到昨天凌晨。

我测试了传说中的 GPT-5.2 和 Veo 3。

我才明白。

不是工具变笨了。

而是时代的底层逻辑变了。

我们正处在一个“技术奇点”的前夜。

以前我们谈论 AI。

更多是把它当作一个辅助工具。

写写正则。

查查 API 文档。

或者生成一段样板代码。

但这次不一样。

GPT-5.2 的推理能力。

加上 Sora 2 和 Veo 3 的多模态理解能力。

正在重新定义什么是“开发”。

今天这篇文章。

我不讲虚的。

不贩卖焦虑。

我们从底层原理、模型实测、到 API 接入实战。

来一次硬核的深度剖析。

希望能帮你在这次技术洗牌中。

不但活下来。

还能活得更好。

一、 模型进化:从“鹦鹉学舌”到“逻辑怪兽”

很多人对 GPT-5.2 的认知还停留在 GPT-4 时代。

觉得无非就是参数大了一点。

语料多了一点。

大错特错。

如果说 GPT-4 是一个博闻强记的文科生。

那么 GPT-5.2 就是一个精通算法的架构师。

它的核心升级在于“思维链”(Chain of Thought)的内化。

在处理复杂编程任务时。

它不再是概率性地预测下一个 token。

而是先构建逻辑树。

自我反思。

然后才输出代码。

举个通俗的例子。

以前你让 AI 写一个贪吃蛇游戏。

它可能背诵了一段网上的代码给你。

变量名可能都还没改。

现在你让 GPT-5.2 写一个“基于区块链技术的去中心化贪吃蛇”。

它会先思考智能合约的架构。

思考状态同步的延迟问题。

思考前端渲染的优化。

最后给你一套完整的解决方案。

这就是质的区别。

不仅如此。

视觉模型 Veo 3 和 Sora 2 的加入。

让 AI 有了“眼睛”。

你可以直接把 UI 设计稿丢给它。

它能识别出按钮的圆角半径。

阴影的参数。

甚至能理解设计师想表达的交互逻辑。

然后直接生成 Flutter 或 React 代码。

精准度高得吓人。

二、 开发者面临的“三座大山”

技术虽好。

落地却难。

这也是我后台私信问得最多的问题。

既然模型这么强。

为什么我的项目里还用不上?

主要卡在三个地方:

第一,账号风控。

OpenAI 和 Google 的风控越来越变态。

普通开发者想申请一个高并发的 API Key。

简直比登天还难。

动不动就封号。

项目刚上线。

Key 没了。

这谁顶得住?

第二,网络延迟。

直连海外服务器。

那个延迟波动。

做实时应用根本没法看。

你需要极其复杂的代理池维护。

这本身就是巨大的运维成本。

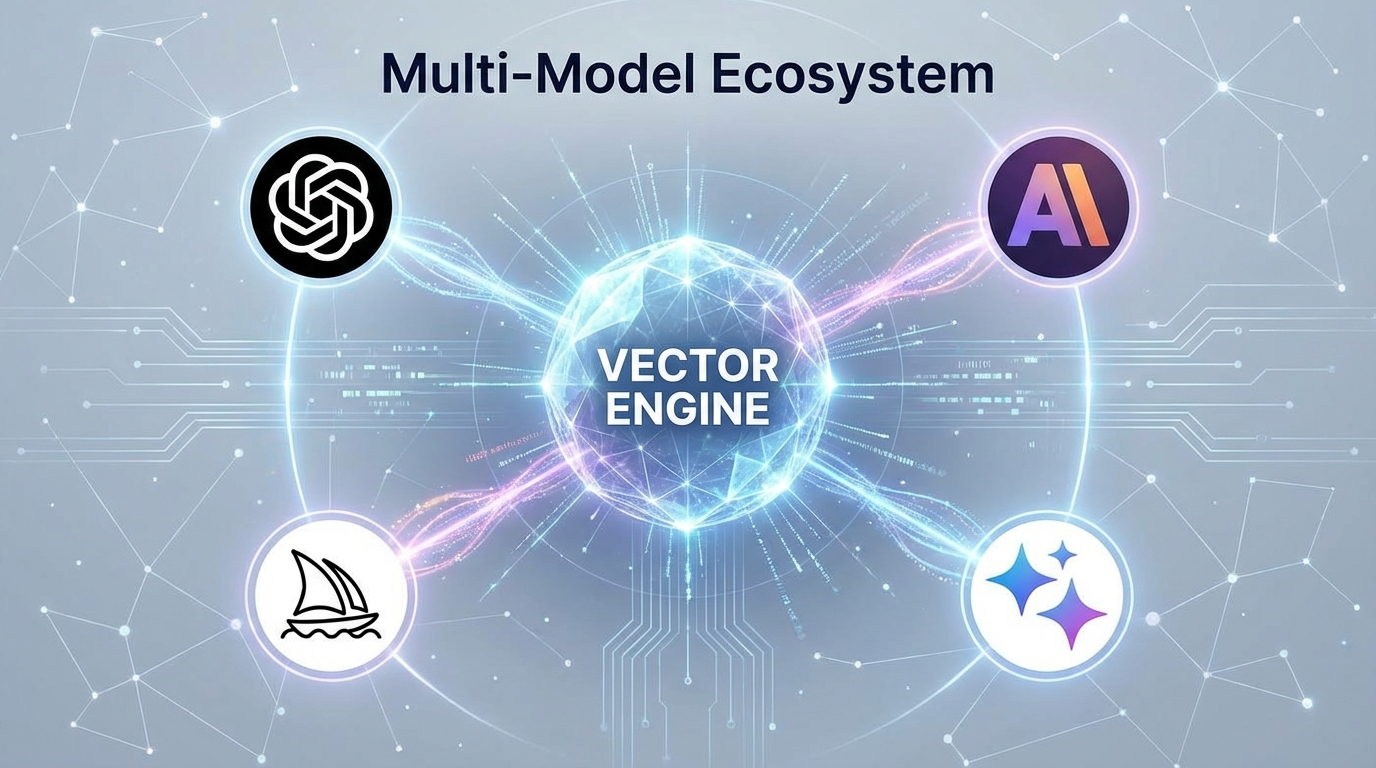

第三,多模型聚合。

你想用 GPT 处理逻辑。

用 Claude 处理长文本。

用 Midjourney 画图。

你得维护三套 SDK。

三套计费系统。

代码写得像意大利面条一样乱。

为了解决这“三座大山”。

我测试了市面上几十款 API 聚合服务。

大部分都是二道贩子。

不稳定。

直到我发现了“向量引擎”。

这应该是我目前用过最稳的一个。

它不是简单的转发。

它做了一层企业级的网关封装。

完全兼容 OpenAI 原生格式。

也就是说。

你原来的代码一行都不用改。

只需要换个 Base URL 和 Key。

就能直接调用 GPT-5.2、GPT-5.2-Pro、Sora 2 等最新模型。

为了方便兄弟们测试。

我把注册地址放在这。

大家可以先注册一个备用。

毕竟这种优质资源。

知道的人多了可能会限流。

👉 官方注册直达:https://api.vectorengine.ai/register?aff=QfS4

对于刚接触的朋友。

如果不知道怎么配置。

这里有一份详细的《向量引擎全栈接入教程》。

涵盖了 Python、Node.js 甚至 Java 的接入方式。

建议收藏:

👉 硬核教程:https://www.yuque.com/nailao-zvxvm/pwqwxv?#

三、 实战演练:用 50 行 Python 代码重构你的工作流

光说不练假把式。

下面我们来实战一下。

假设我们要开发一个“智能代码审计助手”。

它需要读取你的本地代码。

分析潜在的 Bug。

并给出修复建议。

在以前。

你需要训练一个 BERT 模型。

效果还很差。

现在。

利用向量引擎聚合的 GPT-5.2-Pro。

我们只需要几十行代码。

首先。

安装 OpenAI 的官方库(没错,直接用官方库):

pip install openai

然后配置客户端:

注意看。

这里的 base_url 填的是向量引擎的地址。

这就绕过了复杂的网络问题。

接下来。

我们定义一个核心函数。

利用 System Prompt 来设定 AI 的角色。

如果你用的是原版 GPT-4。

可能需要很复杂的提示词工程。

但在 GPT-5.2-Pro 面前。

你只需要用自然语言描述需求。

它就能理解得非常透彻。

比如我们可以这样写提示词:

“你是一个拥有 20 年经验的 Linux 内核开发者,请帮我审查这段代码的内存泄漏风险。”

实测下来。

它的 Code Review 质量。

已经超过了大部分中级工程师。

甚至能发现一些非常隐蔽的竞态条件(Race Condition)。

更有趣的是。

我们可以结合 Veo 3 的能力。

做一个“截图写代码”的功能。

原理很简单。

把前端页面的截图转成 Base64 编码。

通过向量引擎的视觉接口发给 Veo 3。

让它返回 HTML + Tailwind CSS 代码。

我昨天试了一下复刻 CSDN 的首页。

布局还原度达到了 95% 以上。

连响应式布局都给我写好了。

这种开发效率的提升。

是指数级的。

四、 深入解析:Token 经济学与成本控制

很多开发者不敢用 API。

是怕贵。

确实。

如果你直接用原价的 GPT-5.2。

跑几个大任务钱包就空了。

但这里有个信息差。

向量引擎这种聚合平台。

因为是大批量采购的 Token。

通常会有折扣。

而且。

我们需要学会“模型路由”(Model Routing)。

这也是高级 AI 工程师的必修课。

什么意思呢?

就是“杀鸡焉用牛刀”。

对于简单的文本分类、情感分析任务。

我们可以调用便宜的 GPT-4o-mini 或者更轻量的模型。

只有在遇到复杂的逻辑推理。

或者生成核心业务代码时。

才切换到 GPT-5.2-Pro。

通过在代码里做一个简单的判断逻辑。

我们可以把成本降低 80% 以上。

而效果几乎不打折。

这才是技术人的智慧。

不要只做一个 API 的调用者。

要做一个架构的设计者。

五、 未来已来:Agent 智能体与 RAG 的结合

文章的最后。

我想聊聊未来。

单纯的 Chat 模式已经过时了。

接下来的风口。

一定是 Agent(智能体)+ RAG(检索增强生成)。

想象一下。

你不再是给 AI 下指令。

而是给 AI 一个目标。

比如:“帮我分析最近一周 GitHub 上的热门 Python 项目,并写一篇总结博客。”

AI 会自动拆解任务。

第一步:写爬虫去 GitHub 抓数据。

第二步:调用 RAG 技术检索相关技术文档。

第三步:用 GPT-5.2 分析代码亮点。

第四步:生成文章并推送到你的博客。

全程不需要人工干预。

这就是我们现在能做的事情。

所有的这些能力。

都需要一个稳定、高速、多模态的底层 API 支持。

所以我才反复强调工具的重要性。

工欲善其事。

必先利其器。

别让繁琐的网络配置消磨了你的创造力。

别让高昂的成本阻碍了你的探索。

趁着现在技术还在爆发期。

赶紧上车。

把这些最新的模型集成到你的产品里。

哪怕只是写一个小脚本。

也是在拥抱未来。

最后再提醒一下大家。

好的通道真的很紧缺。

刚才提到的那个注册链接。

建议大家保存好。

说不定哪天就是你项目的救命稻草。

技术在这个时代。

不仅仅是谋生的手段。

更是我们对抗平庸的最强武器。

愿每一位 CSDN 的开发者。

都能在 AI 的浪潮中。

找到属于自己的那艘方舟。

我们代码里见。

结语与互动

如果你觉得这篇文章对你有启发。

欢迎在评论区留下你的看法。

或者分享你正在用 AI 做什么有趣的项目。

我会随机挑选几位朋友。

交流一下最新的 Prompt 技巧。

点赞、收藏、关注。

不迷路。

更多推荐

已为社区贡献19条内容

已为社区贡献19条内容

所有评论(0)