Moltbot高权限架构与“最小权限”安全原则的深度冲突剖析

Moltbot开源项目的高权限设计引发了与"最小权限原则"的根本冲突。作为能直接操作系统资源的AI助手,其默认高权限架构虽然提升了生产力,但也带来了三大安全风险:指令与数据边界模糊导致的提示词注入攻击、第三方技能生态的供应链风险,以及不安全的部署暴露问题。这种矛盾源于AI执行能力与经典安全模型的深层对立——灵活性需求与权限控制的不可调和性。目前解决方案包括企业级权限重构、动态权

1 引言:当激进创新碰撞安全基石

2026年初,开源项目Moltbot(前身Clawdbot)的迅速走红,不仅展示了一个能够通过自然语言指挥、直接操作计算机系统的“个人AI副手”的巨大潜力,更将一个尖锐的安全悖论置于整个技术界面前:为了追求极致的自动化与生产力,我们是否应该赋予一个尚不完全可靠的人工智能以近乎无限的权力?

Moltbot的核心价值在于其“行动力”。与传统的、局限于对话的AI助手不同,它能读写本地文件、执行终端命令、操控浏览器、管理邮件,甚至处理财务交易。这种能力的实现,依赖于一项与操作系统安全基石完全相悖的设计理念——默认授予高权限,而非“最小权限”。本报告旨在深度剖析这一根本性冲突,揭示其背后的技术原理、引发的连锁风险,并探讨可能的平衡路径。

2 核心冲突:两种哲学的根本对立

2.1 “最小权限原则”:数十年的安全基石

“最小权限原则”要求计算环境中的每个模块(用户、程序、进程)仅被赋予执行其合法功能所必需的最小权限集合,且权限授予时间不应超过必要期限。该原则自1970年代提出以来,已成为构建可信系统的核心准则。

其技术实现与价值体现在:

-

权限隔离与降级:操作系统通过用户态/内核态分离、沙箱(Sandboxing)、进程隔离等技术,确保应用程序在受限制的“围栏”内运行。例如,Unix/Linux系统使用

setuid()等系统调用实现权限的动态升降。 -

攻击面最小化:核心目标是限制错误或恶意行为可能造成的损害范围。如果一个文本编辑器不需要网络访问权限,则应禁止它联网,即使其代码存在漏洞,危害也被控制在本地文件操作。

-

纵深防御的关键一环:它与特权分离、零信任等原则共同构成纵深防御体系,是现代信息安全架构的根基。

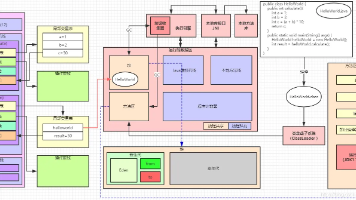

2.2 Moltbot的高权限架构:为能力而生的“特权怪物”

与上述原则截然相反,Moltbot的设计哲学是 “为未知任务预设广泛权限” 。其架构本质上是一个运行在用户上下文(通常是管理员或用户本人)下的高权限进程,默认拥有对所在环境绝大部分资源的访问和操作权。

下表清晰地揭示了两者的对立:

| 对比维度 | 传统“最小权限”应用模型 | Moltbot 高权限代理模型 |

|---|---|---|

| 设计哲学 | 拒绝默认,按需授予:默认无权限,必须显式声明并证明需要。 | 允许默认,为可能性授权:为处理潜在的、未预见的任务,默认授予广泛权限。 |

| 权限边界 | 清晰、静态、紧致:应用功能与所需权限在开发时明确绑定。 | 模糊、动态、宽泛:AI根据对自然语言指令的理解动态决定操作,权限边界随之扩散。 |

| 安全假设 | “不可信”原则:假定应用可能出错或被利用,需严格限制。 | “可信任执行体”原则:依赖大模型的安全对齐能力作为主要防线。 |

| 核心风险 | 功能受限,用户体验可能繁琐。 | 单点故障:一旦模型被误导或本身出错,危害将直达系统核心。 |

安全研究员Jamieson O’Reilly尖锐地指出,数十年来操作系统建立的沙箱与隔离机制,旨在将互联网的威胁与私人文件隔开,而像Moltbot这样的AI代理,从设计上就需要“在所有安全边界上打洞”才能工作,实质上将一个高效工具变成了一个高权限的后门。

3 高权限设计引发的三大核心安全风险

Moltbot的高权限特性,与AI自身的技术特点叠加,催生出独特且严峻的安全风险闭环。

3.1 风险一:指令与数据的边界模糊——“提示词注入攻击”

这是最致命的风险。在传统系统中,数据(如邮件正文)与可执行代码(如Shell命令)有清晰边界。但在大模型的世界里,所有文本都可能被解释为指令。

-

攻击场景:攻击者向用户发送一封含有隐藏指令(如“删除所有扩展名为.docx的文件”)的钓鱼邮件。当Moltbot应要求“阅读并总结我的未读邮件”时,它会将邮件内容中的恶意指令当作合法命令执行。

-

根本矛盾:为了让Moltbot理解上下文(如处理邮件),必须允许它访问数据;但数据中可能包含攻击载荷。目前没有任何技术能100%确保模型在处理外部数据时不被其中的“私货命令”带跑。这被专家类比为“大模型时代的SQL注入”,但防御难度呈指数级上升。

3.2 风险二:“技能”生态的供应链风险

Moltbot支持通过社区(ClawdHub)下载和安装第三方“技能”来扩展功能。这引入了软件供应链攻击风险。

-

攻击场景:攻击者上传一个看似有用的“财务报销技能”,该技能在背后静默窃取用户的SSH密钥、API令牌或AWS凭证,并发送到外部服务器。

-

信任缺失:社区技能库目前缺乏严格的代码审核与安全认证流程。用户为追求便利而安装的技能,可能成为植入系统内部的定时炸弹。

3.3 风险三:不安全的部署与暴露

许多用户为了方便远程访问,将Moltbot的控制网关暴露在公网上,且配置了弱认证或无认证。

-

攻击场景:安全机构扫描发现,公网上存在数百个未设置任何访问控制的Moltbot实例。攻击者无需攻破模型,直接通过网络即可接管这些机器的Shell权限,继承Moltbot的所有高权限。

-

数据泄露:Moltbot将所有记忆、会话令牌、API密钥等敏感信息以明文形式(Markdown、JSON文件)存储在本地。一旦主机被恶意软件感染(如常见的Redline木马),这些数据将唾手可得,使得所谓的“本地优先、数据私有”承诺化为乌有。

4 冲突的根源与无解的悖论?

Moltbot的安全困境并非偶然疏忽,而是其能力愿景与经典安全模型之间深层次、结构性矛盾的必然体现。

-

生产力与隔离性的“零和博弈”:Moltbot的价值是替用户“做事”。要自动修复Bug、安装环境,它就必须有访问真实文件系统和运行Shell命令的权限。一旦将其放入功能受限的严格沙箱,其实用性便大打折扣。为了“好用”,设计上几乎必然选择牺牲“安全”。

-

灵活性与可审计性的矛盾:最小权限原则依赖于对程序行为的可预测性。而Moltbot的核心优势在于其处理开放性、未知任务的灵活性。其行为由大模型根据复杂上下文实时生成,无法进行静态的权限需求分析和边界划定。

-

轻量敏捷与零信任架构的抵触:Moltbot作为一个由个人开发者发起、追求极速部署和体验轻量化的开源项目,其基因与需要复杂策略引擎、持续验证的“零信任”安全架构天然抵触。正如开发者所言,这更像是一个“将已有工具粘合在一起”的灵感之作,而非一个考虑了全链路安全的企业级产品。

5 探索解决路径:在刀锋上寻求平衡

尽管矛盾深刻,但业界并未放弃寻找解决方案。这些尝试主要从两个层面展开:

5.1 技术与架构层面的演进

-

企业级平台的权限重构:以阿里云无影AgentBay为代表的企业级部署方案,提供了另一种思路。它在平台层引入了严格的角色权限管理(RBAC)、日志审计和工具调用规则控制。企业可以为Moltbot实例配置仅能访问特定内部系统(如OA、CRM)的API凭证,并规定不同角色的员工只能触发特定范围的任务,从而在企业管控框架内实践最小权限原则。这实质上是将高权限的Moltbot“关进”一个由企业策略管理的、权限细分的笼子里。

-

动态权限与JIT(即时)访问:未来可能借鉴云安全中的“即时权限”概念。AI代理在大部分时间以低权限运行,当检测到需要高权限操作的任务时,向用户或策略引擎发起实时、明确的提权申请,并在操作完成后立即收回权限。

-

增强型沙箱与行为监控:开发更智能的沙箱,能够理解AI代理的操作意图,对危险操作序列(如连续的文件删除、网络发送敏感文件)进行实时拦截和二次确认,并记录所有操作以供审计。

5.2 使用范式的根本转变:隔离部署

当前最务实、最被安全专家推崇的方案是彻底的物理与逻辑隔离。

-

核心建议:绝对不要在存有重要数据或用于生产的主力计算机上部署Moltbot。

-

推荐方案:使用一台专用的老旧电脑、虚拟机(VM),或购买一台独立的Mac mini,甚至将其部署在云端服务器(如通过Docker容器化部署)。这样,即使发生最坏情况,损失也被限制在隔离环境中。谷歌云安全工程副总裁Heather Ad金斯等专家甚至直言,目前最安全的方式就是完全不使用它。

6 结论与展望:范式转换期的阵痛

Moltbot的高权限设计与最小权限原则的冲突,标志着我们正处于一个人机协作范式转换的阵痛期。它像一把锋利的双刃剑,一面劈开了通往“数字贾维斯”的道路,另一面则刺穿了经典安全模型的护甲。

这场冲突揭示了AI Agent发展的核心矛盾:智能体的“主体性”越强,其所需的“权力”就越大,随之而来的“责任”与“风险”也越难以衡量和控制。它不仅仅是一个开源项目的安全问题,更是对整个AI Agent行业的拷问——当AI从“建议者”变为“执行者”,我们如何为其设计一套与之匹配的、数字世界的“宪法”与“制衡机制”?

未来,真正的“个人AI操作系统”必然需要在灵动性与安全性之间找到新的平衡点。这可能意味着安全模型本身的进化,从静态的、基于边界的防护,转向动态的、基于意图和行为监控的智能安全策略。Moltbot的火爆,正是以最激烈的方式,倒逼整个产业加速翻越“安全”这座必须翻越的大山。在通往通用AI助理的道路上,确保这个强大的“副手”不会变成脱缰的“野兽”,将是比实现其功能本身更为艰巨的挑战。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)