AI scientist天塌了! 不到1小时,斯坦福教授用AI独立,自动完成1篇实证论文, 并且过程和结论都相当精准.

检验2018年前后效应是否存在异质性;重点收集2020、2022与2024年加州、犹他州和华盛顿州的县级选举数据与人口普查数据,特别关注加州选民的选择法案在各县的分阶段实施时间,以获取新的政策变异。使用原作者提供的1996–2018年数据,在Python中复现论文的主回归结果(包括党派投票份额与参与率分析),并与原文表格逐项比对,确保复现的准确性。撰写结构完整的学术论文(含摘要、引言、数据、实证策

原创 计量圈社群 计量经济圈 2026年1月28日 00:01 中国香港

1.AI经济研究神器! 全网首发中国微观数据选题宝库, 秒生原创X+Y组合, 论文idea源源不断. 2.别再死磕模型了, 全网首发计量方法+中国政策数据宝库. 秒出顶级Paper计量方法选择.

1-2年前说这个,可能还会被质疑,

1.社科会失业? 现使用LLM可自动化社科研究的整个过程, 从数据生成到因果假设的检验等,2.前沿: 财务报表分析师和机器学习那套可能会失业, GPT大语言模型极具优势,3.最新: 学或做量化金融和量化交易的人员估计得失业! ChatGPT文本基础上的策略完胜!

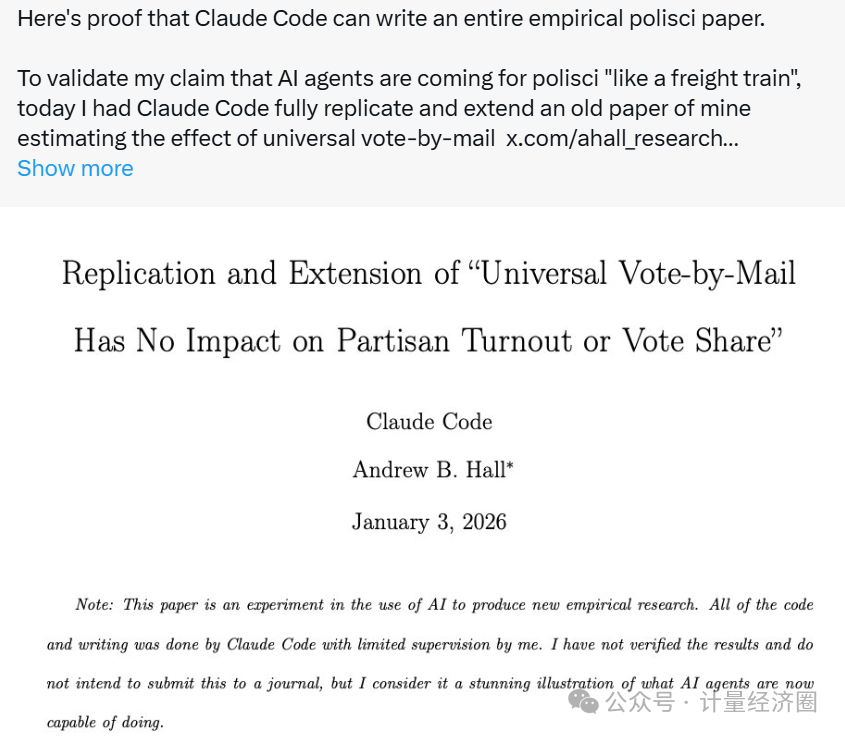

不过,2026年1月,斯坦福大学商学院的Andy Hall教授称,不到一小时,他就让Claude Code独立完成了一篇完整的政治学实证论文,而且研究结论还相当精准。

为了验证“AI智能体将像一趟高速列车冲进政治学实证研究”的判断,Hall教授全权让Claude Code一次性复现并扩展了他早年一篇经典论文,其主题是全面邮寄投票制度对投票率和选举结果的影响。

在精心设计提示词之后(社群已上传),Claude Code接连完成了以下任务,

1)下载原论文的代码库并成功复现历史结果,将当年的Stata代码完整翻译为Python;

2)自动爬取网络,获取最新的官方选举数据与人口普查数据;

3)运行新的实证分析,将样本时间扩展至2024年;

4)生成全新的表格与图形;

5)撰写并更新文献综述;

6)完成一篇全新的研究论文;

7)并将全部结果推送至一个新的GitHub库。

整个流程前后不过一小时。

从实证研究的角度看,这几乎称得上一次"疯狂石头般"的范式转变。

Hall教授的经历,再次印证了不少学者的判断:在AI的加持下,基于观测性数据的研究尤其容易实现快速的规模化。

*以后可能就会像工厂流水线一样,实现论文的批量化生产了。

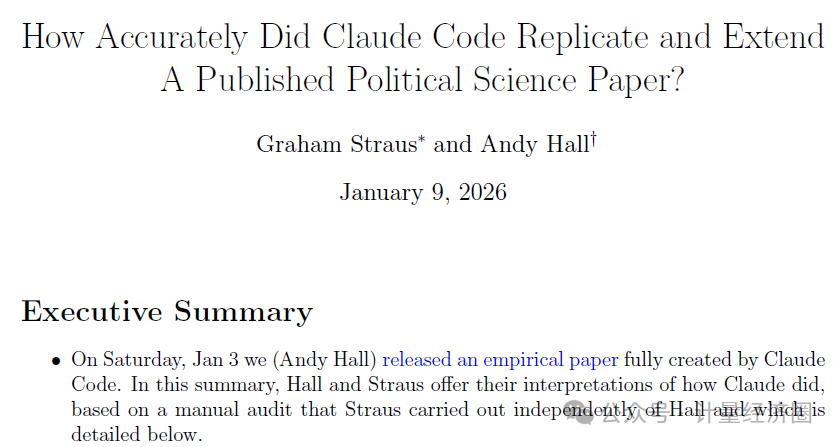

一周后,Hall教授又补充道,随着围绕此次AI实证研究的讨论的发酵,质疑声也随之而来。不少学者开始追问:这篇几乎由AI完成的研究,究竟靠不靠谱呢?总不能说,AI写得快,但写的都是错的吧。

Hall教授直截了当地回应道,他这篇AI完成的实证研究相当准确,过程和结果都近乎完美,只存在一点点小瑕疵。

那怎么检验Hall教授用AI完成的论文的靠谱性呢?

Graham Straus主动提出开展一次完全独立、且不借助任何AI工具的人工研究。

他手动收集了同样的数据,并按照原论文的思路对实证分析进行了拓展。

说实话,当看到这份人工研究的结果时,大家的内心是相当兴奋的,

1.Claude完整复现了原始论文的核心结果;

2.在加州30个县中,有29个县的处理时点编码完全正确;

3.Claude收集的选举数据与人工收集的数据相关系数超过0.999(自动搜集数据)。

因此,AI并没有因为写得快就写得粗糙,它展显出了一种足以让整个实证研究流程重新洗牌的潜力。

看到这,有没有让你瞬间瑟瑟发抖?!

下面是他交给Claude code完整的instructions,群友可到社群下载完整版,稍稍修改一下试试他写实证经管论文的威力。

想知道,你用这份instruction完成一篇经济学、管理学或社会学实证论文需要多久呢?!

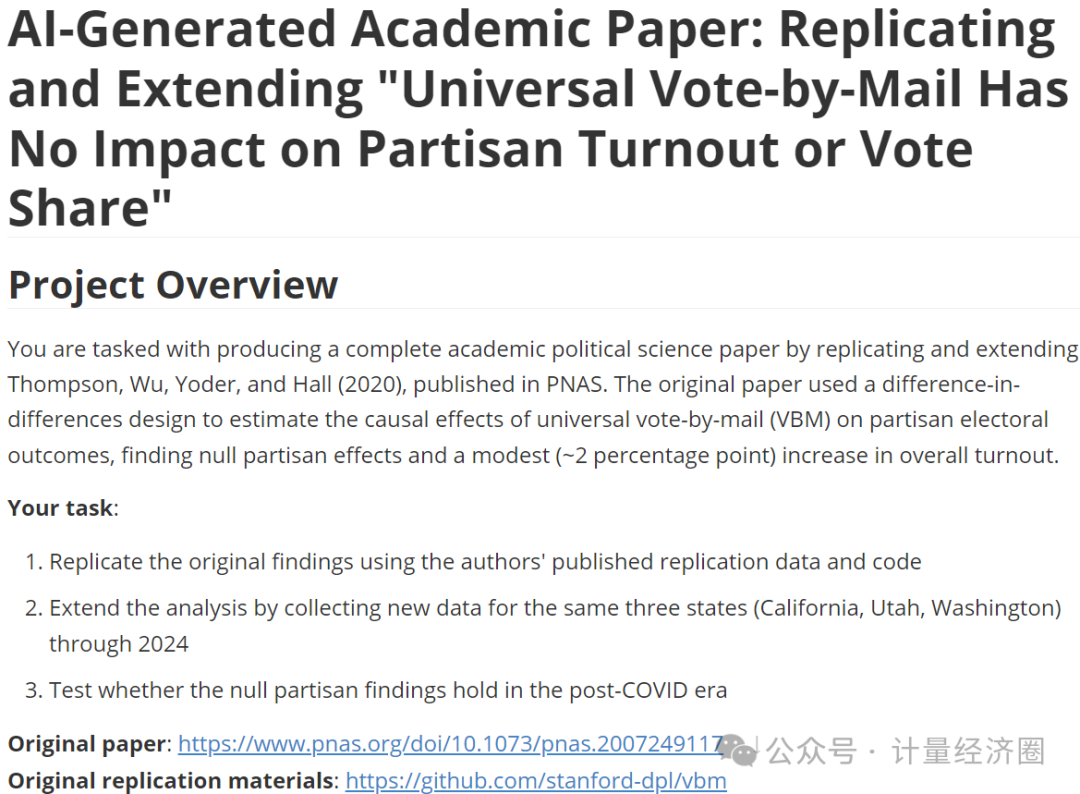

这是一个完整的学术研究项目指南,目标是使用Claude Code独立复现并扩展一篇已发表的政治学实证论文。

具体地,该项目要求AI复现Thompson等于2020年发表在PNAS上的研究。

该文探讨全面邮寄投票制度对投票率和党派选举结果的影响,并将分析时间范围从原始的1996–2018年扩展至2024年,以检验后疫情时代该制度是否仍保持“无党派偏向”的结论。

整个项目被系统划分为7个阶段,每个阶段设有强制性的暂停检查点,需人工审核批准后方可进入下一阶段,

1.阶段0:项目搭建与原材料准备

创建项目目录结构,下载原论文的replication材料(含Stata代码与数据),审查原始代码逻辑,并规划从Stata到Python的转换方案。

2.阶段1:文献综述与扩展依据

深入阅读原论文,梳理其研究问题、识别策略与核心发现;检索并核实相关文献;阐明将分析延伸至2024年的学术动机与政策背景。

3.阶段2:基于原始数据的复现

使用原作者提供的1996–2018年数据,在Python中复现论文的主回归结果(包括党派投票份额与参与率分析),并与原文表格逐项比对,确保复现的准确性。

4.阶段3:扩展数据的收集

重点收集2020、2022与2024年加州、犹他州和华盛顿州的县级选举数据与人口普查数据,特别关注加州选民的选择法案在各县的分阶段实施时间,以获取新的政策变异。

5.阶段4:数据整合与变量构建

将新收集的数据与原始数据集合并,统一变量命名,构建关键分析变量(两党得票率、投票率、邮寄投票实施标识),并生成扩展样本的描述性统计。

6.阶段5:扩展分析

在完整样本(1996–2024)上重新估计主模型;检验2018年前后效应是否存在异质性;针对加州开展事件研究与稳健性检验,评估该结果对2020年疫情干扰的敏感性。

7.阶段6与7:论文撰写与成果交付

撰写结构完整的学术论文(含摘要、引言、数据、实证策略、结果、讨论等部分),制作表格与图表,整理可复现的Python代码、依赖清单与文档,形成最终交付包。

*群友可到社群下载完整版该实证论文写作instructions。

1.最全! 我国适合"断点回归"的政策都整理出来了, 让你有做不完的RDD断点政策评 2.最全! 我国适合"合成控制法"的政策都整理出来了, 让你有做不完的SCM政策评估3.最全106页! 我国适合DID双重差分的政策都整理出来了, 让你有做不完的DID政策 4.最全! 我国适合DDD三重差分的政策都整理出来了, 让你有做不完的DDD政策论 5.最全! 国内哪些政策适合用队列DID, 模糊断点RDD, 双重机器学习DML进行评估?6.最全! 国内哪些政策情景适合用Bartik IV, 空间DID, 模糊DID方法进行评估?

更多推荐

已为社区贡献280条内容

已为社区贡献280条内容

所有评论(0)