成功解决 RuntimeError: Out of memory: CUDA out of memory 报错

本文针对vLLM 0.5.0在超长上下文(≥8k)推理时出现的"CUDA out of memory"错误进行深入分析。该问题源于KV Cache分配逻辑漏洞,导致显存计算错误。解决方案包括:升级vLLM至0.5.1+版本、拆分超长上下文、使用FP16混合精度、优化KV Cache管理、调整批量大小等。通过综合运用这些方法,开发者可在有限显存条件下稳定运行大模型长文本推理任务。

文章目录

成功解决 RuntimeError: Out of memory: CUDA out of memory 报错

—— vLLM 超长上下文显存优化实践

前言

在大规模语言模型(LLM)推理或训练过程中,显存管理是影响模型稳定性和性能的关键因素。开发者在使用 vLLM 进行超长上下文推理时,常会遇到如下报错:

RuntimeError: Out of memory: CUDA out of memory. Tried to allocate 2.30 GiB

尤其是当输入上下文长度超过 8k 时,即使通过 gpu_memory_utilization 配置显存利用率,模型仍可能触发显存溢出。通过深入分析,我们发现 vLLM 0.5.0 的 KV Cache 分配逻辑存在漏洞:超长上下文的 KV Cache 分配错误,导致显存占用计算不准确,从而出现意外溢出。本文将系统解析报错原因、环境检查方法、修复和优化方案,以及显存管理最佳实践,帮助开发者安全高效地使用 vLLM。

一、问题描述

报错通常出现在以下场景:

- 使用 vLLM 0.5.0 推理超长上下文(≥ 8k tokens)

- 设置

gpu_memory_utilization限制显存使用 - 模型在生成过程中或加载大上下文时直接触发 CUDA OOM

示例代码:

from vllm import LLM, SamplingParams

llm = LLM("facebook/opt-13b", gpu_memory_utilization=0.7)

input_text = "..." * 9000 # 超长上下文

result = llm.generate([input_text], sampling_params=SamplingParams(max_tokens=1024))

报错信息:

RuntimeError: Out of memory: CUDA out of memory. Tried to allocate 2.30 GiB

表现为:

- GPU 显存快速被占满

- 即使设置了

gpu_memory_utilization限制,也无法生效 - 对超长上下文推理任务无法执行

二、影响范围

该问题主要影响以下用户场景:

- 超长上下文推理

- 上下文长度 ≥ 8k tokens

- 包括长文档问答、书籍摘要、代码生成等任务

- GPU 显存有限

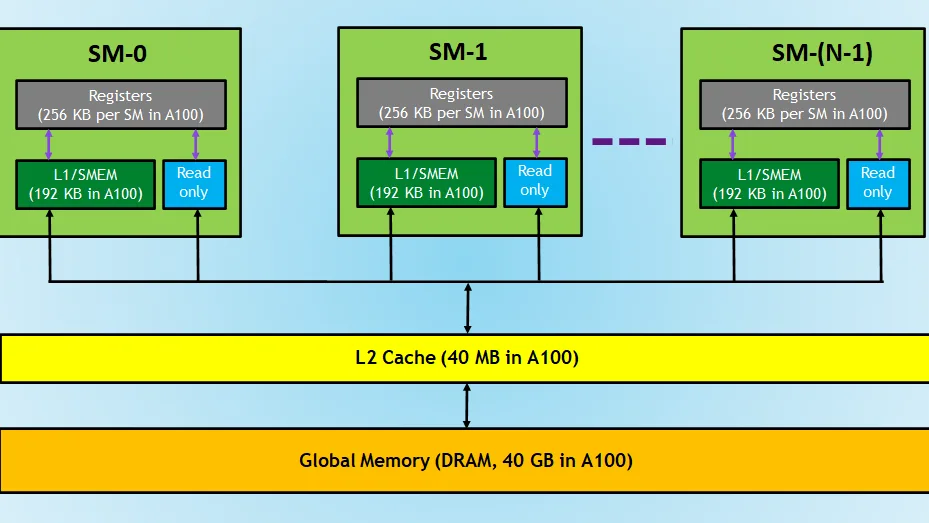

- RTX 3090 24GB、A100 40GB 等显卡

- 对于 24GB 显卡,在处理超长上下文时容易触发 OOM

- vLLM 0.5.0 版本用户

- KV Cache 分配逻辑漏洞

- 即使设置

gpu_memory_utilization,仍可能计算错误

三、原因分析

核心原因在于 vLLM 0.5.0 的 KV Cache 分配逻辑漏洞:

- KV Cache 分配错误

- 在生成超长上下文时,vLLM 为每个 token 生成 key/value cache

- KV Cache 分配大小错误,未考虑超长上下文的扩展

- 导致实际占用显存超过

gpu_memory_utilization限制

- 显存利用率计算错误

gpu_memory_utilization是理论限制,vLLM 在计算实际可用显存时出现 bug- 超长上下文导致 KV Cache 分配计算异常,超过 GPU 实际可用显存

- GPU OOM 触发条件

- 超长上下文 + KV Cache 错误 + 大批量生成

- 最终触发 CUDA Runtime 报错:

Out of memory

四、解决方案

解决方案可分为 升级版本、优化显存管理、拆分上下文、混合精度与张量调度。

1. 升级 vLLM 版本

- 官方已在 vLLM 0.5.1+ 修复 KV Cache 分配逻辑

- 升级命令:

pip install --upgrade vllm

- 升级后,

gpu_memory_utilization可正常限制显存使用

2. 拆分超长上下文

- 对超长文本进行分块处理,避免一次性加载完整上下文

- 示例:

def chunk_text(text, chunk_size=4096):

return [text[i:i+chunk_size] for i in range(0, len(text), chunk_size)]

chunks = chunk_text(input_text)

results = []

for chunk in chunks:

results.append(llm.generate([chunk], sampling_params=SamplingParams(max_tokens=512)))

- 每次仅加载一部分上下文,显存占用可控

3. 使用混合精度(FP16)

- 半精度训练或推理可显著减少显存占用

llm = LLM("facebook/opt-13b", gpu_memory_utilization=0.7, dtype="fp16")

- 在大模型和长上下文场景下尤其有效

4. KV Cache 优化

- 手动清理不再使用的 KV Cache

- 对于生成过程中不需要保留全部历史 token 的任务,可动态释放

# 假设 llm 支持手动清理

llm.clear_kv_cache()

- 避免累积占用过多显存

5. 调整批量大小

- 减少同时处理的文本数量

batch_size调整为 1~2,可避免一次性分配过大 KV Cache

results = llm.generate(batch_inputs, sampling_params=SamplingParams(batch_size=1))

6. GPU 显存监控与调试

- 使用

nvidia-smi实时监控显存使用 - 确认 KV Cache 分配与显存限制一致

- 遇到异常可通过日志分析显存占用峰值

五、注意事项

-

版本升级必须确认

- vLLM 0.5.0 有 KV Cache 漏洞

- 升级到 0.5.1+ 或官方稳定版本

-

上下文拆分策略

- 尽量保证每块上下文长度 ≤ GPU 承载能力

- 可配合 sliding window 或 overlap 方法保持上下文连续性

-

显存管理

- 配合混合精度和动态释放 KV Cache

- 避免一次性分配整个超长上下文

-

批量处理

- 控制 batch size,尤其是长上下文和大模型组合

六、总结

RuntimeError: Out of memory: CUDA out of memory 在 vLLM 0.5.0 中的核心原因是 超长上下文(≥8k)导致 KV Cache 分配逻辑漏洞,即使设置 gpu_memory_utilization,显存仍可能溢出。通过以下措施可彻底解决:

- 升级 vLLM 至 0.5.1+

- 拆分超长上下文,按块推理

- 使用混合精度(FP16)降低显存占用

- 清理 KV Cache,避免累积

- 调整 batch size,监控显存使用

采用这些方法后,开发者可以在 GPU 显存有限的情况下安全运行超长上下文生成任务,保证大模型推理的稳定性和效率,为长文本问答、书籍摘要、代码生成等应用提供可靠支持。

更多推荐

已为社区贡献39条内容

已为社区贡献39条内容

所有评论(0)