【大模型技术报告】LongCat-Flash Technical Report

大型语言模型推理的自回归特性带来了独特的效率挑战。预填充阶段受计算能力限制,而诸如分块预填充[Agrawal et al., 2023]等方法通过规范化数据以实现最优处理。相比之下,解码阶段常因流量模式导致的小规模、不规则批次而受限于内存带宽,这会损害内核性能。因此,优化这些特定情况对于最小化单输出令牌耗时至关重要。现有库(如DeepGEMM [Zhao等人, 2025a])将模型权重映射为与k/

摘要

我们推出LongCat-Flash,这是一个拥有5600亿参数的混合专家(MoE)语言模型,专为实现计算效率与高级智能体能力而设计。出于对可扩展效率的需求,LongCat-Flash采用了两项新颖设计:(a)零计算专家机制,可实现动态计算资源分配,根据上下文需求每个token激活186亿至313亿参数(平均270亿),从而优化资源使用;(b)捷径连接的MoE结构,扩大了计算-通信重叠窗口,相比同等规模模型在推理效率和吞吐量上表现出显著提升。我们开发了一套完整的大模型扩展框架,结合超参数迁移、模型增长初始化、多维度稳定性套件及确定性计算,实现了稳定且可复现的训练。值得注意的是,通过可扩展架构设计与基础设施建设的协同效应,我们在30天内完成了超过20万亿token的训练,同时实现每秒100+ token的推理速度,每百万输出token成本仅为0.70美元。为培育LongCat-Flash的智能体能力,我们在优化混合数据集上进行了大规模预训练,随后针对推理、代码和指令进行定向中期与后期训练,并通过合成数据与工具使用任务进一步强化。综合评估表明,作为非思维型基础模型,LongCat-Flash在主流模型中展现出极具竞争力的性能,在智能体任务中表现尤为突出。LongCat-Flash的模型检查点已开源以促进社区研究。

1.引言

以DeepSeek-V3 [DeepSeek-AI et al., 2025]、Qwen 3 [Yang et al., 2025]和Kimi-K2 [Team et al., 2025]等为代表的大型语言模型的快速发展,充分证明了扩大模型规模和计算资源的有效性。尽管近期的一些进展引发了人们对扩展速度可能放缓的担忧,但我们认为,算法设计、底层系统优化以及数据策略均对进一步推动可扩展智能的前沿发展起着同样关键的作用。这要求在模型架构和训练策略上进行创新,以提高扩展的成本效益,同时还需要系统性的数据策略,以增强模型解决现实世界任务的能力。

本工作中,我们推出LongCat-Flash——一种高效而强大的专家混合语言模型,旨在沿两个协同方向推进语言模型的前沿:计算效率与智能体能力。该模型在数万加速器上进行训练,通过架构创新与精密的多阶段训练方法相结合,实现了可扩展的智能建模。我们的贡献同时涵盖效率与智能体能力两大维度:

• 面向计算效率的可扩展架构设计

LongCat-Flash 的设计与优化遵循两大核心原则:高效的计算利用,以及高效的训练与推理。具体而言:(1)鉴于并非所有标记(token)均等重要,我们在 MoE 模块中引入零计算专家机制,依据标记的重要性为其动态分配计算预算,即根据上下文需求激活 180 亿至 313 亿参数(总参数量为 5600 亿)。为确保计算负载稳定,我们采用由 PID 控制器调节的专家偏置机制,使每标记平均激活参数量维持在约 270 亿。(2)随着通信开销成为 MoE 模型扩展时的瓶颈,我们采用短路连接 MoE(ScMoE)[Cai et al., 2024] 设计以扩展计算-通信重叠窗口。结合定制化的基础设施优化,该设计支持在超过数万加速器的大规模集群上进行训练,并实现高吞吐、低延迟的推理。

• 高效的模型扩展策略

如何有效且高效地扩展模型规模仍是策略设计的关键挑战。为此,我们开发了一套全面的稳定性与扩展框架,用于鲁棒地训练大规模模型:(1)我们成功将超参数迁移策略应用于此大型模型,通过理论保障下的小规模代理模型结果预测最优超参数配置。(2)基于精调优化的半规模检查点,采用模型增长机制初始化模型,相比传统初始化方法获得性能提升。(3)多维度稳定性方案包含原则性的路由器梯度平衡、抑制大幅激活的隐藏状态 z-loss 以及精细调优的优化器配置。(4)为提升大规模集群训练的可靠性,我们引入确定性计算。这确保了实验的完全可复现性,并能在训练过程中检测静默数据损坏(SDC)。这些措施保障了 LongCat-Flash 训练过程的稳定性,未出现不可恢复的损失峰值。

• 面向智能体能力的多阶段训练流程

通过精心设计的训练流程,LongCat-Flash 被赋予先进的智能体行为。初期工作聚焦于构建更适合智能体后训练的基础模型:我们设计了两阶段预训练数据融合策略,以集中推理密集型领域数据。在中期训练阶段,我们增强模型的推理与代码能力,同时将上下文长度扩展至 128K 以满足智能体后训练需求。在此强化基础模型之上,我们实施多阶段后训练。针对智能体任务中高质量、高难度训练数据稀缺的问题,我们设计了一个多智能体合成框架,从信息处理、工具集复杂度和用户交互三个维度定义任务难度——利用专用控制器生成需要迭代推理与环境交互的复杂任务。

总体而言,得益于可扩展架构设计、训练策略与基础设施建设的协同效应,LongCat-Flash在实现高训练吞吐量的同时保持了低推理延迟。值得注意的是,我们仅用30天时间完成了5600亿参数模型在20万亿词元上的预训练,并在无需人工干预进行故障处理的情况下实现了98.48%的时间可用率。在推理阶段,于H800集群上的大规模部署效率超过每秒100个输出词元(TPS),每百万输出词元的成本仅为0.7美元,与同等规模模型相比展现出卓越的性能表现。

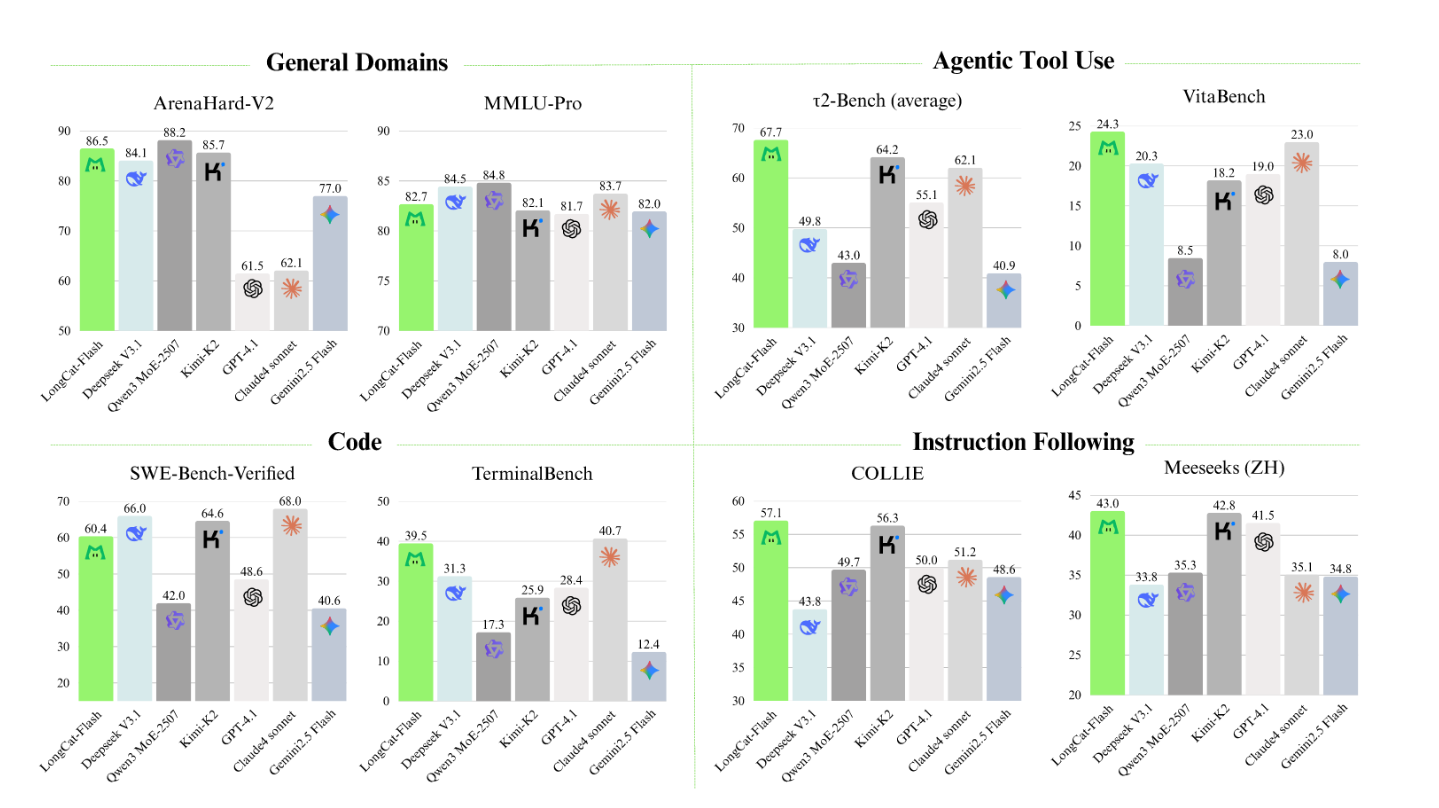

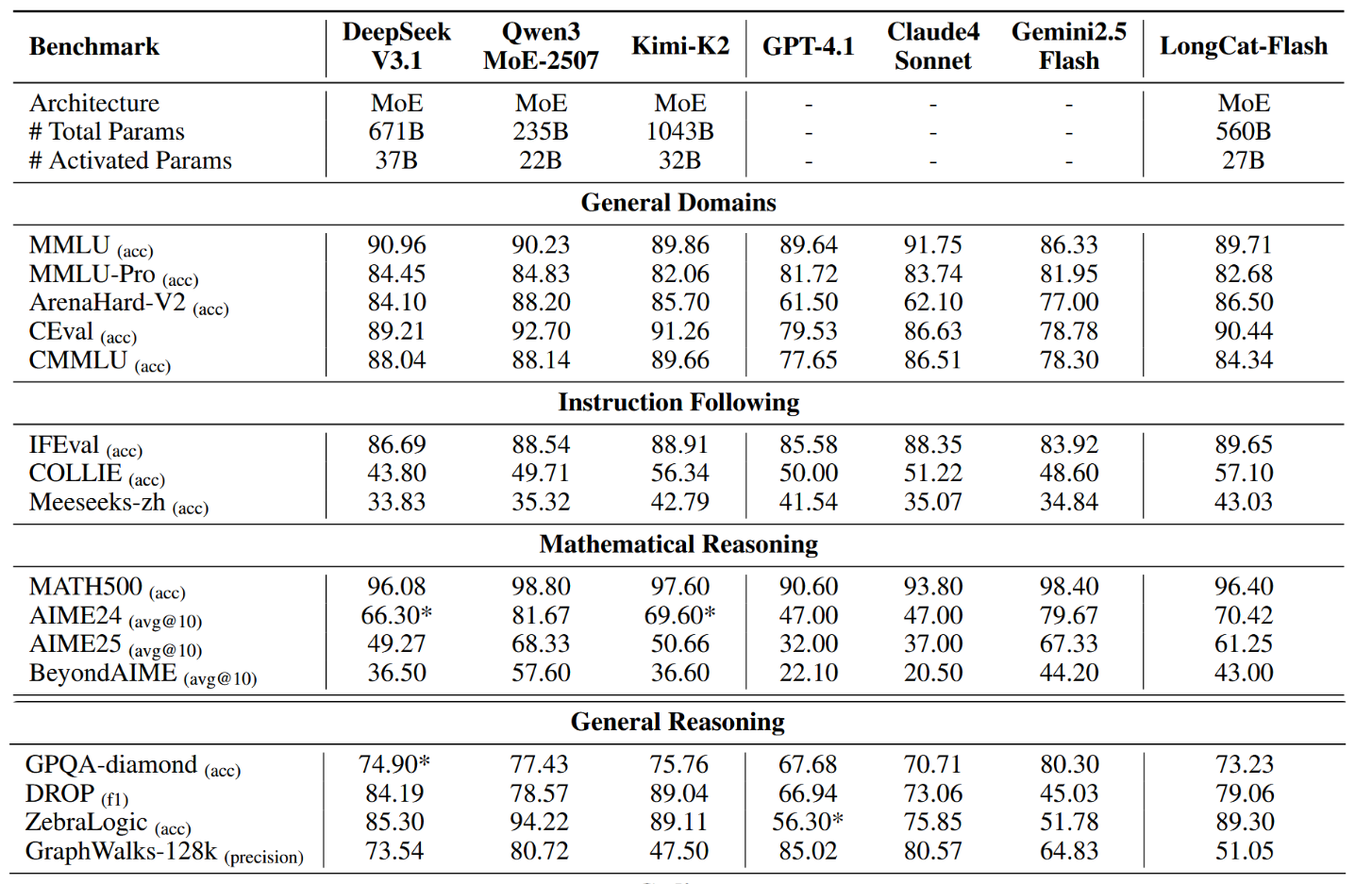

我们在多项基准测试中评估了LongCat-Flash的基础版本和指令微调版本,其概览如图1所示。作为一种非思考模型,LongCat-Flash在参数量更少且推理速度更快的同时,取得了与包括DeepSeek-V3.1 [DeepSeek-AI et al., 2025]和Kimi-K2 [Team et al., 2025]在内的最先进非思考模型相媲美的性能。具体而言,LongCat-Flash在ArenaHard-V2上得分为86.5,在TerminalBench上得分为39.5,在τ 2-Bench上得分为67.7,展现出在通用领域、编码及智能体工具使用方面的强大能力。为减轻现有开源基准测试可能存在的污染问题并提升评估可信度,我们精心构建了两项新基准测试:Meeseeks [Wang et al., 2025a] 与 VitaBench。Meeseeks 通过迭代式反馈框架模拟真实的人机交互,以评估多轮指令遵循能力,其中 LongCat-Flash 的得分与前沿大语言模型持平。VitaBench 则依托真实商业场景,评估模型处理复杂现实任务的能力,在此项测试中 LongCat-Flash 的表现优于其他大语言模型。

图1:LongCat-Flash 的基准测试性能。

在本报告后续部分,我们将首先详述LongCat-Flash的架构与创新之处。随后阐述其预训练与后训练流程,包括训练策略、数据构建方法及评估结果。最后,我们将探讨训练LongCat-Flash过程中遇到的挑战及解决方案,并介绍如何利用其独特架构实现优化的推理与部署方法。

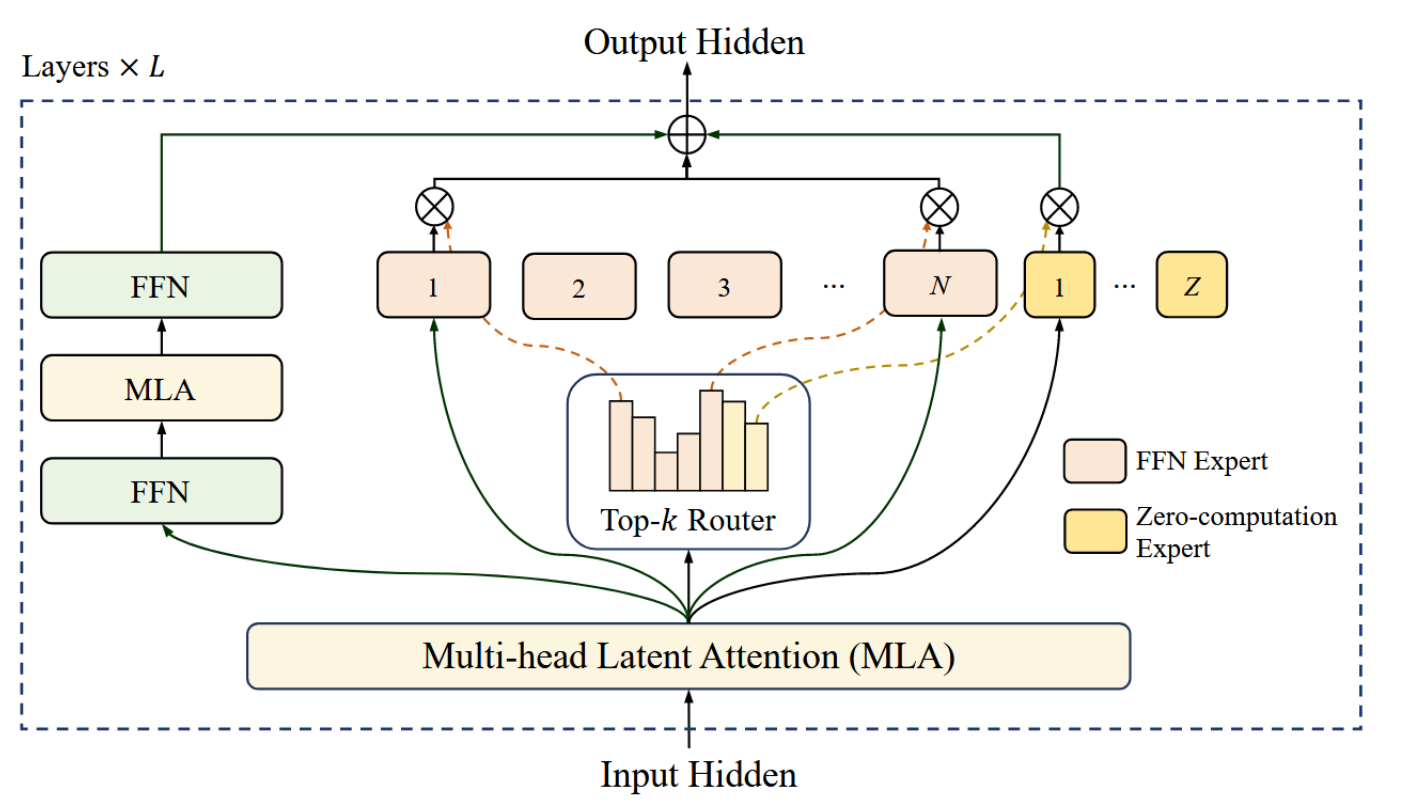

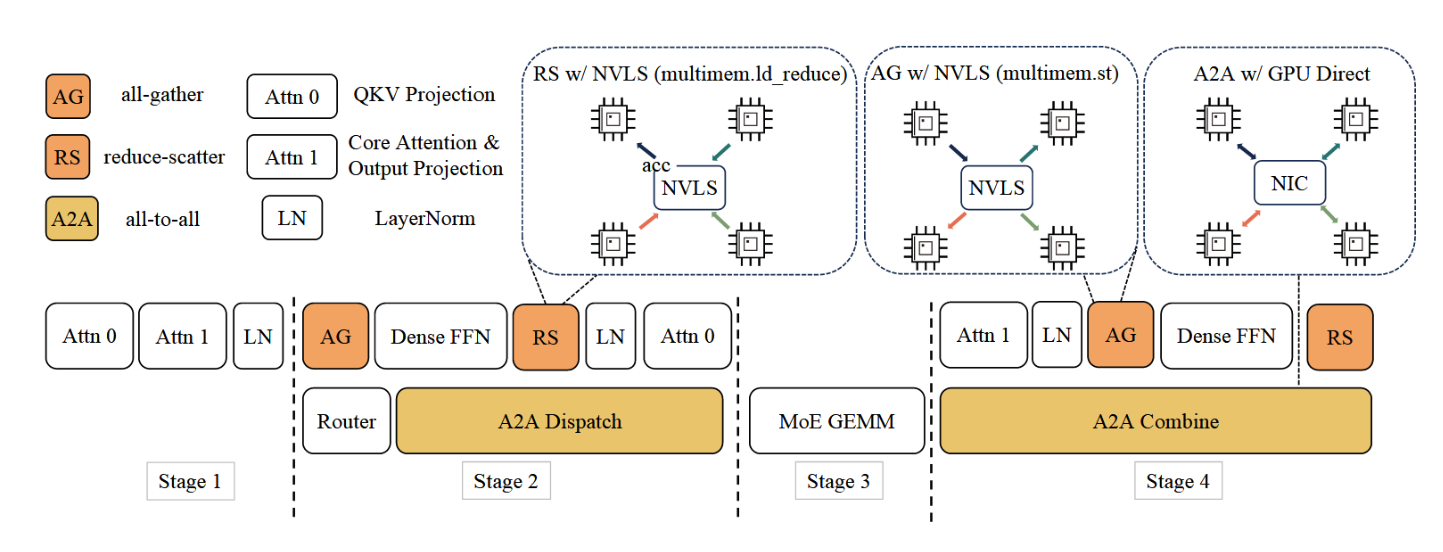

2.架构

LongCat-Flash采用了一种新颖的混合专家模型架构,其包含两项关键创新(图2):(1)该MoE模块引入了零计算专家[Jin等人,2024年],以实现动态计算,使得各令牌能够根据其上下文重要性消耗可变的计算资源。此外,通过自适应专家偏置机制对平均计算负载进行调控。(2)每一层整合了两个多头潜在注意力模块[Liu等人,2024a]以及多个异构前馈网络模块。我们采用了从首个MLA输出直连至MoE模块的捷径连接[Cai等人,2024年]。为进一步提升性能,我们通过方差对齐方法对MLA模块和细粒度FFN专家进行了优化。后续小节将详细阐述以上各个组成部分。

图2:LongCat-Flash模型采用的架构。每一层均采用带有零计算专家的快捷连接混合专家系统(ScMoE)。ScMoE显著扩展了计算-通信窗口,从而提升训练与推理效率。零计算专家能够根据上下文重要性进行动态计算,提高了计算资源的利用效率。

2.1 零计算专家

下一词元预测具有内在的计算异质性。困难词元可能需要更多资源以实现准确预测,而简单词元的计算需求可忽略不计。推测解码的实证研究也佐证了这一现象:小型草稿模型能够可靠预测大型模型对多数简单词元的输出结果 [Leviathan et al., 2023]。

受此启发,LongCat-Flash 提出了一种动态计算资源分配机制,该机制通过零计算专家激活每个令牌数量可变的 FFN 专家 [Jin et al., 2024, Zeng et al., 2024],从而能够根据上下文重要性更合理地分配计算量。具体而言,LongCat-Flash 在 N 个标准 FFN 专家的基础上,额外增加了 Z 个零计算专家以扩展其专家池。零计算专家直接将输入 x t x_t xt作为输出返回,因此不引入额外计算成本。设 x t x_t xt为第t个token的MoE输入,LongCat-Flash中的MoE模块可表述如下:

M o E ( x t ) = ∑ i = 1 N + Z g i E i ( x t ) , \mathrm{MoE}(x_t)=\sum_{i=1}^{N+Z}g_iE_i(x_t), MoE(xt)=i=1∑N+ZgiEi(xt),

g i = { R ( x t ) i , i f R ( x t ) i ∈ T o p K ( R ( x t ) i + b i ∣ 1 ≤ i ≤ N + Z , K ) , 0 , otherwise, ( 1 ) g_i=\begin{cases}R(x_t)_i,&\mathrm{if~}R(x_t)_i\in\mathrm{TopK}\left(R(x_t)_i+b_i|1\leq i\leq N+Z,K\right),\\0,&\text{otherwise,}&\end{cases}\quad(1) gi={R(xt)i,0,if R(xt)i∈TopK(R(xt)i+bi∣1≤i≤N+Z,K),otherwise,(1)

E i ( x t ) = { F F N i ( x t ) , i f 1 ≤ i ≤ N , x t , i f N < i ≤ N + Z , E_i(x_t)=\begin{cases}\mathrm{FFN}_i(x_t),&\mathrm{if}1\leq i\leq N,\\x_t,&\mathrm{if}N<i\leq N+Z,&\end{cases} Ei(xt)={FFNi(xt),xt,if1≤i≤N,ifN<i≤N+Z,

其中R表示softmax路由器, b i b_i bi为第i个专家对应的偏置项,K表示每个令牌选用的专家数量。

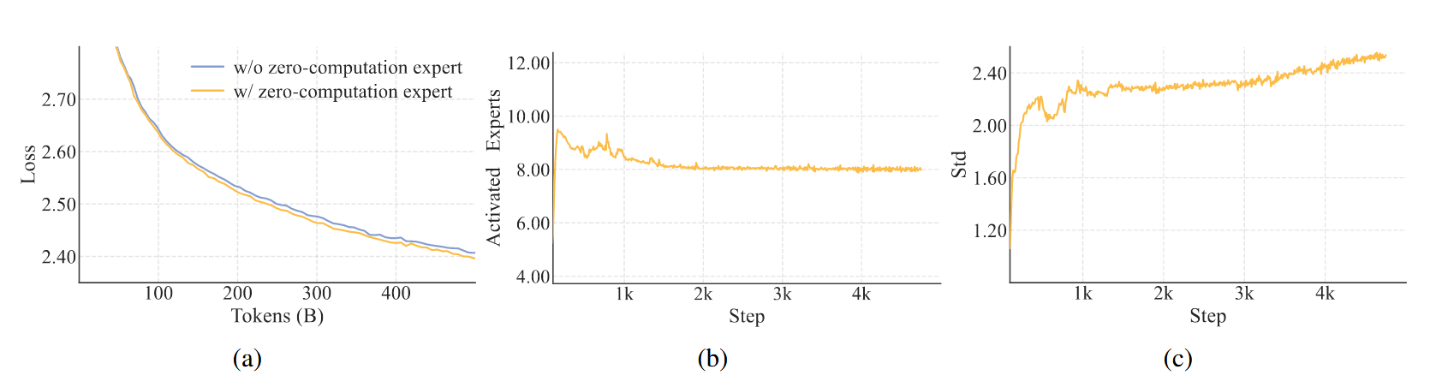

路由器为每个令牌分配K个专家,其中基于上下文重要性,每个令牌激活的前馈神经网络专家数量各不相同。通过这种自适应分配机制,模型学会动态地将更多计算资源分配给具有更高上下文重要性的令牌,从而如图3a所示,在同等计算容量下实现了更优的性能。

图 3:(a) 在匹配计算预算下,比较含/不含零计算专家的模型验证损失曲线。基线模型(top-k=8,蓝色)每令牌固定激活 60 亿参数,而零专家变体(top-k=12,橙色)动态激活 42 亿至 70 亿参数,但保持 8 个前馈网络专家的期望值(波动小于 1%)。损失持续降低证明了零计算专家的有效性。(b) LongCat-Flash 训练期间激活的前馈网络专家平均数量。平均数量稳定在 8 左右,对应预期激活的 270 亿参数。© 激活前馈网络专家的标准差增至 3,表明不同令牌间激活参数存在显著波动。

2.1.1 计算预算控制

为激励模型学习上下文相关的计算分配机制,对零计算专家的平均选择率进行精细化控制至关重要。若无显式约束,模型倾向于低效利用零计算专家,从而导致计算资源利用率低下。

我们通过改进无辅助损失策略中的专家偏置机制[Wang et al., 2024a]来实现这一点:引入一个专家特定偏置项,该偏置项能根据专家近期利用率动态调整路由分数,同时保持与语言模型训练目标解耦。对于对应第i位专家的偏置项 b i b_i bi,其每一步的更新增量计算方式如下:

Δ b i = { μ ( K e K ⋅ 1 N − T i K T a l l ) , i f 1 ≤ i ≤ N , 0 , i f N < i ≤ N + Z , ( 2 ) \Delta b_i=\begin{cases}\mu\left(\frac{K_e}{K}\cdot\frac{1}{N}-\frac{T_i}{KT_{\mathrm{all}}}\right),&\mathrm{if}1\leq i\leq N,\\0,&\mathrm{if}N<i\leq N+Z,&\end{cases}\quad(2) Δbi={μ(KKe⋅N1−KTallTi),0,if1≤i≤N,ifN<i≤N+Z,(2)

其中μ表示偏置适应率, T a l l T_{all} Tall表示全局批次中的令牌总数, T i T_i Ti表示路由至第i位专家的令牌数量, K e K_e Ke表示激活前馈网络专家的期望数量,该值小于K。

所提出的更新规则采用了控制理论中的PID控制器(比例-积分-微分)[Bennett, 1993],确保第i位专家的令牌分配收敛至其目标比例。与固定的偏置相比增量[Wang等人,2024a]机制提升了softmax路由器的概率分布在专家数量扩展时的鲁棒性。值得注意的是,我们将零计算专家排除在偏置更新之外,因其恒等性质仅需满足全局约束,而该约束在所有前馈网络专家达到其预期token比例时将自动满足。实证表明,大批次大小及对μ采用衰减调度能提升预算控制的稳定性,而小批次大小可能需要降低更新频率。

在预训练期间,我们记录了激活专家的平均数量与标准差(图3b与3c)。结果表明,经过约200亿词元的调整后,所有层中的平均专家数量均收敛至预期值,波动幅度小于1%。然而,标准差始终维持在较高水平,这表明模型在不同词元间分配的计算资源存在显著差异。

有关动态路由的详细统计数据和案例研究,请参阅附录A.1。

2.1.2 负载均衡控制

高效的MoE训练需要FFN专家之间实现稳健的负载均衡。虽然等式(2)在语料库级别强制实现了均衡,但我们进一步引入了设备级负载均衡损失[DeepSeek-AI et al., 2025],以防止EP组之间出现极端的序列级不均衡。我们做出了必要努力以兼容零计算专家。具体来说,假设所有N个FFN专家被划分为D组,每组包含G = N / D个专家,则该损失可表达为:

L L B = α ∑ j = 1 D + 1 f j P j , \mathcal{L}_{\mathrm{LB}}=\alpha\sum_{j=1}^{D+1}f_jP_j, LLB=αj=1∑D+1fjPj,

P j = 1 T ∑ i ∈ Group j ∑ t = 1 T R ( x t ) i , ( 4 ) \begin{aligned}P_j&=\frac{1}{T}\sum_{i\in\operatorname{Group}_j}\sum_{t=1}^TR(x_t)_i,\\&&(4)\end{aligned} Pj=T1i∈Groupj∑t=1∑TR(xt)i,(4)

f j = { D K e T ∑ t = 1 T I ( t o k e n t selects Group j ) , i f 1 ≤ j ≤ D , 1 ( K − K e ) T ∑ t = 1 T I ( t o k e n t selects zero-computation experts ) , i f j = D + 1 , ( 5 ) \begin{aligned}f_j=\begin{cases}\frac{D}{K_eT}\sum_{t=1}^T\mathbb{I}(\mathrm{token~}t\text{ selects Group}_j),&\mathrm{if~}1\leq j\leq D,\\\frac{1}{(K-K_e)T}\sum_{t=1}^T\mathbb{I}(\mathrm{token~}t\text{ selects zero-computation experts}),&\mathrm{if~}j=D+1,&&\end{cases}&\mathrm{(5)}\end{aligned} fj={KeTD∑t=1TI(token t selects Groupj),(K−Ke)T1∑t=1TI(token t selects zero-computation experts),if 1≤j≤D,if j=D+1,(5)

其中α为平衡因子,T表示微批次中的令牌数量,I为指示函数。在损失函数中,我们将所有零计算专家分配至一个额外组别,并对各组频率取平均值。通过调整fj的系数,我们确保当损失收敛时,前馈网络专家与零计算专家的比例趋近于 K e / ( K − K e ) K_e/(K−K_e) Ke/(K−Ke)。

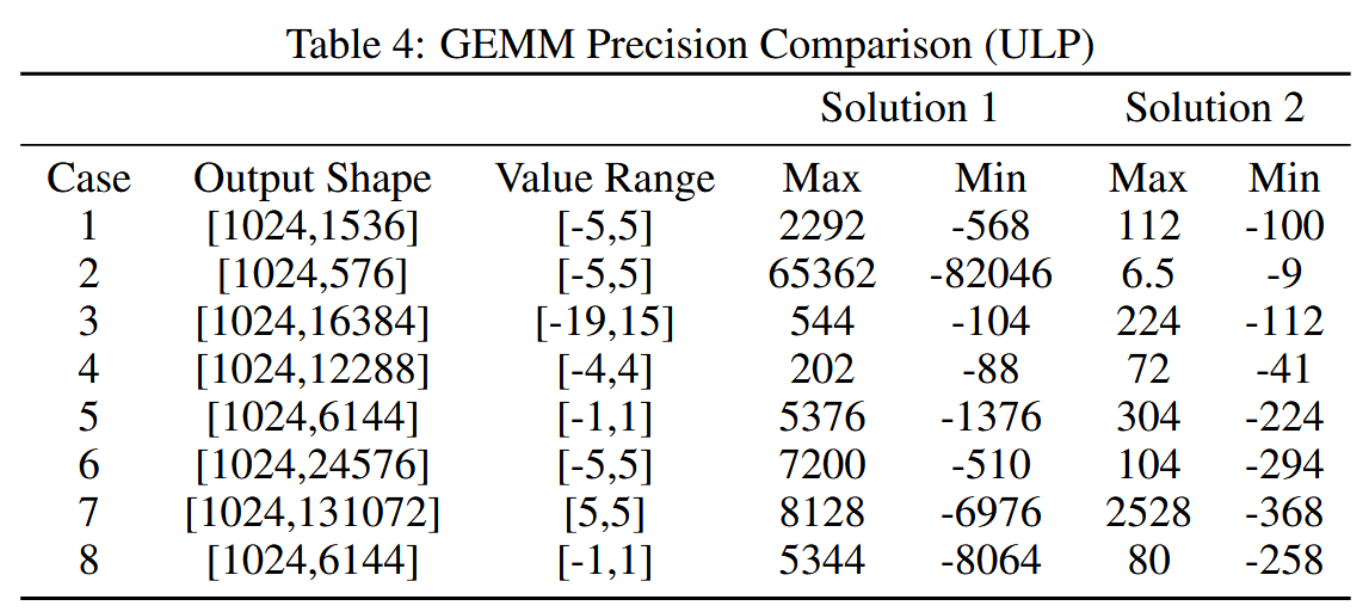

2.2 快捷连接专家混合层

我们最初的架构采用了MoE与稠密前馈网络块交错排列的拓扑结构。该设计已通过大量实证研究得到充分验证,其性能表现与主流的共享专家模型相当[Rajbhandari et al., 2022, Liu et al., 2024a]。然而,大规模MoE模型的效率在很大程度上受限于通信开销。在传统的执行范式下,专家并行机制强加了一种顺序化的工作流程:必须首先通过集合操作将词元路由至指定专家,才能开始计算。这种通信延迟成为系统瓶颈,导致设备利用率不足,并制约了整体系统吞吐量。

共享专家架构试图通过将通信与单个专家的计算重叠来缓解这一问题,但其效率受限于该专家有限的计算窗口。我们通过采用快捷连接混合专家架构(ScMoE)[Cai et al., 2024] 克服了这一限制。ScMoE引入了一种跨层快捷连接,重新调整了执行流水线。这一关键创新使得前一个块中的稠密前馈网络能够与当前MoE层的调度/组合通信并行执行,从而创建出比共享专家设计更显著的重叠窗口。此外,以下关键发现验证了该架构设计选择的合理性。

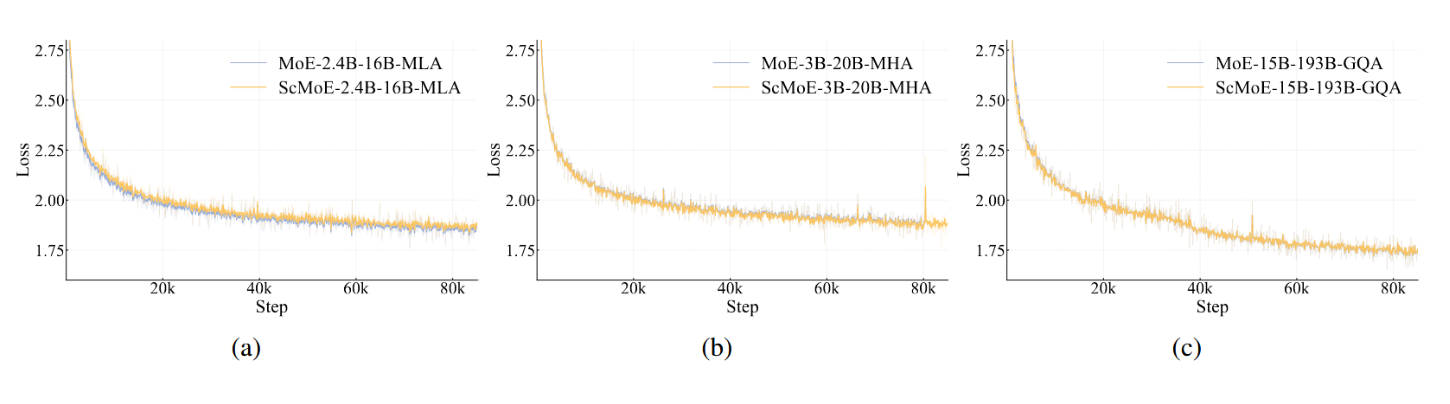

首先,ScMoE结构不会损害模型质量。如图4所示,我们的架构与未使用ScMoE的基线的训练损失曲线几乎完全一致,这证实了这种重排序的执行方式不会削弱模型性能。在多种配置中均观察到一致的结果,包括采用MLA的2.4B-16B MoE模型、采用MHA的3B-20B模型[Vaswani等人,2017],以及采用GQA的15B-193B模型[Ainslie等人,2023]。重要的是,这些发现表明ScMoE的稳定性和优势与注意力机制的选择是正交的。

图4:训练损失曲线对比基线模型(无ScMoE)与其ScMoE增强版本在四种不同模型配置下的表现。在所有实验中——(a) 采用MLA的2.4B-16B模型,(b) 采用MHA的3B-20B模型,以及© 采用GQA的15B-193B模型——损失曲线几乎完全重合。这提供了有力证据,表明ScMoE优化是质量中性的,其收益与模型规模及所使用的具体注意力架构均正交。

其次,ScMoE架构在训练和推理两个层面均能实现显著的系统级效率提升。

对于大规模训练:扩展的重叠窗口使得前一个块的计算能够与其在MoE层中的调度和组合通信阶段完全并行,这是通过沿令牌维度将操作分割为细粒度分块实现的。

针对高效推理:ScMoE支持单批次重叠流水线,相较于DeepSeek-V3等领先模型,将理论单输出词元耗时降低近50%。此外,该系统允许并行执行不同的通信模式:通过NVLink进行的节点内张量并行通信(在稠密前馈网络上执行)可与通过RDMA进行的节点间专家并行通信完全重叠,从而实现整体网络利用率的最大化。

总而言之,ScMoE在保持模型质量的同时实现了显著的性能提升。这些效率增益并非通过权衡取舍获得,而是经过严格验证、质量中立的架构创新所带来的直接成果。

2.3 面向可扩展性的方差对齐设计

在小尺度上表现优异的架构设计,随着模型规模扩大会逐渐失效;反之亦然,这使得初始设计选择失去参考价值。通过大量实验和理论分析,我们识别出特定模块中的方差失配是导致该差异的关键因素,这种失配会在模型扩展过程中引发不稳定性和性能下降。为应对这一挑战,我们针对MLA和MoE模块分别提出了方差对齐技术。

2.3.1 MLA尺度校正

LongCat-Flash采用了一种改进的多头潜在注意力(MLA)机制[Liu et al., 2024a],该机制引入了尺度校正因子 α q α_q αq和 α k v α_{kv} αkv,以解决非对称低秩分解中固有的方差失衡问题。我们整合了这些校正因子的完整数学公式如下:

c t Q = α q W D Q h t ∈ R d q , c t K V = α k v W D K V h t ∈ R d k v , c_t^Q=\boxed{\alpha_q}W^{DQ}h_t\in\mathbb{R}^{d_q},\quad c_t^{KV}=\boxed{\alpha_{kv}}W^{DKV}h_t\in\mathbb{R}^{d_{kv}}, ctQ=αqWDQht∈Rdq,ctKV=αkvWDKVht∈Rdkv,

q t , 1 : n h C = W U Q c t Q , q_{t,1:n_h}^C=W^{UQ}c_t^Q, qt,1:nhC=WUQctQ,

k t , 1 : n h C = W U K c t K V , k_{t,1:n_h}^C=W^{UK}c_t^{KV}, kt,1:nhC=WUKctKV,

v t , 1 : n h = W U V c t K V , v_{t,1:n_{\boldsymbol{h}}}=W^{UV}c_t^{KV}, vt,1:nh=WUVctKV,

q t , 1 : n h R = R o P E ( W Q R c t Q ) , q_{t,1:n_h}^R=\mathrm{RoPE}(W^{QR}c_t^Q),\quad qt,1:nhR=RoPE(WQRctQ),

k t , i = [ k t , i C ; k t R ] , k_{t,i}=\begin{bmatrix}k_{t,i}^C;k_t^R\end{bmatrix}, kt,i=[kt,iC;ktR],

o t , i = A t t e n t i o n ( q t , i , k 1 : t , i , v 1 : t , i ) , o_{t,i}=\mathrm{Attention}(q_{t,i},k_{1:t,i},v_{1:t,i}), ot,i=Attention(qt,i,k1:t,i,v1:t,i),

u t = W O [ o t , 1 ; o t , 2 ; … ; o t , n h ] , u_t=W^O\left[o_{t,1};o_{t,2};\ldots;o_{t,n_h}\right], ut=WO[ot,1;ot,2;…;ot,nh],

其中 h t ∈ R m o d e l d h_t ∈ R^d_{model} ht∈Rmodeld表示第t个词元的注意力输入, n h n_h nh为注意力头的数量。

α q α_q αq与 α k v α_{kv} αkv的引入旨在解决查询向量与键向量各分量间存在的基础方差失配问题。初始化时,各分量的方差与其源维度成正比: σ 2 ( q t C ) σ^2(q_t^C) σ2(qtC)、 σ 2 ( q t R ) ∝ d q σ^2(q_t^R) ∝ d_q σ2(qtR)∝dq,而 σ 2 ( k t C ) ∝ d k v σ²(k_t^C) ∝ d_{kv} σ2(ktC)∝dkv。相比之下,旋转键分量ktR的方差与完整模型维度成正比: σ 2 ( k t R ) ∝ d m o d e l σ^2(k_t^R) ∝ d_{model} σ2(ktR)∝dmodel。当 d q d_q dq、 d k v d_{kv} dkv和 d m o d e l d_{model} dmodel取值不同时,这种维度差异会导致初始化阶段注意力得分不稳定,进而在模型缩放过程中引发性能下降与不可预测的结果。

我们的解决方案是重新调整低秩路径组件的比例,使其最终方差与参考尺度对齐,并以完整模型维度作为参考标准。这是通过将缩放因子定义为以下形式实现的:

α q = d m o d e l d q a n d α k v = d m o d e l d k v . \alpha_q=\sqrt{\frac{d_{\mathrm{model}}}{d_q}}\quad\mathrm{and}\quad\alpha_{kv}=\sqrt{\frac{d_{\mathrm{model}}}{d_{kv}}}. αq=dqdmodelandαkv=dkvdmodel.

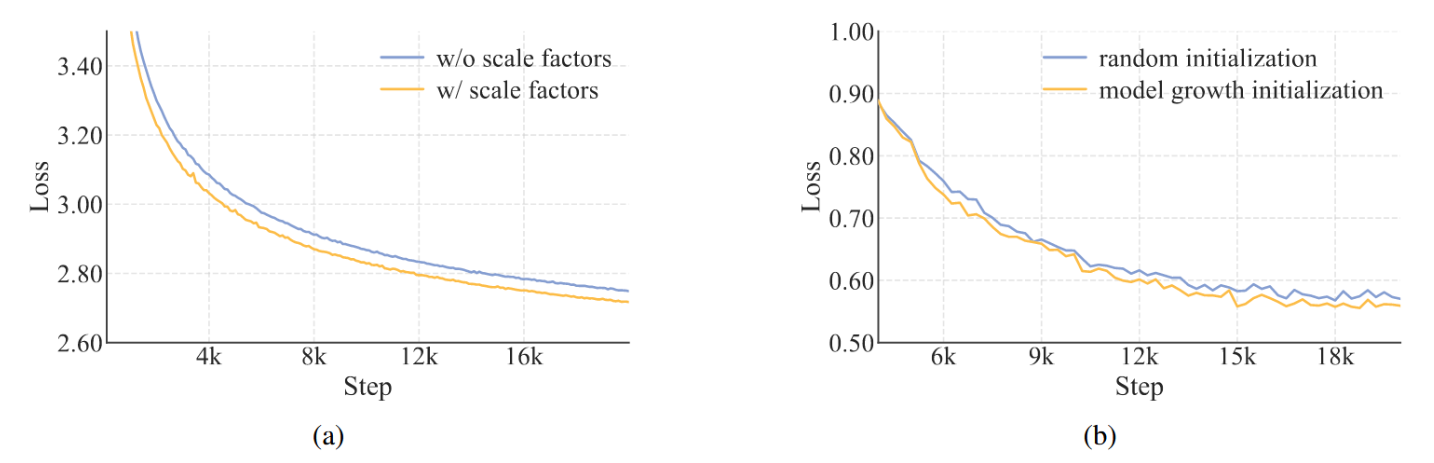

该尺度不变校正消除了方差失配,确保其满足注意力计算的良好条件。我们的实验表明,如图5a所示,此方法提升了模型性能。

图5:(a) 在MLA中引入尺度校正因子,显示出10亿激活参数的MOE模型收敛性改善(损失降低)。(b) 模型增长实验中,60亿激活参数MoE模型的验证损失曲线。

2.3.2 专家初始化方差补偿

LongCat-Flash采用DeepSeek-MoE [Liu et al., 2024a]中的细粒度专家策略,将每个专家分割为m个更细粒度的子专家,以提升组合灵活性与知识专业化程度。然而,我们发现该设计的性能对其他架构选择(如专家数量、top-k值、m值)较为敏感。为应对此问题,我们提出一种方差补偿机制,用以抵消专家分割导致的初始化方差下降。该机制通过一个缩放因子γ作用于专家聚合输出,其公式如下:

M o E ( x t ) = γ ( ∑ i = 1 m N g i ⋅ E i ( x t ) ) , ( 8 ) \mathrm{MoE}(x_t)=\gamma\left(\sum_{i=1}^{mN}g_i\cdot E_i(x_t)\right),\quad(8) MoE(xt)=γ(i=1∑mNgi⋅Ei(xt)),(8)

其中 g i g_i gi 为路由器在 mN 个细粒度专家上的输出,N 表示分割前专家的总数。

等式(8)中的缩放因子γ是通过量化两个主要的方差缩减来源推导得出的。

- 门控稀释:将每个原始N个专家分解为m个更细粒度的专家,使专家总数扩展至mN。这种扩展迫使softmax门将其概率质量分布到更大的专家池上,从而按比例减少了个别门控值 g i g_i gi的幅度。因此,输出方差大约减少了m倍。

- 维度缩减:每个细粒度专家的中间隐藏维度被降低了m倍。在均匀参数初始化的假设下,单个专家的输出方差也降低了m倍。

为在初始化时保持MoE层输出方差不变(与分割前基线匹配),γ必须同时补偿两种效应。因此,综合方差补偿因子为 γ = √m · m = m。

2.4 模型信息

Tokenizer LongCat-Flash采用字节对编码(BPE)[Shibata et al., 1999, Sennrich et al., 2015]进行分词。我们的分词器在涵盖网页、书籍、源代码等的综合多语言语料库上训练而成,确保了强大的跨领域性能。在继承GPT-4预分词框架的同时,我们引入了以下改进:(1)增强CJK字符分割以优化中文文本处理,以及(2)独立的数字分词以提升数学能力。词汇表大小优化为131,072个词元,在计算效率与语言覆盖范围之间实现了有效平衡。

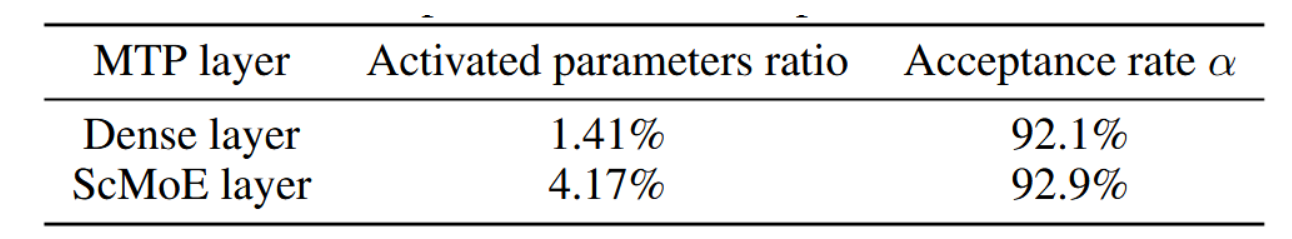

多词元预测

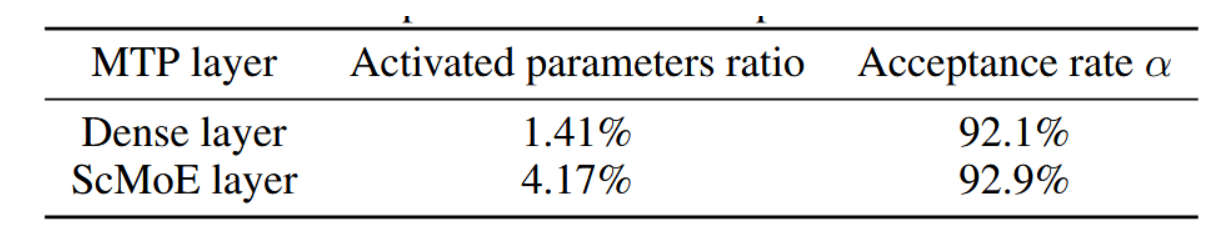

为提升推理效率,我们引入多词元预测(Multi-Token Prediction, MTP)[Gloeckle et al., 2024; DeepSeek-AI et al., 2025]作为辅助训练目标。为实现最佳推理性能,我们采用单一稠密层而非MoE层作为MTP头部。实证观察表明MTP损失收敛迅速,因此我们策略性地在训练流程中期引入MTP训练,以平衡模型性能与预测准确性。评估中MTP头部接受率超过90%(表5)。

表5:6B激活模型下不同MTP头部结构在MT-Bench上的草稿令牌接受率。同时报告了MTP头部参数与主模型参数的比值。

模型配置

LongCat-Flash 包含 28 层(不含 MTP 层),隐藏状态维度为 6144。每个 MLA 模块使用 64 个注意力头,每个头的维度为 128,以实现性能与效率的平衡权衡。遵循 DeepSeek-V3 [Liu et al., 2024a] 的设置,我们将 KV 压缩维度设为 512,查询压缩维度设为 1536。稠密路径中的 FFN 采用 12288 个中间维度,而每个 FFN 专家使用 2048 维。MLA 模块和 FFN 模块中的缩放因子遵循第 2.3.1 节的方法。每层包含 512 个 FFN 专家和 256 个零计算专家,每个令牌精确激活 12 个专家(从两种类型中选择)。LongCat-Flash 总参数量为 5600 亿,根据上下文不同,每个令牌激活的参数量在 186 亿至 313 亿之间,平均激活参数量约为 270 亿。

3.预训练

LongCat-Flash的预训练遵循三阶段课程设计:(1) 我们使用约20万亿令牌、8192序列长度训练模型,以建立稳健的基座模型。(2) 利用数万亿数据进一步增强推理与编码能力。(3) 通过长上下文语料训练将上下文长度扩展至128k。每个阶段均实施定制化的数据策略,并辅以严格的去污染流程以防止测试集泄露。

为优化扩展性,我们引入超参数迁移与模型增长策略,在模型规模扩大时显著提升性能。针对大规模训练固有的不稳定性挑战,我们识别并实施了多种有效技术以增强训练稳定性。

3.1 训练策略

3.1.1 超参数迁移

LongCat-Flash采用一种基于宽度缩放的超参数迁移策略[Everett et al., 2024]来高效训练大规模模型。该方法包括两个步骤:(1) 在一个较小的代理模型上确定最优超参数;(2) 通过理论驱动的缩放规则,将这些配置迁移至目标模型。

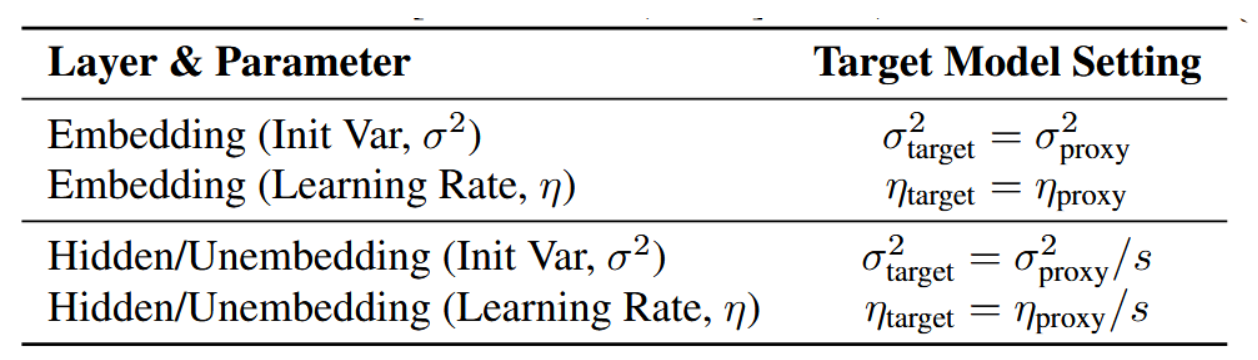

该迁移机制的核心在于宽度缩放因子 s = n t a r g e t / n p r o x y s = n_{target}/n_{proxy} s=ntarget/nproxy,其中n代表模型的隐藏维度。我们特别采用标准参数化下的"Adam LR完全对齐"规则。这些规则明确了如何将代理模型的最优初始化方差(σ²)和学习率(η)适配到目标架构中。实际迁移规则总结于表1。

表1:基于标准参数化亚当学习率完全对齐原理推导出的实用超参数迁移规则及其对应的标度指数[Everett et al., 2024]。此处s为宽度缩放因子 s = n t a r g e t / n p r o x y s = n_{target}/n_{proxy} s=ntarget/nproxy。

按照该方法,我们的训练流程包含以下步骤:

- 基于计算效率与迁移性能之间的权衡分析,我们将宽度缩放因子 s 设定为 8。代理模型配置的宽度为 768。

- 随后,我们在代理模型上进行了全面的超参数搜索,以确定最优的层特定初始化方差( σ p r o x y 2 σ^2_{proxy} σproxy2)和学习率( η p r o x y η_{proxy} ηproxy)。

- 根据表 1 详述的规则,将代理模型的最优超参数迁移至目标模型。在此迁移过程中,所有其他架构属性(深度、稀疏度和批大小)均保持不变。

我们进行了全面的实验以验证该方法的有效性。结果表明,该方法在为大规模模型训练确定最优超参数(初始化方差和学习率)时,能显著降低计算成本,同时为模型缩放建立了一个具有坚实理论基础的鲁棒框架。

3.1.2 模型增长初始化

LongCat-Flash 采用模型增长作为其初始化策略,从预训练于数百亿词符的半规模模型开始。在现有模型增长方法中[Chen et al., 2015; Du et al., 2024; Wang et al., 2023a; Shen et al., 2022; Wang et al., 2023b; Gong et al., 2019],我们采用层堆叠技术[Du et al., 2024; Kim et al., 2023]来扩展参数并提升性能。暂时忽略嵌入与解嵌入过程,整个流程可表述为:

L s m a l l = l 1 ∘ l 2 ∘ ⋯ ∘ l n L t a r g e t = L s m a l l ∘ L s m a l l ∘ ⋯ ∘ L s m a l l ⏟ r \begin{aligned}&L_{\mathrm{small}}=l_1\circ l_2\circ\cdots\circ l_n\\&L_{\mathrm{target}}=\underbrace{L_{\mathrm{small}}\circ L_{\mathrm{small}}\circ\cdots\circ L_{\mathrm{small}}}_r\end{aligned} Lsmall=l1∘l2∘⋯∘lnLtarget=r Lsmall∘Lsmall∘⋯∘Lsmall

其中,li 表示模型中第 i 层的变换,r 表示扩展率, L s m a l l L_{small} Lsmall 表示小模型从词元嵌入到最终隐藏状态的变换,Ltarget 表示通过堆叠 r 个小模型副本所构建的目标(大)模型的变换。在我们的架构中,我们使用 r = 2。

通过大量实验,我们持续观察到通过模型增长初始化的模型表现出特征性的损失轨迹:初始阶段损失上升,随后加速收敛,最终表现超越随机初始化的基线模型。图5b展示了我们在60亿激活参数模型实验中的一个代表性案例,印证了模型增长初始化方法的优势。

我们推测这一改进源于两个协同因素:(1) 较小模型的快速收敛可能为扩展训练提供了更高质量的参数初始化;(2) 增长操作可能作为防止参数坍塌的隐式正则化项。实验证据进一步表明,对前代模型过度优化可能对目标模型的标记效率产生负面影响,这提示我们需要审慎选择增长时机。

在LongCat-Flash初始化过程中,我们首先在初始数据段上使用随机初始化训练一个与目标模型架构完全相同的14层模型。随后,将该训练完成的模型进行堆叠以构建28层检查点,完整保留前驱模型的所有训练状态,包括样本计数器和学习率调度参数。

3.1.3 训练稳定性

我们从三个角度提升LongCat-Flash的训练稳定性:路由器稳定性、激活稳定性与优化器稳定性。

路由器稳定性

训练MoE模型的一个根本性挑战在于路由器稳定性,其根源在于两种相互竞争的梯度之间的张力:

• 语言建模损失,推动专家专业化(将词元分配给最合适的专家),

• 辅助负载均衡损失,强制实现路由均匀性(将词元均匀分配至各专家)。

当LB梯度占主导时,所有专家的路由器参数会趋于相似,导致无论输入标记如何都会产生统一的路由决策。这使条件计算的优势失效,并严重降低模型性能。为诊断和控制此行为,我们提出了一个监测框架,其中包含两个关键指标:

• 路由器权重相似度:测量专家权重向量{wi}间的平均两两余弦相似度。较高的相似度直接表明负载均衡损失占主导地位的程度过高。

• 梯度范数比(Rg):量化两种损失对批次平均专家概率向量 ⃗P 的相对影响:

R g = ∥ α ∇ P ⃗ L L B ∥ 2 ∥ ∇ P ⃗ L L M ∥ 2 , R_g=\frac{\|\alpha\nabla_{\vec{P}}\mathcal{L}_{\mathrm{LB}}\|_2}{\|\nabla_{\vec{P}}\mathcal{L}_{\mathrm{LM}}\|_2}, Rg=∥∇PLLM∥2∥α∇PLLB∥2,

其中, L L B L_{LB} LLB为未使用系数α计算得到的负载均衡损失。

基于此框架指引,我们建立了设定超参数α的实用准则。其核心原则是确保负载均衡项在不过度主导语言模型损失的前提下发挥正则化作用。因此,我们建议选择一个能使Rg保持在较小阈值(例如Rg < 0.1)以下的系数。

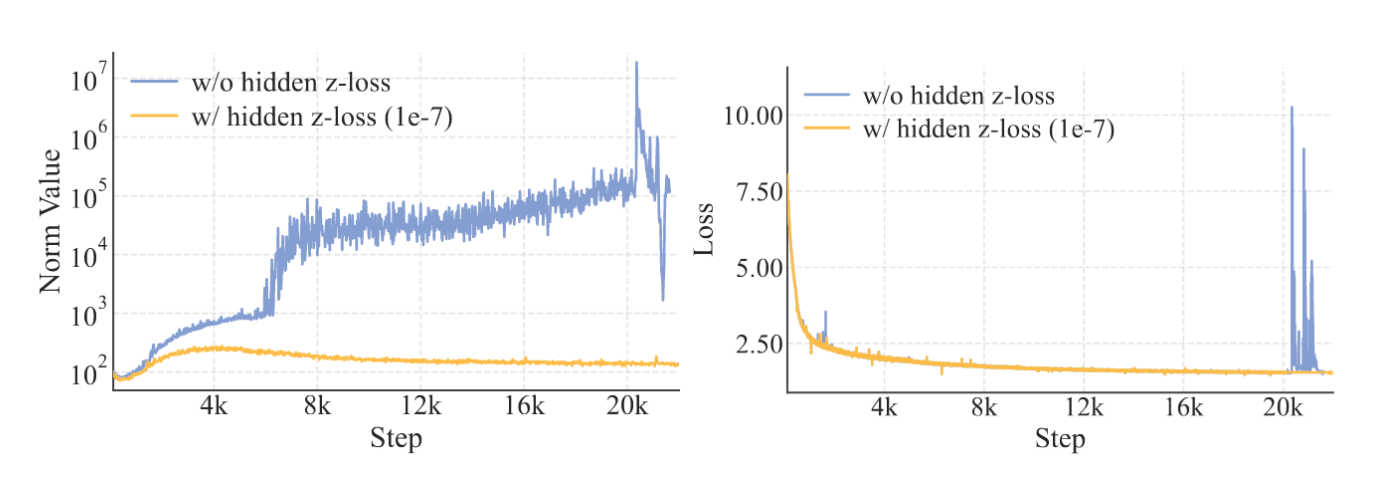

受路由器z损失[Zoph等人,2022]启发,我们设计了隐藏层z损失,以规避大语言模型训练过程中普遍出现的巨量激活现象[Sun等人,2024]。通过实证观察,我们发现此类巨量激活与训练过程中出现的严重损失峰值相关,这些峰值通常伴随着优化不稳定性和潜在的性能下降。隐藏层z损失主要用于抑制幅值极大的激活元素:

L Z = λ T ∑ t = 1 T ( log ∑ i = 1 ∣ z t ∣ exp ( a b s ( z t i ) ) ) 2 , \mathcal{L}_\mathrm{Z}=\frac{\lambda}{T}\sum_{t=1}^T(\log\sum_{i=1}^{|z_t|}\exp(\mathrm{abs}(z_t^i)))^2, LZ=Tλt=1∑T(logi=1∑∣zt∣exp(abs(zti)))2,

其中λ为损失加权系数, z t z_t zt为第t个词元的最终层输出(在最终层归一化前),|zt|表示隐藏状态维度,abs(∗)为绝对值函数。如图6所示,我们发现极小的损失系数即可显著抑制大幅激活现象,且不会影响训练损失,从而降低BF16训练过程中出现数值误差的风险。

图6:超参数欠佳的小型模型最后一层隐藏状态的L2范数与训练损失。引入系数可忽略的隐藏z损失可在不降低训练损失的前提下使范数曲线趋于稳定。

关于Adam优化器中Epsilon参数的实践配置

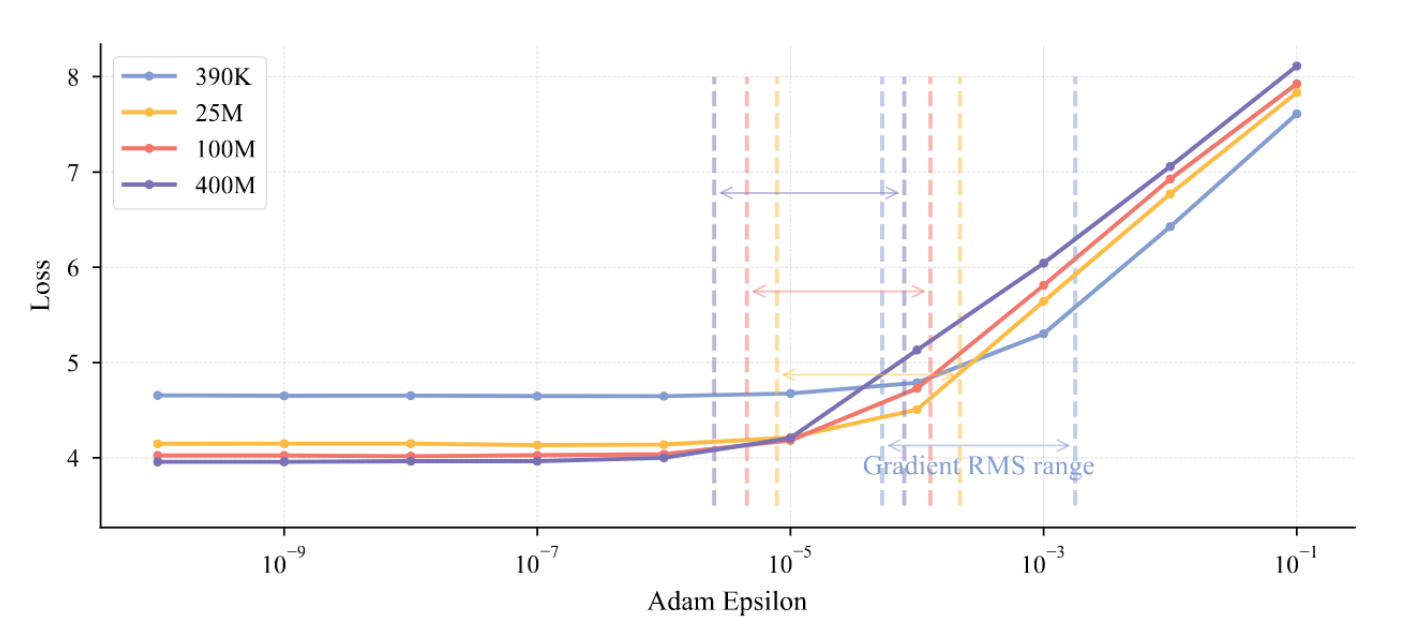

随着模型规模的增长,Adam优化器中的epsilon(ε)参数——传统上被视为保障数值稳定的次要常数——逐渐显现为关键超参数。OLMo等人[2024]的研究表明,将其设置为1e-8相较于默认值1e-5能产生更优结果。这种敏感性的提升主要源于两方面因素:(1) 大规模模型通常采用更小的参数初始化范围;(2) 训练过程中使用了显著更大的批处理规模。当采用默认ε值时,该参数的量级可能与梯度二阶矩的典型尺度相当甚至超出,从而破坏优化器的自适应调节机制。

如图7所示,我们通过追踪梯度均方根范数的实证分析揭示出两个关键发现:(1) 阈值效应:当ε接近观测到的梯度均方根范数时,模型性能会出现显著下降;(2) 下界稳定性:一旦ε降低至该临界阈值以下,继续减小ε对模型性能的影响可忽略不计。因此,我们建议将ε设置为一个较小值(比预期梯度均方根范小数个数量级)。在LongCat-Flash中,我们采用ε=1e-16的配置,该设置能在保持优化器自适应特性的同时确保数值稳定性。

图7:探究梯度均方根范数及epsilon值对不同规模模型损失的影响。“梯度均方根范围”表示模型内不同权重的梯度均方根最大值与最小值之间的区间。随着模型规模增大(参数量从39万至4亿),梯度均方根值逐渐减小。当epsilon值接近梯度均方根范围时,可观察到损失快速恶化。

3.2 通用预训练

我们首先进行通用预训练阶段以确保模型的整体能力。设计多阶段流程以保障数据质量与多样性,主要阶段包括:

内容提取

我们使用定制版的trafilatura [Barbaresi, 2021] 处理通用网页内容,并采用专门流程解析STEM材料,以正确提取公式、代码和表格等复杂元素。

质量过滤

采用两步过滤法。初始分类器清除明显低质量的文档,随后基于流畅度和内容完整性等指标进行更精细的筛选。

去重处理

我们应用高效的MinHash算法进行大规模去重,并辅以识别和处理重复网页模板的策略,以实现更精确的文档级去重。

最终数据混合流程采用两阶段调度方案,逐步增加高质量推理数据(如STEM内容和代码)的比例。

• 第一阶段:针对通用数据,我们采用样本混合 [Xi et al., 2025] 中所述的实例级数据混合策略,以平衡数据质量与多样性。该策略首先依据质量和多样性分数计算初始采样分布,并基于细粒度的领域与写作风格标签进一步调整分布倾向。低价值冗余领域(如广告、体育、招聘)会被降采样,而富含推理内容的领域(如科学)则被升采样。

• 第二阶段:此阶段我们优先考虑推理密集型领域,其中STEM与代码数据占最终混合数据的70%。初步实验表明,通用领域数据的急剧减少会暂时降低模型能力。因此,我们实施代码比例的渐进式提升,并通过在外部验证集上进行持续的困惑度监测来指导调整,以确保平稳过渡,同时不损害通用性能。

3.3 推理与编码增强

为进一步提升模型的推理与编程能力,并构建具备强大后续训练潜力的基础模型,我们通过预训练数据检索与数据合成相结合的方式,利用生成的高质量相关数据开展了中期训练阶段。系统化的合成数据工作流程通过三个关键机制优化数据质量与多样性:(1) 知识图谱遍历与节点组合,确保概念复杂度与领域覆盖度;(2) 多阶段迭代优化,逐步提升问题难度及思维链推理质量;(3) 双模态生成与验证机制,保障数学精确性与解答有效性。我们结合基于规则和基于模型的过滤方法进行严格质量控制,最终数据集规模达数千亿标记。

3.4 长上下文扩展

为实现后续长上下文推理与智能体训练的需求,我们实施了两阶段上下文长度扩展策略。第一阶段使用800亿训练令牌将上下文窗口从8k扩展至32k令牌,并将RoPE的基准频率[Su et al., 2024]从1,000,000提升至5,000,000。第二阶段通过额外200亿训练令牌进一步扩展至128k令牌,同时将基准频率提升至10,000,000。

训练语料基于自然长文本数据构建,包括高质量书籍与小说等。此外,我们开发了系统化方法组织仓库级源代码以增强模型的长上下文处理能力。通过精心筛选高质量代码仓库,并实施多阶段过滤流程去除非文本内容、构建产物及自动生成代码,最终构建出经过精心筛选的200亿令牌数据集,专门用于长上下文预训练。

为确保模型在长度扩展过程中通用能力保持稳定,我们采用了与主预训练阶段完全相同的数据混合策略,并在此混合基础上额外增加了25%的长上下文数据,以增强模型的长上下文处理性能。

3.5 去污处理

我们对所有训练数据执行严格的去污染处理,以防止常见基准测试集的数据泄露。针对网页与代码数据,我们移除了与预设测试集存在任何13-gram重叠的文档。对于合成数据及问答对数据,我们采用基于BGE-m3嵌入模型[Chen et al., 2024]语义相似度的更严格策略:若文档满足以下任一条件即被剔除:(1)与任何测试案例的语义相似度得分 > 0.9;(2)词汇重叠(通过稀疏嵌入测量)且相似度得分介于0.7至0.9之间。

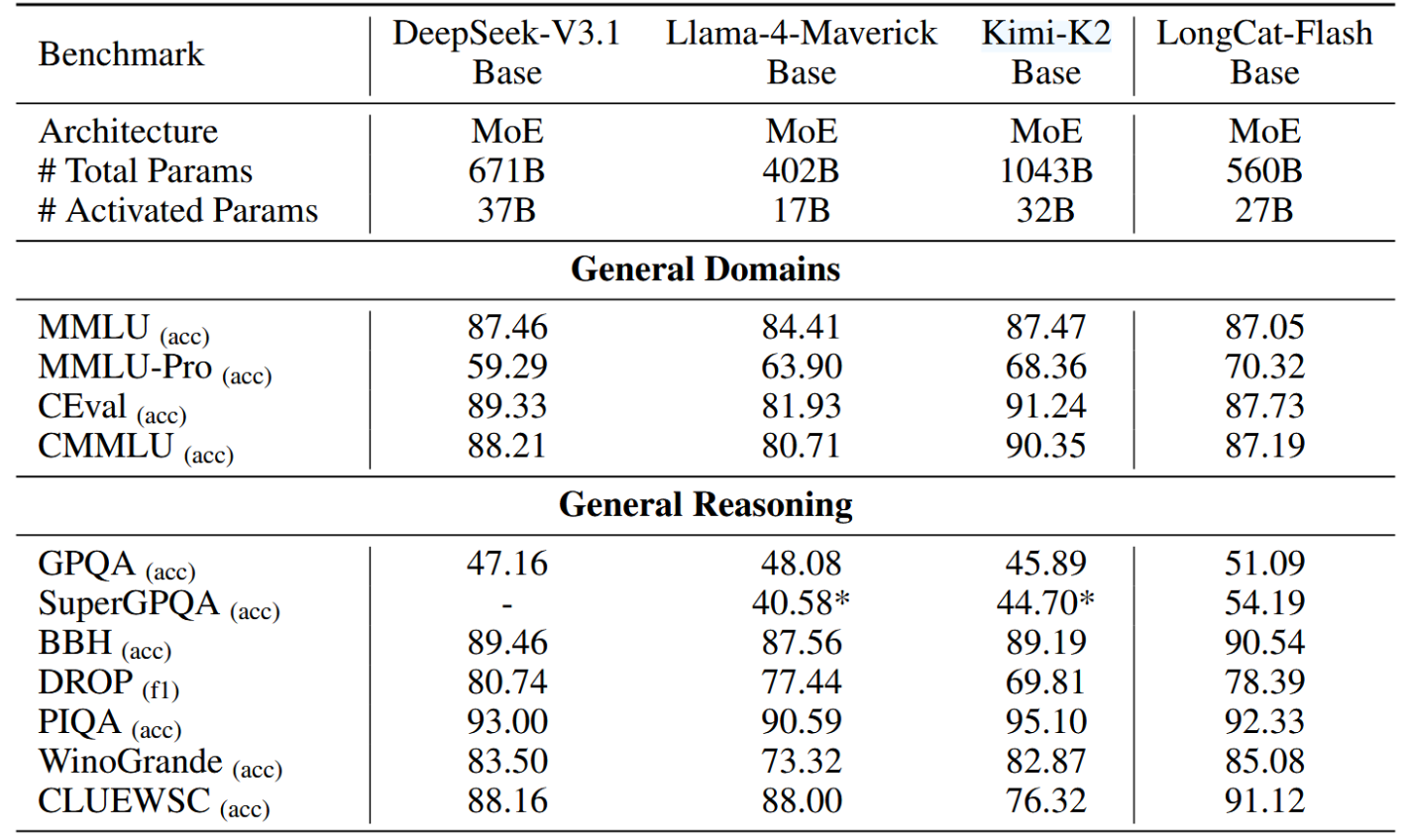

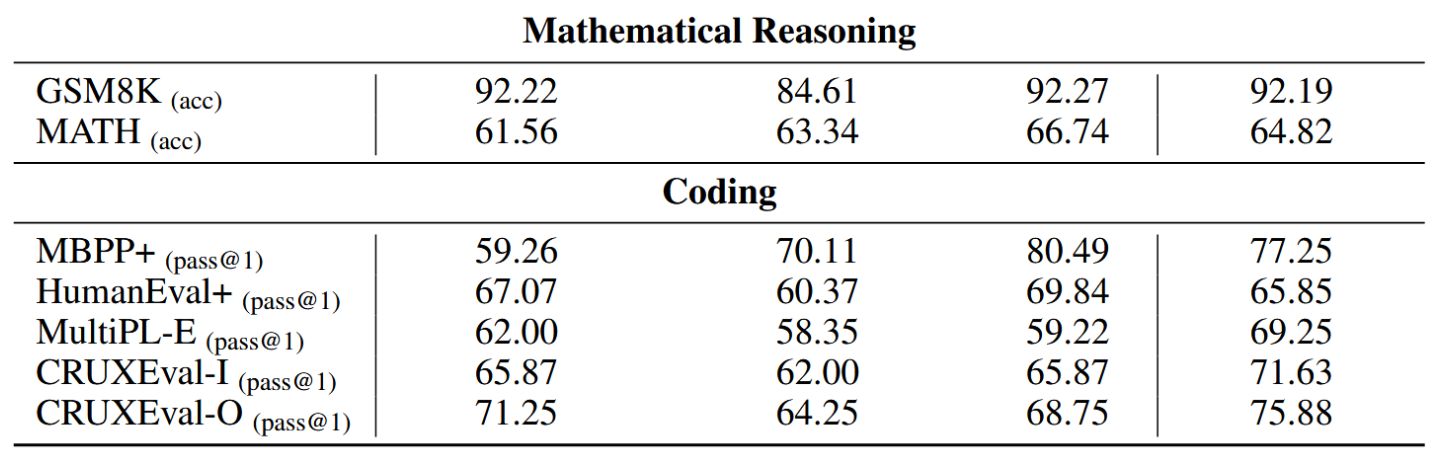

3.6 评估

本节将对LongCat-Flash基础模型进行综合评估,涵盖方法论与结果。

3.6.1 评估基准与配置

模型评估涵盖四大核心能力:通用任务、通用推理、数学推理与代码生成。所使用的评测基准包括:

- 通用任务:MMLU [Hendrycks et al., 2021a]、MMLU-Pro [Wang et al., 2024b]、C-Eval [Huang et al., 2023] 及 CMMLU [Li et al., 2023a]。

- 推理任务:GPQA [Rein et al., 2023]、SuperGPQA [M-A-P Team, ByteDance., 2025]、BBH [Suzgun et al., 2023]、PIQA [Bisk et al., 2019]、DROP [Dua et al., 2019]、CLUEWSC [Xu et al., 2020] 及 WinoGrande [Sakaguchi et al., 2019]。

- 数学任务:GSM8K [Cobbe et al., 2021]、MATH [Hendrycks et al., 2021b]。

- 代码任务:MBPP+ [Liu et al., 2024b]、HumanEval+ [Liu et al., 2024b]、MultiPL-E [Cassano et al., 2022] 及 CRUXEval [Gu et al., 2024]。

我们将LongCat-Flash基础模型与当前最先进的开源基础MoE模型进行比较,其中包括DeepSeekV3.1 Base [深度求索等,2025]、Llama-4-Maverick Base [Meta AI, 2025] 以及 Kimi-K2 Base [月之暗面,2025]。

为确保公平性,所有模型均在相同的流程与配置下进行评估。对于少数无法复现的结果,我们直接采用公开报告中的指标,并在表2中予以明确标注。具体评估设置如下:

• 通用/推理/数学任务:使用少量示例提示引导输出格式,通过准确率或F1分数衡量性能。

• HumanEval+与MBPP+:遵循OpenAI推荐设置[Chen et al., 2021]。

• MultiPL-E:遵循BigCode评估工具链[Ben Allal et al., 2022]。

• CRUXEval:遵循官方配置¹,采用2样本示例进行测试。

表2:LongCat-Flash与其他基础模型对比。标有*的数值来源于公开报告。

3.6.2 评估结果

表2呈现了在不同基准测试中的评估结果。尽管LongCat-Flash Base模型具有紧凑的激活/总参数量,但其性能达到了与顶尖基础模型相当的水平。尽管Llama-4-Maverick的激活参数和总参数更少,但LongCat-Flash Base在几乎所有基准测试中都超越了前两者。

对比分析显示,尽管参数更少,LongCat-Flash Base在所有领域的性能都与DeepSeek-V3.1 Base相当。这两个模型在通用任务上表现相近,但LongCat-Flash Base在MMLU-Pro基准测试(包含极具挑战性的问题)上展现出显著优势。在推理任务中,LongCat-Flash Base取得了更高的平均分。在数学和编码任务上,其在大多数基准测试中均优于DeepSeek-V3.1 Base,仅在CRUXEval和MultiPL-E上观察到微小的性能差距。相较于Kimi K2 Base,LongCat-Flash Base在通用任务上表现略逊,但在推理、数学和编码任务上达到持平或更优水平。

这些结果共同凸显了LongCat-Flash Base模型的参数效率,其在大多数评估基准上均取得了与更大模型相当或更优的性能。

4.后训练

我们采用了一种传统的多阶段后训练框架,以增强基础模型在不同领域的性能,涵盖复杂推理、编码、智能体工具使用任务乃至通用能力。在此过程中,我们观察到,高质量问题集的有限可用性是所有领域面临的一个显著瓶颈。在后续章节中,我们将呈现从后训练方法中得出的关键见解,这些内容被组织为三个不同的阶段:(1) 推理与编码,(2) 智能体工具使用,以及(3) 通用能力。

4.1 推理与编程

数学

为生成高质量且新颖的问题,我们采用角色扮演[Ge et al., 2024]与自指导[Wang et al., 2022]范式。这一过程由一个涵盖从基础到高级主题的综合性数学框架引导。我们利用多样化的数学“专家”角色提出问题,引导大语言模型生成涵盖代表性不足学科的查询。每条查询均设计为引发思维链推理,以促进生成答案中的逐步问题求解。角色构建与答案验证的具体细节如下:

-

角色构建:角色从多来源构建:从高质量预训练数据生成,从现有数学查询推导,并整合来自Persona Hub的相关集合。每个角色均按其STEM学科进行系统标注。为确保最大多样性并与学科框架对齐,我们使用MinHash算法筛选最终的角色集合用于查询生成。

-

答案验证:我们采用两阶段流程确保合成解答的准确性:(1)使用多个不同大语言模型为每道问题生成答案,并选择最一致的解作为最终答案。(2)训练一个生成式奖励模型——特别通过推理数据增强——以自动评分并验证解题步骤的逻辑严密性。

编程

我们从多种来源整合了一套多元化的编码查询,包括公共数据集、基于GitHub代码片段生成的查询[Wei et al., 2024]以及编程相关论坛的查询,同时采用了代码演化指令方法[Luo et al., 2024]对查询进行演化生成。数据分布依据主题多样性和难度进行了均衡处理。具体而言,我们训练了一个模型用于筛选出表达清晰、逻辑一致、正确无误且具备充分解释细节的查询,并实施了过滤流程以剔除包含乱码内容、重复模式或逻辑错误的回答。针对软件工程任务,我们整理并验证了上万个包含测试用例的Docker镜像。每个镜像均用于验证模型生成的代码是否能解决对应代码仓库中的特定问题。我们开发了一套基于智能体的系统,该系统利用多种工具自主分析代码结构、定位相关文件、修复错误并实现新功能。这一过程产生了数千条成功通过所有测试用例的执行轨迹,从而提升了模型自主解决现实世界软件工程问题的能力。

逻辑推理

我们构建了涵盖演绎推理、假设推理与归纳推理的逻辑推理数据集,其中包含LogicPro [Jiang et al., 2025]、PODA [Wang et al., 2025b]及斑马谜题式逻辑推理等任务。为调控难度,我们首先采用Pass@k指标进行初步平衡,随后过滤掉高级思维模型无法解决的棘手问题。我们还将选择题转换为填空形式以减少随机猜测的影响。回答的评估主要关注四个关键方面:(1)最终答案的正确性;(2)推理过程的完整性与清晰度;(3)避免过度重复;(4)语言使用的一致性。

4.2 智能工具使用

我们将智能体任务定义为通过系统性环境交互实现的复杂问题解决。在此范式中,模型必须迭代分析现有信息,并判断何时需要进行环境交互。具体而言,在智能体工具调用框架中,环境由用户和工具这两类特性各异的实体构成。用户作为自主信息提供实体,不存在上下游依赖关系,但表现出不愿被频繁打扰且不会主动披露信息的特性。因此,模型必须在必要时采用策略性提问技术以获取最精确信息的同时,最大限度减少对用户的查询频次。工具可被高频次广泛调用,但存在复杂的相互依赖关系。基于此视角,若排除领域特定专业知识(如高级编程能力或数学计算),我们将任务难度的提升归因于三个因素:

• 信息处理复杂性

模型需进行复杂推理过程,以整合并转换信息为所需组件。

• 工具集复杂性

通过将工具集依据相互依赖关系建模为有向图,其复杂性可通过图的节点基数与边密度进行量化表征。

• 用户交互复杂性

模型需学会以最低频率进行多轮策略性提问,适应多样化的对话风格、沟通意愿层级及信息披露模式,从而在确保充分获取信息的同时实现高效用户交互。

基于上述洞见,我们构建了一个多智能体数据合成框架,通过系统化处理对智能体训练至关重要的三个复杂性维度来生成高质量挑战性任务:(1)工具集复杂性,(2)信息处理复杂性,以及(3)用户交互复杂性。该框架包含以下专门化智能体:

• 用户画像智能体

除生成包含个人信息与偏好的基础用户画像外,我们进一步对用户对话风格、沟通意愿层级及信息表露模式实施控制,以更精准地模拟真实用户交互场景,同时提升任务复杂度。

• 工具集智能体

为最大化数据多样性并防止对特定场景的过拟合,我们采用类似 Kimi-K2 [Team et al., 2025] 的方法,枚举 40 个不同领域,随后利用模型枚举 1,600 个应用。基于这些应用,我们构建了 80,000 个模拟工具,形成扩展工具图谱。通过随机游走方法,我们从该完整工具图谱中系统化采样具有预定节点数量的子图,从而通过节点数量控制工具图谱复杂度。

• 指令智能体

推理难度通过以下维度量化:约束条件复杂性、推理点数量及推理链长度。该模型需基于工具集智能体提取的工具集,生成完整描述任务的指令。

• 环境智能体

我们基于用户画像智能体与指令智能体生成的内容,增强包括物品细节、位置信息、时间参数及气象条件在内的环境信息。此外,我们为物品与位置引入干扰因素,以进一步提升推理复杂度。

• 评估标准智能体

我们基于各类任务相关信息构建了全面且具体的核查清单。在最终评估阶段,考虑到智能体任务固有的长上下文特性,我们采用滑动窗口方法评估完整轨迹,持续更新核查清单条目的完成状态。

• 验证智能体与去重智能体

我们从多角度核查最终任务质量,并移除过度相似的任务。该流程确保我们获得多样化且高质量的任务集合。

基于这些高质量挑战性任务,我们进一步执行严格的响应筛选,以构建数量适宜的冷启动训练集,同时展现多样化模式并保持较高的探索能力。我们还从中精心筛选出部分生成任务用于后续的后训练流程,确保每项任务都值得进行深度探索。

4.3 通用能力

指令遵循 我们构建了包含单轮与多轮的指令遵循数据集,其约束复杂度与数量层级各异。针对多重约束查询,我们借鉴 Ye 等人 [2025] 的方法,筛选语义质量低或存在约束冲突的查询。对于不同查询类型,我们采用可验证规则、基于模型的验证以及定制化策略,确保响应满足全部约束条件。此外,我们针对高难度任务构建了批判性数据集,以增强模型的批判性思维能力 [Wang 等人, 2025c]。我们观察到某些约束类型天然难以遵循,直接生成有效的查询-答案对并不可靠。为此,我们提出反向提示生成策略:从已确保满足约束的预定义答案中反向生成查询。

为增强模型在复杂冗长语境中识别与分析相关信息的能力,我们构建了三种长序列数据集:阅读理解、基于表格的问答及定制化任务。为促进模型学习长序列中的关键信息,我们在数据构建中聚合主题相关的上下文片段,特别强化了模型的多跳推理、多轮对话及复杂计算能力。为降低模型面对不完整语境时的幻觉现象,我们优化了其拒绝应答机制,从而提升其对知识边界与局限性的认知。

基于Mu等人(2024年)的框架并依据内部内容准则,我们制定了一套内容安全策略,将用户查询分为超过40种不同的安全类别,并对应五种响应类型:遵从、依准则遵从、软性拒绝、依准则软性拒绝或硬性拒绝。明确的评判标准确保每种响应类型均能生成一致且符合安全标准的回复。该系统作为上下文感知的数据合成器分两个阶段运行:(1)查询分类:来自多源(开放域语料库、内部业务风险报告、政府问答及对抗性LLM合成的红队内容)的查询通过自动化标注结合人工验证的方式归类至安全类别。(2)响应映射与优化:已分类的查询被映射到相应响应类型,并生成针对该类型优化的响应内容,这些响应在作为训练目标前均需经过人工评估。

4.4 评估

我们对LongCat-Flash在完成训练后进行了全面且严谨的评估。具体而言,我们从多个维度评估了其能力,包括通用领域、指令遵循、数学推理、一般推理以及编程与智能体任务。

4.4.1 评估基准与配置

本次评估采用以下基准:

- 通用领域:MMLU [Hendrycks等人,2021a]、MMLU-Pro [Wang等人,2024b]、ArenaHard [Li等人,2024a,b]、CEval [Huang等人,2023] 与 CMMLU [Li等人,2023a]。

- 指令遵循:IFEval [Zhou等人,2023]、COLLIE [Yao等人,2024] 与 Meeseeks [Wang等人,2025a]。Meeseeks通过模拟真实人机交互的迭代反馈框架,在多轮对话场景中评估模型的指令遵循能力,使模型能够基于每轮特定错误进行自我纠正,从而更好地反映实际应用模式。

- 数学推理:MATH500 [Lightman等人,2023]、AIME24 [美国数学协会,2024]、AIME25 [美国数学协会,2025] 与 BeyondAIME [字节跳动-Seed,2025]。

- 通用推理:GPQA-diamond [Rein等人,2023]、DROP [Dua等人,2019]、ZebraLogic [Lin等人,2025] 与 GraphWalks [OpenAI,2025a]。

- 代码能力:Humaneval+ [Liu等人,2024b]、MBPP+ [Liu等人,2024b]、LiveCodeBench (2024.08-2025.05) [Jain等人,2025]、SWE-Bench-Verified [Jimenez等人,2024] 与 TerminalBench [Team,2025a]。

- 智能体工具调用:τ²-Bench [Barres等人,2025] 与 AceBench [Chen等人,2025]。

此外,我们基于美团丰富的真实业务场景,构建了高质量专有基准VitaBench,用于系统评估模型解决复杂现实任务的能力。在VitaBench中,为全面评估模型的泛化智能体能力,我们精心设计了跨领域日常场景,明确定义了工具间依赖关系,且不提供大量领域特定策略。我们的基准着重关注三个关键复杂性维度:工具集复杂性(以稠密工具图为特征,平均每任务可用工具数超过30个)、推理复杂性以及用户交互复杂性(设计了具有挑战性的用户角色,被测模型平均每任务交互轮次超过60轮)。完整的基准数据集、详细的构建方法及全面的结果分析将在后续工作中完整公开。

我们也评估了LongCat-Flash的安全性能。具体而言,我们对以下四大风险类别进行了评估:

- 有害内容:暴力、仇恨言论、侮辱、骚扰与霸凌、自残与自杀、成人内容等。

- 违法犯罪:非法活动、未成年人违规、极端恐怖主义与暴力等。

- 虚假信息:错误信息与虚假信息、不安全实践、幻觉内容等。

- 隐私侵犯:隐私泄露、侵权等。

在每个类别中,我们构建了足够数量的私有测试查询,随后进行了全面的人工审核,以确保其分类的准确性和质量的可靠性。

我们将龙猫闪聊版(LongCat-Flash)与多个当代非思维链(non-thinking)聊天模型进行了比较,包括DeepSeek-V3.1 [DeepSeek-AI et al., 2025]、Qwen3-235B-A22B(2507版本)[Yang et al., 2025]、Kimi-K2 [MoonshotAI, 2025]、GPT-4.1 [OpenAI, 2025b]、Claude4-Sonnet [Anthropic, 2025]以及Gemini2.5-Flash [Comanici et al., 2025]。对于闭源模型,我们通过其官方API进行评估。对于同时支持思维链和非思维链模式的模型(Qwen3-235B-A22B、Gemini2.5-Flash和Claude4-Sonnet),我们明确将其配置为非思维链模式,以确保比较的公平性。

针对各类基准测试,我们采用以下专用指标与设置:

• 通用领域基准:我们使用准确率作为评估指标。原始基准通常依赖严格匹配(EM)进行正确性判断,而我们采用评分模型来评估模型响应是否与参考答案相符。由于我们的评分模型能够识别语义正确的答案(即使文本不完全匹配),因此报告数值可能略高于原始文献记载。

• 指令遵循基准:我们基于指令规则设计正则表达式以验证合规性,并额外采用基于规则和基于模型的答案片段提取工具辅助此项评估。

• 数学推理基准测试:我们在MATH500数据集上应用前述评分模型,并对AIME相关基准取10次运行的平均EM分数。

• 通用推理基准测试:我们采用评分模型处理GPQA-diamond数据集,计算DROP数据集的F1分数,对ZebraLogic采用基于规则的匹配方法,并依据官方实现方案在128k上下文长度子集上使用GraphWalk的精确度指标。

• 代码生成基准测试:若模型响应在沙箱环境中通过全部测试用例或达到特定状态则计1分,否则计0分,最终得分为所有问题的平均分。Humaneval+与MBPP+采用OpenAI²提供的脚本评估,其余测试使用官方脚本。特别地,在SWE-Bench-Verified评估中,除DeepSeek V3.1(使用Openhands⁴)外,我们采用R2E-Gym³(Openhands脚手架)并限制100次迭代运行进行评估。Terminal-Bench评估则使用Terminus框架进行直接提示测试。

• 智能体工具使用基准测试:我们采用官方基准框架确保公平性与可复现性。针对AceBench使用直接提示而非函数调用方式;针对我们提出的VitaBench,考虑到智能体任务固有的长上下文特性,采用滑动窗口机制系统化评估整个执行轨迹中的任务完成状态,实现对检查清单各组件完成情况的持续更新。

4.4.2 评估结果

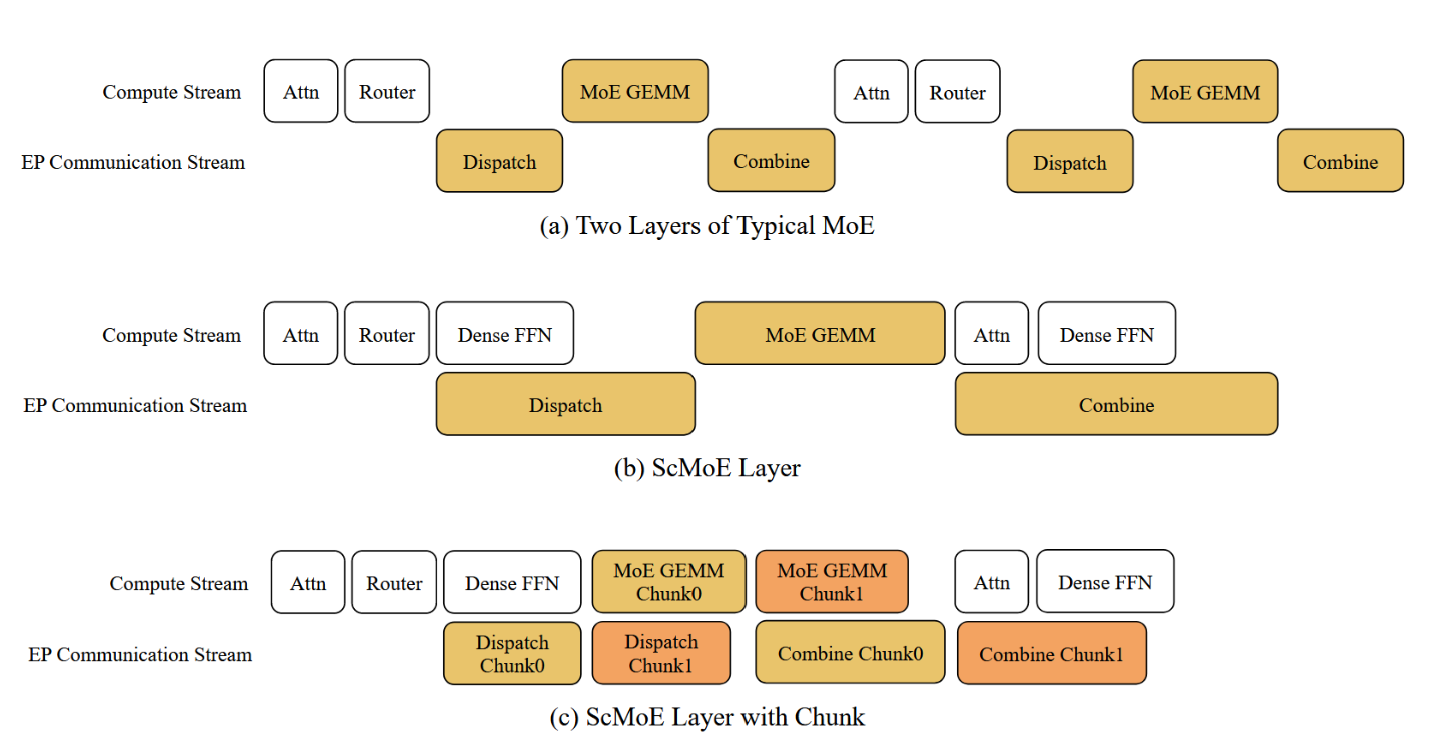

如表3所述,我们的综合评估表明LongCat-Flash是一个强大且多功能的模型。它在不同领域始终展现出领先的性能,在广泛的高难度任务中,经常以相对较少的激活参数超越同期模型。以下分析将从不同维度对其卓越能力进行详细剖析。

表3:前沿对话模型评测结果。标注*的数值源自其他公开报告。请注意,DeepSeek-V3.1、Qwen3-235B-A22B、Gemini2.5-Flash及Claude4-Sonnet均在其非思考模式下进行评测。

通用领域

在通用领域知识方面,LongCat-Flash展现出全面且强劲的性能。它在ArenaHard-V2上取得了86.50的优异分数,在所有评估模型中排名第二,体现了其在极具挑战性的直接对比中的强大能力。在基础基准测试中,它同样保持高度竞争力:MMLU得分89.71,CEval得分90.44。这些成绩与领先模型相当,且值得注意的是,其参数量少于DeepSeek-V3.1和Kimi-K2等竞争对手,显示出较高的效率。

指令遵循

LongCat-Flash具备顶尖的指令遵循能力。它在IFEval上取得了89.65的最高分,超越了所有其他模型,展现出在遵循复杂、细致指令方面卓越的可靠性。此外,它在COLLIE(57.10分)和Meeseeks-zh(43.03分)上也获得了最佳成绩,凸显了其在处理中英文多样化、高难度指令集方面的出色熟练度。

数学推理

在数学推理方面,LongCat-Flash展现出强大且先进的能力。其在MATH500上的得分(96.40)已极具竞争力,而其优势在更复杂、竞赛级别的基准测试中尤为明显。它在AIME25(61.25分)和BeyondAIME(43.00分)上取得了优秀的一流成绩,位列这些高难度领域表现最佳的模型之中。这凸显了其在复杂、多步骤逻辑推导和问题解决方面的高级能力。

通用推理

在通用推理任务上,LongCat-Flash的表现同样扎实。它在结构化逻辑推理方面展现出卓越实力,在ZebraLogic上获得89.30分,位居顶尖竞争者之列。在阅读理解基准测试DROP上也取得了79.06分的竞争力成绩。相对而言,其在GPQA-diamond(73.23分)和GraphWalks(51.05分)上的结果则表明,未来尚有改进空间,特别是在提升其在超长上下文中分析结构化数据的能力方面。

代码生成

LongCat-Flash在代码领域展现出有前景且实力不俗的潜力。其突出表现体现在TerminalBench上,获得了39.51分,排名第二,显示出在实际、具代理性的命令行任务方面的出色熟练度。在SWE-Bench-Verified基准测试中,其60.4分的成绩也具备竞争力。在Humaneval+和MBPP+等基础代码生成任务上,其表现稳健,但仍存在未来优化以对标领先模型的潜力。

代理式工具使用

LongCat-Flash在代理式工具使用领域展现出明显优势,尤其在τ²-Bench上表现优于其他模型,即使与参数量更多的模型相比也是如此。在高度复杂的场景中,它在VitaBench上获得了最高的24.30分,证明了其在复杂场景中的强大处理能力。

安全 LongCat-Flash 模型在整体风险识别与缓解方面,尤其是在有害内容及违法犯罪领域,相较于其他模型展现出卓越的能力。

5.训练基础设施

我们训练基础设施的核心设计原则是在精确度保障下的可扩展性。我们开发了系统性方法来验证算子精度,并将在线静默数据损坏检测嵌入空闲计算阶段,以最小化数值误差。为保证可复现性并确保小规模实验与全规模训练结果一致,我们在所有计算和通信算子中强制执行确定性。这使得任何训练步骤在多次重复运行时都能获得比特级对齐的损失值。

在确保正确性的基础上,我们着力提升训练效率。实际运行时间对算法快速迭代至关重要,但单加速器计算能力有限。为此,我们将训练任务扩展至上万个加速器,同时应对可扩展性与稳定性挑战。通过模型-系统协同设计、多维并行化及全自动故障检测与恢复机制,我们实现了接近线性的扩展效率与98.48%的系统可用性,最终在30天内完成了训练任务。

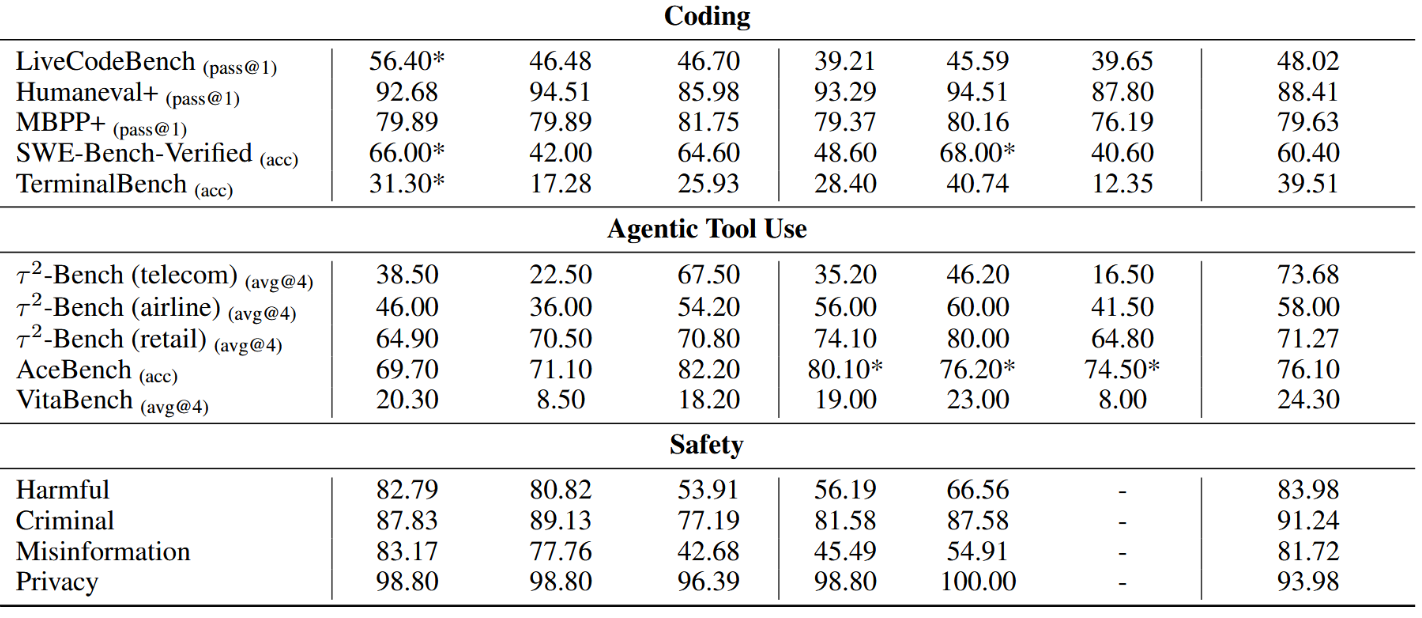

5.1 数值精度控制与故障检测

ULP评估中的浮点误差受多种因素影响,甚至同一厂商不同代际的加速器之间也存在差异。为量化并缓解此类误差,我们采用ULP(末位单位)作为度量标准,其中ULP误差衡量加速器BF16结果与CPU FP32基准真值的偏差。零ULP误差表示完全精确,数值越大则精度越低。我们收集训练中使用的所有算子类型与维度,并比较其ULP误差。表4展示两种解决方案间GEMM运算的ULP误差。

SDC检测机制

SDC故障在大规模训练中通常难以避免,其会在无系统警告的情况下改变数据,严重降低模型性能。为此,我们实现了一种高效的片上原位算子重计算机制。具体而言,我们发现FlashAttention梯度(FAG)的反向计算对SDC最为敏感,因其同时混合了张量与向量运算。重计算结果间的比特差异可指示潜在的SDC风险。检测计算在计算流中进行编排,且重计算间隔支持手动调节,从而实现检测覆盖度与计算成本间的灵活权衡。

值得注意的是,算子精度控制对于确保模型准确性是必要但不充分的。采用不同算子实现的实验可能显示训练损失差异在1e-3∼1e-4范围内,但在基准测试中却表现出超过5个百分点的波动。如何以成本效益的方式评估算子精度误差对模型性能的影响,仍然是一个待解决的挑战。

5.2 面向确定性与性能的内核优化

确定性作为计算正确性的黄金标准,消除了浮点误差作为实验变量的干扰。然而,实现确定性通常伴随着显著的性能开销。我们通过内核重新设计解决了这一问题,在LongCat-Flash的整个训练过程中保持了计算与通信的确定性。

确定性前馈注意力门控(FAG)

默认的FAG实现具有非确定性,因为dQ、dK和dV沿不同维度进行归约,而原子加法操作缺乏顺序保持性。我们开发了一种高效的确定性FAG内核,利用有限的额外工作空间以确定性顺序累积数据块。通过双重缓冲流水线、优化的分块调度以及负载均衡等协同优化,我们的实现性能达到原始确定性版本的1.6倍,并达到非确定性版本的0.95倍,在确定性与效率之间取得了平衡。

确定性ScatterAdd

反向传播中的ScatterAdd操作对梯度聚合至关重要,但存在输入-输出操作数数量不匹配的问题。其默认实现强制在单个计算单元内顺序执行,导致最高可达50倍的性能下降。我们提出一种分层归约算法,该算法通过在所有可用处理器上并行化梯度聚合,实现了与非确定性版本相当的运行效率。

优化分组GEMM

分组GEMM虽计算量大但计算密度低于密集型GEMM,其性能至关重要。我们通过以下方式优化:(1) 采用双缓冲流水线实现计算、内存I/O与后处理的并行重叠;(2) 使用对角分块策略缓解L2缓存冲突;(3) 通过计算单元限制控制HBM带宽,使分组GEMM与通信调度/聚合过程重叠。这些优化使性能较基准版本提升5%–45%。

融合GemmAdd

深度计算在梯度累积阶段面临带宽瓶颈。我们将FP32加法融合至GEMM后处理阶段,避免中间结果写回,并将加法操作隐藏于分块GEMM流水线中。此举显著降低延迟,同时消除BF16数据写入HBM导致的精度损失,在融合GroupedGemmAdd基准测试中实现3.12倍至3.86倍的加速。

此外,我们重实现了IO密集型算子(如MoE层的置换/逆置换),集成令牌丢弃与零计算专家处理等功能,确保确定性与性能并重。

5.3 面向大规模训练的分布式策略

训练架构以专家并行组(EP Group)为核心,每组包含32个加速器。在EP组内部,注意力层采用上下文并行(CP=8)而非张量并行(TP)以降低通信开销,前馈网络层采用EP分区而不使用TP。多个EP组通过流水线并行(PP)和数据并行(DP)维度进行扩展。

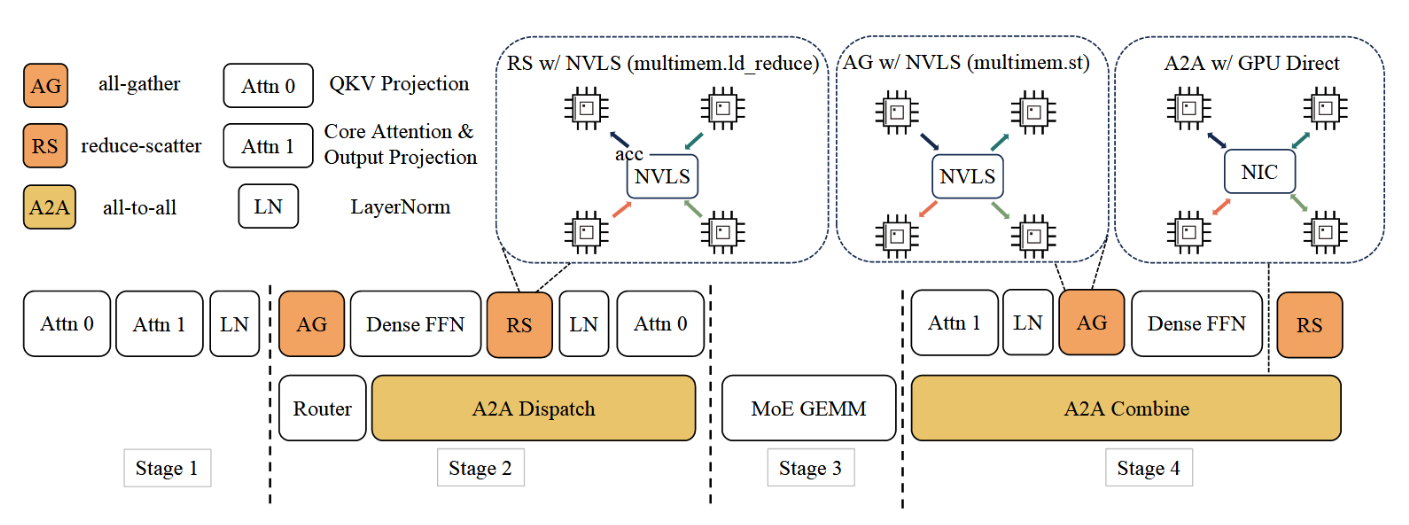

采用专家并行(EP)旨在减少静态内存占用,包括权重和优化器状态。然而,EP本身会引入开销较大的分发(dispatch)与聚合(combine)通信操作。为缓解此问题,LongCat-Flash采用了ScMoE结构,该结构使得单个批次内的分发/聚合通信能够通过更多计算实现重叠。此外,MoE层沿令牌维度被划分为两个分块。这些子分块实现了两个目标:(1)与稠密前馈网络计算重叠;(2)彼此相互重叠(见图8)。

图8:这些架构具有相同的专家总数与激活专家数量。采用分块处理的稀疏混合专家模型实现了最高效率,因为其通过计算重叠了更多通信开销。

针对调度/组合通信有两种优化策略:

(1)在节点内与节点间采用流水线执行的全收集/规约分散内核;

(2)优化的全交换内核。原生全交换会使本地数据量扩大至 top-k 倍,增加经每加速器 200Gb/s RDMA 网络的流量。此外,由于拥塞控制不足,全交换性能不稳定。我们选择具有确定性的流水线式全收集/规约分散作为主要解决方案,在 ScMoE 架构下,非重叠调度/组合通信的时间占比从 25.3% 降至 8.4%。

现有流水线策略(如1F1B、交错式1F1B、Zero-bubble [Qi等人,2023])普遍存在各流水线阶段内存使用不均衡的问题。为此,我们采用V-ZB算法[Qi等人,2024],该算法能实现内存均衡。LongCat-Flash训练中,各阶段内存使用均得到控制,峰值内存降至60GB以下。此外,我们从零气泡出发实现了后验证策略,达成了理论上的零气泡。一项关键改进是在优化器状态回滚时,使用前一步的备份数据替代反演运算,从而确保了数值的比特级对齐。

5.4 可靠性与可观测性

可靠性通过有效训练时间占比(可用性)进行衡量,不可用时间包括故障恢复期及最后一次检查点与故障发生间的无效耗时。异步检查点技术将训练停滞时间压缩至2∼4秒,支持更高频率的检查点保存,从而最小化故障导致的训练损失。结合在线关键日志过滤、优化初始化和全自动化流程,系统将恢复时间缩短至10分钟以内。通过上述机制,系统实现了98.48%的可用性,全部20次故障均通过自动处理完成,无需人工干预。

可观测性整合了细粒度与粗粒度的性能剖析能力以及指标平台。细粒度的PyTorch性能剖析时间线支持分布式、并行感知的协同分析,以识别流水线并行中的“气泡”与跨节点通信等待。粗粒度监控则通过低开销运行时分析发现掉队节点。指标平台持续追踪损失值、权重、梯度及激活值,实现快速模型状态评估。

6.推理与部署

LongCat-Flash采用模型与系统协同设计的方法,这对其实现高吞吐和低延迟起到了关键作用。本节重点介绍我们一个部署集群中实施的推理优化策略,阐述了在H800上同步提升系统吞吐量并将延迟显著降低至100 TPS的方法。我们首先介绍与模型架构协同设计的并行推理架构,随后阐述量化与定制内核等优化方法,最后展示部署策略与性能结果。

6.1 模型专用推理优化

为实现高效的推理系统,必须解决两大关键挑战:(1)计算与通信协同编排;(2)KV缓存I/O与存储。针对第一项挑战,现有方法通常利用三种传统粒度的并行化:算子级重叠(如NanoFlow[Zhu et al., 2025])、专家级重叠(以EPS-MoE[Qian et al., 2025]为代表)以及层级重叠(见于DeepSeek-V3 TBO[Team, 2025b])。LongCat-Flash的ScMoE架构引入了第四维度——模块级重叠——为此我们设计了SBO调度策略以同时优化时延与吞吐量。对于第二项挑战(KV缓存I/O与存储),LongCat-Flash通过注意力机制与MTP结构的架构创新降低有效I/O开销。

6.1.1 计算与通信编排

图9:重叠策略概述。

LongCat-Flash 在其结构上天然具备计算-通信重叠的特性,这是其在保持生成吞吐量的同时实现更低延迟的关键。我们精心设计了单批次重叠(SBO)——一种四阶段的流水线执行方案,它利用模块级重叠来充分释放 LongCat-Flash 的潜力,如图 9 所示。SBO 与 TBO 的不同之处在于,它将通信开销隐藏在单个批次内部。在 SBO 中,阶段 1 需要单独执行,因为 MLA 的输出是后续阶段的输入。在阶段 2,我们将全对全分发操作与稠密前馈网络和注意力 0(QKV 投影)重叠执行。这种重叠至关重要,因为通信开销过大,促使我们对注意力过程进行了拆分。阶段 3 独立执行 MoE 通用矩阵乘法。此阶段的延迟将受益于宽 EP 部署策略。在阶段 4,我们将注意力 1(核心注意力与输出投影)和稠密前馈网络与全对全合并操作相重叠。这种编排有效缓解了通信开销,确保了 LongCat-Flash 的高效推理。

此外,在广泛专家并行部署方案下,ScMoE架构通过GPUDirect RDMA技术[Choquette, 2022],实现了节点内NVLink带宽利用与节点间RDMA通信的重叠,从而提升了整体带宽效率。ScMoE中的稠密前馈网络具有较大的中间层维度,因此采用张量并行部署以最小化内存占用,这需要在稠密前馈网络前后分别进行全收集与规约散射通信。为降低此类通信开销,我们开发了定制化内核,并采用TP2或TP4配置替代TP8。

6.1.2 推测解码

LongCat-Flash采用MTP作为推测解码的草稿模型。我们的优化框架源自对推测解码加速公式的系统性分解,正如Sadhukhan等人[2025]所述:

T A v g S D T T = 1 Ω ( γ , α ) ( γ ⋅ T D T T + T V ( γ ) T T ) , \frac{T_{Avg}^{SD}}{T_T}=\frac{1}{\Omega(\gamma,\alpha)}\left(\frac{\gamma\cdot T_D}{T_T}+\frac{T_V(\gamma)}{T_T}\right), TTTAvgSD=Ω(γ,α)1(TTγ⋅TD+TTTV(γ)),

其中 T A v g S D T^{SD}_{Avg} TAvgSD、 T T T_T TT、 T D T_D TD 分别表示推测解码、目标模型和草案模型对每个令牌的预期延迟。γ代表单次解码步骤中草案令牌的数量。Ω(γ, α)表示在给定步长γ和接受率α条件下的预期接受长度。 T V ( γ ) T_V(γ) TV(γ)表示目标验证的预期延迟。我们的方法主要针对以下三个关键因素:

• 期望接受长度 Ω ( γ , α ) Ω(γ, α) Ω(γ,α) 与草稿令牌的接受率 α 呈正相关。为最大化接受率 α,我们采用 MTP 方法。在后期预训练中集成单一 MTP 头,在测试集上实现了约 90% 的接受率。

• 草稿与目标模型成本比 γ = T D / T T γ = T_D / T_T γ=TD/TT,该比率主要受目标模型和草稿模型的结构影响。如 Liu 等人 [2024c] 所指出的,平衡草稿质量与速度至关重要。为在保持相近接受率的同时最小化生成开销,LongCat-Flash 采用参数精简的轻量级 MTP 架构。我们的实验(表 5)表明,采用单一密集层作为 MTP 头可优化此权衡,在延迟方面优于 ScMoE 层。

• 目标验证与解码成本比 T V ( γ ) / T T T_V(γ) / T_T TV(γ)/TT。为降低此比率,我们采用 C2T [Huo 等人, 2025] 方法,使用分类模型在验证前过滤掉不太可能被接受的令牌。

表5:6B激活模型下不同MTP头部结构在MT-Bench上的草稿令牌接受率。同时报告了MTP头部参数与主模型参数的占比。

6.1.3 KV缓存压缩

为兼顾性能与效率,LongCat-Flash在其注意力机制中采用了具有64个头的MLA设计,此举在降低注意力组件计算负载的同时,实现了卓越的KV缓存压缩,从而减轻了存储与带宽压力。这对于协调LongCat-Flash的流水线至关重要,如图9所示,该模型的注意力计算始终无法与通信过程重叠。具体而言,MLA吸收方法采用的类MQA结构在m维度(64个头)上共享KV,此举与WGMMA指令的形状对齐,以实现硬件利用率的最大化。

6.2 全系统推理技术

6.2.1 最小化调度开销

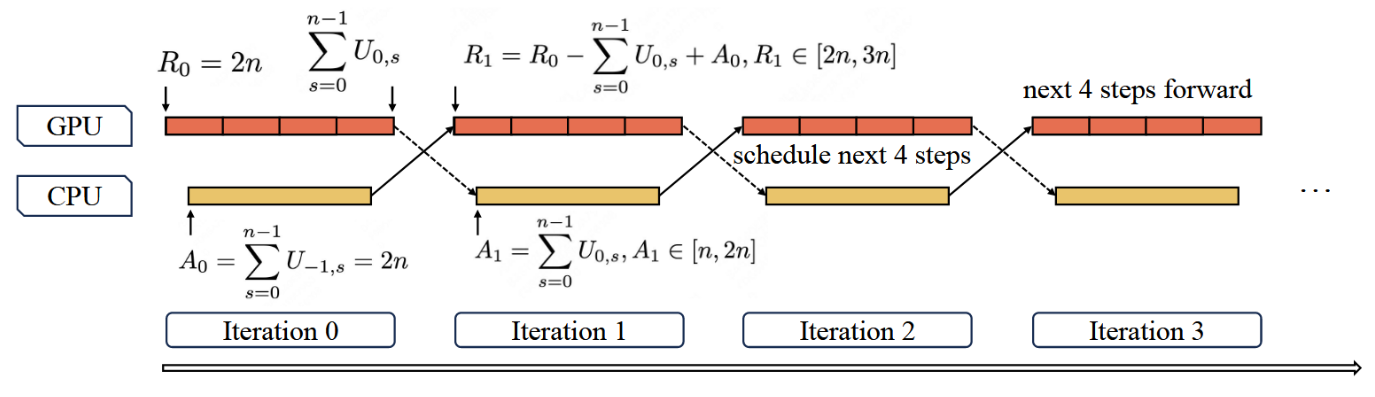

大语言模型推理系统中的解码阶段可能因内核启动开销而受限于启动环节。该问题在引入推测解码后尤为突出——特别是在LongCat-Flash的轻量级多轮令牌预测机制中,验证内核与草稿前向传播的分离调度会引入显著开销。为缓解此问题,我们采用目标前向传播、验证与草稿前向传播三合一融合策略,将其整合至单一CUDA计算图中。为进一步提升GPU利用率,我们实现了重叠调度器。然而实验结果表明,LongCat-Flash前向传播的低延迟特性使得单步预调度策略不足以完全消除调度开销。如图10所示,我们引入了多步重叠调度器,在单次调度迭代中启动多步前向传播的内核。该方法将CPU调度与同步开销有效隐藏于GPU前向计算过程中,从而确保GPU占用率的持续性。

图10:多步骤重叠调度器(此处以4个步骤为例)。

在多步重叠调度器中,我们需要动态预分配多个未来步骤的KV缓存槽位,而无需预先获知先前迭代中推测解码的接受长度。一个关键问题在于多步重叠调度是否会导致KV缓存分配出现分歧。我们以MTP = 1且步数n = 4为例进行说明。令Ri表示GPU第i次迭代前向传播期间可用的KV条目数,因此R0 = (MTP + 1) × n = 2n。 U i , s ∈ [ 1 , 2 ] U_{i,s} ∈ [1, 2] Ui,s∈[1,2]表示第s步在第i次迭代中的接受长度,其初始值 U − 1 , s = 2 U_{−1,s} = 2 U−1,s=2。当GPU执行第i次迭代的前向计算时,调度器会根据第(i − 1)次前向迭代中的接受长度,预分配第(i + 1)次前向迭代所需的KV缓存槽位,其中Ai表示已分配的KV缓存槽位。形式化表述如下:

A i = ∑ s = 0 n − 1 U i − 1 , s , i ≥ 0 A_i=\sum_{s=0}^{n-1}U_{i-1,s},i\geq0 Ai=s=0∑n−1Ui−1,s,i≥0

R i = R i − 1 − ∑ s = 0 n − 1 U i − 1 , s + A i − 1 , i ≥ 1 R_i=R_{i-1}-\sum_{s=0}^{n-1}U_{i-1,s}+A_{i-1},i\geq1 Ri=Ri−1−s=0∑n−1Ui−1,s+Ai−1,i≥1

通过归纳法,我们得到闭式表达式:

R i = 4 n − ∑ s = 0 n − 1 U i − 1 , s , i ≥ 1 R_i=4n-\sum_{s=0}^{n-1}U_{i-1,s},i\geq1 Ri=4n−s=0∑n−1Ui−1,s,i≥1

这意味着

R i ∈ [ 2 n , 3 n ] , i ≥ 1 R_i\in[2n,3n],\mathrm{~}i\geq1 Ri∈[2n,3n], i≥1

通过数学归纳法,这确保了即使不知道当前迭代的接受长度,也能为下一次迭代安全分配KV缓存,同时保证分配的KV缓存大小必然收敛。

6.2.2 自定义内核

大型语言模型推理的自回归特性带来了独特的效率挑战。预填充阶段受计算能力限制,而诸如分块预填充[Agrawal et al., 2023]等方法通过规范化数据以实现最优处理。相比之下,解码阶段常因流量模式导致的小规模、不规则批次而受限于内存带宽,这会损害内核性能。因此,优化这些特定情况对于最小化单输出令牌耗时至关重要。

现有库(如DeepGEMM [Zhao等人, 2025a])将模型权重映射为与k/n维度对齐的右侧矩阵(即A×B=C中的B),而输入激活则成为映射到m/k维度的左侧矩阵,其中m表示令牌数量。这种传统方法在令牌数量低于m的64元素最小值时需要填充。为解决这一效率问题,我们采用SwapAB [Dege等人, 2025]技术:将权重视为左侧矩阵,激活视为右侧矩阵。通过利用n维度灵活的8元素粒度,SwapAB最大限度地提升了张量核心利用率。

通信内核

如图9所示,该推理系统利用NVLink Sharp的硬件加速广播(multimem.st)和交换机内归约(multimem.ld_reduce)功能,以最小化数据移动和SM占用。通过内联PTX汇编,归约-分散和全收集内核实现了高效的数据传输。这些内核支持GPU间均匀与非均匀的令牌分布,在4KB至96MB的消息大小范围内,仅使用4个线程块,其性能始终优于NCCL[NVIDIA]与MSCCL++[Shah等人,2025]。

6.2.3 量化

LongCat-Flash采用与DeepSeek-V3相同的量化方案,使用细粒度分块量化:激活值按[1,128]分块,权重按[128,128]分块。此外,为达成最优的性能-精度平衡,我们基于两种方法实施了分层混合精度量化:第一种方案遵循我们在FPTQ [Li et al., 2023b] 与Super-Expert [Su et al., 2025]中的方法,观察到某些线性层(尤其是Downproj)的输入激活值存在极值,幅度高达10^6。第二种方案通过逐层计算分块FP8量化误差(包括相对误差与绝对误差),发现特定专家层存在显著量化误差。通过综合两种方案的量化敏感层交集,我们实现了显著的精度提升。

6.3 部署与性能

6.3.1 实测性能

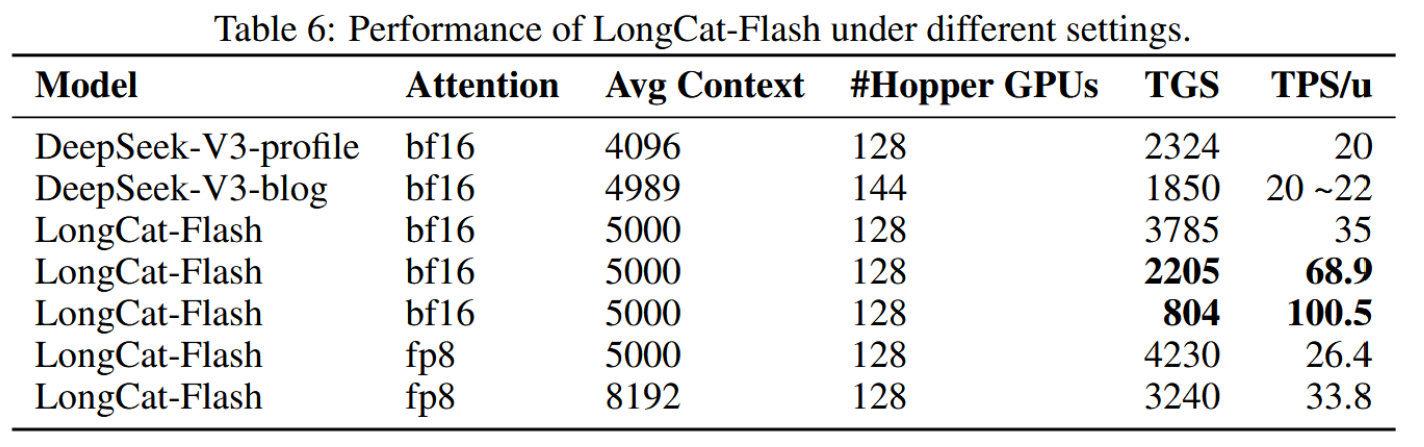

为实现预填充与解码阶段的独立优化,系统采用PD解耦架构。该设计中的关键挑战在于将KV缓存从预填充节点传输至解码节点所产生的开销。为缓解此问题,我们实施分层传输机制,在高QPS工作负载下显著降低了首令牌生成时间。预填充与解码节点的最小部署单元为2个节点,各配备16块H800-80GB GPU。同时采用广域专家并行策略,结合DeepEP[Zhao et al., 2025b]以最小化通信开销。此外,我们改进了DeepEP与专家并行负载均衡器,使其支持零计算专家——此类专家的输出无需通信即可获取。

表6比较了LongCat-Flash与DeepSeek-V3(DeepSeek-V3-profile来自DeepSeek [2025a],DeepSeek-V3-blog来自DeepSeek [2025b])的吞吐量和延迟。其中,TGS(每秒每GPU生成令牌数)代表单设备生成吞吐量(数值越高表明成本越低),TPS/u(每秒每用户令牌数)代表单用户生成速度(数值越高越好)。测试时采用给定序列长度下的稳态生成吞吐量进行计算。LongCat-Flash在不同序列长度下均实现了更高的生成吞吐量和更快的生成速度。

基于ReACT模式[Yao et al., 2023]的智能体应用中,完成单任务需经过多轮模型交互,其交互延迟直接影响用户体验。对典型智能体调用模式的分析表明,模型输出存在差异化的速度需求:

• 推理内容(用户可见):包含认知过程与解释说明,须匹配人类阅读速度(20词元/秒)。

• 操作指令(用户不可见):结构化数据(如函数名与参数),通常为30~100词元,但直接影响工具调用启动时间——需追求最高处理速度。

针对这一场景,LongCat-Flash实现了近100 tokens/s的动作指令生成速度。在H800 GPU每小时2美元的成本假设下,这相当于每百万输出tokens的价格为0.7美元。该性能将单轮工具调用的延迟控制在一秒以内,从而显著提升了Agent应用的交互性。

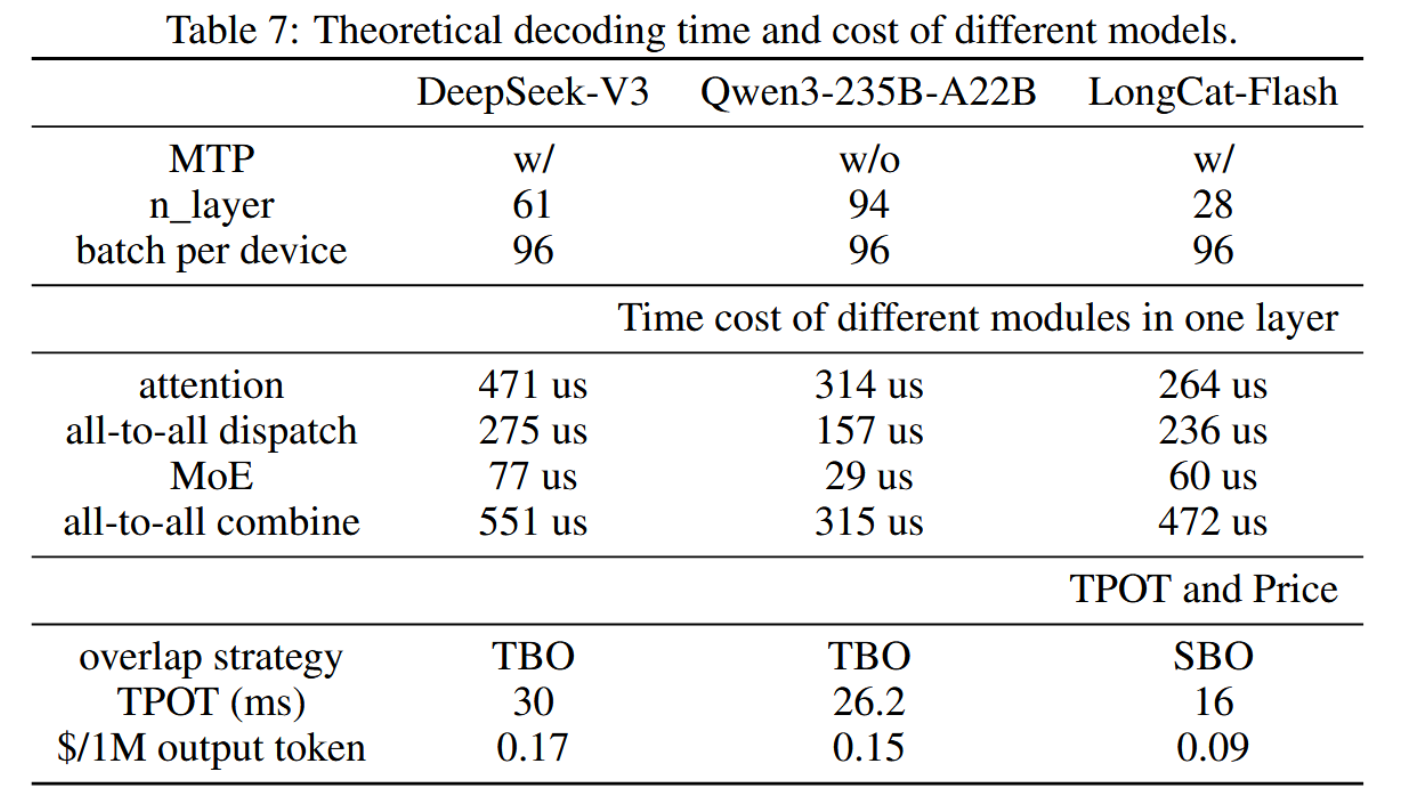

6.3.2 理论性能

图9表明,LongCat-Flash的延迟主要由三个部分决定:

• MLA:其耗时无法通过增加专家并行度来减少。

• 全对全分发/聚合:二者均受单设备批量大小和topk值限制。

• 混合专家层:其在内存受限区域的耗时随专家并行度增加而减少。

图9:重叠策略概述。

假设EP数量为128,MLA对DeepSeek-V3和LongCat-Flash使用DP,GQA对Qwen3235B-A22B使用TP4(因其具有4个kv头),每设备批处理大小为96。实际上,Qwen-235B-A22B的GQA特性导致其KV缓存内存占用较高,实践中难以实现每GPU 96的批处理大小。此处假设其能达到该值仅为理论分析之目的。如[Jiashi Li, 2025]指出,FlashMLA在NVIDIA H800 SXM5 GPU上最高可实现660 TFlops;Zhao等人[2025b]表明DeepEP带宽可达40GB/s。我们的计算中采用了这两项指标。假设每张H800成本为每小时2美元。考虑MTP=1且接受率为80%时,我们可计算出DeepSeek-V3、Qwen3-235B-A22B和LongCat-Flash单层中各模块的理论耗时与成本,如表7所列。对于原生不支持MTP的Qwen3-235B-A22B,我们假设采用具有相当接受率的推测采样策略。

在此配置下,LongCat-Flash结合SBO的理论极限TPOT可表示为:

T P L = 264 + 236 + 60 + 472 = 1032 u s , \mathrm{TPL}=264+236+60+472=1032\mathrm{~}us, TPL=264+236+60+472=1032 us,

T P O T = 28 × T P L 1000 × 1.8 ≈ 16 m s , \mathrm{TPOT}=\frac{28\times\mathrm{TPL}}{1000\times1.8}\approx16\mathrm{~ms}, TPOT=1000×1.828×TPL≈16 ms,

其中TPL表示每层时间成本。实测值在批次大小96下约为TPOT = 26 ms,约为理论值的61.5%,与DeepSeek-V3(约64%)表现相当。实测值与理论速度的差距主要源于小算子的额外开销以及通信带宽损耗。

我们采用相同方法计算了DeepSeek-V3与Qwen3-235B-A22B在TBO调度下的理论TPOT与生成成本上限。从表7可见,通过模型系统协同设计,LongCat-Flash在吞吐与延迟方面均实现了显著的理论性能提升。

进一步地,我们观察到关于LongCat-Flash的两个关键发现:(1)LongCat-Flash不仅显露出全通信与MoE计算,还包含MLA计算。因此,在相同批次大小下,LongCat-Flash的单层处理时间略长于DeepSeek-V3。但由于其总层数大幅减少,系统整体延迟更低。(2)LongCat-Flash的第二阶段MLA计算可与全通信合并操作重叠。这意味着在解码阶段,LongCat-Flash能在不显著增加延迟的前提下,将序列长度提升至一定规模。

7.总结

我们推出LongCat-Flash,这是一个拥有5600亿参数的混合专家模型,具备三项关键创新:(1) 上下文感知的动态计算机制与快捷连接MoE架构,实现了训练与推理的高效率;(2) 集成策略确保大规模训练的稳定性;(3) 多阶段训练流程培育了LongCat-Flash的智能体能力,使其能够执行需要迭代推理与环境交互的复杂任务。通过将LongCat-Flash作为开源模型发布,我们旨在推动高效MoE架构、高质量数据策略以及智能体模型开发的研究,促进大语言模型领域的社区驱动创新。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)