自动驾驶仿真测试场景生成方法:从技术突破到工程落地的全维度解析

自动驾驶仿真测试场景生成技术正经历从人工建模到智能重建的革新。传统方法依赖人工建模或有限路测数据,存在效率低、覆盖窄、真实性差等痛点。3D高斯泼溅(3DGS)技术通过离散化场景建模,在保持高保真度的同时实现实时渲染,成为当前最优解决方案。康谋aiSim3DGS方案构建了"采集-重建-测试"全流程闭环,支持多源数据输入、高精度重建和动态场景编辑,将数字孪生构建时间从数月缩短至1天

在自动驾驶技术迈向 L4 及更高阶别的进程中,仿真测试已成为算法迭代、功能验证与安全合规的核心支撑。其中,测试场景的真实性、多样性与可扩展性直接决定了仿真测试的有效性 —— 传统场景生成方式依赖人工建模与有限真实数据采集,不仅耗时耗力,更难以覆盖极端工况与长尾场景。随着 3D 高斯泼溅(3DGS)、神经辐射场(NeRF)等技术的崛起,自动驾驶仿真场景生成正迎来从 "手动构建" 到 "智能重建" 的革命性转变。本文将系统解析当前主流场景生成方法,深度拆解技术演进逻辑,并介绍康谋 aiSim 3DGS 方案如何实现场景生成的全流程闭环,为自动驾驶研发提供高效、高保真的解决方案。

一、自动驾驶仿真场景生成的核心挑战与技术演进

(一)传统场景生成方法的痛点

早期自动驾驶仿真场景生成主要依赖两种路径:一是工程师手动搭建虚拟场景,通过物理引擎配置道路、交通参与者与环境参数;二是基于真实路测数据进行简单复刻,形成开环测试用例。这两种方式均存在难以逾越的瓶颈:

- 效率极低:复杂场景手动建模需数月时间,且无法快速适配不同测试需求;

- 泛化能力弱:真实路测数据受限于采集范围,难以覆盖暴雨、暴雪、极端视角等特殊工况;

- 领域差距显著:即便采用光追渲染,虚拟场景与真实环境在视觉细节、物理特性上仍存在 "domain gap",导致测试结果可信度不足;

- 可编辑性差:修改传感器配置、交通流密度等参数需重新建模或采集数据,无法支持闭环迭代测试。

(二)技术演进:从物理建模到神经重建的跨越

随着人工智能与计算机视觉技术的发展,场景生成方法逐步转向数据驱动的神经重建模式,核心技术路径经历了三个阶段:

- 传统物理渲染阶段:依赖 UE、Unity 等引擎构建虚拟场景,优势是支持灵活编辑,但真实性依赖人工调校,难以还原真实道路的复杂细节;

- NeRF 神经辐射场阶段:通过神经网络学习空间坐标与图像色彩、密度的映射关系,实现高保真场景重建,但计算成本极高,渲染速度慢且不支持实时编辑;

- 3DGS 高斯泼溅阶段:将场景离散为携带位置、协方差矩阵、不透明度等信息的 3D 高斯点,兼具 NeRF 的高保真特性与实时渲染能力,成为当前最具工程价值的场景生成技术。

二、主流自动驾驶仿真场景生成方法解析

(一)三类核心生成方法对比

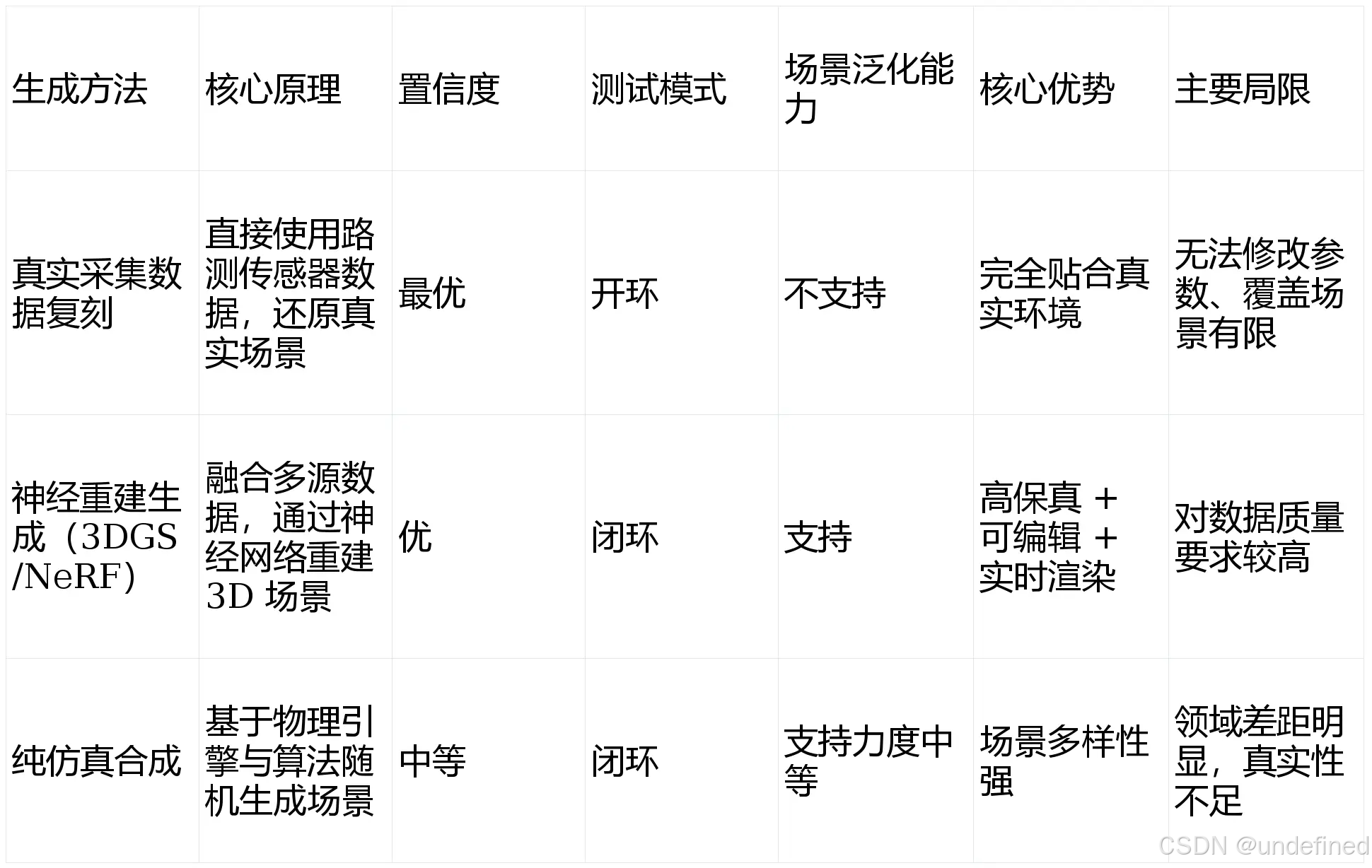

当前行业主流的场景生成方法可分为真实采集数据复刻、神经重建生成、纯仿真合成三类,其技术特性与适用场景各有侧重:

其中,神经重建生成方法凭借 "真实还原 + 灵活编辑" 的双重优势,成为平衡测试可信度与效率的最优解,而 3DGS 技术因其更优的实时性能与工程适配性,逐渐成为该路径的主流选择。

(二)3DGS 神经重建:场景生成的最优技术路径

3DGS 场景生成的核心流程可分为四大环节,实现从原始数据到可用仿真场景的全链路转化:

- 多源数据标准化输入:采集相机图像、激光雷达点云、自车运动数据等多模态信息,通过 aiData 等工具链完成格式统一、时间戳同步与坐标系对齐,解决数据异构问题;

- 场景预处理优化:包括 3D 自动标注(识别车辆、行人等目标并生成 3D 边界框)、2D 语义分割(优化场景细节)、相机位姿校准(确保空间坐标准确性),为重建提供 "干净数据";

- 神经重建模型训练:融合 NeRF 的几何泛化能力与 3DGS 的实时特性,通过 T-S 结构将深度、法线等监督信号迁移至高斯参数优化,结合 LiDAR 深度约束提升建模精度;

- 场景验证与编辑:通过 DEVIANT 算法(校验几何精度)与 Mask2Former 算法(验证像素一致性)双重验证,确保场景与真实环境一致;支持添加交通流、模拟极端天气、配置传感器等灵活编辑。

这一流程既保留了真实场景的高可信度,又具备纯仿真合成的灵活扩展性,完美解决了传统方法的核心痛点。

三、康谋 aiSim 3DGS 方案:重新定义场景生成的工程标准

康谋神经网络渲染自动驾驶仿真方案,将 3DGS 神经重建技术从实验室推向工程落地,构建起 "数据采集 - 场景重建 - 仿真测试" 的全流程闭环。

(一)核心技术突破:四大创新打造高保真场景生成能力

- 全栈自动化工具链:从数据采集到场景输出实现端到端自动化,仅需 1 天即可完成传统方法 3-6 个月的数字孪生构建工作,大幅降低时间成本;

- 混合式渲染引擎:原生集成生产级仿真软件 aiSim,融合神经重建与物理渲染优势,既还原真实场景细节,又支持暴雨、暴风雪、地面积水等多样化环境模拟;

- 多模态传感器兼容:全面覆盖摄像头、激光雷达(LiDAR)、毫米波雷达等主流传感器,支持自定义传感器配置,满足复杂感知系统测试需求;

- 极端视角泛化能力:支持偏离原始采集轨迹最远达 3 米的新视角生成,通过 Difix 技术增强图像质量,解决极端工况下的场景覆盖难题。

(二)场景生成的全流程闭环优势

康谋 aiSim 3DGS 方案通过五大环节实现场景生成与仿真测试的无缝衔接:

- 数据输入兼容:支持 Waymo 开源数据集、第三方采集数据等多种输入形式,通过标准化工具链解决多源数据异构问题;

- 高精度重建:基于 3DGS 技术实现静态场景的高保真重建,剔除动态物体干扰,同时保留道路、建筑等细节的精准还原;

- 动态场景增强:内置 2000+3D 资产库,可灵活添加车辆、行人、交通信号灯等动态元素,支持基于 OpenSCENARIO 1.2 构建标准场景;

- 多维度验证:通过 Waymo 数据集量化验证,在 3D 目标检测任务中 AP 3D 值表现优异,像素分类一致性达 90% 以上,有效消除领域差距;

- 闭环仿真测试:支持 SiL、HiL、DiL 等多种测试模式,即便在偏离原始轨迹的全新路径上,仍能实现自动驾驶系统的稳定闭环测试。

(三)案例实证:从技术优势到业务成效

在实际应用中,康谋 aiSim 3DGS 方案已为欧洲乘用车 OEM、日本 EV OEM 等客户创造显著价值:

- 数字孪生构建时间从 3-6 个月缩短至 1 天,研发效率提升 95% 以上;

- 人工标注成本降低至原预算的 5% 以下,大幅减少人力投入;

- 支持传感器配置快速迭代,无需重复采集数据,测试成本降低 40%;

- 覆盖泊车、高速公路、城市道路、越野等多种 ODDs 场景,满足全场景测试需求。

四、结语

自动驾驶仿真测试场景的生成质量,直接决定了自动驾驶系统的研发效率与安全水平。从传统手动建模到 3DGS 神经重建,场景生成技术的演进本质上是 "真实性" 与 "灵活性" 的平衡过程。康谋 aiSim 3DGS 方案通过技术创新实现了这一平衡,既保留了真实场景的高可信度,又具备灵活编辑与极端工况覆盖能力,为自动驾驶研发提供了高效、可靠的仿真测试基础。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)