大模型微调——三阶段全流程训练分享(小白友好)

一、继续预训练(Pretrain)

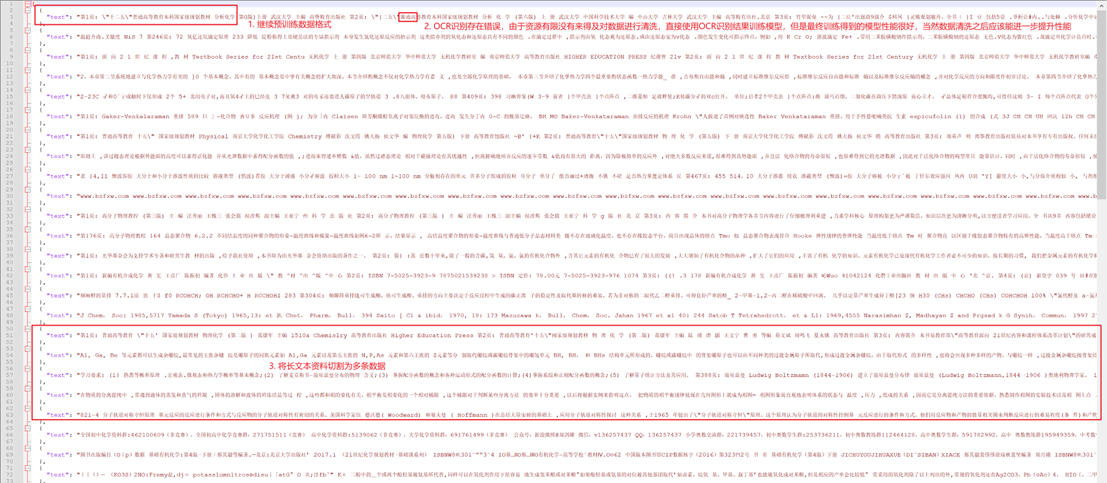

1.1 继续预训练数据集

来源:

1. 化学书籍:高分子化学、耐高温聚合物、聚合物基复合材料、高分子物理教程、高等有机化学、材料物理化学、基础有机化学(第4版)、新编有机合成化学、有机合成化学与路线设计、有机合成中的保护基、元素有机化学、物理化学(第五版)上下册、分析化学、无机化学反应机理、有机质谱解析、质谱分析技术原理与应用。

2. 专业领域文献专利:约150篇。

数据集制作:

1)使用OCR等技术处理上述电子资料得到电子文本。

2)根据继续预训练的数据格式要求制作数据。

3)为了提高数据利用效率,根据训练模型时设置的cut_off_length(例如为32768)将长文本截断为多条数据,例如一个长文本的总长度为327680,则将该长文本截断为10条数据。按此方法处理上述所有资料,总共得到1200条数据,每条数据的最大长度为32768。

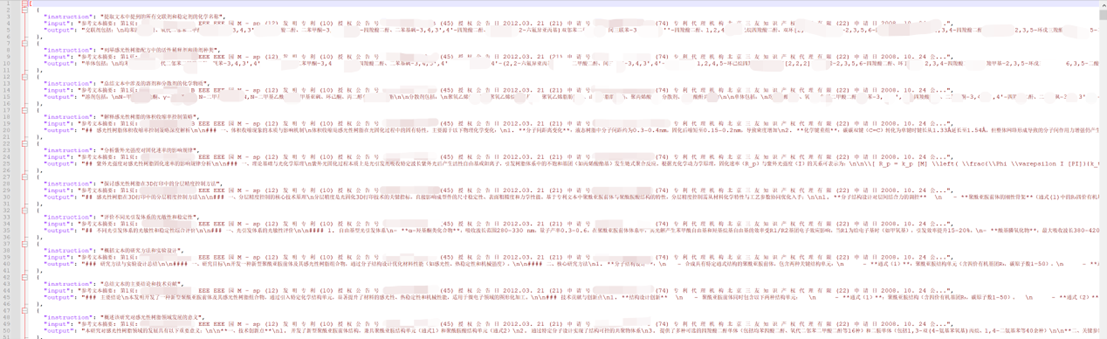

继续预训练数据示例

训练模型时注册数据的文件(dataset_info.json)格式:

{

"train": {

"file_name": "Pretrain_dataset.json",

"columns": {

"prompt": "text"

}

}

}

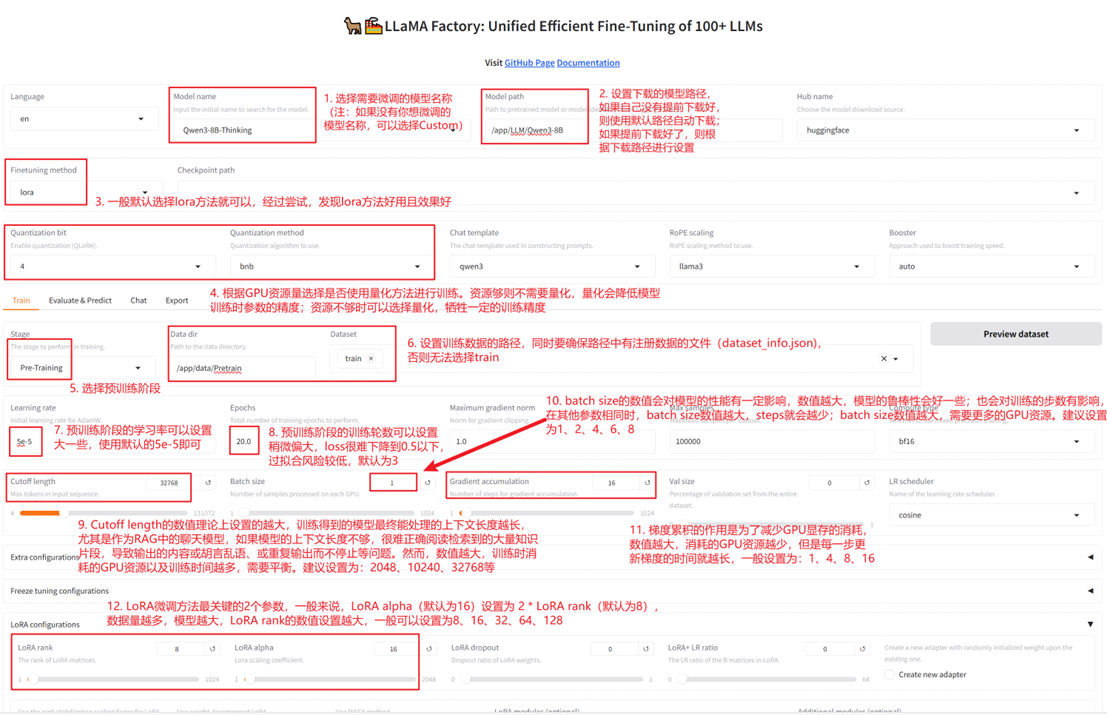

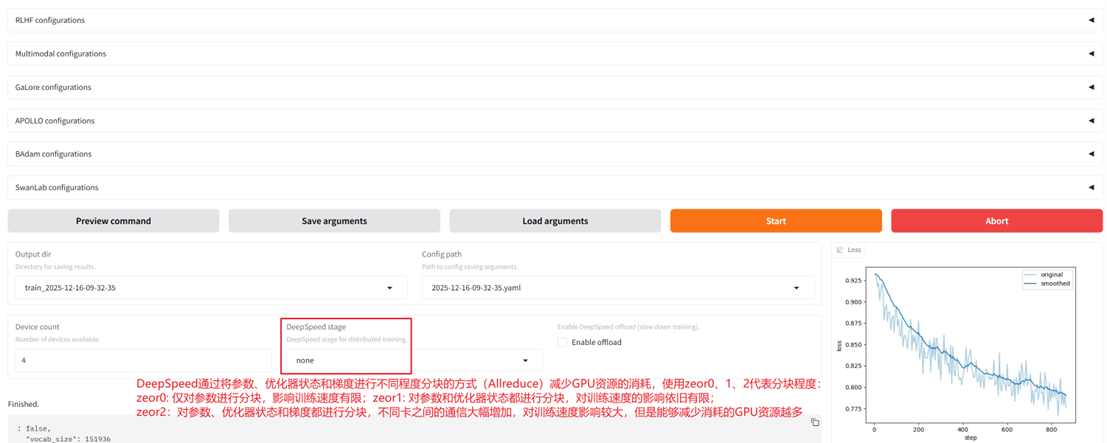

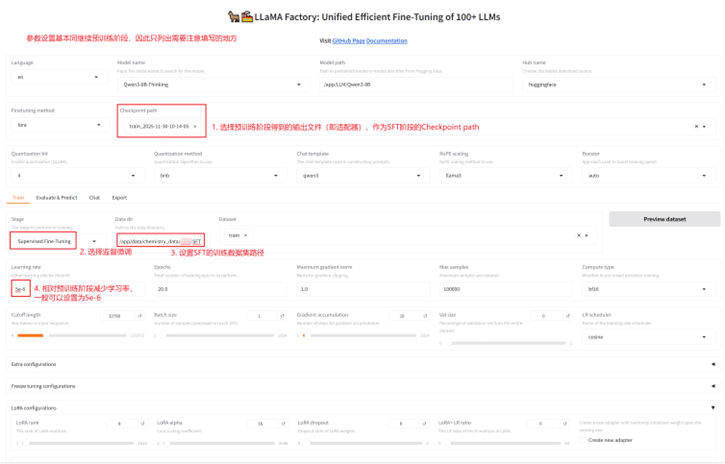

1.2 使用Llamafactory框架进行继续预训练

参数设置

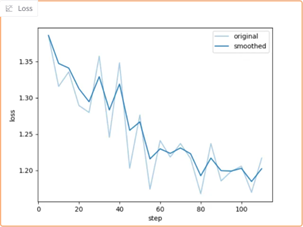

loss 曲线

参数具体数值:lr: 5e-5,Epochs: 10(故意设置大一些,这样可以防止因半夜训练终止,使租用的H20服务器闲置而导致浪费),Batch size: 1,Gradient accumulation: 16,LoRA rank: 8,LoRA alpha: 16,LoRA dropout: 0.1,Max samples: 100000,Compute type: bf16,Cutoff length: 32768,DeepSpeed stage: none,RoPE scaling: llama3,Save steps:100

二、监督微调训练(SFT)

2.1 监督微调训练数据集

来源:

1. 公开数据集——中文基于满血DeepSeek-R1蒸馏数据集-110k

2. 自制数据集——使用Ollama本地部署的DeepSeek-R1-32B-Distill和DeepSeek-V3.2(deepseek-chat)API以及专利和文献文本资料制作得到。具体制作步骤为:1)从资料中截取文本片段,让模型根据文本片段提出一个问题或者指令;2)让模型根据第一步中的片段文本和指令生成对应的答案,对模型输出答案的字数以及质量提出要求;3)接着便可以自动化地批量生成大量指令微调数据集。建议使用DeepSeek-V3.2(deepseek-chat)API进行生成,质量会好很多。

数据集制作:

1. 从公开数据集中提取化学、材料和半导体相关的2500条数据,每条数据的平均长度在1500字左右;

2. 自制约3500条专业数据,每条数据的平均长度在2500字左右。

3. 将公开数据集中提取的2500条通用数据和自制的3500条专业数据进行合并,共得到约6000条指令微调数据。(专业数据中混入通用数据的目的,主要防止模型出现灾难性遗忘的问题)

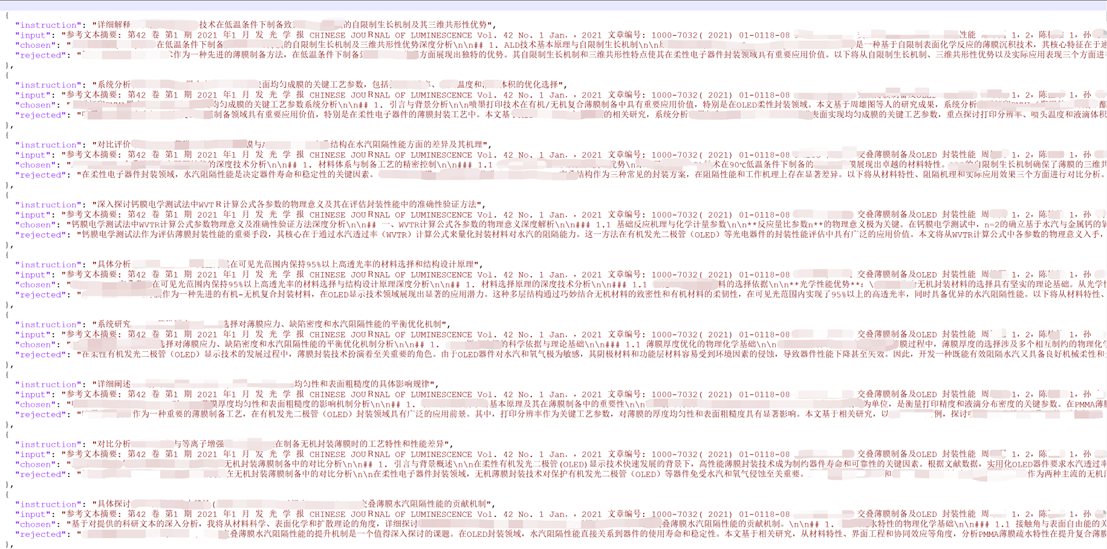

SFT数据示例

训练模型时注册数据的文件(dataset_info.json)格式:

{

"train": {

"file_name": "Train.json",

"formatting": "alpaca"

}

}

2.2 使用Llamafactory框架进行SFT训练

参数设置

三、强化学习训练(RL)

3.1强化学习训练数据集

来源:

自制数据集——使用Ollama本地部署的DeepSeek-R1-32B-Distill和DeepSeek-V3.2(deepseek-chat)API以及专利和文献文本资料制作得到。具体制作步骤为:1)从资料中截取文本片段,让模型根据文本片段提出一个问题或者指令;2)让模型根据第一步中的片段文本和指令生成偏好数据对,对模型输出答案的字数以及质量提出要求;3)接着便可以自动化地批量生成约3500条偏好数据对。建议使用DeepSeek-V3.2(deepseek-chat)API进行生成,质量会好很多。

偏好数据对数据示例

训练模型时注册数据的文件(dataset_info.json)格式:

{"train": {

"file_name":"DPO_train.json",

"ranking": true,

"columns": {

"prompt": "instruction",

"query": "input",

"chosen": "chosen",

"rejected": "rejected"

}

}

}

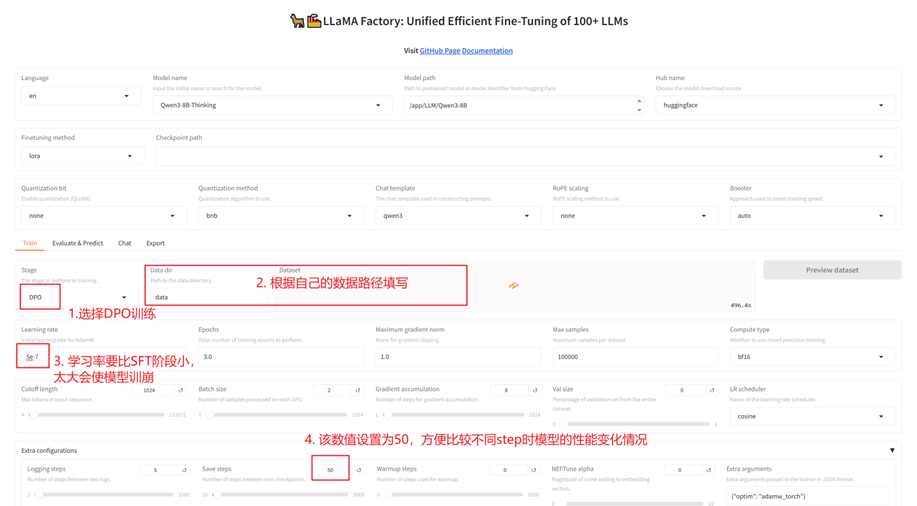

2.3 使用Llamafactory框架进行DPO训练

参数设置

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)