2026大模型智能体(Agent)面试全攻略

回答要点:这是提升Agent成功率最有效的模式。Agent生成输出后,由另一个(或同一个)Agent扮演批评者(Critic),检查输出是否符合约束条件,并提供反馈让前者迭代。技术细节:可以使用Reflexion架构,记录”失败轨迹”作为长短期记忆,避免重复同样的错误。

目录

一、核心概念与架构篇

- Q1:请简述Agent的基本架构组成,并解释其与传统LLM Chain的区别。

- Q2:解释ReAct模式的工作原理。

- Q3:如何实现Agent的长期记忆(Long-term Memory)?

二、多智能体协同(Multi-Agent Systems, MAS)

- Q4:单Agent遇到瓶颈时,为什么需要Multi-Agent?常见的协作模式有哪些?

- Q5:多智能体系统中如何解决”无限循环”或”通信冗余”问题?

三、Agent核心设计模式 (Design Patterns)

- Q6:请对比”工作流(Workflows)”与”自主智能体(Autonomous Agents)”的优劣。

- Q7:详细解释”编排者-执行者(Orchestrator-Workers)”模式。

- Q8:什么是”反思/自我纠正(Reflection/Self-Correction)”模式?

四、深度技术实现与状态管理

- Q9:在多轮对话Agent中,如何处理”状态爆炸”和”上下文溢出”?

- Q10:如何保证Agent调用工具(Function Calling)的可靠性?

- Q11:LangGraph中的”节点(Node)”和”边(Edge)”与传统工作流有何不同?

五、2026必考的Evals(评估)

- Q12:你如何量化一个Agent的性能?

六、Agentic RAG专项问答

- Q13:RAG系统中经常遇到检索出来的片段(Chunk)互相冲突,Agent该听谁的?

- Q14:如何处理企业知识库中的”权限隔离”问题?Agent会不会把高管工资查出来给普通员工?

- Q15:当知识库内容更新很快(如每日新闻或实时股价)时,你的RAG系统如何应对?

- Q16:如何提升问答准确度

- Q17:回答中如何包含原文档相关的图和表格

七、多模态处理专项问答

- Q18:在生成答案时,你如何确保LLM知道要在哪里插入哪张图?

- Q19:表格非常大,放入Prompt会导致上下文溢出或干扰模型,怎么优化?

- Q20:如何解决多页文档中,图片和描述文本不在同一页导致的关联错误?

八、项目落地:难点与解决方案

九、项目经历和技术亮点

- 项目一:设备故障维修助手

- 项目二:合同审核项目

- 项目三:企业级 Agentic RAG 知识库与交互系统

- 总结:三个项目在简历中的分工

十、给应聘者的建议

十一、面试官视角

- 面试官视角:我为什么会录用你?

- 面试深度 QA 预演(11道题和加分话术)

十二、简历自我评价和项目经历描述样例

- 简历自我评价(样例)

- 项目经历描述 (样例)

十三、 Agent 设计模式的深度讲解

一、核心概念与架构篇

Q1:请简述Agent的基本架构组成,并解释其与传统LLM Chain的区别。

回答要点:Agent = LLM + 规划(Planning) + 记忆(Memory) + 工具使用(Tool Use)。

区别:

- Chain是预定义的、线性的硬编码工作流。

- Agent具备”自主性”,它根据目标自发决定执行路径,通过推理循环(Reasoning Loop)不断调整策略。

Q2:解释ReAct模式的工作原理。

回答要点:ReAct (Reasoning + Acting)是Agent的基石。它将”;思考”(Thought)和”行动”(Action)结合。LLM先生成一段推理,说明下一步要做什么,然后调用工具观察(Observation)结果,再根据结果进入下一轮推理。

Q3:如何实现Agent的长期记忆(Long-term Memory)?

回答要点:

- 短期记忆:利用Context Window,存储当前会话的历史(Chat History)。

- 长期记忆:通过RAG (检索增强)。将历史经验、知识编码为Embedding存入向量数据库,Agent在执行任务前检索相关经验(Experience Retrieval)。

- 2026新趋势:利用长文本模型(Long-context LLMs)直接处理超长历史,或者通过”摘要层级结构”对记忆进行递归压缩。

二、多智能体协同(Multi-Agent Systems, MAS)

Q4:单Agent遇到瓶颈时,为什么需要Multi-Agent?常见的协作模式有哪些?

回答要点:

原因:单个Agent在处理复杂、跨领域长任务时容易出现”注意力漂移”或”推理链断裂”。

协作模式:

- 中心化(Boss-Worker):一个主Agent拆分任务并指派给子Agent。

- 流水线(Pipeline/Sequential):A的输出作为B的输入(如代码生成 -> 代码审查 -> 修复)。

- 民主协作(Joint Discussion):多个Agent共同讨论得出结论。

Q5:多智能体系统中如何解决”无限循环”或”通信冗余”问题?

回答要点:

三、Agent核心设计模式 (Design Patterns)

Q6:请对比”工作流(Workflows)”与”自主智能体(Autonomous Agents)”的优劣。

回答要点:

- Workflows:通过DAG(有向无环图)或状态机硬编码路径。优点是高可靠性、结果可预期,适用于报销审批、标准化客服。

- Autonomous Agents:由LLM决定循环次数和工具调用。优点是灵活性极高,适用于开放式研究、代码编写。

- 面试金句:2026年的工程趋势是”用Workflow约束Agent”,即在框架定义的路径内给予Agent局部决策权。

Q7:详细解释”编排者-执行者(Orchestrator-Workers)”模式。

回答要点:主Agent(Orchestrator)负责将复杂任务分解为子任务,分发给具有不同Skill的Worker Agents,最后汇总结果。

适用场景:大型软件开发(一个写UI,一个写后端,一个写测试)。

难点:任务分解的粒度。如果拆得太细,通信成本极高;太粗,Worker会产生幻觉。

Q8:什么是”反思/自我纠正(Reflection/Self-Correction)”模式?

回答要点:这是提升Agent成功率最有效的模式。Agent生成输出后,由另一个(或同一个)Agent扮演批评者(Critic),检查输出是否符合约束条件,并提供反馈让前者迭代。

技术细节:可以使用Reflexion架构,记录”失败轨迹”作为长短期记忆,避免重复同样的错误。

四、深度技术实现与状态管理

Q9:在多轮对话Agent中,如何处理”状态爆炸”和”上下文溢出”?

回答要点:

1. State Schema:定义严格的状态结构(如使用LangGraph的 TypedDict ),只保存核心变量。

2. Trim Strategy:不仅是简单的截断,而是根据语义重要性保留(例如保留System Prompt、最近N轮对话和当前任务目标)。

3. Summary Buffer:将旧的对话摘要化,将摘要存入Context头部。

Q10:如何保证Agent调用工具(Function Calling)的可靠性?

回答要点:

- 语法层面:利用JSON Mode或强类型约束。

- 逻辑层面:引入”确认机制(Human-in-the-loop)”,对于高风险操作(如删库、转账)必须由人点击确认。

- 重试逻辑:如果LLM生成的参数不合法,将报错信息返回给LLM,让其自我修复(Self-heal)。

Q11:LangGraph中的”节点(Node)”和”边(Edge)”与传统工作流有何不同?

回答要点:

- 传统工作流的边是固定的。

- LangGraph的边可以是条件边(Conditional Edges),由LLM的输出决定下一步走向哪个Node。

- 支持循环(Cycles),这是Agent能够不断尝试直到成功的核心。

五、2026必考的Evals(评估)

Q12:你如何量化一个Agent的性能?

回答要点:

1. 任务成功率 (Success Rate):这是核心指标。

2. 平均推理步数 (Avg Steps):步数越少,成本越低,响应越快。

3. 工具调用准确率 (Tool Call Accuracy)。

4. 影子测试 (Shadow Testing):在生产环境并行跑新旧Agent逻辑,对比输出差异。

六、Agentic RAG专项问答

Q13:RAG系统中经常遇到检索出来的片段(Chunk)互相冲突,Agent该听谁的?

回答要点:

1. 元数据加权:根据文档的实时性、权威性(部门等级)进行权重排序。

2. 多智能体辩论(Multi-Agent Debate):让不同的Agent持不同的Chunk进行对比,识别出冲突点并反馈给用户,或者根据逻辑一致性选择最合理的解释。

3. 引用溯源:强制要求输出必须附带Source链接,让用户做最后校验。

Q14:如何处理企业知识库中的”权限隔离”问题?Agent会不会把高管工资查出来给普通员工?

回答要点:

核心策略:RAG权限对齐。

实现方式:在向量数据库中,每个Embedding向量都附带 ACL (访问控制列表)元数据。在Agent触发检索请求时,强制将”当前用户信息”作为Filter注入检索语句中。确保在向量检索阶段就完成物理隔离,而不是靠提示词拦截。

Q15:当知识库内容更新很快(如每日新闻或实时股价)时,你的RAG系统如何应对?

回答要点:

1. 动态路由:Agent根据问题类型识别出”实时性要求”,如果是实时问题,优先调用实时API或搜索工具,而非检索向量库。

2. 流式索引更新:利用数据流(如Kafka)监听知识库变化,实现增量Embedding写入。

3. 缓存失效策略:针对高频问题设置TTL缓存,并在源数据更新时触发缓存失效。

Q16:如何提升问答准确度

提升准确度不能只靠 Prompt,而是一套组合拳:

1. 深度解析层:Layout-Aware Parsing(布局感知解析)

- 痛点:传统的文本分割(Chunking)会打断表格结构或将标题与正文分离,导致语义断裂。

- 解决方案:

- 使用 Layout Analysis 模型(如

DocLayout-YOLO或Unstructured)。将文档识别为:标题、正文、表格、图片、列表。 - 语义分块:按标题层级(H1-H4)进行切分,而不是按字符数。确保每个 Chunk 都有完整的上下文。

2. 检索增强层:Multi-Stage Retrieval

- 混合检索(Hybrid Search):向量检索(语义)+ BM25(关键词,解决专有名词、缩写问题)。

- 重排序(Reranking):使用 Cross-Encoder 模型(如 BGE-Reranker)对初筛的 Top-50 进行精排。这是提升准确度性价比最高的方法。

- 查询扩展(Query Expansion):Agent 自动生成 3 个同义问题并行检索,解决用户提问过于简单的问题。

3. 生成校验层:Self-Correction (Self-RAG)

- 验证节点:在生成答案前,让 Agent 判断:

- “检索到的内容是否足以回答问题?”(不够则重新检索)

- “答案中是否有任何内容是检索结果里没提到的?”(防止幻觉)

Q17:回答中如何包含原文档相关的图和表格

这是目前工业界的难点,核心在于“多模态对齐”和“引用索引”。

1. 表格的处理(Tables)

- 解析阶段:不要将表格转为纯文本。

- 最佳实践:将表格解析为 Markdown 或 HTML 格式。LLM 对结构化标记语言的理解能力远强于纯文本。

- 摘要索引:为每个表格生成一个自然语言摘要(Summary),将摘要存入向量库。检索时通过摘要定位表格,但在生成时把完整的 Markdown 表格喂给 LLM。

- 渲染阶段:前端直接渲染 LLM 输出的 Markdown 表格。

2. 图片的处理(Images)

- 多模态索引法:

- Image Captioning:使用多模态模型(如 GPT-4o-mini 或本地的 Qwen-VL)为图片生成详细描述。

- 存入向量库:将“图片描述 + 图片 ID + 所在页码”存入向量库。

- 检索逻辑:当用户问到“XX流程图”时,匹配到图片描述。

- 回显机制:

- 在返回给用户的答案中,使用特定占位符,如

[IMAGE_ID: 123]。 - 前端解析该占位符,从静态资源服务器(OSS)调用对应的图片 URL 进行展示。

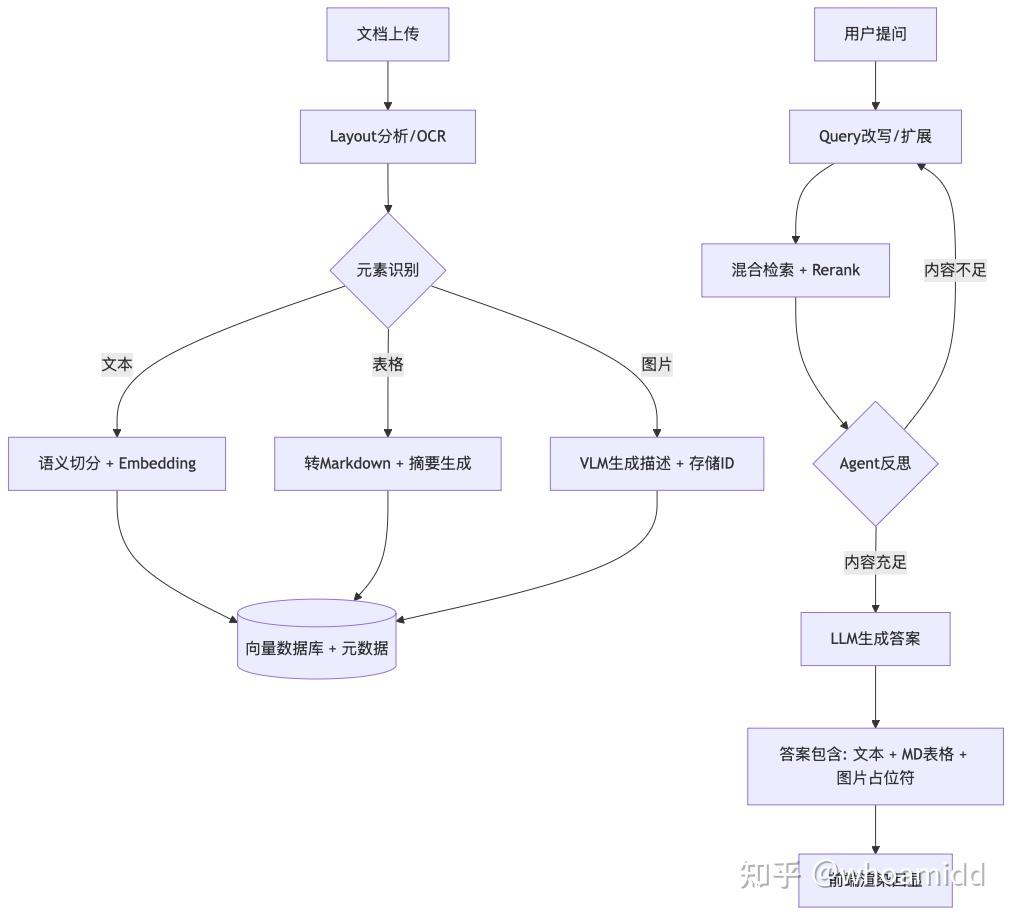

处理流程图

展示你对整个链路的工程化理解:

七、多模态处理专项问答

Q18:在生成答案时,你如何确保LLM知道要在哪里插入哪张图?

回答要点:引用占位符机制。

_“我在Prompt中强制约束LLM:’如果在检索到的内容中发现图片占位符(如 [IMG001] ),且该图片与答案高度相关,请在回复的相应位置保留该占位符’。 最终在前端展示时,我会写一个解析器,匹配这些占位符并从存储服务器(如OSS)中拉取真实图片进行渲染。这样既保证了图文位置对应,又避免了把大图片数据直接塞进Context导致的Token浪费。”

Q19:表格非常大,放入Prompt会导致上下文溢出或干扰模型,怎么优化?

回答要点:先摘要,后选择,再读取(Select-then-Read)。

“对于超大型表格,我不会一股脑塞给模型。 1. 第一步:Agent先通过表格的Schema(表头信息)和摘要判断该表是否包含所需数据。 2. 第二步:如果是,Agent会生成一个查询指令(类似SQL或Python代码),只提取表格中相关的行列。 3. 第三步:将提取后的精简子表喂给生成节点。这大大减少了干扰信息,准确度反而更高。”

Q20:如何解决多页文档中,图片和描述文本不在同一页导致的关联错误?

回答要点:滑动窗口与跨页聚合。

“在解析阶段,我会维护一个滑动窗口(Sliding Window)。如果图片出现在页眉,而相关描述在上一页末尾,系统会通过布局距离计算,将邻近的文本块作为该图片的’上下文元数据’共同存储,确保检索时的相关性。”

如何学习AGI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取