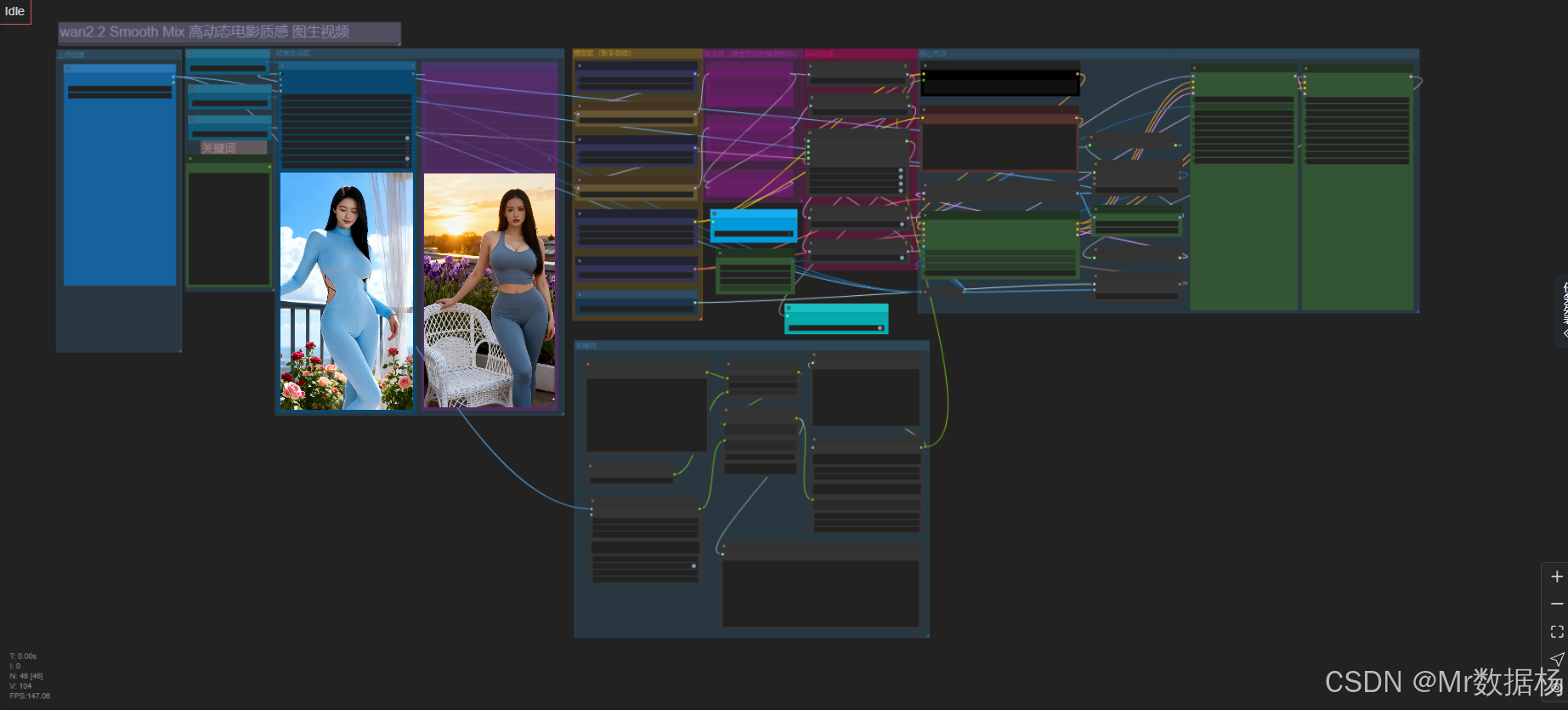

【ComfyUI】Wan2.2 Smooth Mix 通用主题电影质感图生视频

本文介绍了一个基于ComfyUI的电影质感图生视频工作流,适用于短片、微电影等创作场景。该工作流采用双模型融合技术(SmoothMix高低曝光模型),结合BlockSwap机制和SD3采样模块,实现丰富的画面层次与高动态范围效果。核心流程包括模型加载融合、文本/视觉提示处理、潜变量生成解码及视频合成,通过KSamplerAdvanced和CLIPVisionEncode确保帧间连贯性。关键节点如C

今天给大家演示一个基于 ComfyUI 通用主题电影质感图生视频工作流,该工作流融合了高级电影质感和短剧叙事能力,适合用于创作精致短片、微电影、动画分镜等场景。通过双模型融合机制与高效的图像-视频转换流程,它不仅能输出色彩细腻、氛围强烈的画面,还能兼容多样的提示词表达,在高自由度的前提下保持稳定生成质量。以下将从核心模型、关键节点结构到整个流程逻辑,逐步拆解该工作流的实现方法。

文章目录

工作流介绍

本工作流以 SmoothMix 双UNet 模型为主,采用双流模型融合技术(BlockSwap),分别处理不同曝光质感图像输入,以达到丰富的画面层次。工作流中结合了 ModelSamplingSD3 与 ModelPatchTorchSettings 模块,完成对模型权重的动态打补丁。同时,为实现从静态图到视频的过渡,使用 WanImageToVideo 与 VAEDecode 进行潜变量解码与视频帧构建,最后通过 VHS_VideoCombine 合成完整视频。本流程自动控制采样长度、分辨率与后处理,确保图像质量与帧间连贯性之间取得平衡。

核心模型

本工作流使用了 SmoothMix 定制版模型 smoothMixWan22I2V14B_i2vHigh 与 smoothMixWan22I2V14B_i2vLow,分别用于模拟不同光影风格的图像生成。它们通过 BlockSwap 机制融合处理,配合 VAELoader 与 CLIP 模型,实现多模态的控制力,同时保持了图像的高细节保真度。该模型组合适合生成高动态范围内容,并保留极强的艺术风格控制能力。

| 模型名称 | 说明 |

|---|---|

| smoothMixWan22I2V14B_i2vHigh.safetensors | 高光影质感图像生成模型,适用于突出曝光效果、细节强烈的画面场景 |

| smoothMixWan22I2V14B_i2vLow.safetensors | 低曝光、柔和风格图像生成模型,适合营造温柔、沉稳的视觉氛围 |

| wan_2.1_vae.safetensors | VAE 编码器,用于图像潜变量的解码与复原,提高图像还原质量 |

| umt5_xxl_fp8_e4m3fn_scaled.safetensors | 文本理解与编码使用的 CLIP 模型,支持中文语义理解 |

| clip_vision_h.safetensors | 用于图片内容理解的视觉编码器,增强生成视频与输入图像的一致性 |

Node节点

该工作流的节点设计覆盖从文本编码、模型采样、融合打补丁,到图像后处理与视频合成的全链条流程。重点模块包括双通道 BlockSwap 控制器、SD3 采样模块、高精度解码器以及视觉引导的 CLIP Encode 节点。此外,通过 KSamplerAdvanced 实现分阶段采样策略,让视频帧间连贯性大幅提升。

| 节点名称 | 说明 |

|---|---|

| UNETLoader | 加载 UNet 主模型,分别负责高低曝光图像生成路径 |

| wanBlockSwap | 实现模型 Block 融合,控制生成层次差异 |

| ModelSamplingSD3 | 控制模型采样强度与细节程度 |

| ModelPatchTorchSettings | 对模型进行参数补丁设定,提高推理稳定性 |

| CLIPLoader / CLIPTextEncode | 文本提示词的处理与特征提取 |

| CLIPVisionLoader / CLIPVisionEncode | 输入图像的视觉特征提取,为图像视频一体化生成做准备 |

| VAELoader / VAEDecode | 潜变量解码为图像,保留细节质量 |

| WanImageToVideo | 图像帧到潜变量视频的核心生成组件 |

| VHS_VideoCombine | 多帧图像合成最终视频,支持音频、帧率等参数配置 |

工作流程

该工作流采用分阶段式图像到视频的生成逻辑,核心通过双模型采样实现画面差异融合,再通过多节点协调完成推理、解码与视频合成。整体流程分为六大阶段:模型加载与融合、文本与视觉提示处理、潜变量采样生成、图像解码、视频构建与优化处理。流程中通过两个 KSamplerAdvanced 控制推理节奏,并借助 CLIPVisionEncode 对图像结构进行引导,确保视频连续性与语义一致。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型加载与融合 | 加载两个不同风格的 UNet 模型,并通过 BlockSwap 模块实现特征融合 | UNETLoader、wanBlockSwap |

| 2 | 采样参数控制 | 使用 SD3 模型采样结构控制图像推理过程的风格强度 | ModelSamplingSD3 |

| 3 | 模型打补丁 | 使用 Torch Patch 模块设置模型推理参数,提升稳定性 | ModelPatchTorchSettings |

| 4 | 文本与图像提示处理 | 加载 CLIP 文本与视觉模型,并将提示词与输入图像编码成条件向量 | CLIPLoader、CLIPTextEncode、CLIPVisionEncode |

| 5 | 潜变量生成与解码 | 使用 WanImageToVideo 模块将条件向量与图像生成潜变量,再通过 VAE 解码为图像帧 | WanImageToVideo、VAEDecode |

| 6 | 视频合成与输出 | 将图像帧合成为视频,并设置帧率、格式、输出路径等参数 | VHS_VideoCombine |

大模型应用

CLIPTextEncode 文本语义编码核心节点

这一节点负责把用户的文字提示转成可供模型理解的语义特征。它不处理图像,只专注于文字信息的编码质量,决定了生成画面的风格、光影、主体细节与整体表达。优质 Prompt 能让模型在取景、质感与叙事方向上更贴近用户的意图,而负面 Prompt 则用于抑制噪点、错肢、风格跑偏等问题。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncode | beautiful young girl sitting by a pool… vibrant colors, 8k ultra realistic illustration 色调艳丽,过曝,静态… poorly drawn face, deformed, disfigured… |

将文本提示转成模型能理解的语义编码,用于控制画面风格、人物质感与画面质量,是生成方向最关键的文字驱动模块。 |

AILab_QwenVL 图像理解与文字生成节点

AILab_QwenVL 用于对输入图像进行语义分析,并生成可直接作为 Prompt 使用的文字描述。它的主要职责是理解画面中的人物、环境、光线与动作,为最终视频构建自动化文案提示。Prompt 在这个节点中同样发挥引导作用,决定模型描述的角度、细节深度以及写作风格。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| AILab_QwenVL | Describe this image in detail. Please provide a detailed description of the image content. |

自动解析画面并输出结构化描述,用于生成视频文案提示、补充角色细节或构建自动化正向 Prompt。 |

CLIPVisionEncode 图像视觉特征编码节点

此节点负责将输入图像转为视觉特征,用于在视频生成时提供参考。它不会参与图像绘制,而是提供纯视觉理解能力,确保角色外观、环境或基础构图能在后续阶段被模型保留。Prompt 虽不直接输入,但视觉特征会结合文本 Prompt 共同影响最终效果。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPVisionEncode | (无文字 Prompt) | 将图像内容提取为视觉特征编码,与文字 Prompt 共同影响生成画面,对角色外貌、背景和图像布局保持一致性起核心作用。 |

使用方法

整个工作流通过“图像 + Prompt + 视觉特征”共同驱动视频生成。用户只需替换输入图片、修改 Prompt 或更新参考图,系统就会自动完成文本编码、视觉分析、模型采样、画面重建到最终视频整合的全流程。角色图用于确定人物外貌,动作图用于提供动态参考,音频可用于同步输出,Prompt 决定画面的审美风格、光影质感与镜头表达。替换素材后,整个流程会自动重新走完整链路,从语义解析到视频渲染一次生成,无需额外操作。

| 注意点 | 说明 |

|---|---|

| Prompt 要具体 | 描述越清晰,生成效果越稳定。 |

| 保持角色参考清晰 | 模糊或低分辨率图像会降低模型对外貌的理解度。 |

| 负面 Prompt 必须完整 | 用于压制畸形、错肢、画面噪点等问题。 |

| 图片比例需匹配视频尺寸 | 避免拉伸或构图错位。 |

| 避免过度修改节点结构 | 会造成无法正常生成或结果不一致。 |

应用场景

该工作流适用于生成具备叙事性与电影质感的视频内容,特别适合动画短剧、剧情预告、创意广告等场景。借助双模型融合与精准的文本提示控制,用户可以实现从情绪控制、角色造型到背景叙述等全方位自定义。系统支持高清输出、视频帧增强与语义一致性引导,适合创作者、AI艺术家、内容剪辑人员使用,极大提升了从图像向动态视频创作的效率与品质。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 短剧动画创作 | 通过提示词快速生成风格一致的角色短片 | AI动画创作者 | 动态人物、角色情绪、动作连续性 | 视频连贯、情绪表达自然 |

| 剧情预告制作 | 利用镜头风格引导生成不同场景短预告 | 短视频剪辑师 | 场景切换、光影变化、氛围渲染 | 电影感强、画面统一 |

| 创意广告/视觉包装 | 生成风格化动图或视频广告内容 | 品牌视觉设计师 | 主题画面、色彩张力、视觉符号 | 风格突出、适配多平台 |

| 视频封面生成 | 输出视频封面帧或 GIF 动图 | 自媒体工作者 | 视频缩略图、主图动效 | 吸引眼球、增强点击率 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)