从 0 开始学习人工智能——AIGC 生成式人工智能主流框架演变过程

本文深度解析了生成式AI的主流架构及其应用场景。文章首先介绍了生成式模型的五大主流类型:自回归模型(如Transformer)、扩散模型、生成对抗网络(GAN)、变分自动编码器(VAE)和基于流的模型。重点分析了Transformer在自然语言处理中的革命性突破,扩散模型在图像生成领域的优势,以及GAN"左右互搏"的独特训练机制。同时探讨了VAE在数据压缩和异常检测中的应用价值

深度解析生成式模型的主流架构

作为一名长期关注人工智能发展的科技博主,经常有读者问我:“ChatGPT 和 Midjourney 到底有什么区别?”答案不仅仅在于一个是生成文本,一个是生成图片,而在于它们“大脑”的构造——即生成式模型(Generative Models)的底层架构。

生成式 AI 并非魔法,而是数学与架构的艺术。深度生成式模型利用多层神经网络来理解数据的复杂分布,进而创造出全新的数据点。今天,我们就通过拆解当前最主流的几种模型架构,来探究生成式 AI 是如何工作的。

一、 生成式模型的“战国时代”

在深入细节之前,我们需要先看清版图。目前的生成式领域并非一家独大,而是多种架构各领风骚,每种架构都有其独特的“世界观”:

自回归模型 (Autoregressive Models):预测序列的下一个环节,语言模型的基石。

扩散模型 (Diffusion Models):从无序的噪声中重构秩序,图像生成的霸主。

生成式对抗网络 (GAN):矛与盾的博弈,曾经的王者,依然在视觉领域占有一席之地。

变异自动编码器 (VAE):通过编码压缩与解码还原,寻找数据的隐空间表示。

基于流的模型 (Flow-based Models):通过可逆数学运算,直接学习复杂分布。

二、 自回归模型与 Transformer 的崛起

自回归模型的核心逻辑非常直观:基于过去,预测未来。它通过评估序列中已存在部分的概率相关性,来决定下一个数据点是什么。

1. 从 RNN 到 Transformer 的范式转移

早期的自回归模型多采用循环神经网络 (RNN)。虽然 RNN 奠定了基础,但它有两个致命弱点:

“失忆症”:难以捕捉长距离的依赖关系(比如文章开头和结尾的呼应)。

效率低下:必须逐个按顺序处理数据,无法并行计算。

2017 年,Transformer 架构横空出世,彻底改变了游戏规则。 它通过两大创新解决了 RNN 的痛点,成为了如今 LLM(大型语言模型)的事实标准:

并行处理 (Parallel Processing):Transformer 可以同时处理序列中的所有项目。这意味着我们可以用更大规模的数据集,在更短的时间内训练出更强大的模型。

自注意力机制 (Self-Attention):这是 Transformer 的灵魂。它允许模型在处理当前词元时,同时关注序列中所有其他词元的相对重要性,无论它们相距多远。这赋予了模型前所未有的上下文理解能力。

2. 行业格局与应用

目前,包括 OpenAI 的 GPT 系列、Anthropic 的 Claude、Meta 的 Llama 以及 Google 的 Gemini,本质上都是基于 Transformer 架构的自回归模型。

NLP 与对话:从 ChatGPT 到文档摘要,这是 Transformer 的主场。

代码生成:不仅是写文本,Transformer 对逻辑严密的代码(如调试、生成片段)同样得心应手。

时间序列与强化学习:在金融预测、天气预报甚至教 AI 做决策(强化学习)方面,自回归逻辑同样适用。

三、 扩散模型:从噪声中诞生的艺术

如果说 Transformer 是逻辑大师,那么扩散模型 (Diffusion Models) 就是一位极具耐心的画家。目前主流的 AI 绘画工具,如 Midjourney、Stable Diffusion 和 DALL-E 2,均由其驱动。

1. 核心原理:破坏与重建

扩散模型的工作流程可以分为三个阶段,不仅优雅而且精妙:

前向扩散(施加噪声):

想象一下,一位吉他手不断调大放大器的增益,直到吉他声完全变成刺耳的静电噪音。扩散模型在训练时就是这样,通过马尔可夫链不断向图片添加高斯噪声,直到数据面目全非。

学习过程:

模型观察数据是如何一步步被“毁掉”的,从而学习噪声变化的规律。

反向扩散(去噪生成):

这是“见证奇迹”的时刻。模型利用学到的规律,将一团纯随机的噪声逐步还原,去除杂质,最终“雕刻”出符合用户提示词的高保真图像。

2. 超越图像的潜力

除了生成逼真的人脸和艺术画作,扩散模型在工业界还有更深的应用:

3D 内容生成:Google 的 DreamFusion 正利用扩散原理从文本生成 3D 模型。

异常检测:由于扩散模型深知数据随时间变化的规律,它能敏锐地发现网络安全或医疗影像中不符合趋势的“异常点”。

版权争议:值得注意的是,AI 生成图像的版权问题(如美国版权局 2023 年的裁定)仍是法律界的热点,这也伴随着扩散技术的普及而成为行业必须面对的合规挑战。

四、 生成式对抗网络 (GAN):左右互搏的博弈论

在扩散模型爆火之前,GAN (2014年推出) 曾是生成式 AI 的代名词。它的核心架构基于一种对抗博弈,通常由两个卷积神经网络 (CNN) 组成。

1. 生成器 vs 判别器

GAN 的逻辑就像是一场“艺术伪造者”与“鉴定专家”的猫鼠游戏:

生成器 (Generator):负责制造“赝品”,试图骗过鉴定专家。

判别器 (Discriminator):负责判断输入是“真迹”还是“赝品”。

两者在激烈的竞争中共同进化:伪造者的技艺越来越高超,鉴定家的眼光也越来越毒辣。最终,生成器创造出的内容足以乱真。

2. 优势与局限

优势:GAN 的推理速度极快(优于扩散模型),且计算效率高。

劣势:GAN 容易出现“模式崩溃 (Mode Collapse)”,即生成器为了偷懒,只反复生成极少数能骗过判别器的样本,导致输出缺乏多样性。

3. 当下的应用

虽然在纯图像生成上受到了扩散模型的挑战,但 GAN 在特定领域依然不可替代:

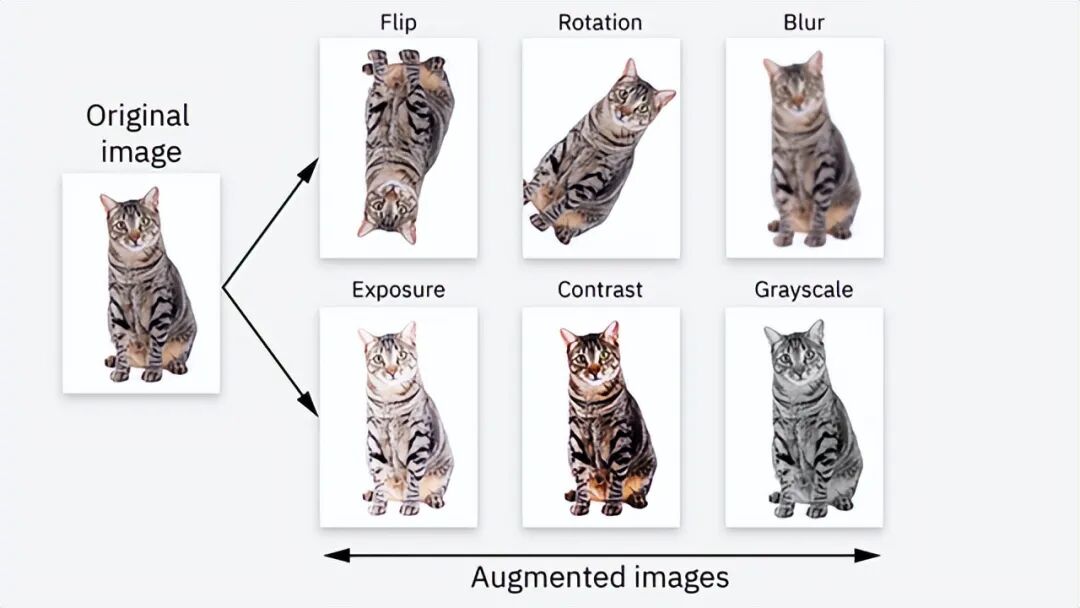

数据增强:在数据稀缺时,利用 GAN 生成合成数据来训练其他模型。

计算机视觉:物体检测、人脸识别、以及极为精细的异常检测。

前沿融合:目前已有研究提出 Diffusion-GAN,试图结合扩散模型的稳定性与 GAN 的高效率。

从 Transformer 的“预测下一个词”,到扩散模型的“从噪声中重构”,再到 GAN 的“左右互搏”,生成式 AI 的繁荣正是建立在这些各具特色的架构之上。

作为开发者或技术爱好者,理解这些模型底层的差异,能帮助我们更好地选择工具,甚至预见 AI 的下一个突破口。未来,我们或许会看到更多融合型架构的出现,让 AI 的创造力更上一层楼。

五、 变分自动编码器 (VAE):隐空间的探索者

如果说扩散模型是“无中生有”的画家,那么 变分自动编码器 (VAE) 更像是一位精通数据压缩与解压的统计学家。

1. 核心架构:瓶颈处的艺术

VAE 的工作原理建立在编码器 (Encoder) 和 解码器 (Decoder) 的优雅协作之上,其核心在于对潜在空间 (Latent Space) 的掌控:

编码器(压缩):它不只是简单地压缩数据,而是学习数据集中的潜在变量 (Latent Variables)。想象一下,编码器试图将一张复杂的人脸照片浓缩成几个核心特征(如“微笑程度”、“光照方向”)。这些特征构成了潜在空间。

瓶颈 (Bottleneck):这是 VAE 最独特的设计。数据被压缩到一个极低维度的分布中,只有最关键的信息能通过这个“瓶颈”。

解码器(重构):它从瓶颈处获取压缩后的表示,并将其“脑补”回原始数据的形态。

一个优秀的 VAE 模型,其解码器不仅能还原数据,还能通过调整潜在空间中的参数,生成与原始数据相似但全新的变体。

2. VAE 的行业定位与用例

在图像生成的“逼真度”竞赛中,VAE 确实输给了扩散模型(生成的图像往往略显模糊,因为它是对潜在空间取“平均值”)。但在其他对结构化理解要求更高的领域,VAE 依然是王者:

异常检测的性价比之选:相比 GAN 和扩散模型,VAE 的训练成本更低、更稳定。在工业质检或网络安全中,VAE 可以通过比较“重构数据”与“原始数据”的差异,快速揪出偏离预测分布的异常点。

基因组学:这是 VAE 的高光领域。遗传学家利用它来计算育种价值或预测疾病风险,因为 VAE 擅长处理复杂的生物特征分布。

数据修复与去噪:VAE 虽然不擅长从零画出高清图,但非常擅长“修图”。它可以填补音频文件中的空白,或者去除医疗影像中的噪点,因为它“知道”干净的数据应该长什么样。

半监督学习:在标注数据稀缺的情况下,VAE 可以帮助理解数据分布,甚至生成增强数据来辅助分类器的训练。

六、 基于流的模型:数学家的精确解

基于流的模型 (Flow-based Models) 是生成式模型中数学理论最严谨的一派。与 VAE 近似估计分布不同,流模型试图通过一系列可逆的数学变换 (Normalizing Flows),明确地学习数据集的概率密度函数。

1. 核心逻辑:无损的可逆管道

想象一条管道,数据从一端流向另一端。

可逆性:数据可以从简单分布(如噪声)流向复杂分布(如图像),也可以无损地反向流动。

精确的密度估算:它不靠猜,而是通过复杂的统计数学,精确计算出目标变量的概率密度。这意味着生成的样本能完美保持初始数据集的统计属性。

2. 独特的应用场景

由于其对数据分布的精确把控,基于流的模型在科学计算领域大放异彩:

分子图生成 (Molecular Graph Generation):这是新药发现的关键。科学家利用流模型生成新的分子结构,帮助寻找下一个重磅药物或新型材料。

高精度的密度估算:在任何需要精确了解数据概率分布的场景下,流模型都是首选。

图像生成:虽然 PixelCNN(一种将自回归应用于变换序列的模型)等早期探索证明了其潜力,但目前流模型在捕捉长距离依赖关系上仍逊色于 Transformer,因此在主流图像生成中较为小众。

七、 房间里的大象:生成式模型的“幻觉”

生成式 AI 令人惊叹的创造力,本质上是一把双刃剑。同样的机制让它能写出美妙的诗歌,也让它会一本正经地胡说八道——这就是所谓的幻觉 (Hallucinations)。

1. 幻觉的本质

当模型在训练数据中强行寻找现实中不存在的模式,或者将概率上相关但事实不符的信息拼凑在一起时,幻觉就产生了。它不是在“撒谎”,它只是在进行错误的“模式补全”。

2. 经典案例:Seinfeld 的“孟加拉之旅”

让我们看一个真实的翻车现场。当询问 ChatGPT-4o mini 关于美剧《Seinfeld》的情节时:

用户:“Kramer 哪一集去了孟加拉国?”

AI 回复:“Kramer 在第 8 季第 145 集‘The Little Jerry’中去了孟加拉……”

事实核查:

《Seinfeld》里 Kramer 从未去过孟加拉国。

“The Little Jerry”这集讲的是 Kramer 买了一只斗鸡。

再次询问时,AI 甚至可能编造出一个叫“The Maldives”的不存在的剧集。

这种现象不仅存在于文本模型。扩散模型在画手时画出 6 根手指,或者画出违反物理规律的物体,本质上也是视觉层面的“幻觉”。

八、 工程化解法:如何驯服幻觉?

作为技术从业者,我们必须认识到:目前还无法从数学上彻底消除幻觉,但我们可以通过工程手段 (Engineering Best Practices) 将其风险降至最低。

1. 提示词工程 (Prompt Engineering)

给足上下文:不要让 AI 猜。提示越明确,限制条件越多,AI 瞎编的空间就越小。

角色设定:明确指示 AI 扮演“严谨的研究员”而非“创意作家”,并要求其“仅依据可验证的事实回答”。

2. 检索增强生成 (RAG) —— 行业的杀手锏

这是目前企业级应用中最主流的方案。不要让 LLM 仅依靠其“大脑”(预训练权重)里的记忆作答,而是先让它去“图书馆”(外部知识库)检索相关文档,再基于检索到的信息生成答案。RAG 能显著降低幻觉率,因为答案有据可依。

3. 微调与人工介入 (HITL)

微调 (Fine-tuning):针对特定领域(如法律、医疗)的高质量数据进行微调,可以纠正模型的通用偏差。

人工验证 (Human-in-the-Loop):在关键决策场景下,AI 只能作为副驾驶,最终的核查必须由具备专业知识的人类完成。

从 VAE 的隐空间压缩,到流模型的数学精确性,再到与幻觉的斗争,生成式 AI 的发展史就是一部在“创造力”与“可控性”之间寻找平衡的历史。理解这些架构的优劣,正是我们驾驭这项技术的前提。

更多transformer,VIT,swin tranformer

参考头条号:人工智能研究所

v号:人工智能研究Suo, 启示AI科技动画详解transformer 在线视频教程

更多推荐

已为社区贡献39条内容

已为社区贡献39条内容

所有评论(0)