DeepSpeed v0.18.5 发布:PyTorch 2.9 适配、ZeRO-3 优化与多项关键修复全面升级!

代码地址:github.com/deepspeedai/DeepSpeedDeepSpeedv0.18.5是一次稳定而重要的更新。该版本在多平台支持、分布式训练性能、BF16 与 ZeRO 模式兼容性、文档一致性等方面都进行了全面优化。随着 PyTorch 2.9 的支持加入,DeepSpeed 在高性能大模型训练领域的工程成熟度再度提升。这次更新不仅强化了核心训练引擎的健壮性,也为未来的性能扩展

·

2026 年 2 月 1 日,DeepSpeed 官方团队正式发布 v0.18.5 版本。本次更新带来了大量功能改进与稳定性增强,进一步完善了在多设备(尤其是 MPS 与 BF16 环境)下的兼容性与性能优化。以下为本次更新的详细内容整理。

🧩 版本概览

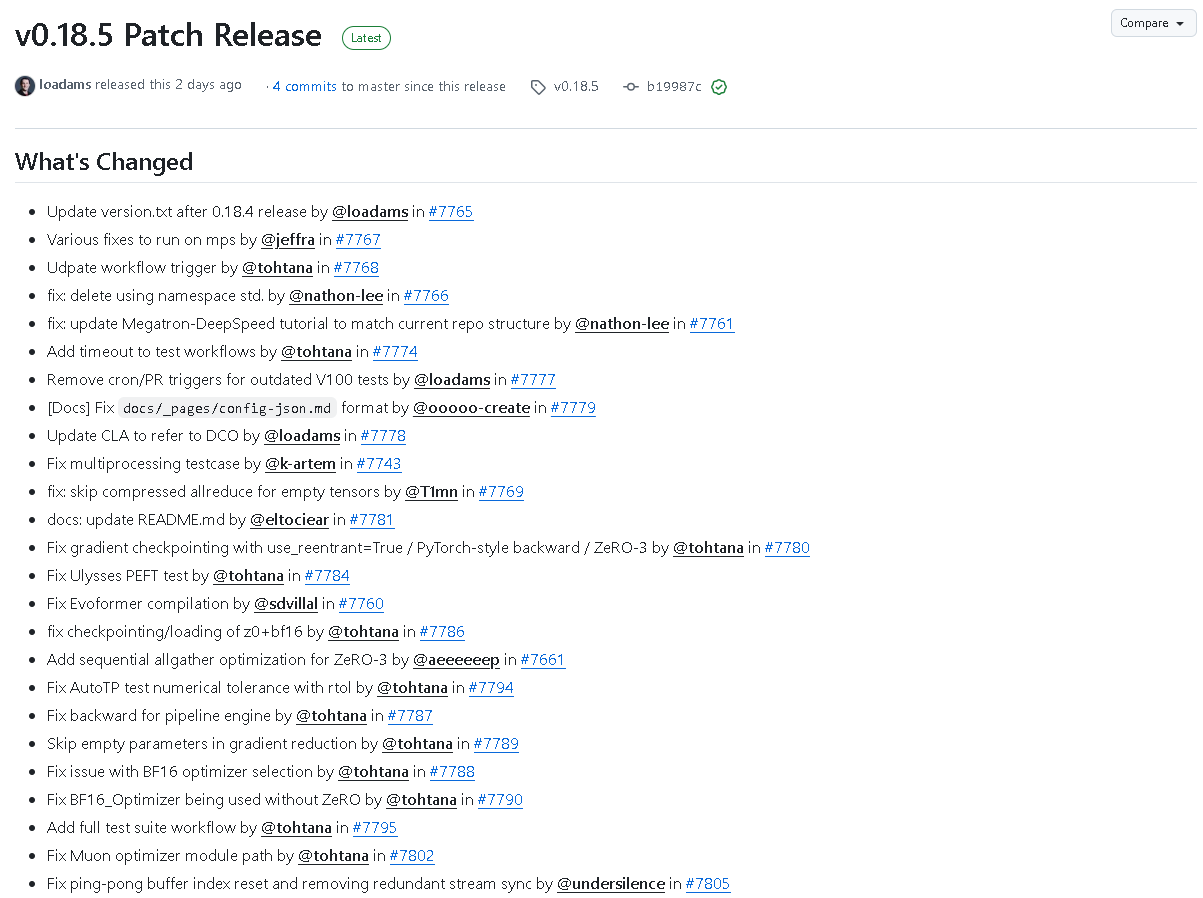

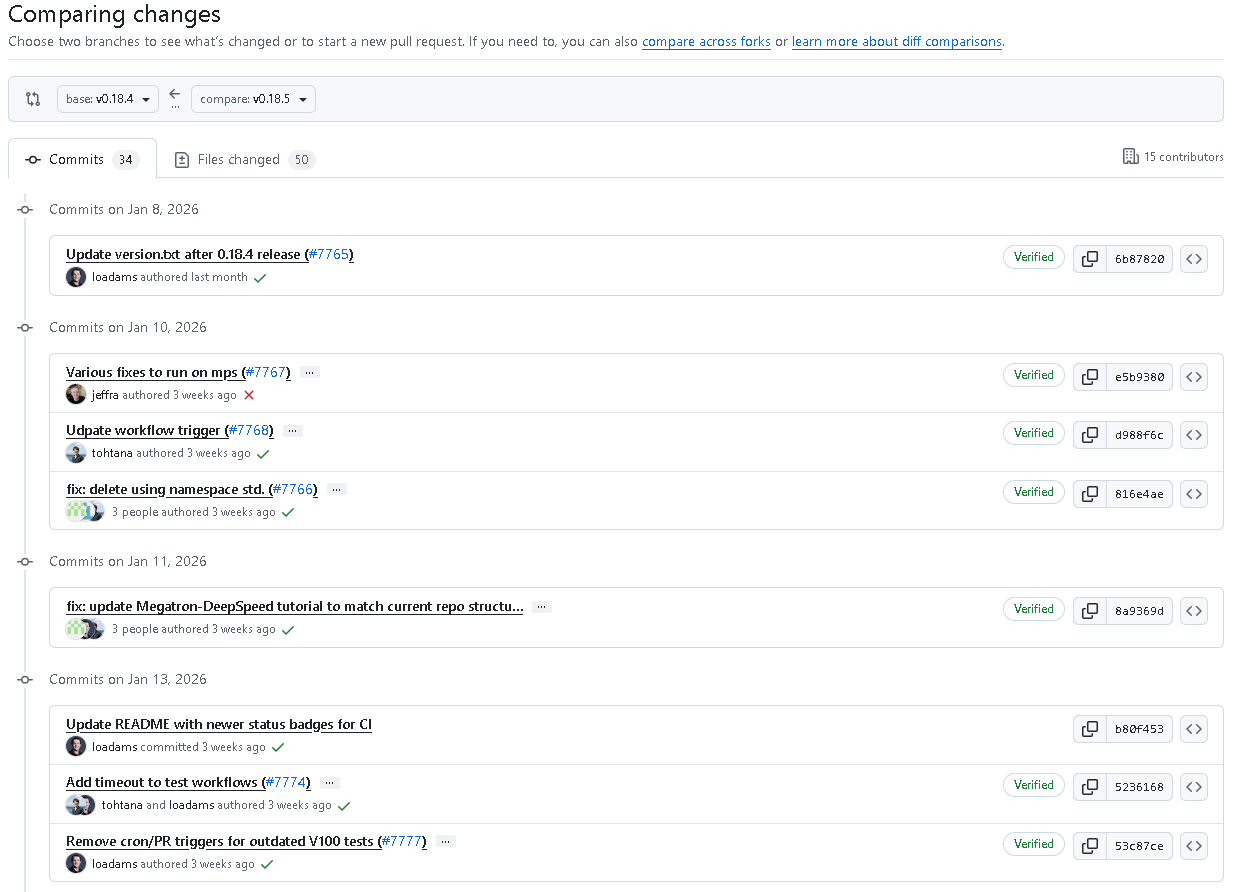

DeepSpeed v0.18.5 共包含 34 次提交(Commits)、15 位贡献者、50 个文件变更,主要集中于以下几个方向:

- 多平台兼容性优化

- ZeRO-3 与 BF16 支持增强

- 训练引擎与测试框架改进

- 文档与教程同步更新

- PyTorch 版本升级至 v2.9

🚀 功能与修复详情

✅ 系统与测试优化

- 更新版本号文件 version.txt(v0.18.4 → v0.18.5)。

- 增强在 Apple MPS 平台上的运行兼容性。

- 优化 GitHub Workflow 触发逻辑,新增测试超时限制。

- 删除过时的 V100 测试触发器,提升 CI 效率。

- 新增 完整测试套件工作流,确保功能覆盖更广。

✅ 代码结构与稳定性增强

- 删除

using namespace std.语句,提升代码规范性。 - 修复多进程测试问题。

- 针对压缩 allreduce 操作添加空张量跳过逻辑。

- 优化引擎清理机制(engine cleanup),减少冗余资源占用。

- 修复 Ping-Pong 缓冲索引重置逻辑,移除多余的同步操作。

🔄 训练框架与性能优化

🧮 ZeRO 系列改进

- 为 ZeRO-3 增加 顺序 allgather 优化,显著提升大规模分布式训练性能。

- 修复 ZeRO 阶段中 BF16 优化器选择逻辑,确保不同精度模式下的正确行为。

- 修复 BF16_Optimizer 无 ZeRO 模式下被误用的问题。

- 在 ZeRO 测试中自动选择合适的优化器,保证一致性。

💾 检查点与反向传播修复

- 修复 z0 + bf16 模式下的 checkpoint 加载问题。

- 修复 梯度检查点(gradient checkpointing) 在

use_reentrant=True、PyTorch-style backward、ZeRO-3 模式下的兼容性问题。 - 修复管道引擎(pipeline engine)中反向传播的异常。

- 在梯度归约(gradient reduction)中跳过空参数,避免无效同步。

🔧 优化器与模型稳定性提升

- 修复 BF16 优化器选择问题,避免错误分配。

- 修复 Muon 优化器模块路径错误。

- 解决在 Ulysses 模型中 sp_size < world_size 时反向传播报错(Rank index out of range) 的问题。

- 修复 Ulysses PEFT 测试 与 Evoformer 编译错误,并调整 Evoformer 测试为顺序执行,以提升稳定性。

📘 文档与教程同步改进

- 更新 Megatron-DeepSpeed 教程,使其与当前仓库结构匹配。

- 修复 配置文件文档(config-json.md) 的格式问题。

- 更新 README.md 与 加速器配置指南,修正拼写与链接错误。

- 调整 CLA 协议说明,改为采用 DCO(Developer Certificate of Origin) 验证机制,简化贡献流程。

🧠 额外改进

- 增加在未指定

modifier_rank的情况下,对 GatheredParameters 原地修改的清晰报错提示,帮助开发者快速定位问题。 - 将 PyTorch 模态测试 框架全面升级至 v2.9,确保最新版本兼容性与性能表现。

🧾 总结

代码地址:github.com/deepspeedai/DeepSpeed

DeepSpeed v0.18.5 是一次稳定而重要的更新。该版本在 多平台支持、分布式训练性能、BF16 与 ZeRO 模式兼容性、文档一致性 等方面都进行了全面优化。随着 PyTorch 2.9 的支持加入,DeepSpeed 在高性能大模型训练领域的工程成熟度再度提升。

这次更新不仅强化了核心训练引擎的健壮性,也为未来的性能扩展和多平台支持奠定了基础。

版本信息:

- 🔖 版本号:v0.18.5

- 📅 发布日期:2026 年 2 月 1 日

- 🧑💻 提交数:34

- 🧩 文件变动:50

结语:

DeepSpeed v0.18.5 的推出,再次展示了其在分布式训练与模型加速领域的持续领先。对于追求极致性能与兼容性的开发者而言,本次升级值得立即尝试与部署。

更多推荐

已为社区贡献45条内容

已为社区贡献45条内容

所有评论(0)