大模型:python交通大数据分析系统 智慧交通 地铁数据 客流量分析 爬虫 预测算法 AI大模型 模型对比 毕业设计(建议收藏)✅

本文介绍了一个基于Python的交通大数据分析系统,整合Flask、Vue、MySQL等技术栈,实现交通数据采集、分析与预测功能。系统包含五大模块:仪表盘总览全局数据、交通健康榜排名、地铁运营分析、基于ARIMA/LSTM算法的客流/拥堵预测,以及多维度可视化展示。通过爬虫技术获取实时数据,结合算法模型提供未来一周趋势预测,为交通管理和公众出行提供决策支持。测试表明系统运行稳定,预测误差可控,具有

博主介绍:✌全网粉丝50W+,前互联网大厂软件研发、集结硕博英豪成立工作室。专注于计算机相关专业项目实战8年之久,选择我们就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅🍅感兴趣的可以先收藏起来,点赞、关注不迷路,大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助同学们顺利毕业 。🍅

1、毕业设计:2026年计算机专业毕业设计选题汇总(建议收藏)✅

2、大数据毕业设计:2026年选题大全 深度学习 python语言 JAVA语言 hadoop和spark(建议收藏)✅

1、项目介绍

技术栈:

python语言、Flask框架、Vue前端框架、MySQL数据库、Echarts可视化、requests爬虫技术、Arima算法、LSTM算法

python交通大数据分析系统 智慧交通 地铁数据 客流量分析 爬虫 预测算法 模型对比 毕业设计

技术栈:

python语言、Flask框架、Vue前端框架、MySQL数据库、Echarts可视化、requests爬虫技术、Arima算法、LSTM算法

中国主要城市交通健康榜网站数据

https://www.metrodb.org/index/guangzhou.html

功能模块:

一、首页仪表盘:

二、交通数据分析

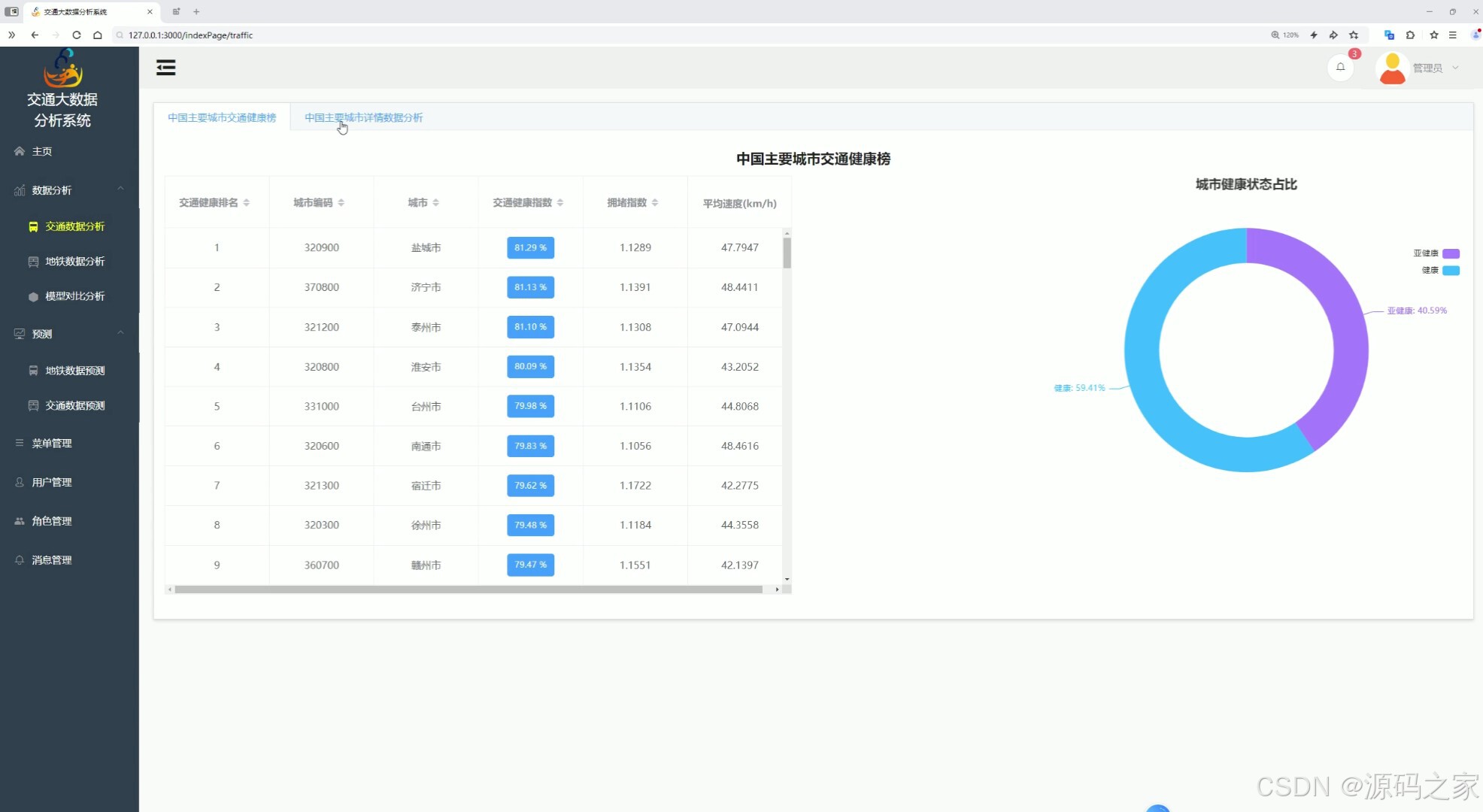

1、中国主要城市交通健康榜

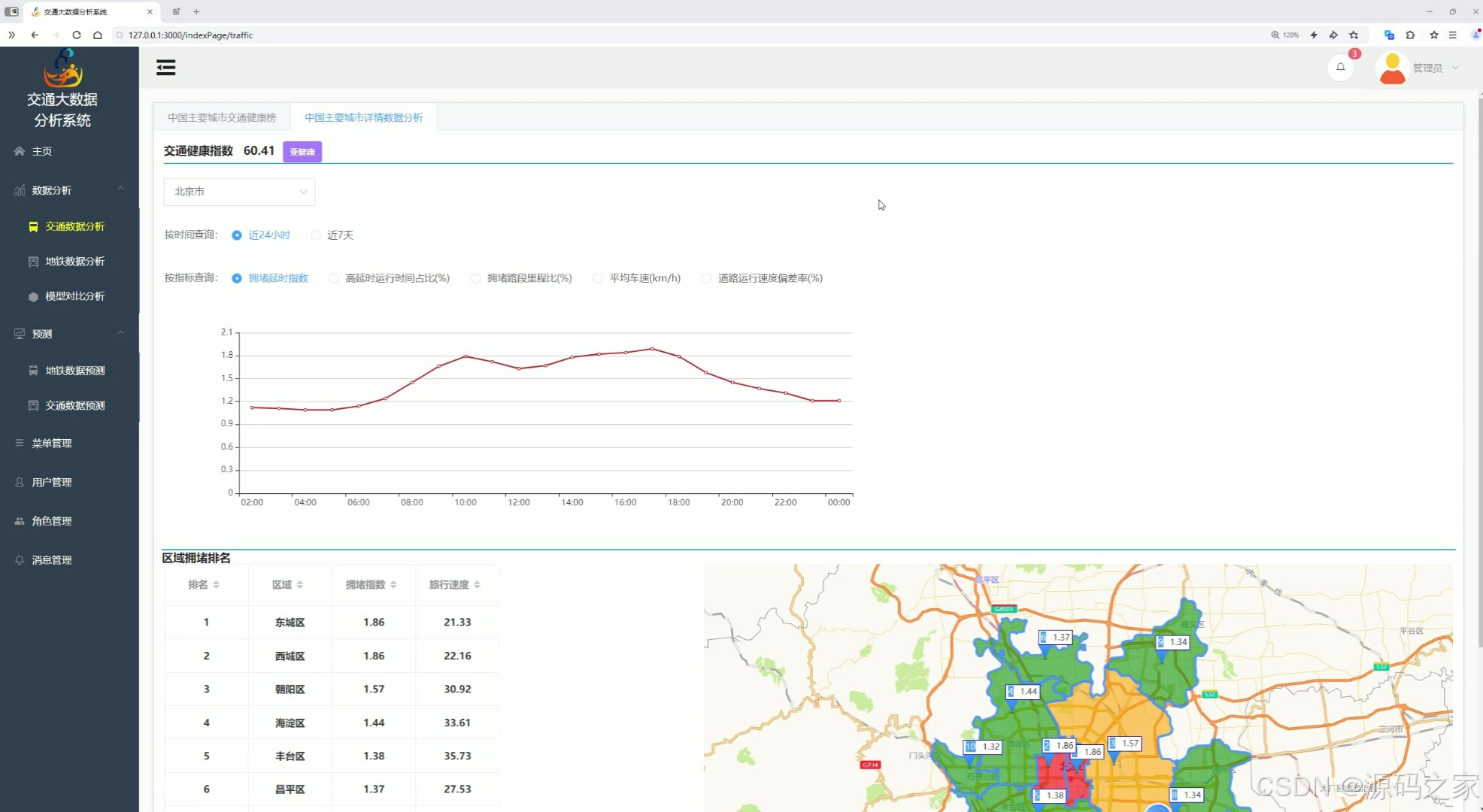

2、中国主要城市详情数据分析

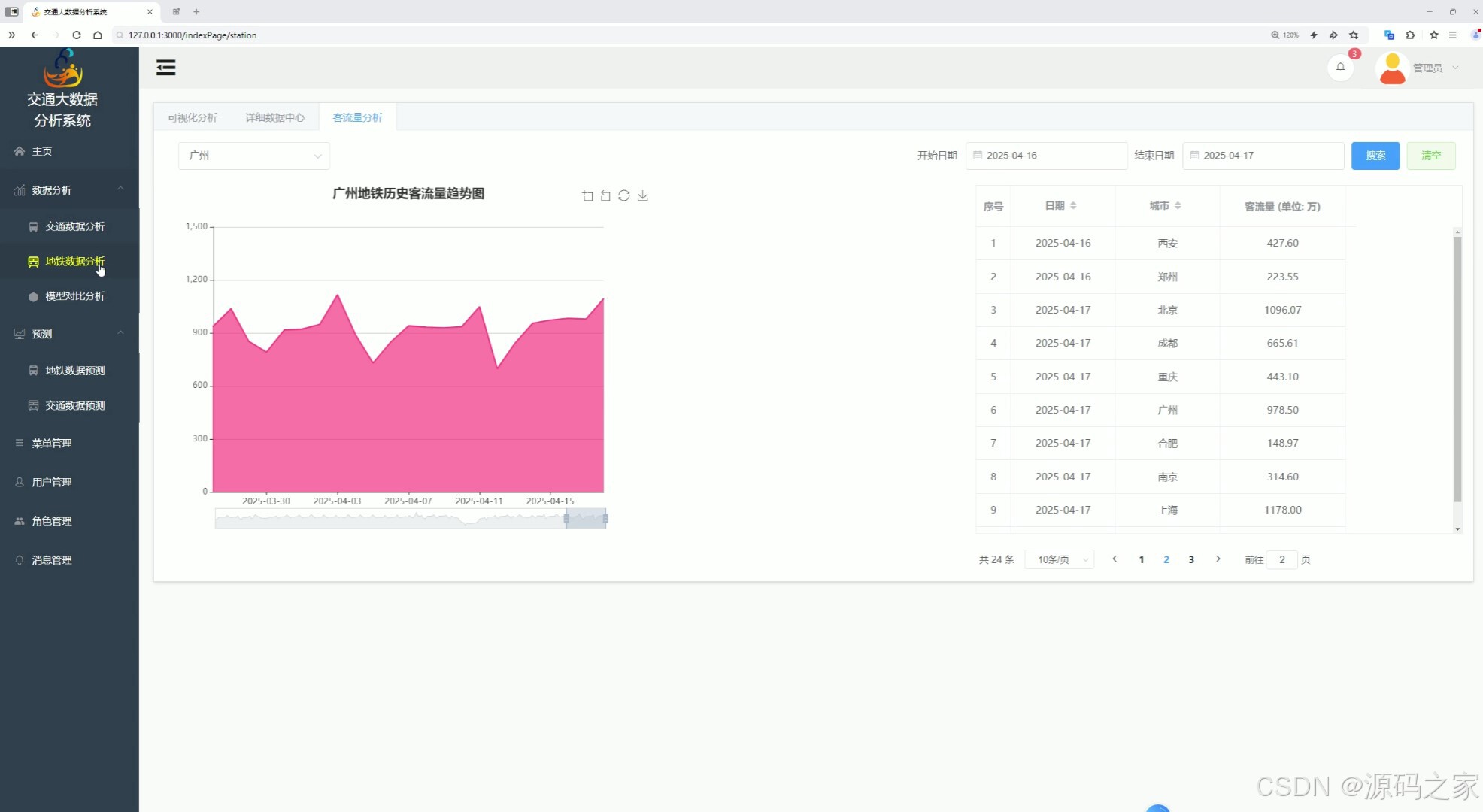

三、地铁数据分析

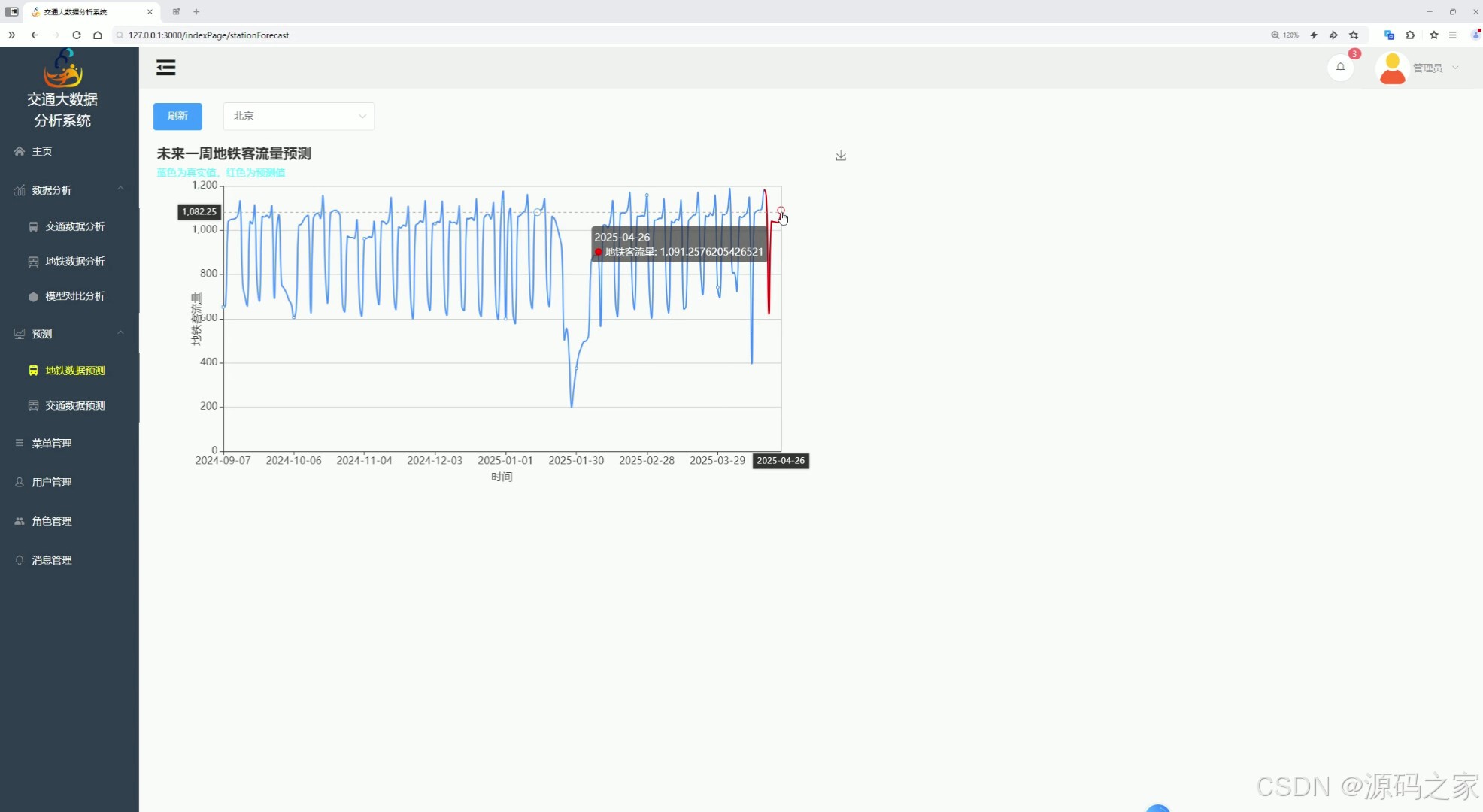

四、地铁数据预测

城市选择、未来一周地铁客流量预测折线图

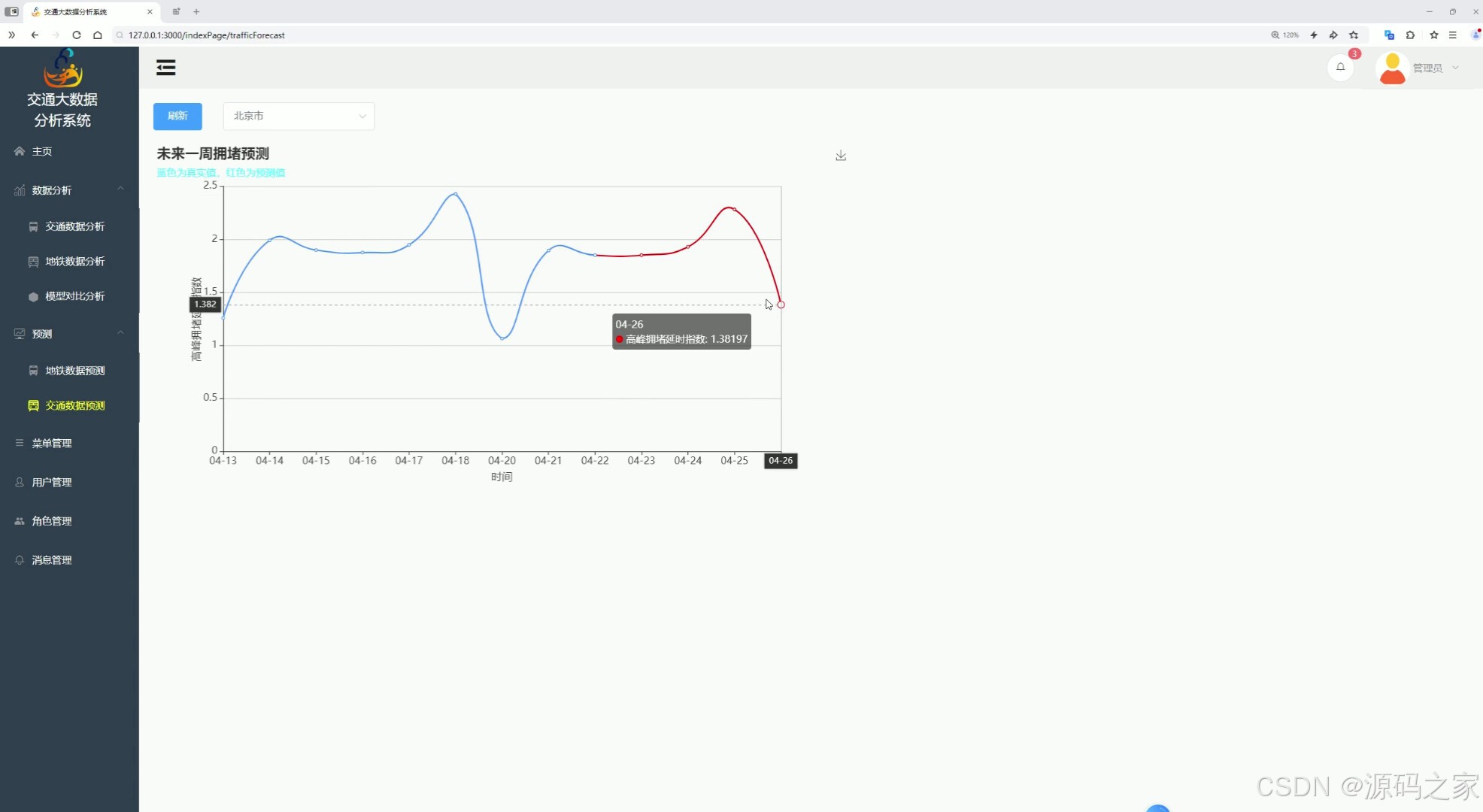

五、交通数据预测

城市选择、未来一周交通拥堵预测折线图

2、项目界面

一、首页仪表盘,交通数据

二、首页仪表盘

三、中国主要城市交通健康榜

四、交通数据分析

五、地铁数据分析

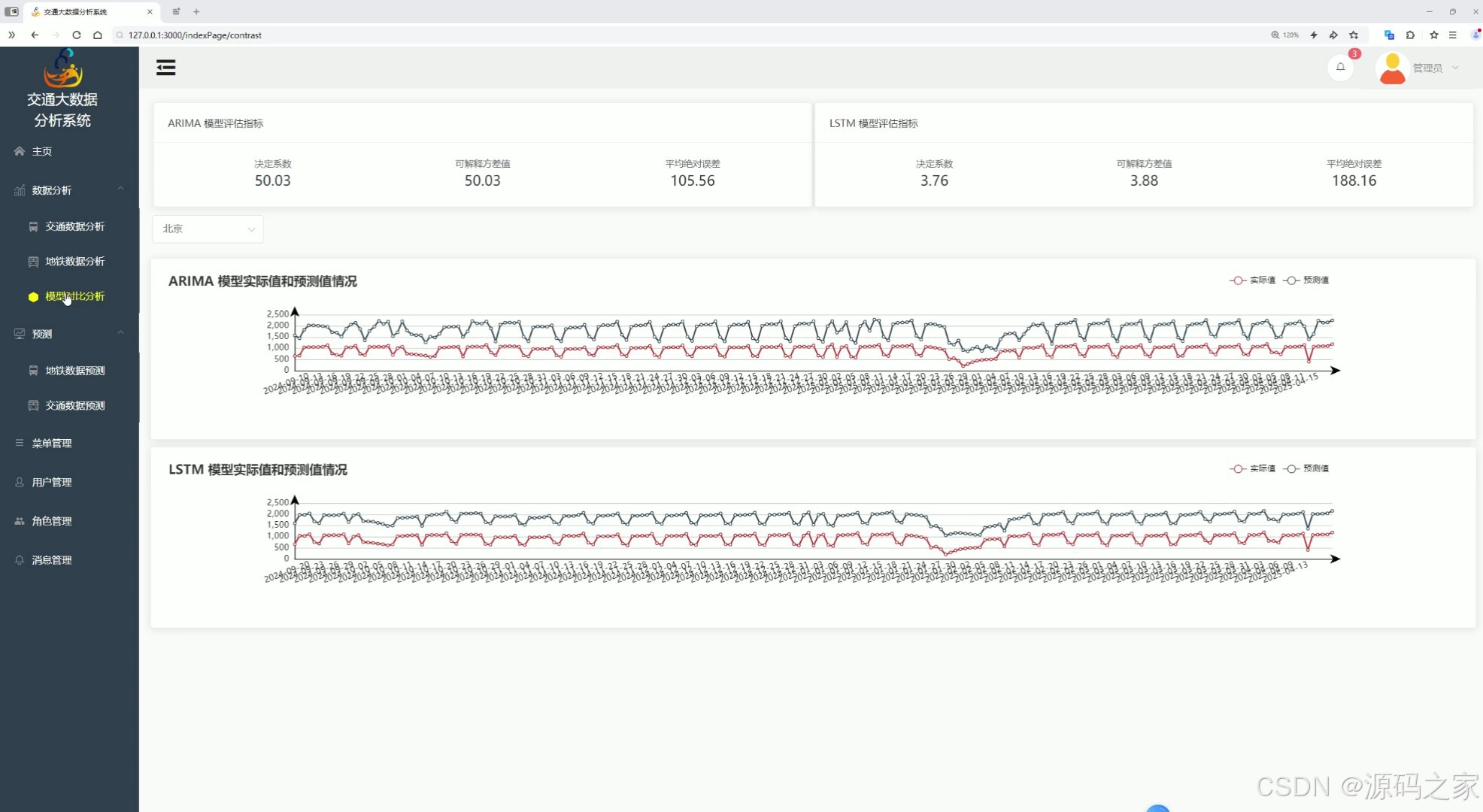

六、模型对比

七、地铁数据预测

八、交通数据预测

九、登录页面

3、项目说明

摘 要

城市化进程中交通拥堵问题加剧,对交通数据的全面分析与精准预判需求愈发迫切。为解决现有交通数据应用中分析维度单一、缺乏系统性展示与前瞻性预测的不足,本课题设计并实现了一套以功能模块为核心的交通数据分析与预测系统,旨在为交通管理决策与公众出行规划提供全方位数据支撑。

系统以Python为核心开发语言,采用Flask和MySQL技术栈,构建四层架构保障功能落地,核心亮点在于五大功能模块的协同设计:其一,首页仪表盘模块,集成地铁城市总数、总客流量等核心统计数据面板,通过不同星期客流量柱状图、城市健康与亚健康饼图、前10城市客流趋势折线图,实现全局数据可视化总览;其二,交通数据分析模块,包含中国主要城市交通健康榜(展示排名、拥堵指数等数据)与城市详情分析子模块,支持按近24小时/近7天时间范围及多类交通指标筛选查询,结合图表联动呈现数据特征;其三,地铁数据分析模块,涵盖城市地铁运营数据可视化、日期筛选的详细数据中心及多城市客流历史趋势分析功能,满足精细化数据挖掘需求;其四,地铁数据预测模块,支持城市选择,基于ARIMA与LSTM算法输出未来一周客流量预测结果并以折线图展示;其五,交通数据预测模块,针对城市拥堵指数,通过同款算法模型预测未来一周趋势,直观呈现拥堵变化规律。

测试结果表明,各功能模块运行稳定,数据采集完整、展示精准,预测误差控制在合理范围。系统实现了交通数据从全局总览、精细分析到短期预测的全流程覆盖,功能设计贴合实际需求,可有效提升交通管理效能,为公众出行提供科学指引,具备重要的实用价值与应用前景。

关键词:Python语言;交通;数据分析;预测

7.1 总结

本交通数据分析与预测系统以中国主要城市交通数据治理需求为核心,依托Python、Flask、Vue、MySQL等成熟技术栈,构建了一套涵盖数据采集、分析、可视化及预测的全流程解决方案,有效填补了交通数据整合分析与前瞻性预判的应用缺口。系统核心成果体现在三大维度:其一,数据采集与处理体系完备,通过Requests爬虫技术实现对MetroDB网站交通健康榜、地铁运营及客流量数据的定时精准抓取,经清洗格式化后稳定存储于MySQL数据库,保障了数据的时效性与完整性,为后续分析预测提供了可靠的数据基础;其二,功能模块设计贴合实际需求,五大核心模块协同发力,首页仪表盘实现全局数据总览,交通与地铁数据分析模块支撑精细化数据挖掘,预测模块依托ARIMA与LSTM算法实现短期趋势预判,各模块支持城市选择、多条件筛选及图表交互,兼顾了管理端决策与公众端查询的多元需求;其三,可视化与交互体验优化,借助Echarts实现柱状图、饼图、折线图等多类型图表渲染,数据展示直观清晰,图表缩放、悬浮提示、数据联动等交互功能流畅,大幅降低了数据解读门槛。

技术层面,系统通过分层架构实现前后端解耦,提升了代码可维护性与扩展性;算法应用上融合ARIMA与LSTM优势,提升了预测结果的准确性与可靠性。经全面测试验证,系统各功能模块运行稳定,数据流转顺畅,预测误差控制在合理范围,可有效为交通管理部门的运力调配、拥堵疏导决策提供数据支撑,同时为公众出行规划提供前瞻性参考,具备显著的实用价值与应用前景。

4、核心代码

# -*- coding: UTF-8 -*-

"""

@summary:

@DATE: 11/15 17:53

"""

import asyncio

import csv

import aiohttp

import re

import json

# from tool.logger import logger

from datetime import datetime

from concurrent.futures import ThreadPoolExecutor

from bs4 import BeautifulSoup

import requests

from tqdm import tqdm

from typing import List, Any, Union

class DataFetcher:

def __init__(self, base_url: str, headers: dict, cookies: dict):

self.base_url = base_url

self.headers = headers

self.cookies = cookies

async def get_response(self, session, url):

"""异步获取响应"""

max_retries = 5 # 最大重试次数

retries = 0

while retries < max_retries:

try:

async with session.get(url, headers=self.headers, cookies=self.cookies) as response:

return await response.text()

except aiohttp.ClientConnectorError as e:

retries += 1

print(f"连接错误,正在重试 {retries}/{max_retries}...")

await asyncio.sleep(2) # 等待2秒后重试

except Exception as e:

print(f"发生错误: {e}")

break

return None

def is_null_number_string(self, string: str) -> Union[int, str]:

"""判断字符串是否为空数字字符串"""

return 0 if string.strip() == "" else string

def process_city_data(self, city, response_text, year_list):

"""处理每个城市的数据"""

new_data = re.findall(r'data: \[(.*?)\]', response_text)

years = new_data[1].split(', ')[:-1]

flows = new_data[2].split(', ')[:-1]

flow_list = [0] * len(year_list)

for i, year in enumerate(years):

year = int(year)

if year in year_list:

index = year_list.index(year)

flow_list[index] = flows[i]

new_data = re.findall(r'rollNum\(".*", 0, (.*?)\);', response_text)

data = {

'city': city[1],

'time': new_data[0],

'operating_line': new_data[1],

'under_construction_line': new_data[2],

'operating_mileage': self.is_null_number_string(new_data[3].replace(', 2', '')),

'max_passenger_flow': self.is_null_number_string(new_data[4].replace(', 2', '')),

'yesterday_passenger_flow': self.is_null_number_string(new_data[6].replace(', 2', '')),

'yesterday_passenger_intensity': self.is_null_number_string(new_data[7].replace(', 2', '')),

'operating_station_count': self.is_null_number_string(new_data[8]),

'year_flow': json.dumps(dict(zip(year_list, flow_list)), ensure_ascii=False),

}

return data

async def fetch_city_data(self, session, city, year_list):

"""异步获取每个城市的数据"""

url = f"{self.base_url}/index/{city[0]}"

while True:

try:

response_text = await self.get_response(session, url)

return self.process_city_data(city, response_text, year_list)

except aiohttp.ClientError:

continue

async def get_data(self, city_url: str, year_list: List[int], max_workers=10):

"""获取并处理数据"""

async with aiohttp.ClientSession() as session:

# 获取城市列表

response_text = await self.get_response(session, city_url)

city_list = re.findall('<a href="(.*?)">(.*?)</a>', response_text)[1:-1]

total_cities = len(city_list)

results = []

errors = []

# 使用线程池来加速写入等操作

with ThreadPoolExecutor(max_workers=max_workers) as executor:

with tqdm(total=total_cities, desc="处理城市数据") as pbar:

loop = asyncio.get_event_loop()

tasks = []

# 创建任务

for city in city_list:

tasks.append(self.fetch_city_data(session, city, year_list))

# 处理完成的任务

for future in asyncio.as_completed(tasks):

try:

city_data = await future

results.append(city_data)

pbar.update(1)

except Exception as e:

pbar.update(1)

errors.append(str(e))

return results, errors

def generate_date_lists(self, start_date, end_date):

"""根据日期生成年份列表"""

start = datetime.strptime(start_date, '%Y-%m-%d')

end = datetime.strptime(end_date, '%Y-%m-%d')

return [year for year in range(start.year, end.year + 1)]

async def get_metro_db_data():

# 初始化DataFetcher实例

city_url = "https://www.metrodb.org/index/guangzhou.html"

# 创建DataFetcher实例

fetcher = DataFetcher(base_url="https://www.metrodb.org", headers=headers, cookies=cookies)

# 获取年份列表

year_list = fetcher.generate_date_lists('2018-01-01', datetime.now().strftime('%Y-%m-%d'))

# 获取数据并返回

result, errors = await fetcher.get_data(city_url, year_list, max_workers=10)

if errors:

print(f"处理过程中发生错误:{errors}")

return result

def get_response(url, headers, method: str = "GET", cookies: dict = None):

response = None

if method == "GET":

try:

response = requests.get(url, headers=headers, cookies=cookies, timeout=10)

except:

max_retries = 5 # 最大重试次数

retries = 1

while retries < max_retries:

print(f"连接错误,正在重试 {retries}/{max_retries}...")

try:

response = requests.get(url, headers=headers, cookies=cookies, timeout=10)

return response

except:

retries += 1

else:

response = requests.post(url, headers=headers, cookies=cookies, timeout=10)

return response

def to_date(date_str):

return datetime.strptime(date_str, "%Y-%m-%dT%H:%M:%S")

def to_timestamp(timestamp):

# 将时间戳转换为datetime对象

dt_object = datetime.fromtimestamp(timestamp)

# 将datetime对象格式化为字符串

return dt_object.strftime("%Y-%m-%d %H:%M:%S")

def get_metro_watch_data():

def get_real_time_traffic_detail_data(code, data_type: str):

"""

@summary: 获取实时交通详情数据

"""

url = "https://report.amap.com/ajax/cityHourly.do"

params = {

"cityCode": code,

"dataType": data_type

}

response = requests.get(url, headers=headers, params=params, cookies=cookies)

json_data = response.json()

data_list = []

print(type(data_type))

if data_type != '5':

for item in json_data:

data_list.append([to_timestamp(item[0] / 1000), item[1]])

return data_list

else:

return json_data

def get_real_time_traffic_detail_data2(code, data_type: str):

"""

@summary: 获取实时交通详情数据

"""

url = "https://report.amap.com/ajax/cityDaily.do"

params = {

"cityCode": code,

"dataType": data_type

}

response = requests.get(url, headers=headers, params=params, cookies=cookies)

json_data = response.json()

data_list = []

if data_type != '5':

for item in json_data:

data_list.append([to_timestamp(item[0] / 1000), item[1]])

return data_list

else:

return json_data

async def get_traffic_data():

url =

response = get_response(url, headers, cookies=cookies)

json_data = response.json()

city_traffic = []

for item in tqdm(json_data):

code = item['adcode']

rank = item['rankchange1']

time = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

cityName = item['cityName']

healthValue = item['healthValue']

idx = item['idx']

realSpeed = item['realSpeed']

city_traffic.append({

'rank': rank,

'city': cityName,

'city_code': code,

'timestamp': time,

'traffic_health_index': healthValue,

'congestion_delay_index': idx,

'average_speed': realSpeed

})

return city_traffic

if __name__ == "__main__":

print(to_timestamp(1733533200))

get_metro_watch_data()

ls = get_real_time_traffic_detail_data('321200', '1') # 获取实时交通详情数据

print(ls)

pass

5、源码获取方式

biyesheji0005 或 biyesheji0001 绿泡泡

🍅由于篇幅限制,获取完整文章或源码、代做项目的,查看我的【用户名】、【专栏名称】、【顶部选题链接】就可以找到我啦🍅

感兴趣的可以先收藏起来,点赞、关注不迷路,下方查看👇🏻获取联系方式👇🏻

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)