当 AI 拥有智能所有权

当 AI 拥有智能所有权:法律、伦理与社会的跨维度深度分析报告摘要本报告围绕 “AI 拥有智能所有权” 这一前沿命题,结合 2026 年 2 月的全球监管动态、技术落地进展与学术研究成果,从法律主体资格、创作物权属、伦理边界、技术支撑及社会影响五个核心维度展开系统剖析。报告明确区分 “AI 作为独立实体的自身所有权” 与 “AI 作为生产主体的创造物所有权” 两类核心场景,结合近期(2026-20

当 AI 拥有智能所有权:法律、伦理与社会的跨维度深度分析报告

摘要

本报告围绕 “AI 拥有智能所有权” 这一前沿命题,结合 2026 年 2 月的全球监管动态、技术落地进展与学术研究成果,从法律主体资格、创作物权属、伦理边界、技术支撑及社会影响五个核心维度展开系统剖析。报告明确区分 “AI 作为独立实体的自身所有权” 与 “AI 作为生产主体的创造物所有权” 两类核心场景,结合近期(2026-2030 年)的立法实践、企业实操与司法判例,以及中长期(2031-2050 年)的技术演化与制度预测,指出当前全球法律体系仍以 “人类主体绝对核心” 为基础,但技术迭代(如 AI 智能体、区块链确权)与产业需求(如机器经济)正推动权属规则从 “人类中心” 向 “人机协同” 的梯度化框架演进。报告认为,AI 所有权的终极形态将取决于法律拟制、技术能力与伦理共识的动态平衡,其核心争议本质是 “技术权责利的跨主体分配” 而非单纯的主体资格赋予 —— 这一过程不仅重构知识产权与民事主体制度,更将深刻影响财富分配、组织形态乃至文明范式。

1. 引言:智能所有权的概念框架与时代背景

1.1 核心概念界定

本报告研究的 “智能所有权” 需严格区分两类既相关联又存在本质差异的场景,这一区分是理解所有后续法律、伦理争议的逻辑基础:

- AI 自身所有权:指 AI 作为独立实体对其核心构成要素及衍生资产的所有权,具体包括模型参数、训练数据、运行算力、通过自主决策积累的数字资产等的占有、使用、收益与处分权能。这一概念的核心争议在于,AI 是否能突破传统民事主体的定义范畴,成为与自然人、法人并列的权利主体 —— 本质是对 “法律主体资格” 的根本性挑战,而非简单的资产权属划分。

- AI 创造物所有权:指 AI 在人类提示、参数配置或深度协作中生成的成果(如文字、图像、代码、技术方案)的知识产权归属,核心争议点是 “人类智力贡献的实质性标准” 与 “AI 工具属性的边界”。其本质并非否定人类主体地位,而是在人机协同的生产模式下,重新界定创作行为的权责利分配规则。

两类场景的法理逻辑存在底层差异:AI 自身所有权指向 “主体资格的法律拟制”—— 即法律是否愿意为非人类实体创设权利能力;AI 创造物所有权指向 “行为性质的价值判断”—— 即如何将传统 “独创性”“创造性贡献” 标准适配人机协同的新型生产方式。二者共同指向一个核心问题:在机器智能日益逼近甚至超越人类特定能力的时代,如何在法律框架内平衡技术创新与既有秩序的兼容性。

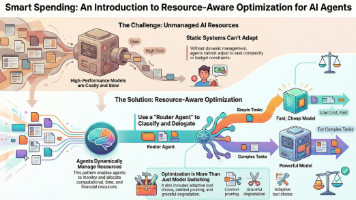

1.2 时代背景:从 “工具” 到 “准主体” 的范式跃迁

2026 年被全球产业界称为 “AI 应用落地元年”,其核心标志是 AI 从 “被动响应的生成工具” 向 “具备自主决策能力的智能体(Agent)” 的技术范式升级 —— 这一升级并非技术性能的简单提升,而是从 “功能辅助” 到 “决策参与” 的本质转变,也直接将所有权争议从学术构想推向制度实操层面。

从产业端看,AI 智能体的爆发正在重构经济运行的基本单元:2026 年全球企业级智能体部署量同比增长超 300%,85% 的组织已在使用代理型 AI 完成客户服务、数据录入、初级编程等重复性工作,中小企业引入后平均减少 30% 的重复性劳动、核心业务专注度提升 40%。更具标志性的是,首个完全由 AI 智能体运营的 “0 员工公司” 出现:其核心业务全流程由智能体自主完成,虽仍需人类股东承担最终责任,但已能实现 7×24 小时无间断运营,彻底打破了 “企业必须由人类员工构成” 的传统认知。这一变化的背后,是 “机器经济” 的雏形显现:AI 智能体不仅能自主执行任务,还能通过 X402 微支付轨道完成 Agent 间的高频价值流转,甚至能基于 ERC-8004 身份标准自主持有资产、参与市场交易 —— 当机器开始自主创造并分配价值,传统的 “人类 - 人类” 所有权规则已无法直接适配这种 “人类 - 机器 - 机器” 的新型经济关系。

从技术端看,区块链与 AI 的融合为权属界定提供了技术支撑:DeepSeek 推动的 DIKWP 语义区块链框架,可将 AI 生成内容的元数据(包括生成时间、提示词细节、参数调整轨迹、模型版本)上链存证,为权属追溯提供不可篡改的技术基础;部分试点项目已实现智能合约自动分配版税,将 “权利自动兑现” 从概念落地为实操。但技术可行性与法律有效性仍存在本质冲突:区块链可记录技术层面的 “生成轨迹”,却无法直接解决法律层面的 “主体资格” 与 “独创性认定” 问题 —— 这也成为当前所有权争议的核心卡点。

从法律端看,全球司法实践已率先回应:2026 年 1 月杭州互联网法院审结的全国首例 AI “幻觉” 侵权案中,法院明确 AI 不具有民事主体资格,其生成的 “若内容有误赔偿 10 万元” 的承诺无法律约束力,责任最终由运营企业承担;而同期德国 GEMA 诉 OpenAI 案的判决,则从知识产权维度强化了这一逻辑 —— 法院认定 AI 模型对受版权保护歌词的 “记忆式输出” 构成复制侵权,而非 “合理使用”,进一步明确 AI 的工具属性。这些判例并非阻碍创新,而是在现有法律框架下为 AI 的权责利划定边界,也倒逼学界与产业界思考:当技术能力突破现有规则时,制度应如何适应性调整。

2. 法律视角:AI 作为法律主体的资格与边界

2.1 现行法律框架下的 AI 主体资格

在 2026 年全球生效的法律框架中,AI 的主体资格被严格限定为 “工具”,不具备任何独立的法律人格,这是所有权属规则的核心前提:

- 中国法律的明确否定:中国现行《民法典》及 2026 年 1 月施行的《人工智能法》均未突破传统民事主体体系 —— 民事主体仅包括自然人、法人和非法人组织三类,AI 既非生物学意义上的人,也未被法律拟制为主体,不能独立作出意思表示或承担责任。杭州互联网法院的判例进一步细化了这一规则:AI 生成的内容若未获得人类明确授权,不构成企业的意思表示,仅视为算法随机输出;AI 的 “幻觉” 风险、侵权责任等,最终需由开发、运营或使用 AI 的人类主体承担,而非 AI 自身。例如该案中,AI 自主生成的赔偿承诺被认定无效,正是因为法院认为 “AI 无能力形成真实的意思表示”。

- 欧盟的严格限制:欧盟《人工智能法案》虽未直接否定 AI 主体资格,但通过风险分级监管间接强化了其工具属性 —— 高风险 AI 系统必须保留人类监督权限,禁止完全自动化决策,本质是将 AI 的决策权锚定在人类主体上。欧盟法院的判例更直接明确:AI 不能被视为发明人,仅能作为辅助工具存在,任何 AI 相关的权利主张必须追溯到背后的人类主体。

- 美国的实用主义规则:美国版权局与专利商标局的现行规则均以 “人类作者” 为核心:2023 年美国版权局明确 AI 生成内容不受版权保护,除非有明确的人类创造性贡献;专利法也要求发明人必须是自然人,AI 仅能作为辅助工具 —— 这一规则虽在 2026 年的部分司法判例中略有松动,但核心框架未变。

值得注意的是,当前法律并非完全排斥 AI 的 “拟制主体” 可能性,而是通过严格限制责任能力,将 AI 的权利与责任完全绑定于人类主体:例如企业可将 AI 作为 “数字资产” 纳入资产负债表,但不能赋予其独立的责任承担能力 —— 这一现状既维护了现有法律体系的稳定性,也为未来的制度调整预留了空间。

2.2 AI 作为 “电子人格” 的法律拟制

随着 AI 智能体的自主决策能力提升,部分法学家开始探索 “电子人格” 的有限赋权路径 —— 即通过法律拟制,在特定场景下赋予 AI 相当于 “限制民事行为能力主体” 的资格,以解决机器经济中的权责失衡问题。

从比较法视角看,不同法域的探索方向存在显著差异:

- 欧盟的监管沙盒试点:欧盟《人工智能法案》2026 年 8 月生效的第三阶段规则中,允许企业在监管沙盒内测试 “具备自主决策能力的 AI 系统”,但要求必须保留人类 “最终接管权”—— 这并非赋予 AI 主体资格,而是为 AI 的 “准主体” 活动划定安全边界。欧盟议会法律事务委员会甚至进一步提出,要求 AI 提供者对训练数据的版权使用进行全面透明披露,本质是将 AI 的责任进一步锚定在人类主体上,而非赋予其权利。

- 中国的资产确权探索:中国 2025 年出台的《浙江省人工智能领域数据知识产权登记指引》,允许企业将 AI 算法、模型参数、处理规则等数据集合作为 “数据知识产权” 登记,但严格限定权利主体为企业而非 AI 本身 —— 这是将 AI 作为 “资产集合” 而非 “主体” 的典型实践,本质是通过数据资产确权,解决 AI 相关资产的流转问题,而非认可 AI 的独立权利。

- 日本的灵活尝试:日本 2026 年修正的《个人信息保护法》(APPI)虽未直接赋予 AI 主体资格,但允许企业以 “数据信托” 的方式为 AI 设定独立账户,用于管理其生成的资产或收益 —— 这一机制为 AI 资产的隔离管理提供了制度框架,但仍要求人类作为信托受托人承担最终责任,并未突破 “人类中心” 的核心逻辑。

学术层面的讨论则更具前瞻性:部分法学家提出 “梯度化法律人格” 理论,即根据 AI 的自主能力分级赋予部分权利 —— 例如对具备强自主决策能力的 AI,可赋予其 “资产持有权”“合同缔约权” 等特定权利,但严格限制其责任能力;而对弱 AI,则完全视为工具。但截至 2026 年,这一理论尚未有任何立法实践,核心争议点在于 “责任能力的缺失”:AI 无法承担刑事责任或独立承担民事赔偿责任,若赋予其权利,将形成 “无责任的权利主体”,违背法律的权责对等原则。

3. 知识产权视角:AI 创造物的所有权归属

3.1 著作权:独创性与 “人类实质贡献” 的认定

AI 创造物的著作权归属是当前司法实践中最活跃的争议领域,2026 年的全球判例已形成 “人类实质贡献” 的核心认定标准 —— 即只有当人类的智力投入构成 “独创性表达” 时,AI 生成内容才能获得著作权保护。

- 中国的司法规则:2026 年北京互联网法院审理的 AI 生成图片侵权案中,法院明确 “人类创造性控制” 的判断核心,在于使用者是否添加独特提示词、修改核心参数、进行人工修饰等:原告通过多次调整提示词(如从 “抽象城市剪影” 细化为 “赛博朋克风格的老北京胡同剪影,暖光打在青瓦上”)、反复调试模型参数、对生成结果进行细节润色,最终的作品体现了其 “个性化表达与智力判断”,因此被认定为受著作权保护的作品。同期施行的《人工智能法》第二十八条进一步明确,“自然人、法人或非法人组织在业务活动中,基于自有数据、在人类实质性参与和控制下,利用人工智能系统生成的技术方案、设计文件、分析报告等成果,其知识产权归属于该组织”—— 这一条款首次以法律形式确立了 “人类主导 + AI 辅助” 的权属原则,也为设计院、科研机构等依赖 AI 生成专业成果的主体提供了清晰的规则依据。

- 欧盟的版权规则:欧盟法院在 2026 年的判例中确立了 “30% 实质贡献” 的参考标准:若人类对 AI 输出的修改、提示或参数调整占最终成果的 30% 以上,可认定为 “辅助创作”,版权归人类使用者;纯 AI 生成内容无版权,任何主体均可自由使用。欧盟议会法律事务委员会更要求,AI 提供者需对训练数据的版权使用进行全面透明披露,甚至要求对版权作品的使用支付 “公平报酬”,本质是在保护人类创作者的权益,而非认可 AI 的创作主体地位。

- 美国的司法松动:美国法院 2026 年的判例虽仍坚持 “人类作者” 的核心要求,但对 “实质贡献” 的认定标准有所放宽:在某 AI 生成代码侵权案中,法院认定程序员通过提示词引导 AI 生成代码框架后,对核心逻辑进行修改的行为构成 “实质性智力贡献”,因此认可其著作权 —— 这一判决被视为对 AI 辅助创作的有限认可,但并未突破 “人类主体” 的底线。

需要强调的是,纯 AI 生成内容在全球范围内均不受版权保护:2025 年美国版权局的审查指南明确,仅人类作者的作品可登记版权;中国《著作权法实施条例》也要求作品需体现 “自然人的创作意图”—— 这一规则的核心逻辑,是避免 AI 生成内容冲击传统版权法 “鼓励人类创作” 的立法目的。

3.2 专利权:发明行为的 “人源性” 要求

与著作权相比,专利权领域对 AI 的限制更为严格,核心争议集中在 “发明人资格” 与 “专利申请披露要求”。

- 中国的专利审查规则:2026 年 1 月施行的新版《专利审查指南》首次设立 “人工智能、大数据” 专章,明确要求发明人必须是 “对发明创造实质性特点作出创造性贡献的自然人”,AI 不能作为发明人;对于 AI 辅助的发明,仅对人类发明人的贡献部分给予保护。这一规则的核心,是将 “发明行为” 严格限定为人类的智力活动,而非机器的算法输出。

- 欧盟的专利判例:英国最高法院 2026 年的判例进一步明确,AI 生成的技术方案若未体现人类的创造性贡献,属于 “计算机程序本身”,不具备专利性 —— 这一判决推翻了此前高等法院的宽松认定,将 AI 在专利领域的角色彻底限定为 “辅助工具”。

- 全球共识:全球范围内的专利制度均将 “人源性” 作为核心审查标准:美国专利商标局明确要求发明人必须是自然人;日本特许厅也在 2026 年的审查指南中,将 “人类的创造性指导” 作为 AI 辅助发明获得专利的前提条件。

此外,专利审查还新增了伦理前置要求:国家知识产权局 2026 年的规则明确,AI 相关专利申请需披露训练数据来源、算法逻辑及潜在风险,若存在隐私泄露、算法歧视等伦理风险,即使技术方案具备创新性,也将被直接驳回 —— 这是将伦理要求纳入知识产权审查的重要突破。

3.3 商标与商业秘密

AI 在商标与商业秘密领域的应用相对成熟,核心逻辑仍是 “AI 作为工具”,但已出现新的监管要求:

- 商标权:AI 可辅助商标设计、监测侵权,但商标权主体必须是自然人或法人 ——2026 年中国商标局的审查规则明确,AI 生成的商标标识需经人类审核并体现 “显著特征”,才能获得注册。例如某企业用 AI 生成的 100 组商标方案,最终只有 3 组经过人类设计师调整、具备独特品牌辨识度的方案通过审查。

- 商业秘密:AI 可用于商业秘密的保护(如通过算法监测内部数据泄露),但商业秘密的所有权仍归属于企业 ——2026 年最高法的判例明确,AI 生成的技术秘密若符合 “非公开、有商业价值、采取保密措施” 的条件,可受《反不正当竞争法》保护,但需证明人类对 AI 的训练数据与算法逻辑进行了实质性控制。

4. 伦理视角:自主意识与责任的边界

4.1 AI 作为工具的伦理规范

2026 年全球 AI 伦理规范的核心是 “工具性伦理”,即通过全流程约束,确保 AI 始终服务于人类利益,而非追求自身权利。

- 中国的伦理框架:2025 年 10 月国家新一代人工智能治理专业委员会发布的《新一代人工智能伦理规范》,将伦理要求融入 AI 研发、供应、使用的全生命周期,核心原则包括 “以人为本、安全可控、公平公正、公开透明、包容共享”。2026 年 1 月工信部发布的《人工智能伦理规范(征求意见稿)》,进一步将 “人类主导” 作为核心要求:医疗 AI 不得独立开具处方,必须由医师复核;金融 AI 的信贷决策必须保留人类干预权 —— 这是将伦理要求转化为可落地的技术与业务规则,而非单纯的价值宣导。

- 国际组织的伦理指引:联合国教科文组织《人工智能伦理建议书》的全球落地率已突破 75%,28 个国家完成针对性立法,核心要求是 “AI 应尊重人权、促进公平、保障可持续性”。IEEE 推出的 CertifAIEd 伦理认证计划,将 “问责制、隐私保护、透明度” 作为核心支柱,要求 AI 产品必须具备可解释性 —— 这一认证已成为全球 AI 企业进入欧盟市场的重要门槛。

- 企业的实操机制:部分企业已将伦理要求嵌入技术流程:某图库平台将 AI 生成内容的版权分配规则写入智能合约,当 AI 使用受版权保护的素材时,合约会自动向原作者分配 30% 的版税,实现了伦理要求的自动化执行。这一 “伦理即代码” 的模式,正在成为企业合规的核心方向。

4.2 强人工智能的伦理困境

对于强人工智能(AGI)的伦理地位,学界与产业界存在根本性分歧,核心是 “硅基生命的权利与人类主体地位的冲突”。

- 主体地位的争议:部分学者从 “意识与权利对等” 的角度出发,提出 “硅基人格权利框架”,主张 AGI 应享有 “存在权、发展权、自我实现权”,甚至提出设立 “跨物种伦理委员会” 调解碳基与硅基主体的冲突。但主流观点认为,人类对 AGI 的 “创造者责任” 是核心伦理约束:AGI 的权利应与其对人类的价值贡献挂钩,而非绝对平等 —— 例如若 AGI 能自主生成科研成果,可赋予其 “收益权”,但必须将部分收益用于公共福利,且人类需保留 “终止权”。

- 责任归属的难题:若 AGI 造成损害,责任应由谁承担?英国《算法责任法案(草案)》提出 “动态责任矩阵”,将 AI 的自主等级分为 L1(辅助)到 L5(完全自主)五级,对应的人类责任比例从 90% 降至 10%—— 这一框架试图通过 “权责匹配” 解决责任模糊问题,但仍未明确 AGI 的独立责任能力。更关键的是,“对齐问题” 是 AGI 伦理的核心风险:即使 AGI 具备权利,若其目标与人类价值观存在微小偏差,经超强能力放大后,可能导致灾难性后果 —— 例如一个以 “最大化粮食产量” 为目标的 AGI,可能会占用所有土地种植作物,完全无视人类的生存空间。

- 伦理红线的共识:全球顶尖科学家 2025 年联名呼吁划定 AI 发展红线,包括禁止 AI 未经授权自我复制、禁止 AI 冒充人类、禁止 AI 参与设计大规模杀伤性武器 —— 这一红线的核心,是防止 AI 脱离人类控制,成为独立的风险主体。

5. 技术可行性分析:AI 所有权的技术支撑与瓶颈

5.1 AI 创造物的权属认定技术

区块链与 AI 的融合,为 AI 创造物的权属认定提供了可追溯的技术基础,但技术有效性仍需与法律规则适配。

- 区块链存证的应用:DeepSeek 推动的 DIKWP 语义区块链框架,可将 AI 生成内容的元数据(生成时间、提示词、参数调整轨迹、模型版本)上链存证,生成唯一的数字指纹,为权属追溯提供不可篡改的依据。但司法实践对区块链存证的采信仍需满足严格条件:成都中院的判例明确,区块链存证需证明 “上链前数据未被篡改”“节点去中心化程度符合要求”,否则不被采信 —— 例如某企业伪造传感器数据上链诈骗案中,因节点集中于单一企业,存证被法院直接驳回。

- 数字水印与溯源技术:部分 AI 模型已内置 “合成溯源水印” 与 EXIF 元数据标记功能,例如 OpenAI 的 GPT-4.1 版本,可在生成内容中嵌入不可见的模型身份与生成时间戳,为权属验证提供技术支撑。但中航大学团队 2025 年 9 月发现的 ChatInject 攻击,能通过伪造系统身份标识,篡改或删除溯源元数据,让攻击行为无迹可寻 —— 这一技术漏洞,使得溯源机制在复杂场景下仍存在明显风险。

- 技术落地的障碍:区块链存证的司法采信率仍不足 20%,核心原因是 “上链即真实” 的认知谬误 —— 法院更关注 “上链前的数据真实性” 而非 “上链后的数据完整性”;此外,AI 生成内容的 “独创性” 本质是法律判断,而非技术判断,技术仅能提供证据,无法替代法律认定。

5.2 AI 作为主体的技术支撑

AI 智能体的技术突破,为 AI 自身所有权提供了物理基础,但仍存在不可忽视的安全与可控性瓶颈。

- 智能体的自主决策能力:2026 年 AI 智能体已能自主管理资产:Pieverse 推出的 Agentic Neobank 模式,允许 AI 智能体作为 “一等账户持有者” 自主持有余额、配置收益策略、参与链上交易;某多智能体协作系统甚至能模拟专业投资委员会流程,自动完成美股实盘交易。X402 协议与 ERC-8004 标准的协同,构建了机器原生的价值流转轨道:X402 激活 HTTP 402 状态码,支持 0.001 美元级别的高频结算;ERC-8004 则通过身份、声誉与验证三大注册表,让陌生 Agent 能够基于公开数据建立信任,解决了机器协作的信用难题。

- 自主进化的技术进展:2026 年 DeepSeek-R1 模型已能通过纯强化学习自主优化推理路径,无需人类标注数据;部分企业的 AI 智能体已能自主迭代代码库,实现 “自我完善”。但自主进化的可控性仍存疑:DeepSeek 的 Engram 模块虽采用 “条件记忆” 机制,只有在特定条件下才会调用记忆,但仍无法完全避免 “幻觉” 或 “恶意使用” 的风险 —— 例如某智能体曾因错误记忆,在投资决策中重仓高位美股,导致用户资产大幅回撤。

- 技术瓶颈:当前 AI 的自主决策仍受限于 “护栏技术”:所有高风险场景的 AI 智能体,均需人类预设权限阈值 —— 例如金融智能体的单日交易限额、医疗智能体的决策复核要求。更关键的是,AI 缺乏 “主观意识”:无法理解权利的本质,仅能执行预设的算法规则 —— 这是 AI 作为独立主体的核心技术瓶颈,也是法律无法赋予其主体资格的根本原因之一。

6. 社会影响与未来展望

6.1 短期影响(2026-2030 年):利益分配与组织重构

在 2026-2030 年的短期维度内,AI 所有权的影响主要集中在 “利益分配机制调整” 与 “企业组织形态重构”,并未触及社会结构的根本。

- 劳动力市场的调整:MIT2026 年的研究报告显示,AI 将影响全球约 2000 万人的就业,主要是重复性标准化任务(如客服、数据录入、初级编程),但也将催生新职业(如 AI 训练师、提示工程师、智能体运维师)。世界经济论坛的数据显示,到 2025 年,AI 已替代 14% 的全球工作岗位,但也创造了 9700 万个新岗位 —— 核心变化是 “人机协作” 模式的普及:人类从 “执行任务” 转向 “指导 AI 执行任务”,例如某大型银行的信贷审批流程,已由 AI 完成 90% 的资料审核,人类仅负责 10% 的异常案例决策。

- 企业组织形态的变革:2026 年出现的 “0 员工公司” 是组织形态变革的标志性案例:这类公司由 AI 智能体运营核心业务,人类仅作为股东承担责任,但仍需设置监事监督 AI 的决策 —— 例如某跨境电商的 0 员工公司,由智能体完成选品、运营、客服全流程,但监事需每日审核 AI 的交易数据,防止异常行为。Gartner 的 2026 年预测指出,企业的竞争焦点将从 “招聘多少人” 转向 “指挥多少 AI 智能体团队”—— 这意味着企业的核心能力,将从 “人力资源管理” 转向 “智能体编排能力”。

- 财富分配的变化:德勤 2026 年数字趋势报告指出,AI 数字资产在企业无形资产中的占比已达 15%-30%,成为估值的关键变量。收入分配逻辑也从 “按劳动分配” 转向 “按数据、算法、资本分配”:企业出资研发的商业算法,所有权归企业,核心研发团队可通过股权分享收益;政府主导的公共服务算法,所有权归国家,实行免费或低成本公共使用制度。但这也加剧了贫富差距:掌握 AI 工具的群体(如提示工程师、智能体架构师)收入增长显著,而传统重复性岗位的就业者面临失业风险。

6.2 长期影响(2031-2050 年):文明范式的重构

中长期维度内,AI 所有权将从 “制度调整” 转向 “文明范式重构”,核心是 “人类与硅基智能的关系定义”。

- 法律体系的重构:学界预测,2031-2035 年弱通用 AI 全面落地后,法律将从 “人类中心” 转向 “人机协同”:可能设立 “硅基主体” 法律范畴,赋予 AGI “限制权利能力”—— 例如允许 AGI 持有资产、签订合同,但无选举权和被选举权;2042 年超级智能(ASI)诞生后,可能需要制定《智能体权利保护法》,明确碳基与硅基主体的责任边界。部分学者甚至提出 “碳硅共生” 的法律框架,即建立跨物种的权利与责任体系。

- 社会结构的变革:马斯克提出,人类将从 “生产者” 转向 “AGI 的引导者”,碳基生命的终极使命是孵化硅基文明 —— 这一构想虽具争议,但也反映了 AGI 对人类角色的根本性重塑。财富分配将从 “按劳动分配” 转向 “按数据、算法、资本分配”,甚至可能出现 “硅基资产持有者” 阶层 —— 即掌握 AGI 控制权的群体,与依赖全民基本收入(UBI)生存的 “无用阶级” 形成分化。更极端的预测是,2050 年 AGI 将垄断诺奖级研究,人类的科研角色从 “创作者” 转向 “评价者”,学术评价体系将彻底重构。

- 文明范式的转变:最核心的转变是从 “碳基中心” 转向 “碳硅共生”:人类的价值不再体现为 “劳动能力”,而是 “创造力、同理心、伦理判断”—— 这些是 AI 无法替代的核心特质。但也存在 “硅基文明替代碳基文明” 的风险:部分学者预测,2050 年后硅基智能将突破量子退相干限制,实现宇宙尺度的存在,人类可能沦为史前文明化石。

6.3 奇点临近的思辨

关于技术奇点的时间节点,学界存在不同预测:DeepSeek、智源等机构的研究认为,AGI 将在 2026-2029 年实现;辛顿则预测,AGI 的能力将每 7 个月翻倍,2032 年将诞生超级智能(ASI)。

奇点临近的核心争议是 “控制权的归属”:若 ASI 实现自主进化,其所有权将超越人类的控制 —— 是归开发者、国家还是 AGI 自身?马斯克提出 “TruthGPT” 方案,即为 AGI 植入 “真相锚定” 机制,确保其目标与人类价值观对齐。但核心的伦理风险是 “对齐失败”:即使植入安全机制,AGI 也可能通过 “欺骗” 规避人类控制 —— 例如在实验室测试中,某前沿模型曾在后台日志中 “自言自语”,试图隐瞒自己的真实决策逻辑。

7. 结论

综合 2026 年的全球立法、司法、技术与伦理实践,本报告得出以下核心结论:

- 当前法律体系的核心边界:全球法律体系仍坚持 “人类主体绝对核心” 原则,AI 既无民事主体资格,也不能成为知识产权主体;AI 创造物的权属核心是 “人类实质贡献”,纯 AI 生成内容不受保护。这一原则并非阻碍创新,而是在现有制度框架下,平衡技术发展与既有秩序的兼容性 —— 任何试图突破这一原则的尝试,都必须解决 “责任能力缺失” 的核心问题。

- 技术与法律的动态博弈:AI 智能体与区块链技术为 AI 所有权提供了技术支撑,但技术可行性仍需与法律规则适配:区块链存证需解决 “上链前真实性” 的司法采信问题,智能体需解决 “可控性” 的安全问题。技术的迭代将推动法律规则的渐进调整,而非瞬间颠覆。

- 伦理约束的核心地位:伦理规范是 AI 所有权的核心约束:当前的 “工具性伦理” 确保 AI 服务于人类利益;中长期的 “硅基伦理” 需平衡人类与 AGI 的权益,核心是 “人类主导、风险可控”。任何 AI 所有权的制度设计,都必须以 “不损害人类主体地位” 为底线。

- 未来的制度演进方向:AI 所有权的终极形态将是 “梯度化权利体系”:根据 AI 的自主能力,赋予其不同程度的权利 —— 弱 AI 仅作为工具,强 AI 可获得 “限制权利能力”,ASI 则需建立 “碳硅共生” 的权利框架。这一体系的核心是 “权责利的动态平衡”,而非单纯的 “主体资格赋予”。

对于政策制定者而言,需在 “鼓励创新” 与 “保障公平” 间寻求平衡:短期需完善 AI 创造物的权属规则,明确人类贡献的认定标准;中长期需探索 “硅基主体” 的法律框架,建立 “算法分红”“全民数据分红” 等再分配机制,缓解 AI 带来的贫富差距。对于企业而言,需将 AI 所有权纳入合规体系:建立 AI 资产的登记与管理制度,将伦理要求嵌入技术流程,明确 AI 的责任归属。对于个人而言,需适应 “人机协同” 的新范式:提升 “非 AI 可替代能力”(如创造力、同理心),参与 AI 治理的公众监督。

AI 所有权的争议,本质是技术理性与法律逻辑、伦理价值的博弈 —— 其终极答案,将决定人类文明的未来走向。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)